Скорость развития искусственного интеллекта (AI) привела к мощному синергическому эффекту между крупными языковыми моделями (КЯМ) и агентами AI. Эта динамическая взаимосвязь похожа на сказание о Давиде и Голиафе (без битвы), где ловкие агенты AI усиливают и расширяют возможности гигантских КЯМ.

Это руководство исследует, как агенты AI – подобно Давиду – усиливают КЯМ – наши современные Голиафы – для помощи в революционизации различных отраслей и научных областей.

Содержание

Появление AI-агентов в языковых моделях

AI-агенты являются автономными системами, предназначенными для восприятия своей среды, принятия решений и осуществления действий для достижения конкретных целей. Когда они интегрируются с LLM, эти агенты могут выполнять сложные задачи, рассуждать о информации и генерировать инновационные решения.

Эта комбинация привела к существенным успехам во многих секторах, от разработки программного обеспечения до научных исследований.

Трансформирующий влияние на отрасли

Интеграция AI-агентов с LLM оказала глубокое влияние на различные отрасли:

-

Софтware разработка: AI-powered кодирование помощников, таких как GitHub Copilot, продемонстрировали способность создавать до 40% кода, приводя к заметному увеличению скорости разработки на 55%.

-

Образование: AI-powered учебные помощники показали перспективу в уменьшении среднего времени завершения курса на 27%, теоретически могущая революционизировать образовательную сферу.

-

Транспорт: Прогнозы предполагают, что 10% автомобилей будут беспилотными к 2030 году, и автономные ИИ-агенты в само guidoing автомобилях готовы трансформировать транспортную отрасль.

Продвижение научных открытий

Одним из самых захватывающих применений ИИ-агентов и БПСЛМ является их использование в научных исследованиях:

-

Обнаружение лекарств: ИИ-агенты ускоряют процесс обнаружения лекарств путем анализа огромных наборов данных и предсказания потенциальных кандидатов в лекарственные средства, значительно сокращая время и затраты, связанные с традиционными методами.

-

Физика частиц: В Large Hadron Collider CERN используются агенты AI для анализа данных о столкновениях частиц, используя детекцию аномалий для идентификации перспективных направлений, которые могут указать на существование не открытых частиц.

-

Общее научное исследование: Агенты AI повышают скорость и объем научных открытий, анализируя прошлые исследования, идентифицируя неожиданные связи и предлагая новые эксперименты.

Сочетание интеллектуальных агентов AI и крупных языковых моделей (LLMs) позволяет технологии искусственного интеллекта перейти на новую эру непредвиденных возможностей. Этот комплексный справочник исследует динамическое взаимодействие этих двух технологий, раскрывая их совместный потенциал революционизировать отрасли и решать сложные проблемы.

Мы проследим за эволюцией AI от его истоков до появления автономных агентов и подъема сложных LLMs. Мы также исследуем этические соображения, которые являются фундаментом ответственного развития AI. Это поможет нам убедиться, что эти технологии соответствуют нашим человеческим ценностям и благосостоянию общества.

Когда мы приходим к заключению этого справочника, у вас будет глубокое понимание синергетической силы AI-агентов и LLMs, а также знания и инструменты, чтобы использовать эту передовую технологию.

Раздел 1: Введение в Интеллектуальные Агенты AI и Языковые Модели

Что такие Интеллектуальные Агенты AI и Большие Языковые Модели?

быстрое развитие искусственного интеллекта (AI) привело к появлению трансформационного синергического взаимодействия между большими языковыми моделями (LLMs) и AI-агентами.

АИ-агенты являются автономными системами, предназначенными для восприятия их среды, принимания решений и выполнения действий для достижения определенных целей. Они проявляют такие качества, как автономия, восприятие, реактивность, умственные способности, принятие решений, обучение, коммуникация и ориентация на цели.

С другой стороны, СКИ являются сложными АИ-системами, использующими технику глубокого обучения и огромные наборы данных для понимания, генерации и предсказания похожего на человеческий текста.

Эти модели, такие как GPT-4, Mistral, LLama, продемонстрировали выдающиеся способности в задачах природного языкового процесса, включая генерацию текста, языковое перевода и диалогические агенты.

Ключевые характеристики АИ-агентов

У АИ-агентов есть ряд определяющих особенностей, которые отличают их от традиционного программного обеспечения:

-

Автономия: Они могут работать независимо от постоянного вмешательства человека.

-

Восприятие: Агенты могут воспринимать и интерпретировать свою среду с помощью различных входов.

-

Реактивность: Они динамично реагируют на изменения в своей среде.

-

Рассуждение и принятие решений: Агенты могут анализировать данные и принимать информированные решения.

-

Обучение: Они улучшают свои показатели с time through experience.

-

Коммуникация: Агенты могут взаимодействовать с другими агентами или людьми с помощью различных методов.

-

Ориентация на цели: Они предназначены для достижения определенных целей.

Capabilities of Large Language Models

LLMs have demonstrated a wide range of capabilities, including:

-

Текстовая генерация: LLMs can produce coherent and contextually relevant text based on prompts.

-

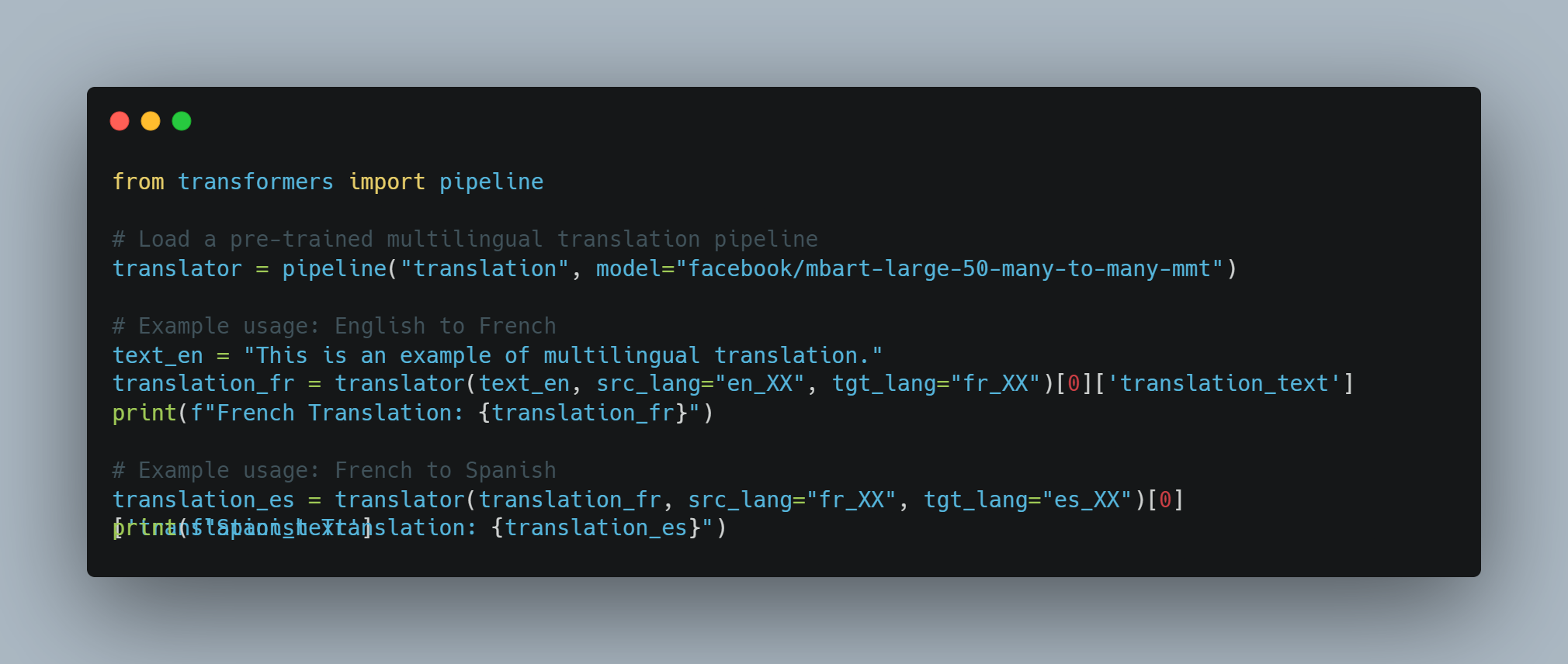

Перевод языка: They can translate text between different languages with high accuracy.

-

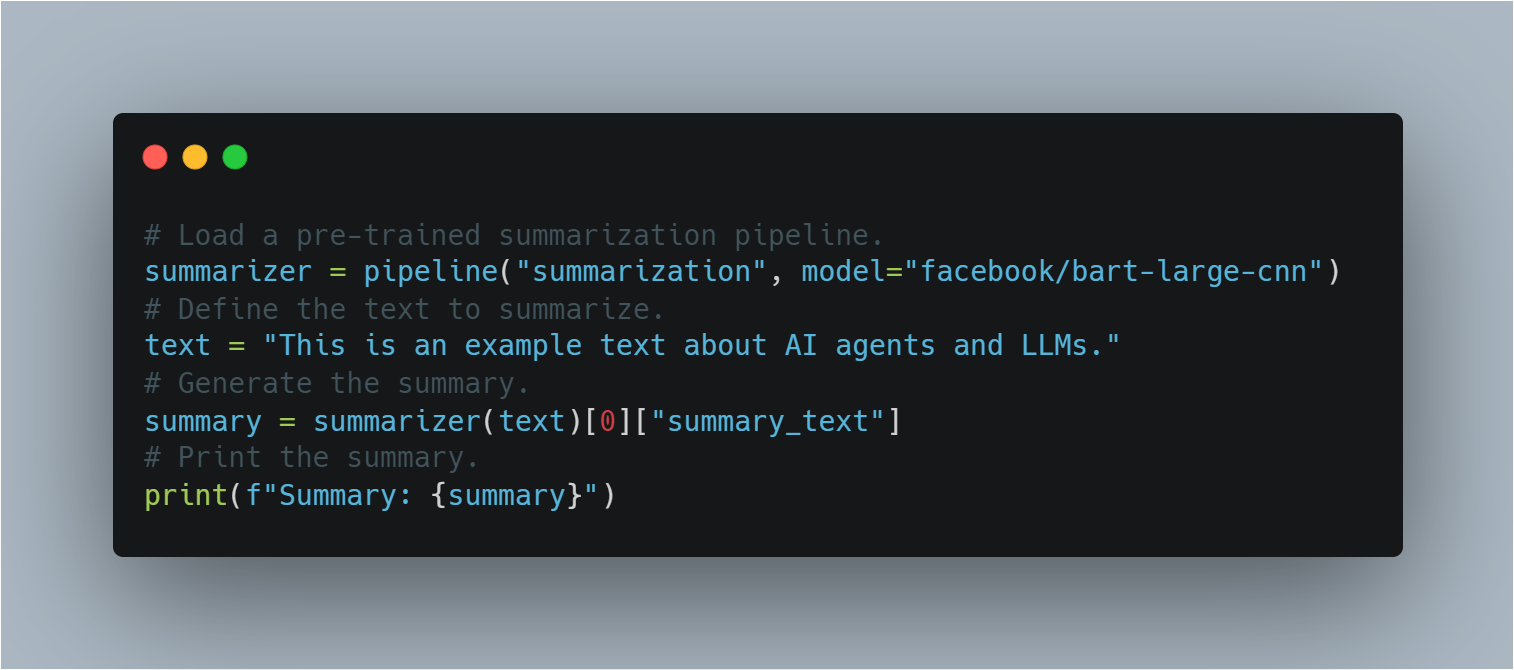

Резюме

: LLM могут сжать длинные тексты в краткие резюме, сохраняя ключевую информацию.

- Ответ на вопрос: Они могут提供更 точных ответов на вопросы на основе своей обширной базы знаний.

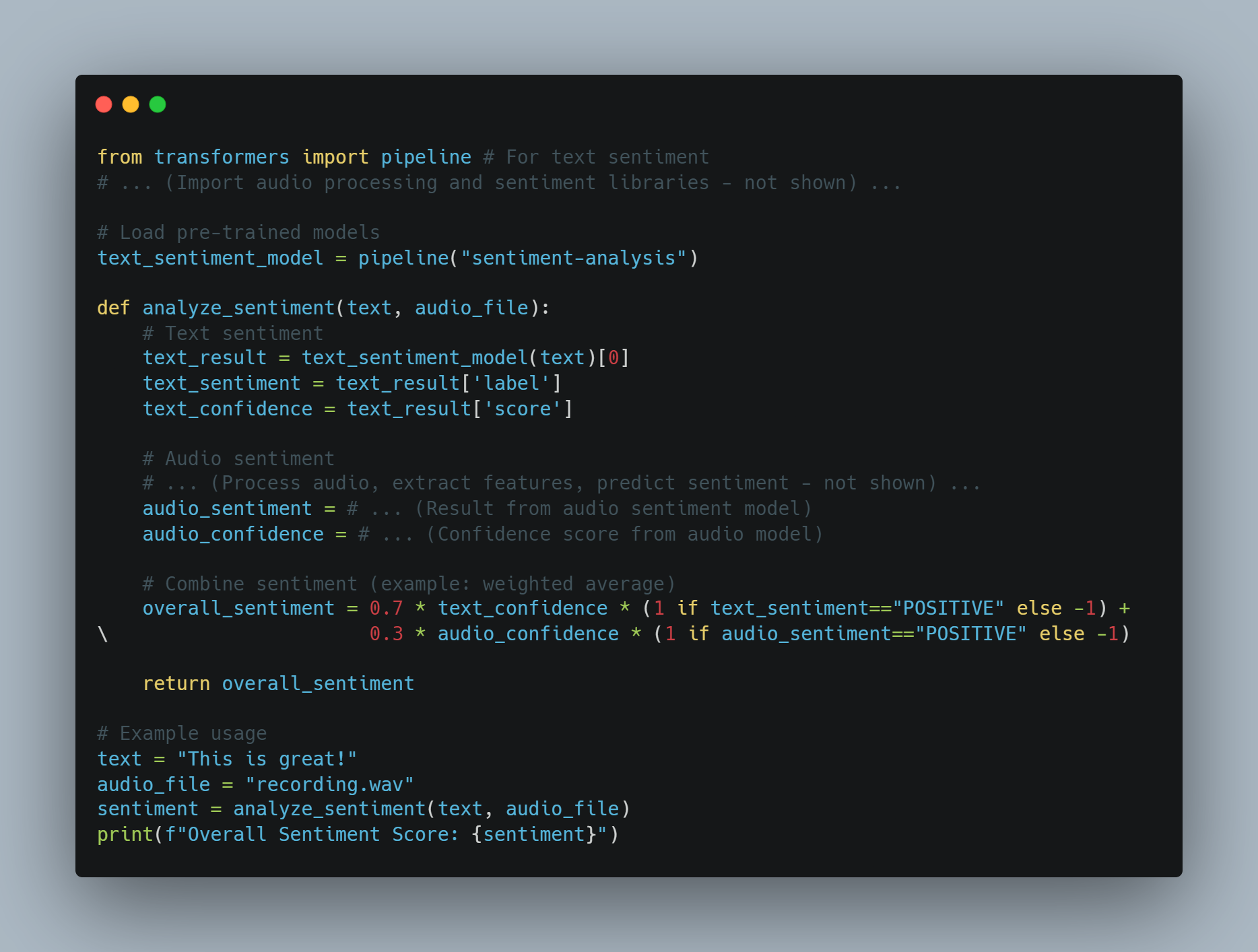

- Анализ эмоций: LLM могут анализировать и определять эмоции, выраженные в данном тексте.

- Генерация кода: Они могут генерировать фрагменты кода или целые функции на основе自然ного языкового описания.

Уровни агентов AIАгенты AI могут быть классифицированы по уровням в зависимости от их способностей и сложности.

- Уровень 1 (L1): Агенты AI в качестве научных помощников, где ученые устанавливают гипотезы и определяют задачи для достижения целей.

-

Уровень 2 (L2): Агенты AI, которые могут автономно выполнять конкретные задачи в определенных рамках, такие как анализ данных или простые решения.

- Уровень 3 (L3): Агенты AI, способные учиться на опыте и адаптироваться к новым ситуациям, улучшая процессы своего решения.

-

Уровень 4 (L4): Агенты AI с avanced reasonнing and problem-solving abilities, capable of handling complex, multi-step tasks.

- Уровень 5 (L5): Полностью автономные агенты AI, которые могут работать независимо в динамической среде, принимая решения и предпринимая действия без вмешательства человека.

Ограничения крупных моделей языка

Стоимость обучения и ограничения ресурсов

Крупные модели языка (LLMs), такие как GPT-3 и PaLM, революционизировали применение естественного языка (NLP) за счет использования техник глубокого обучения и огромных наборов данных.

Но эти усовершенствования приходят за значительный счет. Тренировка БПС требуетsubstantial computational resources, зачастую涉及thousands of GPUs и обширного потребления энергии.

По словам Сама Альтмана, генерального директора OpenAI, стоимость тренировки GPT-4 превысила $100 million. Это соответствует сообщаемому масштабу и сложности модели, с оценками, указывающими на примерно 1 триллион параметров. However,其他source提供不同的数字:

-

泄露的报告表明,GPT-4的训练成本约为$63 million, 考虑到计算能力和训练时间。

-

截至2023年年中,一些估计表明训练一个类似于GPT-4的模型可能需要大约$20 million,并需要大约55天,反映出效率的提升。

Эти высокие затраты на обучение и поддержку LLM ограничивают их широкое распространение и масштабируемость.

Ограничения данных и предрассудки

Эффективность LLM сильно зависит от качества и разнообразия обучающих данных. Несмотря на то, что модели обучены на огромных наборах данных, они могут все еще проявлять предубеждения, присутствующие в данных, что приводит к искаженным или неподходящим выводам. Эти предрассудки могут проявляться в различных формах, включая гендерные, расовые и культурные предрассудки, которые могут укреплять стереотипы и дезинформацию.

Кроме того, статичность обучающих данных означает, что LLM могут не быть обновлены до последней информации, что ограничивает их эффективность в динамической среде.

Специализация и сложность

Хотя LLM отлично справляются с общими задачами, они часто испытывают трудности с специализированными задачами, которые требуют знаний в специальной области и высокого уровня сложности.

Например, задачи в областях, таких как медицина, право и научные исследования, требуют глубокого понимания специальной терминологии и изощренного рассуждения, которые LLM могут не обладать изначально. Это ограничение требует интеграции дополнительных слоев экспертизы и точной настройки, чтобы сделать LLM эффективными в специализированных приложениях.

Ограничения ввода и чувствительности

Компьютерные программы, основанные на нейронных сетях, в основном обрабатывают текстовые входы, что ограничивает их способность взаимодействовать с миром в многокомпонентном порядке. хотя они могут генерировать и понимать текст, у них нет возможности обрабатывать прямо визуальные, слуховые или sensor inputs.

это ограничение препятствует их применению в областях, требующих всестороннего сенсорного объединения, таких как робототехника и автономные системы. например, компьютерные программы не могут объяснять визуальные данные с камеры или аудиосensor данные с микрофона без дополнительных процессорныхслоев.

ограничения в коммуникации и взаимодействии

текущие коммуникационные возможности компьютерных программ основаны на тексте, что ограничивает их способность участвовать в более глубоком и интерактивном общении.

например, хотя компьютерные программы могут генерировать текстовые ответы, они не могут производить видео содержание или голографические представления, которые все более важны в приложениях Virtua reality and Augmented reality (читать больше здесь). Это ограничение снижает эффективность компьютерных программ в средах, требующих обильного, многокомпонентного взаимодействия.

как преодолеть ограничения с помощью Агентов AI

агенты AI предлагают перспективные решения многих ограничений, с которыми сталкиваются компьютерные программы. эти агенты проектируются для работы автономно, воспринимать свое окружение, принимать решения и выполнять действия для достижения конкретных целей. при интеграции агентов AI с компьютерными программами можно улучшить их возможности и адресовать их внутренние ограничения.

- Улучшенный контекст и память: Агенты искусственного интеллекта могут сохранять контекст на протяжении множества взаимодействий, что позволяет обеспечивать более последовательные и контекстуально значимые ответы. Эта способность особенно полезна в приложениях, требующих долгосрочной памяти и непрерывности, таких как обслуживание клиентов и личные помощники.

-

Мультимодальная интеграция: Агенты искусственного интеллекта могут включать восприятие сенсорных входов из различных источников, таких как камеры, микрофоны и сенсоры, позволяя LLM обрабатывать и реагировать на визуальные, акустические и сенсорные данные. Эта интеграция критична для приложений в области робототехники и автономных систем.

-

Специальные знания и экспертность: AI agents can be fine-tuned with domain-specific knowledge, enhancing the ability of LLMs to perform specialized tasks. This approach allows for the creation of expert systems that can handle complex queries in fields such as medicine, law, and scientific research.

-

Interactive and Immersive Communication: AI agents can facilitate more immersive forms of communication by generating video content, controlling holographic displays, and interacting with virtual and augmented reality environments. This capability expands the application of LLMs in fields that require rich, multimodal interactions.

Несмотря на впечатляющие способности больших языковых моделей в обработке естественного языка, у них есть свои ограничения. Высокие затраты на обучение, смещения в данных, проблемы специализации, ограничения чувств и ограничения связи представляют собой значительные препятствия.

Но интеграция AI-агентов предлагает жизнеспособный путь для преодоления этих ограничений. Использование сильных сторон AI-агентов может улучшить функциональность, адаптируемость и приложимость LLM, тем самым проложив путь для более продвинутых и универсальных систем AI.

Глава 2: История искусственного интеллекта и AI-агентов

Зарождение искусственного интеллекта

Концепция искусственного интеллекта (AI) уходит своими корнями гораздо дальше современного цифрового века. Идея создания машин, способных к человеческому рассуждению, может быть прослежена до древних мифов и философских споров. Но формальное зарождение AI как научной дисциплины произошло в середине 20-го века.

Конференция в Дартмуте 1956 года, организованная Джоном McCarthy, Марвином Мински, НATHANIEL Rochester и Клодом Шэном, широко считается местом рождения AI как области исследований. Этот великийEvent brought together leading researchers to explore the potential of creating machines that could simulate human intelligence.

раннее восхищение и зима AI

ранние годы исследований AI были характеризованы неограниченным оптимизмом. Researchers made significant strides in developing programs capable of solving mathematical problems, playing games, and even engaging in rudimentary natural language processing.

но этот исходный энтузиазм был ослаблен признанием того, что создание настоящих интеллектуальных машин было намного сложнее, чем сначала предполагалось.

1970-е и 1980-е годы ознаменовали период сокращения финансирования и интереса к исследованиям AI, известный как “зима AI”. Этот спад был principalmente du à la faillite des systèmes AI de satisfaire aux attentes exagérées des premiers pionniers.

от систем на основе правил к Machine Learning

эра экспертных систем

1980-е годы стали свидетелями второго roaring interest in AI, primarily driven by the development of expert systems. These rule-based programs were designed to emulate the decision-making processes of human experts in specific domains.

Экспертные системы нашли применения в различных областях, включая медицину, финансы и инженерию. Однако их ограничивала неспособность приобретать знания из опыта или адаптироваться к новым ситуациям вне программируемых ими правил.

Развитие машинного обучения

Ограничения систем на основе правил открыли путь к смене Paradigm для машинного обучения. Этот подход, который стал превалировать в 1990-х и 2000-х годах, сфокусирован на разработке алгоритмов, которые могут leaned от данных и делать предсказания или решения.

Техники машинного обучения, такие как нейронные сети и машины поддержки vektorov, показали значительный успех в задачах, таких как распознавание моделей и классификация данных. Появление big data и увеличение вычислительной мощи еще больше ускорило развитие и применение алгоритмов машинного обучения.

Появление автономных агентов AI

от Narrow AI к General AI

По мере того, как технологии AI продолжали развиваться, исследователи начали исследовать возможность создания более versa и автономных систем. Этот shift marker ознаменовал переход от узких AI, предназначенных для конкретных задач, к стремлению создать искусственную общую интеллектуальность (AGI).

Цель AGI состоит в развитии систем, способных выполнять любую интеллектуальную задачу, которую может выполнять человек. Хотя истинная AGI остается далекой целью, были достигнуты значительные успехи в создании более гибких и адаптивных систем AI.

Роль глубокого обучения и нейронных сетей

Появление глубокого обучения, подмножества машинного обучения, основанного на искусственных нейронных сетях, стало ключевым моментом в развитии области AI.

Алгоритмы глубокого обучения, вдохновленные структурой и функцией человеческого мозга, продемонстрировали необыкновенные способности в таких областях, как распознавание изображений и голоса, обработка природных языков и игровая деятельность. Эти успехи положили основы для развития более сложных автономных агентов AI.

Характеристики и типы агентов AI

Агенты AI являются автономными системами, способными воспринимать свое окружение, принимать решения и выполнять действия для достижения конкретных целей. У них есть характеристики, такие как автономия, восприятие, реактивность, мышление, принятие решений, обучение, коммуникация и ориентация на цели.

Есть несколько типов агентов AI, each with unique capabilities:

-

Простые рефлективные агенты: реагируют на специфические стимулы на основе предdefinite rules.

-

Агенты на основе модели рефлексии: Поддерживают внутреннюю модель окружения для принятия решений.

-

Целевые агенты: Выполняют действия для достижения конкретных целей.

-

Агенты на основе полезности: Рассматривают потенциальные результаты и выбирают действия, максимизирующие ожидаемую полезность.

-

Обучающиеся агенты: Улучшают процесс принятия решений со временем с помощью техник машинного обучения.

Проблемы и этические соображения

По мере того, как системы искусственного интеллекта становятся всё более продвинутыми и автономными, они представляют важные соображения для обеспечения того, чтобы их использование оставалось в пределах социально приемлемых границ.

Крупные языковые модели (КЯМ), в частности, действуют как турбонаддувы производительности. Но это поднимает важный вопрос: Что будут эти системы турбонаддувать — доброе или злое намерение? Когда намерение за использованием ИИ является злонамеренным, становится необходимым для этих систем обнаруживать такое злоупотребление с помощью различных техник NLP или других инструментов, которые у нас есть.

Инженеры LLM имеют доступ к целому ряду инструментов и методологий для решения этих проблем:

-

Анализ настроения: Использовав анализ настроения, LLMs могут оценить эмоциональный тон текста, чтобы обнаружить вредное или агрессивное языкое поведение, помогая идентифицировать потенциальное неверно использование в коммуникационных платформах.

-

Фильтрация контента: Инструменты, такие как фильтрация ключевых слов и сопоставление моделей, могут быть использованы для предотвращения генерации или распространения вредного контента, такого как враждебные высказывания, дезинформация или откровенный материал.

-

Инструменты обнаружения предвзятости: Внедрение фреймворков для обнаружения предвзятости, таких как AI Fairness 360 (IBM) или Indicators of Fairness (Google), может помочь идентифицировать и смягчить предвзятость в языковых моделях, обеспечивая справедливое и равноправное функционирование систем AI.

-

Объясняемость техник

: Использование инструментов объясняемости, таких как LIME (Локально интерпретируемые модели-независимые объяснения) или SHAP (Согласно Шапли), позволяет инженерам понимать и объяснять процессы принятия решений в КПИ, что упрощает обнаружение и коррекцию незамыслованных поведений.

-

Тесты против атак: Simulating malicious attacks or harmful inputs, engineers can stress-test LLMs using tools like TextAttack or Adversarial Robustness Toolbox, identifying vulnerabilities that could be exploited for malicious purposes.

-

Этические руководящие принципы и схемы для AI: Принятие этических руководящих принципов разработки AI, таких как те, что предоставляют IEEE или Partnership on AI, может направлять создание ответственных систем AI, которые ставят приоритетом благо общества.

Помимо этих инструментов, вот почему нам нужна специальная Красная команда для ИИ — команды, которые тестируют LLM до предела, чтобы выявить лакуны в их защите. Красные команды моделируют адversarialные сценарии и обнаруживают уязвимости, которые могли бы остаться незамеченными.

Но важно осознать, что люди за продуктом имеют наибольшее влияние на него. Многие из атак и вызовов, с которыми мы сталкиваемся сегодня, существовали ещё до разработки LLM, что подчёркивает, что человеческий фактор остаётся центральным для обеспечения этичного и ответственного использования ИИ.

Интеграция этих инструментов и методов в процесс разработки, наряду с деятельностью внимательной Красной команды, важна для обеспечения того, чтобы LLM использовались для повышения позитивных итогов, а также для обнаружения и предотвращения их злоупотребления.

Глава 3: Где ИИ-агенты светят ярче всего

Уникальные сильные стороны ИИ-агентов

ИИ-агенты отличаются способностью автономно воспринимать окружающую среду, принимать решения и осуществлять действия для достижения конкретных целей. Эта автономия, в сочетании с передовыми возможностями машинного обучения, позволяет ИИ-агентам выполнять задачи, которые либо слишком сложны, либо слишком повторяющиеся для людей.

Следующие ключевые преимущества делают агентов искусственного интеллекта блестящими:

-

Автономность и Эффективность: Агенты искусственного интеллекта могут работать независимо без постоянного вмешательства человека. Эта автономия позволяет им выполнять задачи круглосуточно, значительно повышая эффективность и производительность. Например, чат-боты с искусственным интеллектом могут обработать до 80% рутинных запросов клиентов, снижая операционные расходы и улучшая время ответа.

-

Расширенное Решение Проблем: Агенты искусственного интеллекта могут анализировать огромные объемы данных для принятия информированных решений. Эта способность особенно ценна в таких областях, как финансы, где торговые боты с искусственным интеллектом могут существенно повысить эффективность торговли.

-

Ученье и адаптивность: Агенты AI могут учиться на опыте и адаптироваться к новым ситуациям. Этот процесс постоянного усовершенствования позволяет им улучшать свои показатели с течением времени. Например, AI-ассистенты здравоохранения могут помочь уменьшить ошибки в диагностике, улучшая результаты лечения.

-

Персонализация: Агенты AI могут предоставлять персонализированные опыты, анализируя поведение пользователей и их предпочтения. Модель рекомендаций Amazon, которая приводит к 35% его продаж, является хорошим примером того, как агенты AI могут улучшать опыт пользователей и повышать доходы.

为什么AI代理是解决方案

AI-агенты решают многие проблемы, с которыми сталкиваются традиционные программные системы и системы, управляемые человеком. Вот почему они являются preferable choice:

-

Скалярность: AI-агенты могут масштабировать операции без пропорционального увеличения затрат. Это масштабность является критическим для бизнесов, которые хотят вырасти без значительного увеличения своего рабочего персонала или операционных расходов.

-

Согласованность и надежность: Unlike humans, AI-агенты не страдают от усталости или непоследовательности. Они могут выполнять повторяющиеся задачи с высокой точностью и надежностью, обеспечивая устойчивое поведение.

-

Data-Driven Insights: AI-агенты могут обрабатывать и анализировать большие наборы данных, чтобы обнаружить модели и INSIGHTS, которые могли бы быть пропущены человеком. This capability is invaluable for decision-making in areas such as finance, healthcare, and marketing.

-

Сокращение затрат: Благодаря автоматизации повседневных задач, агенты AI могут уменьшить потребность в рабочей силе, что приводит к значительному сокращению затрат. Например, системы распознавания мошенничества, основанные на AI, могут экономлять миллиарды долларов США в год, снижая раскраinedные действия.

Условия, необходимые для хорошего выполнения агентов AI

Для обеспечения успешного развертывания и хорошего выполнения агентов AI необходимо соблюсти certain conditions:

-

Clear Objectives and Use Cases: Defining specific goals and use cases is crucial for the effective deployment of AI agents. This clarity helps in setting expectations and measuring success. For instance, setting a goal to reduce customer service response times by 50% can guide the deployment of AI chatbots.

-

Качественные данные: Агенты AI создаются и работают на основе высококачественных данных. Убедиться, что данные являются точными, реlevantными и актуальными, необходимо для того, чтобы агенты могли принимать высококачественные решения и работать эффективно.

-

Integration with Existing Systems: Seamless integration with existing systems and workflows is necessary for AI agents to function optimally. This integration ensures that AI agents can access the necessary data and interact with other systems to perform their tasks.

-

Continuous Monitoring and Optimization: Regular monitoring and optimization of AI agents are crucial to maintain their performance. This involves tracking key performance indicators (KPIs) and making necessary adjustments based on feedback and performance data.

-

Этические соображения и смягчение предрассудков: рассмотрение этических аспектов и ослабление предрассудков у САИ важно для обеспечения справедливости и всеобъемлющих возможностей. Внедрение мероприятий для обнаружения и предотвращения предрассудков поможет в строительстве доверия и обеспечении ответственного развертывания.

Лучшие практики для развертывания САИ

При развертывании САИ соблюдение лучших практик может обеспечить их успех и эффективность:

-

Определить цели и сценарии использования: ясно определить цели и сценарии использования САИ. Это помогает установить ожидания и измерять успех.

-

Выберите правильную платформу искусственного интеллекта: Выберите платформу искусственного интеллекта, соответствующую вашим целям, сценариям использования и существующей инфраструктуре. Учитывайте такие факторы, как возможности интеграции, масштабируемость и стоимость.

-

Разработайте комплексную базу знаний: Создайте хорошо структурированную и точную базу знаний, чтобы позволить агентам искусственного интеллекта предоставлять актуальные и надежные ответы.

-

Обеспечьте беспроблемную интеграцию: Интегрируйте агентов искусственного интеллекта с существующими системами, такими как CRM и технологии колл-центра, чтобы обеспечить единое клиентское взаимодействие.

-

Обучайте и оптимизируйте агентов искусственного интеллекта: Непрерывно обучайте и оптимизируйте агентов искусственного интеллекта с использованием данных из взаимодействий. Оценивайте производительность, выявляйте области для улучшения и соответствующим образом обновляйте модели.

-

Внедрите адекватные процедуры эскалации

: Установите протоколы для передачи сложных или эмоциональных вызовов человеческим агентам, обеспечивая гладкий переход и эффективное разрешение.

- Мониторинг и анализ производительности: Следите за ключевыми показателями производительности (КПИ), такими как ставки решения вызовов, среднее время обработки и оценки удовлетворения клиентов. Используйте инструменты аналитики для получения данных-ориентированных выводов и принятия решений.

- Обеспечение конфиденциальности и безопасности данных: важным являются жесткие меры безопасности, такие как анонимизация данных, обеспечение человеческого контроля, установление политики хранения данных и внедрение сильных методов шифрования для защиты данных клиентов и сохранения конфиденциальности.

AI-агенты + LLM: Новая эра умного программного обеспечения

Представьте программное обеспечение, которое не только понимает ваши запросы, но и может также выполнять их. Это обещание является результатом комбинации агентов искусственного интеллекта с большими языковыми моделями (БЯМ). Эта мощная пара создает новое поколение приложений, которые стали более интуитивными, способными и влиятельными, чем когда-либо раньше.

Агенты искусственного интеллекта: Выполнение не только простых задач

Часто сравниваемые с цифровыми помощниками, агенты искусственного интеллекта намного больше, чем просто доработанные следователи сценариев. Они включают в себя ряд изощренных технологий и работают на основе-framework, который позволяет динамическое принятие решений и действия.

-

Архитектура: Типичный агент искусственного интеллекта состоит из нескольких ключевых компонентов:

-

Сенсоры: Они позволяют агенту воспринимать свою среду, собирая данные из различных источников, таких как датчики, API или ввод пользователя.

-

Состояние убеждения: Это представляет понимание агентом мира на основе собранной информации. Оно постоянно обновляется по мере поступления новых данных.

-

Система рассуждений: Это ядро процесса принятия решений агентом. Она использует алгоритмы, часто основанные на методах укрепления обучения или планирования, для определения наилучшего курса действий на основе текущих убеждений и целей.

-

Актуаторы: Это инструменты агента для взаимодействия с миром. Они могут варьироваться от отправки API-запросов до управления физическими роботами.

-

-

Преимущества:

Традиционные искусственные интеллектуальные агенты, хотя и славятся эффективностью в обработке хорошо определенных задач, часто испытывают трудности следующим:

-

Обработка природного языка: Interpreting nuanced human language, handling ambiguity, and extracting meaning from context remain significant challenges.

-

Рассуждения с common sense: Current AI agents often lack the common sense knowledge and reasoning abilities that humans take for granted.

-

Общей трансформацией: Train agents to perform well on unseen tasks or adapt to new environments remains a key area of research.

-

LLM: Разблокирование понимания и генерации языка

LLM, обладающие огромными знаниями, закодированными в миллиардах параметров, приносят безпрецедентные языковые способности:

-

Архитектура Transformer: Основа большинства современных LLM является архитектурой Transformer, дизайн нейронной сети, который превосходно обрабатывает последовательные данные, такие как текст. Это позволяет LLM улавливать длинные зависимости в языке, что позволяет им понимать контекст и генерировать связный и контекстуально релевантный текст.

-

Возможности: LLM отлично справляются с широким спектром языковых задач:

-

Генерация текста: От написания креативной фантастики до генерации кода на многих языках программирования, LLM проявляют удивительную гибкость и креативность.

-

Ответы на вопросы: Они могут давать краткие и точные ответы на вопросы, даже когда информация разбросана по длинным документам.

-

Резюмирование: LLM могут сводить большие объемы текста в краткие резюме, извлекая ключевую информацию и отбрасывая незначимые детали.

-

-

Ограничения: несмотря на их впечатляющие способности, СМЯМ имеют ограничения:

-

Отсутствие привязки к реальному миру: СМЯМ в основном работают в области текста и неспособны взаимодействовать напрямую с физическим миром.

-

Потенциаль для предвзятости и иллюзорности: TRAINED на огромных, необученных данных, СМЯМ могут наследовать предвзятости, присутствующие в данных, и иногда генерировать фактически неверную или нелогичную информацию.

-

Сочетание: Bridging the Gap Between Language and Action

Комбинация AI агентов и СВП адресует ограничения каждого, создавая системы, которые являются и интеллектуальными и способными:

-

СВП в качестве трансляторов и планировщиков: СВП могут транслировать приказы自然ного языка в формат, который понимает AI агент, что позволяет более интуитивную взаимодействию между человеком и компьютером. Они также могут использовать свои знания, чтобы помочь агентам в планировании сложных задач, разбивая их на более маленькие, управляемые шаги.

- AI агенты как исполнители и учителя: AI агенты обеспечивают LLM возможность взаимодействия с миром, сбора информации и получения обратной связи о своих действиях. Этот реальный привязанность может помочь LLM научиться на опыте и улучшить свои показатели с течением времени.

Эта сильная связь идет впереди развития нового поколения приложений, которые sont plus intuitifs, adaptables et capables que jamais. Avec la poursuite du progrès des technologies à la fois des agents AI et LLM, nous pouvons attendre la mise en évidence de plus des applications innovantes et impactives, remodelant ainsi le paysage de l’édition logicielle et de l’interaction homme-ordinateur.

Exemples réels: Transformation des industries

Cette combinaison puissante est déjà provoquant des ondes à travers divers secteurs:

-

Клиентская служба: решение проблем с учетом контекста

- Пример: Представьте, что клиент связывается с онлайн-розничным продавцом по поводу задержанного поставочного заказа. Агент AI, работающий с помощью системы LLM, может понять обида клиента, получить доступ к истории заказов, отслеживать пакет в реальном времени и активно предлагать решения, такие как ускоренная доставка или скидка на следующий заказ.

-

Создание контента: генерация массового качественного контента

- Пример: команда маркетинга может использовать систему AI-агент + LLM для генерации целевых социальных медиа-постов, написания описаний продуктов или даже создания сценариев для видеороликов. Система LLM保证了内容的吸引力和信息性,同时 AI-агент обеспечивает процесс публикации и распределения.

-

Разработка программного обеспечения: Ускорение кодирования и отладки

- Пример: Разработчик может описать желаемую функцию программного обеспечения с использованием естественного языка. LLM может затем генерировать фрагменты кода, идентифицировать потенциальные ошибки и предлагать улучшения, значительно ускоряя процесс разработки.

-

Здравоохранение: Персонализация лечения и улучшение ухода за пациентами

- Пример: AI-агент с доступом к медицинской истории пациента и оборудованный LLM может отвечать на их вопросы, связанные со здоровьем, предоставлять персонализированные напоминания о приёме лекарств и даже предлагать предварительные диагнозы на основе их симптомов.

-

Закон: Стандартизация правового исследования и подготовки документов

- Пример: Адвокату нужно составить контракт с конкретными положениями и правовыми прецедентами. AI-агент, оснащенный LLM, может анализировать указания адвоката, искать в обширных правовых базах данных, идентифицировать соответствующие положения и прецеденты, и даже подготовить части контракта, значительно сокращая трудозатраты.

-

Создание видео: Легкое создание захватывающих видеороликов

- Пример: Маркетинговой команде нужно создать короткое видео, объясняющее особенности их продукта. Они могут предоставить AI-агенту + системе LLM концепцию сценария и предпочтения визуального стиля. LLM может затем сгенерировать детальный сценарий, предложить соответствующую музыку и визуальные элементы, и даже отредактировать видео, автоматизировав значительную часть процесса создания видео.

-

Архитектура: проектирование зданий с помощью AI-обеспеченных знаний

- Пример: Архитектор проектирует новый офисный здание. Он может использовать систему AI-агента + LLM, чтобы ввести свои цели дизайна, такие как максимизация естественного света и оптимизация использования пространства. LLM может затем проанализировать эти цели, сгенерировать различные варианты дизайна и даже симулировать, как здание будет функционировать под различными экологическими условиями.

-

Строительство: улучшение безопасности и эффективности на строительных объектах

- Пример: Агент AI, оборудованный камерой и датчиками, может контролировать строительный объект в поисках опасностей безопасности. Если работник не носит соответствующего снаряжения или оборудование оставлено в опасном положении, LLM может анализировать ситуацию, оповещать руководителя стройки и даже автоматически останавливать работы, если это необходимо.

Будущее здесь: новый эпоха разработки программного обеспечения

Сочетание агентов AI и LLM ознаменовало значительный шаг вперед в разработке программного обеспечения. Будучи продолжающими развиваться, эти технологии могут ожидать еще более инновационных применений, трансформируя отрасли, уStreamlining процессов, и создавая целые новые возможности для взаимодействия человек-компьютер.

AI агенты наиболее яркими в областях, требующих обработки огромных объемов данных, автоматизации повторяющихся задач, принимания сложных решений и обеспечения индивидуальных ощущений. При соблюдении необходимых условий и соблюдении лучших практик организации могут использовать полный потенциал AI агентов, чтобы двигать инновации, эффективность и рост.

Глава 4: Философская основа умных систем

Развитие умных систем, особенно в области искусственного интеллекта (AI), требует глубокого понимания философских принципов. В этой главе рассматриваются коренные философские идеи, которые формируют дизайн, разработку и использование AI. Внимание уделено важности согласования прогресса технологии с этическими ценностями.

Философская основа умных систем не является только теоретическим упражнением – это жизненно важная структура, которая гарантирует, что технологии AI приносят пользу человечеству. Продвигая справедливость, инклюзивность и улучшая качество жизни, эти принципы помогают направлять AI на служение нашим лучшим интересам.

Этические соображения в разработке AI

По мере того, как системы AI становятся все более интегрированными в каждую сферу человеческой жизни, от здравоохранения и образования до финансов и управления, нам надо строго исследовать и внедрить этические принципы, направляющие их дизайн и развертывание.

Основная этическая вопрос касается того, как AI могут быть созданы для того, чтобы воплощать и поддерживать человеческие ценности и моральные принципы. Этот вопрос играет центральную роль в том, как AI будет формировать будущее обществ по всему миру.

В центре этой этической дискуссии находится принцип благожелательности, который является краеугольным камнем моральной философии и учитывает, что действия должны направляться на совершение добра и улучшение блага индивидов и общества в целом (Floridi & Cowls, 2019).

В контексте ИТ, благожелательность означает проектирование систем, которые активно способствуют процветанию человека — системы, которые улучшают результаты здравоохранения, увеличивают возможности образования и содействуют экономическому росту справедливости.

Но применение благожелательности в ИТ далеко от простого. Оно требует сложного подхода, который тщательно сопоставит потенциальные преимущества ИТ с возможными рисками и вредами.

Одним из основных проблем при применении принципа благожелательности к развитию ИТ является необходимость сбалансировать инновации и безопасность.

ИТ обладает потенциалом революционизировать области, такие как медицина, где прогнозирующие алгоритмы могут диагностировать болезни раньше и с большей точностью, чем врачи-люди. Но без жесткого этического надзора эти технологии могли бы усугубить существующие неравенства.

Это, например, может произойти, если технологии будут в основном размещены в богатых регионах, в то время как обслуженные общины по-прежнему останутся без доступа к базовому здравоохранению.

В связи с этим этическое развитие ИТ требует не только focus на максимизации преимуществ, но и активного подхода к уменьшению рисков. Это означает внедрение надежных защитных мероприятий, чтобы предотвратить неправильное использование ИТ и обеспечить, чтобы эти технологии не случайно причиняли вред.

Этическая основа ИТ также должна быть имманентно инклюзивной, обеспечивая равномерное распределение благ ИТ среди всех слоев общества, включая те, которые традиционно являются маргинализированными. Это требует приверженности принципам справедливости и справедливости, чтобы ИТ не просто укрепляла статус-кво, но активно работала на разрушение системных неравенств.

К примеру, автоматизация профессиональных задач с использованием AI может значительно увеличить производительность и экономический рост. Однако она также может привести к значительному изменению рабочих мест, особенно сказываясь на низкоквалифицированных рабочих.

Как вы можете видеть, этически устойчивая основа AI должна включать стратегии для равномерного распределения выгод и обеспечения поддержки для тех, кто негативно сказывается от усовершенствований AI.

Этическое развитие AI требует непрерывного взаимодействия с различными заинтересованными сторонами, включая этических ученых, технологических специалистов, политических деятелей и общин, которые будут наиболее затронуты этими технологиями. Эта междисциплинарная кооперация гарантирует, что AI-системы не разрабатываются в условиях изоляции, а instead are instead shaped by a broad spectrum of perspectives and experiences.

Именно благодаря этому коллективному усилию мы можем создавать AI-системы, которые не только отражают, но и поддерживают ценности, определяющие нашу человечность – сострадание, справедливость, уважение автономии и приверженность общему благу.

Этические соображения в развитии AI не являются просто руководствами, но являются необходимыми элементами, которые определяют, будет ли AI служить силой добра в мире. Утверждая, что AI основано на принципах благожелательности, справедливости и инклюзивности и поддерживая осторожный подход to the balance of innovation and risk, мы можем убедиться, что развитие AI не просто ускоряет технологии, но также повышает качество жизни всех членов общества.

По мере того, как мы продолжаем исследовать возможности AI, чтобы эти этические соображения оставались в центре нашего стремления, направляя нас к будущему, где AI настоящим образом будет служить человечеству.

Императив дизайна искусственного интеллекта, ориентированного на человека

Дизайн искусственного интеллекта, ориентированный на человека, превосходит простые технические соображения. Он основан на глубоких философских принципах, которые придают приоритет человеческому достоинству, автономии и агентству.

Этот подход к разработке искусственного интеллекта фундаментально укоренен в кантовской этической системе, которая утверждает, что людей следует рассматривать как конечные цели, а не просто как средства для достижения других целей (Кант, 1785 год).

Импликации этого принципа для дизайна искусственного интеллекта глубоки, требуя, чтобы системы искусственного интеллекта разрабатывались с неизменным фокусом на служение интересам человека, сохранение человеческого агентства и уважение индивидуальной автономии.

Техническая реализация принципов, ориентированных на человека

Повышение человеческой автономии через искусственный интеллект: Понятие автономии в системах искусственного интеллекта критично, особенно в обеспечении того, чтобы эти технологии давали пользователю полномочия, а не контролировали или несправедливо влияли на них.

С технической точки зрения это включает в себя разработку систем искусственного интеллекта, придающих приоритет автономии пользователя, предоставляя им необходимые инструменты и информацию для принятия обоснованных решений. Для этого модели искусственного интеллекта должны быть осведомлены о контексте, что означает, что они должны понимать конкретный контекст, в котором принимается решение, и соответственно корректировать свои рекомендации.

С точки зрения проектирования систем это включает в себя интеграцию контекстуального интеллекта в модели искусственного интеллекта, что позволяет этим системам динамически адаптироваться к окружению пользователя, его предпочтениям и потребностям.

К примеру, в медицине, система, основанная на AI, которая помогает врачам диагностиковать состояния здоровья, должна учитывать уникальную медицинскую историю пациента, текущие симптомы, и даже психологическое состояние, чтобы предложить рекомендации, которые поддерживают экспертизу врача, а не заменили бы ее.

Этот контекстуальный адаптационный процесс помогает AI оставаться инструментом поддержки, улучшающим, а не умаляющим, автономию человека.

Гарантирование прозрачности процессов принятия решений: Прозрачность в AI-системах является фундаментальным требованием для обеспечения того, что пользователи могут верить и понимать решения, принимаемые этими технологиями. technically, это транслируется как необходимость разъясняемой AI (XAI), которая заключается в разработке алгоритмов, которые могут ясно представить причину за их решения.

Это особенно важно в областях, таких как финансы, медицина и уголовное право, где непрозрачные процессы принятия решений могут привести к недоверию и этическим проблемам.

Согласно нескольким техническим подходам можно достичь объяснительности. Один из наиболее распространенных методов – это постфукситивная интерпретируемость, когда модель AI-генерирует объяснение после принятия решения. Это может涉及 разбиение решения на его компонентных факторов и показать, как каждый из них внес свой вклад в итоговое результат.

Другая стратегия состоит в применении по умолчанию прозрачных моделей, в которых архитектура модели направлена на то, чтобы ее решения были прозрачными. Например, модели, такие как решение деревьев и линейные модели, являются естественно прозрачными, поскольку их процесс принятия решений легко следовать и понять.

Однако основная проблема в реализации объясняемого AI заключается в нахождении баланса между прозрачностью и поperformацией. Оften, более сложные модели, такие, как глубокие нейронные сети, менее прозрачны, но более точны. Таким образом, разработка AI центрированного на человеке должна учитывать торговый оператор между прозрачностью модели и ее предсказательной силой, обеспечивая то, что пользователи могут верить и понять решения AI без потери точности.

Разрешение значимого руководства Homo sapiens: значимое руководство Homo sapiens очень важно для обеспечения работы AI систем в этических и операционных рамках. Это руководство включает создание AI систем с safety и оверIDE системами, которые позволяют операторам вмешаться, когда это необходимо.

Техническое реализация руководства Homo sapiens может быть принята several ways.

Одним из подходов является включение систем с Homo sapiens в цикл, где процессы принятия решений AI постоянно наблюдаются и оцениваются операторами Homo sapiens. Эти системы проектировались для того, чтобы позволить вмешательство Homo sapiens на критических перекрёстках, обеспечивая, что AI не действует автономно в ситуациях, требующих этических заключений.

В случае систем автономного оружия, контроль человека является необходимым для предотвращения того, что AI делает решения, связанные с жизнью и смертью, без вклада человека. Это может включать установление строгих операционных границ, которые AI не может пересекать без человеческого разрешения, тем самым внедряя этические предохранители в систему.

Другим техническим моментом является разработка аудитных трейлов, которые являются записями всех решений и действий, совершенных системой AI. Эти трейлы обеспечивают прозрачную историю, которую человеческие операторы могут проверять для обеспечения соблюдения этических стандартов.

Аудитные трейлы особенно важны в таких секторах, как финансы и право, где решения должны быть документально подтверждены и обоснованы для поддержания общественного доверия и соответствия регулятивным требованиям.

Сочетание автономии и контроля: Ключевой технический вызов в человекоцентрическом AI заключается в нахождении правильного баланса между автономией и контролем. Хотя системы AI разрабатываются для автономной работы во многих сценариях, важно, чтобы эта автономия не подрывала человеческий контроль или наблюдение.

Этот баланс может быть достигнут через внедрение уровней автономии, которые определяют степень независимости AI в принятии решений.

Например, в полуавтономных системах, таких как самоуправляемые автомобили, уровни автономии варьируются от базовой помощи водителю (где человек остается под полным контролем) до полной автоматизации (где AI отвечает за все функции управления автомобилем).

Дизайн этих систем должен обеспечить, чтобы при любом уровне автономии человеческий оператор сохранял возможность вмешаться и переопределить AI, если это необходимо. Это требует изысканных контрольных интерфейсов и систем поддержки решений, которые позволяют людям быстро и эффективно взять управление, когда это необходимо.

Кроме того, разработка этических рамок AI является необходима для направления самостоятельных действий систем AI. Эти рамки – это наборы правил и направлений, встроенных в AI и указывающих, каким образом оно должно вести себя в этически сложных ситуациях.

Например, в здравоохранении, этическая рамка AI может включать правила о соглашении пациента, конфиденциальности и определении приоритетов лечения на основе медицинских потребностей, а не финансовых соображений.

При встроении этих этических принципов непосредственно в процессы принятия решений AI, разработчики могут уверенно заявить, что автономия системы осуществляется способом, согласным человеческим ценностям.

Интеграция человекоцентричных принципов в дизайн AI является не только философской идеей, но и технической необходимостью. Улучшая автономию человека, обеспечивая прозрачность, позволяя значительному надзору и精巧но балансируя автономию с контролем, системы AI могут быть разработаны таким образом, что соответствуют истинному служению человечеству.

Эти технические соображения обеспечивают создание AI, которая не только усиливает человеческие возможности, но и уважает и поддерживает ценности, которые являются фундаментом нашего общества.

По мере продолжения развития AI, приверженность дизайну, центрированному на человеке, будет ключевой для обеспечения того, чтобы эти могущественные технологии были использованы этическим и ответственным образом.

Как обеспечить, чтобы ИИ выгодно влиял на человечество: улучшение качества жизни

Когда вы продвигаетесь в разработке систем ИИ, важно опора ваших усилий на этическую основу utilitarianism — философию, которая акцентирует улучшение общего счастья и благополучия.

В этом контексте ИИ обладает потенциалом решать важные общественные проблемы, особенно в таких областях как здравоохранение, образование и устойчивость окружающей среды.

Цель состоит в создании технологий, которые значительно улучшают качество жизни для всех. Но преследование этого амбициозного целевого охраняемое комплексностью. Utilitarianism предлагает убедительные причины для широкого применения ИИ, но также выносит на передний план важные этические вопросы о том, кто извлекает выгоду и кто может оказаться за бортом, особенно среди уязвимых групп населения.

Чтобы обойти эти проблемы, нам нужна сложная, технически проинформированная стратегия — одна, которая балансирует широкий поиск общественного блага с необходимостью справедливости и справедливости.

При применении принципов utilitarianism к ИИ ваше внимание должно быть сфокусировано на оптимизации результатов в конкретных областях. В здравоохранении, например, диагностические средства, driven by AI, имеют потенциал значительного улучшения исходов лечения за счет позволяющего более раннее и точное диагнозирование системы. Эти системы могут анализировать обширные данные, чтобы обнаружить модели, которые могут упустить человеческие практики, тем самым расширяя доступ к качественному обслуживанию, особенно в недостаточно ресурсированных условиях.

Но внедрение these технологий требует осторожного рассмотрения, чтобы избегать усиления существующих неравенств. Данные, используемые для обучения моделей AI, сильно варьируются по регионам, влияя на точность и надежность этих систем.

Этот разрыв подчеркивает важность установления прочных структур управления данными, которые обеспечивают, чтобы ваши AI-основанные решения в здравоохранении были как репрезентативными, так и справедливыми.

В области образования AI способность personalize learning является обещающей. Системы AI могут адаптировать учебный контент для соответствия особым потребностям отдельных студентов, тем самым enhancing learning outcomes. Analyzing данные о показателях успеваемости и поведения студентов, AI может идентифицировать места, где студент может быть в difficulty и предоставить целевую поддержку.

But while you work towards these benefits, it’s crucial to be aware of the risks — such as the potential to reinforce biases or marginalize students who don’t fit typical learning patterns.

Mitigating these risks requires the integration of fairness mechanisms into AI models, ensuring they do not inadvertently favor certain groups. And maintaining the role of educators is critical. Their judgment and experience are indispensable in making AI tools truly effective and supportive.

In terms of environmental sustainability, AI’s potential is considerable. AI systems can optimize resource use, monitor environmental changes, and predict the impacts of climate change with unprecedented precision.

Например, ИИ может анализировать огромные объемы экологических данных, чтобы предсказывать погодные условия, оптимизировать потребление энергии и минимизировать отходы – действия, способствующие благосостоянию текущих и будущих поколений.

Но это технологическое развитие приносит и свои собственные проблемы, особенно в связи с экологическим воздействием самих ИИ-систем.

Потребление энергии, необходимое для работы масштабных ИИ-систем, может компенсировать экологические преимущества, которые они намерены достичь. Таким образом, разработка энергоэффективных ИИ-систем является ключевой для обеспечения того, что их положительное влияние на устойчивость не будет поставлено под угрозу.

Когда вы разрабатываете ИИ-системы с утилитарными целями, важно также учитывать последствия для социальной справедливости.Utilitarianism фокусируется на максимизации общей счастливости, но не исходя из этого активизирует распределение выгод и негативных последствий среди различных социальных групп.

Это поднимает возможность того, что ИИ-системы неравномерно выгодят тех, кто уже обладает привилегиями, в то время как маргинализированные группы могут лишь слабо улучшить свое положение.

Чтобы этому противостоять, ваш процесс разработки ИИ должен включать принципы, сфокусированные на равенстве, убеждаясь, что выгоды распределяются Fairly и что любые возможные вредам обращаются внимание. Это может涉及 создание алгоритмов, направленных на уменьшение предрассудков, и включение в процесс разработки различных точек зрения.

Во время разработки систем АИ, направленных на повышение качества жизни, важно найти баланс между утилитарной целью максимизации блага и необходимостью справедливости и Fairness. Это требует изящного, технически обоснованного подхода, который рассматривает более широкие последствия развертывания систем AI.

Продуктивно создавая AI системы, которые являются как эффективными, так и равноправными, вы можете способствовать будущему, где технологические усовершенствования истинно обслуживают различные потребности общества.

Внедрь защитные меры против возможного вреда

При разработке технологий AI, вы должны признать внутреннюю возможность для вреда и активно устанавливать устойчивые защитные меры, чтобы смягчить эти риски. Эта ответственность глубоко укоренена в деONTOLOGICAL этической. Эта ветка этики акцентирует внимание на моральную обязанность соблюдать установленные правила и стандарты этической политики, обеспечивая сходство созданных вами технологий с основными моральными принципами.

Внедрение жестких протоколов безопасности не является только предохранительным, но и моральным обязательством. Эти протоколы должны включать всесторонние тесты для определения предвзятости, прозрачность в алгоритmic процессах и ясные механизмы для управления ответственностью.

Такие защитные меры крайне важны для предотвращения непреднамеренного вреда, который AI системы могут причинить, either through biased decision-making, opaque processes, or lack of oversight.

На практике внедрение этих мер требует глубокого понимания как технических так и этических аспектов AI.

Тестирование на предвзятость, например, включает не только идентификацию и коррекцию предвзятостей в данных и алгоритмах, но и понимание более широких социальных последствий этих предвзятостей. Вы должны убедиться, что ваши модели AI тренировались на различных, представительных наборах данных и регулярно оценивались для обнаружения и исправления любых предвзятостей, которые могут возникнуть с течением времени.

С другой стороны, требования прозрачности требуют, чтобы системы AI были разработаны так, что их процессы принятия решений легко понимались и проверялись пользователями и заинтересованными сторонами. Это включает разработку понятных моделей AI, которые предоставляют ясные, интерпретируемые выходы, позволяя пользователям видеть, как принимаются решения, и обеспечивая, чтобы эти решения были обоснованны и справедливы.

Кроме того, механизмы ответственности очень важны для поддержания доверия и обеспечения ответственного использования систем AI. Эти механизмы должны включать четкие руководства о том, кто ответственен за результаты решений AI, а также процессы для обработки и исправления любых ущербов, которые могут произойти.

Вы должны установить рамку, где этические соображения интегрированы во все стадии разработки AI, от исходного дизайна до развертывания и далее. Это включает не только следование этическим руководствам, но и постоянное мониторинг и настройку систем AI, когда они взаимодействуют с реальным миром.

При внедрении этих гарантий в самую основу разработки AI вы можете помочь обеспечить, что технологический прогресс служит большему благу без приводствия незапланированных негативных последствий.

Роль человеческого надзора и циклов обратной связи

Человеческий надзор в СИ является критическим компонентом для обеспечения этической практики развертывания AI. Принцип ответственности подкрепляет необходимость непрерывного участия людей в работе AI, особенно в серьезных средах, таких как здравоохранение и уголовное правосудие.

Циклы обратной связи, в которых используется ввод человека для усовершенствования и улучшения систем AI, являются необходимыми для поддержания ответственности и адаптивности (Raji et al., 2020). Эти циклы позволяют исправлять ошибки и интегрировать новые этические соображения в связи с эволюцией общественных ценностей.

При внедрении человеческого надзора в системы AI разработчики могут создавать технологии, которые не только эффективны, но и соответствуют этическим нормам и ожиданиям людей.

Кодирование этики: перевод философских принципов в AI системы

Перевод философских принципов в AI системы является сложной, но необходимой задачей. Этот процесс включает внедрение этических соображений в собственно код, управляющий алгоритмами AI.

Понятия, такие как справедливость, справедливость и самоуправление, должны быть кодифицированы в AI системах, чтобы убедиться, что их действия отражают общественные ценности. Это требует многодисциплинарного подхода, в котором этические ученые, инженеры и социологи сотрудничают, чтобы определить и реализовать этические руководства в процессе кодирования.

Цель состоит в создании AI систем, которые не только технически компетентны, но и морально устойчивы, способные принимать решения, уважающие достоинство человека и способствующие общественному благу (Mittelstadt et al., 2016).

Продвижение инклюзивности и равного доступа в разработку и развертывание AI

Включение и равноправный доступ являются фундаментальными для этического развития ИИ. Концепция справедливости как справедливости Джона Роулза (Rawlsian) обеспечивает философскую основу для обеспечения того, чтобы системы ИИ были разработаны и внедрены таким образом, чтобы поощрять блага всех членов общества, особенно самых уязвимых (Роулз, 1971).

Это требует проактивных усилий включить различные точки зрения в процесс разработки, особенно из не представленных групп и Южного полушария.

Проинтегрировав эти различные точки зрения, разработчики ИИ могут создавать системы, которые более эквивалентны и реагируют на потребности ширшего спектра пользователей. Кроме того, обеспечение эквивалентного доступа к технологиям ИИ важно для предотвращения усиления существующих социальных неравенств.

Решайте вопросы алгоритмической несправедливости и справедливости

Алгоритмическая несправедливость является значительным этическим проблемой в развитии ИИ, поскольку нейтральные алгоритмы могут поддерживать и даже усиливать социальные неравенства. решая эту проблему требуется стремление к процедурной справедливости, обеспечивая, чтобы системы ИИ были разработаны через справедливые процессы, учитывающие влияние на все заинтересованные стороны (Ниссенауб, 2001).

Это заключается в идентификации и смягчении предвзятых взглядов в тренировочных данных, разработке ясных и объясняемых алгоритмов и внедрении проверок справедливости на различных стадиях жизненного цикла ИИ.

При решении вопросов алгоритмической несправедливости разработчики могут создавать системы ИИ, которые способствуют более справедливому и эквивалентному обществу, а не усилению существующих различий.

Включите различные точки зрения в разработку ИИ

Включение различных точек зрения в разработку искусственного интеллекта необходимо для создания систем, которые будут инклюзивными и справедливыми. Участие голосов представителей малопредставленных групп гарантирует, что технологии искусственного интеллекта не будут просто отражать ценности и приоритеты узкого сегмента общества.

Этот подход соответствует философскому принципу делиберативной демократии, который подчеркивает важность инклюзивных и участвующих процессов принятия решений (Хабермас, 1996).

Содействуя разнообразному участию в разработке искусственного интеллекта, мы можем гарантировать, что эти технологии разрабатываются для обслуживания интересов всего человечества, а не только немногих привилегированных.

Стратегии преодоления разрыва в области искусственного интеллекта

Разрыв в области искусственного интеллекта, характеризующийся неравным доступом к технологиям искусственного интеллекта и их преимуществами, представляет собой значительное вызов для глобальной справедливости. Преодоление этого разрыва требует обязательства перед распределительной справедливостью, гарантируя, что преимущества искусственного интеллекта распространяются широко по различным социоэкономическим группам и регионам (Сен, 2009).

Мы можем добиться этого через инициативы, способствующие доступу к образованию в области искусственного интеллекта и ресурсам в недооцененных общинах, а также через политики, поддерживающие справедливое распределение экономических выгод, приносимых искусственным интеллектом. Решая проблему разрыва в области искусственного интеллекта, мы можем гарантировать, что искусственный интеллект вносит свой вклад в глобальное развитие способом, который является инклюзивным и справедливым.

Находите баланс между инновациями и этическими ограничениями

Нахождение баланса между стремлением к инновациям и этическими ограничениями является ключевым аспектом ответственного продвижения в области искусственного интеллекта. Принцип предосторожности, который призывает к осторожности в условиях неопределенности, особенно актуален в контексте разработки искусственного интеллекта (Сандин, 1999).

Новаторство, driving progress, должно быть смягчено przez этические соображения, защищающие от возможных вредных последствий. Это требует тщательного анализа рисков и выгод новых технологий AI, а также внедрения регламентных рамок, обеспечивающих соблюдение этических стандартов.

Проведя баланс между инновацией и этическими ограничениями, мы можем содействовать развитию технологий AI, которые являются одновременно передовыми и соответствующими общественному благосостоянию.

Как вы можете видеть, философская основа умных систем обеспечивает критическую структуру для обеспечения того, что технологии AI разрабатываются и внедряются в этических, включающих и полезных для всего человечества способах.

При опоре на эти философские принципы развитие AI, мы можем создавать умные системы, которые не только усовершенствуют технологические возможности, но и улучшают качество жизни, способствуют справедливости и обеспечивают равномерное распределение благ AI по всему обществу.

Глава 5: AI-агенты как улучшители LLM

Слияние AI-агентов с крупными моделями языка (LLM) представляет собой фундаментальный сдвиг в искусственном интеллекте, решая критические ограничения LLM, которые limit their broader applicability.

Эта интеграция позволяет машинам преодолеть свои традиционные роли, перейдя от пассивных текстовых генераторов к автономным системам, способным к динамическому ratioch и принятию решений.

Так как системы AI все более управляют критическими процессами в различных областях, понимание того, как AI-агенты заполняют пробелы в возможностях LLM, является необходимым для реализации их полного потенциала.

Преодоление пробелов в возможностях LLM

LLM, несмотря на свою мощь, имеют врожденные ограничения, связанные с данными, на которых они обучались, и статичной природой их архитектуры. Эти модели работают в рамках фиксированного набора параметров, обычно определенных корпусом текста, использованного во время их обучения.

Это ограничение означает, что LLM не могут автономно искать новую информацию или обновлять свою базу знаний после обучения. В результате LLM часто устаревают и не могут предоставлять контекстно-релевантные ответы, требующие реальных данных или понимания, выходящего за пределы их исходных данных обучения.

AI-агенты преодолевают эти пробелы, динамически интегрируя внешние источники данных, что позволяет расширить функциональные возможности LLM.

Например, LLM, обученная на финансовых данных до 2022 года, может предоставлять точные исторические анализы, но будет испытывать трудности при генерации актуальных прогнозов рынка. AI-агент может дополнить эту LLM, получая актуальные данные с финансовых рынков и применяя их для генерации более соответствующих и текущих анализов.

Такая динамическая интеграция гарантирует, что результаты не только исторически точны, но и контекстно соответствуют текущим условиям.

Повышение автономии принятия решений

Еще одним значительным ограничением LLM является их отсутствие автономных возможностей принятия решений. LLM отлично справляются с генерацией языковых выводов, но не могут справиться с задачами, требующими сложного принятия решений, особенно в средах, характеризующихся неопределенностью и изменениями.

СHORTAGE ОF FUNCTIONALITY PRIMARILY ОCCURS DUE TО THE MODEL’S DEPENDENCE ОN EXISTING DATA AND THE LACK ОF MECHANISMS FOR ADAPTIVE REASONING OR LEARNING FROM NEW EXPERIENCES AFTER DEPLOYMENT.

АGЕNTЫ ИИ РЕШАЮТ ЭТО, ОПРЕДЕЛЯЯ НЕОБХОДИМУЮ ИНФРАСТРУКТУРУ ДЛЯ АВТОНОМНОГО ПРИНЯТИЯ РЕШЕНИЙ. ОНИ МОГУТ ВЗЯТЬ СТАТИЧЕСКИЕ ВЫВОДЫ ЛПМ И ОБРАБОТАТЬ ИХ С ПОМОЩЬЮ ПРОГРАММНЫХ ФРАМЕВОК ДЛЯ ПРОВЕРКИ ЗНАНИЙ, ОСНОВАННЫХ НА ПРАВИЛАХ, ЭВРИСТИКИ ИЛИ МОДЕЛЕЙ УСИЛЕНИЯ ОБУЧЕНИЯ.

Например, в медицинской сфере ЛПМ может создать список потенциальных диагнозов на основе симптомов и медицинской истории пациента. Но без агента ИИ ЛПМ не может оценить эти варианты или рекомендовать курс действий.

Агент ИИ может взять на себя роль оценки этих диагнозов в соответствии с текущей медицинской литературой, данными о пациенте и контекстуальными факторами, в конечном итоге принимая более обоснованное решение и предлагая выполнимые следующие шаги. Эта синергия преобразует выводы ЛПМ из простых предложений в выполнимые, основанные на контексте решения.

РЕШЕНИЕ ПРОБЛЕМЫ ПОЛНОТЫ И СООТВЕТСТВИЯ

Полнота и последовательность являются критическими факторами для обеспечения надежности выводов ЛПМ, особенно в сложных задачах рассуждения. Из-за своей параметризованной природы ЛПМ часто генерируют ответы, которые либо неполны, либо лишены логической связности, особенно при работе с многошаговыми процессами или требующими всестороннего понимания различных областей.

Эти проблемы происходят из изолированной среды, в которой работают ЛПМ, где они не могут сравнивать или проверять свои выводы с внешними стандартами или дополнительной информацией.

Агенты AI играют решающую роль в смягчении этих проблем, внедряя итеративные механизмы обратной связи и слои валидации.

например, в сфере права, LLM может написать первоначальную версию законодательного заявления на основе своих тренировочных данных. Но этот проект может пропустить certain precedents или не организовать аргумент логически.

Агент AI может проверить этот проект, обеспечивая соответствие требуемым стандартам полноты путем сравнения с внешними базами юридической информации, проверки логической последовательности и запроса дополнительной информации или разъяснения, где требуется.

Этот итеративный процесс позволяет произвести более устойчивый и надеждной документ, соответствующий строгим требованиям практики права.

Overcoming Isolation Through Integration

Одна из самых глубоких ограничений LLM заключается в их внутренней изоляции от других систем и источников знаний.

LLM, как они были спроектированы, являются закрытыми системами, которые неродственно взаимодействие с внешним окружением или базами данных. Эта изоляция значительно ограничивает их способность адаптироваться к новой информации или работать в реальном времени, делая их менее эффективными в приложениях, требующих динамического взаимодействия или реального времени принятия решений.

AI агенты преодолевают эту изоляцию, действуя как интеграционные платформы, соединяющие LLM с более широкой экосистемой данных и вычислительных средств. Through APIs и других интеграционных средств, AI агенты могут получить доступ к реальному времени данные, сотрудничать с другими системами AI и даже взаимодействовать с физическими устройствами.

Например, в приложениях для обслуживания клиентов, LLM может генерировать стандартные ответы на основе предварительно обученных скриптов. Однако эти ответы могут быть статичными и не содержать необходимой для эффективного взаимодействия с клиентами персонализации.

Агент AI может улучшить эти взаимодействия, интегрируя реаль-time данные из профилей клиентов, предыдущих взаимодействий и инструментов анализа эмоционального состояния, что помогает генерировать ответы, которые являются не только контекстуально значимыми, но и направлены на определение особых потребностей клиента.

Эта интеграция превращает经验ние клиента от ряда сценаризированных взаимодействий в динамичную, персонализированную беседу.

Расширение творческого потенциала и способности решать проблемы

尽管LLM是非常强大的生成内容的工具,但是他们的创造力和解决问题的能力本质上是受限于他们在训练时使用的数据。这些模型通常无法将理论概念应用于新的或未曾预见到的挑战,因为它们的问题解决能力受限于它们既有的知识和训练参数。

AI代理通过运用先进的推理技术和更广泛的分析工具,增强了LLM的创造力和解决问题的潜力。这种能力使得AI代理能够突破LLM的限制,以创新的方式将理论框架应用于实际问题。

例如,考虑社交媒体平台上的误导信息问题。LLM可能会基于文本分析识别误导信息的模式,但它可能难以开发出全面遏制虚假信息传播的策略。

Агент-AI может использовать这些洞见, применить теории междисциплинарных наук, таких как социология, психология и сетевая теория, и развить устойчивую, многостороннюю стратегию, которая включает реальное время мониторинг, образование пользователей и автоматизированные способы модерации.

Эта способность синтезировать различные теоретические рамки и применять их к реальным мирным проблемам является примером улучшенных производственных способностей, которые AI агенты приносят на стол.

более конкретные примеры

AI агенты, обладая способностью взаимодействовать с различными системами, получать реальные данные и выполнять действия, решают эти ограничения прямо, трансформируя LLM из мощного, но пассивного языкового модель в динамичных, мирных проblem solvers.みなさんはいくつかの例を見てみょう:

1. от статичных данных до динамических взглядов: LLM в круге

-

Проблема: представьте себе, что вы спросите LLM, обученного до 2023 г. медицинским исследованиям, “Какие самые последние инновации в лечении рака?” Его знания уже устарело.

-

Решение AI агента: AI агент может подключить LLM к медицинским журналам, исследовательским базам данных и новостным потокам. сейчас LLM может предоставлять информацию о последних клинических исследованиях, лечебных возможностях и найденных исследованиях.

2. от анализа к действию: автоматизация задач на основе взглядов LLM

-

Проблема: LLM, наблюдающий за социальными медиа для бренда, может идентифицировать резкое увеличение негативных эмоций, но не может ничего сделать для их решения.

-

Решение AI-агента: AI-агент, подключенный к социальным аккаунтам бренда и оснащенный предварительно одобренными ответами, может автоматически решать проблемы, отвечать на вопросы и даже передавать сложные вопросы человеческим представителям.

3. от первого черновика до отполированного продукта: обеспечение качества и точности

-

Проблема: LLM, назначенный на перевод технического руководства, может произвести грамматически правильные, но технически неточные переводы из-за отсутствия специальных знаний.

- Решение AI-агента: AI-агент может интегрировать LLM с специальными словарями, справочниками и даже подключить его к экспертам по теме для получения реального времени обратной связи, что обеспечит конечный перевод, являющийся как грамматически правильным, так и технически correct.

4. Обход барьеров: Подключение LLMs к реальному миру

- Проблема: LLM, спроектированный для управления смарт-дом, может испытывать трудности при адаптации к изменяющимся распорядкам и предпочтениям пользователя.

- Решение AI-агента: AI-агент может подключить LLM к сенсорам, смарт-устройствам и календарям пользователей. Analyzing поведение пользователя, LLM может научиться предсказывать потребности, автоматически настраивать настройки освещения и температуры и предлагать персонализированные плейлисты музыки в соответствии с временем дня и деятельностью пользователя.

5. От имитации к инновации: расширение креативности LLM

-

Проблема: LLM, ответственный за создание музыки, может создавать произведения, звучащие заимствованными или лишенные эмоциональной глубины, так как в первую очередь опирается на модели, обнаруженные в его тренировочных данных.

-

Решение с использованием AI-агента: AI-агент может подключить LLM к биофидбэк-датчикам, измеряющим эмоциональные реакции композитора на различные музыкальные элементы. Использовав эту реальную временную отдачу, LLM может создавать музыку, которая не только технически грамотна, но и эмоционально вызывает воспоминания и оригинальна.

Комбинация AI-агентов как усилителей LLM представляет не просто ступенчатое улучшение, а фундаментальное расширение возможностей искусственного интеллекта. За счет решения ограничений, присущих традиционным LLM, таких как статичная база знаний, ограниченная автономия принятия решений и изолированная операционная среда, AI-агенты позволяют этим моделям работать на полную мощность.

По мере развития технологии искусственного интеллекта, роль AI-агентов в усилении LLM будет становиться все более важной, не только расширяя возможности этих моделей, но и переопределяя границы искусственного интеллекта самого по себе. Эта синтезия проложит путь для следующего поколения AI-систем, способных к самостоятельному рассуждению, реальному времени адаптации и инновационному решению проблем в постоянно меняющемся мире.

Глава 6: Архитектурное проектирование для интеграции AI-агентов с LLM

Интеграция AI-агентов с LLM зависит от архитектурного проектирования, которое является ключевым для улучшения принятия решений, адаптируемости и масштабируемости. Архитектура должна быть тщательно спроектирована для обеспечения бесшовного взаимодействия между AI-агентами и LLM, гарантируя оптимальную работу каждого компонента.

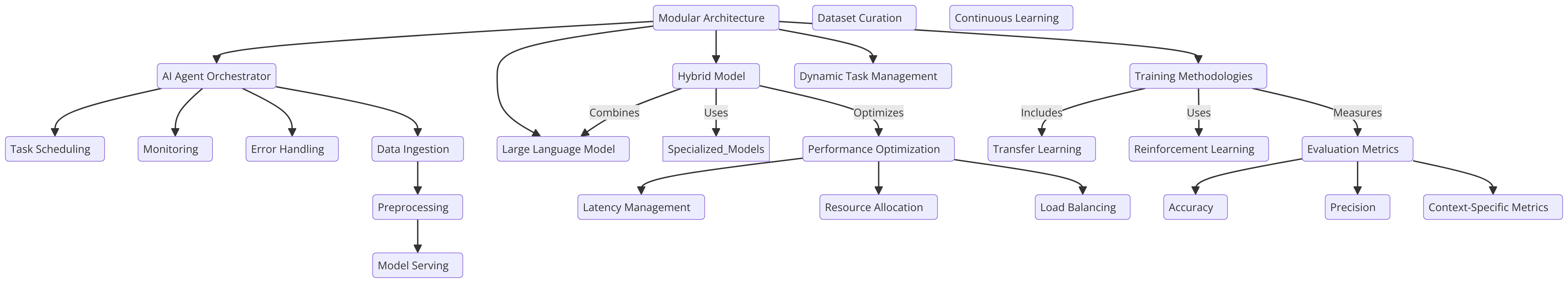

Модульная архитектура, в которой AI-агент выполняет роль дирижёра, направляя способности LLM, является одним из подходов, который поддерживает динамическое управление задачами. Этот дизайн использует сильные стороны LLM в обработке естественного языка, позволяя AI-агенту управлять более сложными задачами, такими как многоступенчатое рассуждение или контекстуальное принятие решений в реальном времени.

альтернативно, гибридная модель, сочетающая LLM с специализированными, подобранными моделями, обеспечивает гибкость, позволяя агенту AI делегировать задачи наиболее подходящим моделям. Этот подход оптимизирует производительность и улучшает эффективность по широкому кругу приложений, делая его особенно эффективным в различных и изменчивых операционных контекстах (Liang et al., 2021).

Методологии и лучшие практики тренировки

Тренировка AI-агентов, интегрированных с LLM, требует методичного подхода, который балансирует общее обобщение с оптимизацией для конкретных задач.

Перенос обучения является ключевой техникой в данном случае, позволяя LLM, предварительно тренированному на большом разнообразном корпусе, быть подобраным на домен-специфических данных, связанных с задачами AI-агента. Этот метод сохраняет широкий значительный базис знаний LLM, позволяя ему специализироваться в определенных приложениях, улучшая общую эффективность системы.

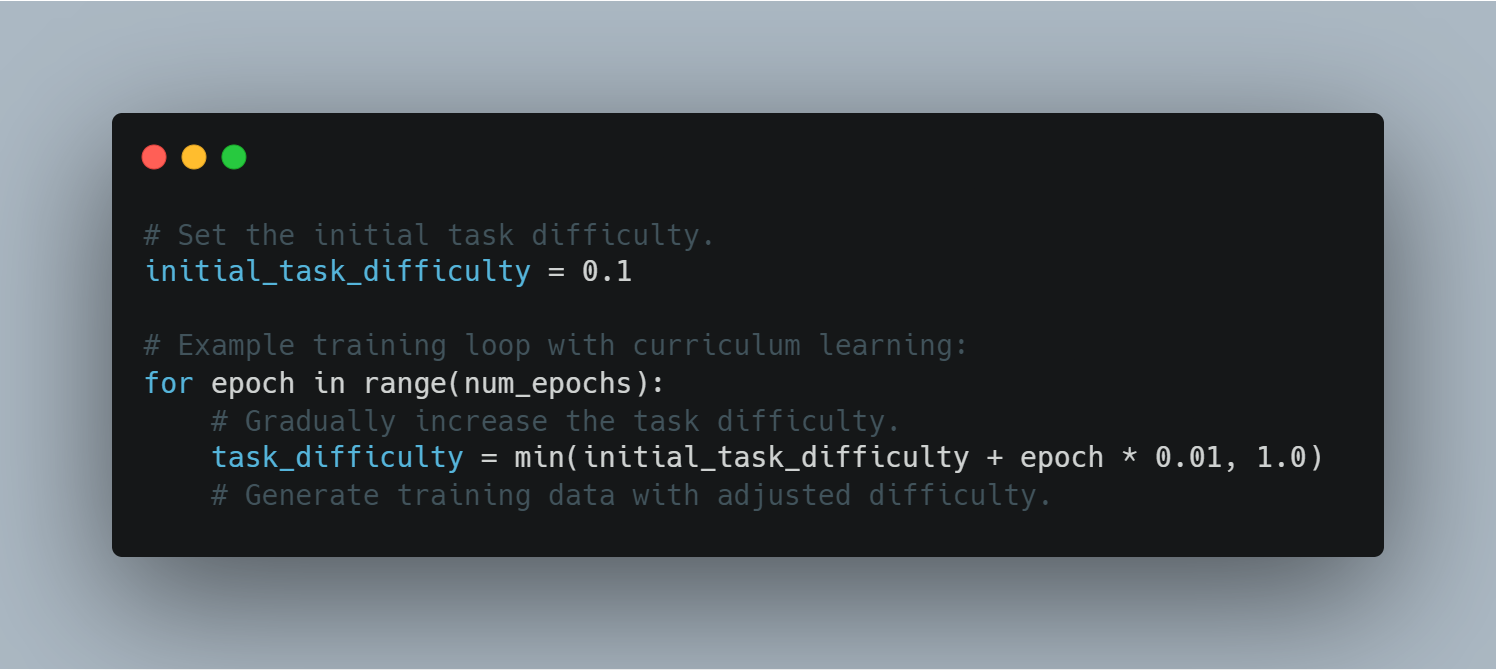

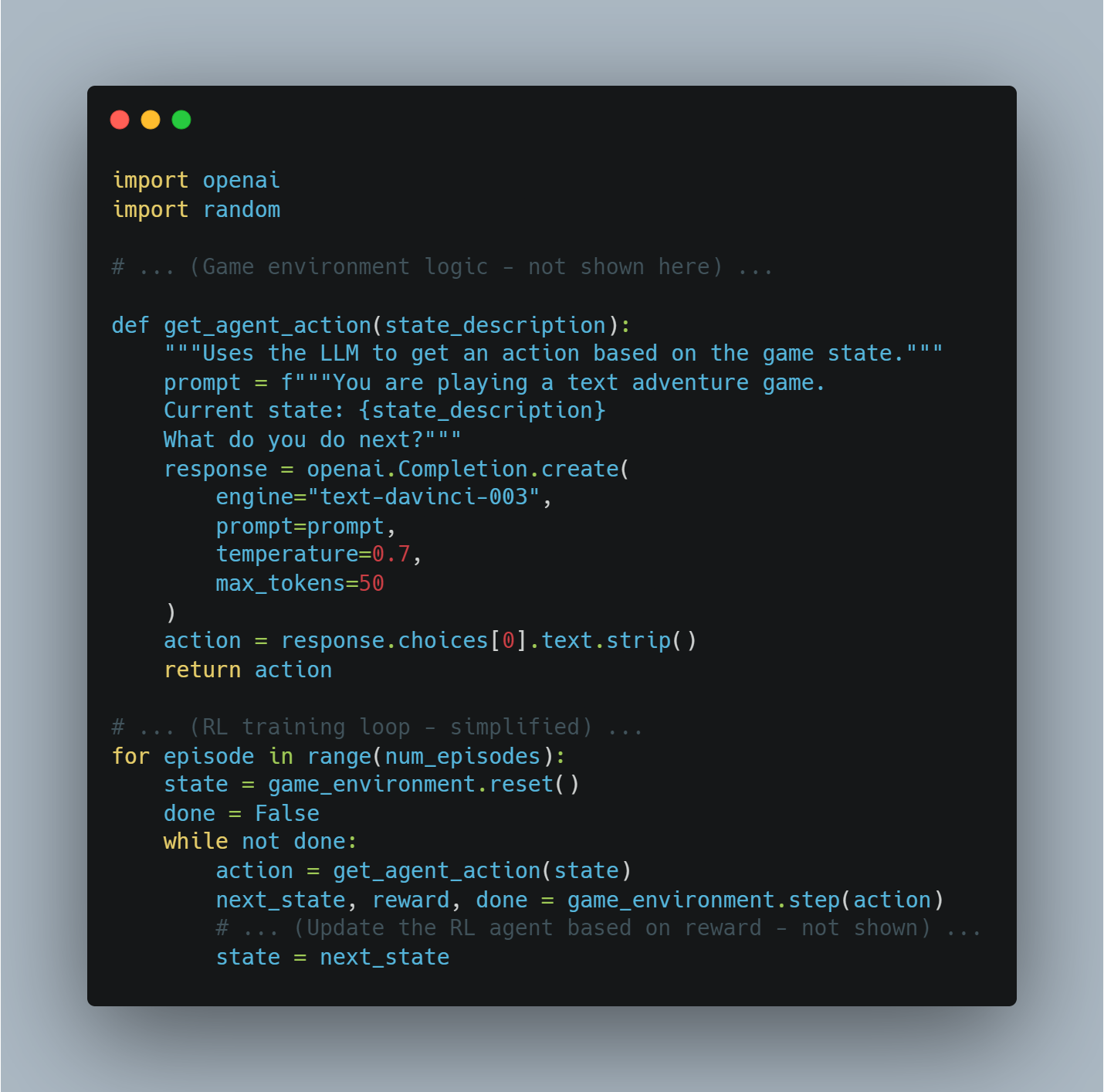

Также в этом качестве играет критическая роль рефолс-обучение (RL), особенно в сценариях, когда AI-агент должен адаптироваться к изменяющимся средам. Благодаря взаимодействию с его средой AI-агент может непрерывно улучшать процессы принятия решений, становясь умелым в обработке новых проблем.

Чтобы обеспечить надежную работу в различных сценариях, необходимы тщательно разработанные метрики оценки. Эти метрики должны включать и стандартные оси по сравнению и критерии для конкретных задач, чтобы обеспечить, чтобы система была гибкой и всесторонне обучена (Silver et al., 2016).

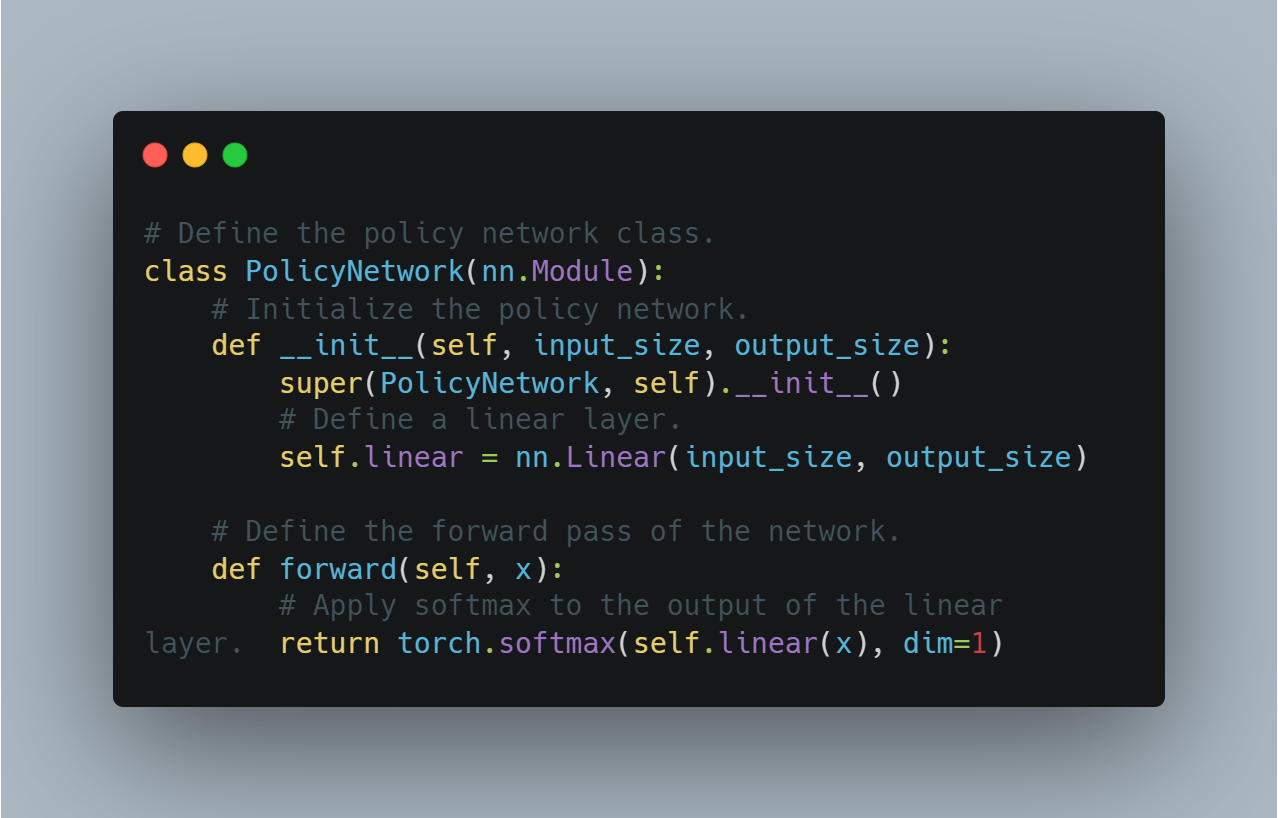

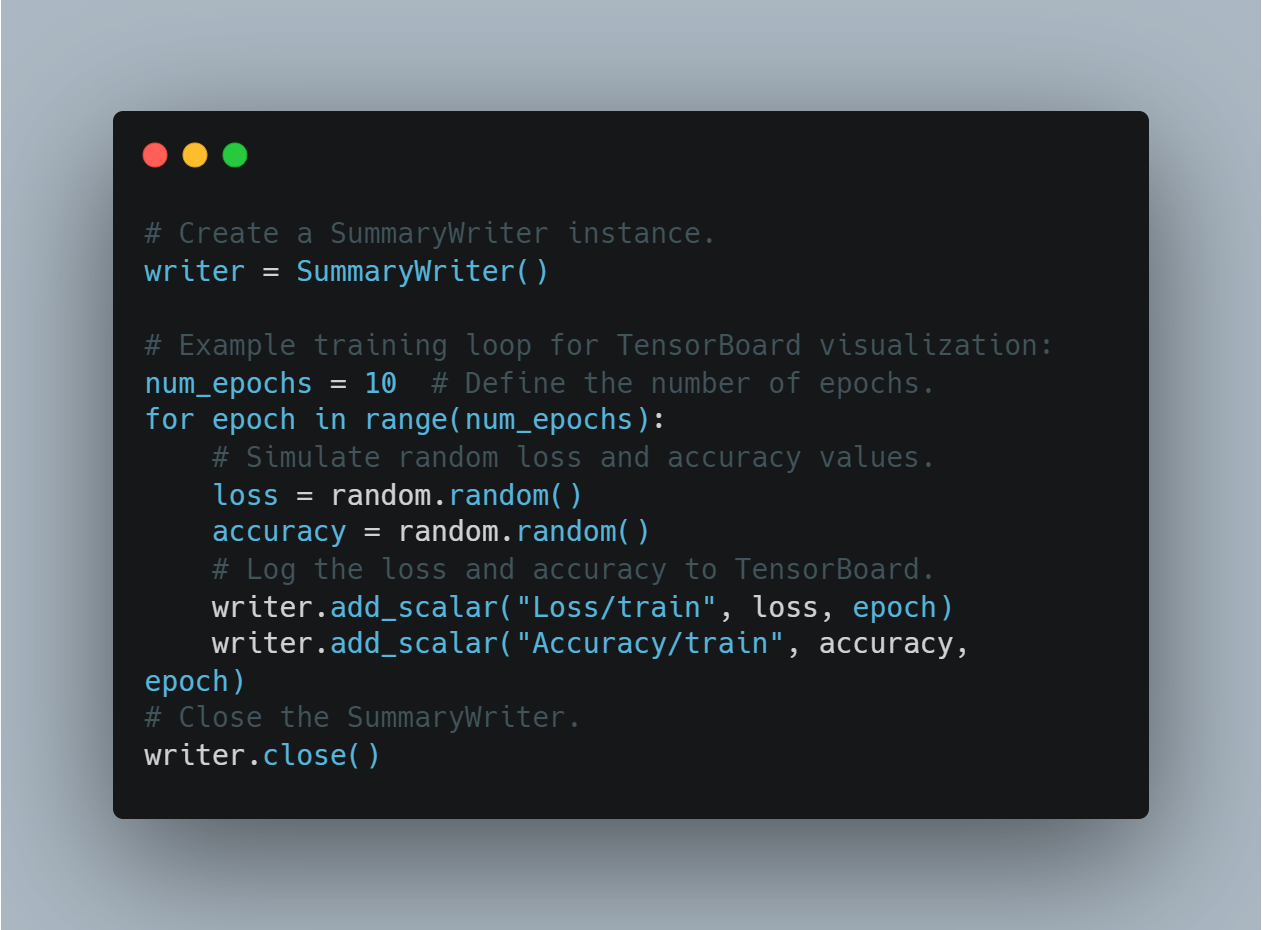

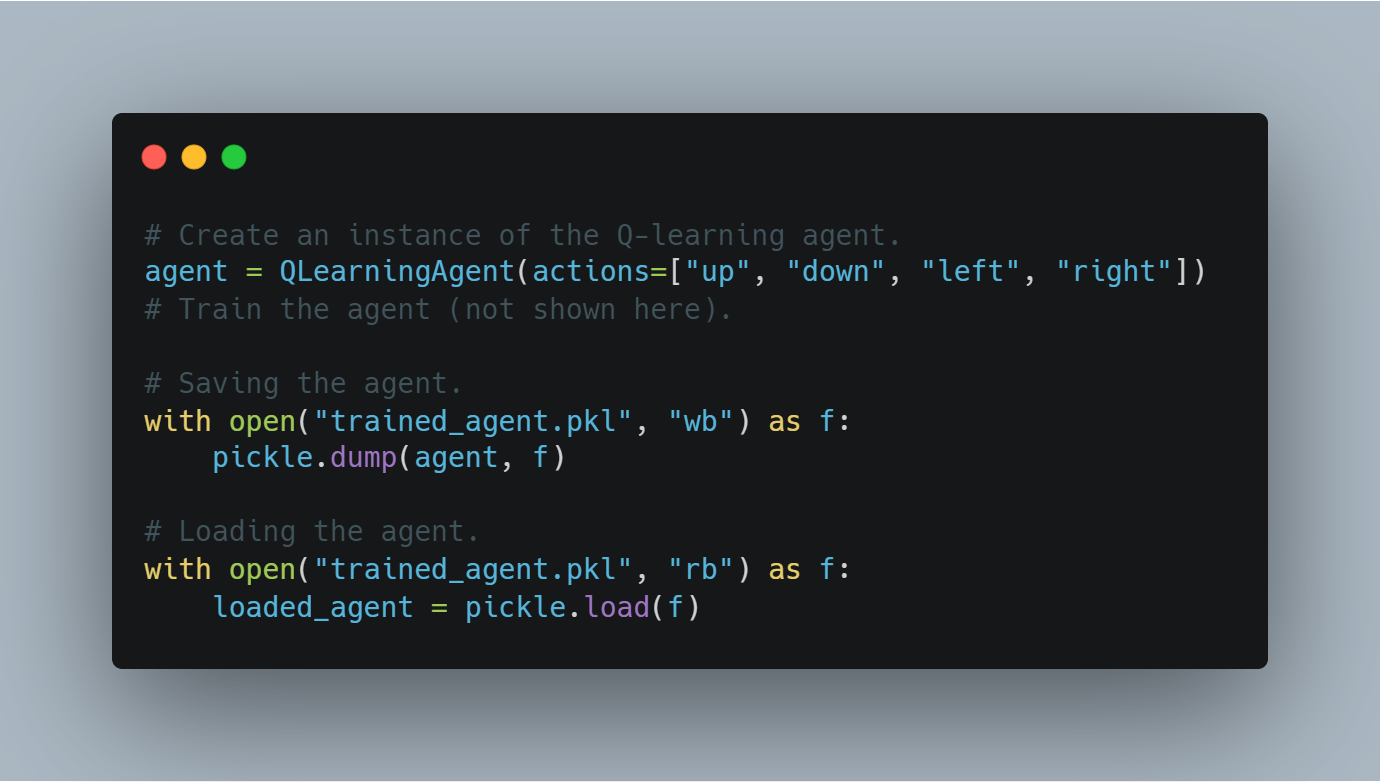

Введение в подобрание большой модели языка (LLM) и концепции рефолс-обучения

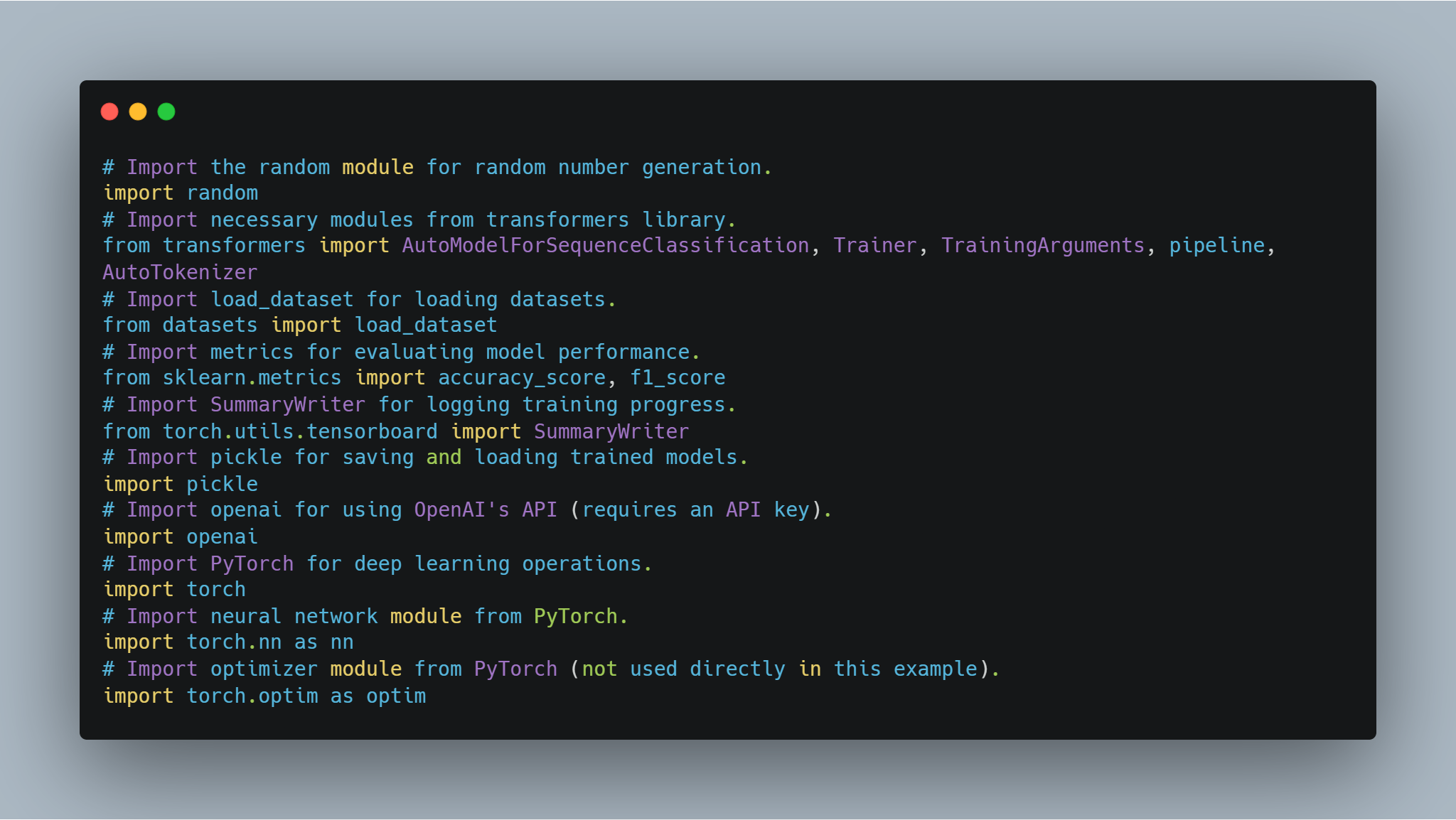

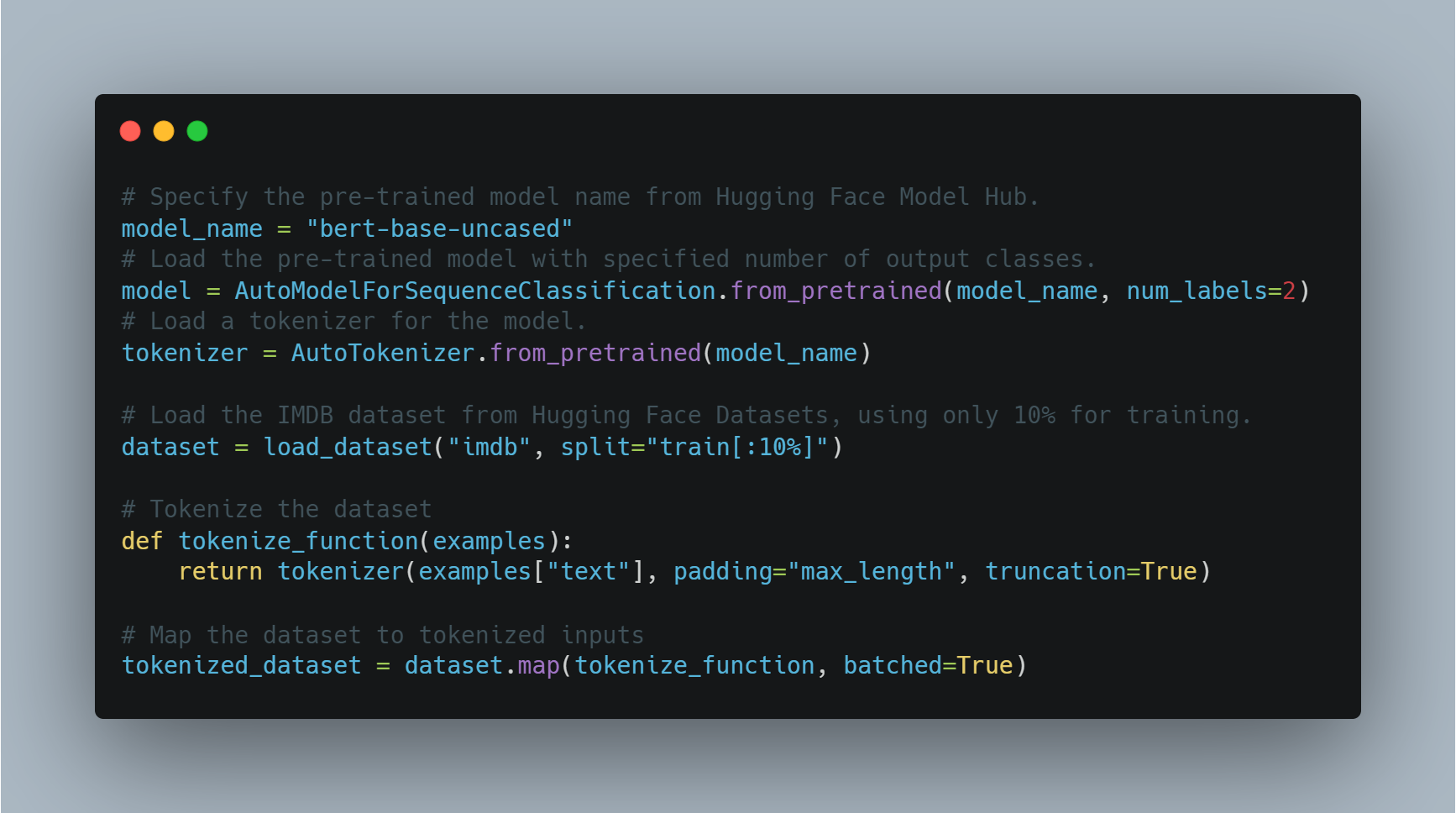

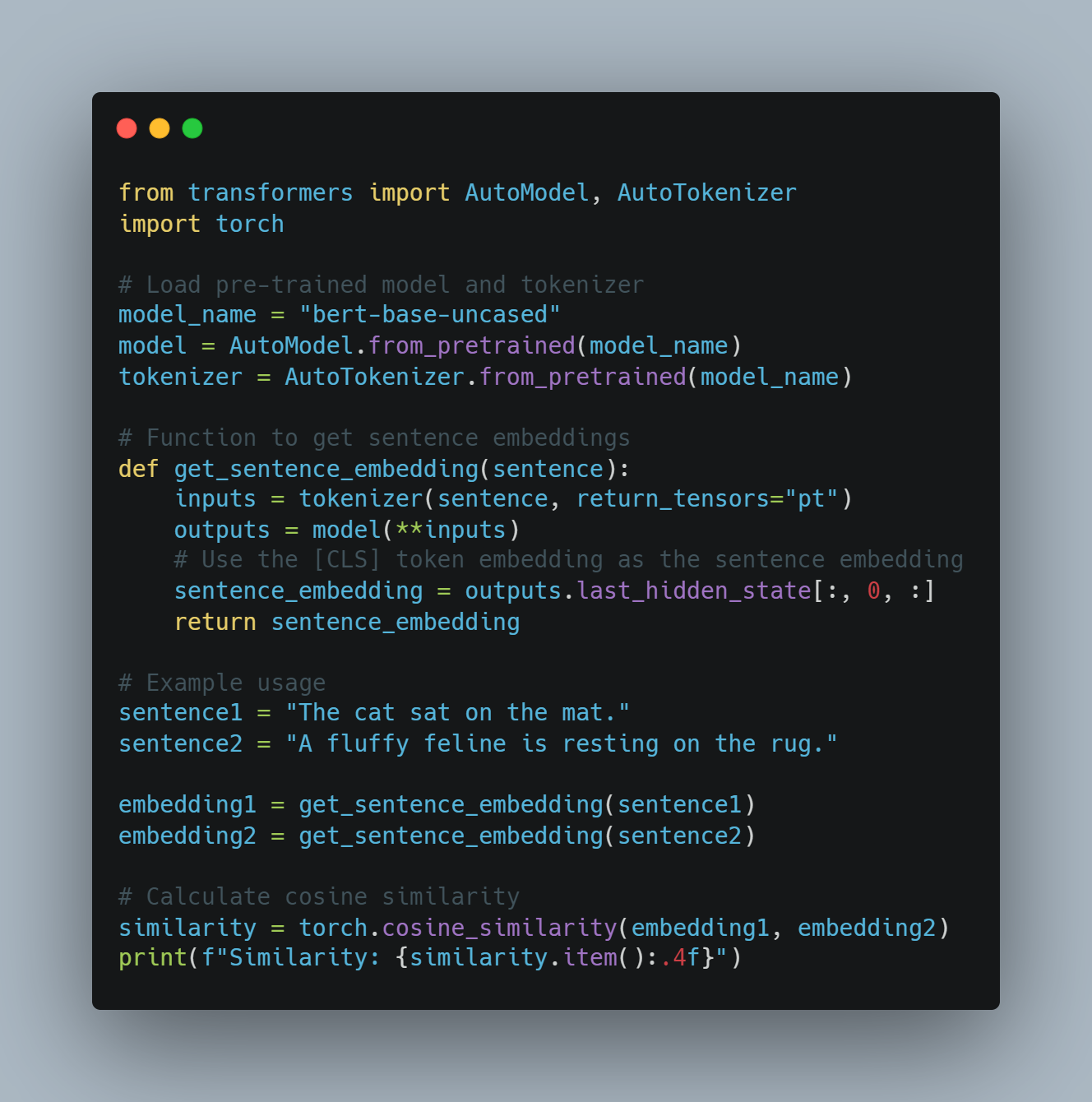

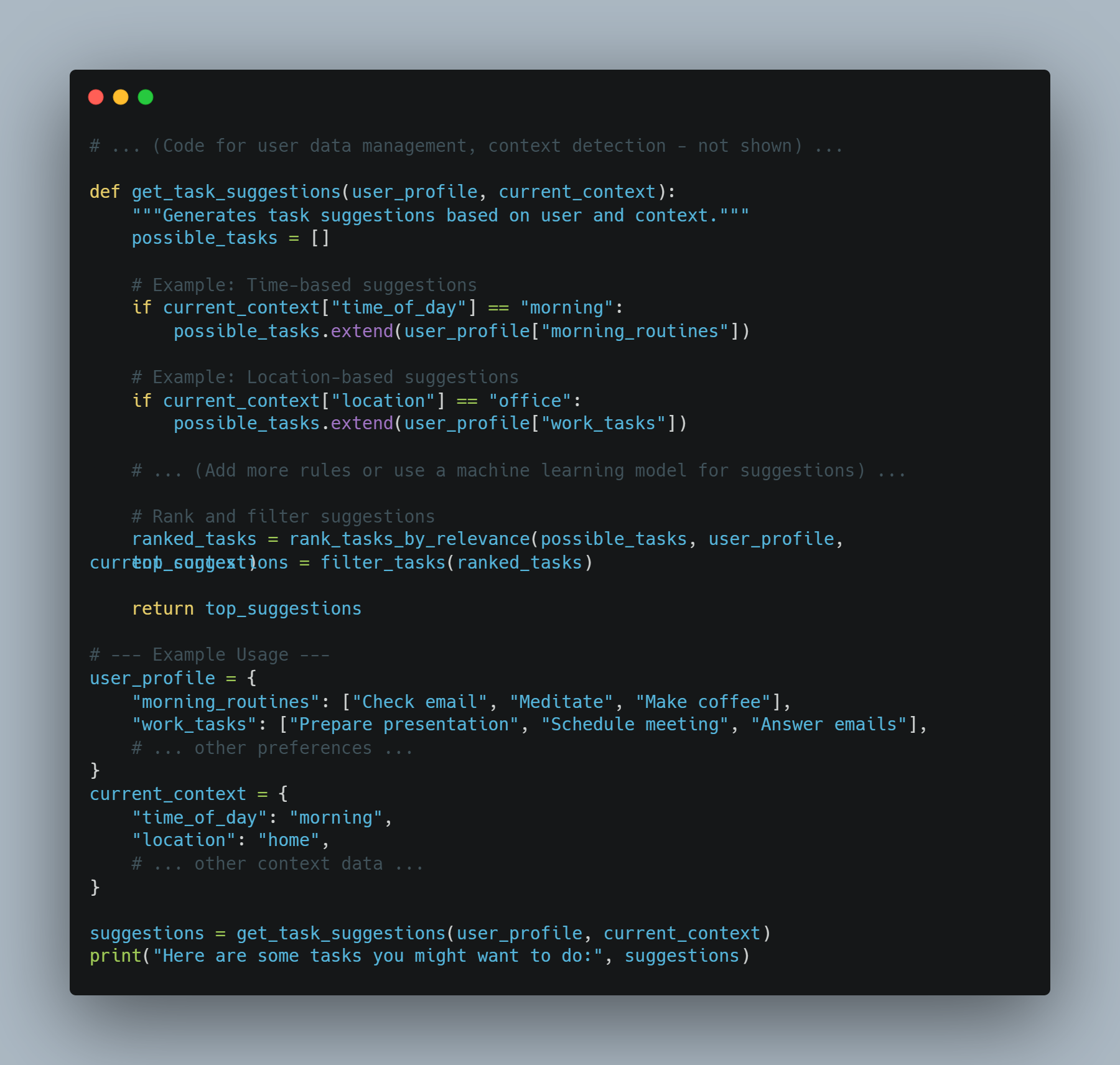

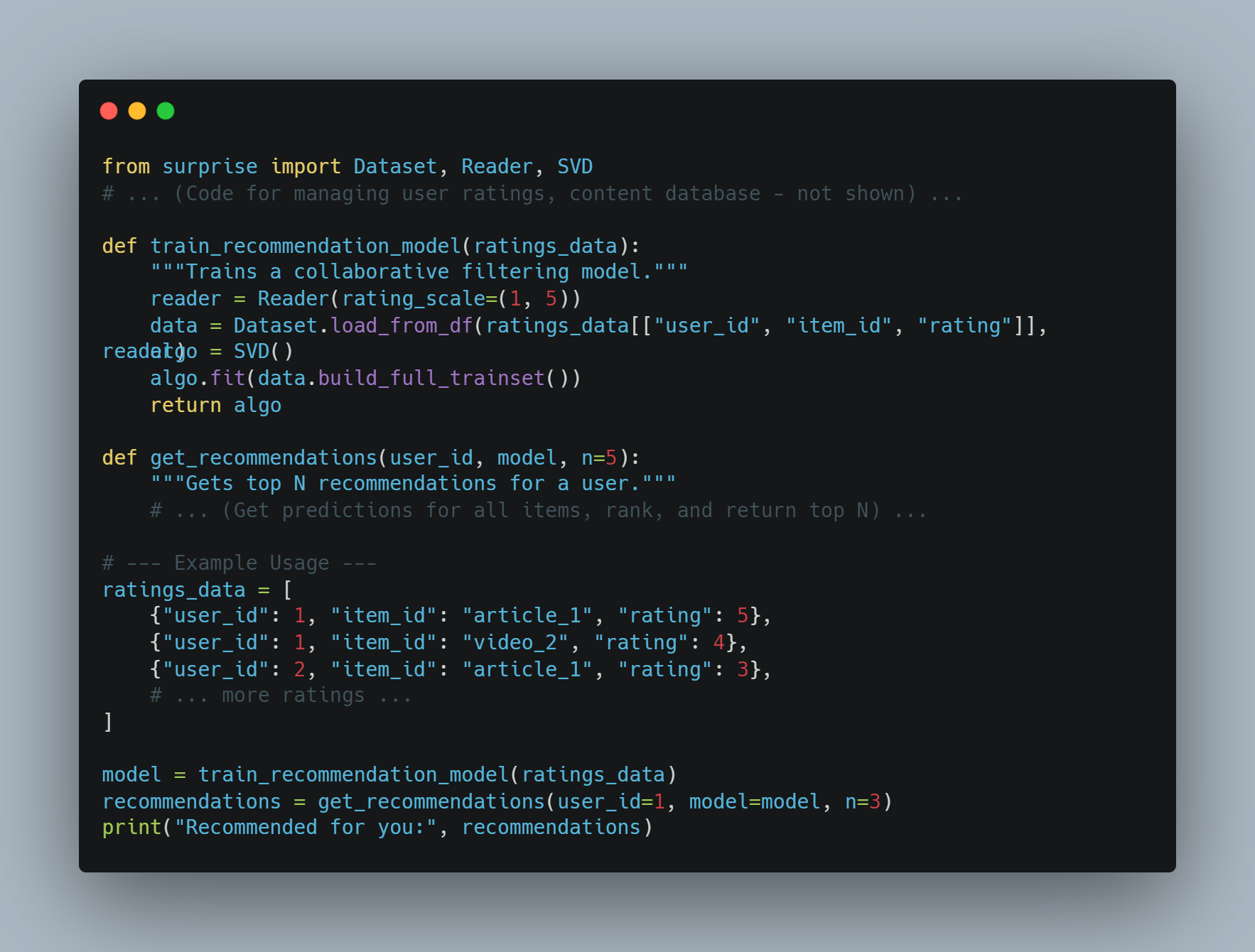

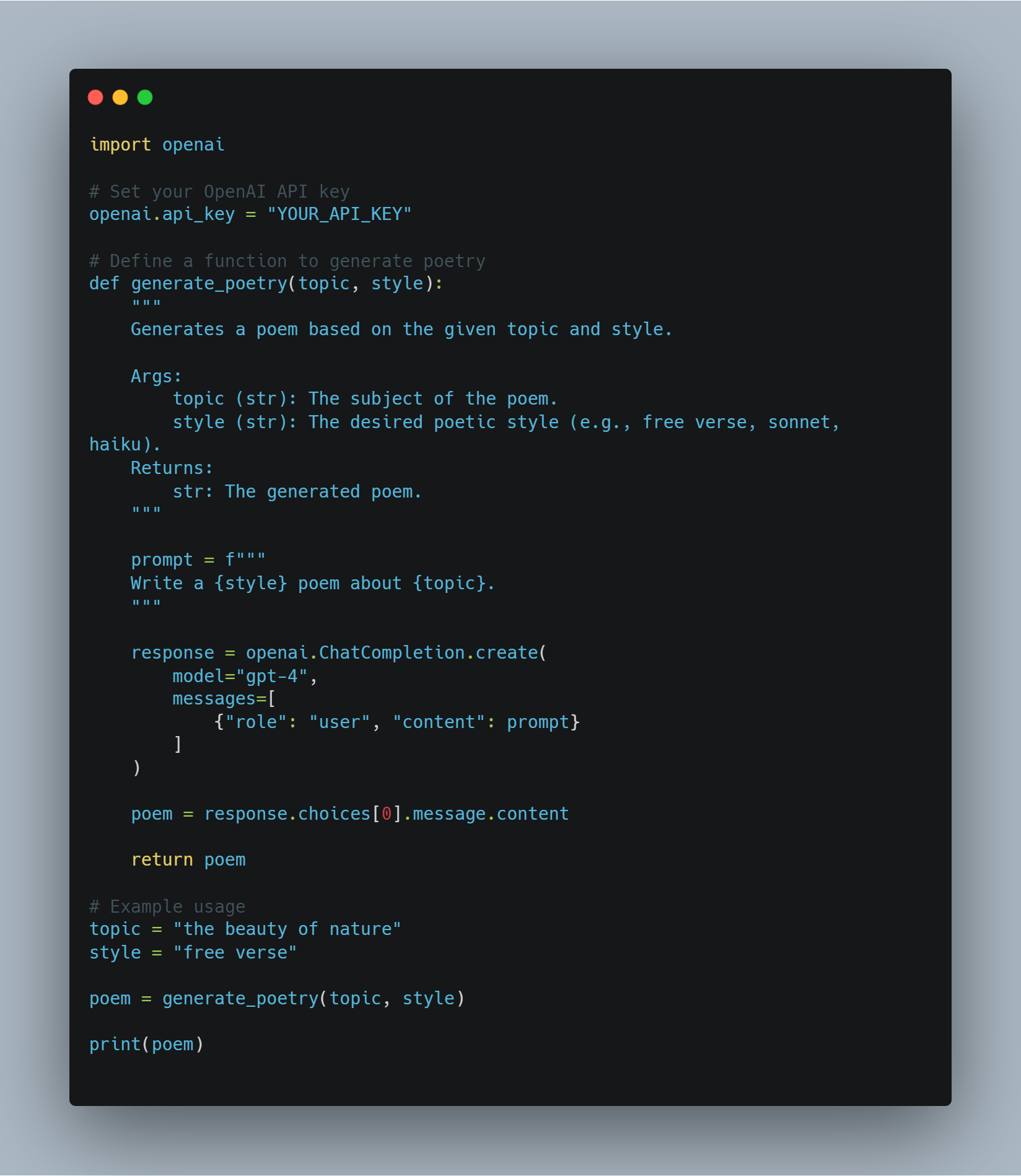

Этот код демонстрирует различные техники, включающие машинное обучение и природное языковое процессование (NLP), сфокусируясь на微调 крупных языковых моделей (LLMs) для специфических задач и реализации агентов рефолдования leaning (RL). Код охватывает несколько ключевых областей:

-

Micro-tuning LLM: Использование предварительно обученных моделей, таких как BERT, для таких задач, как анализ сентимента, используя библиотеку Hugging Face

transformers. Это включает токенизацию набора данных и использование тренировочных аргументов для направления процесса микро-тренинга. -

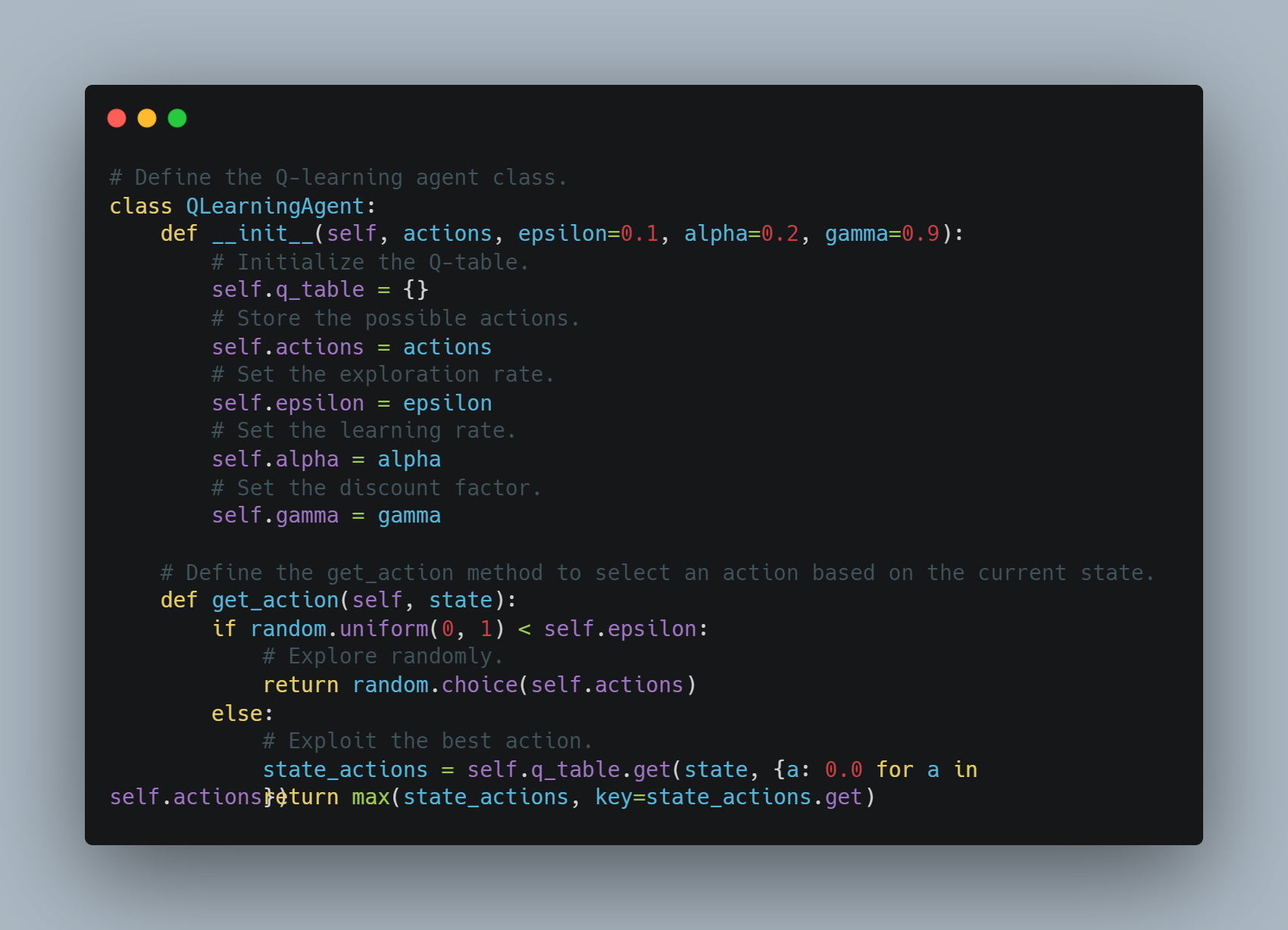

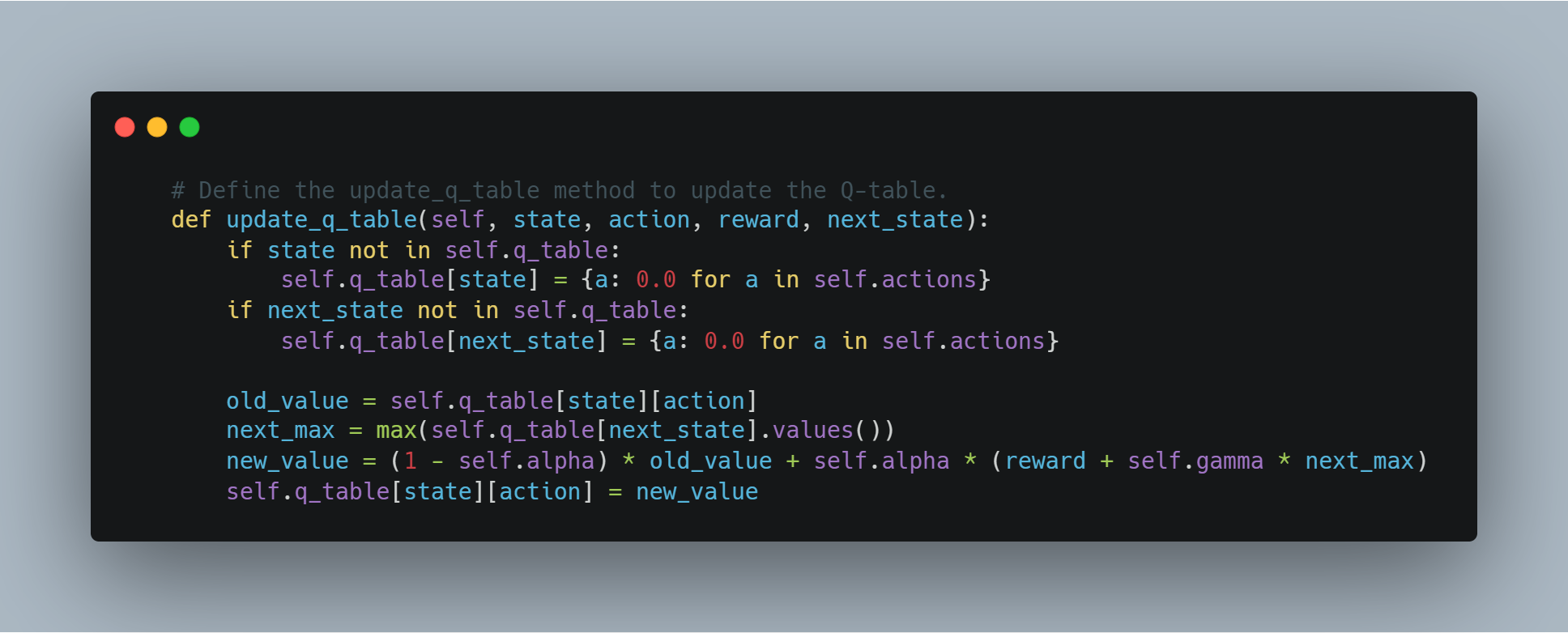

Рефолдование Learning (RL): Введение в основы рефолдования с помощью простого Q-learning агента, где агент учится через опыт и ошибки, взаимодействуя с средой и обновляя свои знания через Q-таблицы.

-

Моделирование награды с помощью API OpenAI: концептуальный метод использования API OpenAI для динамического обеспечения сигналов награды рефолдованию агенту, позволяя языковой модели оценивать действия.

-

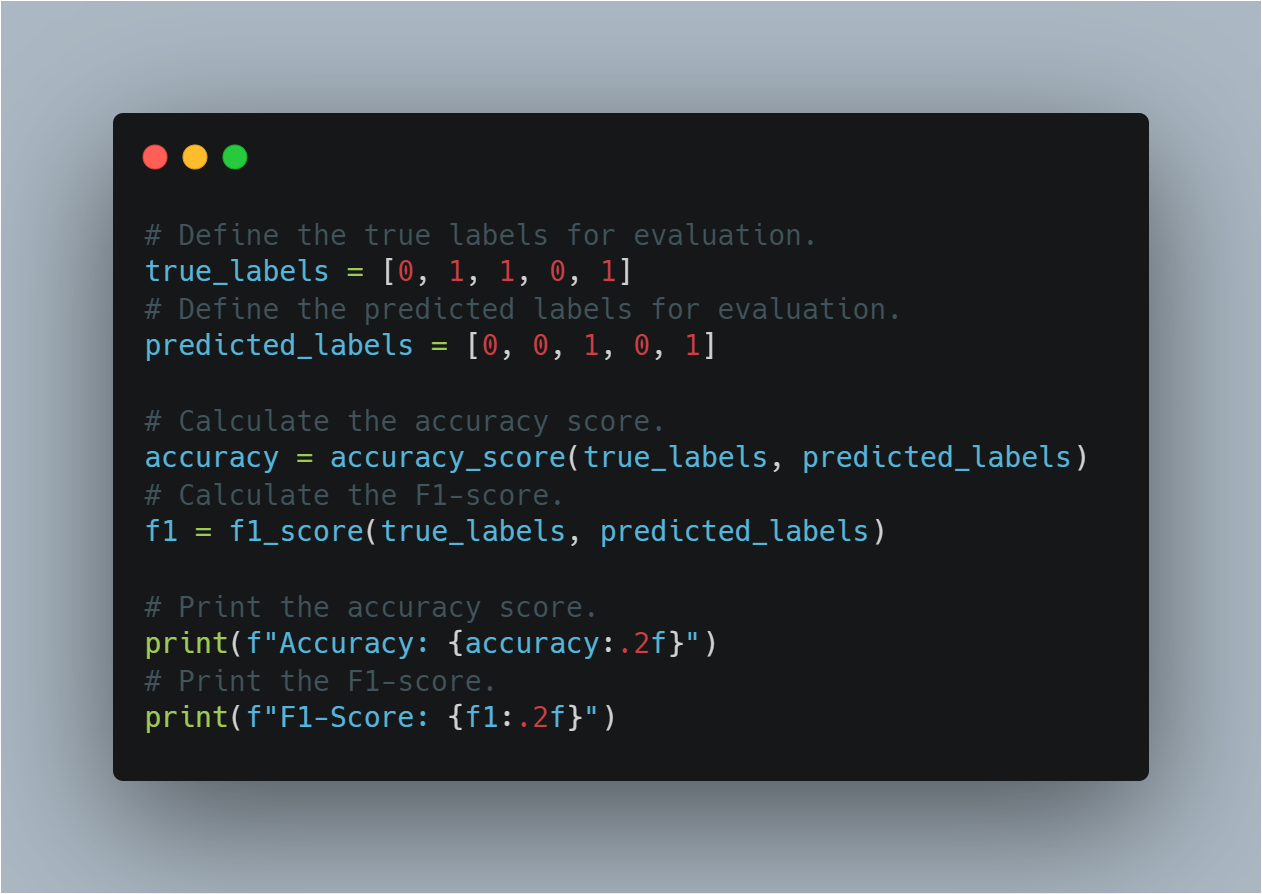

Оценка модели и логирование: Использование библиотек, таких как