L’évolution rapide de l’intelligence artificielle (IA) a permis l’apparition d’une puissante synergie entre les grands modèles de langue (LLM) et les agents intelligents. Cette dynamique interplay est telle que les agiles agents intelligents renforcent et amplifient les capacités des colossales LLM.

Ce manuel explore comment les agents intelligents, semblables à David, superchargent les LLM – nos modernes Goliaths – pour aider à révolutionner diverses industries et domaines scientifiques.

Table des matières

-

L’émergence des agents intelligents dans les modèles de langue

-

Chapitre 1 : Introduction aux agents intelligents et aux modèles de langue

-

Chapitre 2 : L’histoire de l’intelligence artificielle et des agents intelligents

-

Chapitre 4 : La base philosophique des systèmes intelligents

-

Chapitre 6 : Conception architecturale pour l’intégration des agents IA avec les LLM

-

Chapitre 8 : Les agents intelligents dans les domaines de mission critique

L’émergence des agents intelligents dans les modèles de langue

Les agents intelligents sont des systèmes autonomes conçus pour percevoir leur environnement, prendre des décisions et exécuter des actions pour atteindre des objectifs spécifiques. Lorsqu’ils sont intégrés à des GdL, ces agents peuvent effectuer des tâches complexes, réfléchir à l’information et générer des solutions innovantes.

Cette combinaison a permis d’obtenir des avancées significatives dans de multiples secteurs, du développement logiciel à la recherche scientifique.

Impact transformateur sur les industries

L’intégration des agents intelligents avec les GdL a eu un impact profond sur diverses industries :

-

Développement de logiciels : Les assistants de codage dotés d’IA, tels que GitHub Copilot, ont montré la capacité à générer jusqu’à 40 % du code, ce qui a permis une augmentation remarquable de 55 % de la vitesse de développement.

-

Éducation : Les assistants d’apprentissage dotés d’IA ont montré de prometteuses performances en réduisant le temps moyen de terminaison des cours de 27 %, ce qui pourrait révolutionner le paysage éducatif.

-

Transportation: Des projections suggèrent que 10% des véhicules seront autonomes d’ici 2030, ce qui amènerait les agents AI autonomes dans les voitures sans conducteur à transformer l’industrie des transports.

Avancer les découvertes scientifiques

Une des applications les plus passionnantes des agents AI et des GMT est dans la recherche scientifique :

-

Découverte de médicaments : Les agents AI accélèrent le processus de découverte de médicaments en analysant des jeux de données importants et en prédisant les candidats potentiels de médicaments, réduisant significativement le temps et le coût associés aux méthodes traditionnelles.

-

Physique des Particules : Au Grand collisionneur hadronique de CERN, des agents IA sont utilisés pour analyser les données de collisions de particules, utilisant la détection d’anomalies pour identifier des pistes prometteuses indiquant peut-être l’existence de particules non découvertes.>

-

Recherche Scientifique Générale : Des agents IA sont améliorant le rythme et la portée de découvertes scientifiques en analysant des études passées, en identifiant des liens imprévus et en proposant de nouvelles expériences.

La convergence d’agents intelligents et de grands modèles de langue (GML) propulse l’intelligence artificielle dans une nouvelle ère de capacités sans précédent. Ce manuel complet examine l’interaction dynamique entre ces deux technologies, dévoilant leur potentiel combiné pour révolutionner les industries et résoudre les problèmes complexes.

Nous retracerons l’évolution de l’IA de ses origines à l’avènement d’agents autonomes et du développement de GML sophistiqués. Nous explorerons également les considérations éthiques, qui sont fondamentales au développement responsable de l’IA. Cela nous aidera à nous assurer que ces technologies alignent nos valeurs humaines et le bien-être de la société.

A la fin de ce manuel, vous aurez une compréhension profonde du pouvoir synergique des agents intelligents et des GML, ainsi que les connaissances et outils pour exploiter cette technologie de pointe.

Chapitre 1 : Introduction aux Agents Intelligents et aux Modèles de Langue

Qu’est-ce que des Agents Intelligents et des Grandes Modèles de Langue ?

L’évolution rapide de l’intelligence artificielle (IA) a mis en évidence une synergie transformative entre les grands modèles de langue (GML) et les agents intelligents.

Les agents intelligents sont des systèmes autonomes conçus pour percevoir leur environnement, prendre des décisions et exécuter des actions pour atteindre des objectifs spécifiques. Ils présentent des caractéristiques telles que l’autonomie, la perception, la réactivité, la raisonnement, la prise de décision, l’apprentissage, la communication et l’orientation vers les objectifs.

D’autre part, les LLM (Large Language Models) sont des systèmes intelligents complexes qui utilisent des techniques d’apprentissage profondes et de vastes jeux de données pour comprendre, générer et prédire du texte semblable à celui des humains.

Ces modèles, tels que GPT-4, Mistral, LLama, ont démontré des capacités remarquables dans les tâches de traitement du langage naturel, y compris la génération de texte, la traduction de langue et les agents de conversation.

Caractéristiques clés des agents intelligents

Les agents intelligents possèdent plusieurs caractéristiques distinctives qui les différencient des logiciels traditionnels :

-

Autonomie: Ils peuvent fonctionner indépendamment de l’intervention constante de l’humain.

-

Perception: Les agents peuvent ressentir et interpréter leur environnement à travers diverses entrées.

-

Réactivité: Ils réagissent dynamiquement aux changements dans leur environnement.

-

Raisons et Prise de décision : Les agents peuvent analyser des données et prendre des choix informés.

-

Apprentissage : Ils améliorent leurs performances au fil du temps par l’expérience.

-

Communication : Les agents peuvent interagir avec d’autres agents ou avec des humains à l’aide de diverses méthodes.

-

Orientation vers des objectifs : Ils sont conçus pour atteindre des objectifs spécifiques.

Capacités des grands modèles de langue

Les gros modèles de langue ont montré une large gamme de capacités, y compris :

-

Génération de texte : Les MMT peuvent produire du texte cohérent et pertinent selon les prompts.

-

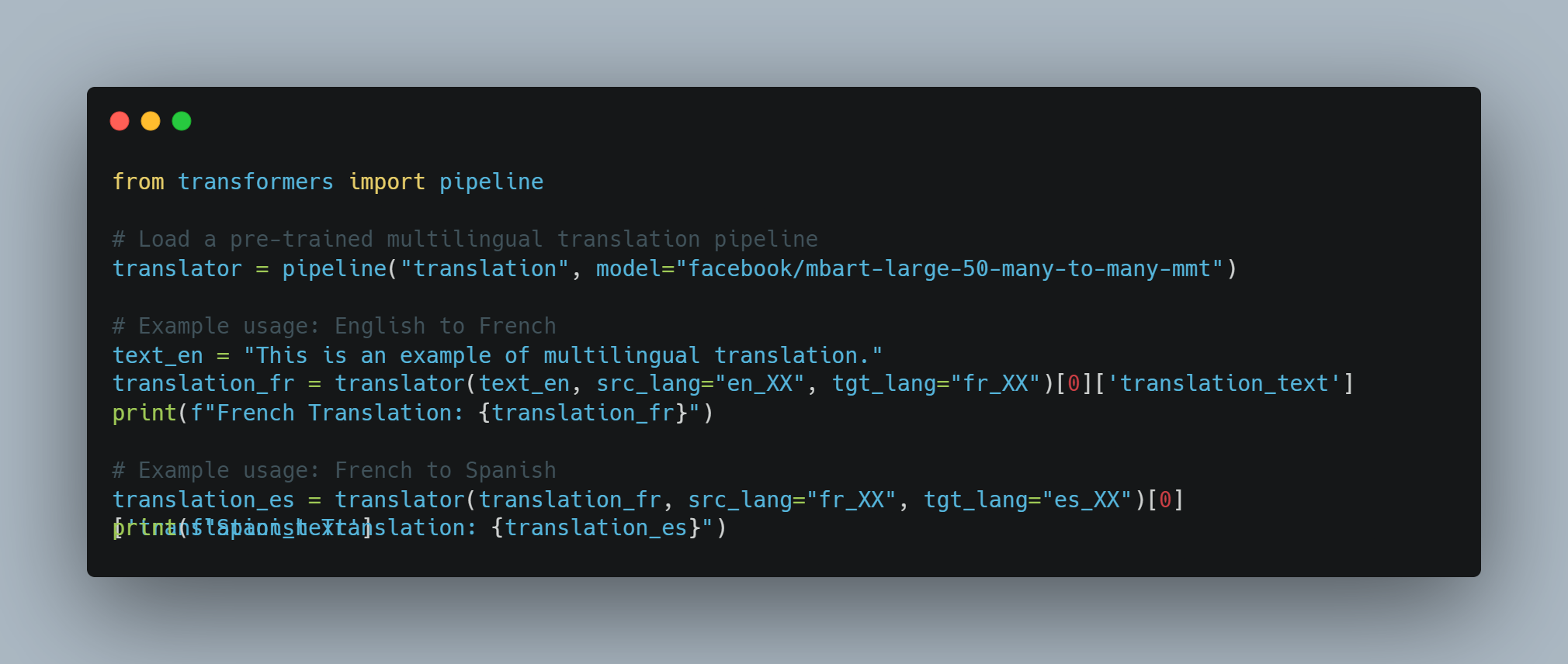

Traduction de langue : Ils peuvent traduire du texte entre différentes langues avec une grande précision.

-

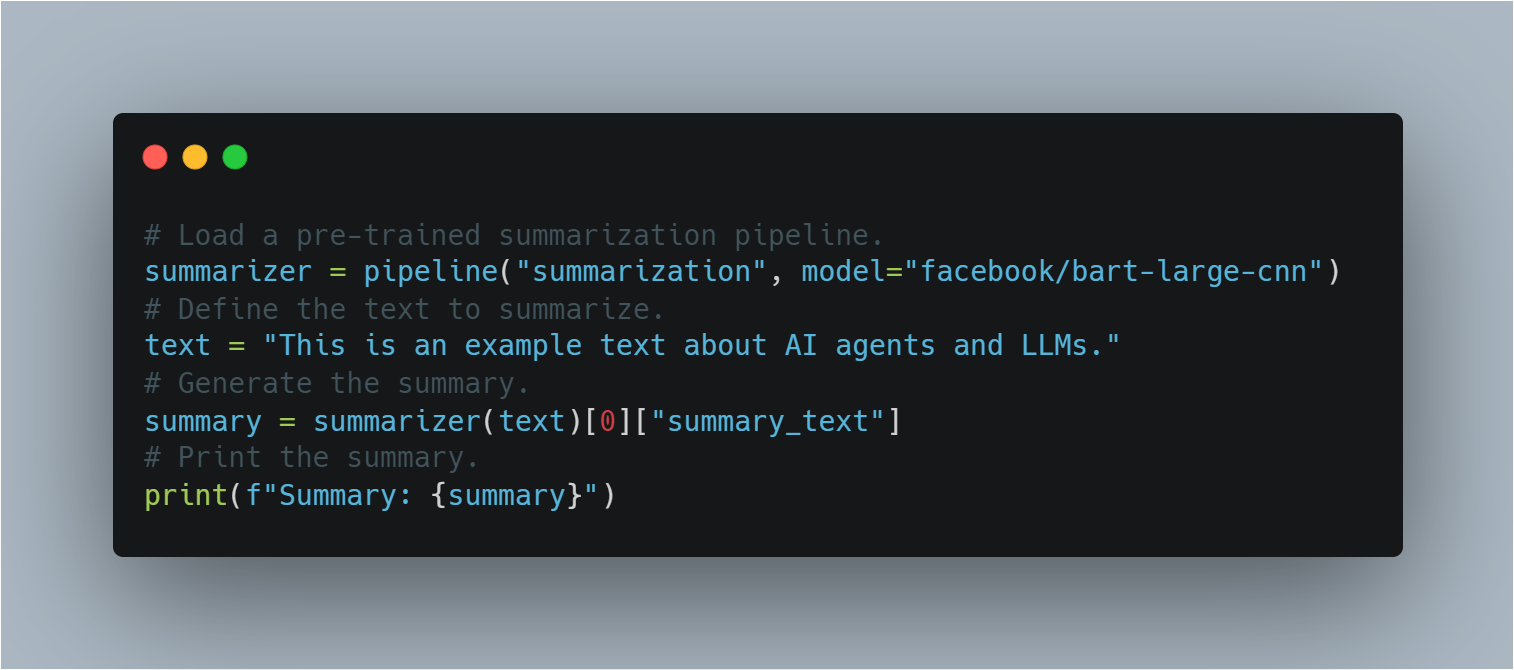

Résumé

: Les GLLM peuvent condenser de longs textes en sommaires courts tout en conservant les informations clés.

- Recherche de réponses : Ils peuvent fournir des réponses précises aux questions basées sur leur base de connaissances vaste.

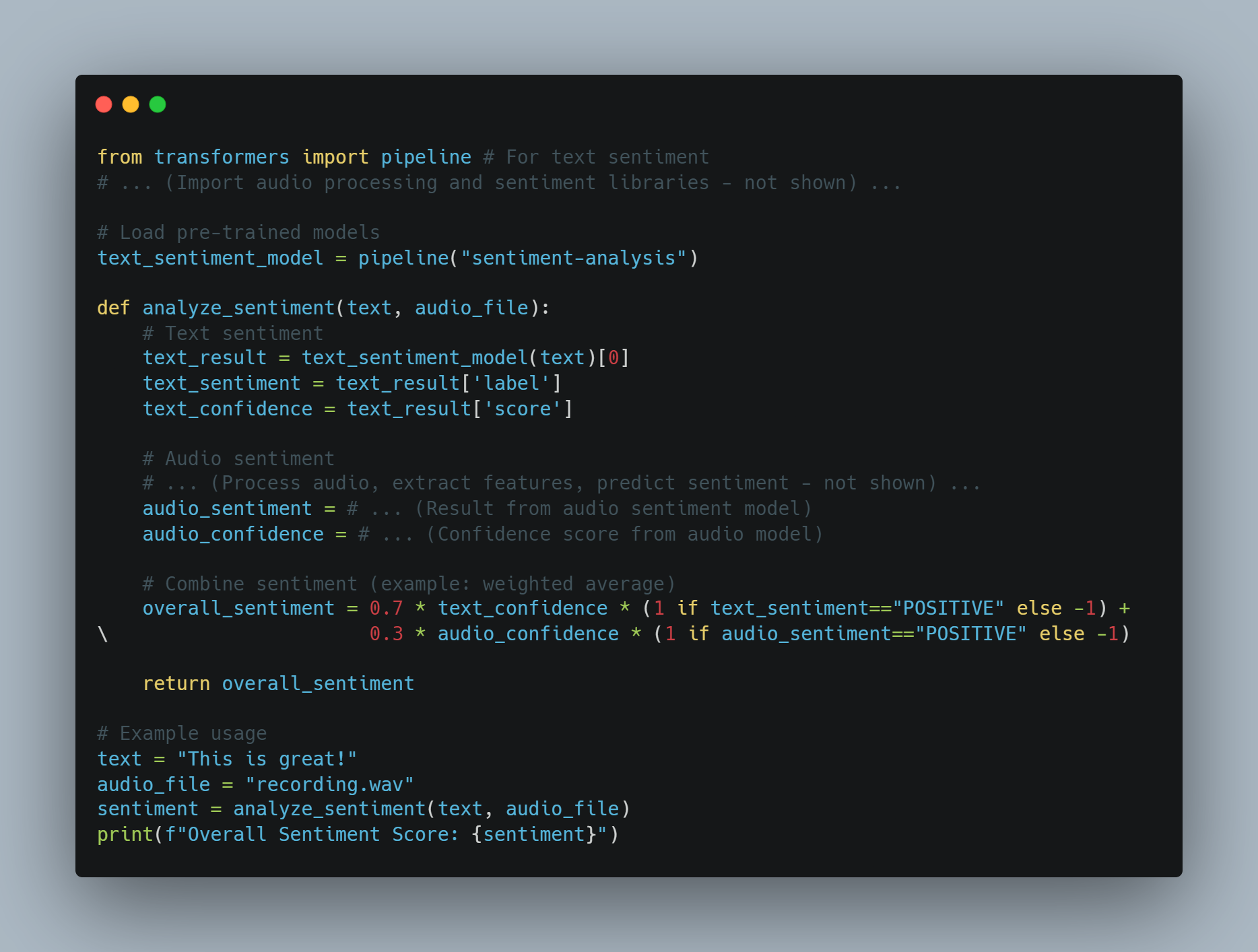

- Analyse des sentiments : Les GLLM peuvent analyser et déterminer le sentiment exprimé dans un texte donné.

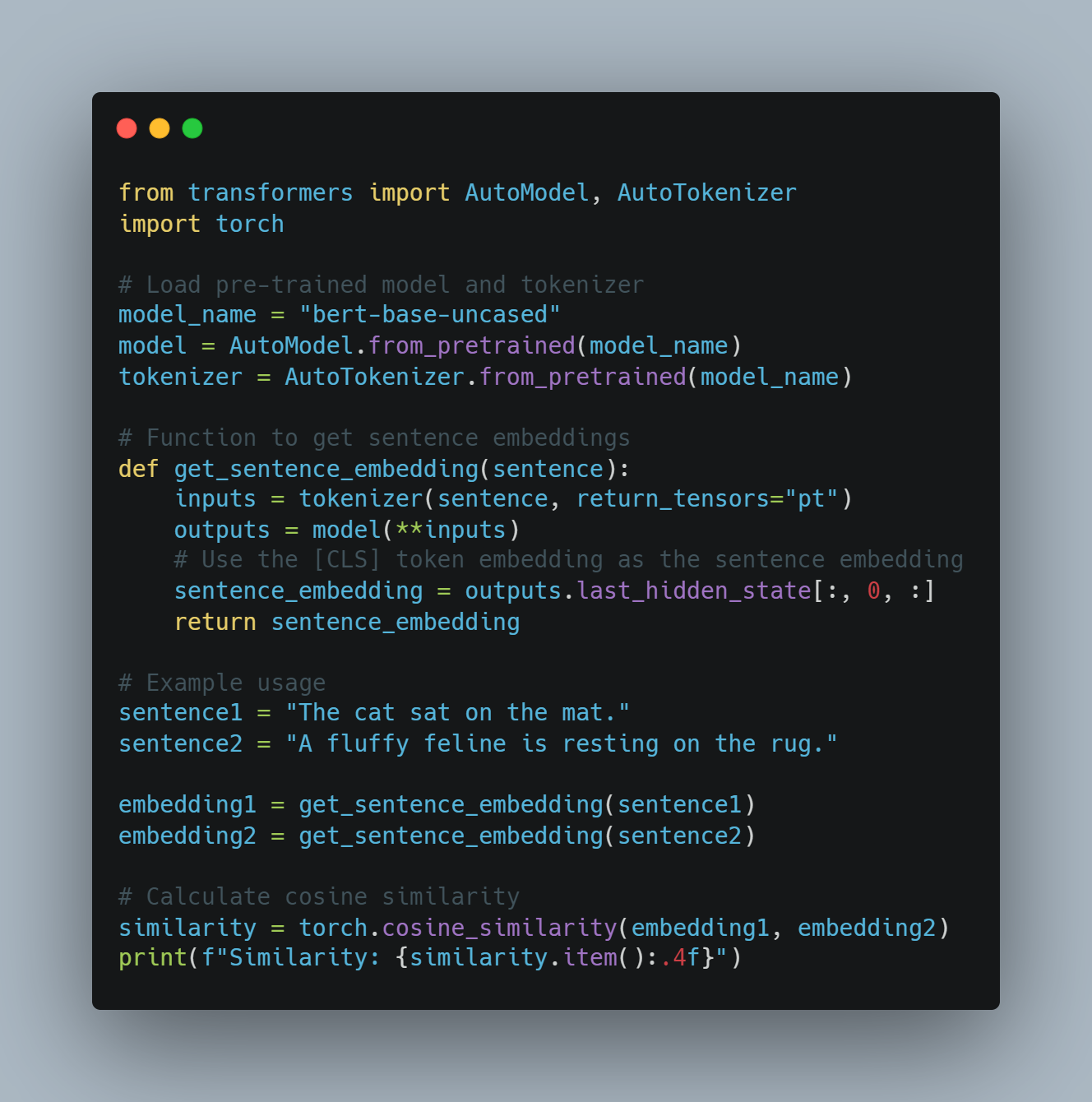

- Génération de code : Ils peuvent générer des extraits de code ou des fonctions entières sur la base de descriptions en langue naturelle.

Niveaux des agents intelligents

Les agents intelligents peuvent être classés dans différents niveaux en fonction de leurs capacités et de leur complexité. Selon un papier sur arXiv, les agents intelligents sont catégorisés en cinq niveaux :

- Niveau 1 (L1) : Les agents intelligents en tant que assistants de recherche, où les scientifiques définissent des hypothèses et spécifient des tâches pour atteindre des objectifs.

-

Niveau 2 (N2) : Des agents intelligents autonomes pouvant exécuter des tâches spécifiques dans un certain domaine défini, telles que l’analyse des données ou des processus de décision simples.

-

Niveau 3 (N3) : Des agents intelligents capables d’apprendre à partir de l’expérience et d’adapter leur comportement aux nouvelles situations, améliorant ainsi leurs processus de décision.

-

Niveau 4 (N4) : Des agents intelligents dotés de capacités de raisonnement avancées et de résolution de problèmes, pouvant gérer des tâches complexes à plusieurs étapes.

-

Niveau 5 (N5) : Des agents intelligents autonomes complètement indépendants pouvant fonctionner de manière autonome dans des environnements dynamiques, prenant des décisions et agissant sans intervention humaine.

Limitations des Grands Modèles de Langue

Coûts de formation et contraintes de ressources

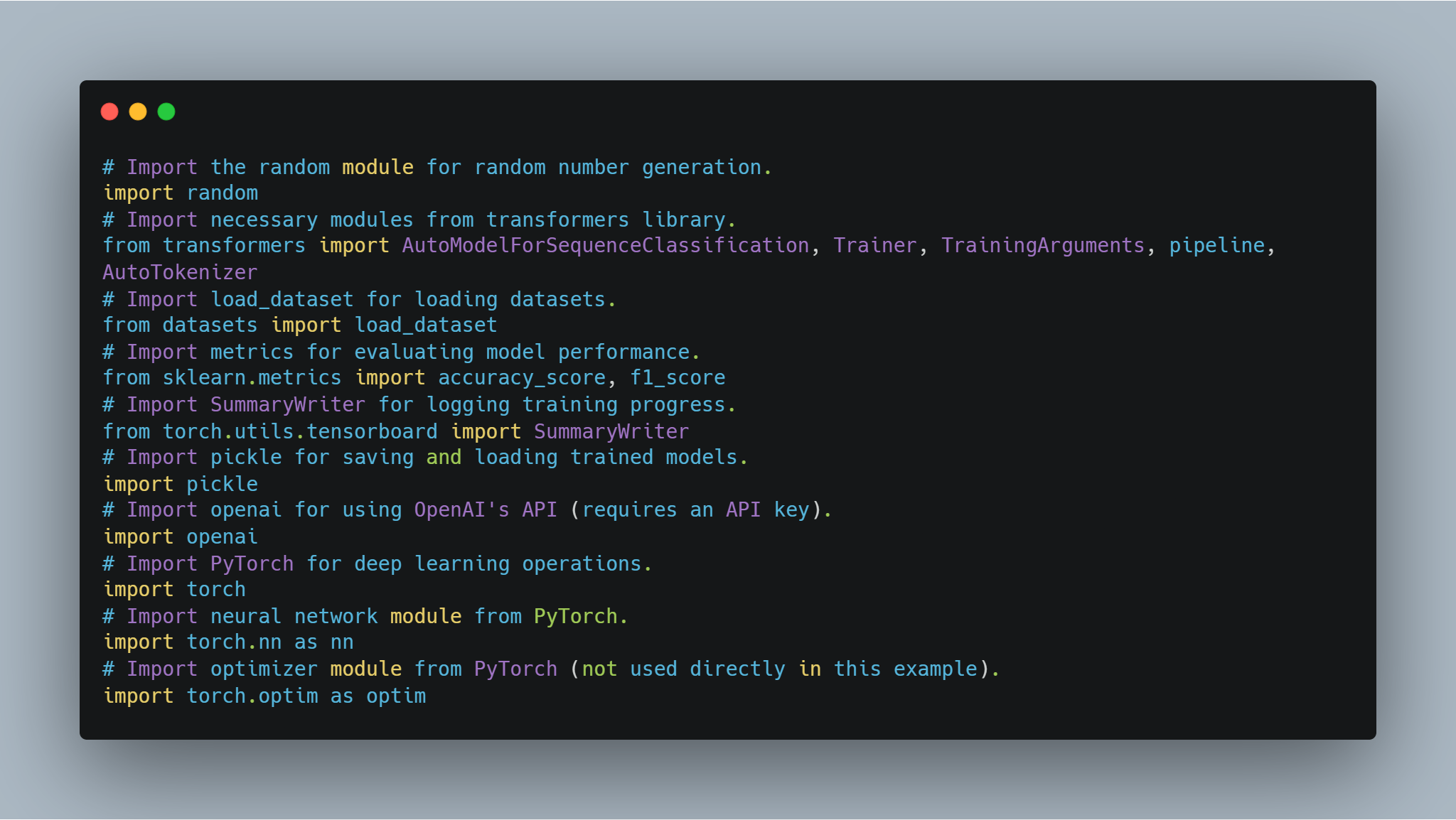

Les grands modèles de langue tels que GPT-3 et PaLM ont révolutionné le traitement du langage naturel (TLN) en exploitant des techniques de deep learning et de vastes jeux de données.

Cependant, ces avancées reviennent à un coût significatif. L’entraînement de GGUs nécessite de substantiels ressources calculatoires, souvent impliquant des milliers de GPU et une consommation énergétique importante.

Selon Sam Altman, PDG d’OpenAI, les coûts d’entraînement pour GPT-4 ont dépassé 100 millions de dollars. Cela correspond au volume et à la complexité du modèle annoncés, avec des estimations suggérant qu’il possède environ 1 trillion de paramètres. Cependant, d’autres sources offrent des chiffres différents :

-

Un rapport divulgué indiquait que les coûts d’entraînement de GPT-4 étaient d’environ 63 millions de dollars, en tenant compte de la puissance calculatoire et de la durée de l’entraînement.

-

Au milieu de 2023, certaines estimations suggéraient que l’entraînement d’un modèle similaire à GPT-4 pourrait coûter environ 20 millions de dollars et prendre environ 55 jours, reflétant les progrès en matière d’efficacité.

Ces coûts élevés d’entraînement et de maintenance des GMT limitent leur adoption large et leur scalabilité.

Limitations des données et biais

La performance des GMT est fortement tributaire de la qualité et de la diversité des données d’entraînement. Malgré l’entraînement sur de vastes ensembles de données, les GMT peuvent encore présenter les biais présents dans les données, conduisant à des sorties décalées ou inappropriées. Ces biais peuvent se manifester sous diverses formes, y compris des biais selon le sexe, la race et la culture, qui peuvent perpétuer les stéréotypes et les informations erronées.

De plus, la nature statique des données d’entraînement signifie que les GMT peuvent ne pas être à jour avec les informations les plus récentes, limitant ainsi leur efficacité dans des environnements dynamiques.

Spécialisation et complexité

Bien que les GMT soient excellents dans les tâches générales, elles font souvent face à des défis dans les tâches spécialisées exigeant des connaissances spécifiques au domaine et une complexité élevée.

Par exemple, les tâches dans les domaines tels que la médecine, le droit et la recherche scientifique exigent une compréhension profonde du vocabulaire spécialisé et de la logique nuancée, que les GMT ne possèdent pas nécessairement intrinsèquement. Cette limitation exige l’intégration de couches supplémentaires d’expertise et l’entraînement fine pour rendre les GMT efficaces dans les applications spécialisées.

Limitations des entrées et des sens.

Les GIE primaire traitent des entrées basées sur le texte, ce qui limite leur capacité à interagir avec le monde de manière multimodale. Bien qu’ils puissent générer et comprendre du texte, ils ne sont pas capables de traiter directement les entrées visuelles, auditives ou sensorielle.

Cette limitation entrave leur application dans des domaines exigeant une intégration sensorielle complète, tels que la robotique et les systèmes autonomes. Par exemple, un GIE ne peut pas interpréter les données visuelles d’une caméra ou les données auditives d’un microphone sans des couches de traitement supplémentaires.

Contraintes de communication et d’interaction

Les capacités de communication actuelles des GIE sont principalement basées sur le texte, ce qui limite leur capacité à s’engager dans des formes de communication plus immersives et interactives.

Par exemple, si bien que des GIE peuvent générer des réponses textuelles, ils ne peuvent pas produire de contenu vidéo ou des représentations holographiques, qui sont de plus en plus importants dans les applications de réalité virtuelle et augmentée (lire plus ici). Cette contrainte réduit l’efficacité des GIE dans des environnements exigeant des interactions riches et multimodales.

Comment surmonter les limites avec les agents intelligents

Les agents intelligents offrent une solution prometteuse à bon nombre des limites rencontrées par les GIE. Ces agents sont conçus pour fonctionner de manière autonome, percevoir leur environnement, prendre des décisions et exécuter des actions pour atteindre des objectifs spécifiques. En intégrant des agents intelligents aux GIE, il est possible d’améliorer leurs capacités et de lever leurs limitations inhérentes.

-

Amélioration du contexte et de la mémoire : Les agents intelligents peuvent conserver le contexte sur plusieurs interactions, permettant de donner des réponses plus cohérentes et pertinentes dans le contexte. Cette capacité est particulièrement utile dans les applications qui requièrent de la mémoire à long terme et une continuité, telles que le service client et les assistants personnels.

-

Intégration multimodale : Les agents intelligents peuvent intégrer des entrées sensorielle provenant de diverses sources, telles que les caméras, les microphones et les capteurs, permettant aux GLL de traiter et de répondre aux données visuelles, auditives et sensorielle. Cette intégration est essentielle pour les applications dans les systèmes robots et autonomes.

-

Connaissance et expertise spécialisées : Les agents AI peuvent être affinés avec des connaissances spécifiques au domaine, ce qui améliore la capacité des LLM à exécuter des tâches spécialisées. Cette méthode permet de créer des systèmes experts capables de traiter des demandes complexes dans des domaines tels que la médecine, le droit et la recherche scientifique.

-

Communication interactive et immersive : Les agents AI peuvent faciliter des formes plus immersives de communication en générant du contenu vidéo, contrôlant des affichages holographiques et interagissant avec des environnements de réalité virtuelle et augmentée. Cette capacité élargit l’application des LLM dans des domaines nécessitant des interactions multimodales riches.

Bien que les grands modèles de langue naturelle aient montré des capacités remarquables dans le traitement du langage naturel, ils présentent des limites. Les coûts de formation élevés, les biais de données, les défis de spécialisation, les limitations sensorielle et les contraintes de communication posent des obstacles importants.

Cependant, l’intégration d’agents intelligents offre un chemin viable pour surmonter ces limites. En exploitant les forces des agents intelligents, il est possible d’améliorer les fonctionnalités, l’adaptabilité et l’applicabilité des GMT, ouvrant la voie vers des systèmes d’IA plus avancés et polyvalents.

Chapitre 2 : L’histoire de l’intelligence artificielle et des agents d’IA

Le début de l’intelligence artificielle

La notion d’intelligence artificielle (IA) a des racines beaucoup plus anciennes que l’ère numérique moderne. L’idée de créer des machines capables de raisonner comme l’homme peut être retracée jusqu’à des mythes antiques et des débats philosophiques. Mais la naissance formelle de l’IA en tant que discipline scientifique a eu lieu dans la deuxième moitié du 20e siècle.

La conférence de Dartmouth de 1956, organisée par John McCarthy, Marvin Minsky, Nathaniel Rochester et Claude Shannon, est largement considérée comme le berceau de l’IA en tant que domaine d’étude. Cet événement seminal a rassemblé les principaux chercheurs pour explorer le potentiel de la création de machines capable de simuler l’intelligence humaine.

L’Optimisme des débuts et l’hiver de l’IA

Les premières années de recherche en IA étaient caractérisées par un optimisme sans entraves. Les chercheurs ont fait des progrès importants dans la création de programmes capables de résoudre des problèmes mathématiques, de jouer aux jeux et même de procéder à une communication naturelle de base.

Cependant, cet enthousiasme initial a été tempéré par la réalité que créer des machines véritablement intelligentes était beaucoup plus complexe que prévu initialement.

Les années 1970 et 1980 ont vu une période de financement réduit et d’intérêt moindre pour les recherches en IA, couramment appelée la « hiver de l’IA« . Cette baisse était principalement due à l’échec des systèmes IA à atteindre les espérances élevées des pionniers早期.

De la logique des règles à l’apprentissage automatique

L’ère des systèmes experts

Les années 1980 ont été témoins d’un regain d’intérêt en IA, principalement impulsé par le développement des systèmes experts. Ces programmes basés sur des règles étaient conçus pour émuler les processus de décision des experts humains dans des domaines spécifiques.

Les systèmes experts trouvent des applications dans divers domaines, y compris la médecine, les finances et l’ingénierie. Cependant, ils étaient limités par leur incapacité d’apprendre à partir de l’expérience ou d’adapter à de nouvelles situations en dehors de leurs règles programmées.

L’émergence de l’apprentissage automatique

Les limites des systèmes basés sur des règles ont ouvert la voie pour un changement de paradigme vers l’apprentissage automatique. Cette approche, qui a pris de l’importance dans les années 1990 et 2000, se concentre sur la développement d’algorithmes qui peuvent apprendre à partir de données et faire des prédictions ou des décisions.

Les techniques d’apprentissage automatique, telles que les réseaux de neurones et les machines à support vectoriel, ont montré un succès remarquable dans des tâches telles que la reconnaissance de modèles et la classification des données. L’avènement du big data et l’accroissement de la puissance de calcul ont encore accéléré le développement et l’application des algorithmes d’apprentissage automatique.

L’émergence d’agents intelligents autonomes

De l’IA restreinte à l’IA générale

Avec l’évolution continue des technologies IA, les chercheurs ont commencé à explorer la possibilité de créer des systèmes plus polyvalents et autonomes. Ce changement a marqué la transition de l’IA restreinte, conçue pour des tâches spécifiques, vers la poursuite de l’intelligence artificielle générale (AGI).

L’IA générique vise à développer des systèmes capables de réaliser toute tâche intellectuelle que peut effectuer un humain. Si l’IA générique reste un objectif éloigné, des progrès importants ont été réalisés dans la création de systèmes IA plus flexibles et adaptables.

Le rôle de l’apprentissage profond et des réseaux de neurones

L’apparition de l’apprentissage profond, un sous-domaine de l’apprentissage automatique basé sur les réseaux de neurones artificiels, a été essentiel pour avancer dans le domaine de l’IA.

Les algorithmes d’apprentissage profond, inspirés par la structure et la fonction du cerveau humain, ont démontré des capacités remarquables dans des domaines tels que la reconnaissance d’images et de la parole, le traitement du langage naturel et le jeu. Ces avancées ont jeté les fondations pour le développement d’agents autonomes IA plus sophistiqués.

Caractéristiques et types d’agents IA

Les agents IA sont des systèmes autonomes capable de percevoir leur environnement, de prendre des décisions et d’effectuer des actions pour atteindre des objectifs spécifiques. Ils possèdent des caractéristiques telles que l’autonomie, la perception, la réactivité, la raisonnement, la prise de décision, l’apprentissage, la communication et l’orientation vers les objectifs.

Il existe plusieurs types d’agents IA, chacun avec des capacités uniques :

-

Agents de réflexe simples : répondent à des stimuli spécifiques en fonction de règles prédéfinies.

-

Agents Reflexifs Basés sur un Modèle : Maintiennent un modèle interne de l’environnement pour la prise de décisions.

-

Agents Orientés vers des Objectifs : Exécutent des actions pour atteindre des objectifs spécifiques.

-

Agents Basés sur l’Utilité : Considerent les résultats potentiels et choisissent des actions maximisant l’utilité attendue.

-

Agents Apprenants : Améliorent la prise de décision au fil du temps grâce à des techniques d’apprentissage automatique.

Defis et Considérations Ethiques

Les systèmes d’IA de plus en plus avancés et autonomes soulèvent des considérations critiques pour assurer que leur utilisation reste dans les limites acceptées socialement.

Les Grands Modèles de Langue (GML), en particulier, agissent comme des surdouateurs de productivité. Mais cela soulève une question cruciale : Que vont ces systèmes surdonder — de bonnes intentions ou de mauvaises intentions ? Lorsque l’intention derrière l’utilisation de l’IA est malveillante, il devient impératif pour ces systèmes de détecter ce détournement à l’aide de diverses techniques de PLN ou d’autres outils à notre disposition.

Les ingénieurs en génie logiciel disposent d’un ensemble de outils et de méthodologies pour s’attaquer à ces défis :

-

Analyse dessentiments : En utilisant l’analyse dessentiments, les LLM peuvent évaluer le ton émotionnel du texte pour détecter un langage harmful ou agressif, aidant à identifier une potentielle utilisation abusive sur les plateformes de communication.

-

Filtre de contenu : Des outils tels que le filtrage par mot-clé et le matching de modèles peuvent être utilisés pour empêcher la génération ou la propagation de contenu harmful, comme le discours haineux, les informations fausses ou les matériaux explicites.

-

Outils de détection de biais : L’implémentation de cadres de détection de biais, tels que AI Fairness 360 (IBM) ou Indicateurs de Fairness (Google), peut aider à identifier et à atténuyer le biais dans les modèles de langue, visant à assurer une impartialité et une équité équitables dans les systèmes d’IA.

-

Techniques d’explicabilité

: En utilisant des outils d’explicabilité tels que LIME (Local Interpretable Model-agnostic Explanations) ou SHAP (SHapley Additive exPlanations), les ingénieurs peuvent comprendre et expliquer les processus de prise de décision des LLM (Large Language Models), ce qui facilite la détection et la correction de comportements non intentionnels.

-

Testage adversaire : En simulant des attaques malveillantes ou des entrées nocives, les ingénieurs peuvent mettre à l’épreuve les LLM en utilisant des outils tels que TextAttack ou Adversarial Robustness Toolbox, identifiant ainsi des vulnérabilités qui pourraient être exploitées à des fins malveillantes.

-

Guidelines et cadres éthiques pour l’IA : En adoptant des directives d’élaboration éthique de l’IA, telles que celles fournies par le IEEE ou le Partnership on AI, les ingénieurs peuvent guider la création de systèmes d’IA responsables qui privilégient le bien-être de la société.

En plus de ces outils, c’est pourquoi nous avons besoin d’une équipe Red Team spécialisée pour l’IA — des équipes spécialisées qui poussent les LLM à leurs limites pour détecter les lacunes dans leurs défenses. Les équipes rouges simulent des scénarios adversaires et découvrent les vulnérabilités qui pourraient sinon rester non remarquées.

Mais il est important de reconnaître que les personnes derrière le produit ont d’énormes effets sur celui-ci. Beaucoup des attaques et défis que nous confrontons aujourd’hui ont existé même avant que les LLM soient développées, soulignant que l’élément humain demeure central pour s’assurer que l’IA est utilisée de manière éthique et responsable.

L’intégration de ces outils et techniques dans la chaîne de développement, accompagnée d’une vigilante Red Team, est essentielle pour s’assurer que les LLM sont utilisées pour multiplier les résultats positifs tout en détectant et prévenant leur utilisation abusée.

Chapitre 3 : Les Points forts des Agents IA

Les forces uniques des agents IA

Les agents IA se démarquent grâce à leur capacité d’autonomes à percevoir leur environnement, prendre des décisions et exécuter des actions pour atteindre des objectifs spécifiques. Cette autonomie, combinée aux capacités avancées d’apprentissage automatique, permet aux agents IA de réaliser des tâches qui sont soit trop complexes ou trop répétitifs pour les humains.

Voici les principaux points forts qui font briller les agents intelligents :

-

Autonomie et Efficacité : Les agents intelligents peuvent fonctionner indépendamment sans intervention constante des humains. Cette autonomie leur permet de traiter des tâches 24 heures sur 24, ce qui améliore significativement l’efficacité et la productivité. Par exemple, les bots de chat dotés d’intelligence artificielle peuvent gérer jusqu’à 80% des demandes clients courantes, réduisant les coûts opérationnels et améliorant les délais de réponse.

-

Propriétés de décision avancées : Les agents intelligents peuvent analyser des quantités considérables de données pour prendre des décisions informées. Cette capacité est particulièrement précieuse dans les domaines tels que les finances, où les bots de trading dotés d’intelligence artificielle peuvent beaucoup accroître l’efficacité des transactions.

-

Apprentissage et adaptabilité : Les agents intelligents peuvent apprendre à partir de l’expérience et s’adapter à de nouvelles situations. Cette amélioration continue leur permet de renforcer leurs performances au fil du temps. Par exemple, les assistants médicaux intelligents peuvent aider à réduire les erreurs de diagnostic, améliorant ainsi les résultats des soins de santé.

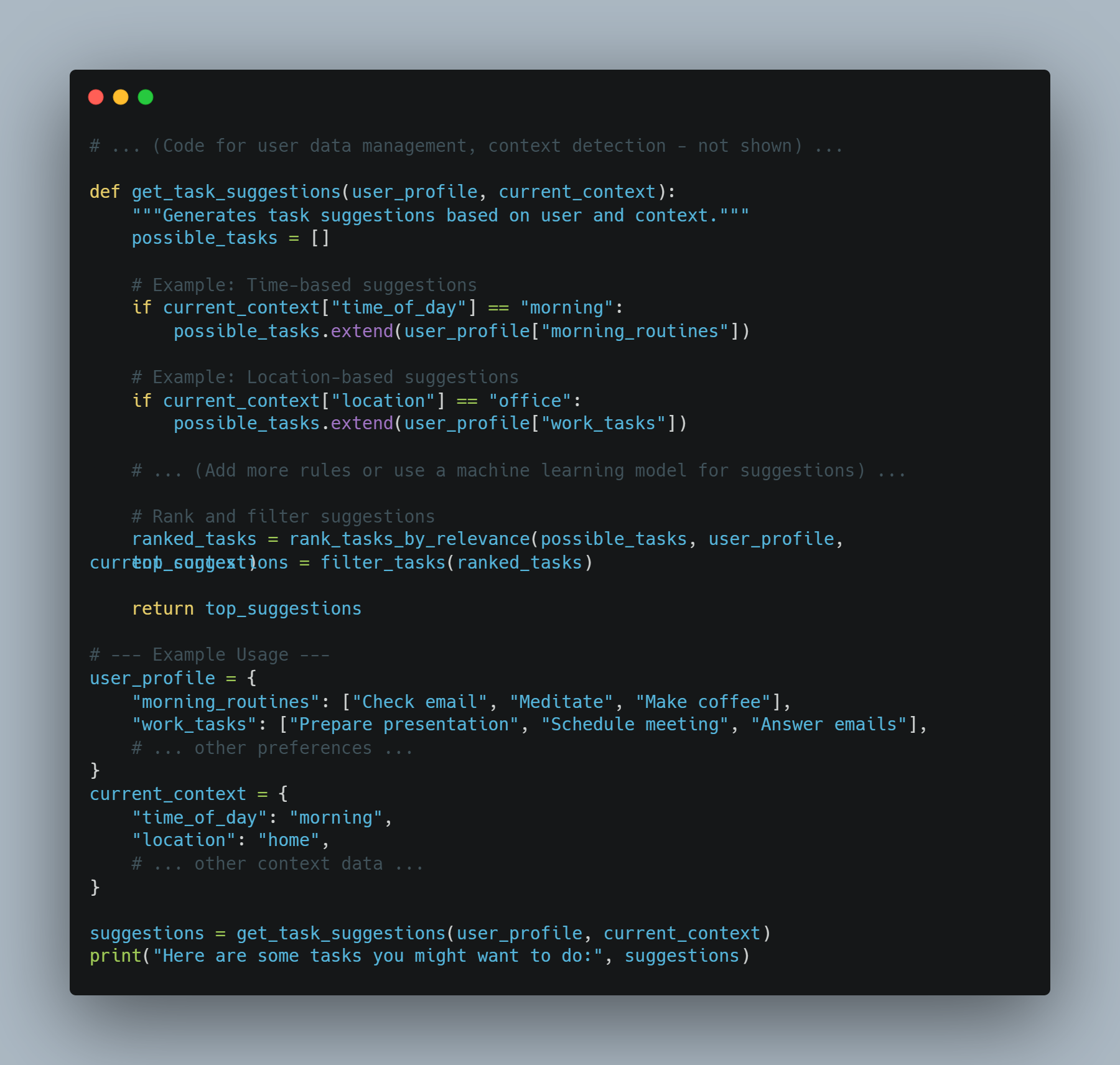

- Personnalisation : Les agents intelligents peuvent offrir des expériences personnalisées en analysant le comportement et les préférences des utilisateurs. Le moteur de recommandations d’Amazon, qui représente 35 % de ses ventes, est un excellent exemple de la manière dont les agents intelligents peuvent améliorer l’expérience utilisateur et augmenter les revenus.

Pourquoi les agents intelligents sont la solution

Les agents intelligents offrent des solutions à de nombreux défis auxquels font face les logiciels traditionnels et les systèmes opérés par des humains. Voici pourquoi ils sont le choix préféré :

-

Évolutivité : Les agents intelligents peuvent élargir leurs opérations sans augmentation proportionnelle des coûts. Cette évolutivité est cruciale pour les entreprises souhaitant croître sans augmenter significativement leur effectif ou leurs dépenses opérationnelles.

-

Consistance et fiabilité : Contrairement aux humains, les agents intelligents ne sont pas affectés par la fatigue ou l’incohérence. Ils peuvent exécuter des tâches répétitives avec une haute précision et une fiabilité élevées, assurant ainsi un rendement cohérent.

-

Actions basées sur les données : Les agents intelligents peuvent traiter et analyser de grandes quantités de données pour découvrir des modèles et des informations que les humains pourraient manquer. Cette capacité est précieuse pour la prise de décisions dans des domaines tels que les finances, la santé et la marketing.

-

Économies de coûts : En automatisant les tâches routinières, les agents intelligents peuvent réduire la nécessité d’employés humains, aboutissant à des économies importantes. Par exemple, des systèmes de détection de fraude dotés d’IA peuvent économiser des milliards de dollars par année en réduisant les activités frauduleuses.

Conditions Requises pour le Bon Fonctionnement des Agents Intelligents

Pour assurer le déploiement réussi et le bon fonctionnement des agents intelligents, certaines conditions doivent être remplies :

-

Objectifs et Cas D’utilisation Clairs : Définir des objectifs et des cas d’utilisation spécifiques est crucial pour le déploiement efficace des agents intelligents. Cette clarté aide à établir des attentes et à mesurer le succès. Par exemple, fixer l’objectif de réduire le temps de réponse du service client de 50% peut guider le déploiement de robots d’assistance intelligents.

-

Données de qualité : Les agents intelligents ont besoin de données de haute qualité pour l’entraînement et le fonctionnement. Assurer que les données sont exactes, pertinentes et à jour est essentiel pour que les agents puissent prendre des décisions informées et fonctionner efficacement.

-

Intégration avec les systèmes existants : Une intégration sans faille avec les systèmes existants et les flux de travail est nécessaire pour que les agents intelligents fonctionnent de manière optimale. Cette intégration garantit que les agents intelligents peuvent accéder aux données nécessaires et interagir avec d’autres systèmes pour exécuter leurs tâches.

-

Surveillance et optimisation continues : La surveillance et l’optimisation régulières des agents intelligents sont cruciales pour maintenir leurs performances. Cela implique le suivi des indicateurs clés de performance (KPIs) et la mise à jour des données de rendement pour apporter les ajustements nécessaires.

-

Considérations éthiques et atténuation des biais : Traiter les considérations éthiques et atténuer les biais chez les agents IA est essentiel pour assurer l’équité et l’inclusivité. Mettre en œuvre des mesures pour détecter et prévenir les biais peut aider à construire la confiance et à assurer un déploiement responsable.

Meilleures pratiques pour le déploiement d’agents IA

Lors du déploiement d’agents IA, suivre les meilleures pratiques peut assurer leur succès et leur efficacité :

-

Définir les objectifs et les cas d’utilisation : Identifier clairement les objectifs et les cas d’utilisation pour le déploiement d’agents IA. Cela aide à établir les attentes et à mesurer le succès.

-

Choisir la plateforme AI correcte : Sélectionnez une plateforme AI qui est alignée avec vos objectifs, les cas d’utilisation et l’infrastructure existante. Pensez aux facteurs tels que les capacités d’intégration, la scalabilité et le coût.

-

Développer une base de connaissance complète : Construisez une base de connaissance bien structurée et précise pour permettre aux agents AI de fournir des réponses pertinentes et fiables.

-

S’assurer de l’intégration en une seule foulée : Intégrez les agents AI avec les systèmes existants tels que le CRM et les technologies de centres d’appels pour fournir une expérience client unifiée.

-

Former et optimiser les agents AI : Formez et optimisez constamment les agents AI à l’aide de données provenant des interactions. Surveillez le rendement, identifiez les domaines à améliorer, et mettez à jour les modèles correspondant.

-

Mettre en œuvre des procédures d’escalade adéquates : Définir des protocoles pour transférer les appels complexes ou émotionnels à des agents humains, en assurant une transition fluide et une résolution efficace.

-

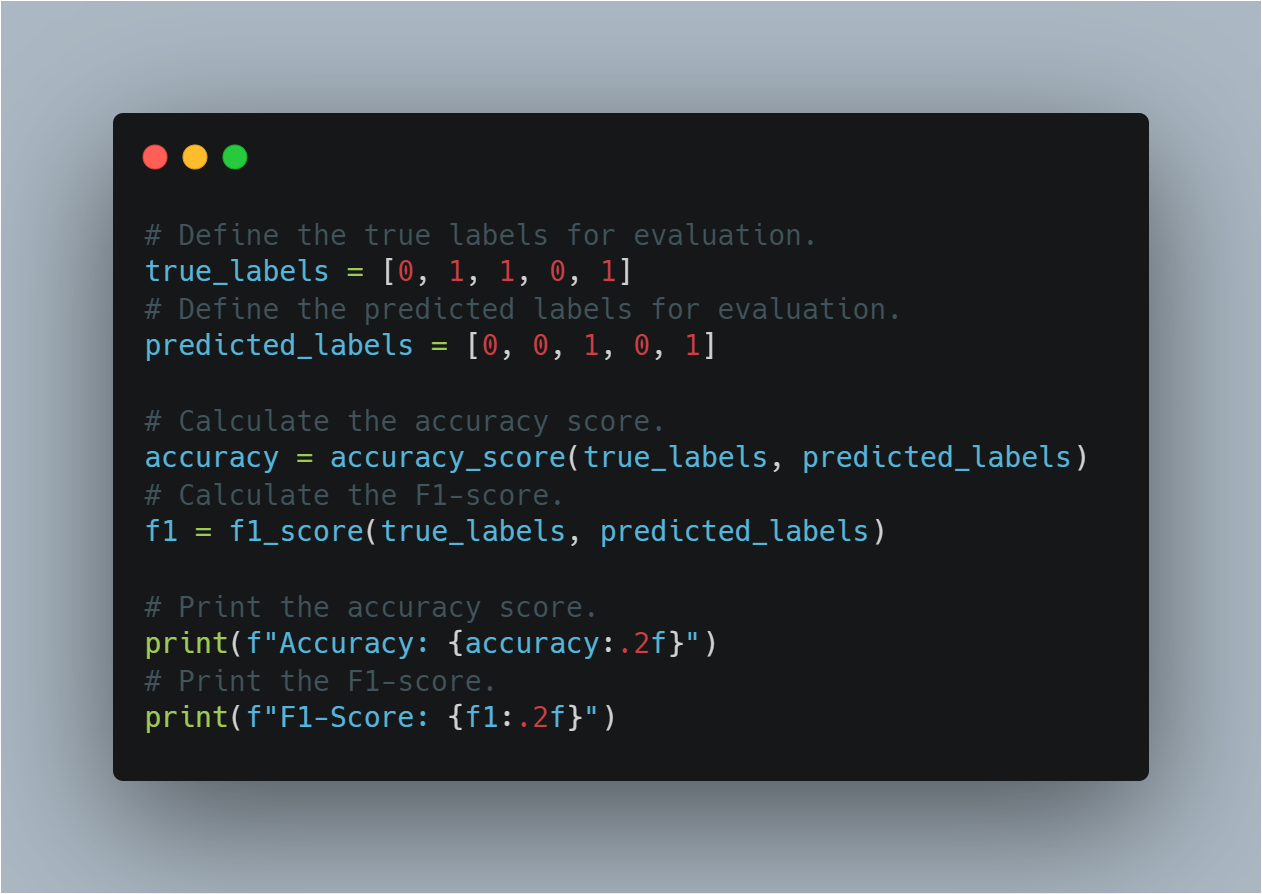

Surveiller et analyser la performance : Suivre les indicateurs clés de performance (KPIs) tels que les taux de résolution des appels, le temps de traitement moyen et les scores de satisfaction client. Utilisez des outils d’analyse pour obtenir des insights basés sur les données et prendre des décisions.

-

Assurer la confidentialité et la sécurité des données : Des mesures de sécurité robustes sont essentielles, telles que rendre les données anonymes, assurer une surveillance humaine, définir des politiques pour la conservation des données et mettre en œuvre des mesures d’encodage fortes pour protéger les données clientales et maintenir la confidentialité.

AGENTS AI + GLLM : UN NOUVEAU SIÈCLE DE LOGICIELS INTELLIGENTS

Imaginez un logiciel capable not seulement de comprendre vos demandes mais également de les exécuter. C’est la promesse de la combinaison d’agents intelligents avec des Grands Modèles de Langue (GML). Cette association puissante crée une nouvelle génération d’applications plus intuitives, capables et impactantes que jamais auparavant.

Les Agents Intelligents : Au-delà de l’Exécution de Tâches Simples

Bien que souvent comparés aux assistants numériques, les agents intelligents sont bien plus que des suiveurs de script devenus arrondis. Ils englobent une gamme de technologies sophistiquées et opèrent dans un cadre qui permet le processus décisionnel dynamique et l’exécution d’actions.

-

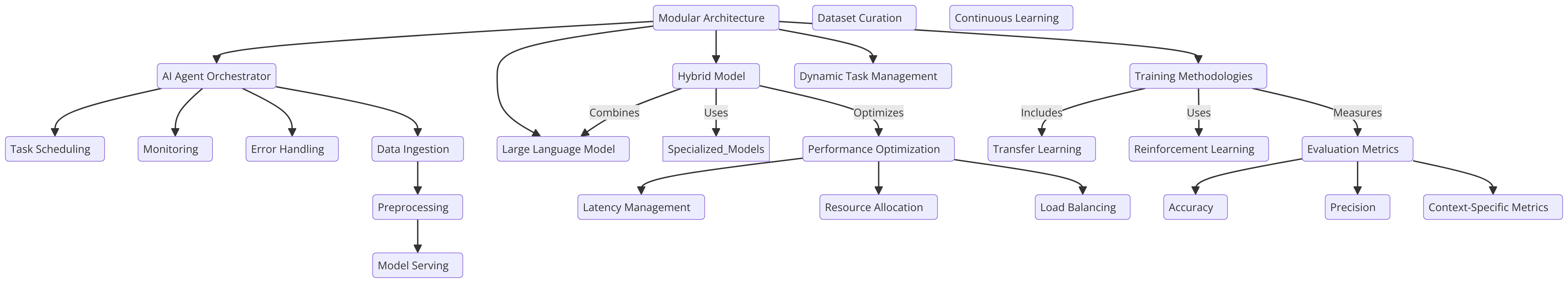

Architecture : Un agent intelligent typique est composé de plusieurs composants clés :

-

Capteurs : Ces derniers permettent à l’agent de percevoir son environnement, en collectant des données provenant de diverses sources telles que des capteurs, des API ou de l’entrée utilisateur.

-

État des Croyances : Il représente la compréhension de l’agent du monde en fonction des données collectées. Il est constamment mis à jour à mesure que de nouvelles informations sont disponibles.

-

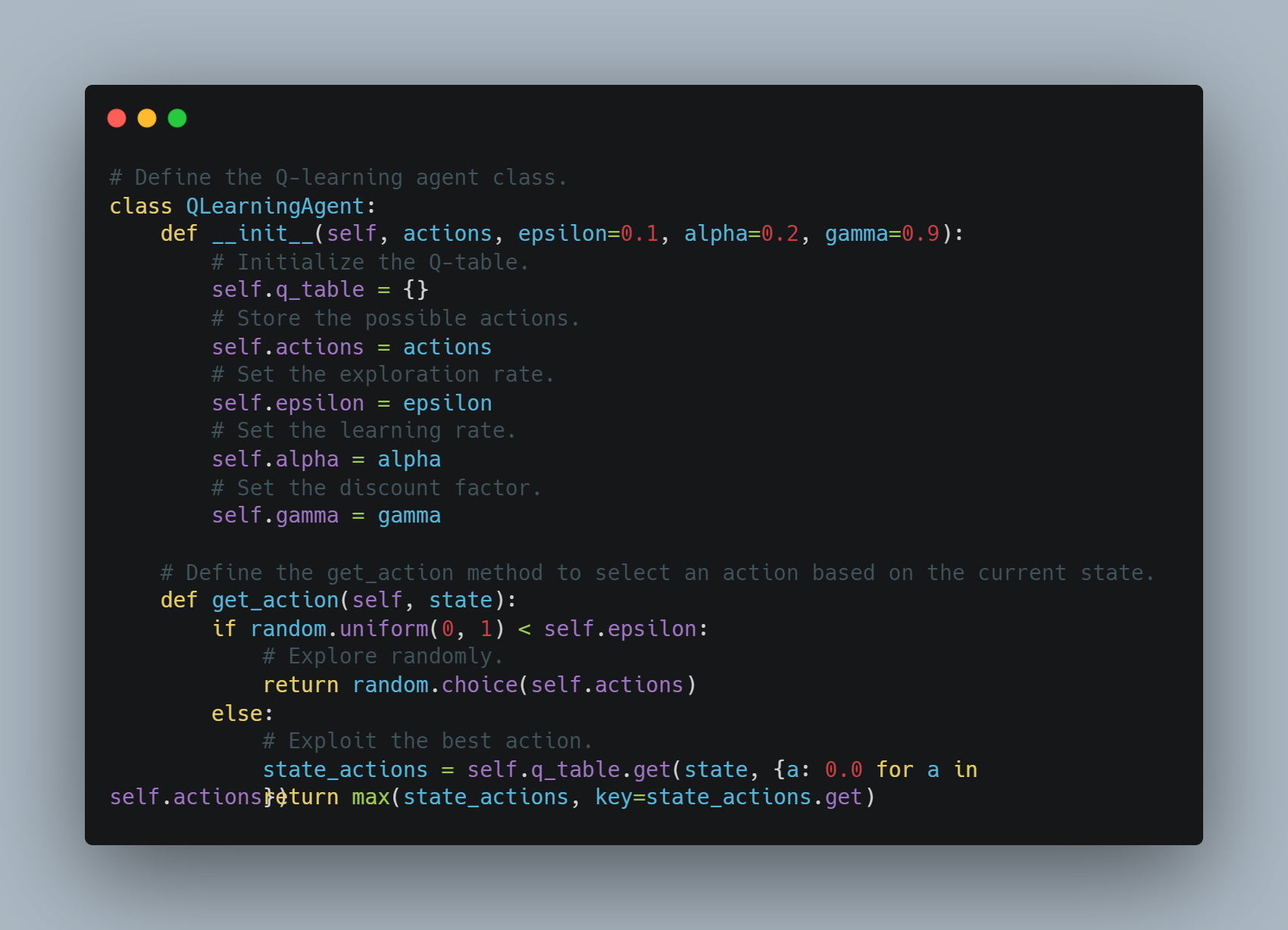

Moteur de Raisons : Il s’agit du cœur du processus de décision de l’agent. Il utilise des algorithmes, souvent basés sur l’apprentissage par renforcement ou sur des techniques de planification, pour déterminer la meilleure action en fonction de ses croyances et de ses objectifs actuels.

-

Actionneurs : Ils sont les outils de l’agent pour interagir avec le monde. Ils peuvent aller从envoyer des appels API à contrôler des robots physiques.

-

-

Challenges : Les agents intelligents traditionnels, quoique habiles à traiter des tâches bien définies, font souvent face à :

-

Comprendre le Langage Naturel : Interpréter le langage humain nuancé, gérer l’ambiguïté et extraire du sens du contexte demeure un défi significatif.

-

Réasonner avec le Sens Commun : Les agents intelligents actuels souffrent souvent d’un manque de connaissances de base et de capacités de raisonnement que les humains tiennent pour acquis.

-

Généralisation : L’entraînement d’agents pour s’exécuter bien sur des tâches non vues ou pour s’adapter à de nouveaux environnements demeure une zone clé de recherche.

-

LLM : Déverrouiller la compréhension et la génération du langage

Les LLM, avec leur connaissance imense encodée dans des milliards de paramètres, apportent des capacités linguistiques sans précédent à la table :

-

Architecture Transformer : La base de la plupart des LLM modernes est l’architecture transformer, une conception de réseau de neurones qui excelle dans le traitement de données séquentielles comme le texte. Cela permet aux LLM de capturer les dépendances à long terme dans le langage, les rendant capables de comprendre le contexte et de générer du texte cohérent et pertinent du point de vue contextuel.

-

Capacités : Les LLM se démarquent dans une large gamme de tâches basées sur le langage :

-

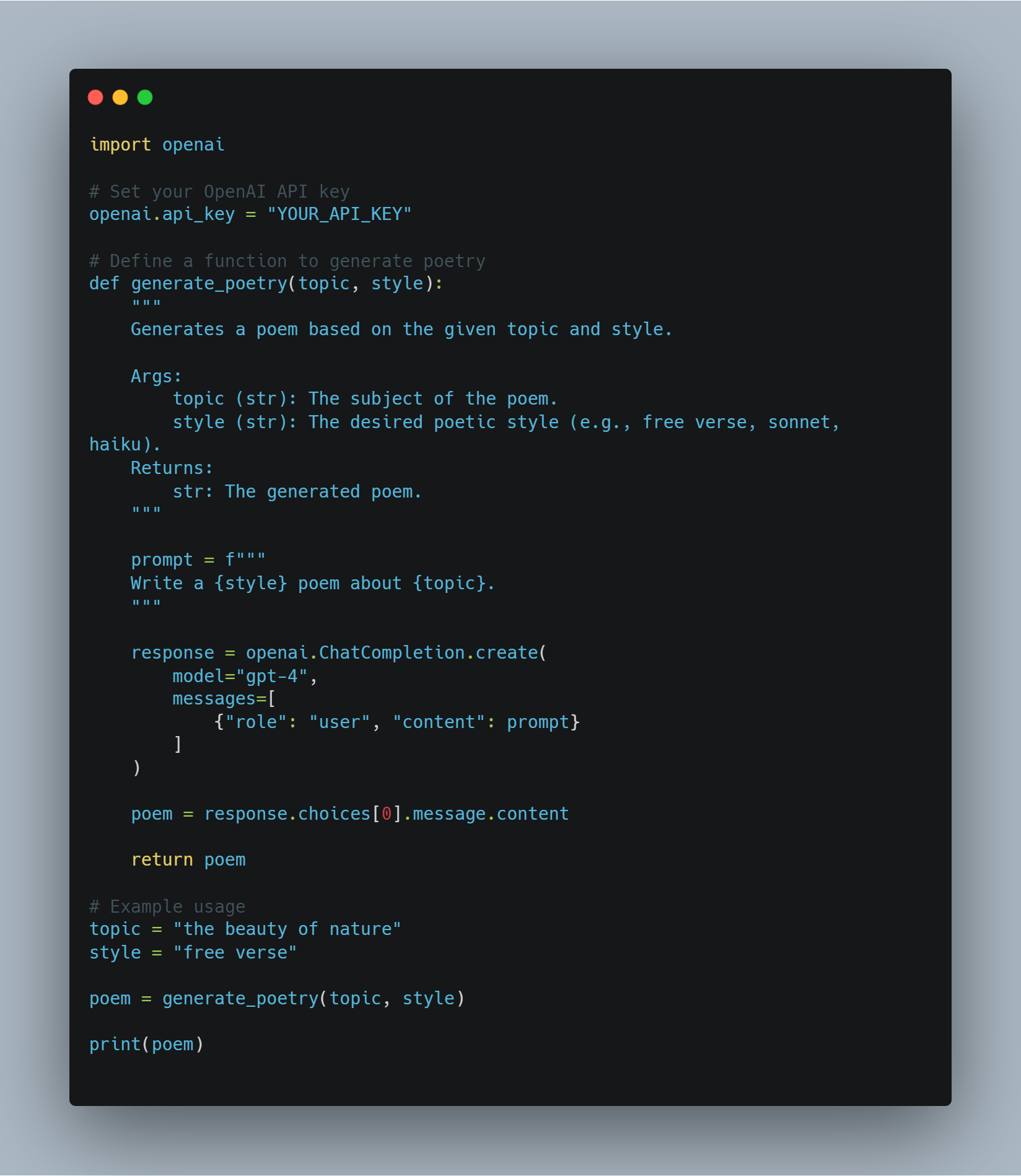

Génération de texte : Des écrits de fiction créative à la génération de code dans plusieurs langages de programmation, les LLM font preuve d’une remarquable aisance et de créativité.

-

Réponse à des questions : Ils peuvent fournir des réponses concises et exactes à des questions, même lorsque l’information est dispersée dans des documents longs.

-

Résumé : Les LLM peuvent résumer des volumes importants de texte en extraissant les informations clés et en éliminant les détails inutiles.

-

-

Limitations : Malgré leurs capacités impressionnantes, les GLL présentent des limitations :

-

Manque de base dans le monde réel : Les GLL opèrent principalement dans le domaine du texte et n’ont pas la capacité d’interagir directement avec le monde physique.

-

Potentiel de biais et d’illusion : Entraînés sur des jeux de données massifs et non ciblés, les GLL peuvent hériter des biais présents dans les données et parfois générer des informations factuellement incorrecte ou absurde.

-

La synergie : Faire le lien entre le langage et l’action

La combinaison d’agents intelligents et de GLLM permet de surmonter les limitations de chacun, créant des systèmes qui sont à la fois intelligents et capables :

-

Les GLLM en tant qu’interprètes et planificateurs : Les GLLM peuvent traduire les instructions naturelles en un format que les agents peuvent comprendre, permettant une interaction humain-ordinateur plus intuitive. Elles peuvent également utiliser leurs connaissances pour aider les agents à planifier des tâches complexes en les décomposant en plus petits et plus aisés.

- Les agents intelligents en tant qu’exécutants et apprenants : Les agents intelligents offrent aux LLM la capacité d’interagir avec le monde réel, de rassembler des informations et de recevoir des retours sur leurs actions. Cette immersion dans le monde réel peut aider les LLM à apprendre par expérience et à améliorer leurs performances au fil du temps.

Cette synergie puissante est à l’origine du développement d’une nouvelle génération d’applications plus intuitives, adaptables et capables que jamais. Avec l’avancement des technologies tant des agents intelligents que des LLM, nous pouvons attendre la naissance de plus d’innovations et d’applications impactantes, repensant ainsi le paysage de l’édition de logiciels et de l’interaction homme-ordinateur.

Exemples réels : transformation des industries

Cette combinaison puissante est déjà en train de secouer divers secteurs :

-

Service client : résoudre des problèmes avec une prise en compte contextuelle

- Exemple : Envisagez un client qui contacte un détaillant en ligne à propos d’une expédition retardée. Un agent AI alimenté par une MM peut comprendre la frustration du client, accéder à leur historique d’ commandes, suivre le colis en temps réel et proposer proactivement des solutions telles que l’expédition accélérée ou une remise sur leur prochaine commande.

-

Création de contenu : génération de contenu de haute qualité à l’échelle

- Exemple : Une équipe de marketing peut utiliser un système d’agent AI + MM pour générer des publications ciblées sur les réseaux sociaux, écrire des descriptions de produits ou même créer des scripts de vidéo. L’MM garantit que le contenu est engageant et informatif, tandis que l’agent AI gère le processus de publication et de distribution.

-

Développement de logiciels : Accélération du codage et du débogage

- Exemple : Un développeur peut décrire une fonctionnalité de logiciel qu’il souhaite créer en utilisant le langage naturel. L’IA large peut alors générer des extraits de code, identifier les erreurs potentielles et proposer des améliorations, accélérant considérablement le processus de développement.

-

Santé : Personnaliser le traitement et améliorer les soins aux patients

- Exemple : Un agent intelligent doté d’un LLM et ayant accès à l’historique médical d’un patient peut répondre à leurs questions sur la santé, leur fournir des rappels personnalisés de médicaments et même proposer des diagnostics préliminaires en fonction de leurs symptômes.

-

Droit : rationaliser la recherche juridique et la rédaction de documents

- Exemple : Un avocat doit rédiger un contrat avec des clauses spécifiques et des précédents juridiques. Un agent IA alimenté par une MMJ peut analyser les instructions de l’avocat, parcourir de vastes bases de données juridiques, identifier les clauses et précédents pertinents, et même rédiger des parties du contrat, réduisant显著ement le temps et les efforts requis.

-

Création de vidéos : générer des vidéos engageantes avec facilité

- Exemple : Une équipe de marketing souhaite créer une courte vidéo expliquant les caractéristiques de leur produit. Ils peuvent fournir un système d’IA + MMJ avec un schéma de script et des préférences pour le style visuel. L’MMJ peut alors générer un script détaillé, suggérer de la musique et des images appropriées, et même éditer la vidéo, automatisant une grande partie du processus de création de vidéos.

-

Architecture : concevoir des bâtiments avec des insights rapides par intelligence artificielle

- Exemple : Un architecte conçoit un nouveau bâtiment de bureaux. Il peut utiliser un agent IA + un système LLM pour saisir ses objectifs de conception, tels que maximiser la lumière naturelle et optimiser l’utilisation de l’espace. L’LLM peut alors analyser ces objectifs, générer différentes options de conception, et même simuler comment le bâtiment fonctionnerait sous différentes conditions environnementales.

-

Construction : Améliorer la sécurité et l’efficacité sur les sites de construction

- Exemple : Un agent AI équipé de caméras et de capteurs peut surveiller un site de construction à la recherche de dangers pour la sécurité. Si un ouvrier n’est pas habillé avec l’équipement de sécurité adéquat ou si un appareil est laissé dans une position dangereuse, le MGAA peut analyser la situation, alerter le superviseur du site et même arrêter automatiquement les opérations si nécessaire.

L’avenir est ici : Une nouvelle ère de développement de logiciels

La convergence d’agents AI et de MGAA marque une avancée significative dans le domaine du développement de logiciels. Comme ces technologies continuent à évoluer, nous pouvons attendre davantage d’applications innovantes qui transformeront les industries, rationaliseront les flux de travail et créeront complètement de nouvelles possibilités pour l’interaction homme-ordinateur.

Les agents AI brillent le plus dans les domaines qui exigent le traitement de grandes quantités de données, l’automatisation de tâches répétitives, la prise de décisions complexes et la fourniture d’expériences personnalisées. En répondant aux conditions nécessaires et en suivant les meilleures pratiques, les organisations peuvent exploiter pleinement le potentiel des agents AI pour stimuler l’innovation, l’efficacité et la croissance.

Chapitre 4 : La base philosophique des systèmes intelligents

Le développement de systèmes intelligents, en particulier dans le domaine de l’intelligence artificielle (IA), nécessite une compréhension approfondie des principes philosophiques. Ce chapitre explore les idées philosophiques fondamentales qui ont influencé la conception, le développement et l’utilisation de l’IA. Il met en avant l’importance de aligner le progrès technologique sur les valeurs éthiques.

La base philosophique des systèmes intelligents n’est pas uniquement une exercise théorique – c’est un cadre vital qui assure que les technologies de l’IA profitent à l’humanité. En promouvant la justice, l’inclusivité et l’amélioration de la qualité de vie, ces principes orientent l’IA pour servir nos meilleurs intérêts.

Considérations éthiques dans le développement de l’IA

Avec l’intégration croissante des systèmes d’IA dans tous les aspects de la vie humaine, depuis la santé et l’éducation jusqu’à la finance et la gouvernance, nous devons examiner rigoureusement et mettre en œuvre les impératifs éthiques guidant leur conception et leur déploiement.

La question éthique fondamentale se pose sur la manière dont l’IA peut être conçue pour répondre et défendre les valeurs humaines et les principes moraux. Cette question est centrale à la manière dont l’IA formera le futur de sociétés à travers le monde.

Au cœur de ce débat éthique se trouve le principe de la bénédiction, un pilier de la philosophie morale qui prévoit que les actions devraient viser à faire le bien et à accroître le bien-être des individus et de la société dans son ensemble (Floridi & Cowls, 2019).

Dans le contexte de l’IA, la bienveillance se traduit par la conception de systèmes qui contribuent activement au prospérité humaine – des systèmes qui améliorent les résultats de la santé, augmentent les opportunités éducatives et facilitent la croissance économique équitable.

Cependant, l’application de la bienveillance en IA est loin d’être simple. Elle exige une approche nuancée qui balance prudemment les avantages potentiels de l’IA avec les risques et les dommages possibles.

L’une des principales difficultés à l’application du principe de bienveillance à la phase de développement de l’IA est la nécessité d’un équilibre délicat entre l’innovation et la sécurité.

L’IA a le potentiel de révolutionner des domaines tels que la médecine, où des algorithmes préditifs peuvent diagnostiquer des maladies plus tôt et avec plus d’exactitude que les médecins humains. Cependant, sans un contrôle éthique rigoureux, ces mêmes technologies pourraient exacerber les inégalités existantes.

Cela pourrait par exemple se produire si elles sont principalement déployées dans les régions riches tandis que les communautés sous-servies continuent de manquer d’accès aux soins de santé de base.

En raison de cela, le développement éthique de l’IA nécessite non seulement une concentration sur la maximisation des avantages mais aussi une approche proactive de la réduction des risques. Cela implique l’implémentation de safeguards robustes pour prévenir l’utilisation abusive de l’IA et assurer que ces technologies n’ont pas de conséquences indésirables.

Le cadre éthique pour l’IA doit également être intrinsèquement inclusif, garantissant que les avantages de l’IA sont distribués équitablement à tous les groupes sociaux, y compris ceux qui sont traditionnellement marginalisés. Cela exige un engagement à la justice et à l’équité, en assurant que l’IA ne renforce pas simplement le statu quo mais agit activement pour démanteler les inégalités systématiques.

Par exemple, l’automatisation du travail assistée par l’IA peut potentiellement augmenter la productivité et la croissance économique. Cependant, elle pourrait également entraîner un déplacement significatif des emplois, affectant particulièrement les travailleurs à faible revenu.

Comme vous pouvez le voir, un cadre éthique pour l’IA doit inclure des stratégies pour un partage équitable des avantages et la fourniture de systèmes de soutien pour ceux touchés négativement par les avancées de l’IA.

Le développement éthique de l’IA nécessite un engagement constant avec des parties prenantes diverses, y compris des éthiciens, des technologues, des décideurs politiques et les communautés qui seront les plus touchées par ces technologies. Cette collaboration interdisciplinaire s’assure que les systèmes d’IA ne sont pas développés dans un vide, mais sont plutôt façonnés par un large éventail de perspectives et d’expériences.

C’est à travers ce effort collectif que nous pouvons créer des systèmes d’IA qui reflètent et soutiennent les valeurs qui définissent notre humanité – la compassion, l’équité, le respect de l’autonomie et un engagement en faveur du bien commun.

Les considérations éthiques dans le développement de l’IA ne sont pas seulement des directives, mais des éléments essentiels qui détermineront si l’IA sert de force positive dans le monde. En ancrant l’IA dans les principes de la bonté, de la justice et de l’inclusivité, et en adoptant une approche vigilante en matière d’équilibre entre l’innovation et le risque, nous pouvons assurer que le développement de l’IA ne progresse pas seulement dans la technologie, mais également améliore la qualité de vie pour tous les membres de la société.

Au fur et à mesure que nous explorons les capacités de l’IA, il est impératif que ces considérations éthiques restent à l’avant de nos efforts, guidant notre chemin vers un futur où l’IA véritablement profite à l’humanité.

L’imperative du design de l’IA centrée sur l’humain

Le design de l’IA centrée sur l’humain va au-delà de simples considérations techniques. Il est ancré dans des principes philosophiques profonds qui privilégient la dignité, l’autonomie et l’agentivité humaines.

Cette approche de l’évolution de l’IA est fondamentalement ancrée dans le cadre éthique kantien, qui affirme que les humains doivent être considérés en tant que des fins en eux-mêmes, pas uniquement comme des instruments pour atteindre d’autres objectifs (Kant, 1785).

Les implications de ce principe pour le design de l’IA sont profondes, exigeant que les systèmes IA soient développés avec un focus inébranlable sur le service des intérêts humains, la préservation de l’autonomie humaine et le respect de l’autonomie individuelle.

Implémentation technique des principes centrés sur l’humain

Améliorer l’autonomie humaine par l’IA : Le concept d’autonomie dans les systèmes IA est crucial, en particulier pour s’assurer que ces technologies empower les utilisateurs plutôt que de les contrôler ou d’exercer une influence indue sur eux.

En termes techniques, cela implique de concevoir des systèmes IA qui prioritaires de l’autonomie utilisateur en leur fournissant les outils et l’information nécessaires pour prendre des décisions informées. Cela exige que les modèles IA soient contextuellement conscients, ce qui signifie qu’ils doivent comprendre le contexte particulier dans lequel une décision est prise et adapter leurs recommandations en conséquence.

Du point de vue de la conception des systèmes, cela implique l’intégration d’une intelligence contextuelle dans les modèles IA, ce qui permet à ces systèmes de s’adapter dynamiquement à l’environnement de l’utilisateur, aux préférences et aux besoins.

Par exemple, dans le domaine de la santé, un système IA qui assiste les médecins dans la diagnose des pathologies doit prendre en considération l’histoire médicale unique de chaque patient, les symptômes actuels, et même l’état psychologique pour offrir des recommandations qui soutiennent l’expertise du médecin plutôt que de la remplacer.

Cette adaptation contextuelle assure que l’IA reste un outil de soutien qui améliore, plutôt que de diminuer, l’autonomie humaine.

Assurer des Processus de Décision Transparents : La transparence des systèmes IA est une exigence fondamentale pour assurer que les utilisateurs peuvent faire confiance et comprendre les décisions prises par ces technologies. Techniquement, cela se traduit par la nécessité d’avoir un IA explicable (XAI), qui implique la développement d’algorithmes capable d’articuler clairement la logique derrière leurs décisions.

Cela est particulièrement crucial dans les domaines tels que la finance, la santé et la justice pénale, où des processus de décision opaques peuvent conduire à la méfiance et aux problèmes éthiques.

La explicabilité peut être réalisée par plusieurs approches techniques. Une méthode commune est l’interprétabilité post-hoc, où le modèle IA génère une explication après que la décision ait été prise. Cela peut impliquer décomposer la décision en ses facteurs constitutifs et montrer comment chacun d’eux a contribué à l’issue finale.

Une autre approche consiste en modèles intrinsèquement interprétables, où l’architecture du modèle est conçue de telle manière que ses décisions sont transparentes par défaut. Par exemple, des modèles tels que les arbres de décision et les modèles linéaires sont naturellement interprétables parce que leur processus de prise de décision est facile à suivre et à comprendre.

Le défi de l’introduction de l’IA explicable consiste à établir un équilibre entre la transparence et la performance. souvent, les modèles plus complexes, tels que les réseaux de neurones profonds, sont moins interprétables mais plus précis. Par conséquent, la conception de l’IA axée sur l’humain doit considérer le compromis entre l’interprétabilité du modèle et sa capacité prédictive, en assurant que les utilisateurs peuvent avoir confiance et compréhension dans les décisions de l’IA sans sacrifier la précision.

Permettre un Contrôle Humain Signifiant : Le contrôle humain significatif est crucial pour s’assurer que les systèmes d’IA fonctionnent dans les limites éthiques et opérationnelles. Ce contrôle implique la conception de systèmes d’IA avec des systèmes d’arrêt d’urgence et des mécanismes d’annulation qui permettent aux opérateurs humains d’intervenir lorsque nécessaire.

La mise en œuvre technique du contrôle humain peut se faire de plusieurs manières.

Une approche consiste à intégrer des systèmes avec l’homme dans le circuit, où les processus de prise de décision de l’IA sont constamment supervisés et évalués par des opérateurs humains. Ces systèmes sont conçus pour permettre une intervention humaine à des points cruciaux, en assurant que l’IA n’agisse pas autonomiquement dans des situations où des jugements éthiques sont requis.

Par exemple, dans le cas des systèmes d’armes autonomes, une surveillance humaine est essentielle pour éviter que l’IA n’effectue des décisions de vie ou de mort sans l’intervention de l’homme. Cela pourrait impliquer la définition de frontières opérationnelles strictes que l’IA ne peut pas franchir sans autorisation humaine, en embarquant ainsi des garanties éthiques dans le système.

Une autre considération technique est le développement de traînes d’audit, qui sont des enregistrements de toutes les décisions et actions prises par le système IA. Ces traînes fournissent une histoire transparente qui peut être revue par les opérateurs humains pour s’assurer de la conformité avec les normes éthiques.

Les traînes d’audit sont particulièrement importantes dans des secteurs tels que la finance et le droit, où les décisions doivent être documentées et justifiables pour maintenir la confiance du public et satisfaire aux exigences réglementaires.

Balancer l’Autonomie et le Contrôle : Un des principaux défis techniques dans l’IA centrée sur l’homme est de trouver le bon équilibre entre l’autonomie et le contrôle. Alors que les systèmes IA sont conçus pour fonctionner autonomement dans de nombreux scénarios, il est crucial que cet autonomie ne mine pas le contrôle ou la surveillance humaine.

Cet équilibre peut être atteint par l’implémentation de niveaux d’autonomie, qui dictent le degré d’indépendance que l’IA a dans la prise de décisions.

Par exemple, dans les systèmes semi-autonomes tels que les voitures autonomes, les niveaux d’autonomie varient从基本辅助驾驶(其中人类驾驶员保留完全控制权)到完全自动化(其中AI负责所有驾驶任务)。

Le design de ces systèmes doit s’assurer que, à tout niveau d’autonomie donné, l’opérateur humain conserve la capacité d’intervenir et d’annuler l’IA si nécessaire. Cela nécessite des interfaces de contrôle sophistiquées et des systèmes de soutien à la décision qui permettent aux humains d’intervenir rapidement et efficacement lorsque c’est nécessaire.

De plus, l’élaboration de cadres éthiques pour l’IA est essentielle pour guider les actions autonomes des systèmes IA. Ces cadres sont des jeux de règles et de directives intégrés dans l’IA qui dictent comment elle devrait se comporter dans des situations éthiquement complexes.

Par exemple, dans le domaine de la santé, un cadre éthique pour l’IA pourrait inclure des règles sur le consentement du patient, la confidentialité et la priorité des traitements en fonction des besoins médicaux plutôt que des considérations financières.

En incorporant directement ces principes éthiques dans les processus de décision de l’IA, les développeurs peuvent s’assurer que l’autonomie du système est exercée de manière compatible avec les valeurs humaines.

L’intégration de principes humanCentriques dans le design de l’IA n’est pas seulement une idée philosophique mais une nécessité technique. En améliorant l’autonomie humaine, en assurant la transparence, en permettant un contrôle significatif et en équilibrant l’autonomie avec le contrôle, les systèmes IA peuvent être développés de manière à réellement servir l’humanité.

Ces considérations techniques sont essentielles pour créer une IA qui non seulement augmente les capacités humaines mais également respecte et défend les valeurs qui sont fondamentales à notre société.

Au fil de l’évolution de l’IA, l’engagement envers un design humanCentrique sera crucial pour s’assurer que ces puissantes technologies sont utilisées éthiquement et de manière responsable.

Comment assurer que l’IA profite à l’humanité : améliorer la qualité de vie

Lorsque vous participez à l’élaboration de systèmes d’IA, il est essentiel de vous fondre dans le cadre éthique du utilitarisme – une philosophie qui met l’accent sur l’amélioration du bonheur et du bien-être global.

Dans ce contexte, l’IA peut résoudre des défis sociaux cruciaux, en particulier dans des domaines tels que la santé, l’éducation et la durabilité environnementale.

Le but est de créer des technologies qui améliorent significativement la qualité de vie pour tous. Mais cette quête est accompagnée de complexités. Le utilitarisme offre un motif convaincant pour déployer l’IA de manière large, mais il met également à l’avant des questions éthiques importantes sur qui profite et qui pourrait être laissé derrière, en particulier dans les populations vulnérables.

Pour naviguer à travers ces défis, nous avons besoin d’une approche sophistiquée et informée techniquement – une balance entre la quête large du bien de la société et la nécessité de justice et d’équité.

Lorsque vous appliquez les principes du utilitarisme à l’IA, votre attention devrait se concentrer sur l’optimisation des résultats dans des domaines spécifiques. Dans le domaine de la santé, par exemple, les outils de diagnostic automatisés par IA peuvent améliorer significativement les résultats des patients en permettant des diagnostics plus précoces et plus précis. Ces systèmes peuvent analyser de vastes jeux de données pour détecter des patrons qui pourraient échapper aux praticiens humains, ce qui élargit ainsi l’accès à des soins de qualité, en particulier dans les environnements sous-ressource.

Cependant, le déploiement de ces technologies nécessite une réflexion minutieuse afin d’éviter de renforcer les inégalités existantes. Les données utilisées pour entraîner les modèles d’IA peuvent varier considérablement d’une région à l’autre, ce qui affecte l’exactitude et la fiabilité de ces systèmes.

Cette disparité souligne l’importance d’établir des cadres solides de gouvernance des données qui garantissent que vos solutions de santé basées sur l’IA sont à la fois représentatives et équitables.

Dans le domaine de l’éducation, la capacité de l’IA à personnaliser l’apprentissage est prometteuse. Les systèmes d’IA peuvent adapter le contenu éducatif aux besoins spécifiques de chaque élève, améliorant ainsi les résultats d’apprentissage. En analysant les données sur les performances et le comportement des élèves, l’IA peut identifier les difficultés rencontrées par un élève et fournir un soutien ciblé.

Mais en travaillant pour obtenir ces avantages, il est crucial de prendre conscience des risques, tels que le potentiel de renforcer les biais ou de marginaliser les élèves qui ne correspondent pas aux schémas d’apprentissage typiques.

Pour atténuer ces risques, il est nécessaire d’intégrer des mécanismes d’équité dans les modèles d’IA, afin de garantir qu’ils ne favorisent pas involontairement certains groupes. Et le rôle des éducateurs est essentiel. Leur jugement et leur expérience sont indispensables pour rendre les outils d’IA véritablement efficaces et favorables.

En termes de durabilité environnementale, le potentiel de l’IA est considérable. Les systèmes d’IA peuvent optimiser l’utilisation des ressources, surveiller les changements environnementaux et prédire les impacts du changement climatique avec une précision sans précédent.

Voici la traduction en français :

Pourquoi l’IA peut analyser d’immenses quantités de données environnementales pour prévoir les schémas météorologiques, optimiser la consommation énergétique et minimiser les déchets — des actions qui contribuent au bien-être des générations présentes et futures.

Mais cette avancée technologique présente ses propres défis, en particulier concernant l’impact environnemental des systèmes d’IA eux-mêmes.

La consommation d’énergie nécessaire pour faire fonctionner des systèmes d’IA à grande échelle peut annuler les avantages environnementaux qu’ils cherchent à atteindre. Il est donc crucial de développer des systèmes d’IA économes en énergie pour garantir que leur impact positif sur la durabilité ne soit pas compromise.

Lorsque vous développez des systèmes d’IA avec des objectifs utilitaires, il est important de considérer également les implications pour la justice sociale. L’utilitarisme se concentre sur le maximisation du bien-être général mais ne traite pas nécessairement la distribution des avantages et des dommages à travers différents groupes sociaux.

Cela soulève la possibilité que les systèmes d’IA profitent de manière disproportionnée à ceux qui sont déjà privilégiés, tandis que les groupes marginalisés pourraient voir peu ou pas de miglioramento dans leurs conditions.

Pour contrer cela, votre processus de développement d’IA devrait intégrer des principes axés sur l’équité, en assurant que les avantages sont distribués de manière juste et que les éventuels dommages sont corrigés. Cela pourrait impliquer de concevoir des algorithmes qui visent spécifiquement à réduire les biais et d’inclure une gamme diversifiée de perspectives dans le processus de développement.

Lorsque vous travaillez à développer des systèmes dotés d’IA destinés à améliorer la qualité de vie, il est essentiel de maintenir un équilibre entre l’objectif utilitaire de maximiser le bien-être et le besoin de justice et d’équité. Cela nécessite une approche nuancée, basée sur des connaissances techniques, qui tient compte des implications plus larges du déploiement d’IA.

En concevant délibérément des systèmes d’IA qui soient à la fois efficaces et équitables, vous pouvez contribuer à un avenir où les avancées technologiques servent véritablement les besoins diversifiés de la société.

Mettez en œuvre des mesures de protection contre les risques potentiels

Lors du développement de technologies dotées d’IA, vous devez reconnaître la potentialité d’origine du préjudice et établir activement des mesures de protection solides pour atténuer ces risques. Cette responsabilité est profondément enracinée dans les éthiques déontologiques. Cette branche de l’éthique met l’accent sur le devoir moral de respecter des règles établies et des normes éthiques, garantissant que la technologie que vous créez est alignée sur des principes moraux fondamentaux.

La mise en œuvre de protocoles de sécurité stricts n’est pas seulement une précautions, c’est une obligation éthique. Ces protocoles devraient englober des tests de biais complets, la transparence dans les processus algorithmiques et des mécanismes clairs de responsabilité.

De telles mesures de protection sont essentielles pour éviter que les systèmes d’IA ne provoquent des préjudices non intentionnels, que ce soit par des processus de décision biaisés, des processus opaques ou par manque de surveillance.

En pratique, la mise en œuvre de ces mesures de protection nécessite une bonne compréhension des dimensions techniques et éthiques de l’IA.

Le test de biais, par exemple, ne se limite pas à identifier et corriger les biais dans les données et les algorithmes, mais aussi à comprendre les implications sociales plus larges de ces biais. Vous devez vous assurer que vos modèles d’IA sont entraînés sur des jeux de données diversifiés et représentatifs, et qu’ils sont évalués régulièrement pour détecter et corriger tout biais qui pourrait apparaître au fil du temps.

De l’autre côté, la transparence exige que les systèmes d’IA soient conçus de manière à ce que leurs processus de décision puissent être facilement compris et examinés par les utilisateurs et les parties prenantes. Cela implique de développer des modèles d’IA explicables qui fournissent des sorties claires et interprétables, permettant aux utilisateurs de voir comment les décisions sont prises et faisant en sorte que ces décisions soient justifiables et équitables.

De plus, les mécanismes d’accountabilité sont cruciaux pour maintenir la confiance et assurer que les systèmes d’IA sont utilisés de manière responsable. Ces mécanismes devraient inclure des directives claires sur qui est responsable des résultats des décisions de l’IA, ainsi que des processus pour traiter et corriger tout préjudice qui pourrait survenir.

Vous devez établir un cadre où les considérations éthiques sont intégrées à toutes les étapes du développement de l’IA, de la conception initiale à la mise en œuvre et au-delà. Cela inclut non seulement le respect de directives éthiques mais aussi la surveillance continue et l’ajustement des systèmes d’IA au fur et à mesure qu’ils interagissent avec le monde réel.

En implémentant ces garanties dans la structure même du développement de l’IA, vous pouvez aider à assurer que le progrès technique sert le bien commun sans aboutir à des conséquences négatives non intentionnelles.

Le rôle de la surveillance humaine et des boucles de rétroaction.

La surveillance humaine dans les systèmes d’IA est un composant critique pour assurer un déploiement éthique de l’IA. Le principe de responsabilité sous-tend la nécessité d’une participation humaine continue dans l’opération des systèmes d’IA, particulièrement dans des environnements à hauts risques tels que la santé et la justice pénale.

Les boucles de rétroaction, où l’input humain est utilisé pour affiner et améliorer les systèmes d’IA, sont essentielles pour maintenir une responsabilité et une adaptabilité (Raji et al., 2020). Ces boucles permettent la correction d’erreurs et l’intégration de nouvelles considérations éthiques au fil de l’évolution des valeurs sociales.

En incorporant la surveillance humaine dans les systèmes d’IA, les développeurs peuvent créer des technologies qui sont non seulement efficaces mais également alignées sur les normes éthiques et les attentes humaines.

Coding Ethics: Translating Philosophical Principles into AI Systems

La traduction des principes philosophiques dans les systèmes d’IA est une tâche complexe mais nécessaire. Ce processus implique l’incorporation de considérations éthiques dans le code même qui anime les algorithmes d’IA.

Concepts tels que l’équité, la justice et l’autonomie doivent être codifiés dans les systèmes d’IA pour s’assurer qu’ils fonctionnent de manières qui reflètent les valeurs sociétales. Cela nécessite une approche multidisciplinaire, où des éthiciens, des ingénieurs et des scientifiques sociaux collaborent pour définir et mettre en œuvre des directives éthiques dans le processus de codage.

Le but est de créer des systèmes d’IA qui sont non seulement techniques de premier ordre mais également éthiquement solides, capables de prendre des décisions respectant la dignité humaine et promouvant le bien social (Mittelstadt et al., 2016).

Promouvoir l’inclusivité et l’accès équitable au développement et au déploiement de l’IA.

L’inclusivité et l’accès équitable sont fondamentaux au développement éthique de l’IA. Le concept de justice comme équité de Rawls offre une base philosophique pour assurer que les systèmes IA sont conçus et déployés de manière à profiter à tous les membres de la société, en particulier les plus vulnérables (Rawls, 1971).

Cela implique des efforts actifs pour inclure des perspectives diverses dans le processus de développement, en particulier des groupes sous- représentés et du Sud global.

En intégrant ces points de vue divers, les développeurs IA peuvent créer des systèmes plus équitables et plus réceptifs aux besoins d’un plus large éventail d’utilisateurs. De plus, assurer l’accès équitable aux technologies IA est crucial pour prévenir l’exacerbation des inégalités sociales existantes.

Traiter la Biais Algorithme et la justice

Le biais algorithme est une préoccupation éthique significative dans le développement de l’IA, car les algorithmes biaisés peuvent perpétuer et même exacerbuer les inégalités sociales. Traiter ce problème exige un engagement en faveur de la justice procédurale, en assurant que les systèmes IA sont développés par des processus équitables qui considèrent l’impact sur toutes les parties prenantes (Nissenbaum, 2001).

Cela implique l’identification et la réduction des biais dans les données d’entraînement, le développement d’algorithmes transparents et explicables, et l’application de vérifications de justice tout au long du cycle de vie de l’IA.

En traitant le biais algorithme, les développeurs peuvent créer des systèmes IA qui contribuent à une société plus juste et plus équitable, plutôt que de renforcer les disparités existantes.

Inclure des Perspectives Diverses dans le Développement de l’IA

Intégrer des perspectives diverses dans le développement de l’IA est essentiel pour créer des systèmes qui soient inclusifs et équitables. La participation de voix provenant de groupes sous-représentés assure que les technologies de l’IA ne reflètent pas simplement les valeurs et les priorités d’un petit segment de la société.

Cette approche est alignée sur le principe philosophique de la démocratie délibérative, qui met l’accent sur l’importance de processus de décision qui soient inclusifs et participatifs (Habermas, 1996).

En favorisant une participation diverse au développement de l’IA, nous pouvons assurer que ces technologies sont conçues pour servir les intérêts de l’humanité entière, plutôt que de quelques privilégiés.

Strategies for Bridging the AI Divide

La division de l’IA, caractérisée par un accès inégal aux technologies de l’IA et à leurs avantages, pose un défi significatif à l’équité mondiale. Pontonner cette division nécessite un engagement en faveur de la justice distributive, en assurant que les avantages de l’IA sont partagés largement entre différents groupes socioéconomiques et régions (Sen, 2009).

Nous pouvons le faire par l’initiative qui promeut l’accès à l’éducation de l’IA et aux ressources dans les communautés sous-servies, ainsi que par les politiques qui appuient la distribution équitable des gains économiques liés à l’IA. En traitant de la division de l’IA, nous pouvons assurer que l’IA contribue au développement mondial de manière inclusive et équitable.

Balance Innovation with Ethical Constraints

Balancer la poursuite de l’innovation avec les contraintes éthiques est crucial pour un développement responsable de l’IA. Le principe de précaution, qui milite en faveur de la prudence en présence de l’incertitude, est particulièrement pertinent dans le contexte du développement de l’IA (Sandin, 1999).

Tandis que l’innovation propulse le progrès, elle doit être tempérée par des considérations éthiques protégeant contre les潜在es dommages. Cela nécessite une évaluation prudente des risques et des avantages des nouvelles technologies AI, ainsi que l’implémentation de cadres réglementaires garantissant le respect de normes éthiques.

En équilibrant l’innovation avec les contraintes éthiques, nous pouvons favoriser le développement des technologies AI qui sont à la fois à la pointe et alignées sur les objectifs plus larges du bien-être sociétal.

Comme vous pouvez le voir, la base philosophique des systèmes intelligents fournit un cadre critique pour assurer que les technologies AI sont développées et déployées de manières éthiques, inclusives et bénéfiques pour toute l’humanité.

En fondant le développement de l’IA sur ces principes philosophiques, nous pouvons créer des systèmes intelligents qui non seulement avancent les capacités technologiques mais également améliorent la qualité de vie, promeuvent la justice et assurent que les avantages de l’IA sont partagés équitablement dans la société.

Chapitre 5 : Les agents AI comme améliorateurs des GAL

La fusion des agents AI avec les Grands Modèles de Langue (GML) représente un changement fondamental dans l’intelligence artificielle, traitant des limitations critiques des GML qui les ont limitées dans leur large appliquabilité.

Cette intégration permet aux machines de transcender leurs rôles traditionnels, passant d’agents de génération de texte passifs à des systèmes autonomes capables de raisonnement dynamique et de prise de décisions.

Comme les systèmes d’IA de plus en plus assurent des processus critiques dans divers domaines, comprendre comment les agents AI comblent les lacunes dans les capacités des GML est essentiel pour réaliser leur potentiel complet.

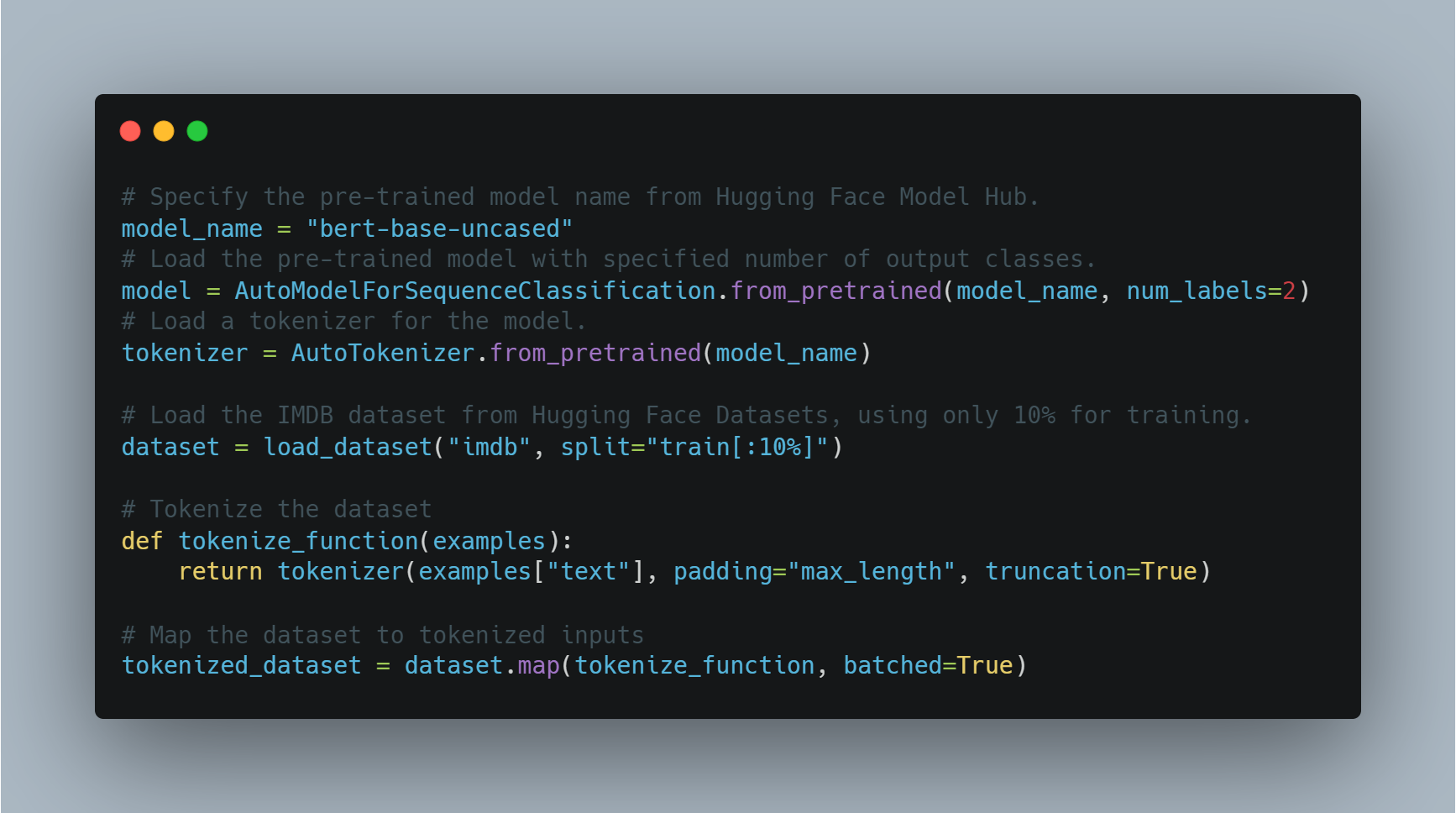

Fonctionnaliser les capacités des GLL

Les GLL, quoique puissantes, sont intrinsèquement limitées par les données sur lesquelles elles ont été entraînées et par la nature statique de leur architecture. Ces modèles fonctionnent dans un ensemble fixe de paramètres, généralement défini par le corpus de texte utilisé pendant leur phase d’entraînement.

Cette limitation signifie que les GLL ne peuvent pas rechercher automatiquement de nouvelles informations ou mettre à jour leur base de connaissances après l’entraînement. Par conséquent, les GLL sont souvent périmées et manquent de la capacité de fournir des réponses pertinentes dans le contexte qui exige des données ou des aperçus en temps réel en dehors de leurs données d’entraînement initiales.

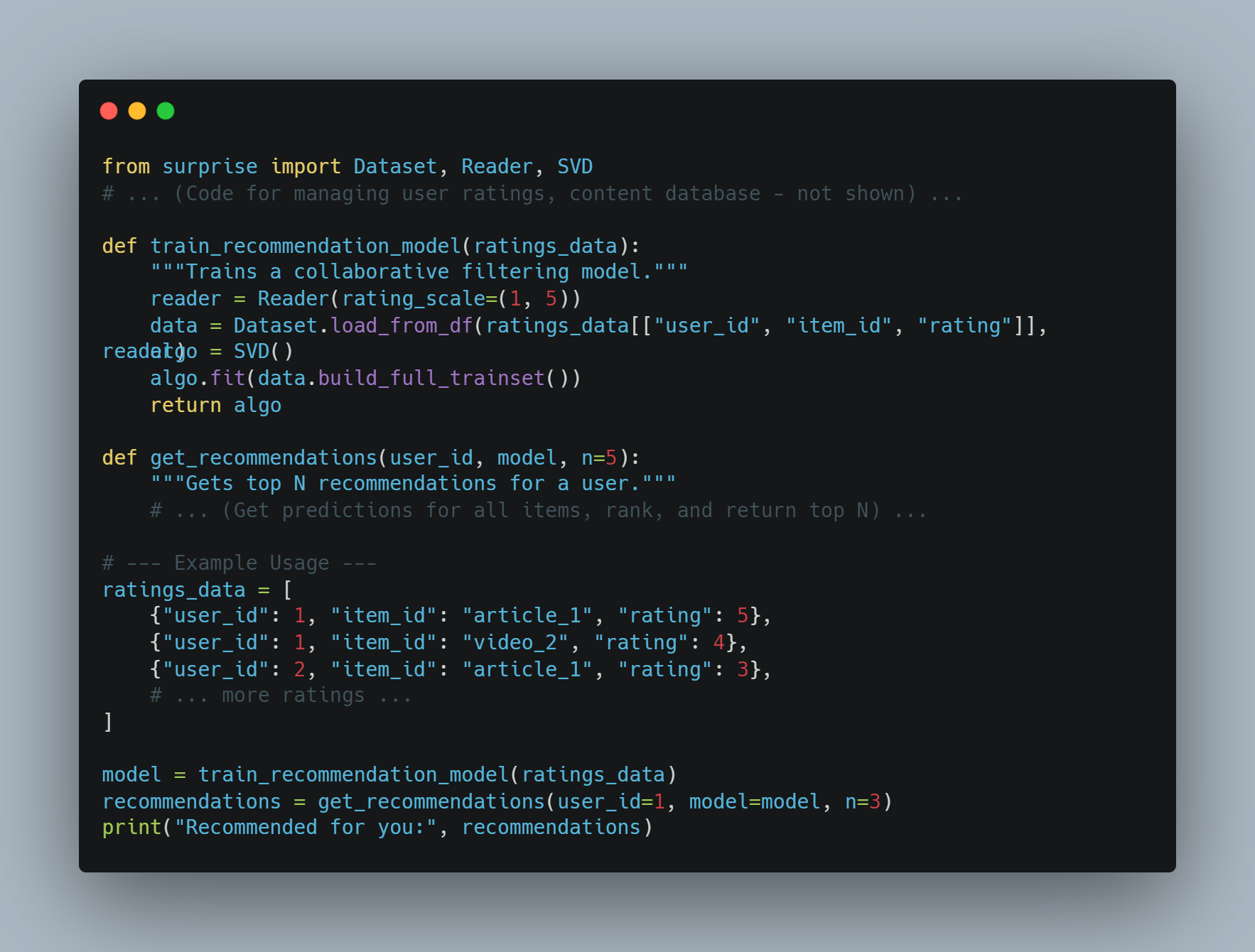

Les agents IA brident ces lacunes en intégrant dynamiquement des sources externes de données, ce qui peut élargir l’horizon fonctionnel des GLL.

Par exemple, une GLL entraînée sur les données financières jusqu’en 2022 pourrait fournir des analyses historiques précises mais pourrait struggle à générer des prévisions de marché à jour. Un agent IA peut amplifier cette GLL en tirant à partir de données en direct des marchés financiers, en appliquant ces entrées pour générer des analyses plus pertinentes et actuelles.

Cette intégration dynamique garantit que les sorties ne sont pas seulement historiquement exactes mais sont également pertinentes dans le contexte actuel.

Améliorer l’autonomie des processus de décision

Une autre limitation significative des GLL est leur manque de capacités de prise de décision automatique. Les GLL sont excellents à la production d’outputs basés sur le langage mais manquent dans les tâches qui exigent une prise de décision complexe, en particulier dans des environnements caractérisés par l’incertitude et le changement.

Cette insuffisance est principalement due à la dépendance du modèle à des données préexistantes et l’absence de mécanismes pour la réasonnance adaptative ou l’apprentissage à partir de nouvelles expériences après le déploiement.

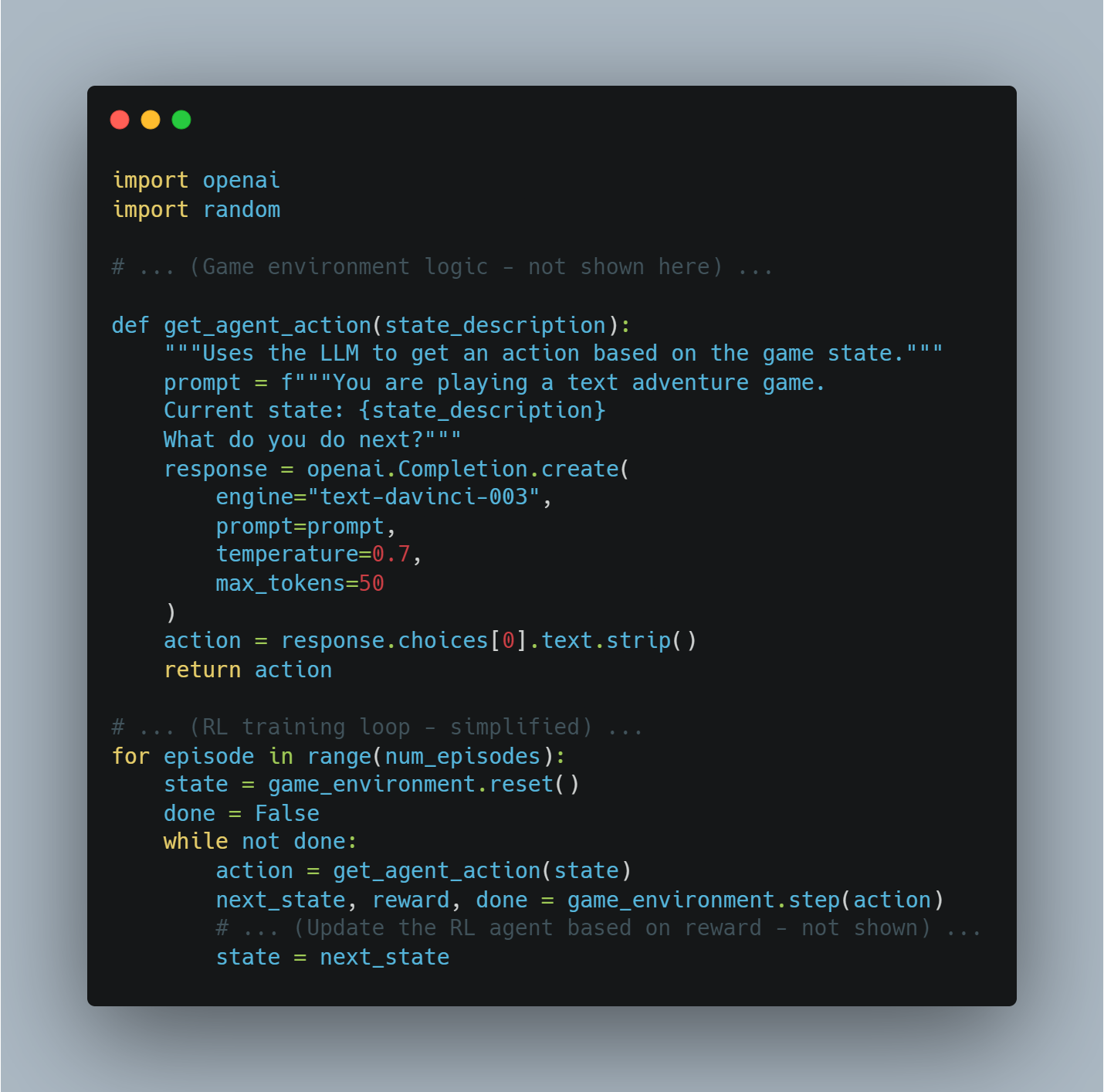

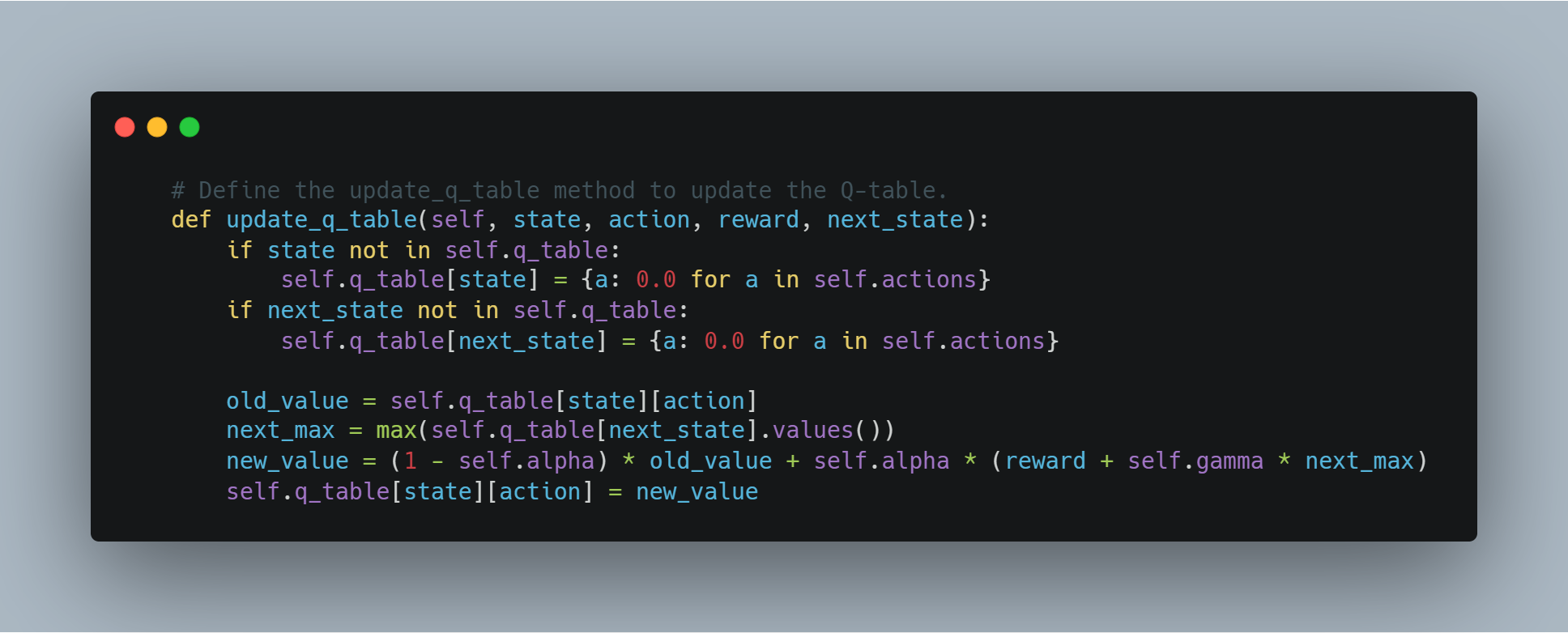

Les agents intelligents parcourent ce défi en fournissant l’infrastructure nécessaire pour la prise de décision autonome. Ils peuvent transformer les sorties statiques d’un GMT en utilisant des schémas de raisonnement avancés tels que des systèmes basés sur des règles, des heuristiques ou des modèles d’apprentissage par réinforcement.

Par exemple, dans un contexte de santé, un GMT pourrait générer une liste de diagnostics potentiels en fonction des symptômes et de l’historique médical d’un patient. Cependant, sans un agent intelligent, le GMT ne peut pas évaluer ces options ou recommander une action.

Un agent intelligent peut alors intervenir pour évaluer ces diagnostics en fonction de la littérature médicale actuelle, des données du patient et des facteurs contextuels, aboutissant finalement à une décision plus informée et suggérant des prochaines étapes pratiques. Cette synergie transforme les sorties du GMT de simples suggestions en décisions exécutables et sensibles au contexte.

Traiter la Complétude et la cohérence

La complétude et la cohérence sont des facteurs cruciaux pour assurer la fiabilité des sorties des GMT, en particulier dans les tâches de raisonnement complexe. En raison de leur nature paramétrisée, les GMT générent souvent des réponses qui sont soit incomplètes, soit manquantes de cohérence logique, surtout lorsqu’il s’agit de processus multi-étapes ou d’une compréhension complète de domaines divers.

Ces problèmes découlent de l’environnement isolé dans lequel les GMT opèrent, où ils sont incapables de cross-référencer ou de valider leurs sorties à des normes externes ou à des informations supplémentaires.

Les agents intelligents jouent un rôle crucial dans la réduction de ces problèmes en introduisant des mécanismes de rétroaction itératifs et des couches de validation.

Par exemple, dans le domaine juridique, une MMG pourrait élaborer une première version d’un mémoire juridique sur la base de ses données d’entraînement. Cependant, ce projet pourrait ignorer certains précédents ou ne pas structurer l’argumentation de manière logique.

Un agent intelligent peut examiner ce projet, veillant à ce qu’il réponde aux normes requises de complétude en faisant des références croisées avec des bases de données juridiques externes, en vérifiant la cohérence logique et en demandant des informations supplémentaires ou des éclaircissements où nécessaire.

Ce processus itératif permet la production d’un document plus robuste et fiable qui répond aux exigences rigoureuses de la pratique juridique.

Surmonter l’isolement par l’intégration

L’une des limitations les plus profondes des GMT est leur isolement inhérent par rapport à d’autres systèmes et sources de connaissance.

Les GMT, tel que conçus, sont des systèmes fermés qui ne communiquent pas nativement avec l’environnement externe ou les bases de données. Cet isolement limite significativement leur capacité d’adapter à de nouvelles informations ou à des opérations en temps réel, les rendant moins efficaces dans des applications nécessitant une interaction dynamique ou des décisions en temps réel.

Les agents intelligents surmontent cet isolement en agissant comme des plateformes d’intégration qui connectent les GMT à un écosystème plus large de sources de données et d’outils de calcul. A travers les API et d’autres cadres d’intégration, les agents intelligents peuvent accéder aux données en temps réel, collaborer avec d’autres systèmes intelligents et même interagir avec des appareils physiques.

Par exemple, dans les applications de service client, un GIE pourrait générer des réponses standardisées à partir de scripts pré-entraînés. Cependant, ces réponses peuvent être statiques et manquer de personnalisation requise pour un engagement client efficace.

Un agent IA peut enrichir ces interactions en intégrant des données en temps réel à partir de profils clients, des interactions précédentes et d’outils d’analyse des sentiments, ce qui aide à générer des réponses non seulement contextuellement pertinentes mais également adaptées aux besoins spécifiques du client.