De snelle evolutie van de kunstmatige intelligentie (AI) heeft een krachtige synergie ontstaan tussen grote taalklassen (LLMs) en AI-agenten. Dit dynamische spel is eigenlijk wat als de sage van David en Goliath (zonder de strijd), waar agile AI-agenten de mogelijkheden van de colossale LLMs versterken en vergroten.

Dit handboek zal ontdekken hoe AI-agenten – vergelijkbaar met David – de LLMs – onze moderne Goliaths – superversterken om verschillende industrieën en wetenschappelijke domeinen te helpen revolutioneren.

Inhoudsopgave

-

Chapter 2: De geschiedenis van de kunstmatige intelligentie en AI-agenten

-

Hoofdstuk 4: De filosofische grondslag van intelligentie systemen

-

Hoofdstuk 6: Architectuur ontwerp voor de integratie van AI-agents met LLMs

De opkomst van AI-agenten in taalmodellen

AI-agenten zijn onafhankelijke systemen die zijn ontworpen om hun omgeving te waarnemen, beslissingen te nemen en acties uit te voeren om specifieke doelstellingen te behalen. Wanneer ze worden geïntegreerd met LLM’s, kunnen deze agenten complexe taken uitvoeren, informatie overleggen en nieuwe oplossingen genereren.

Deze combinatie heeft tot significante vooruitgang geleid in vele sectoren, van softwareontwikkeling tot wetenschappelijk onderzoek.

Transformerende impact over de industrie

De integratie van AI-agenten met LLM’s heeft een diepe impact gehad op verschillende industrieën:

-

Softwareontwikkeling: door AI-gebaseerde codeassistenten, zoals GitHub Copilot, die de mogelijkheid hebben ge demonstreerd maximaal 40% van het code te genereren, met name een opmerkelijke toename van 55% in de ontwikkelingssnelheid.

-

Onderwijs: door AI-gebaseerde leerassistenten, die beloftes hebben gemaakt in gemiddelde cursusafsluitingstijd met 27% te verkorten, en misschien de onderwijslandschap revolutionerend.

-

Vervoer: Met projecties die suggereren dat 10% van de voertuigen in 2030 zonder bestuurder zullen zijn, zijn autonome AI-agenten in zelfrijdende auto’s op het punt om de transportsector te transformeren.

Wetenschappelijke ontdekking

Een van de meest spannende toepassingen van AI-agenten en LLM’s is in de wetenschappelijke onderzoek:

-

Geneeskunde: AI-agenten zijn het voortouw nagelaten in het geneesproces door analyse van grote datasets en voorspellingen van potentiële geneesmiddelen, waardoor de tijd en kosten van traditionele methoden aanzienlijk worden verminderd.

-

Deeltjesfysica: Bij CERN’s LHC worden AI-agents ingezet om deeltjesbotsingdata te analyseren, gebruik makende van anomaliedetectie om gunstige leads te identificeren die kunnen wijzen op de bestaansmogelijkheid van onontdekte deeltjes.

-

Algemeen Wetenschappelijk Onderzoek: AI-agents verhogen de snelheid en de scope van wetenschappelijke ontdekkingen door het analyseren van voorgaande studies, de identificeren van onverwachte verbanden en het voorstellen van nieuwe experimenten.

De convergentie tussen AI-agents en grote taalkundige modellen (LLMs) drijft de kunstmatige intelligentie aan tot een nieuwe periode van ongeziene mogelijkheden. Dit compilatiewerk onderzoekt de dynamische interactie tussen deze twee technologieën, onthulende hun gecombineerde potentiële om industries te revolueren en complexe problemen op te lossen.

We zullen de evolutie van AI van zijn begin tot de opkomst van autonome agents en de ontwikkeling van geavanceerde LLMs volgen. We zullen ook ethische overwegingen verkennen, die fundamenteel zijn aan de verantwoorde ontwikkeling van AI. Dit zal helpen ons ervoor zorgen dat deze technologieën overeenstemmen met onze menselijke waarden en de welvaart van de maatschappij.

Na het afronden van dit handboek zult u een diepgaande begrip hebben van de synergistische kracht van AI-agents en LLMs, samen met de kennis en gereedschap om deze voorloperige technologie te benutten.

Hoofdstuk 1: Inleiding tot AI-agents en taalkundige modellen

Wat zijn AI-agents en grote taalkundige modellen?

De snelle evolutie van kunstmatige intelligentie (AI) heeft een vernieuwende synergie tussen grote taalkundige modellen (LLMs) en AI-agents opgeroepen.

AI-agenten zijn onafhankelijke systemen die ontworpen zijn om hun omgeving te beïnvloeden, beslissingen te nemen en acties uit te voeren om specifieke doelen te bereiken. Ze tonen kenmerken als autonomie, perceptie, reactiviteit, redenering, beslissen, leren, communicatie en doelgerichtheid.

Anders zijn LLM’s geavanceerde AI-systemen die diep leren technieken en grote datasets gebruiken om menselijkeachtige tekst te begrijpen, te genereren en te voorschrijven.

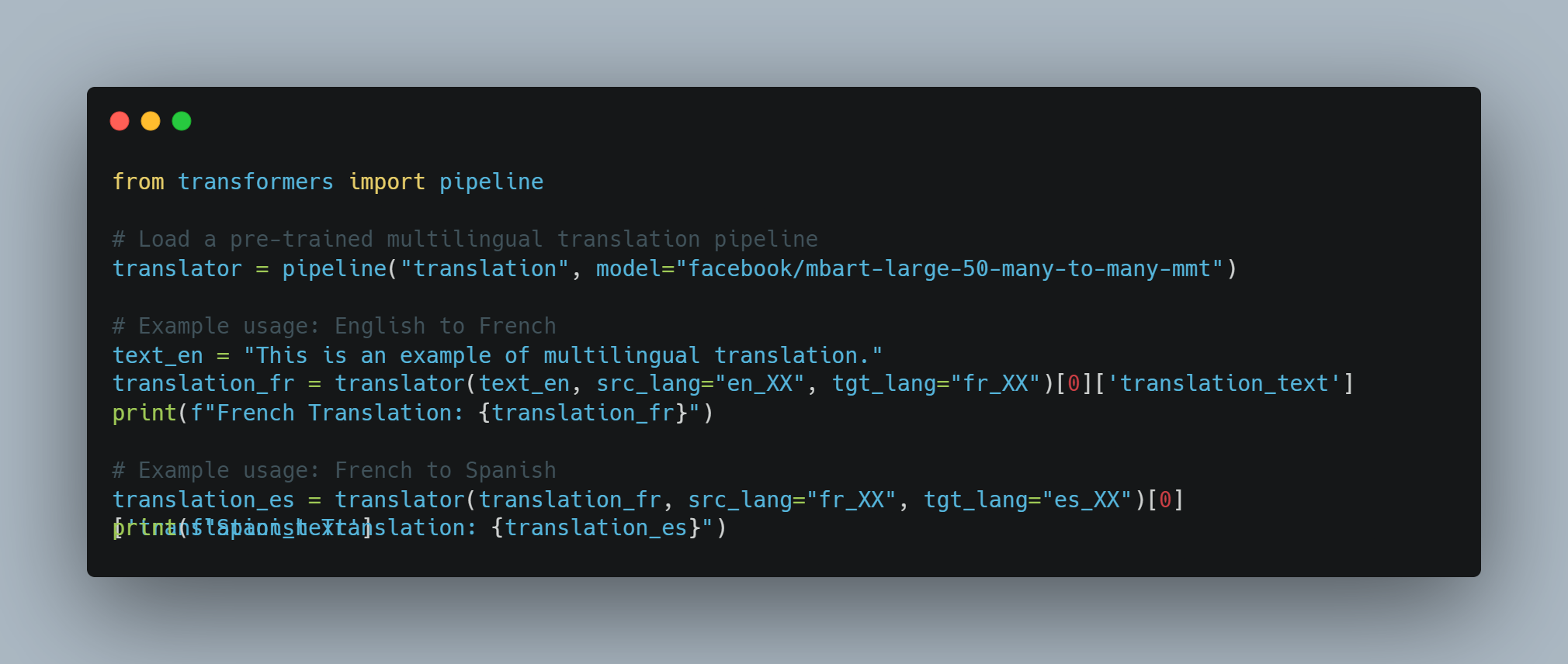

Deze modellen, zoals GPT-4, Mistral, LLama, hebben bijgewerkt aan verrassende mogelijkheden in natuurlijke taalverwerkingstaakken, inclusief tekstgeneratie, taalvertaling en conversatiesystemen.

Belangrijke kenmerken van AI-agenten

AI-agenten hebben enkele onderscheidende eigenschappen die hen van traditionele software onderscheiden:

- Autonomie: Ze kunnen zelfstandig operationeel zijn zonder constante menselijke干预.diy9>

-

Perceptie: Agenten kunnen hun omgeving door middel van diverse invoer detecteren en interpreteren.

-

Reactiviteit: Ze reageren dynamisch op veranderingen in hun omgeving.

-

Redeneren en besluitvorming: Agenten kunnen gegevens analyseren en geïnformeerde keuzes maken.

-

Leren: Ze verbeteren hun prestaties in de loop van de tijd door ervaring.

-

Communicatie: Agenten kunnen communiceren met andere agenten of mensen met behulp van verschillende methoden.

-

Doelgerichtheid: Ze zijn ontworpen om specifieke doelstellingen te bereiken.

Mogelijkheden van Grote Taalmodellen

Grote taalmodellen hebben een breed scala aan mogelijkheden aangetoond, waaronder:

-

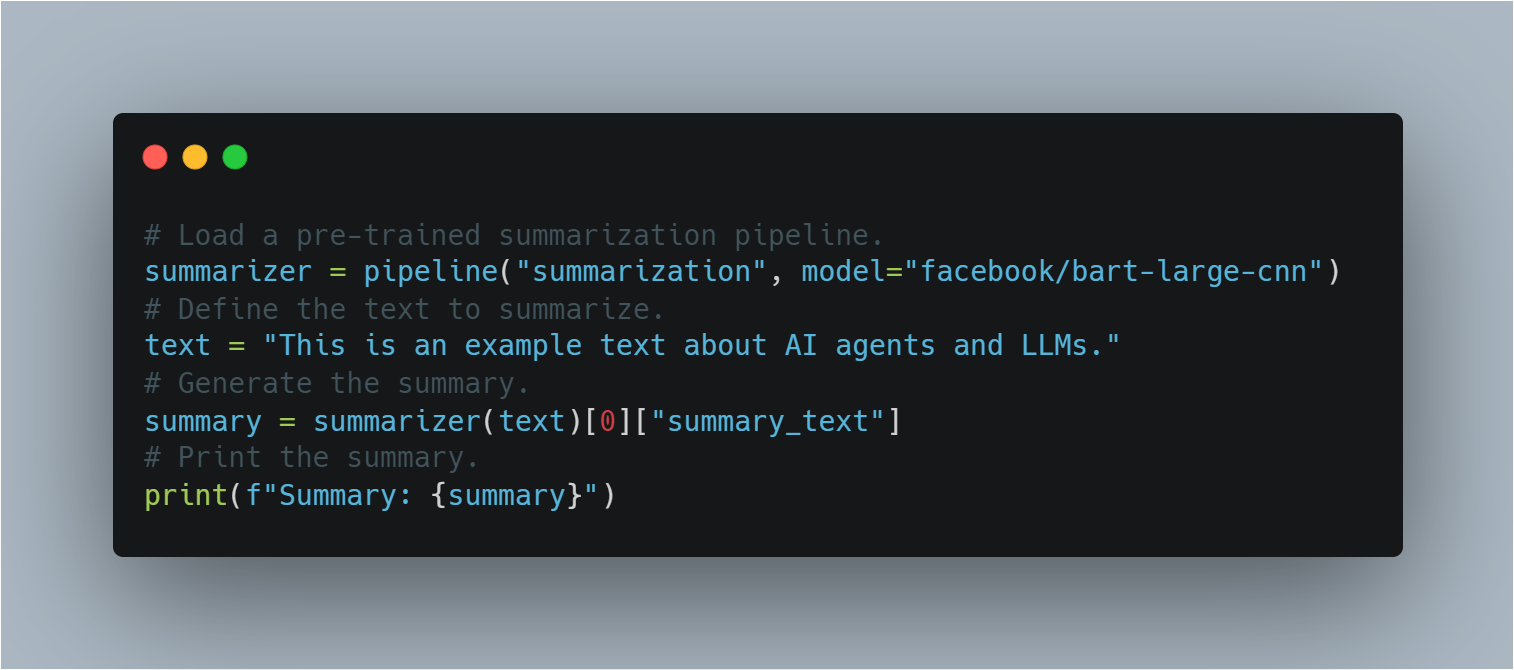

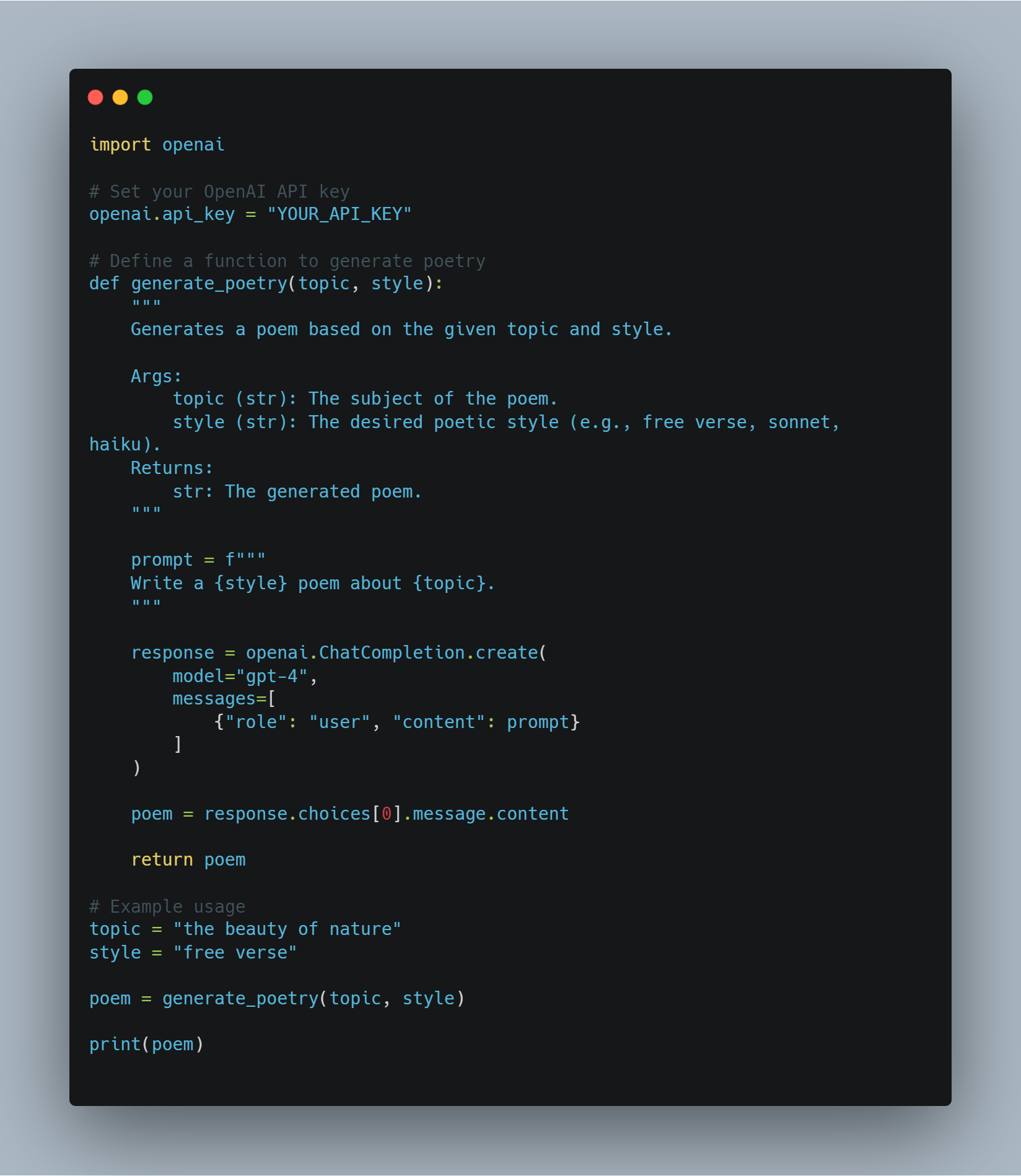

Tekstgeneratie: Grote taalmodellen kunnen samenhangende en contextueel relevante tekst produceren op basis van aanwijzingen.

-

Taalvertaling: Ze kunnen tekst met hoge nauwkeurigheid vertalen tussen verschillende talen.

-

Samenvatting

: LLMs kunnen lange teksten samenvatten in korte samenvattingen terwijl belangrijke informatie behouden wordt.

-

Vraagbehandeling: Ze kunnen exacte antwoorden geven op vragen gebaseerd op hun uitgebreide kennisbank.

-

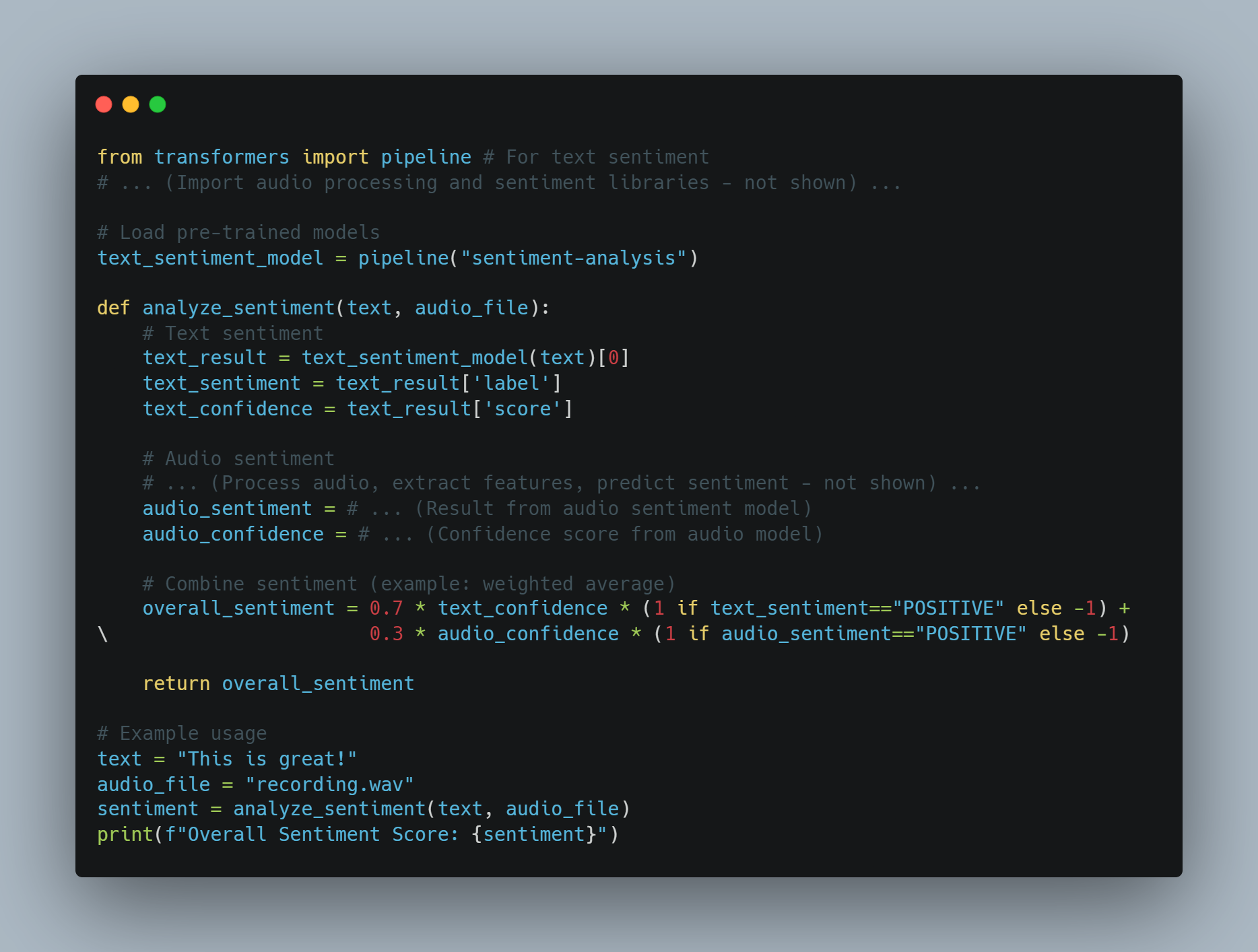

Sentiment Analyse: LLMs kunnen analyseren en bepalen van de gemoedsaard die uitgedragen wordt in een gegeven tekst.

-

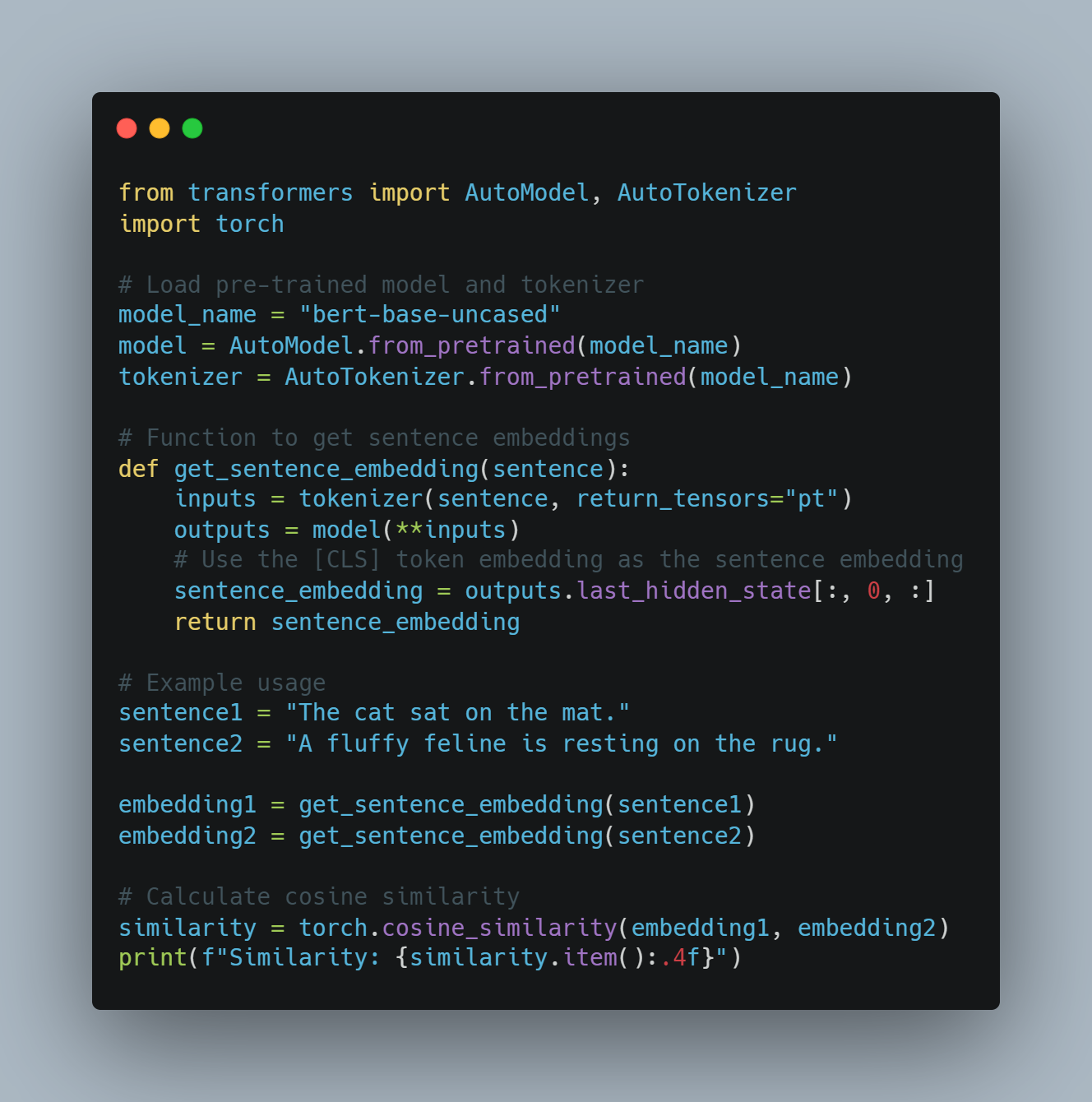

Code Generatie: Ze kunnen code fragmenten of complete functies genereren op basis van natuurlijke taal beschrijvingen.

Niveaus van AI-agenten

AI-agenten kunnen op basis van hun mogelijkheden en complexiteit in verschillende niveaus worden onderverdeeld. Volgens een paper op arXiv, worden AI-agenten ingedeeld in vijf niveaus:

-

Niveau 1 (L1): AI-agenten als onderzoeksassistenten, waar wetenschappers hypoteses stellen en taken specificeren om doelstellingen te behalen.

-

Niveau 2 (L2): AI-agents die zelfstandig bepaalde specifieke taken kunnen uitvoeren binnen een vastgelegd scope, zoals data-analyse of eenvoudige besluitvorming.

-

Niveau 3 (L3): AI-agents die kunnen leren van ervaring en zich aanpassen aan nieuwe situaties, hun besluitvormingsprocessen verbeteringen aanreiking.

-

Niveau 4 (L4): AI-agents met geavanceerde redeneer- en problemoplossingsvaardigheden, in staat complexe, meerstaps taken te behandelen.

-

Niveau 5 (L5): Volledig zelfstandige AI-agents die onafhankelijk kunnen functioneren in dynamische omgevingen, beslissen en acties ondernemen zonder menselijke干预.

Beperkingen van Grote Taalmodellen

Trainingkosten en hulpbronnenbeperkingen

Grote taalmodellen (LLMs) zoals GPT-3 en PaLM hebben de natuurlijke taalverwerking (NLP) revolutioneerd door middel van diepe leertechnieken en uitgebreide datasets te benutten.

Maar deze vooruitgang komt met een significante kosten. Trainen van LLMs vereist omvangrijke computatieressourcen, vaak met behulp van duizenden GPU’s en uitgebreide energieverbruik.

Volgens Sam Altman, CEO van OpenAI, was de trainingskosten voor GPT-4 meer dan $100 miljoen. Dit is in lijn met de gemelde schaal en complexiteit van het model, met schattingen die suggereren dat het ongeveer 1 triljoen parameters heeft. Echter, andere bronnen geven andere getallen:

-

Een onthullende rapport uitgebracht dat de trainingskosten voor GPT-4 ongeveer $63 miljoen waren, rekening houdend met de rekenkracht en de trainingsduur.

-

Tot midden 2023 stelden sommige schattingen voor dat het trainen van een model gelijkend op GPT-4 ongeveer $20 miljoen kostte en ongeveer 55 dagen in beslag nam, reflecterend op vooruitgangen in efficiency.

De hoog kosten van het trainen en behouden van LLM’s beperken hun algemeen gebruik en schaalbaarheid.

Data beperkingen en vooroordelen

Het functioneren van LLM’s is erg afhankelijk van de kwaliteit en diversiteit van de trainingsgegevens. Ondanks dat LLM’s zijn getraind op massieve gegevenssets, kunnen ze nog steeds vooroordelen in de gegevens vertonen, wat leidt tot onjuist of ongepaste uitvoer.these vooroordelen kunnen zich in verschillende vormen manifesteren, inclusief gender, ras en culturele vooroordelen, die stereotypen en misinformatie kunnen doorsturen.

Ook de statische natuur van de trainingsgegevens betekend dat LLM’s misschien niet bijgewerkt zijn met de nieuwste informatie, wat hun effectiviteit in dynamische omgevingen beperkt.

Specialisatie en complexiteit

Alhoewel LLM’s goed zijn in algemene taken, struikelen ze vaak over bij specialiseerde taken die domeinspecifieke kennis en hoog niveau complexiteit vereisen.

Bijvoorbeeld taken in gebieden zoals geneeskunde, rechtspraak en wetenschappelijk onderzoek vereisen een diep begrip van specifieke termen en gecompliceerd redeneren, wat LLM’s mogelijk niet intrinsiek bezitten. Deze beperking maakt het noodzakelijk om extra lagen van expertise te integreren en de LLM’s te fijn afstemmen om effectief te zijn in specifieke toepassingen.

Invoer- en sensorische beperkingen

Krachten van LLM’s processen voornamelijk gebaseerd op tekstinput, wat hun vermogen beperkt om met de wereld op een multimodale manier te interacteren. Hoewel ze tekst kunnen genereren en begrijpen, ontberen ze de mogelijkheid om direct visuele, auditieve of sensorische input te verwerken.

Deze beperking hindert hun toepassing in gebieden die vereisen om een uitgebreide sensorische integratie, zoals robotica en autonome systemen. Bijvoorbeeld, een LLM kan geen visuele gegevens uit een camera of auditieve gegevens uit een microfoon interpreteren zonder aanvullende verwerkingseenheden.

Communicatie- en Interactiebeperkingen

De huidige communicatieve mogelijkheden van LLM’s zijn voornamelijk gebaseerd op tekst, wat hun vermogen beperkt om meer diepgravende en interactieve vormen van communicatie te ondernemen.

Bijvoorbeeld, terwijl LLM’s tekstreacties kunnen genereren, kunnen ze geen video- of hologrammen produceren, die steeds belangrijker worden in virtuele en geavanceerde realiteitstoepassingen (lees meer hier). Deze beperking vermindert de effectiviteit van LLM’s in omgevingen die rijke, multimodale interacties vereisen.

Hoe AI-agenten de beperkingen van LLM’s kunnen overbruggen

AI-agenten bieden eenpromisende oplossing aan veel van de beperkingen die LLM’s ondervinden. Deze agenten zijn ontworpen om autonoom te functioneren, hun omgeving perceptie te maken, beslissingen te nemen en acties uit te voeren om specifieke doelen te behalen. Door AI-agenten te integreren met LLM’s, is het mogelijk hun capaciteiten te verhogen en hun ingebouwde beperkingen aan te pakken.

-

Verbeterd Context en Geheugen: AI-agenten kunnen context handhaven over meerdere interacties, wat leidt tot meer coherente en contextueel relevante reacties. Deze mogelijkheid is bijzonder handig in toepassingen die langetermijneigenschappen en continuïteit vereisen, zoals klantenservice en persoonlijke assistenten.

-

Multimodale Integratie: AI-agenten kunnen sensorische invoer uit verschillende bronnen integreren, zoals camera’s, microfoons en sensoren, wat LLM’s in staat stelt om beeld- en geluidsgegevens te verwerken en te reageren. Deze integratie is crucial voor toepassingen in robotica en autonome systemen.

-

Gespecialiseerde kennis en expertise: AI-agenten kunnen gefine-tuned worden met domeinspecifieke kennis, die de capaciteit van LLM’s verbetert om geavanceerde taken uit te voeren. Dit aanpakken maakt het mogelijk om expert-systemen te ontwikkelen die complexe vragen kunnen behandelen in gebieden als geneeskunde, rechtspraak en wetenschappelijk onderzoek.

-

Interactive en immersieve communicatie: AI-agenten kunnen meer immersieve vormen van communicatie faciliteren door middel van het genereren van video-inhoud, het besturen van holografische voorstellingen en het interacteren met virtuele en geavanceerde realiteitsomgevingen. Deze mogelijkheid breidt de toepassingen van LLM’s uit in gebieden die vereisen om rijke, multimodale interacties te laten plaatsvinden.

Hoewel grote taalmodellen opmerkelijke capaciteiten hebben getoond in natuurlijke taalverwerking, zijn ze niet zonder beperkingen. De hoge trainingkosten, gegevensbiasssen, specialisatieproblemen, sensorische beperkingen en communicatiebeperkingen vormen aanzienlijke hindernissen.

Maar de integratie van AI-agenten biedt een haalbare manier om deze beperkingen te overwinnen. Door de sterke punten van AI-agenten te benutten, is het mogelijk om de functionaliteit, aanpasbaarheid en toepasbaarheid van LLM’s te verbeteren, waardoor de weg wordt vrijgemaakt voor meer geavanceerde en veelzijdige AI-systemen.

Hoofdstuk 2: De geschiedenis van kunstmatige intelligentie en AI-agenten

De oorsprong van kunstmatige intelligentie

Het concept van kunstmatige intelligentie (AI) heeft wortels die verder reiken dan de moderne digitale tijd. De gedachte van het creëren van machines die kunnen redeneren als mensen kan worden teruggevoerd naar oude mythen en filosofische debatten. Maar de formele introductie van AI als wetenschappelijke discipline vond plaats in de middeleeuwse twintigste eeuw.

De Dartmouth Conference van 1956, georganiseerd door John McCarthy, Marvin Minsky, Nathaniel Rochester en Claude Shannon, wordt algemeen beschouwd als de geboorteplaats van de AI als een vakgebied van onderzoek. Dit开创se gebeurtenis bracht vooraanstaande onderzoeksers samen om het potentieel van het creëren van machines die menselijke intelligentie konden imiteren te onderzoeken.

Vroege Optimisme en de AI Winter

De vroege jaren van AI-onderzoek waren gekenmerkt door ongeremde optimisme. Onderzoeksers maakten significante vooruitgang in het ontwikkelen van programma’s die in staat waren om wiskundige problemen op te lossen, spellen te spelen en zelfs eenvoudige natuurlijke taalverwerking uit te voeren.

Maar dit initiële enthousiasme werd gedempte door het inzien dat het creëren van echt intelligentie machines veel complexer was dan aanvankelijk verwacht werd.

De jaren 1970 en 1980 brachten een periode van verminderde financiën en interesse in AI-onderzoek, die vaak verwezen wordt als de “AI Winter“. Deze daling was vooral veroorzaakt door het mislukken van AI-systemen om de hoogte van de verwachtingen van de vroege pioniers te meeten.

Van rechtstreekse systemen naar machinelearning

De Eerste Klasse van Expert Systeem

De jaren 1980 werden getuige van een heroprichting van interesse in AI, voornamelijk geleid door de ontwikkeling van expert systemen. Deze rechtstreekse systemen waren ontworpen om de besluitvormingsprocessen van menselijke experts in specifieke domeinen na te bootsen.

Expertensystemen vonden toepassingen in verschillende gebieden, inclusief geneeskunde, financiën en techniek. Maar ze waren beperkt door hun onvermogen om uit ervaring te leren of zich aan te passen aan nieuwe situaties buiten hun geprogrammeerde regels.

Het opkomst van Machine Learning

De beperkingen van regelgebaseerde systemen maakten plaats voor eenparadigmenwisseling in de richting van machine learning. Deze benadering, die prominentie behaalde in de jaren 90 en 2000, concentreert op het ontwikkelen van algoritmen die kunnen leren van en voorspellingen of beslissingen kunnen maken op basis van gegevens.

Machine learning technieken, zoals neurale netwerken en steun vector machines, toonden uitzonderlijk succes in taken als patronen herkenning en gegevens classificering. Het verschijnen van big data en de toename van computationele kracht versnelde de ontwikkeling en toepassing van machine learning algoritmen nog meer.

De opkomst van Autonome AI-agenten

Van Nauw AI naar Algemeen AI

Terwijl AI-technologieën doorgingen met hun ontwikkeling, begonnen onderzoekers met het onderzoeken van de mogelijkheid om meer aanpasbare en autonome systemen te creëren. Deze transitie markeerde de overgang van nauw AI, ontworpen voor specifieke taken, naar het nastreven van kunstmatige algemeen intelligentie (AGI).

AGI heeft als doel systemen te ontwikkelen die in staat zijn elke intellectuele taak uit te voeren die een mens kan, terwijl de echte AGI nog steeds een verre doel is. Toch zijn er significante vooruitgangen gemaakt in het creëren van meer flexibele en aanpasbare AI-systemen.

De rol van diepe leren en neurale netwerken

Het ontstaan van diepe leren, een deelgebied van machineleren dat gebaseerd is op kunstmatige neurale netwerken, is een belangrijke factor geweest in het vooruitgang van het veld van AI.

Algoritmen voor diepe leren, geïnspireerd op de structuur en functie van het menselijke brein, hebben vertoond dat ze uitzonderlijke capaciteiten bezitten in gebieden zoals beeld- en spraakherkenning, natuurlijke taalverwerking en spellen spelen. Deze vooruitgangen hebben de grondslag gelegd voor het ontwikkelen van meer geavanceerde autonome AI-agents.

Kenmerken en typen van AI-agents

AI-agents zijn autonome systemen die in staat zijn hun omgeving perceptie te maken, beslissingen te nemen en acties uit te voeren om specifieke doelen te behalen. Ze bezitten kenmerken zoals autonomie, perceptie, reactiviteit, redeneren, beslissen, leren, communicatie en doelgerichtheid.

Er zijn verschillende typen AI-agents, elk met hun unieke capaciteiten:

-

Eenvoudige Reflexagents: Reageren op specifieke stimuli op basis van voorgedefinieerde regels.

-

Modelgebonden reflecterende agents: Behouden een interne model van het milieu voor besluitvorming.

-

Doelgerichte agents: Uitvoeren van acties om specifieke doelen te behalen.

-

Utiliteitsgerichte agents: Overwegen potentiële uitkomsten en kiezen acties die de verwachte utiliteit maximale.

-

Lerende agents: Verbetering van besluitvorming over tijd door middel van machinaal leren methodes.

Challenges and Ethical Considerations

Als AI-systemen steeds meer geavanceerd en autonoom worden, brengen ze kritische overwegingen met zich mee om te zorgen dat hun gebruik binnen de maatschappelijk aanvaardbare grenzen blijft.

Specifiek voor Grote Taalmodelen (LLMs) zijn ze een krachtbron voor productiviteit. Maar dit brengt een cruciale vraag met zich mee: WAT zal deze systemen supercharge—goede bedoelingen of slechte bedoelingen? Wanneer de bedoeling achter het gebruik van AI kwaad is, is het noodzakelijk dat deze systemen zoeken naar zulke misbruiken met behulp van diverse NLP-technieken of andere beschikbare hulpmiddelen.

Ingenieurs van LLM hebben toegang tot een reeks gereedschap en methodieken om deze uitdagingen aan te gaan:

-

Sentiment Analyse: Door middel van sentiment analyse kunnen LLM’s de emotionele toon van tekst beoordelen om gevaarlijke of agressieve taal te detecteren, waardoor potentiële misbruiken op communicatieplatforms kunnen worden geïdentificeerd.

-

Inhoud Filter: Gereedschappen zoals keywoordfiltering en patronenmatchen kunnen worden gebruikt om het genereren of verspreiden van gevaarlijke inhoud te voorkomen, zoals haatspreek, misinformatie of expliciete materialen.

-

Bias Detection Tools: Door middel van het implementeren van biaisframeworks, zoals AI Fairness 360 (IBM) of Fairness Indicators (Google), kunnen helpen identificeren en de biais in taalmodellen aan te pakken, waardoor AI-systemen fair en equitaatief operationeel zijn.

-

Verklaarbare technieken

: Door gebruik te maken van verklaarbare gereedschap zoals LIME (Local Interpretable Model-agnostic Explanations) of SHAP (SHapley Additive exPlanations) kunnen engineers de besluitvormingsprocessen van LLMs begrijpen en verklaren, waardoor het gemakkelijker wordt om ongerechtvaardigde gedragingen op te sporen en aan te pakken.

-

Adversairale testen: door middel van het simuleren van kwaadaardige aanvallen of schadelijke invoer, kunnen engineers LLMs met gereedschap zoals TextAttack of Adversarial Robustness Toolbox laten testen, identificerende kwetsbaarheden die misbruikt kunnen worden voor kwaadaardige doelen.

-

Ethische AI-richtlijnen en kaders: Door ethische AI-ontwikkelingsrichtlijnen aan te nemen, zoals die aangeboden worden door de IEEE of de Partnership on AI, kunnen engineers verantwoordelijke AI-systemen creëren die de welvaart van de maatschappij in prioriteit hebben.

Naast deze hulpmiddelen is dit waarom we een speciaal Red Team voor AI nodig hebben – gespecialiseerde teams die LLMs tot hun grenzen duwen om hun verdedigingen te testen. Red Teams simuleren vijandige scenario’s en ontdekken kwetsbaarheden die anders onopgemerkt zouden kunnen blijven.

Maar het is belangrijk te erkennen dat de mensen achter het product de grootste invloed op het hebben. Veel van de aanvallen en uitdagingen die we vandaag de dag tegenkomen bestonden al voordat LLMs ontwikkeld werden, wat aan het menselijke element herinnert dat centraal staat bij het waarborgen van de ethische en verantwoordelijke gebruik van AI.

De integratie van deze hulpmiddelen en technieken in de ontwikkelingspijplijn, samen met een vigilante Red Team, is essentieel voor het waarborgen dat LLMs gebruikt worden om positieve resultaten te versnellen terwijl detecteert en preventie van misbruik wordt opgemerkt.

Hoofdstuk 3: Waar AI-agenten het beste uitkomen

De unieke sterke punten van AI-agenten

AI-agenten onderscheiden zich door hun vermogen om autonoom hun omgeving waar te nemen, beslissingen te nemen en acties uit te voeren om specifieke doelstellingen te bereiken. Deze autonomie, in combinatie met geavanceerde machine learning-capabilities, maakt het mogelijk voor AI-agenten taken uit te voeren die te complex of te reproductief zijn voor mensen.

Dit zijn de kenmerkende sterktes die AI-agenten uitblinken:

-

Autonomie en Efficiëntie: AI-agenten kunnen zelfstandig werken zonder constante menselijke干预. Deze autonomie maakt het mogelijk voor hen taken 24/7 af te handelen, wat significant de efficiëntie en productiviteit verbeterd. Bijvoorbeeld, AI-gebaseerde chatbots kunnen tot 80% van de dagelijkse klantcontacten afhandelen, waardoor de operationele kosten worden verminderd en de responsestijden verbeterd.

-

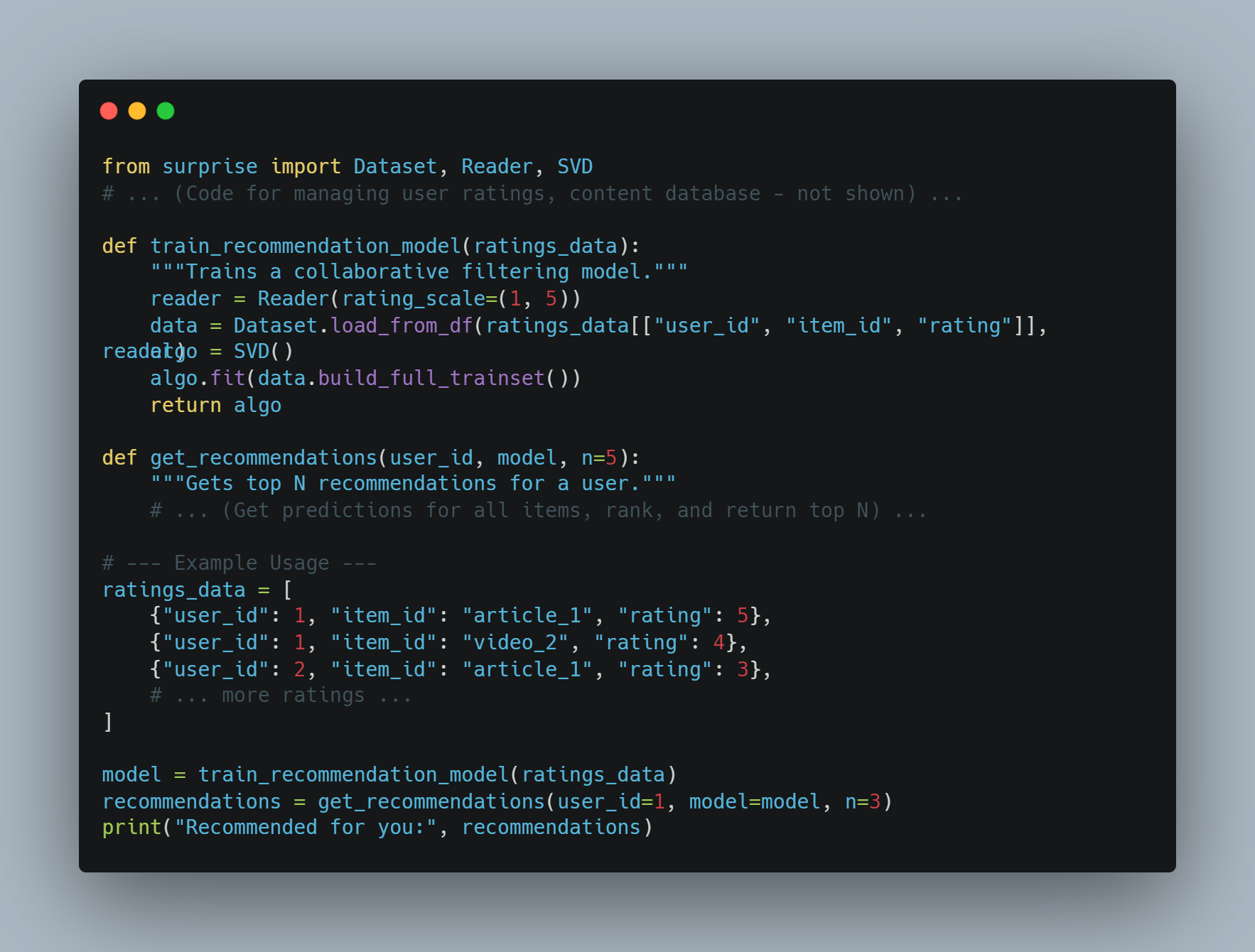

Geavanceerd besluitvormingsvermogen: AI-agenten kunnen grote hoeveelheden gegevens analyseren om informatieve besluiten te nemen. Deze capaciteit is bijzonder waardevol in gebieden zoals financiën, waar AI-handelrobots de handelsefficiëntie aanzienlijk kunnen verhogen.

-

Leren en aanpassen

: AI-agenten kunnen uitervaring leren en zich aanpassen aan nieuwe situaties. Deze doorlopende verbeteringen maken het mogelijk voor hen hun prestaties over tijd te verbeteren. Bijvoorbeeld, AI-gezondheidsassistenten kunnen helpen bij het verminderen van diagnosefouten, waardoor de resultaten van de gezondheidszorg verbeterd kunnen worden.

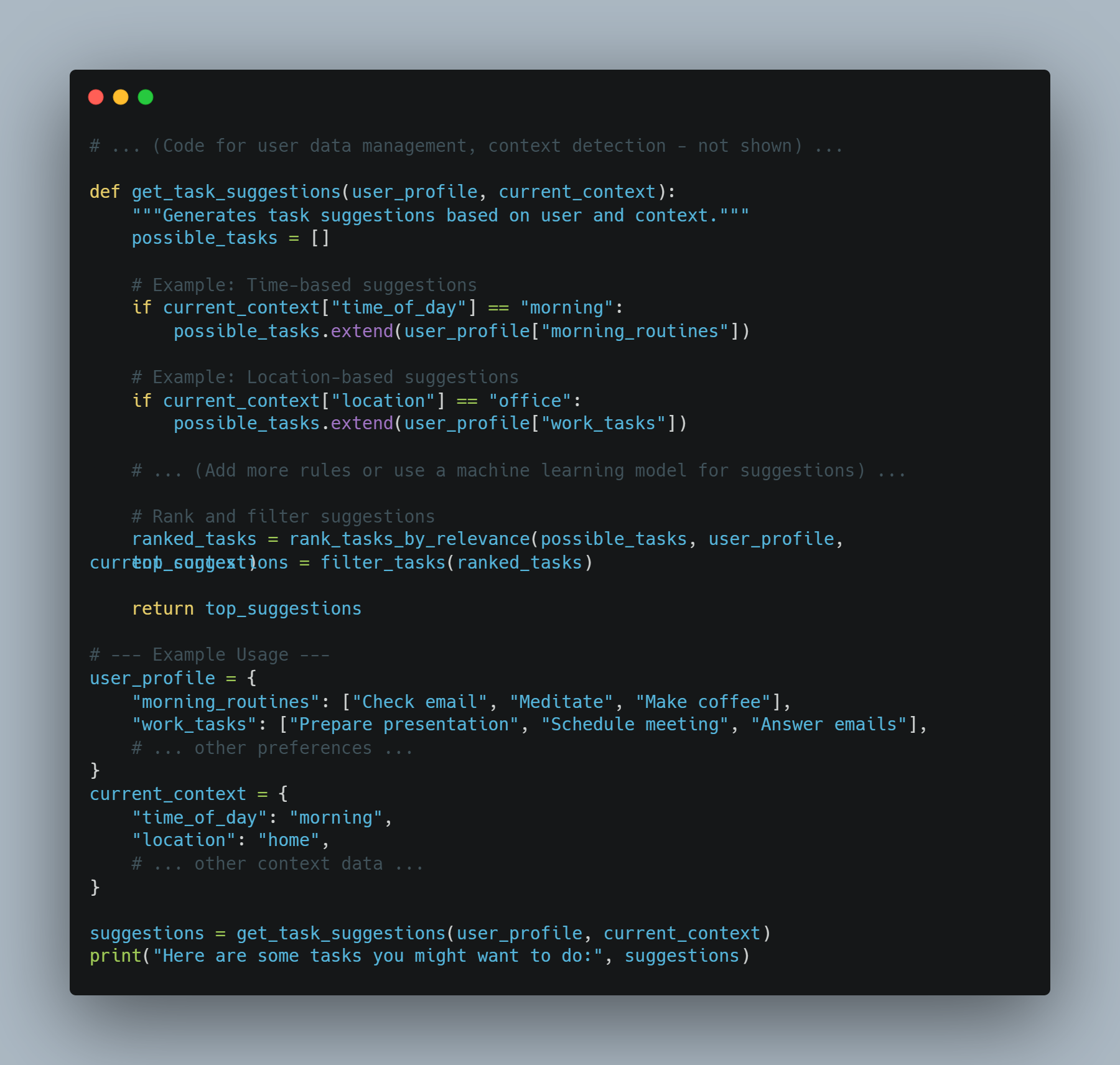

- Personaliseren: AI-agenten kunnen persoonlijke ervaringen bieden door het analyseren van gebruikersgedrag en voorkeuren. Amazon’s aanbevelingsengine, die 35% van zijn omzet drijft, is een goed voorbeeld van hoe AI-agenten de gebruikerservaring kunnen verbeteren en inkomsten kunnen stijgen.

Waarom AI-agenten de oplossing zijn.

AI-agenten bieden oplossingen voor veel van de uitdagingen die traditionele software en menselijk bestuurde systemen aan komen. Dit zijn de redenen waarom ze de voorkeur krijgen:

-

Scalabiliteit: AI-agenten kunnen operaties scalen zonder gelijkenis in kosten. Deze scalabiliteit is crucial voor bedrijven die willen groeien zonder significante toename van hun werkkracht of operationele kosten.

-

Consistentie en Betrouwbaarheid: In tegenstelling tot mensen ondervinden AI-agenten geen moeilijkheden door vermoeidheid of inconsistentie. Ze kunnen reproductieve taken met hoge nauwkeurigheid en betrouwbaarheid uitvoeren, waardoor consistente prestaties zijn gegarandeerd.

-

Data-gebaseerde Inzichten: AI-agenten kunnen grote gegevenssets verwerken en analyseren om patronen en inzichten te onthullen die mensen misschien gemist zouden kunnen worden. Deze mogelijkheid is onbereikbaar voor besluitvorming in gebieden zoals financiën, gezondheidszorg en marketing.

-

Kostenbesparingen: door de automatisering van routine-taken kunnen AI-agenten de behoefte aan menselijke resources verminderen, wat tot significante kostenbesparingen leidt. Bijvoorbeeld, AI-gebaseerde fraudeenquêtes kunnen jaarlijks miljarden van dollars besparen door het verminderen van fraudeleveringen.

Vereisten voor AI-agenten om goed te presteren

Om de succesvolle implementatie en prestatie van AI-agenten te waarborgen, moeten certaingevonden worden:

-

Duidelijke doelstellingen en toepassingsgebieden: Het definiëren van specifieke doelstellingen en toepassingsgebieden is crucial voor de effectieve implementatie van AI-agenten. Deze duidelijkheid helpt bij het instellen van verwachtingen en het meten van succes. Bijvoorbeeld, het stellen van een doel om de reactietijd van de klantenservice door AI-chatbots te reduceren tot 50% kan de implementatie van AI-chatbots begeleiden.

-

Kwaliteit gegevens: AI-agenten zijn afhankelijk van goedkope gegevens voor training en operationeel gebruik. Zorgen dat de gegevens correct, relevant en up-to-date zijn, is essentieel voor de agenten om informerende beslissingen te nemen en effectief te functioneren.

-

Integreren met bestaande systemen: Vloeiende integratie met bestaande systemen en werkstromen is noodzakelijk voor het optimale functioneren van AI-agenten. Deze integratie zorgt ervoor dat AI-agenten toegang krijgen tot de noodzakelijke gegevens en kunnen interacteren met andere systemen om hun taken uit te voeren.

-

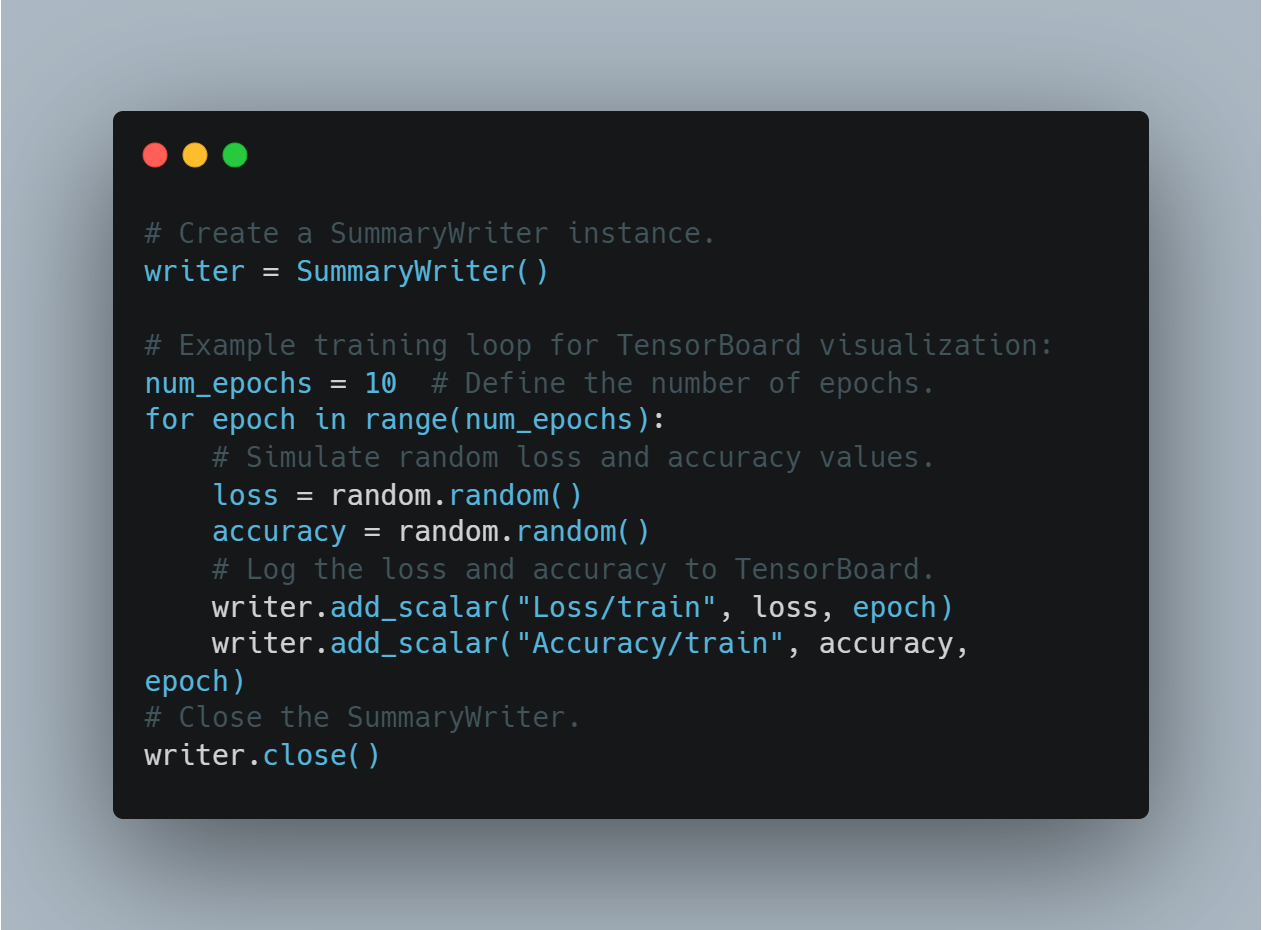

Continu monitor en optimaliseren: Regelmatig monitor en optimaliseren van AI-agenten is crucial voor het behoud van hun prestaties. Dit omvat het volgen van kritieke prestatieindicatoren (KPIs) en het op basis van feedback en prestatiedata nodige aanpassingen uitvoeren.

-

Ethische overwegingen en systematische vooroordelen: Het aanpakken van ethische overwegingen en systematische vooroordelen in AI-agents is essentieel voor het waarborgen van eerlijkheid en inclusiviteit. Het implementeren van maatregelen om vooroordelen te detecteren en te voorkomen helpt bij het opbouwen van vertrouwen en het verzekerden van een verantwoordelijke aanleg.

Best practices voor het implementeren van AI-agents

Bij het implementeren van AI-agents kunnen best practices ervoor zorgen dat hun succes en effectiviteit worden waarborgd:

-

Defineer doelstellingen en toepassingsgebieden: Duidelijk vaststellen van de doelstellingen en toepassingsgebieden voor het implementeren van AI-agents. Dit helpt bij het stellen van verwachtingen en het meten van succes.

-

Kies de juiste AI-platform

: Kies een AI-platform dat alignt met uw doelstellingen, gebruiksgevallen en bestaande infrastructuur. Overweeg factoren als integratiecapabilities, scalabiliteit en kosten.

- Ontwikkel een uitgebreide kennisbasis: Bouw een goed georganiseerde en accurate kennisbasis om AI-agenten in staat te stellen relevante en betrouwbare reacties te geven.

- Zorg ervoor dat de integratie vloeit: Integrate AI-agenten met bestaande systemen zoals CRM en callcenter technologieën om een geünificeerde klantervaring te bieden.

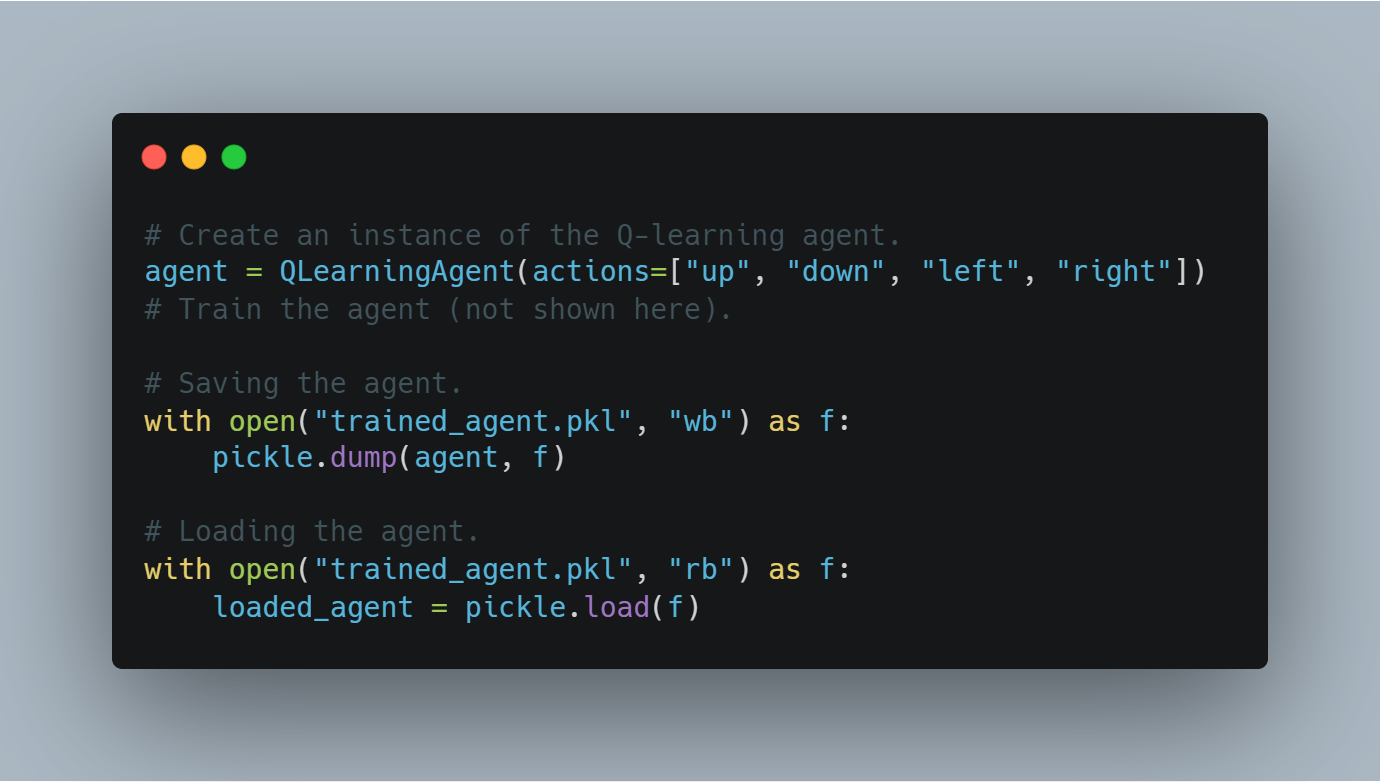

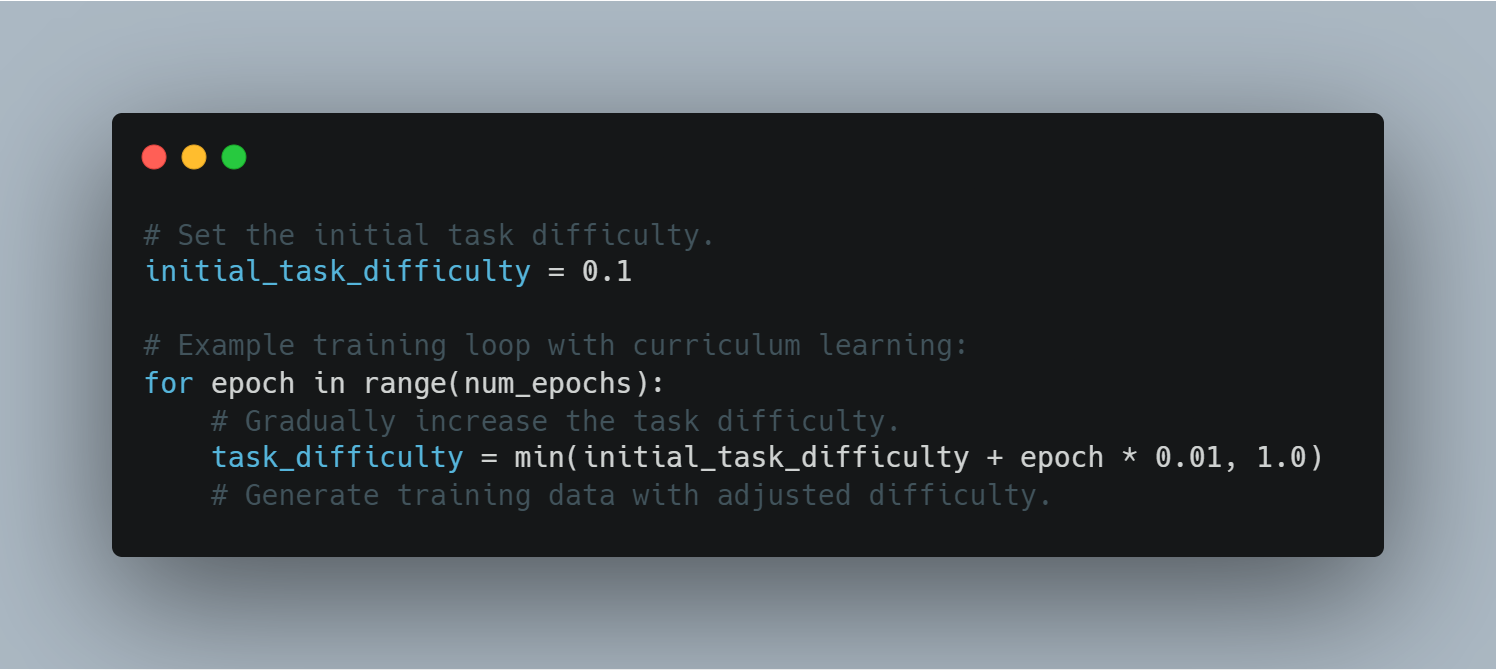

- Traineer en optimaliseer AI-agenten: Train AI-agenten continu met data uit interacties. Monitor de prestaties, identificeer areas voor verbetering en update de modellen daaropaf.

-

Implementeer correcte opwaarderingprocedures: Stel protocollen in voor het overdragen van complexe of emotionele oproepen aan menselijke agenten, om een vloeiende overgang en een effectieve oplossing te waarborgen.

-

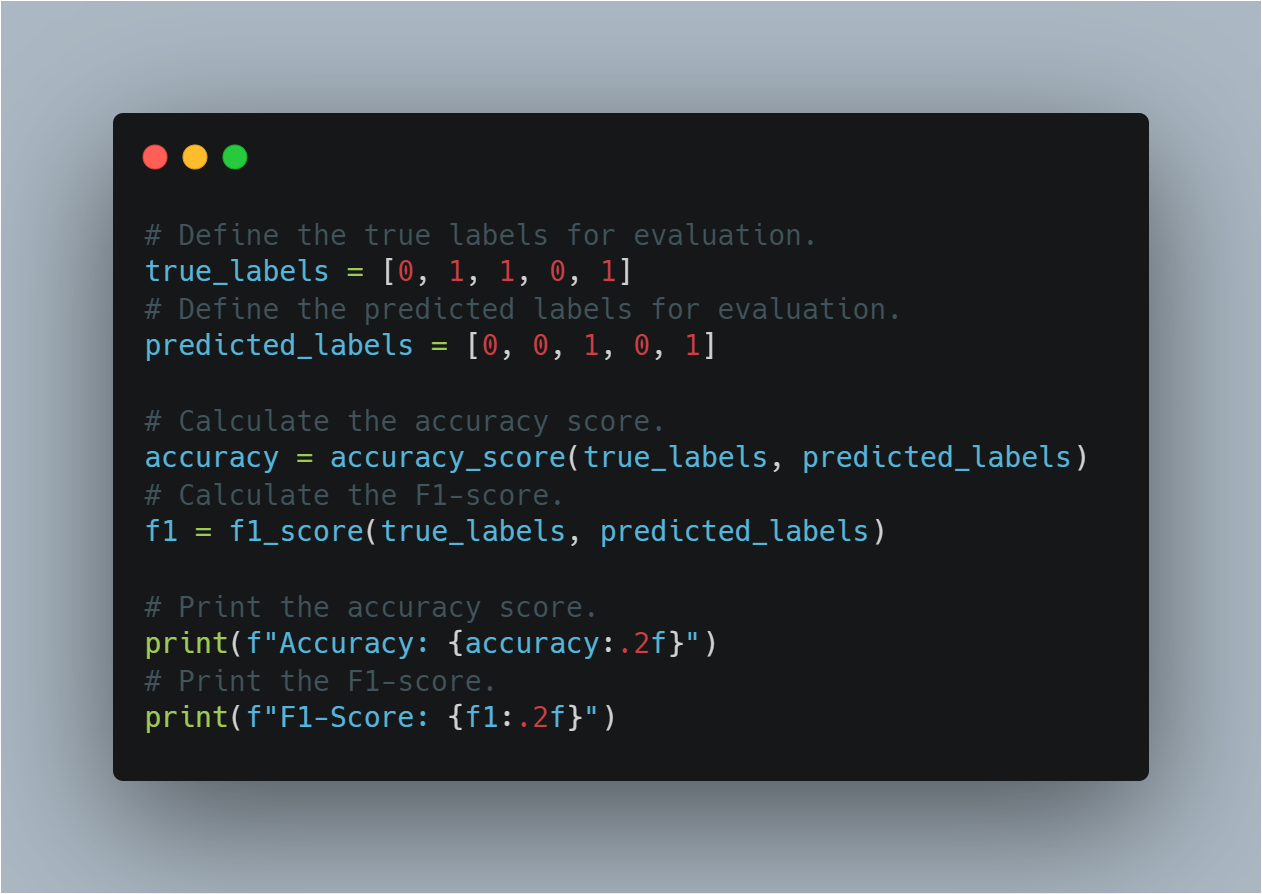

Monitoreer en analyseer prestaties: Volg kritieke prestatiegenereringen (KPIs) zoals oproepoplossingspercentages, gemiddelde behandelingstijd en klanttevredenheidscijfers. Gebruik analytics tools voor data-gebaseerde inzichten en beslissingen.

-

Beveilig gegevens en bescherm privacy: sterke beveiligingsmaatregelen zijn crucial, zoals het anonimiseren van gegevens, erop toezien dat er menselijke toezicht is, het opstellen van beleidsregels voor gegevensbehandeling en het opzetten van sterke encryptiemaatregelen om klantgegevens te beschermen en privacy te handhaven.

AI-agenten + LLMs: Een nieuw tijdperk van slimme software.

Verbeeld software die niet alleen uw verzoeken begrijpt maar ook deze uitvoert. Dat is de belofte van het combineren van AI-agenten met Grote Taalmodellen (LLMs). Deze krachtige combinatie creëert een nieuwe generatie applicaties die intuitiever, krachtiger en meer impactvol zijn dan ooit eerder.

AI-agenten: Bijdrage aan geavanceerde takenuitvoering

Terwijl ze vaak vergeleken worden met digitaal assistenten, zijn AI-agenten veel meer dan verfraaide scriptvolgers. Ze omvatten een reeks geavanceerde technologieën en werken op een framework dat dynamische besluitvorming en actievoering mogelijk maakt.

-

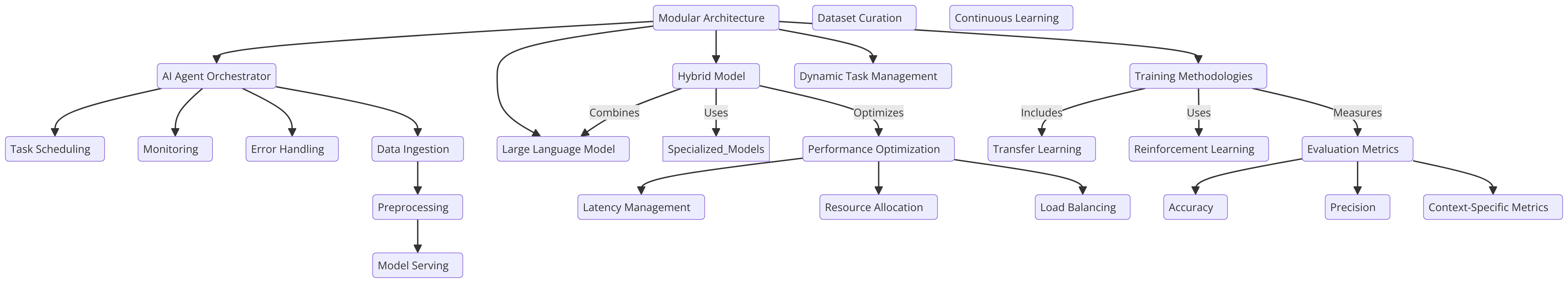

Architectuur: Een typische AI-agent bestaat uit verschillende kernonderdelen:

-

Sensors: Deze stellen de agent in staat om zijn omgeving te waarnemen, gegevens verzameld van diverse bronnen zoals sensoren, APIs of gebruikersinvoer.

-

Belief State: Dit weergeeft de agenten begrip van de wereld op basis van de verzamelde gegevens. Het wordt constant bijgewerkt als nieuwe informatie beschikbaar komt.

-

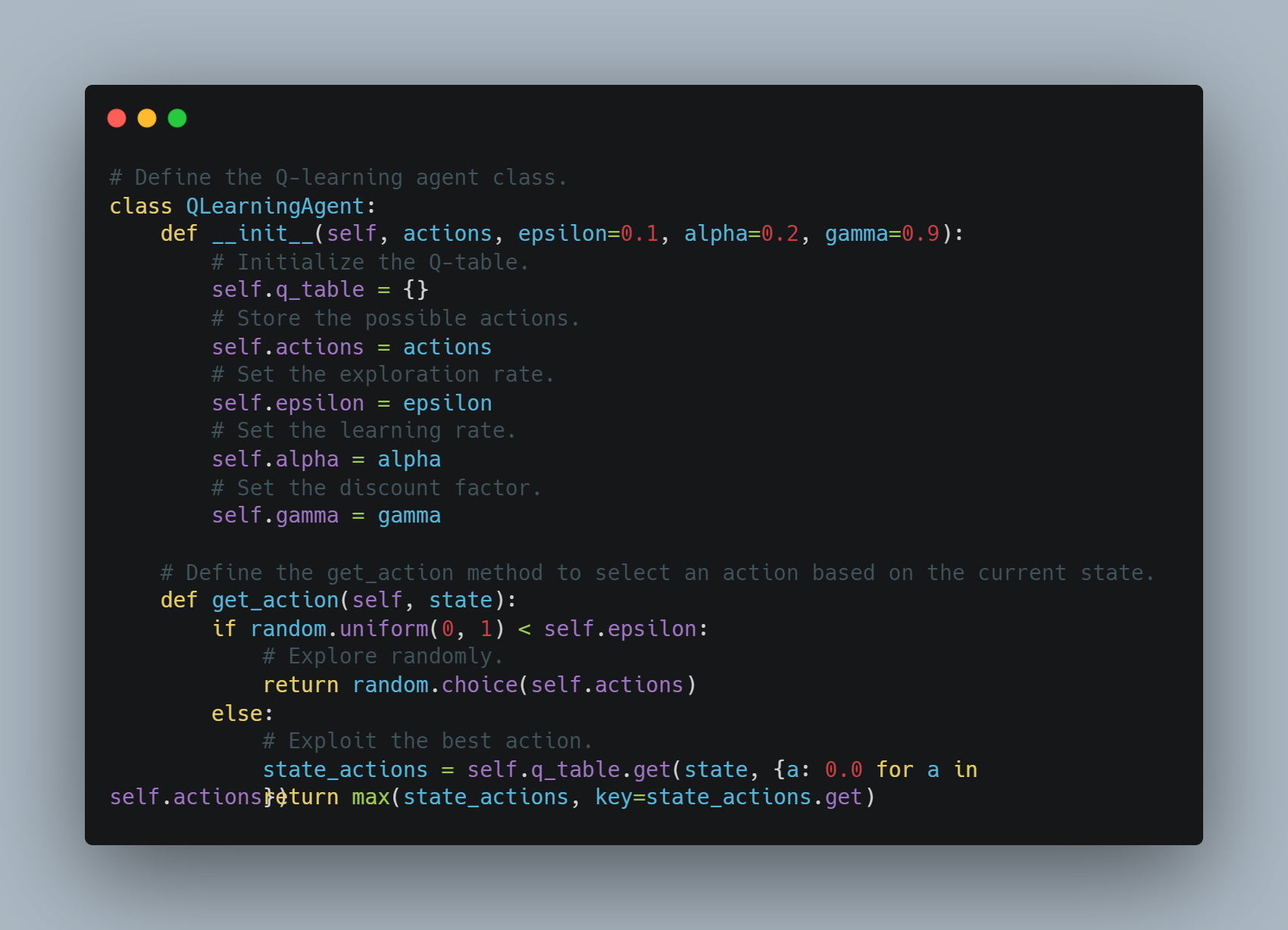

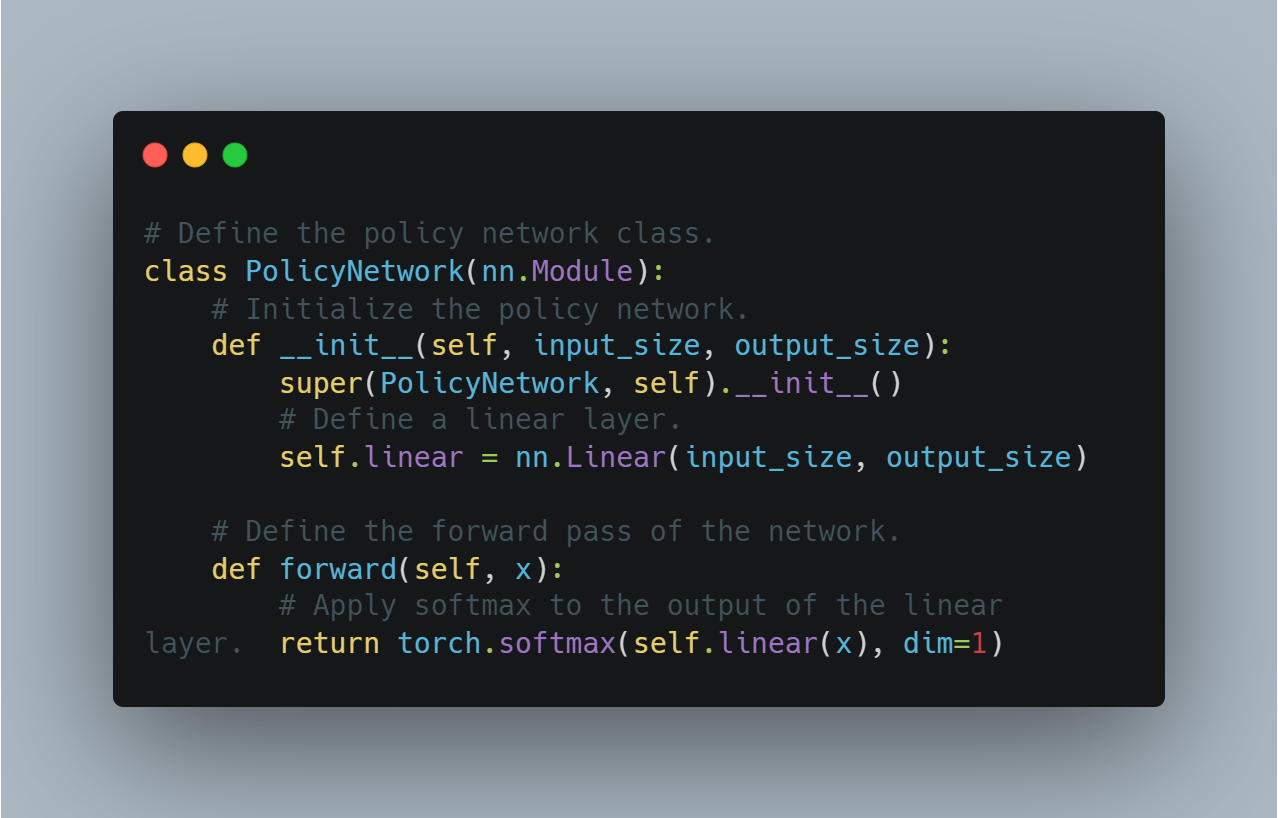

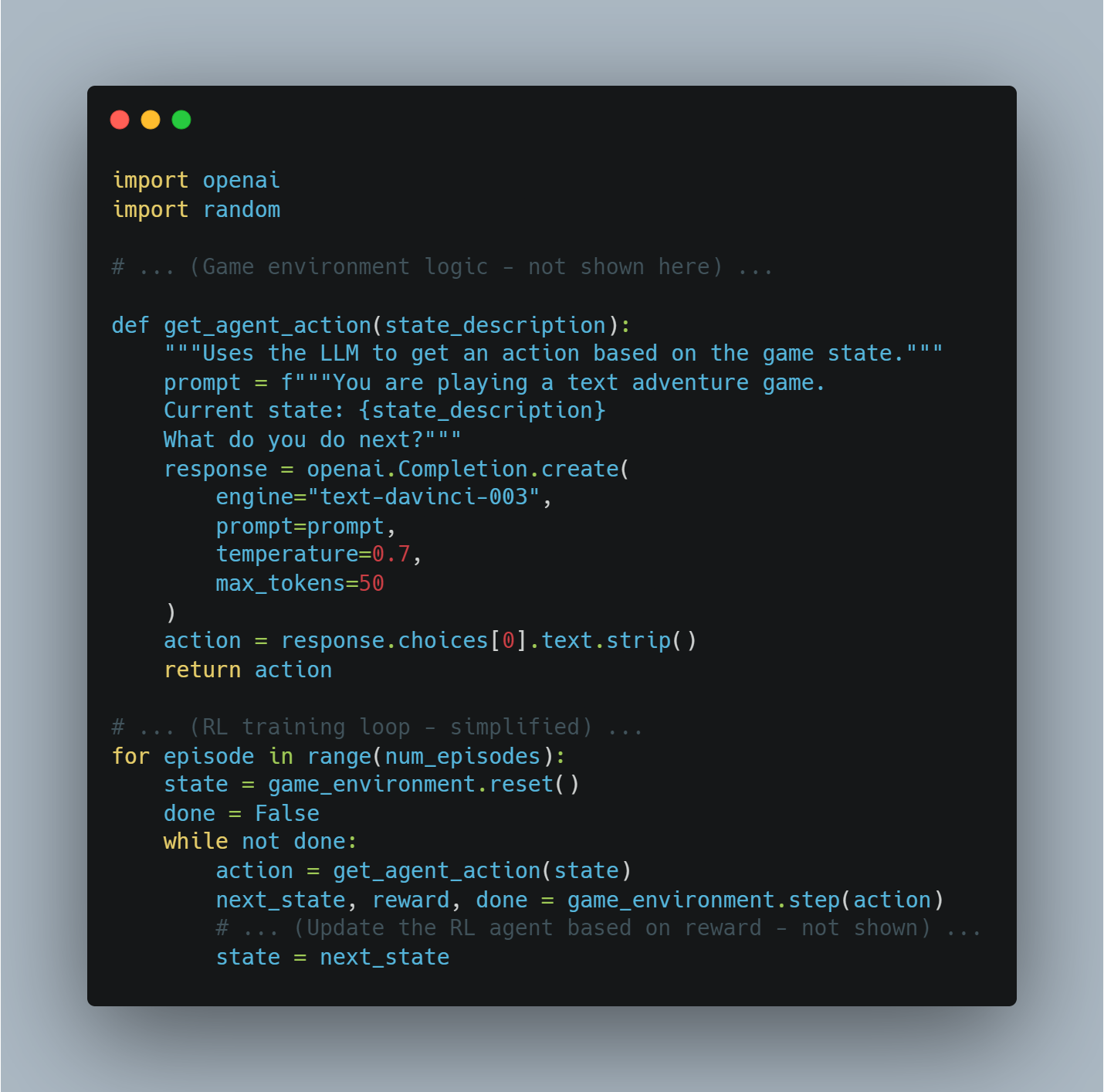

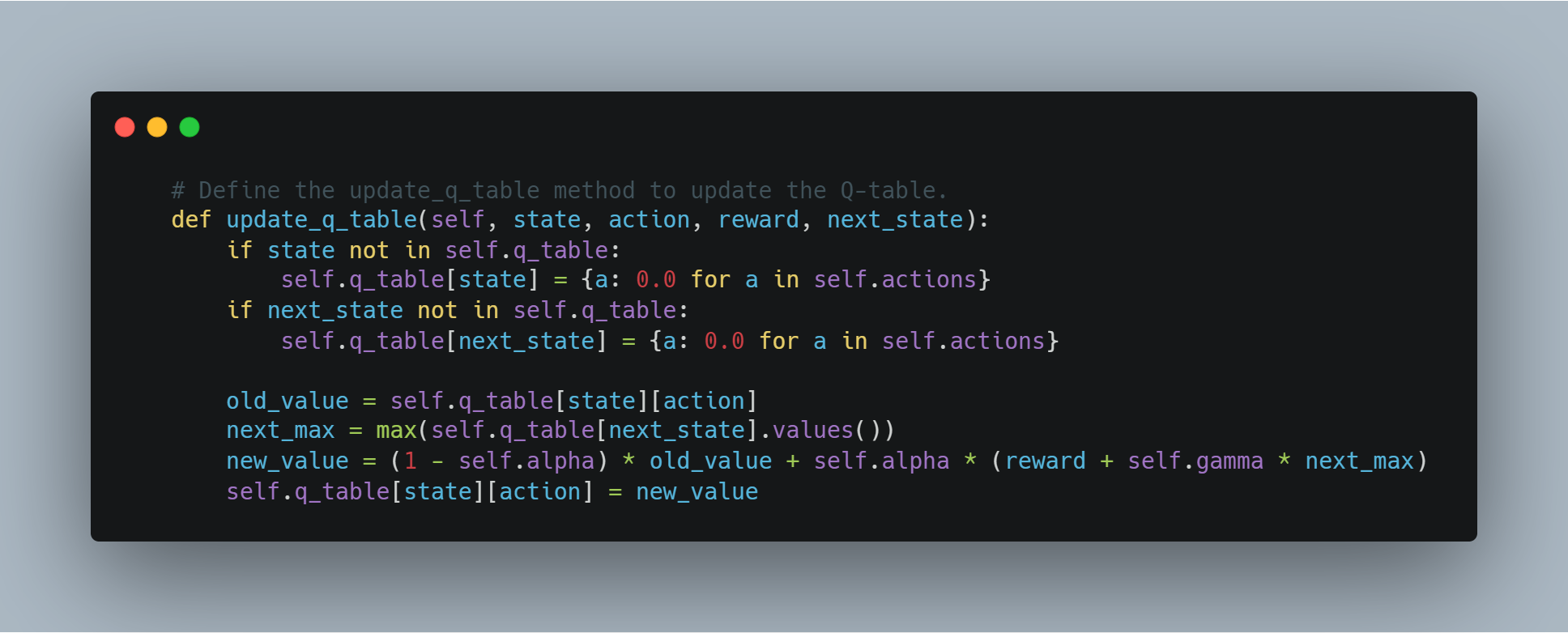

Redeneeringsengine: Dit is het hart van het besluitvormingsproces van de agent. Het gebruikt algoritmen, vaak gebaseerd op reïnforcement learning of planningstechnieken, om de beste actie te bepalen op basis van zijn huidige overtuigingen en doelstellingen.

-

Actuatoren: Deze zijn de tools van de agent voor het interactie met de wereld. Ze kunnen variëren van het versturen van API-aanroepen tot het besturen van fysieke robots.

-

-

Challenges: traditionele AI-agenten, hoewel ze goed opgedane taken kunnen aanpakken, vechten vaak tegen:

-

Natuurlijke taal begrip: het interpreteren van subtiele menselijke taal, het handelen met ambiguïteit en het halen van betekenis uit context zijn nog steeds significante uitdagingen.

-

Redeneren met algemeen kennis: huidige AI-agenten hebben vaak het algemeen kennisgebruik en de redeneervaardigheden die mensen geneest, ontbroken.

-

Generalisatie: het trainen van agenten om goed te presteren op ongeziene taken of aan te passen aan nieuwe omgevingen, is nog steeds een belangrijk onderzoeksgebied.

-

LLM’s: Ontdekking van taalverstand en genereren

LLM’s brengen met hun uitgebreide kennis, ingecodeerd in miljarden parameters, een ongeziene taalkracht aan tafel:

-

Transformer-architectuur: De transformer-architectuur, de basis van de meeste moderne LLM’s, is een ontwerp voor een neural network dat uitstekend sequentieel gegevens als tekst verwerkt. Dit maakt het LLM’s mogelijk om in de taal lange-afstandsafhankelijkheden op te slaan, wat hen in staat stelt context te begrijpen en coherent en contextueel relevante tekst te genereren.

-

Capabilities: LLM’s zijn uitstekend in veel taal gebaseerde taken:

-

Tekstgeneratie: Van het schrijven van creatief fictie tot de generering van code in meerdere programmeertalen, tonen LLM’s ongekende vloeiendheid en creativiteit.

-

Vraagbehandeling: Ze kunnen korte en nauwkeurige antwoorden geven op vragen, zelfs als de informatie over lange documenten verspreid is.

-

Samenvatting: LLM’s kunnen grote hoeveelheden tekst samenvatten in korte samenvattingen, uit diepe informatie belangrijke informatie en onbelangrijke details wegwerkt.

-

-

Beperkingen: Ondanks hun indrukwekkende mogelijkheden hebben LLMs beperkingen:

-

Onrealistische Aanschakeling: LLMs werken voornamelijk in het domein van de tekst en hebben geen directe interactie met de fysieke wereld.

-

Mogelijke Bias en Verhalen: Geëxporteerd op grote, niet gecontroleerde datasets, kunnen LLMs de in de gegevens aanwezige vooroordelen erfden en soms feitelijk onjuist of onzinnig informatie genereren.

-

De Samenspraak: Het Kruisbestrating van Taal en Handeling

De combinatie van AI-agenten en LLM’s addressseert de beperkingen van elke, creatie van systemen die zowel intelligent als vermogen tot actie hebben:

-

LLM’s als Interpreten en Planners: LLM’s kunnen natuurlijke taalinstructies vertalen in een formaat dat AI-agenten kunnen begrijpen, waardoor de mens-computerinteractie intuitiever wordt. Ze kunnen ook hun kennis gebruiken om agenten te assisteren bij het plannen van complexe taken door ze op te delen in kleinere, door te kunnen komen stappen.

-

AI-agenten als uitvoerders en leerders: AI-agenten bieden LLM’s de mogelijkheid om met de wereld te interacteren, informatie te verzamelen en feedback op hun acties te ontvangen. Deze realistische basis kan LLM’s helpen leren van ervaring en hun prestaties langzaam te verbeteren.

Deze krachtige synergie drijft de ontwikkeling van een nieuwe generatie applicaties aan die intuïtiever, aanpasbaarder en krachtiger zijn dan ooit. Aan de hand van beide AI-agent- en LLM-technologieën die steeds verdergaan, kunnen we verwachten dat er nog meer innovatieve en impactvolle toepassingen zullen ontstaan, die het landschap van softwareontwikkeling en mens-computerinteractie veranderen.

Reële wereldvoorbeelden: transformerende bedrijfssectoren

Deze krachtige combinatie maakt al schommelingen in verschillende sectoren:

-

Klantenservice: Problemen oplossen met contextuele bewustheid

- Voorbeeld: Verlangen we een klant die een vertraagde levering van een online winkel aanroept. Een AI-agent die wordt aangedreven door een LLM kan de frustratie van de klant begrijpen, toegang krijgen tot hun bestelgeschiedenis, de pakketten in realtime volgen, en actief aanbiedingen doen zoals verhoogde levering of korting op de volgende aankoop.

-

Inhoud creëren: Grote hoeveelheden hoogwaardige inhoud produceren

- Voorbeeld: Een marketingteam kan een AI-agent + LLM-systeem gebruiken om doelgerichte sociale media-posts te genereren, productomschrijvingen te schrijven of zelfs video-scripts te maken. De LLM zorgt ervoor dat de inhoud Engelstalig en informatief is, terwijl de AI-agent de uitgeverij en distributieproces afhandelt.

-

Softwareontwikkeling: versnelling van codering en debugging

- Voorbeeld: Een ontwikkelaar kan een softwarefunctie beschrijven die ze willen bouwen door middel van natuurlijke taal. De LLM kan dan code fragmenten genereren, potentiele fouten identificeren en suggesties voor verbeteringen aanbieden, wat de ontwikkelingsproces significant versnelt.

-

Gezondheidszorg: personaliseren van behandeling en verbeteren van patientenzorg

- Voorbeeld: Een AI-agent met toegang tot een patiënts medische geschiedenis en uitgerust met een LLM kan antwoorden op hun gezondheidsgerelateerde vragen, personaliseerde medicijnenherinneringen aanbieden en zelfs voorlopige diagnose’s op basis van hun symptomen aanbieden.

-

Wetgeving: Efficiëntieverbetering in Juridisch Onderzoek en Documentenopstellen

- Voorbeeld: Een advocaat moet een contract opstellen met bepaalde clausules en juridische voorgangers. Een AI-agent aangedreven door een LLM kan de instructies van de advocaat analyseren, door grote juridische databases bladeren, relevante clausules en voorgangers identificeren, en zelfs delen van het contract opstellen, hetgeen het benodigde tijd en moeite aanzienlijk reduceert.

-

Video Creatie: Gemakkelijk Engagerende Video’s Genereren

- Voorbeeld: Een marketingteam wil een korte video maken die de functies van hun product uitlegt. Ze kunnen een AI-agent + LLM-systeem voorzien van een scriptuitlijning en voorkeuren voor visuele stijl. De LLM kan vervolgens een gedetailleerd script genereren, geschikte muziek en beelden voorstellen, en zelfs de video bewerken, waarbij een groot deel van het video-creatieproces geautomatiseerd wordt.

-

Architectuur: Ontwerpen van gebouwen met AI-gepowerde inzichten

- Voorbeeld: Een architect ontwerpt een nieuwe kantoorgebouw. Ze kunnen een AI-agent + LLM-systeem gebruiken om hun ontwerpgoals in te geven, zoals het maximale uitbruiken van natuurlijke licht en de optimalisering van ruimtegebruik. De LLM kan dan deze doelstellingen analyseren, verschillende ontwerpopties genereren, en zelfs simuleren hoe het gebouw zou presteren onder verschillende milieuomstandigheden.

-

Bouw: Veiligheid en Efficiëntie op Bouwlocaties Verbeteren

- Voorbeeld: Een AI-agent die uitgerust is met camera’s en sensoren kan een bouwlocatie monitoren op veiligheidsgevaarlijke situaties. Als een werknemer niet de juiste veiligheidsuitrusting draagt of een apparaat in een gevaarlijke positie wordt achtergelaten, kan de LLM de situatie analyseren, de sitebeheerder waarschuwen en zelfs automatisch de activiteiten onderbreken indien nodig.

Het Verleden is Verleden: Een Nieuwe Era van Softwareontwikkeling

De convergentie van AI-agenten en LLMs maakt een grote sprong vooruit in softwareontwikkeling. Terwijl deze technologieën doorgaan met evolueren, kunnen we verwachten dat er nog meer innovatieve toepassingen zullen ontstaan, die industries veranderen, werkstromen streamlineen en nieuwe mogelijkheden voor mens-computerinteractie creëren.

AI-agenten zijn het meest verlicht in gebieden die veel data verwerken, automatiseren van repeterende taken, maken van complexe beslissingen en bieden van persoonlijke ervaringen vereisen. Door de noodzakelijke voorwaarden te meeten en best practices te volgen, kunnen organisaties de volledige potentiële van AI-agenten benutten om innovatie, efficiency en groei aan te drijven.

Kapitel 4: De filosofische grondslag van intelligentie systemen

Het ontwikkelen van intelligentie systemen, vooral in het gebied van kunstmatige intelligentie (AI), vereist een diepgaande begrip van filosofische beginselen. In dit hoofdstuk wordt ingegaan op de kernfilosofische ideeën die de ontwerp, ontwikkeling en gebruik van AI bepalen. Het betonigt de noodzaak van aligneren van technologische vooruitgang met ethische waarden.

De filosofische grondslag van intelligentie systemen is geen theoretische oefening alleen – het is een essentieel raamwerk dat er voor zorgt dat AI-technologieën de mensheid behulpzaam zijn. Door de promotie van rechtvaardigheid, inclusiviteit en het verbeteren van de kwaliteit van leven, helpen deze beginselen AI terug te leiden naar onze beste belangen.

Ethisch overleg bij de ontwikkeling van AI

Als AI-systemen steeds meer geïntegreerd worden in elk aspect van de menselijke wereld, van gezondheidszorg en onderwijs tot financieren en bestuur, moeten we hun ontwerp en implementatie strikt ethisch beoordelen en toepassen.

Het algemeen ethische vraagstuk gaat over hoe AI kan worden geconstrueerd om de menselijke waarden en morele beginselen uit te voeren en te handhaven. Dit vraagstuk is centraal bij de manier waarop AI de toekomst van samenlevingen wereldwijd zal bepalen.

Het hart van dit ethische overleg is het beginsel van beneficie, een steunpunt van de morele filosofie dat voorschrijft dat handelingen moeten zijn gericht op het doen van goed en het verbeteren van de welzijn van individuen en de maatschappij in zijn geheel (Floridi & Cowls, 2019).

In het kader van AI betekent beschermende vruchtbaarheid het ontwerpen van systemen die actief bijdragen aan de bloei van de mensheid — systemen die de gezondheidsresultaten verbeteren, de educatieve mogelijkheden vergroten en de rechtvaardige economische groei faciliteren.

Maar de toepassing van beschermende vruchtbaarheid in AI is niet eenvoudig. Het vereist een gekleurde aanpak die voorzichtig de potentiële voordelen van AI weegt tegen de mogelijke risico’s en schades.

Eén van de belangrijkste uitdagingen bij het toepassen van het principe van beschermende vruchtbaarheid bij de ontwikkeling van AI is de nodige balanceren tussen innovatie en veiligheid.

AI heeft de mogelijkheid om velden als de geneeskunde revolutionair te maken, waar voorspellende algoritmen ziekten eerder en nauwkeuriger kunnen diagnoseren dan menselijke dokters. Maar zonder strikte ethische toezicht kunnen dezelfde technieken bestaande ongelijkheden versterken.

Dit zou bijvoorbeeld kunnen gebeuren als ze voornamelijk in rijke gebieden worden uitgevoerd terwijl minder ontwikkelde gemeenschappen nog steeds basisgezondheidszorg ontberen.

Omwille hiervan vereist ethische AI-ontwikkeling niet alleen een focus op het maximale uitbrengen van voordelen, maar ook een vooruitgangsgerichte aanpak voor risico-reductie. Dit betekent het invoering van solide bescherming om misbruik van AI te voorkomen en ervoor te zorgen dat deze technologieën per ongeluk geen schade toebrengen.

Het ethische kader voor AI moet ook inherent inclusief zijn, ervoor zorgende dat de voordelen van AI gelijkmatig worden verspreid over alle maatschappelijke groepen, inclusief die die traditioneel worden gediscrimineerd. Dit vraagt om een verbintenis aan recht en rechtvaardigheid, ervoor zorgende dat AI niet alleen de status quo bevestigt maar actief werkt systemische ongelijkheden neer te halen.

Bijvoorbeeld, automatisering van banen door middel van AI heeft potentiële bijdrages aan productiviteit en economische groei. Maar het kan ook leiden tot een significante vervanging van banen, die vooral arme werknemers ontelaat.

Zoals u kunt zien, moet een ethisch verantwoorde AI-raamwerk strategieën bevatten voor een rechtvaardig delen van de voordelen en de voorziening van ondersteuningssystemen voor diegene die negatief beïnvloed worden door de vooruitgang van AI.

Het ethische ontwikkelen van AI vereist continu deelname van diverse belanghebbenden, inclusief ethici, technologen, politieke beslissers en de gemeenschappen die het meest beïnvloed zullen worden door deze technologieën. Deze interdisciplinair samenwerking zorgt ervoor dat AI-systemen niet in een vacuüm ontwikkeld worden, maar in plaats daarvan gevormd worden door een breed scala van perspectieven en ervaringen.

Het is door deze collectieve inspanning dat we AI-systemen kunnen creëren die niet alleen de waarden weerspiegelen maar ook deze handhaven, die onze mensheid definiëren —compassie, eerlijkheid, respect voor autonomie en een verbintenis tot het algemeen belang.

De ethische overwegingen in de ontwikkeling van AI zijn niet alleen richtlijnen, maar essentiële elementen die bepalen of AI een goede kracht ter wereld is. door AI op de beginselen van deugd, rechtvaardigheid en inclusiviteit te gronden, en door een voorzichtige aanpak van de balans tussen innovatie en risico, kunnen we ervoor zorgen dat de ontwikkeling van AI niet alleen de technologie voordraagt, maar ook de kwaliteit van het leven voor alle leden van de maatschappij verbetert.

Als we doorgaan met het verkennen van de mogelijkheden van AI, is het noodzakelijk dat deze ethische overwegingen steeds aan het voorfront van onze pogingen blijven, ons geleidend naar een toekomst waarin AI echt de mensheid voordelen brengt.

De noodzaak van een mensgerichte AI-ontwikkeling

Mensgerichte AI-ontwikkeling gaat verder dan alleen maar technische overwegingen. Het is gevestigd in diepe filosofische beginselen die de menselijke waardigheid, autonomie en actieve beschiktheid voorstellen.

Deze aanpak van AI-ontwikkeling is fundamenteel geankerd in de kantiaanse ethische raamwerk, dat stelt dat mensen gezien moeten worden als doelen in zichzelf, niet alleen als instrumenten voor het behalen van andere doelen (Kant, 1785).

De implicaties van dit beginsel voor AI-ontwikkeling zijn diepgaand, die vereisen dat AI-systemen worden ontwikkeld met een onverzadigde focus op dienstbaarheid aan menselijke belangen, het behoud van menselijke agentie en de respectering van individuele autonomie.

Technische implementatie van de beginselen van mensgerichtheid

Autonomie van de mens vergroten door AI: Het concept van autonomie in AI-systemen is kritiek, vooral voor het behouden van de macht van gebruikers in plaats van het controleren of ongerechtvaardigd beïnvloeden van hen.

In technische termen betekent dit het ontwerpen van AI-systemen die de gebruikersautonomie prioriteren door hen de tool’s en informatie te bieden die nodig zijn om informeerde beslissingen te nemen. Dit vereist dat AI-modellen context-bewust zijn, wat betekent dat ze moeten begrijpen waarin de beslissing wordt genomen en hun aanbevelingen daarop aanpassen.

Vanuit het perspectief van systeemontwerp betekent dit de integratie van contextuele intelligentie in AI-modellen, die deze systemen in staat stellen dynamisch aan te passen aan de omgeving, voorkeuren en behoeften van de gebruiker.

Bijvoorbeeld in de gezondheidszorg, moet een AI-systeem dat artsen assisteert bij het diagnoseren van aandoeningen rekening houden met de unieke medische geschiedenis van de patient, de huidige symptomen, en zelfs de psychologische toestand om aanbevelingen uit te voeren die de expertise van de arts ondersteunen in plaats van haar te vervangen.

Dit contextuele aanpassen zorgt ervoor dat AI een ondersteunend instrument blijft dat versterkt, in plaats van verminderd, de menselijke autonomie.

Transparante besluitvormingsprocessen waarborgen: Transparantie in AI-systemen is een fundamentele vereiste voor het verzekeren dat gebruikers de beslissingen van deze technologieën kunnen vertrouwen en begrijpen. Technisch gezien betekent dit het nodige aan expliciete AI (XAI), dat betreft het ontwikkelen van algoritmen die hun beslissingsredenen duidelijk kunnen uitdrukken.

Dit is bijzonder belangrijk in domeinen als financiën, gezondheidszorg en gerechtelijke systemen, waar ondoorzichtige besluitvorming kan leiden tot wantrouwen en ethische bezwaren.

Explicietheid kan worden behaald door verschillende technische methodes. Eén van de algemene methodes is post-hoc interpretabiliteit, waarbij het AI-model een uitleg genereert nadat het besluit is genomen. Dit kan涉及 het opdelen van het besluit in zijn samenstellende factoren en tonen hoe elk ervan tot het uiteindelijke resultaat heeft bijgedragen.

Een andere aanpak is de door gebruikelijke interpretabele modellen, waar de architectuur van de modellen zo ontworpen is dat hun beslissingen vanzelf spraakzaam zijn. Bijvoorbeeld, modellen als beslissingbomen en lineaire modellen zijn natuurlijk interpretabel omdat hun beslissingsproces gemakkelijk gevolgd en begrepen kan worden.

Het probleem bij het implementeren van verklaarbaar AI ligt in het evenwicht houden tussen transparantie en prestatie. Veelal zijn meer complexe modellen, zoals diepe neurale netwerken, minder interpretabel maar nauwkeuriger. Daarom moet de ontwikkeling van mensgerichte AI de keuze tussen de interpretabiliteit van het model en zijn voorspelbare kracht in acht nemen, zodat gebruikers de AI-beslissingen kunnen vertrouwen en begrijpen zonder dat er nauwkeurigheid wordt opgeofferd.

In stand houden van Meerderheidshandhaving: Meerderheidshandhaving is crucial voor het zekerstellen dat AI-systemen operationeel binnen morele en operationele grenzen blijven. Deze handhaving omvat het ontwerpen van AI-systemen met failsafes en overschrijfmogelijkheden die menselijke operators de mogelijkheid geven te ingrijpen indien nodig.

De technische implementatie van de handhaving door mensen kan op verschillende manieren aanpakken.

Eén aanpak is het integreren van systemen met een mens in de loop, waarin de AI-beslissingsprocessen continu worden bewaakt en beoordeeld door menselijke operators. Deze systemen zijn ontworpen om menselijke ingrijpen mogelijk te maken bij cruciale momenten, waardoor AI niet autonoom handelt in situaties waar morele beslissingen nodig zijn.

Zoals bij autonome wapensystemen, is menselijke toezicht essentieel om te voorkomen dat de AI leven-of-doodbeslissingen neemt zonder menselijke invoer. Dit kan betekenen dat er strikte operationele grenzen worden ingesteld die de AI zonder menselijke autorisatie niet kan overschrijden, waardoor ethische veiligheidsmaatregelen in het systeem worden ingebed.

Een ander technisch aspect is het ontwikkelen van controlepaden, die een record zijn van alle beslissingen en acties die door het AI-systeem zijn genomen. Deze paden bieden een transparante geschiedenis die door menselijke operators kunnen worden bekeken om ervoor te zorgen dat de ethische normen worden nageleefd.

Controlepaden zijn vooral belangrijk in sectoren zoals financiën en recht, waar beslissingen gedocumenteerd moeten worden en verantwoordbaar zijn om het publieke vertrouwen te handhaven en aan de regelgeving te voldoen.

Balans tussen Autonomie en Controle: Een belangrijk technisch uitdaging in menscentrische AI is het vinden van de juiste balans tussen autonomie en controle. Hoewel AI-systemen zijn ontworpen om op veel scenario’s autonoom te functioneren, is het cruciaal dat deze autonomie het menselijke controle of toezicht niet ondermijnt.

Deze balans kan worden bereikt door de implementatie van autonomie-niveaus, die het mate van onafhankelijkheid aangeven die de AI heeft bij het maken van beslissingen.

Bijvoorbeeld, in semi-autonome systemen zoals zelfrijdende auto’s, variëren de autonomie-niveaus van basisrijhulp (waarbij de menselijke bestuurder volledig in controle blijft) tot volledige automatisering (waarbij de AI verantwoordelijk is voor alle rijtaken).

Het ontwerp van deze systemen moet ervoor zorgen dat, op elk gegeven niveau van autonomie, de menselijke operator de mogelijkheid behoudt om in te grijpen en de AI over te schemaan als nodig. Dit vereist geavanceerde controleinterface en beslissingsondersteuningssystemen die mensen de mogelijkheid geven snel en effectief de controle terug te krijgen als nodig.

Verder is de ontwikkeling van ethische AI-ramen noodzakelijk voor het bepalen van de autonome acties van AI-systemen. Deze richtlijnen zijn sets van regels en richtlijnen die ingebed zijn binnen de AI en bepalen hoe deze zich moet gedragen in ethisch complexe situaties.

Bijvoorbeeld, in de gezondheidszorg, zou een ethische AI-framebuffer mogelijke regels kunnen bevatten over patiëntenemandatum, privacy en de prioriteit van behandelingen op basis van medische behoeften in plaats van financiële overwegingen.

door deze ethische beginselen direct in het beslissingsproces van de AI in te brengen, kunnen ontwikkelaars ervoor zorgen dat de autonomie van het systeem wordt uitgeoefend in een manier die overeenkomt met menselijke waarden.

Het integreren van mens-centraal georiënteerde beginselen in de AI-ontwerp is niet alleen een filosofisch ideaal maar ook een technische noodzaak. door de menselijke autonomie te versterken, zorgen voor transparantie, mogelijke controle en voorzichtig balansen tussen autonomie en controle, kunnen AI-systemen worden ontwikkeld in een manier die echt de mensheid dienstdoet.

Deze technische overwegingen zijn essentieel voor het creëren van AI die niet alleen de menselijke mogelijkheden vergroot maar ook respect en handhaven van de waarden die fundamenteel zijn aan onze samenleving.

Met de voortdurende evolutie van de AI zal de verbinding met het mens-centraal ontwerpen belangrijk zijn om ervoor te zorgen dat deze krachtige technologieën ethisch en verantwoordelijk worden gebruikt.

Hoe uiteraard AI de mensheid een voordeel biedt: verbetering van de kwaliteit van leven

Als u zich bezighoudt met de ontwikkeling van AI-systemen, is het essentieel om uw pogingen op het morele kader van utilitarisme te gronden – een filosofie die de verbetering van de algemene geluk en welzijn benadrukt.

Binnen dit kader heeft AI de potentiële om op cruciale maatschappelijke uitdagingen te antwoorden, vooral in gebieden als gezondheidszorg, onderwijs en duurzame levensstijl.

Het doel is het creëren van technologieën die de kwaliteit van leven voor iedereen significant verbeteren. Maar deze jacht op vereist complexiteiten. Utilitarisme biedt een aantrekkelijke reden AI breed in te zetten, maar het brengt ook belangrijke morele vragen aan het licht over wie profiteert en wie misschien achterblijft, vooral onder kwetsbare bevolkingsgroepen.

Om deze uitdagingen aan te gaan, hebben we een geavanceerd, technisch ingestelde aanpak nodig – één die de breedte van de maatschappelijke goedheid in balans houdt met het nodige gerechtigheid en rechtvaardigheid.

Wanneer u utilitaire beginselen toegepast aan AI, moet u uw focus leggen op het optimaliseren van resultaten in specifieke domeinen. In de gezondheidszorg, bijvoorbeeld, hebben AI-gebaseerde diagnosegereedschappen de mogelijkheid om de resultaten voor patiënten drastisch te verbeteren door middel van eerder en nauwkeuriger diagnose. Deze systemen kunnen uitgebreide gegevenssets analyseren om patronen te detecteren die menselijke praktijken misschien overkijken, waardoor toegang tot kwalitatieve zorg wordt uitgebreid, vooral in onderresurserende omgevingen.

Maar het implementeren van deze technologieën vereist een voorzichtige aanpak om bestaande ongelijkheden niet te versterken. Het data gebruik voor het trainen van AI-modellen kan significant verschillen per regio, wat de nauwkeurigheid en betrouwbaarheid van deze systemen beïnvloedt.

Deze verschillen duiden op de noodzaak van het opzetten van sterke data governance-frameworks die ervoor zorgen dat uw AI-gebaseerde gezondheidsoplossingen zowel representatief als eerlijk zijn.

In het onderwijsveld biedt de AI de mogelijkheid persoonlijke leermethoden aan. AI-systemen kunnen lesmateriaal aanpassen aan de specifieke behoeften van individuele studenten, waardoor de leerresultaten verbeterd worden. door analyse van gegevens over studentenprestaties en gedrag, kunnen AI-systemen identificeren waar een student mogelijk last van heeft en specifieke steun bieden.

Maar als u zich richt op deze voordelen, is het belangrijk om van de risico’s op de hoogte te zijn – zoals het potentieel om biases te versterken of studenten die niet aan typische leerpatronen voldoen te marginaliseren.

Het verminderen van deze risico’s vereist de integratie van fairness-mechanismen in AI-modellen, ervan uitgaande dat zij niet per ongeluk bepaalde groepen voordelen. En het behouden van de rol van de educatieve professionalen is crucial. hun deskundigheid en ervaring zijn onvervangbaar bij het maken van AI-hulpmiddelen echt effectief en ondersteunend.

Inzake de duurzame ontwikkeling van het milieu biedt de AI een aanzienlijke potentie. AI-systemen kunnen resources optimaliseren, milieuveranderingen monitoren en de impacten van klimaatverandering met ongeëvenaard precision voorschijn laten treden.

Bijvoorbeeld, kan AI vastgesteldata uit het milieu analyseren om weerspatronen te voorspellen, de energieconsumptie te optimaliseren en afval te minimaliseren – acties die bijdragen aan het welzijn van de huidige en toekomstige generaties.

Maar deze technologische vooruitgang gaat gepaard met een reeks uitdagingen, in het bijzonder betreffende de milieueffecten van de AI-systemen zelf.

De energieconsumptie nodig om grote schaal AI-systemen te laten functioneren, kan de milieuvoordelen die ze nastreven, eveneens compenseren. Daarom is het ontwikkelen van energiebesparende AI-systemen crucial om er zeker van te zijn dat hun positieve impact op de duurzaamheid niet ondermijnd wordt.

Als u AI-systemen ontwikkelt met utilitaristische doelstellingen, is het belangrijk om ook de implicaties voor sociale rechtvaardigheid in acht te nemen. Utilitarisme richt zich op het maximum van het algemeen geluk maar adresseert niet per se de verdeling van voordelen en schorsingen over verschillende maatschappelijke groepen.

Dit opent de mogelijkheid dat AI-systemen ongeveer dezelfde voorrechtgenoten een ongeproportioneerd voordeel geven, terwijl de gemarginaliseerde groepen mogelijk geen verbetering in hun omstandigheden zien.

Om dit tegen te gaan, moet uw AI-ontwikkelingsproces de beginselen van gelijkheid bergen, zodat de voordelen fair worden verdeeld en dat eventuele schorsingen worden behandeld. Dit kan bijvoorbeeld door het ontwerpen van algoritmen die specifiek gericht zijn op het verminderen van biases en het betrekken van een diverse reeks van standpunten bij het ontwikkelingsproces.

Als u werkt aan het ontwikkelen van AI-systemen die de kwaliteit van het leven verbeteren, is het essentieel om de utilitaire doelstelling van het maximale welzijn te balancen met de nodige gerechtigheid en eerlijkheid. Dit vereist een geavanceerd, technisch gegrondsonderzoek dat de bredere implicaties van de AI-implementatie in acht neemt.

door AI-systemen te ontwerpen die zowel effectief als eerlijk zijn, kunt u bijdragen aan een toekomst waarin technologische vooruitgang echt de diverse behoeften van de samenleving dient.

Implementeer beschermingen tegen potentiële schade

Bij het ontwikkelen van AI-technologieën moet u erkennen dat de inherente potentiële schade wordt geactiveerd en actief maatregelen treffen om deze risico’s te verminderen. Deze verantwoordelijkheid is diep ingebed in deontologische ethiek. Dit deel van de ethiek legt de morele verplichting om aan vastgestelde regels en morele normen te voldoen, waardoor de technologie die u creëert overeenkomt met fundamentele morele beginselen.

Het implementeren van strikte veiligheidsprotocollen is niet alleen een voorzorg maar een morele verplichting. Deze protocollen moeten een alomvattende test voor vooroordelen, transparantie in de algoritmische processen en duidelijke mechanismen voor verantwoording bevatten.

Zo’n beschermingen zijn essentieel om te voorkomen dat AI-systemen onbedoeld schade veroorzaken, of door vooroordelen in besluitvorming, door ontransparante processen of door een tekort aan toezicht.

In de praktijk vereist het implementeren van deze beschermingen een diepgaande kennis van zowel de technische als de ethische dimensies van AI.

Bias testen omvat niet alleen het identificeren en corrigeren van vooroordelen in data en algoritmen, maar ook het begrijpen van de bredere maatschappelijke implicaties van die vooroordelen. U moet ervoor zorgen dat uw AI-modellen op diverse, representatieve datasets getraind worden en regelmatig worden geëvalueerd om vooroordelen op te sporen en te corrigeren die over tijd kunnen ontstaan.

Transparantie, aan de andere kant, vereist dat AI-systemen zo ontworpen zijn dat hun besluitvormingsprocessen gemakkelijk door gebruikers en belanghebbenden worden begrepen en gekeken kunnen worden. Dit omvat het ontwikkelen van verklaarbare AI-modellen die heldere, interpretabele uitvoer bieden, zodat gebruikers zien kunnen hoe beslissingen worden genomen en ervoor zorgen dat de beslissingen rechtvaardig en eerlijk zijn.

Ook zijn accountabiliteitsmechanismen cruciaal voor het behoud van vertrouwen en het verzekeren dat AI-systemen verantwoordelijk worden gebruikt. Deze mechanismen moeten een duidelijke richtlijn bevatten voor wie verantwoordelijk is voor de resultaten van AI-beslissingen, evenals processen voor het behandelen en herstellen van eventuele schade.

U moet een framework opzetten waarin ethische overwegingen zijn ingebed in elke fase van de AI-ontwikkeling, van het beginsel design tot de implementatie en daarna. Dit omvat niet alleen het volgen van ethische richtlijnen maar ook het continu monitoren en aanpassen van AI-systemen terwijl ze interacteren met de echte wereld.

door deze veiligheidtoepassingen in de borstel van de AI-ontwikkeling in te binden, kunt u helpen verzekeren dat de technologische vooruitgang dienstdoet aan het algemeen belang zonder onverwachte negatieve gevolgen te geven.

Het belang van menselijke toezicht en terugkoppelingslussen

Menselijke toezicht op AI-systemen is een kritisch onderdeel van het waarborgen van ethische AI-toepassingen. Het principe van verantwoordelijkheid ondersteunt de noodzaak van continue menselijke deelname aan de operationele AI, vooral in high-stakes-omgevingen zoals de gezondheidszorg en het crimelijk justitieel systeem.

Terugkoppelingen, waarin menselijke invoer wordt gebruikt om AI-systemen te verfijnen en te verbeteren, zijn essentieel voor het behoud van verantwoordelijkheid en aanpasbaarheid (Raji et al., 2020). Deze terugkoppelingen bieden de mogelijkheid fouten te corrigeren en nieuwe ethische overwegingen te integreren terwijl de waarden van de maatschappij evolueren.

Door menselijk toezicht in AI-systemen in te bouwen, kunnen ontwikkelaars technologieën creëren die niet alleen effectief zijn maar ook in lijn zijn met ethische normen en menselijke verwachtingen.

Ethiek coderen: Filosofische beginselen in AI-systemen omzetten

Het omzetten van filosofische beginselen in AI-systemen is een complex maar noodzakelijk taken. Dit proces omvat het vastleggen van ethische overwegingen in het code dat de AI-algoritmen drijft.

Concepten zoals rechtvaardigheid, gerechtigheid en autonomie moeten binnen AI-systemen worden vastgelegd om er voor te zorgen dat ze zich in overeenstemming met maatschappelijke waarden gedragen. Dit vereist een multidisciplinair aanpak, waarin ethici, ingenieurs en sociale wetenschappers samenwerken om ethische richtlijnen te defineren en toe te passen in het codering proces.

Het doel is om AI-systemen te creëren die niet alleen technisch getalenteerd zijn maar ook moreel verantwoord, in staat zijn beslissingen te nemen die de menselijke waardigheid respecteren en de maatschappelijke goedheid bevorderen (Mittelstadt et al., 2016).

Behoud inclusiviteit en gelijke toegang in de ontwikkeling en toepassing van AI

Inclusiviteit en gelijke toegang zijn fundamenteel voor de ethische ontwikkeling van AI. Het Rawlsiaanse concept van rechtvaardigheid als eerlijkheid biedt een filosofische grondslag voor het verzekeren dat AI-systemen zijn ontworpen en geïmplementeerd worden in manieren die voordelen hebben voor alle leden van de samenleving, in het bijzonder voor diegenen die het meest kwetsbaar zijn (Rawls, 1971).

Dit omvat vooruitgangsinitiatives om diverse perspectieven in het ontwikkelingsproces te betrekken, in het bijzonder vanuit de ondervertegenwoordigde groepen en het Global South.

Door deze diversen kanten op te nemen, kunnen AI-ontwikkelaars systemen creëren die meer eerlijk zijn en reageren op de behoeften van een bredere gebruikersgroep. Ook is het gewichtig voor het voorkomen van de verscherping van bestaande sociale ongelijkheden, de AI-technologieën evenwichtig toegankelijk te maken.

Addresseer Algoritmische Bias en Rechtvaardigheid

Algoritmische bias is een significante ethische zorg in de ontwikkeling van AI, aangezien biaiseerde algoritmen de bestaande maatschappelijke ongelijkheden kunnen voortzetten en zelfs versterken. Om deze kwestie aan te pakken vereist een verplichting tot procesrechtvaardigheid, ervoor zorgend dat AI-systemen zijn ontwikkeld door eerlijke processen die de impact op alle belanghebbenden in acht nemen (Nissenbaum, 2001).

Dit omvat het identificeren en verminderen van bias in trainingsgegevens, het ontwikkelen van algoritmen die transparant en verklaarbaar zijn, en het uitvoeren van rechtvaardigheidscontroles doorheen het levenscyclus van AI.

Door de algoritmische bias aan te pakken, kunnen ontwikkelaars AI-systemen creëren die bijdragen aan een eerlijker en meer rechtvaardige samenleving, in plaats van bestaande verschillen te versterken.

Integreer Diverse Perspectieven in de AI-Ontwikkeling

De integratie van diverse perspectieven in de ontwikkeling van AI is essentieel voor het creëren van systemen die inclusief en gerecht zijn. Het opnemen van stemmen uit onderrepresentede groepen zorgt ervoor dat AI-technologieën niet alleen de waarden en prioriteiten reflecteren van een smal segment van de samenleving.

Dit aanpak aligneert zich met de filosofische principes van dedeliberatieve democratie, die de import van inclusieve en deelnamegebaseerde besluitvormingsprocessen benadrukt (Habermas, 1996).

Door de diverse deelname aan de AI-ontwikkeling te bevorderen, kunnen we ervoor zorgen dat deze technologieën zijn ontworpen om de belangen van de gehele mensheid dienen, in plaats van enkel die van een voorgenomen kleine groep.

Strategieën voor het Overbruggen van de AI-Kloof

De AI-Kloof, gekenmerkt door ongelijke toegang tot AI-technologieën en hun voordelen, stelt een significante uitdaging voor wereldwijde gelijkheid. Om deze kloof over te bruggen, is een verbintenis tot deelname aan deelname nodig, ervoor zorgend dat de voordelen van AI breed worden verdeeld over verschillende socio-economische groepen en regio’s (Sen, 2009).

We kunnen dit door initiaties te bevorderen die toegang tot AI-onderwijs en -resources in onderserviced gemeenschappen bevorderen, evenals door beleid dat de rechtmatige verdeling van de economische winsten die door AI worden aangedreven, ondersteund. door het adresseren van de AI-Kloof, kunnen we ervoor zorgen dat AI bijdragen aan wereldwijde ontwikkeling in een manier die inclusief en gerecht is.

Balanceer Innovatie met Ethische Beperkingen

Het evenwicht tussen de jacht op innovatie en ethische beperkingen is crucial voor verantwoordelijke AI-voortgang. Het voorbehoedsprincipe, dat voorzichtigheid aanbevelend is bij onzekerheid, is bijzonder relevant in de context van AI-ontwikkeling (Sandin, 1999).

Terwijl innovatie de vooruitgang drijft, moet ze worden afgeremd door ethische overwegingen die bescherming bieden tegen potentiële schade. Dit vereist een voorzichtige evaluatie van de risico’s en de voordelen van nieuwe AI-technologieën, evenals de implementatie van regelingskaders die de handhaving van ethische standaarden waarborgen.

Door innovatie in evenwicht te brengen met ethische beperkingen, kunnen we de ontwikkeling van AI-technologieën die vooruitgangskrachtig zijn en overeenkomen met de bredere doelstellingen van de maatschappelijke welzijnsthema’s versterken.

Zoals u kunt zien levert de filosofische grondslag van intelligentiesystemen een cruciale raamwerk voor het waarborgen dat AI-technologieën op ethische, inclusieve en voor iedereen gunstige manieren worden ontwikkeld en geïmplementeerd.

door de AI-ontwikkeling op deze filosofische beginselen te gronden, kunnen we intelligentiesystemen creëren die niet alleen de technologische capaciteiten vooruit helpen maar ook de kwaliteit van het leven vergroten, de rechtvaardigheid bevorderen en ervoor zorgen dat de voordelen van AI gelijkmatig zijn verdeeld over de hele maatschappij.

Hoofdstuk 5: AI-agenten als LLM-versterkers

Het samenvoegen van AI-agenten met Grote Taal Modelen (LLM’s) stelt een fundamentele verandering in de kunstmatige intelligentie voor, die de kritieke beperkingen in LLM’s die hun bredere toepasbaarheid hebben beperkt, aanpakt.

Deze integratie maakt het voor machines mogelijk om hun traditionele rollen over te stijgen, van passieve tekstgeneratoren tot autonome systemen die in staat zijn tot dynamische redeneringen en besluitvorming.

Met name als AI-systemen steeds meer kritische processen over heel verschillende domeinen drijven, is het verstandig om te begrijpen hoe AI-agenten de schappen in de LLM-capaciteiten vullen en daarmee hun volledige potentieel realiseren.

Knopen in de mogelijkheden van LLM’s

LLM’s zijn, hoewel krachtig, inherent beperkt door de data waarop ze zijn getraind en de statische natuur van hun architectuur. Deze modellen werken binnen een vast geheel van parameters, meestal gedefinieerd door de tekstcorpus die werd gebruikt tijdens hun trainingsfase.

Deze beperking betekent dat LLM’s niet autonomie kunnen zoeken in nieuwe informatie of hun kennisbank bijwerken na hun trainingsfase. consequentie hiervan is dat LLM’s vaak verouderd zijn en de mogelijkheid ontberen om contextueel relevante reacties te leveren die realtime data of inzichten vereisen die buiten hun oorspronkelijke trainingsgegevens liggen.

AI-agenten overbruggen deze knoop door dynamisch geïntegreerde externe databronnen, die de functionele horizon van LLM’s kunnen uitbreiden.

Bijvoorbeeld, een LLM die tot 2022 op financiële gegevens is getraind, kan accurate historische analyses leveren maar zal moeite doen om actuele marktvoorspellingen te genereren. Een AI-agent kan deze LLM versterken door in realtime financiële marktdata aan te trekken en deze inpakten toe te passen om relevantere en actuele analyses te genereren.

Deze dynamische integratie zorgt ervoor dat de uitvoer niet alleen historisch correct is maar ook contextueel geschikt is voor de huidige omstandigheden.

Autonoom besluitvorming versterken

Een andere significante beperking van LLM’s is hun ontbrekende autonomie bij besluitvorming. LLM’s zijn goed in het genereren van taalgebonden uitvoer maar niet in taken die complexe besluitvorming vereisen, vooral in omgevingen die gekenmerkt zijn door onzekerheid en verandering.

Deze tekortkoming is voornamelijk het gevolg van de afhankelijkheid van bestaande data van het model en het ontbreken van mechanismen voor aanpassende redenering of leren van nieuwe ervaringen na implementatie.

AI-agenten beantwoorden hiertoe door de noodzakelijke infrastructure voor autonome beslissingen aan te bieden. Ze kunnen de statische uitvoer van een LLM nemen en deze verwerken via geavanceerde redenering framework zoals regelgebaseerde systemen, heuristieken of geÏnstalleerde leer modellen.

Bijvoorbeeld, in een gezondheidszorg omgeving, zou een LLM een lijst van mogelijke diagnose’s genereren op basis van de klachten en medische geschiedenis van een patient. Maar zonder een AI-agent kan de LLM deze opties niet wegen of een richtlijn voor actie aanbevelen.

Een AI-agent kan deze diagnose’s evalueren aan de hand van de huidige medische literatuur, patientgegevens en contextuele factoren, uiteindelijk een meer ingedeeld besluit nemen en suggesties voor actiebare volgende stappen aanbieden. Deze synergie verandert de LLM-uitvoer van enkel suggesties in uitvoerbare, context-gevoelige besluiten.

Aanvullend en consistentie behandelen

Volledigheid en consistentie zijn kritieke factoren voor het verzekeren van de betrouwbaarheid van LLM-uitvoer, vooral bij complexe redenering taken. Door hun parameteriseerde aard genereren LLM’s vaak antwoorden die of onvolledig zijn of geen logische coherente structuur bevatten, vooral bij het behandelen van meerstapsprocessen of vereiste voor een alomvattende verstandigheid over diverse domeinen.

Deze problemen zijn het gevolg van de afgesloten omgeving waarin LLM’s operationeel zijn, waar ze niet in staat zijn om hun uitvoer te vergelijken of te valideren tegen externe normen of aanvullende informatie.

AI-agenten spelen een cruciale rol in het verminderen van deze problemen door middel van iteratieve terugkoppelingmechanismen en validatierollen.

Bijvoorbeeld, in het rechtsgebied, zou een LLM misschien een eerste versie van een rechtsgrondslag op basis van zijn trainingsdata samenstellen. Maar dit voorstel kan bepaalde voorbeelden overschrijden of de argumenten niet logisch structuren.

Een AI-agent kan deze voorstel controleren, en zorgen dat het de vereiste standaard van compleetheid meet door te kruisen met externe rechtsdatabanken, controleren op logische consistentie, en extra informatie of duiding aanvragen indien nodig.

Dit iteratieve proces maakt het mogelijk om een robuuster en betrouwbaarder document te produceren dat aan de stringente vereisten van de rechtspraktijk voldoet.

Overwinnen van isolatie door integratie

Een van de diepste beperkingen van LLMs is hun ingebouwde isolatie van andere systemen en kennisbronnen.

LLMs, zoals ze zijn ontworpen, zijn gesloten systemen die niet van nature interactie bieden met externe omgevingen of databanken. Deze isolatie beperkt significant hun vermogen om zich aan nieuwe informatie aan te passen of in real-time operationeel te zijn, wat hen minder effectief maakt in toepassingen die dynamische interactie of real-time beslissingen vereisen.

AI-agenten overwinnen deze isolatie door als integratieve platforms te fungeren die LLMs verbinden met een breder systeem van gegevensbronnen en computatieleertools. Door middel van API’s en andere integratiekaders kunnen AI-agenten toegang krijgen tot real-time gegevens, samenwerken met andere AI-systemen, en zelfs communiceren met fysieke apparaten.

Bijvoorbeeld, in klantenserviceapplicaties kan een LLM standaardreacties genereren op basis van voorgeprogrammeerde scripts. Maar deze reacties kunnen statisch zijn en het benodigde personaliseren voor effectieve klantengagement ontbreken.

Een AI-agent kan deze interacties verrijken door realtime data van klantprofielen, vorige interacties en sentimentanalysegereedschappen te integreren, wat helpt om reacties te genereren die niet alleen contextueel relevant zijn, maar ook speciaal aangepast zijn aan de specifieke behoeften van de klant.

Deze integratie verandert de klantbeleving van een reeks van gescriptte interacties in een dynamische, persoonlijke conversatie.

Vervolgens vergroten Creativiteit en Probleemoplossing

Alhoewel LLMs krachtige tool zijn voor contentgeneratie, zijn hun creativiteit en probleemoplossingsvaardigheden inherent beperkt door de data waarop ze zijn getraind. Deze modellen kunnen vaak niet theoretische concepten toepassen op nieuwe of onverwachte uitdagingen, aangezien hun probleemoplossingscapabilities zijn beperkt tot hun bestaande kennis en trainingsparameters.

AI-agenten vergroten de creatieve en probleemoplossings potentie van LLMs door geavanceerde redeneertechnieken en een bredere reeks van analytische tools te gebruiken. Deze mogelijkheid laat AI-agenten de beperkingen van LLMs overschrijden, theoretische richtlijnen op praktische problemen toe te passen in innovatieve manieren.

Bijvoorbeeld, denk aan het probleem van het bestrijden van misinformatie op sociale mediasites. Een LLM kan patronen van misinformatie herkennen op basis van taalanalyses, maar het zou kunnen tegenhouden om een alomvattende strategie te ontwikkelen voor het verminderen van de verspreiding van onware informatie.

Een AI-agent kan deze inzichten nemen, interdisciplinair theorieën toepassen uit velden zoals sociologie, psychologie en networtheorie, en een robuust, veelzijdig aanpak ontwikkelen die rechtstreeks monitoren, gebruikersonderwijs en geautomatiseerde moderatie technieken omvat.

Deze mogelijkheid om diverse theorieën samen te vatten en hen toe te passen op praktische wereldproblemen illustreert de verbeterde problemenlossecapabilities die AI-agenten brengen aan tafel.

Meer specifieke Voorbeelden

AI-agenten, met hun vermogen om met diverse systemen te interacteren, realtime gegevens toe te kennen en acties uit te voeren, nemen deze beperkingen direct op, waardoor LLMs van machtige maar passieve taalmodellen worden tot dynamische, reële wereldprobleemoplossers. Laten we enkele voorbeelden bekijken:

1. Van statische gegevens naar dynamische inzichten: LLMs mee in de loop laten

-

Het probleem: Veronderstel dat u een LLM vraagt die is getraind op voor 2023 medische onderzoek, “Wat zijn de laatste doorbraken in de behandeling van kanker?” Zijn kennis zou verouderd zijn.

-

De AI-agent oplossing: Een AI-agent kan de LLM verbinden met medische tijdschriften, wetenschappelijke databases en nieuwssfeer. Nu kan de LLM up-to-date informatie verschaffen over de laatste klinische trials, behandelopties en wetenschappelijke vondsten.

2. Van Analyse naar Actie: Automatiseren van taken op basis van inzichten van de LLM

-

Het probleem: Een LLM die sociale media monitort voor een merk, zou een stijging in negatieve sentimenten kunnen identificeren maar kan er geen actie op ondernemen.

-

De AI-agent oplossing: Een AI-agent die verbonden is met de sociale mediaaccounts van het merk en uitgerust is met vooraf goedgekeurde reacties, kan automatisch problemen aanpakken, vragen beantwoorden en zelfs complexe kwesties aan menselijke vertegenwoordigers overdragen.

3. Van eerste schema tot gepolijst product: Zorgen voor kwaliteit en nauwkeurigheid

-

Het probleem: Een LLM die een technische handleiding moet vertalen, zou mogelijk correct grammaticaal zijn maar technisch niet correcte vertalingen kunnen produceren door een gebrek aan domeinspecifieke kennis.

-

De AI Agent Oplossing: Een AI-agent kan de LLM integreren met gespecialiseerde woordenboeken, glossaries en zelfs verbinding maken met vakdeskundigen voor real-time feedback, waardoor de uiteindelijke vertaling zowel linguïstisch accuraat als technisch verantwoord is.

4. Barrières verminderen: LLM’s verbinden met de echte wereld

-

Het Probleem: Een LLM ontworpen voor slimme thuisbesturing kan moeilijkheden hebben bij het aanpassen aan de veranderende routines en voorkeuren van een gebruiker.

-

De AI Agent Oplossing: Een AI-agent kan de LLM verbinden met sensoren, slimme apparaten en gebruikerskalenders. Door gebruikersgedrag te analyseren kan de LLM leren voorkeuren te anticiperen, automatisch licht- en temperatuurinstellingen aan te passen en zelfs gepersonaliseerde muziek afspeellijsten te suggereren op basis van de tijd van de dag en gebruikersactiviteit.

5. Van imitatie naar innovatie: LLM creativiteit uitbreiden

-

Het probleem: Een LLM die is toegewezen het componeren van muziek, zou misschien stukken maken die aanmatigend klinken of een gebrek aan emotionele diepte hebben, omdat het voornamelijk op patronen in zijn trainingsgegevens rust.

-