A rápida evolução da inteligência artificial (IA) resultou em uma poderosa sinergia entre os grandes modelos de linguagem (MMLs) e os agentes da IA. Essa interação dinâmica é como se fosse a história de David e Goliato (sem a luta), onde os agêntes de IA ágeis melhoram e ampliam as capacidades dos colossais MMLs.

Este manual explorará como os agentes de IA, semelhantes a David, estão supercarregando os MMLs – nossos Goliatos modernos – para ajudar a revolucionar várias indústrias e domínios científicos.

Sumário

-

Capítulo 1: Introdução aos Agentes da IA e Modelos de Linguagem

-

Capítulo 2: A História da Inteligência Artificial e Agentes da IA

-

Capítulo 6: Projeto de Arquitetura para a Integração de Agentes AI com LLMs

A Emergência de Agentes AI em Modelos de Linguagem

Agentes AI são sistemas autônomos projetados para perceber o seu ambiente, tomar decisões e executar ações para alcançar objetivos específicos. Quando integrados com LLMs, esses agentes podem executar tarefas complexas, raciocinar sobre informações e gerar soluções inovadoras.

Essa combinação levou a avanços significativos em vários setores,从软件开发到科学研究。

Impacto Transformador em Várias Indústrias

A integração de agentes AI com LLMs teve um profundo impacto nas indústrias:

-

Desenvolvimento de Software: assistentes de programação baseados em IA, como o GitHub Copilot, têm demonstrado a capacidade de gerar até 40% do código, resultando em uma aumento impressionante de 55% na velocidade de desenvolvimento.

-

Educação: assistentes de aprendizagem baseados em IA têm mostrado potencial em reduzir o tempo médio de conclusão do curso em 27%, potencialmente revolucionando o panorama educacional.

-

Transporte: Com projeções que sugerem que 10% dos veículos serão sem condutor até 2030, agentes artificiais autônomos em carros autônomos estão prontos para transformar a indústria de transporte.

Próximo Ciclo de Descoberta Científica

Uma das aplicações mais entusiasmantes de agentes AI e LLM é na pesquisa científica:

-

Descoberta de Fármacos: Agentes AI estão acelerando o processo de descoberta de fármacos ao analisar grandes conjuntos de dados e prever candidatos de fármacos potenciais, reduzindo significativamente o tempo e o custo associados aos métodos tradicionais.

-

Física de Partículas: No Grande Colisionador de Hadrões (LHC) do CERN, agentes AI são usados para análise de dados de colisões de partículas, usando detecção de anomalias para identificar pistas promissoras que podem indicar a existência de partículas não descobertas.

-

Pesquisa Científica Geral: Os agentes AI estão aumentando o ritmo e a amplitude da descoberta científica ao analisar estudos passados, identificando ligações inesperadas e propondo experimentos novos.

A convergência de agentes de AI e de modelos de linguagem grande (LLMs) está impulsionando a inteligência artificial para uma nova era de capacidades sem precedentes. Este manual abrangente examina a interação dinâmica entre estas duas tecnologias, revelando seu potencial combinado para revolucionar as indústrias e solucionar problemas complexos.

Nós vamos rastrear a evolução da AI de suas origens até o advento de agentes autônomos e o surgimento de sofisticadas LLMs. Também exploraremos considerações éticas, que são fundamentais para o desenvolvimento responsável de AI. Isso nos ajudará a garantir que essas tecnologias estão alinhadas com nossos valores humanos e o bem-estar da sociedade.

Ao final deste manual, você terá um profundo entendimento do poder sinergético dos agentes de AI e LLMs, bem como o conhecimento e ferramentas para aproveitar esta tecnologia de ponta.

Capítulo 1: Introdução aos Agentes de AI e a Modelos de Linguagem

O que são Agentes de AI e Modelos de Linguagem Grande?

A rápida evolução da inteligência artificial (AI) trazendo uma síntese transformadora entre modelos de linguagem grandes (LLMs) e agentes de AI.

Os agentes AI são sistemas autônomos projetados para perceber seu ambiente, tomar decisões e executar ações para alcançar objetivos específicos. Eles apresentam características tais como autonomia, percepção, reatividade, raciocínio, tomada de decisões, aprendizagem e comunicação, além de orientação a objetivos.

Por outro lado, os LLMs são sistemas AI sofisticados que usam técnicas de aprendizagem profunda e conjuntos de dados extensivos para entender, gerar e prever texto humano-like.

Modelos como estes, como GPT-4, Mistral, LLama, têm exibido capacidades notáveis em tarefas de processamento de linguagem natural, incluindo geração de texto, tradução de linguagem e agentes conversacionais.

Características Chave dos Agentes AI

Os agentes AI têm várias características definitivas que os distinguem de softwares tradicionais:

-

Autonomia: Podem operar independentemente sem intervenção humana constante.

-

Percepção: Os agentes podem sentir e interpretar seu ambiente através de várias entradas.

-

Reatividade: Eles respondem dinamicamente a mudanças em seu ambiente.

-

Pensamento e Tomada de Decisão: Agentes podem analisar dados e tomar escolhas informadas.

-

Aprendizado: Eles melhoram sua performance ao longo do tempo através da experiência.

-

Comunicação: Agentes podem interagir com outros agentes ou humanos usando diferentes métodos.

-

Orientação a Objetivos: Eles são projetados para alcançar objetivos específicos.

Capacidades dos Modelos de Linguagem Grande

Modelos de Linguagem Grande (LLMs) têm demonstrado uma ampla variedade de capacidades, incluindo:

-

Geração de Texto: LLMs podem produzir texto coerente e relevante contextualmente com base em prompts.

-

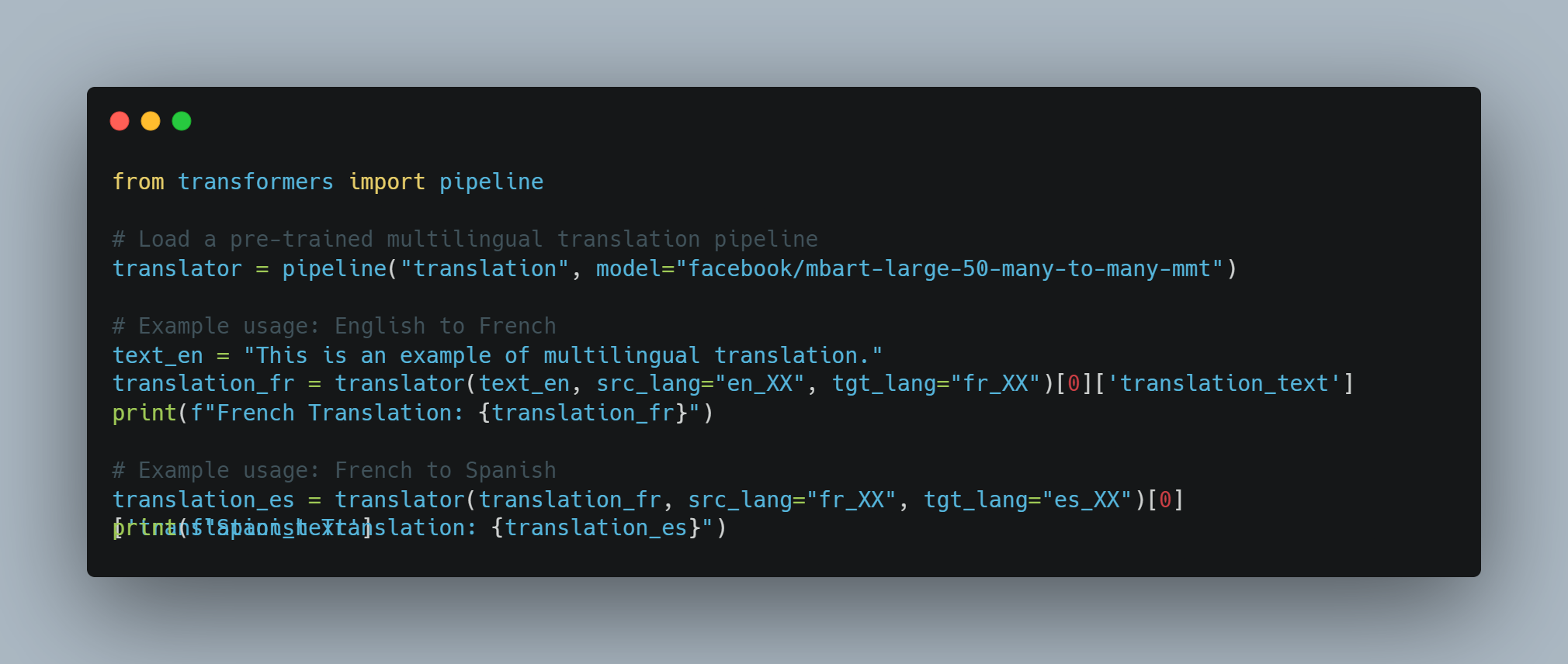

Tradução de Linguagem: Eles podem traduzir texto entre diferentes linguagens com alta precisão.

-

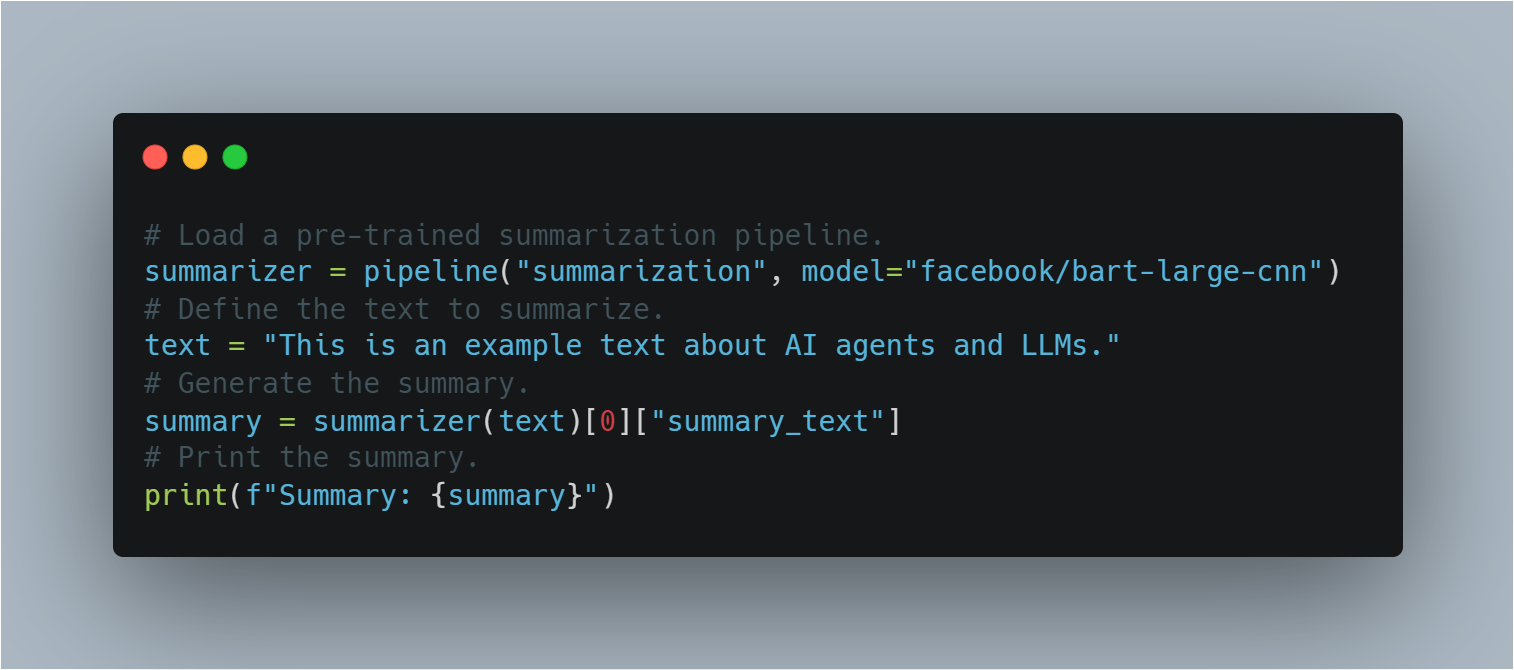

Resumo

: LLMs podem condensar textos longos em resumos concisos enquanto retêm informações chave.

- Perguntas e Respostas: Eles podem fornecer respostas precisas a perguntas com base em seu vasto banco de conhecimento.

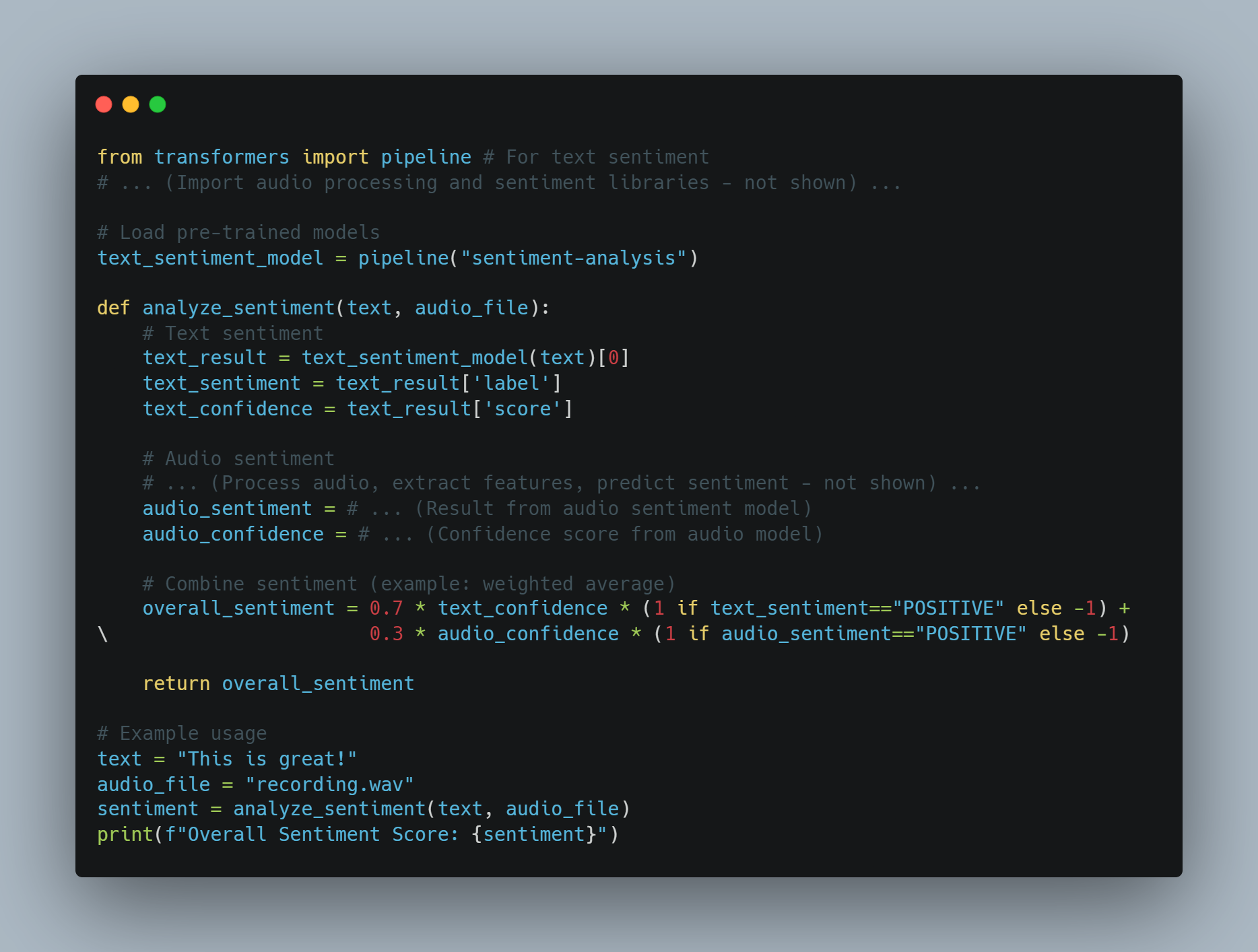

- Análise de Sentimento: LLMs podem analisar e determinar o sentimento expresso em um texto dado.

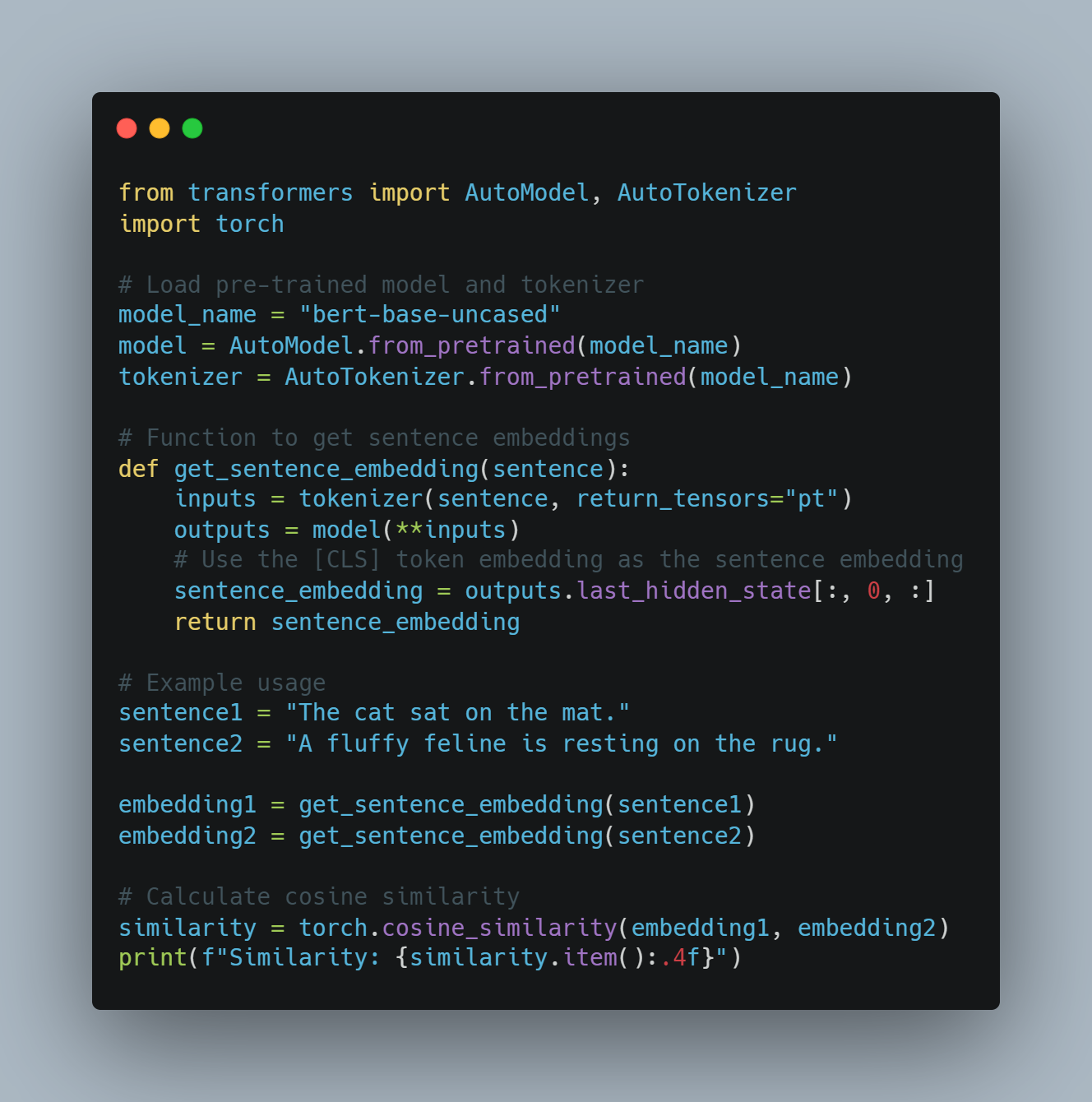

- Geração de Código: Eles podem gerar trechos de código ou funções inteiras com base nas descrições em linguagem natural.

Níveis de Agentes AI

Agentes AI podem ser classificados em diferentes níveis com base em suas capacidades e complexidade. De acordo com um artigo no arXiv, os agentes AI são categorizados em cinco níveis:

- Nível 1 (L1): Agentes AI como assistentes de pesquisa, onde cientistas definem hipóteses e especificam tarefas para alcançar objetivos.

-

Nível 2 (L2): Agentes AI que podem realizar tarefas específicas de forma autônoma dentro de um escopo definido, como análise de dados ou tomada de decisões simples.

-

Nível 3 (L3): Agentes AI capazes de aprender com a experiência e adaptar-se a novas situações, melhorando seus processos de tomada de decisão.

-

Nível 4 (L4): Agentes AI com capacidades de raciocínio avançado e resolução de problemas, capazes de lidar com tarefas complexas, multi-passos.

-

Nível 5 (L5): Agentes AI totalmente autônomos que podem operar independentemente em ambientes dinâmicos, tomando decisões e tomando ações sem intervenção humana.

Limitações dos Modelos de Linguagem de Grande Escala

Custos de Treinamento e Constraints de Recursos

Modelos de linguagem de grande escala (LLMs), como GPT-3 e PaLM, revolucionaram o processamento de linguagem natural (NLP) através da utilização de técnicas de aprendizagem profunda e de vastos conjuntos de dados.

Mas essas melhorias chegam com um custo significativo. O treinamento de LLMs requer recursos computacionais substanciais, muitas vezes envolvendo milhares de GPUs e consumo de energia extensivo.

De acordo com Sam Altman, CEO da OpenAI, o custo de treinamento para GPT-4 ultrapassou 100 milhões de dólares. Isto corresponde com o tamanho e complexidade do modelo relatados, com estimativas sugerindo que ele tem cerca de 1 trilhão de parâmetros. No entanto, outras fontes oferecem números diferentes:

-

Um relatório divulgado indicou que o custo de treinamento de GPT-4 era de aproximadamente 63 milhões de dólares, considerando a potência computacional e a duração do treinamento.

-

Ao meio de 2023, algumas estimativas sugeriram que treinar um modelo semelhante a GPT-4 poderia custar cerca de 20 milhões de dólares e levar cerca de 55 dias, refletindo avanços na eficiência.

Esse alto custo de treinamento e manutenção de LLMs limita sua adoção generalizada e escalabilidade.

Limitações de Dados e Viés

O desempenho de LLMs depende fortemente da qualidade e diversidade dos dados de treinamento. Apesar de serem treinados em conjuntos de dados massivos, LLMs ainda podem apresentar viéses presentes nos dados, levando a saídas distorcidas ou inadequadas. Esses viéses podem manifestar-se em várias formas, incluindo viéses de gênero, racial e cultural, que podem perpetuar estereótipos e desinformação.

Além disso, a natureza estática dos dados de treinamento significa que LLMs podem não estar atualizados com as informações mais recentes, limitando sua efetividade em ambientes dinâmicos.

Especialização e Complexidade

Embora LLMs sejam excelentes em tarefas gerais, eles muitas vezes têm dificuldade com tarefas especializadas que requerem conhecimento específico de domínio e alta complexidade.

Por exemplo, tarefas em campos como medicina, direito e pesquisa científica demandam um entendimento profundo de terminologia especializada e raciocínio sutil, o que LLMs podem não possuir inherentemente. Essa limitação necessita da integração de camadas adicionais de expertise e ajustes finos para tornar LLMs efetivos em aplicações especializadas.

Limitações de Entrada e Sensoriais

Processadores de linguagem natural (PLN)primariamente processam entradas textuais, o que limita sua capacidade de interagir com o mundo de modo multimodal. Embora possam gerar e entender texto, eles não têm a capacidade de processar entradas visuais, auditivas ou sensoriais diretamente.

Essa limitação impede sua aplicação em campos que exigem integração sensorial abrangente, como robótica e sistemas autônomos. Por exemplo, um PLN não pode interpretar dados visuais de uma câmera ou dados auditivos the de um microfone sem camadas de processamento adicionais.

Constraints de Comunicação e Interação

As capacidades de comunicação atuais de PLN são predominantemente baseadas em texto, o que limita sua capacidade de se envolver em formas de comunicação mais imersivas e interativas.

Por exemplo, embora PLN possam gerar respostas textuais, eles não podem produzir conteúdo de vídeo ou representações holográficas, que são cada vez mais importantes em aplicações de realidade virtual e aumentada (leia mais aqui). essa limitação reduce a eficácia de PLN em ambientes que exigem interações multimodais rica.

Como superar Limitações com Agentes AI

Agentes AI oferecem soluções promissoras para muitas das limitações enfrentadas por PLN. Esses agentes são projetados para operar de forma autônoma, perceber seu ambiente, tomar decisões e executar ações para alcançar objetivos específicos. Integrando agentes AI com PLN é possível melhorar suas capacidades e abordar suas limitações inatas.

-

Enhanced Context and Memory: Os agentes AI podem manter o contexto em várias interações, permitindo respostas mais coherentes e relevantes no contexto. Esta capacidade é particularmente útil em aplicações que requerem memória de longo prazo e contínua, como atendimento ao cliente e assistentes pessoais.

-

Integração Multimodal: Os agentes AI podem incorporar entradas sensoriais de várias fontes, como câmeras, microfones e sensores, permitindo que LLMs processem e respondam a dados visuais, auditivos e sensoriais. Esta integração é crucial para aplicações em robôs e sistemas autônomos.

-

Conhecimento Especializado e Competência: Os agentes AI podem ser finamente ajustados com conhecimento específico do domínio, melhorando a capacidade dos MLs de realizar tarefas especializadas. Este método permite a criação de sistemas de peritos que podem lidar com consultas complexas em campos como medicina, direito e pesquisa científica.

-

Comunicação Interativa e Imersiva: Os agentes AI podem facilitar formas mais imersivas de comunicação gerando conteúdo de vídeo, controlando exibições holográficas e interagindo com ambientes virtuais e de realidade aumentada. Esta capacidade expande a aplicação dos MLs em campos que exigem interações rica e multimodais.

Embora modelos de linguagem grandes tenham demonstrado capacidades notáveis em processamento de linguagem natural, eles não estão sem limitações. Os altos custos de treinamento, biases de dados, desafios de especialização, limitações sensoriais e constrangimentos de comunicação representam grandes obstáculos.

Mas a integração de agentes artificiais inteligentes oferece um caminho viável para superar essas limitações. Ao aproveitar as vantagens dos agentes artificiais inteligentes, é possível melhorar a funcionalidade, adaptabilidade e aplicabilidade de LLMs, abrindo caminho para sistemas AI mais avançados e versáteis.

Capítulo 2: A História da Inteligência Artificial e Agentes AI

O surgimento da Inteligência Artificial

O conceito de inteligência artificial (IA) tem raízes que se estendem muito além da idade digital moderna. A ideia de criar máquinas capazes de raciocínio semelhante a humanos pode ser rastreada até mitos antigos e debates filosóficos. Mas a formalização da IA como uma disciplina científica ocorreu no meio do século XX.

A Conferência de Dartmouth de 1956, organizada por John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon, é amplamente considerada o berço da inteligência artificial (IA) como um campo de estudo. Este evento seminal reuniu investigadores líderes para explorar o potencial de criar máquinas que pudessem simular a inteligência humana.

Otimismo Inicial e o Inverno da IA

Os primeiros anos da pesquisa em IA foram caracterizados por optimismo sem restrições. Investigadores fizeram progressos significativos na develop programs capable of solving mathematical problems, playing games, and even engaging in rudimentary natural language processing.

Mas este entusiasmo inicial foi abafado pela compreensão de que criar verdadeiramente inteligentes era muito mais complexo do que inicialmente antecipado.

A década de 1970 e 1980 assistiram a um período de financiamento reduzido e interesse na pesquisa de IA, comumente referido como o “Inverno da IA“. Essa decadência principalmente decorreu do fracasso dos sistemas da IA para atingir as expectativas altas estabelecidas pelos pioneiros iniciais.

De Sistemas Baseados em Regras para Aprendizagem Automática

A Era dos Sistemas Expertos

Os anos 1980 testemunharam um ressurgimento de interesse em AI, principalmente driven by the development of expert systems. These rule-based programs were designed to emulate the decision-making processes of human experts in specific domains.

Sistemas expertos encontraram aplicações em vários campos, incluindo medicina, finanças e engenharia. Mas eles foram limitados pela sua incapacidade de aprender a partir da experiência ou adaptar-se a situações novas fora das regras programadas.

O surgimento do Aprendizado de Máquina

As limitações dos sistemas baseados em regras abriram caminho para uma mudança de paradigma para o aprendizado de máquina. Este método, que ganhou relevância nos anos 90 e 2000, se concentra na desenvolvimento de algoritmos que podem aprender a partir de dados e fazer previsões ou decisões baseadas em dados.

Técnicas de aprendizado de máquina, como redes neurais e máquinas de suporte vetorial, mostraram um sucesso notável em tarefas como reconhecimento de padrões e classificação de dados. O advento de big data e a potência computacional aumentada进一步加速了开发和应用机器学习算法。

A Emergência deAgentes AI Autônomas

Do AI Especializado para AI Geral

Ao evoluir as tecnologias de AI, os investigadores começaram a explorar a possibilidade de criar sistemas mais versáteis e autônomos. Este movimento marcou a transição do AI especializado, projetado para tarefas específicas, para a busca de inteligência artificial generalizada (AGI).

AGI tem como objetivo desenvolver sistemas capazes de realizar qualquer tarefa intelectual que um humano puder fazer. Enquanto o AGI verdadeiro permanece um objetivo distante, progressos significativos foram feitos na criação de sistemas AI mais flexíveis e adaptáveis.

O papel de aprendizagem profunda e redes neurais

O surgimento de aprendizagem profunda, um subconjunto de aprendizagem automática baseado em redes neurais artificiais, tem sido instrumental na avançada do campo de AI.

Algoritmos de aprendizagem profunda, inspirados na estrutura e função do cérebro humano, têm demonstrado capacidades notáveis em áreas como reconhecimento de imagem e fala, processamento de linguagem natural, e jogos. Esses avanços têm sido o ponto de partida para o desenvolvimento de agentes AI autônomos mais sofisticados.

Características e tipos de agentes AI

Agentes AI são sistemas autônomos que conseguem perceber seu ambiente, tomar decisões e executar ações para alcançar objetivos específicos. Possuem características tais como autonomia, percepção, reatividade, raciocínio, decisão, aprendizagem, comunicação e orientação a objetivos.

Existem vários tipos de agentes AI, cada um com capacidades únicas:

-

Agentes de Reflexo Simples: respondem a estímulos específicos com base em regras predefinidas.

-

Agentes Reflexivos Baseados em Modelo: Manterão um modelo interno do ambiente para toma de decisões.

-

Agentes Baseados em Meta-objetivos: Executarão ações para alcançar meta-objetivos específicos.

-

Agentes Baseados em Utilidade: Considerarão resultados potenciais e escolherão ações que maximizam a utilidade esperada.

-

Agentes Aprendiz: Melhorarão a toma de decisões ao longo do tempo através de técnicas de aprendizagem automática.

Desafios e Considerações Éticas

Como os sistemas AI tornam-se cada vez mais avançados e autônomos, trazem considerações críticas para garantir que seu uso permaneça dentro dos limites aceitáveis pela sociedade.

Modelos de Linguagem Grande (LLMs), particularmente, atuam como super-aceleradores de produtividade. Mas isso levanta uma questão crucial: O que esses sistemas super-acelerarão – intenção boa ou má? Quando a intenção para o uso de AI é malévola, torna-se imprescindível que esses sistemas detectem tais abusos usando diferentes técnicas de PRL ou outras ferramentas disponíveis.

Engenheiros de LLM têm acesso a uma variedade de ferramentas e abordagens para abordar estes desafios:

-

Análise de Sentimento: Ao aplicar análise de sentimento, LLMs podem avaliar o tom emocional do texto para detectar linguagem prejudicial ou agressiva, ajudando a identificar potencial uso indevido em plataformas de comunicação.

-

Filtragem de Conteúdo: Ferramentas como filtragem por palavra-chave e correspondência de padrões podem ser usadas para evitar a geração ou divulgação de conteúdo prejudicial, como discurso de ódio, desinformação ou material explícito.

-

Ferramentas de Detecção de Bias: Ao implementar frameworks de detecção de viés, como AI Fairness 360 (IBM) ou Indicadores de Equidade (Google), pode ajudar a identificar e mitigar o viés em modelos de linguagem, garantindo que os sistemas AI operam de forma justa e equitativa.

-

Técnicas de Explicabilidade

: Usando ferramentas de explicabilidade como LIME (Local Interpretable Model-agnostic Explanations) ou SHAP (SHapley Additive exPlanations), engenheiros podem entender e explicar os processos de tomada de decisão de LLMs, tornando mais fácil detetar e corrigir comportamentos não intencionais.

-

Testes Adversários: Simulando ataques maliciosos ou entradas prejudiciais, engenheiros podem testar a resistência dos LLMs usando ferramentas como TextAttack ou Adversarial Robustness Toolbox, identificando vulnerabilidades que podem ser exploradas para fins maliciosos.

-

Guidelines e Frameworks Éticos de AI: Adotando guias de desenvolvimento ético de AI, como as fornecidas pela IEEE ou a Partnership on AI, os engenheiros podem orientar a criação de sistemas AI responsáveis que priorizam o bem-estar da sociedade.

Além destas ferramentas, é por isso que precisamos de uma Equipe Vermelha dedicada para AI — times especializados que impulsionam LLMs às suas limitações para detectar falhas em suas defesas. Equipes Vermelhas simulam cenários adversários e descobrem vulnerabilidades que poderiam passar despercebidas.

Mas é importante reconhecer que as pessoas por trás do produto têm o maior efeito sobre ele. Muitos dos ataques e desafios que enfrentamos hoje existiam mesmo antes de LLMs serem desenvolvidos, destacando que o elemento humano permanece central para garantir que AI é usado ética e responsavelmente.

A integração destas ferramentas e técnicas na pipeline de desenvolvimento, juntamente com uma vigilante Equipe Vermelha, é fundamental para garantir que LLMs são usadas para supercarregar resultados positivos enquanto detecta e previne seu abuso.

Capítulo 3: Onde os Agentes AI Brilham mais Forte

As Forças únicas dos Agentes AI

Agentes AI se destacam por sua capacidade de perceber autonomamente o seu ambiente, tomar decisões e executar ações para alcançar objetivos específicos. Esta autonomia, combinada com capacidades avançadas de aprendizado de máquina, permite que agentes AI realizem tarefas que são ou demasiado complexas ou demasiado reprodutivas para serem executadas por humanos.

Aqui estão as principais vantagens que fazem os agentes AI brilharem:

-

Autonomia e Eficiência: Os agentes AI podem operar independentemente sem intervenção humana constante. Esta autonomia permite que eles gerem tarefas 24/7, melhorando significativamente a eficiência e a produtividade. Por exemplo, bots de chat com inteligência artificial podem atender até 80% das consultas de clientes rotineiras, reduzindo custos operacionais e melhorando o tempo de resposta.

-

Tomada de Decisões Avançadas: Os agentes AI podem analisar vastos quantos dados para tomar decisões informadas. Essa capacidade é particularmente valiosa em campos como a finança, onde bots de negociação AI podem aumentar a eficiência de negociações muito.

-

Aprendizagem e Adaptação: Agentes de AI podem aprender com a experiência e adaptar-se a novas situações. Essa melhoria contínua permite que eles melhorem seu desempenho ao longo do tempo. Por exemplo, assistentes de saúde AI podem ajudar a reduzir erros de diagnóstico, melhorando os resultados de cuidados de saúde.

-

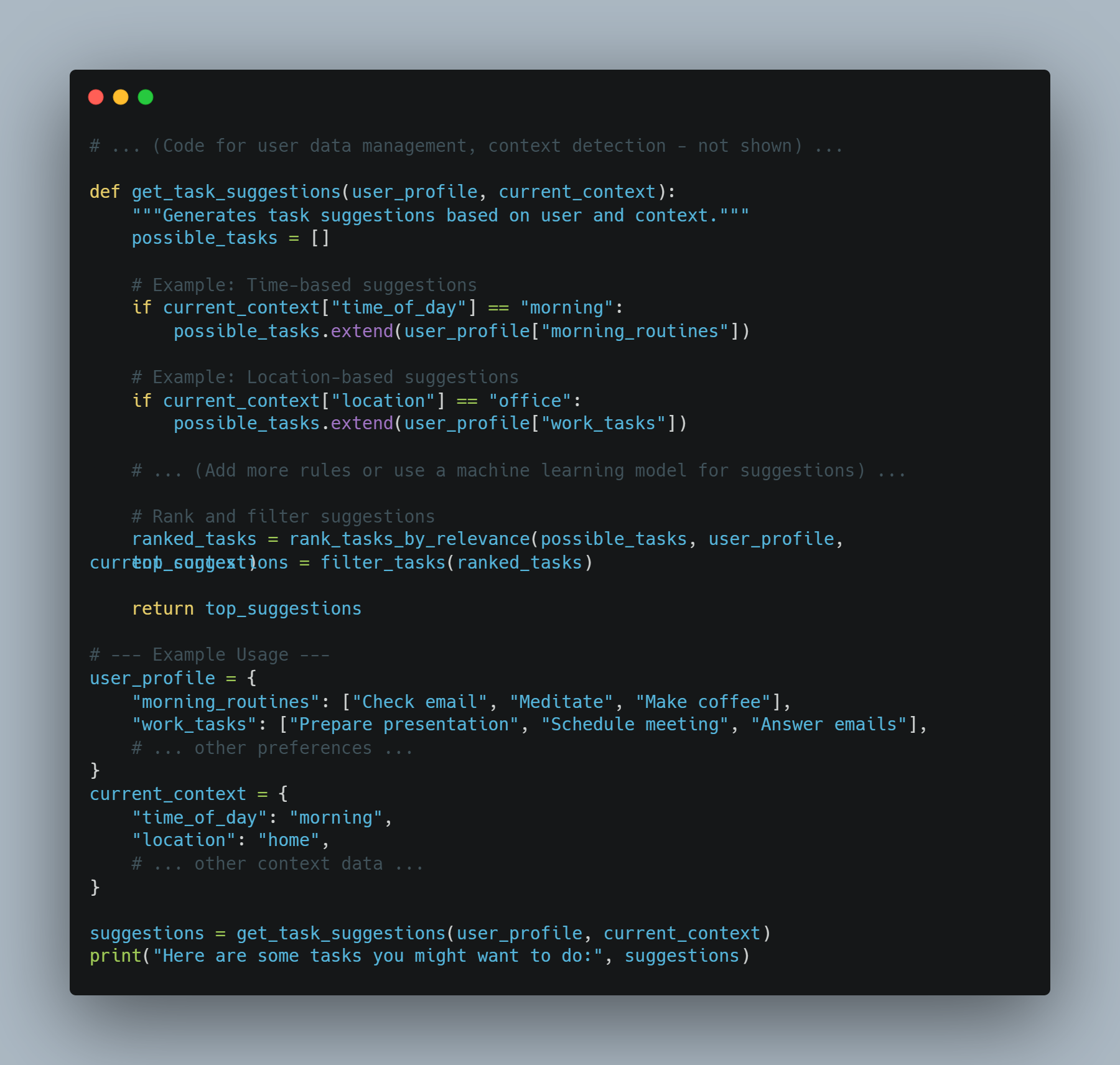

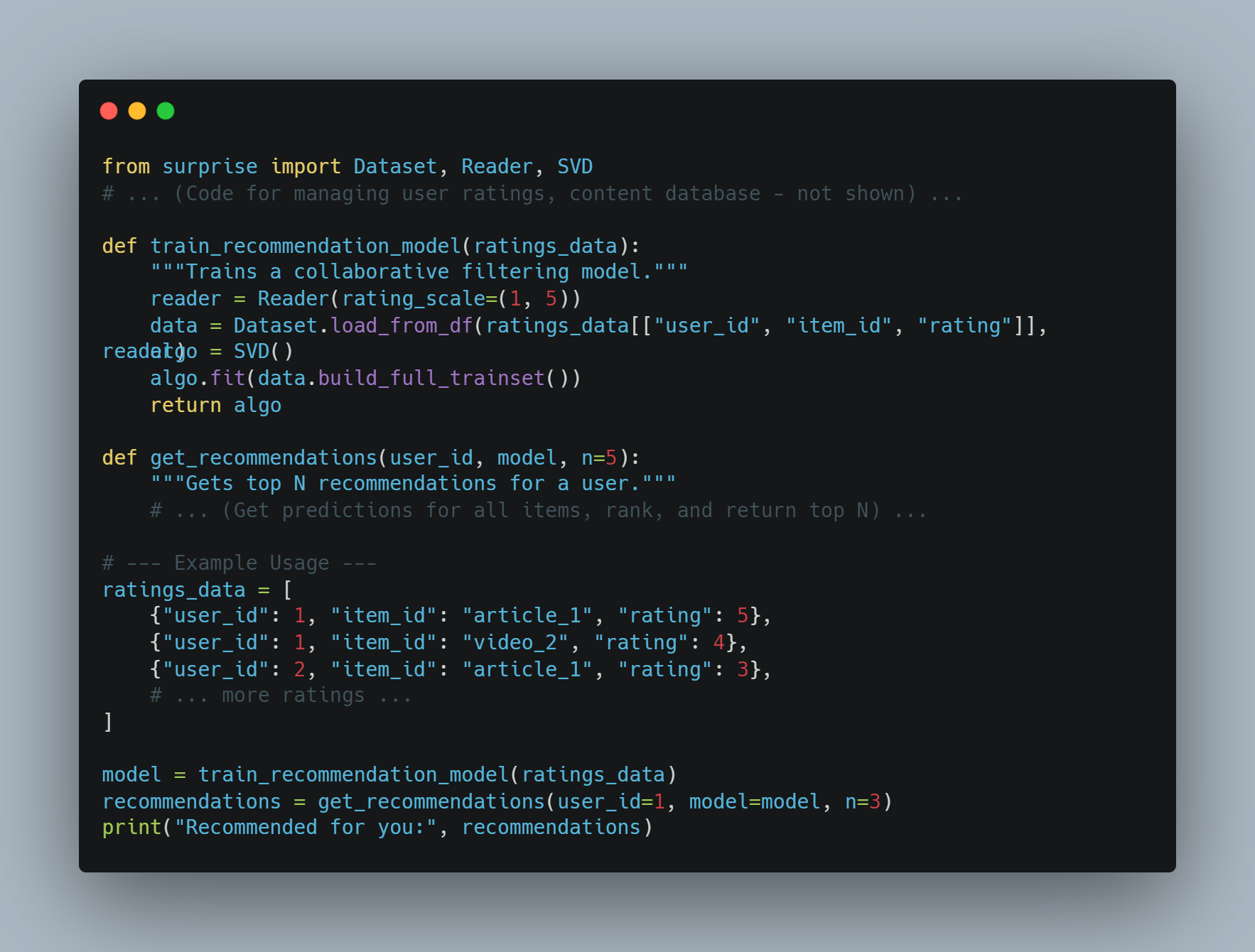

Personalização: Agentes de AI podem fornecer experiências personalizadas analisando o comportamento e preferências dos usuários. O motor de recomendação da Amazon, que move 35% de suas vendas, é um exemplo primário de como agentes de AI podem melhorar a experiência do usuário e aumentar os rendimentos.

Por que os Agentes de AI são a Solução

Os agentes de inteligência artificial oferecem soluções para muitos dos desafios enfrentados por software tradicional e sistemas operados por humanos. Aqui está por que eles são a escolha preferida:

-

Escalabilidade: Agentes de inteligência artificial podem escalar operações sem aumentos proporcionais em custos. Esta escalabilidade é crucial para empresas que procuram crescer sem aumentar significativamente sua força de trabalho ou despesas operacionais.

-

Consistência e Confiabilidade: Diferentemente de humanos, agentes de inteligência artificial não sofrem de fatiga ou inconsistência. Eles podem executar tarefas repetitivas com alta precisão e confiabilidade, garantindo desempenho consistente.

-

Informações Driven por Dados: Agentes de inteligência artificial podem processar e analisar grandes conjuntos de dados para descobrir padrões e insights que podem ser perdidos por humanos. Essa capacidade é valiosa para tomar decisões em áreas como finanças, saúde e marketing.

-

Poupança em Custos: Autorizando tarefas rotineiras, os agentes AI podem reduzir a necessidade de recursos humanos, levando a poupanças consideráveis em custos. Por exemplo, sistemas de detecção de fraude funcionando com AI podem poupar milhares de milhões de dólares por ano, reduzindo as atividades fraudulentas.

Condições Necessárias para que os Agentes AI Exijam Bem

Para garantir o bom desempenho e a implantação bem-sucedida dos agentes AI, devem ser atendidas certas condições:

-

Objetivos e Casos de Uso Claros: A definição de objetivos específicos e casos de uso é crucial para o deploy bem-sucedido de agentes AI. Esta clareza ajuda a definir expectativas e medir o sucesso. Por exemplo, estabelecer um objetivo de reduzir o tempo de resposta do atendimento ao cliente em 50% pode guiar a implantação de chatbots de AI.

-

Qualidade dos Dados: Os agentes AI dependem de dados de alta qualidade para treinamento e operação. Assegurar que os dados são precisos, relevantes e atualizados é essencial para os agentes tomar decisões informadas e executarem de forma eficaz.

-

Integração com Sistemas Existentes: Uma integração sem problemas com sistemas existentes e fluxos de trabalho é necessária para que os agentes AI funcionem de forma ótima. Esta integração garante que os agentes AI possam acessar os dados necessários e interagir com outros sistemas para executar suas tarefas.

-

Monitoramento Contínuo e Otimização: O monitoramento contínuo e a otimização dos agentes AI são cruciais para manter sua performance. Isto envolve acompanhar indicadores de desempenho chave (KPIs) e fazer ajustes necessários com base em feedback e dados de desempenho.

-

Considerações Éticas e Mitigação de Viés: Abordar considerações éticas e mitigar vieses em agentes de IA é essencial para garantir equidade e inclusão. Implementar medidas para detectar e prevenir viés pode ajudar a construir confiança e garantir uma implementação responsável.

Melhores Práticas para Implantar Agentes de IA

Ao implantar agentes de IA, seguir melhores práticas pode garantir seu sucesso e eficácia:

-

Definir Objetivos e Casos de Uso: Identificar claramente os objetivos e casos de uso para implantar agentes de IA. Isso ajuda a definir expectativas e medir o sucesso.

-

Selecione a Plataforma de IA Correta: Escolha uma plataforma de IA que esteja alinhada com seus objetivos, casos de uso e infraestrutura existente. Considere fatores como capacidades de integração, escalabilidade e custo.

-

Desenvolva uma Base de Conhecimento Abrangente: Construa uma base de conhecimento bem estruturada e precisa para permitir que os agentes de IA forneçam respostas relevantes e confiáveis.

-

Garanta Integração Sem Interrupções: Integre agentes de IA com sistemas existentes como CRM e tecnologias de call center para fornecer uma experiência unificada ao cliente.

-

Treine e Otimize os Agentes de IA: Treine e otimize continuamente os agentes de IA usando dados das interações. Monitore o desempenho, identifique áreas de melhoria e atualize os modelos conforme necessário.

-

Implementar Procedimentos de Escaleamento Apropriado: Estabelecer protocolos para transferir chamadas complexas ou emocionais para agentes humanos, garantindo uma transição smooth e uma resolução eficiente.

-

Monitorar e Análizar Desempenho: Rastrear indicadores de desempenho chave (KPIs) como taxas de resolução de chamadas, tempo médio de atendimento e pontuações de satiedade do cliente. Usar ferramentas de análise para insights de decisão baseados em dados.

-

Garantir Privacidade e Segurança de Dados: medidas de segurança robustas são chaves, como tornar os dados anônimos, garantir supervisão humana, estabelecer políticas para retenção de dados e implementar medidas de criptografia fortes para proteger dados do cliente e manter a privacidade.

Agentes AI + LLMs: Um Novo Século de Software Inteligente

Imagine um software que não só entende suas solicitações como também as executa. Essa é a promessa de combinar agentes AI com Modelos de Linguagem Grande (LLMs). Essa poderosa parceria está criando uma nova geração de aplicações que é mais intuitiva, capaz e impactante do que nunca antes.

Agentes AI: Mais Além da Execução de Tarefas Simples

Enquanto frequentemente comparados a assistentes digitais, os agentes AI são muito mais do que seguidores de scripts glorificados. Eles abrangem uma gama de tecnologias sofisticadas e operam em um quadro que permite tomar decisões dinâmicas e tomar ações.

-

Arquitetura: Um agente AI típico compõe vários componentes chave:

-

Sensores: Estes permitem que o agente perceba seu ambiente, coletando dados de várias fontes, como sensores, APIs ou entrada do usuário.

-

Estado de Crença: Isso representa o entendimento do agente do mundo com base nos dados coletados. Ele é atualizado constantemente conforme novas informações ficam disponíveis.

-

Motor de Racionalização: Este é o coração do processo de decisão do agente. Ele usa algoritmos, frequentemente baseados em aprendizado por reforço ou técnicas de planejamento, para determinar a melhor ação com base em suas crenças atuais e objetivos.

-

Atuadores: Essas são as ferramentas do agente para interagir com o mundo. Elas podem variar de enviar chamadas API a controlar robôs físicos.

-

-

Desafios: Os agentes de IA tradicionais, embora proficientes em tarefas bem definidas, muitas vezes lutam com:

-

Compreensão de Linguagem Natural: A interpretação de linguagem humana nuanceda, a manutenção de ambiguidades e a extração de significado do contexto permanecem desafios significativos.

-

Razão com Sentido Comum: Os atuais agentes de IA frequentemente carecem do conhecimento comum e das capacidades de raciocínio que os seres humanos têm por padrão.

-

Generalização: Treinar agentes para funcionar bem em tarefas desconhecidas ou adaptarem-se a novos ambientes permanece um ponto chave de pesquisa.

-

LLMs: Desbloqueando Compreensão e Geração de Linguagem

LLMs, com seu vasto conhecimento codificado em milhões de parâmetros, trazem capacidades de linguagem sem precedentes à mesa:

-

Arquitetura de Transformer: A base de quase todos os LLMs modernos é a arquitetura de transformer, um design de rede neural que se destaca na processação de dados sequenciais, como texto. Isto permite que LLMs captuem dependências de longa distância na linguagem, permitindo que eles entendam o contexto e gerem texto coeso e relevante no contexto.

-

Capacidades: LLMs são excelentes em uma ampla gama de tarefas baseadas em linguagem:

-

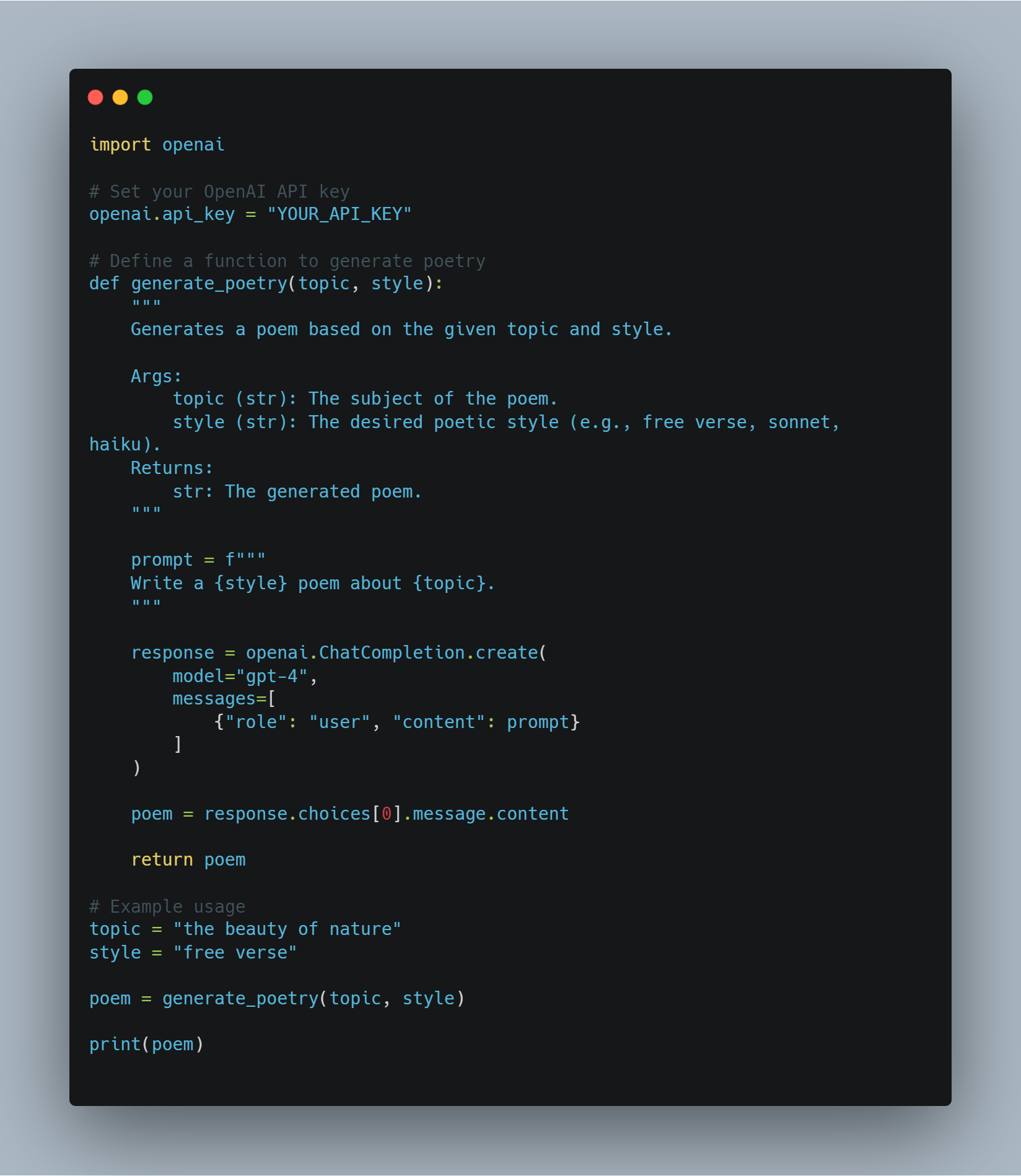

Geração de Texto: Desde escrever ficção criativa até gerar código em vários linguagens de programação, LLMs mostram uma fluência e criatividade notáveis.

-

Respostas a Perguntas: Eles podem fornecer respostas concisas e precisas a perguntas, mesmo quando a informação está espalhada através de documentos longos.

-

Resumo: LLMs podem condensar grandes volumes de texto em resumos concisos, extraindo informações chave e descartando detalhes irrelevantes.

-

-

Limitações: Apesar de suas habilidades impressionantes, LLMs têm limitações:

-

Falta de Referência ao Mundo Real: LLMs operam principalmente no campo do texto e não possuem a capacidade de interagir diretamente com o mundo físico.

-

Potencial para Bias e Ilusão: Treinados the base de dados massivos, não curados, LLMs podem herdar padrões presentes em dados e às vezes gerar informação factualmente incorreta ou sem sentido.

-

A Sinergia: Atravessando o Gap entre Linguagem e Ação

A combinação de agentes AI e LLM aborda as limitações de cada um, criando sistemas que são tanto inteligentes quanto capazes:

-

LLMs como Interpretes e Planejadores: Os LLM podem traduzir instruções em linguagem natural em um formato que os agentes AI possam entender, permitindo uma interação humano-computador mais intuitiva. Eles também podem aproveitar seu conhecimento para assistir os agentes em planejar tarefas complexas, dividindo-as em passos menores e gerenciáveis.

-

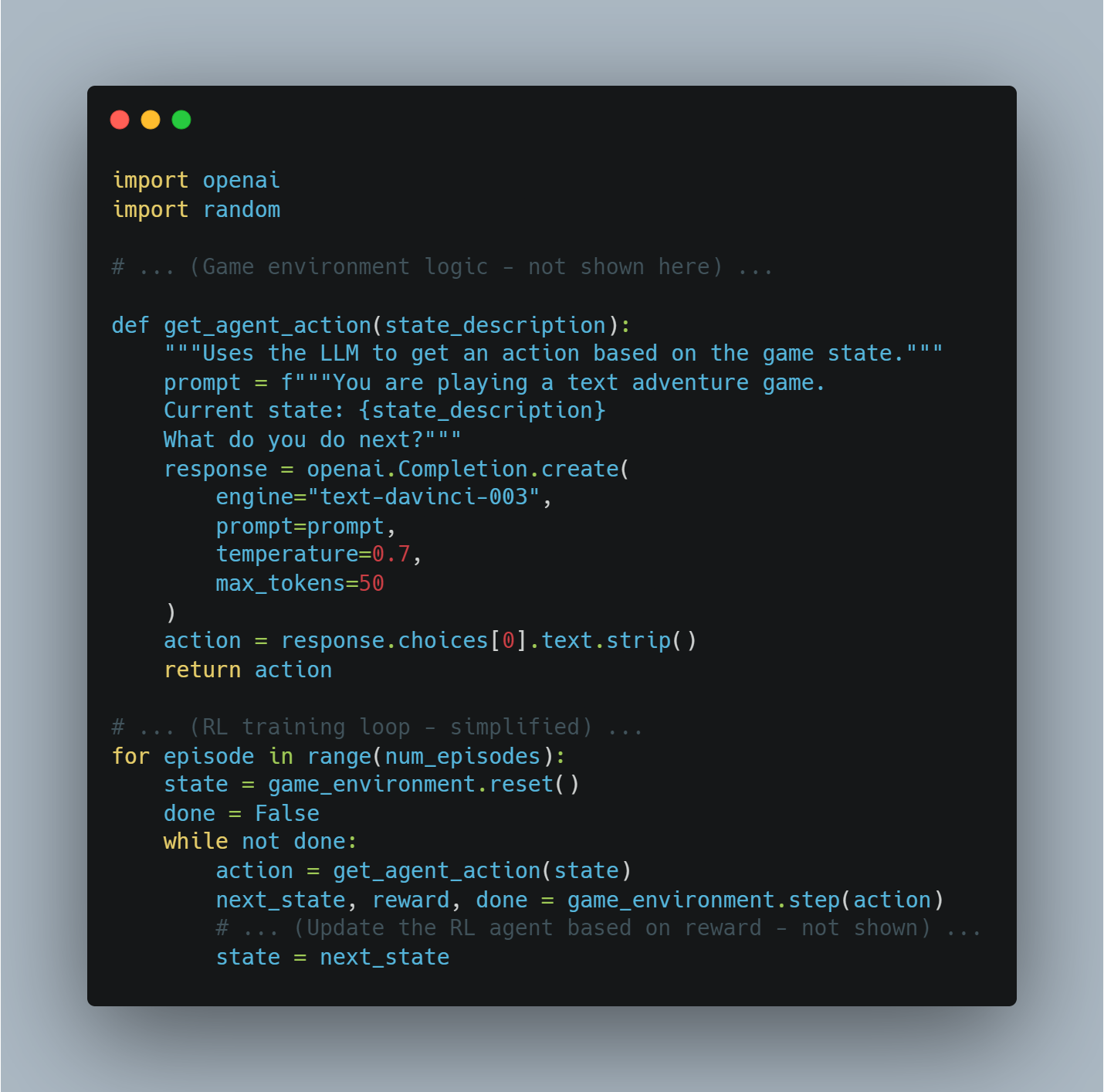

Agentes AI como Executores e Aprendizes: Agentes AI fornecem a LLMs a capacidade de interagir com o mundo, coletar informações e obter feedback sobre suas ações. Esta integração com o mundo real pode ajudar LLMs a aprender das experiências e melhorar seu desempenho ao longo do tempo.

Esta poderosa sinergia está impulsionando o desenvolvimento de uma nova geração de aplicações que são mais intuitivas, adaptáveis e capazes do que nunca. Como as tecnologias tanto de agentes AI quanto de LLMs continuam a avançar, podemos esperar ver ainda mais aplicações inovadoras e impactantes surgindo, repensando o panorama de desenvolvimento de software e de interação humano-computador.

Exemplos da Realidade: Transformando as Indústrias

Esta poderosa combinação já está causando ondas em várias indústrias:

-

Atendimento ao Cliente: resolver problemas com consciência contextual

- Exemplo: Imagine um cliente contatando um retalhista online sobre um frete atrasado. Um agente de AI alimentado por uma AML pode entender a frustração do cliente, acessar seu histórico de pedidos, rastrear o pacote em tempo real e oferecer soluções proativas, como entrega加速ada ou desconto na próxima compra.

-

Criação de Conteúdo: gerando conteúdo de alta qualidade em escala

- Exemplo: Uma equipe de marketing pode usar um sistema de AI agente + AML para gerar posts de mídia social direcionados, escrever descrições de produto ou até mesmo criar roteiros de vídeo. A AML garante que o conteúdo é interessante e informativo, enquanto o agente de AI gerencia o processo de publicação e distribuição.

-

Desenvolvimento de Software: Acelerando o Código e o Debugging

- Exemplo: Um desenvolvedor pode descrever uma funcionalidade de software que ele quer construir usando linguagem natural. O LLM então pode gerar trechos de código, identificar erros potenciais e sugerir melhorias, acelerando significativamente o processo de desenvolvimento.

-

Cadeia de Saúde: Personalizar Tratamento e Melhorar Atendimento a Pacientes

- Exemplo: Um agente artificial com acesso à história clínica de um paciente e equipado com um LLM pode responder às suas perguntas relacionadas à saúde, fornecer lembretes de medicamentos personalizados e até oferecer diagnósticos preliminares baseados em seus sintomas.

-

Lei: simplificar pesquisa legal e redação de documentos

- Exemplo: Um advogado precisa redigir um contrato com cláusulas específicas e precedências legais. Um agente AI alimentado por uma AML pode analisar as instruções do advogado, pesquisar em bases de dados legais extensas, identificar cláusulas e precedências relevantes, e até mesmo redigir partes do contrato, reduzindo significativamente o tempo e esforço necessários.

-

Criação de Vídeo: Geração de Vídeos Engraçados com Facilidade

- Exemplo: Uma equipe de marketing quer criar um vídeo curto explicando as funcionalidades do seu produto. Eles podem fornecer a um agente AI + Sistema AML com um esboço de roteiro e preferências de estilo visual. A AML pode então gerar um roteiro detalhado, sugerir música e imagens apropriadas, e até mesmo editar o vídeo, automatizando muito do processo de criação de vídeo.

-

Arquitetura: Projetando edifícios com insights baseados em AI

- Exemplo: Um arquiteto está projetando um novo prédio de escritório. Eles podem usar um agente AI + um sistema LLM para inserir seus objetivos de projeto, como maximizar a luz natural e otimizar o uso de espaço. O LLM pode então analisar esses objetivos, gerar diferentes opções de projeto, e até simular como o edifício performaria sob diferentes condições ambientais.

-

Construção: Melhorar a Segurança e a Eficiência em Sites de Construção

- Exemplo: Um agente AI equipado com câmeras e sensores pode monitorar um site de construção para riscos de segurança. Se um funcionário não estiver usando o equipamento de segurança apropriado ou um equipamento for deixado em uma posição perigosa, o MLG pode analisar a situação, avisar o supervisor do site e até mesmo suspender automaticamente as operações se necessário.

O Futuro Está Aqui: Um Novo Era de Desenvolvimento de Software

A convergência de agentes AI e MLGs marca um avanço significativo no desenvolvimento de software. Enquanto essas tecnologias continuam a evoluir, podemos esperar ver ainda mais aplicações inovadoras emergindo, transformando indústrias, linearizando fluxos de trabalho e criando novas possibilidades inteiras para a interação humano-computador.

Agentes AI brilham mais quando é necessário processar grandes quantidades de dados, automatizar tarefas repetitivas, tomar decisões complexas e fornecer experiências personalizadas. Conforme atenderem as condições necessárias e seguirem as melhores práticas, as organizações podem aproveitar o potencial total de agentes AI para impulsionar inovação, eficiência e crescimento.

Capítulo 4: A Fundação Filosófica dos Sistemas Inteligentes

O desenvolvimento de sistemas inteligentes, especialmente no campo da inteligência artificial (IA), requer um entendimento profundo dos princípios filosóficos. Este capítulo explora as ideias filosóficas centrais que moldam o design, o desenvolvimento e o uso da IA. Ele destaca a importância de alinhar o progresso tecnológico com os valores éticos.

A fundação filosófica dos sistemas inteligentes não é apenas um exercício teórico – é um framework vital que garante que as tecnologias da IA beneficiam a humanidade. Promovendo ajustes, inclusividade e melhorando a qualidade de vida, esses princípios auxiliam a orientar a IA para servir os nossos melhores interesses.

Considerações Éticas no Desenvolvimento da AI

Como os sistemas AI se tornam cada vez mais integrados em todos os aspectos da vida humana, da saúde e educação à finanças e governança, precisamos examinar e aplicar rigorosamente as imperativos éticos que guiam seu design e implementação.

A questão étnica fundamental gira em torno de como a AI pode ser feita para abraçar e defender os valores humanos e os princípios morais. Essa questão é central ao modo como a AI moldará o futuro das sociedades em todo o mundo.

No cerne deste debate étnico está o princípio de beneficência, um pilar da filosofia moral que diz que as ações devem buscar fazer bem e melhorar o bem-estar dos indivíduos e da sociedade em geral (Floridi & Cowls, 2019).

No contexto da IA, a bondade traduz-se em projetar sistemas que contribuem ativamente para o florescimento humano — sistemas que melhoram os resultados de saúde, ampliam as oportunidades educacionais e facilitam o crescimento econômico equitativo.

Mas a aplicação da bondade na IA é longe de ser simples. Isso exige uma abordagem nuanciada que avalia cuidadosamente os benefícios potenciais da IA contra os riscos e danos possíveis.

Um dos principais desafios na aplicação do princípio da bondade à mudança de desenvolvimento da IA é a necessidade de equilíbrio delicado entre inovação e segurança.

A IA tem o potencial para revolucionar campos como a medicina, onde algoritmos preditivos podem diagnosticar doenças mais cedo e com maior exatidão do que os médicos humanos. Mas sem um controle ético estritamente supervisionado, essas mesmas tecnologias poderiam agravar as desigualdades existentes.

Isso poderia acontecer, por exemplo, se eles fossem principalmente implantados em regiões abastadas enquanto as comunidades subservidas continuam sem acesso básico à assistência médica.

Devido a isso, o desenvolvimento ético da AI exige não apenas foco na maximização dos benefícios, mas também uma abordagem proativa para mitigar riscos. Isto envolve a implementação de garantias robustas para prevenir o abuso da AI e garantir que essas tecnologias não causem danos acidentalmente.

O quadro ético para a AI também deve ser intrinsecamente inclusivo, garantindo que os benefícios da AI sejam distribuídos equitativamente entre todos os grupos da sociedade, incluindo aqueles que são tradicionalmente marginalizados. Isso chama de compromisso com a justiça e a equidade, garantindo que a AI não simplesmente reforça o status quo, mas trabalha ativamente para desmantelar as desigualdades sistémicas.

Por exemplo, a automatização de trabalhos impulsionada por IA tem o potencial para aumentar a produtividade e o crescimento econômico. Mas ela também poderia resultar em uma deslocalização de trabalhos significativa, afetando de forma desproporcionada trabalhadores de baixo rendimento.

Então, como podem ver, um framework ético para a IA deve incluir estratégias para o partilhamento equitativo de benefícios e a prestação de sistemas de apoio para aqueles afetados adversamente pelas avançadas tecnologias da IA.

O desenvolvimento ético da IA exige um envolvimento contínuo com diversos interessados, incluindo eticistas, tecnólogos, formuladores de políticas e comunidades que serão mais afetadas por essas tecnologias. essa colaboração interdisciplinar garante que os sistemas da IA não se desenvolvam em um vácuo, mas são moldados por uma ampla gama de perspectivas e experiências.

É através deste esforço coletivo que podemos criar sistemas da IA que refletem e mantêm os valores que definem a nossa humanidade – compaixão, justiça, respeito à autonomia e compromisso com o bem comum.

As considerações éticas no desenvolvimento da IA não são apenas guias, mas elementos essenciais que determinarão se a IA serve como uma força para o bem no mundo. Ao basear a IA nos princípios de bondade, justiça e inclusividade, e mantendo uma abordagem vigilante em relação ao equilíbrio da inovação e dos riscos, podemos garantir que o desenvolvimento da IA não avança apenas a tecnologia, mas também melhora a qualidade de vida de todos os membros da sociedade.

Ao continuarmos a explorar as capacidades da IA, é imprescindível que essas considerações éticas permaneçam no centro de nossos esforços, guiando-nos para um futuro onde a IA realmente beneficie a humanidade.

A Imperativa de Design de AI Centrado no Humano

O design de AI centrado no humano transcende considerações técnicas meras. Ele está arraigado em princípios filosóficos profundos que priorizam a dignidade humana, a autonomia e a agência.

Este approach para o desenvolvimento de AI é fundamentalmente ancorado no quadro ético kantiano, que afirma que os seres humanos devem ser considerados como fins em si mesmos, e não apenas como instrumentos para alcançar outros objetivos (Kant, 1785).

As implicações deste princípio para o design de AI são profundas, exigindo que sistemas de AI sejam desenvolvidos com foco inflexível em servir os interesses humanos, preservar a agência humana e respeitar a autonomia individual.

Implementação Técnica de Princípios Centrados no Humano

Melhorar Autonomia Humana através de AI: O conceito de autonomia em sistemas AI é crítico, particularmente em garantir que essas tecnologias empower usuários, em vez de controlar ou influenciar nelas de forma indevida.

Em termos técnicos, isso envolve o desenvolvimento de sistemas AI que priorizam a autonomia do usuário, fornecendo-lhes ferramentas e informações necessárias para tomar decisões informadas. Isso requer que modelos AI sejam contextuais, o que significa que eles devem entender o contexto específico em que uma decisão é feita e ajustar suas recomendações em conformidade.

Ao olhar para a perspectiva de projeto de sistemas, isso envolve a integração de inteligência contextual em modelos AI, o que permite que esses sistemas se adaptem dinamicamente ao ambiente, preferências e necessidades do usuário.

Por exemplo, no setor de saúde, um sistema de AI que assiste médicos na diagnose de condições deve considerar o histórico médico único do paciente, os sintomas atuais, e até mesmo o estado psicológico para oferecer recomendações que apoiem a expertise do médico, em vez de a substituir.

Essa adaptação contextual garante que o AI continue sendo uma ferramenta de apoio que melhora, em vez de diminuir, a autonomia humana.

Garantindo Processos de Decisão Transparentes: A transparência em sistemas de AI é um requisito fundamental para garantir que os usuários possam confiar e entender as decisões feitas por essas tecnologias. Tecnicamente, isso traduz-se na necessidade de explicabilidade de AI (XAI), que envolve o desenvolvimento de algoritmos que possam articular claramente a razão por trás das suas decisões.

Isso é particularmente crucial em domínios como finanças, saúde e justiça criminal, onde a tomada de decisões opacas pode levar a desconfiança e preocupações éticas.

A explicabilidade pode ser alcançada por várias abordagens técnicas. Uma das metodologias comuns é a interpretabilidade pós-hoc, onde o modelo de AI gera uma explicação após a decisão ter sido feita. Isso pode envolver a desagregação da decisão em seus fatores constituintes e mostrar como cada um deles contribuiu para o resultado final.

Outra abordagem é os modelos intrinsecamente interpretáveis, onde a arquitetura do modelo é projetada de modo a que suas decisões sejam transparentes por padrão. Por exemplo, modelos como árvores de decisão e modelos lineares são naturaismente interpretáveis porque seu processo de tomada de decisões é fácil de seguir e entender.

O desafio na implementação de IA explicável está em equilibrar a transparência com o desempenho. frequentemente, modelos mais complexos, como redes neurais profundas, são menos interpretáveis mas mais precisos. Portanto, o design de IA humano-centrada deve considerar o compromisso entre a interpretabilidade do modelo e sua capacidade preditiva, garantindo que usuários possam confiar e entender decisões de IA sem sacrificar precisão.

Permitindo Oversight Humano Significativo: O oversight humano significativo é fundamental para garantir que os sistemas AI operam dentro de limites ético e operacional. Este oversight envolve projetar sistemas AI com salvaguardas e mecanismos de sobreposição que permitam que operadores humanos intervendam quando necessário.

A implementação técnica de oversight humano pode ser abordada de várias maneiras.

Uma abordagem é incorporar sistemas human-in-the-loop, onde os processos de decisão da IA são monitorados e avaliados contínueismente por operadores humanos. Esses sistemas são projetados para permitir intervenção humana em pontos críticos, garantindo que a IA não actue de forma autônoma em situações onde juízes éticos são necessários.

Por exemplo, no caso de sistemas de armas autônomas, o supervisão humana é essencial para evitar que o AI faça decisões de vida ou morte sem entrada humana. Isso poderia envolver a definição de limites operacionais rígidos que o AI não pode transpor sem autorização humana, embutindo assim garantias éticas no sistema.

Outro considerado técnico é o desenvolvimento de trajetórias de auditoria, que são registros de todas as decisões e ações tomadas pelo sistema AI. Essas trajetórias fornecem uma história transparente que pode ser revisada por operadores humanos para garantir conformidade com padrões éticos.

Trajetórias de auditoria são particularmente importantes em setores como finanças e direito, onde decisões devem ser documentadas e justificáveis para manter a confiança pública e atender aos requisitos regulatórios.

Equilíbrio Entre Autonomia e Controle: Um desafio técnico chave em AI centrado no humano é encontrar o equilíbrio certo entre autonomia e controle. Embora os sistemas AI sejam projetados para operar autonomamente em muitos cenários, é crucial que essa autonomia não submeta o controle humano ou supervisão.

Esse equilíbrio pode ser alcançado através da implementação de níveis de autonomia, que determinam o grau de independência que o AI tem na tomada de decisões.

Por exemplo, em sistemas semi-autônomos como carros autônomos, os níveis de autonomia variam de assistência de condutor básica (onde o condutor humano permanece em controle total) à automação total (onde o AI é responsável por todas as tarefas de condução).

O design desses sistemas deve garantir que, em qualquer nível de autonomia, o operador humano mantenha a capacidade de intervir e anular o AI, se necessário. Isso requer interfaces de controle sofisticadas e sistemas de apoio à decisão que permitam que humanos assumam o controle rapidamente e eficazmente quando necessário.

Adicionalmente, o desenvolvimento de frameworks éticos de AI é fundamental para guiar as ações autônomas de sistemas de AI. Esses frameworks são conjuntos de regras e diretrizes embutidas no AI que ditam como ele deve se comportar em situações étnicamente complexas.

Por exemplo, em saúde, um framework ético de AI poderia incluir regras sobre consentimento do paciente, privacidade e priorização de tratamentos com base na necessidade médica, em vez de considerações financeiras.

Ao integrar esses princípios éticos diretamente nos processos de decisão do AI, os desenvolvedores podem garantir que a autonomia do sistema é exercida de modo que alinhe com os valores humanos.

A integração de princípios humanocêntricos no design de AI não é apenas um ideal filosófico, mas uma necessidade técnica. Ao melhorar a autonomia humana, garantindo transparência, permitindo controle significativo e equilibrando a autonomia com o controle, os sistemas de AI podem ser desenvolvidos de modo que realmente servem à humanidade.

essas considerações técnicas são essenciais para criar AI que não apenas amplia as capacidades humanas, mas também respeita e mantém os valores fundamentais à nossa sociedade.

Como o AI continua a evoluir, o compromisso com o design humanocêntrico será crucial para garantir que essas poderosas tecnologias sejam usadas ética e responsavelmente.

Como Garantir que a IA Beneficie a Humanidade: Melhorar a Qualidade de Vida

Enquanto se engaja na desenvolvimento de sistemas de IA, é essencial para você fixar seus esforços no quadro ético do utilitarismo – uma filosofia que dá importância para a melhoria da felicidade e bem-estar gerais.

No contexto deste, a IA tem o potencial para abordar desafios críticos da sociedade, particularmente em áreas como saúde, educação e sustentabilidade ambiental.

O objetivo é criar tecnologias que melhorem significativamente a qualidade de vida para todos. Mas essa busca apresenta complexidades. O utilitarismo oferece um motivo convincente para a ampla implantação da IA, mas também coloca questões éticas importantes sobre quem beneficia e quem pode ser deixado para trás, especialmente entre populações vulneráveis.

Para navegar nestes desafios, precisamos de um método sofisticado e informado técnicamente – um equilíbrio entre a busca ampla de bem-estar da sociedade e a necessidade de justiça e equidade.

Ao aplicar os princípios utilitários à IA, seu foco deve estar na otimização de resultados em domínios específicos. Na área de saúde, por exemplo, ferramentas de diagnóstico de IA têm o potencial para melhorar significativamente os resultados dos pacientes, permitindo diagnósticos mais rápidos e precisos. Estes sistemas podem analisar grandes bases de dados para detectar padrões que podem passar despercebidos por profissionais humanos, expandindo assim o acesso a cuidados de qualidade, particularmente em ambientes pouco recursos.

Mas, a implantação destas tecnologias exige uma consideração cuidadosa para evitar a reforçação de desigualdades existentes. Os dados usados para treinar modelos de AI podem variar significativamente entre regiões, afetando a precisão e a confiabilidade desses sistemas.

Essa disparidade destaca a importância de estabelecer frameworks robustos de governança de dados que garantam que suas soluções de saúde auxiliadas por AI sejam tanto representativas quanto equitativas.

Na esfera educacional, a capacidade de personalização do AI é promissora. Sistemas de AI podem adaptar o conteúdo educacional para atender às necessidades específicas de estudantes individuais, melhorando assim os resultados de aprendizagem. Analisando dados sobre o desempenho e o comportamento de estudantes, AI pode identificar onde um estudante pode estar tendo dificuldades e fornecer apoio direcionado.

Mas enquanto você trabalha em direção a esses benefícios, é crucial estar ciente dos riscos – como o potencial de reforçar estereótipos ou marginalizar estudantes que não se encaixam em padrões de aprendizagem típicos.

Mitigar esses riscos exige a integração de mecanismos de equidade em modelos de AI, garantindo que eles não favoreçam acidentalmente certos grupos. E manter o papel dos educadores é fundamental. Sua experiência e juízo são indispensáveis para tornar ferramentas de AI verdadeiramente eficazes e apoio.

Em termos de sustentabilidade ambiental, o potencial de AI é considerável. Sistemas de AI podem optimizar o uso de recursos, monitorar mudanças ambientais e prever os impactos do aquecimento global com precisão sem precedentes.

Por exemplo, a IA pode analisar grandes quantidades de dados ambientais para prever padrões meteorológicos, otimizar o consumo de energia e minimizar o desperdício — ações que contribuem para o bem-estar de gerações atuais e futuras.

Mas essa avançada tecnológica vem com um conjunto de desafios próprios, principalmente referente ao impacto ambiental dos próprios sistemas de IA.

O consumo de energia necessário para operar sistemas de IA em escala grande pode compensar os benefícios ambientais que eles buscam alcançar. Portanto, desenvolver sistemas de IA eficientes em energia é crucial para garantir que seu impacto positivo na sustentabilidade não é subvalorizado.

Enquanto você desenvolve sistemas de IA com objetivos utilitários, é importante considerar também as implicações para a justiça social. O utilitarismo se concentra na maximização da felicidade global, mas não aborda necessariamente a distribuição dos benefícios e danos entre diferentes grupos da sociedade.

Isto levanta o potencial de sistemas de IA beneficiar desproporcionalmente aqueles que já estão privilegiados, enquanto os grupos marginalizados pode ver pouca ou nenhuma melhoria nas suas circunstâncias.

Para contrabalançar isso, seu processo de desenvolvimento de AI deve incorporar princípios enfocados na equidade, garantindo que os benefícios são distribuídos justamente e que quaisquer potenciais danos são abordados. Isto poderia envolver o design de algoritmos que especificamente visam reduzir biases e envolver uma variedade de perspectivas diversas no processo de desenvolvimento.

Enquanto trabalhamos para desenvolver sistemas AI com o objetivo de melhorar a qualidade de vida, é essencial equilibrar o objetivo utilitarista de maximizar o bem-estar com a necessidade de justiça e equidade. Isso requer uma abordagem sofisticada, baseada em tecnologia, que considere as implicações mais amplas do deployamento de AI.

Ao projetar sistemas AI que sejam tanto eficazes quanto equitativos, você pode contribuir para um futuro onde as mudanças tecnológicas realmente atendam às diversas necessidades da sociedade.

ImplementarMedidas de Proteção contra Possíveis Danos

Ao desenvolver tecnologias AI, você deve reconhecer o potencial para danos e estabelecer ativamente medidas robustas para mitigar estes riscos. Esta responsabilidade está profundamente enraizada nas éticas deontológicas. Esta ramificação da ética dá importância à obrigação moral de seguir regras e padrões éticos estabelecidos, garantindo que a tecnologia criada se alinhe com princípios morais fundamentais.

A implementação de protocolos de segurança estritos não é apenas uma precaução, mas uma obrigação ética. Esses protocolos devem abranger testes de bias completos, transparência nos processos algoritmicos e mecanismos claros de responsabilidade.

Tais medidas de proteção são essenciais para prevenir que os sistemas AI causem dano não intencional, seja por decisões baseadas em preconceitos, processos opacos ou por falta de supervisão.

Na prática, a implementação dessas medidas de proteção requer um entendimento profundo das dimensões técnicas e éticas do AI.

Testes de propagação de erro, por exemplo, envolve não só a identificação e correção de propagações de erro em dados e algoritmos, mas também o entendimento das implicações sociais mais amplas dessas propagações de erro. Você deve garantir que seus modelos de AI estejam treinados em bases de dados diversas e representativas e sejam avaliados regularmente para detectar e corrigir quaisquer propagações de erro que possam surgir ao longo do tempo.

Por outro lado, a transparência exige que os sistemas de AI sejam projetados de modo a que seus processos de tomada de decisão sejam facilmente compreensíveis e questionáveis por usuários e stakeholders. Isso envolve o desenvolvimento de modelos de AI explicáveis que fornecem saídas claras e interpretáveis, permitindo que usuários vejam como as decisões são feitas e garantindo que essas decisões sejam justificáveis e equitativas.

Além disso, mecanismos de responsabilidade são cruciais para manter a confiança e garantir que os sistemas de AI são usados responsavelmente. Esses mecanismos devem incluir diretrizes claras sobre quem é responsável pelos resultados das decisões de AI, bem como processos para abordar e corrigir quaisquer danos que possam ocorrer.

Você deve estabelecer um framework onde as considerações éticas são integradas em cada estágio do desenvolvimento de AI, desde o design inicial até a implantação e além disso. Isso inclui não só seguir diretrizes éticas, mas também monitorar contínuamente e ajustar os sistemas de AI conforme interagem com o mundo real.

Ao integrar esses salvaguardas na própria estrutura do desenvolvimento de AI, você pode ajudar a garantir que o progresso tecnológico serve o bem maior sem levantar consequências negativas não intencionadas.

O papel de supervisão humana e ciclos de feedback

Supervisão humana em sistemas AI é um componente crítico para garantir oPLOYIMENTO ETICO DE AI. O princípio de responsabilidade apoia a necessidade de envolvimento humano contínuo na operação de AI, particularmente em ambientes de alto risco como saúde e justiça criminal.

Os laços de feedback, onde a entrada humana é usada para refinar e melhorar os sistemas AI, são essenciais para manter a responsabilidade e adaptabilidade (Raji et al., 2020). Esses laços permitem a correção de erros e a integração de novas considerações éticas à medida que os valores sociais evoluem.

Ao incorporar a supervisão humana em sistemas AI, os desenvolvedores podem criar tecnologias que não só são eficientes mas também alinhadas com normas éticas e expectativas humanas.

codificando Ética: Traduzindo Princípios Filosóficos em Sistemas AI

A tradução de princípios filosóficos em sistemas AI é uma tarefa complexa, mas necessária. Esse processo envolve a incorporação de considerações éticas no próprio código que guia os algoritmos de AI.

Conceitos como justiça, equidade e autonomia devem ser codificados em sistemas AI para garantir que operem de maneiras que refletem valores sociais. Isso requer uma abordagem multidisciplinar, onde eticistas, engenheiros e cientistas sociais colaboram para definir e implementar diretrizes éticas no processo de codificação.

O objetivo é criar sistemas AI que não só são tecnicamente proficientes mas também moralmente sólidos, capazes de tomar decisões que respeitam a dignidade humana e promovem o bem social (Mittelstadt et al., 2016).

Promoção de Inclusividade e Acesso Equitativo no Desenvolvimento ePLOYIMENTO DE AI

Inclusividade e acesso equitativo são fundamentais para o desenvolvimento ético de AI. O conceito Rawlsiano de justiça como equidade fornece uma fundação filosófica para garantir que os sistemas AI são projetados e implementados de modos que beneficiam de todos os membros da sociedade, particularmente aqueles que são os mais vulneráveis (Rawls, 1971).

Isso envolve esforços proativos para incluir perspectivas diversas no processo de desenvolvimento, especialmente de grupos subrepresentados e do Sul Global.

Ao incorporar essas perspectivas diversas, os desenvolvedores de AI podem criar sistemas que sejam mais equitativos e respondem melhor às necessidades de uma ampla gama de usuários. Além disso, garantir o acesso equitativo a tecnologias AI é crucial para prevenir a agravação de desigualdades sociais existentes.

Confrontar o Bias Algorítmico e a Justiça

O bias algorítmico é um problema ético significativo no desenvolvimento de AI, pois algoritmos com essa característica podem perpetuar e até agravar as desigualdades sociais. Para abordar esse assunto, é necessário um compromisso com a justiça procedural, garantindo que os sistemas AI são desenvolvidos através de processos justos que consideram o impacto em todos os interessados (Nissenbaum, 2001).

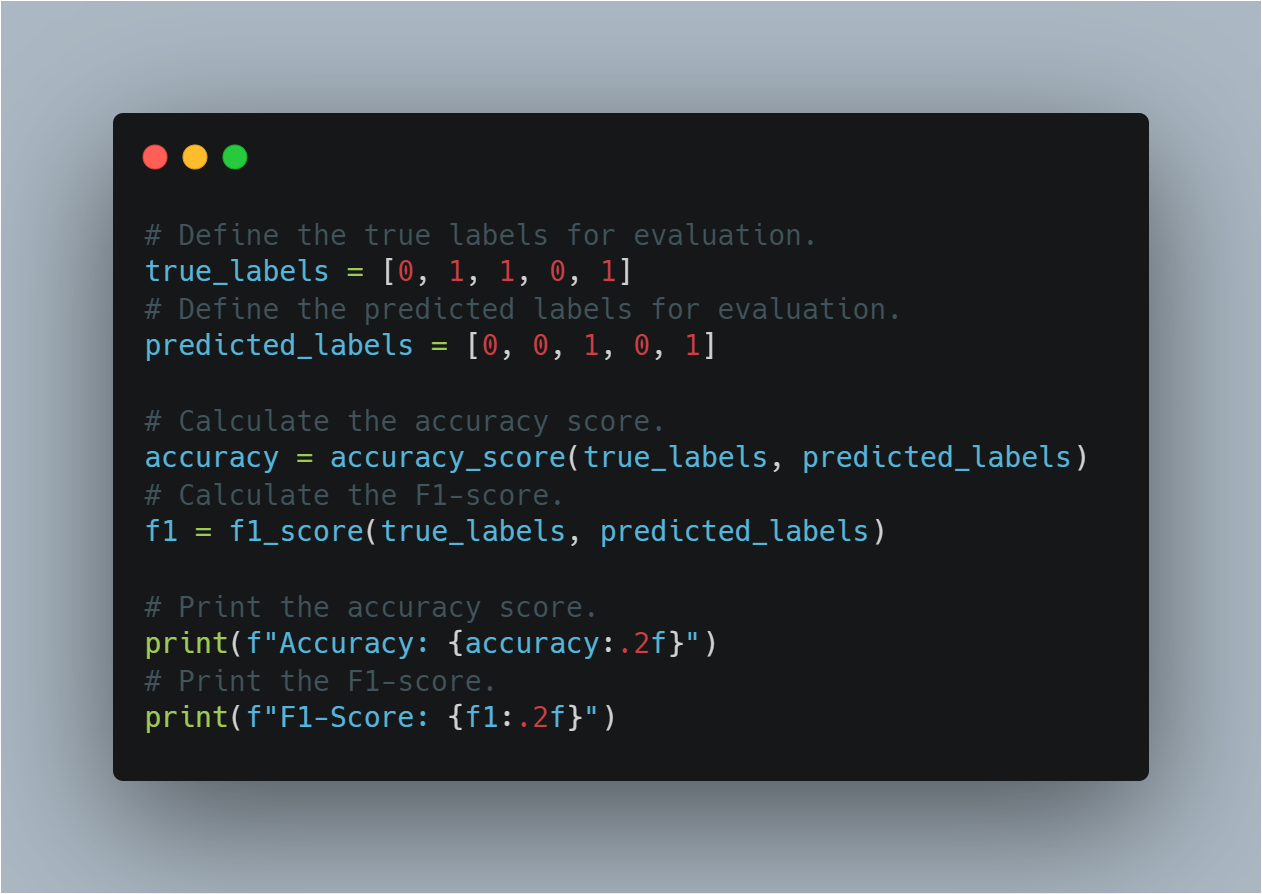

Isso envolve identificar e mitigar os biases nos dados de treinamento, desenvolver algoritmos que sejam transparentes e explicáveis e aplicar verificações de equidade ao longo do ciclo de vida do AI.

Ao abordar o bias algorítmico, os desenvolvedores podem criar sistemas AI que contribuam para uma sociedade mais justa e equitativa, em vez de reforçar as disparidades existentes.

Incorporar Perspectivas Diversas no Desenvolvimento de AI

Incorporar perspectivas diversas na pesquisa em inteligência artificial (IA) é fundamental para a criação de sistemas inclusivos e equitativos. A inclusão de vozes de grupos subrepresentados garante que as tecnologias da IA não refletem apenas os valores e prioridades de um pequeno segmento da sociedade.

Este enfoque está alinhado com o princípio filosófico da democracia deliberativa, que enfatiza a importância de processos decisórios inclusivos e participativos (Habermas, 1996).

Ao fomentar a participação diversa na pesquisa em IA, podemos garantir que essas tecnologias são desenhadas para servir os interesses de toda a humanidade, e não de apenas alguns privilegiados.

Estratégias para aompanhar a divisão da IA

A divisão da IA, caracterizada pela desigualdade de acesso às tecnologias e benefícios da IA, representa um desafio significativo para a equidade global. Contruir este caminho requer um compromisso com a justiça distributiva, garantindo que os benefícios da IA sejam divididos amplamente entre diferentes grupos sócioeconômicos e regiões (Sen, 2009).

Podemos fazer isso através de iniciativas que promovem o acesso à educação em IA e recursos em comunidades de serviço insuficiente, bem como políticas que apoiam a distribuição equitativa de ganhos econômicos driven por IA. Atendendo à divisão da IA, podemos garantir que a IA contribua ao desenvolvimento global de uma maneira inclusiva e equitativa.

Equilibrar a Inovação com as Constraints Éticas

Equilibrar a busca pela inovação com as restrições éticas é fundamental para o avanço responsável da IA. O princípio precautório, que defende a prudência na face da incerteza, é particularmente relevante no contexto do desenvolvimento da IA (Sandin, 1999).

Enquanto inovação drive progresso, deve ser equilibrada por considerações éticas que protegem contra potenciais danos. Isso requer uma avaliação cuidadosa dos riscos e benefícios das novas tecnologias de AI, bem como a implementação de frameworks regulatórios que garantam o cumprimento de padrões éticos.

Ao equilibrar inovação com restrições éticas, podemos fomentar o desenvolvimento de tecnologias de AI que sejam de ponta e alinhadas com os objetivos mais amplos de bem-estar da sociedade.

Como você pode ver, a fundamentação filosófica de sistemas inteligentes fornece um marco crítico para garantir que tecnologias de AI sejam desenvolvidas e implantadas de maneiras éticas, inclusivas e benéficas para toda a humanidade.

Ao basear o desenvolvimento de AI nestes princípios filosóficos, podemos criar sistemas inteligentes que não só avançam as capacidades tecnológicas, mas também melhoram a qualidade de vida, promovem a justiça e garantem que os benefícios de AI sejam partilhados equitativamente pela sociedade.

Capítulo 5: Agentes de AI como Enhancers de LLM

A fusão de agentes de AI com Modelos de Linguagem Grande (LLMs) representa um shift fundamental em inteligência artificial, abordando limitações críticas em LLMs que têm limitado sua aplicabilidade ampla.

Essa integração permite que as máquinas transcendam seus papéis tradicionais, avançando de geradores de texto passivos para sistemas autônomos capazes de raciocínio dinâmico e tomada de decisões.

Como sistemas AI cada vez mais dirigem processos críticos em diversos domínios, entender como os agentes de AI preenchem as lacunas nas capacidades de LLM é essencial para concretizar seu potencial total.

Ponteando asfalte em Capacidades de LLM

LLMs, embora poderosos, estão inherentemente limitados pelo conjunto de dados em que foram treinados e pela natureza estática de sua arquitetura. Esses modelos operam dentro de um conjunto fixo de parâmetros, normalmente definidos pelo corpus de texto usado durante sua fase de treinamento.

Essa limitação significa que LLMs não podem procurar informações novas de forma autônoma ou atualizar sua base de conhecimento após o treinamento. Consequentemente, LLMs são frequentemente desatualizados e carecem da capacidade de fornecer respostas relevantes de contexto que exijam dados ou insights além dos dados de treinamento iniciais.

Agentes de AI ponteiam essas lacunas ao integrar dinamicamente fontes de dados externos, o que pode extender o horizonte funcional de LLMs.

Por exemplo, um LLM treinado em dados financeiros até 2022 poderia fornecer análises históricas precisas, mas poderia ter dificuldade em gerar previsões de mercado atualizadas. Um agente de AI poderia complementar esse LLM, puxando dados reais em tempo real dos mercados financeiros e aplicando esses entradas para gerar análises mais relevantes e atuais.

Essa integração dinâmica garante que as saídas não são apenas precisas historicamente, mas também apropriadas contextualmente para condições atuais.

Melhoria na Autonomia na Tomada de Decisões

Outra limitação significativa de LLMs é sua falta de capacidades de tomada de decisão autônoma. LLMs excelentes em gerar saídas baseadas em linguagem, mas não conseguem realizar tarefas que requerem complexas decisões, especialmente em ambientes caracterizados por incerteza e mudança.

Essa deficiência principalmente é devido ao modelo dependendo de dados pré-existentes e a falta de mecanismos para raciocínio adaptativo ou aprendizagem a partir de novas experiências após a implantação.

Os agentes AI abordam isso fornecendo a infraestrutura necessária para decisões autônomas. Eles podem pegar as saídas estáticas de uma LLM e processá-las através de frameworks de raciocínio avançado, como sistemas baseados em regras, heurísticas ou modelos de aprendizagem por reforço.

Por exemplo, em um ambiente de saúde, uma LLM pode gerar uma lista de diagnósticos potenciais com base em sintomas de um paciente e histórico médico. Mas sem um agente AI, a LLM não consegue ponderar essas opções ou recomendar uma ação.

Um agente AI pode intervir para avaliar esses diagnósticos em relação à literatura médica atual, dados do paciente e fatores contextuais, fazendo assim decisões informadas e sugerindo próximas ações executáveis. Essa sinergia transforma as saídas da LLM de sugestões simples em decisões executáveis e contextuais.

Construindo Completude e Consistência

Completude e consistência são fatores críticos para garantir a confiabilidade dos resultados da LLM, particularmente em tarefas de raciocínio complexo. Devido à sua natureza parametrizada, LLMs frequentemente geram respostas incompletas ou logicamente incoerentes, especialmente quando lidam com processos de várias etapas ou exigem um entendimento abrangente em diversos domínios.

Esses problemas decorrem do ambiente isolado em que LLMs operam, onde eles não conseguem fazer referência cruzada ou validar suas saídas contra padrões externos ou informações adicionais.

Os agentes de inteligência artificial desempenham um papel crucial em mitigar estes problemas, ao introduzir mecanismos de feedback iterativo e camadas de validação.

Por exemplo, no domínio legal, uma MLG (Máquina de Lógica Generalista) pode elaborar uma versão inicial de um brief legal com base em seus dados de treinamento. Mas esse rascunho pode desconsiderar certos precedentes ou falhar em estruturar argumentos logicamente.

Um agente de inteligência artificial pode revisar esse rascunho, garantindo que ele atinja os padrões de completude requeridos, fazendo referência cruzada com bases de dados legais externas, verificando consistência lógica e solicitando informações adicionais ouclarificações onde necessário.

Este processo iterativo permite a produção de um documento mais robusto e confiável que atenda aos rigorosos requisitos da prática legal.

Superar a Isolamento por meio da Integração

Um dos maiores limitamentos das MLGs é sua inerente isolamento de outros sistemas e fontes de conhecimento.

MLGs, conforme projetadas, são sistemas fechados que não interagem naturalmente com ambientes externos ou bases de dados. Essa isolamento limita significativamente sua capacidade de adaptar a novas informações ou operar em tempo real, tornando-as menos efetivas em aplicações que requerem interação dinâmica ou decisões em tempo real.

Agentes de inteligência artificial superam este isolamento, atuando como plataformas integrativas que conectam MLGs a um ecosistema mais amplo de fontes de dados e ferramentas computacionais. Através de APIs e outras frameworks de integração, esses agentes podem acessar dados em tempo real, colaborar com outros sistemas de inteligência e até mesmo se interfaces com dispositivos físicos.

Por exemplo, em aplicações de serviço ao cliente, uma MLG (Máquina de Lógica de Geração) poderia gerar respostas padrão com base em scripts treinados prévios. Mas essas respostas podem ser estáticas e carecer da personalização necessária para o engajamento eficaz com o cliente.

Um agente de AI pode enriquecer essas interações integrando dados em tempo real de perfil do cliente, interações anteriores e ferramentas de análise de sentimento, o que ajuda a gerar respostas que não são apenas relevantes no contexto, mas também customizadas às necessidades específicas do cliente.

essa integração transforma a experiência do cliente de uma série de interações scriptadas em uma conversa dinâmica e personalizada.

Expandir Criatividade e Solução de Problemas

Enquanto as MLGs são ferramentas poderosas para a geração de conteúdo, sua criatividade e habilidades de resolução de problemas são intrinsecamente limitadas pelos dados em que foram treinadas. Esses modelos frequentemente não conseguem aplicar conceitos teóricos a novos desafios ou imprevistos, já que suas capacidades de resolução de problemas estão limitadas pelos conhecimentos prévios e parâmetros de treinamento.

Agentes de AI melhoram o potencial criativo e de resolução de problemas de MLGs, aproveitando técnicas de raciocínio avançadas e uma variedade maior de ferramentas de análise. Essa capacidade permite que agentes de AI ultrapassem as limitações das MLGs, aplicando frameworks teóricos a problemas práticos de forma inovadora.

Por exemplo, considere o problema de combater as informações falsas em plataformas de mídia social. Uma MLG poderia identificar padrões de informação falsa baseada em análises textuais, mas poderia ter dificuldade em desenvolver uma estratégia abrangente para mitigar a disseminação de informações falsas.

Um agente IA pode pegar nestes insights, aplicar teorias interdisciplinares de campos como sociologia, psicologia e teoria das redes, e desenvolver uma abordagem robusta, multifacetada que inclui monitoramento em tempo real, educação de usuários e técnicas de moderação automatizadas.

Esta capacidade de sintetizar frameworks teóricos diversos e aplicá-los a desafios do mundo real exemplifica as capacidades de resolução de problemas aprimoradas que os agentes IA trazem à mesa.

Exemplos Mais Específicos

Agentes IA, com sua capacidade de interagir com sistemas diversos, acessar dados em tempo real e executar ações, enfrentam essas limitações de frente, transformando LLMs de modelos de linguagem poderosos mas passivos em solucionadores de problemas dinâmicos e reais. Vamos olhar para alguns exemplos:

1. De Dados Estáticos para Insights Dinâmicos: Manter LLMs no Loop

-

O Problema: Imagine perguntar a um LLM treinado com pesquisa médica pré-2023, “Quais são as últimas mudanças no tratamento do cancro?” Sua informação estaria desatualizada.

- A Solução do Agente IA: Um agente IA pode conectar o LLM aos jornais médicos, bases de dados de pesquisa e fontes de notícias. Agora, o LLM pode fornecer informações atualizadas sobre os últimos ensaios clínicos, opções de tratamento e descobertas de pesquisa.

2. Da Análise à Ação: Automatizando Tarefas Baseadas em Insights do LLM

-

O Problema: Um LLM a monitorizar os media sociais para uma marca pode identificar uma explosão de sentimento negativo, mas não pode fazer nada para resolve-lo.

-

A Solução de Agente AI: Um agente AI conectado a contas de mídia social da marca e equipado com respostas pré-aprovadas pode automatizar a resolução de preocupações, responder a perguntas e até mesmo escalar questões complexas para representantes humanos.

3. Do Primeiro Rascunho ao Produto Polido: Garantindo Qualidade e Exatidão

-

O Problema: Um LLM encarregue de traduzir um manual técnico pode produzir traduções gramaticalmente corretas, mas técnicamente imprecisas devido à sua falta de conhecimento específico do domínio.

-

Solução do Agente IA: Um agente IA pode integrar o LLM com dicionários e glosários especializados, e até mesmo conectá-lo a expertos na matéria para retorno em tempo real, garantindo que a tradução final é tanto lingüísticamente correta quanto técnicamente confiável.

4. quebrando barreiras: conectando LLMs ao mundo real

-

O Problema: Um LLM projetado para controle de casa inteligente pode ter dificuldade em adaptar-se às rotinas e preferências mudando de um usuário.

-

Solução do Agente IA: Um agente IA pode conectar o LLM a sensores, dispositivos inteligentes e calendários do usuário. Analisando padrões de comportamento do usuário, o LLM pode aprender a antecipar necessidades, ajustar automaticamente configurações de iluminação e temperatura e até mesmo sugerir playlists de música personalizados baseados na hora do dia e na atividade do usuário.

5. Da Imitação à Inovação: Expandindo a Criatividade do LLM

-

O Problema: Um LLM incumbido com a composição de música pode criar peças que soam derivadas ou que carecem de profundidade emocional, já que ele primariamente depende de padrões encontrados em seus dados de treinamento.

-

A Solução de Agente AI: Um agente AI pode conectar o LLM a sensores de feedback biológico que medem as respostas emocionais de um compositor a elementos musicais diferentes. Incorporando essa feedback em tempo real, o LLM pode criar música que não é apenas tecnicamente competente mas também evoca emoções e é original.

A integração de agentes AI como melhoradores de LLM (Large Language Models) não é apenas uma melhoria incremental — ela representa uma expandição fundamental do que a inteligência artificial pode alcançar. Atendendo as limitações inerentes aos LLM tradicionais, como sua base de conhecimento estática, o limitado autocontrole de decisões e o ambiente operacional isolado, os agentes AI permitem que estes modelos funcionem ao seu potencial total.

Com a evolução da tecnologia AI, o papel de agentes AI no melhoramento de LLM se tornará cada vez mais crítico, não apenas em expandir as capacidades destes modelos mas também em redefinir os limites da própria inteligência artificial. Essa fusão está abrindo caminho para a próxima geração de sistemas AI, capazes de raciocínio autônomo, adaptação em tempo real e resolução de problemas inovadores em um mundo sempre em mudança.

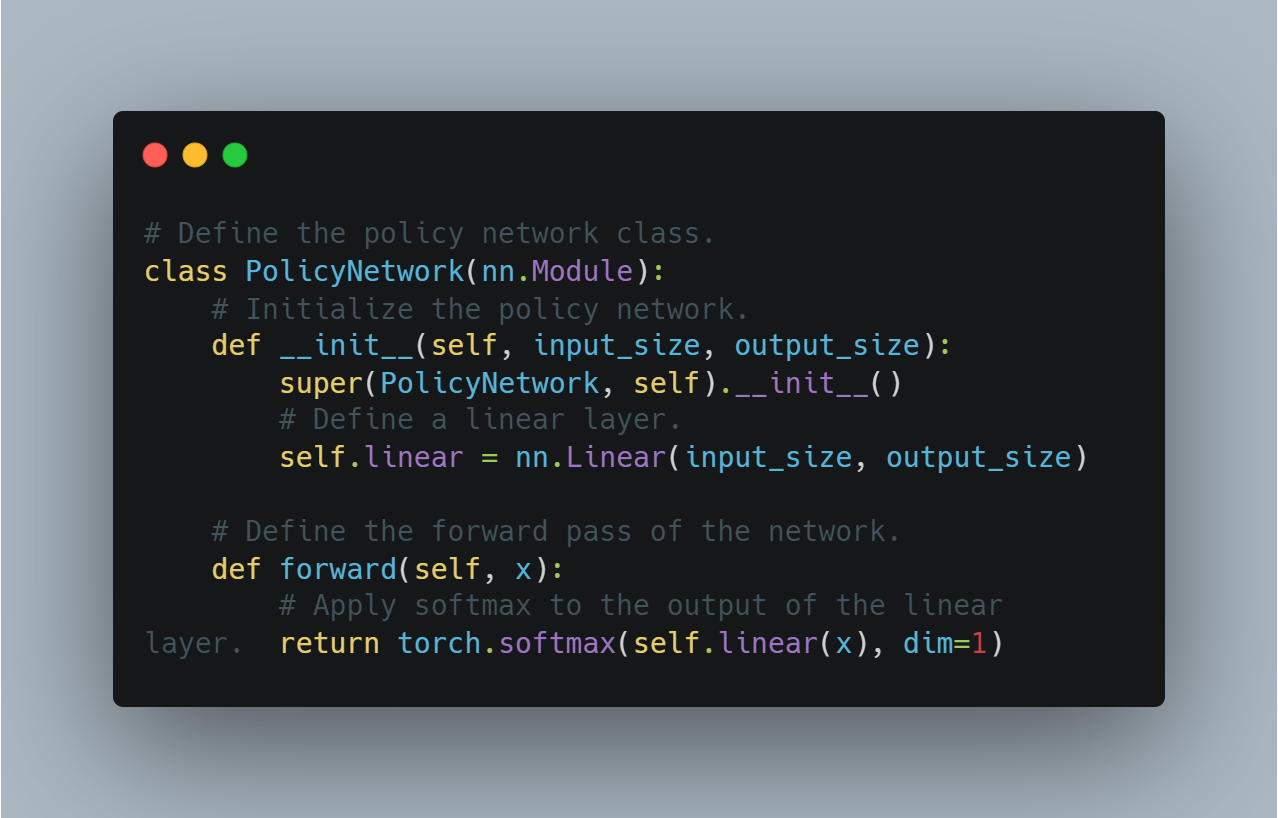

Capítulo 6: Projeto de Arquitetura para a Integração de Agentes AI com LLM

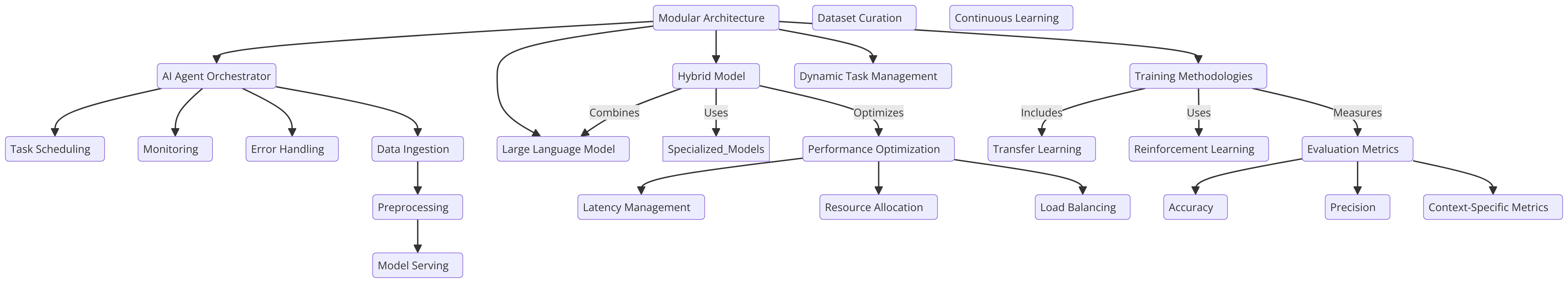

A integração de agentes AI com LLM depende do projeto de arquitetura, que é crucial para o melhoramento da tomada de decisão, da adaptabilidade e da escalabilidade. A arquitetura deve ser cuidadosamente projetada para permitir uma interação fluida entre os agentes AI e LLM, garantindo que cada componente funcione de maneira ótima.

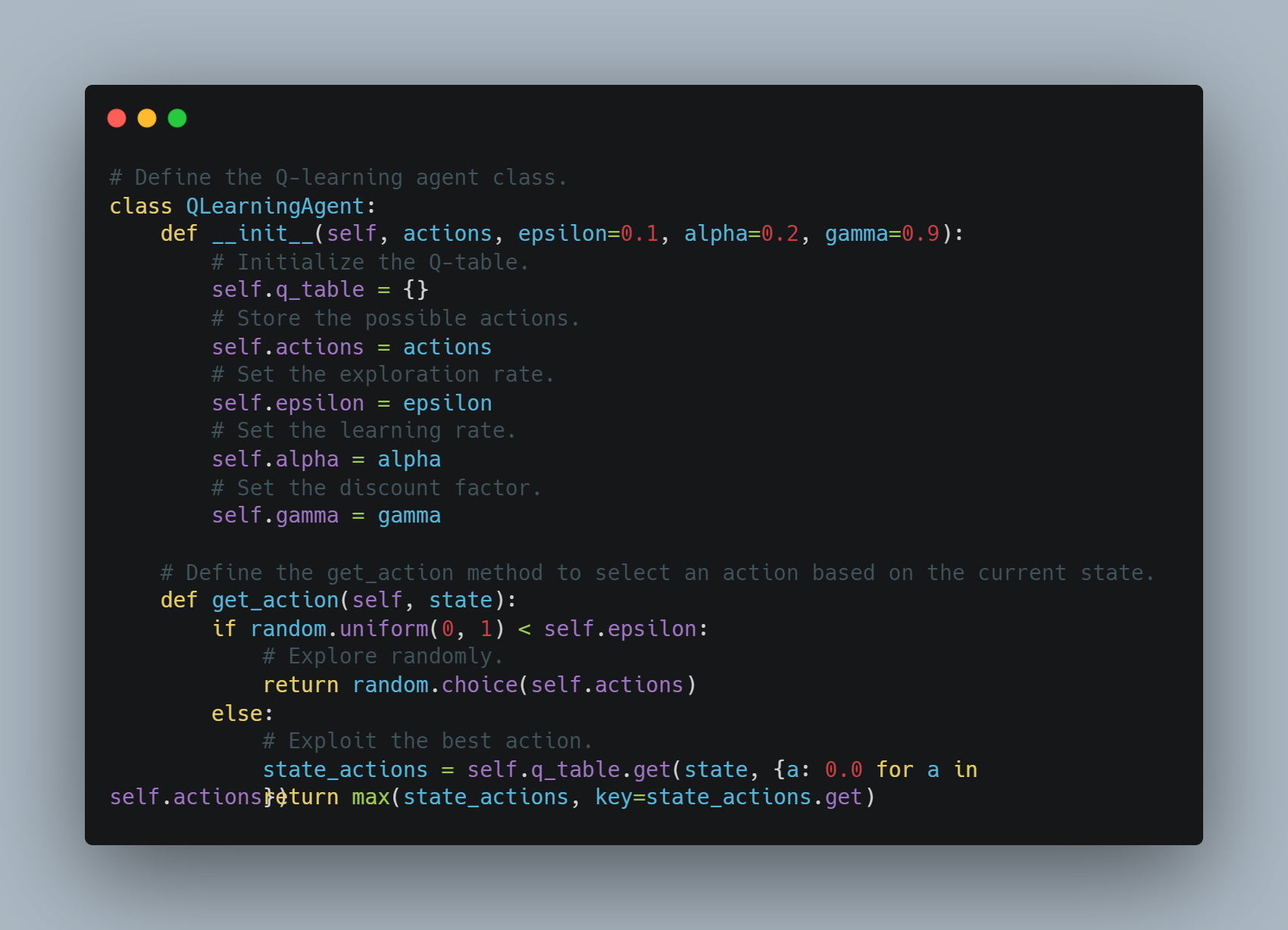

Uma arquitetura modular, onde o agente AI age como um orquestrador, direcionando as capacidades do LLM, é uma abordagem que apoia o gerenciamento dinâmico de tarefas. Este projeto aproveita as forças dos LLM em processamento de linguagem natural enquanto permite que o agente AI gerencie tarefas mais complexas, como raciocínio de vários passos ou decisões contextuais em ambientes em tempo real.

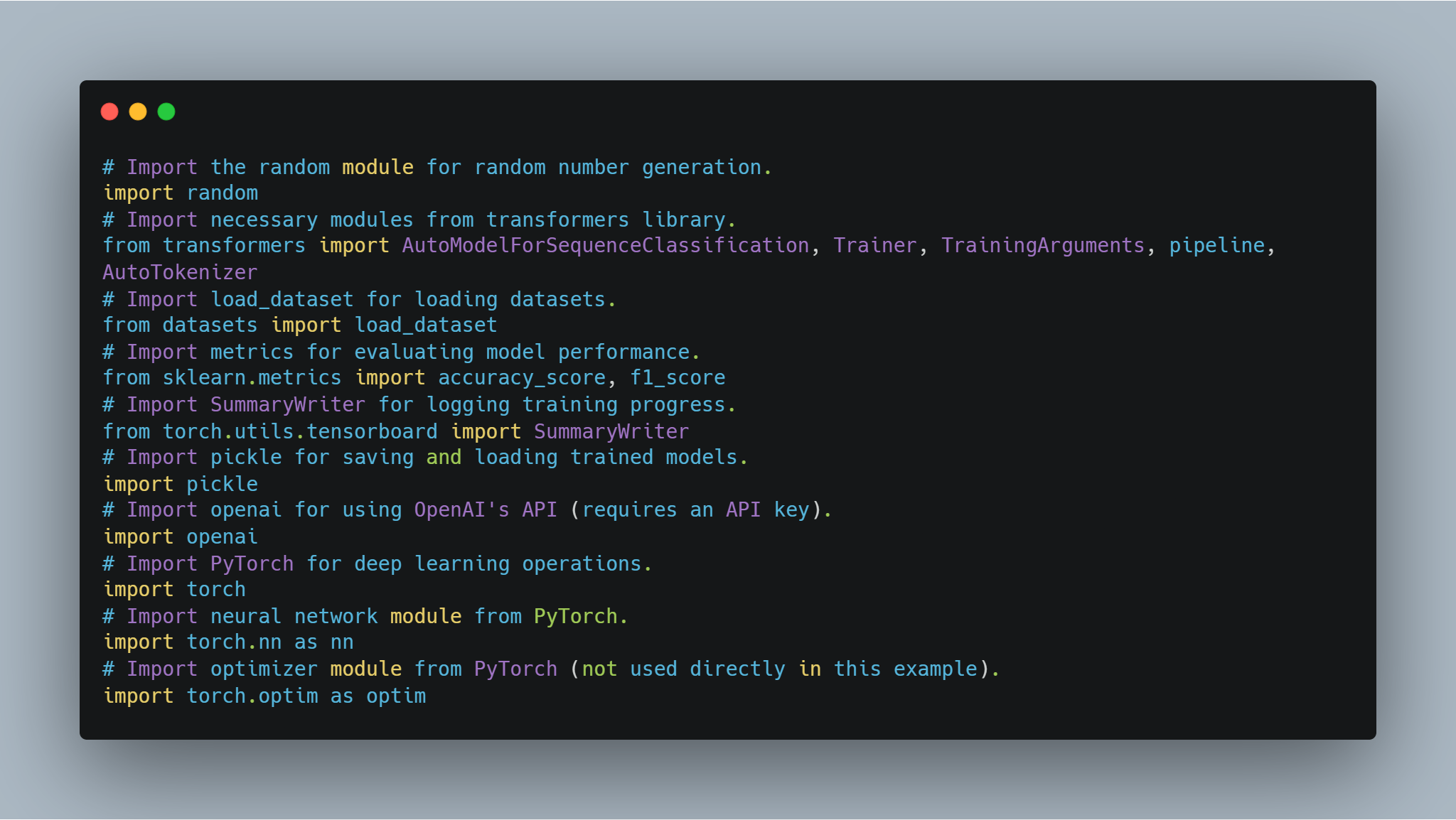

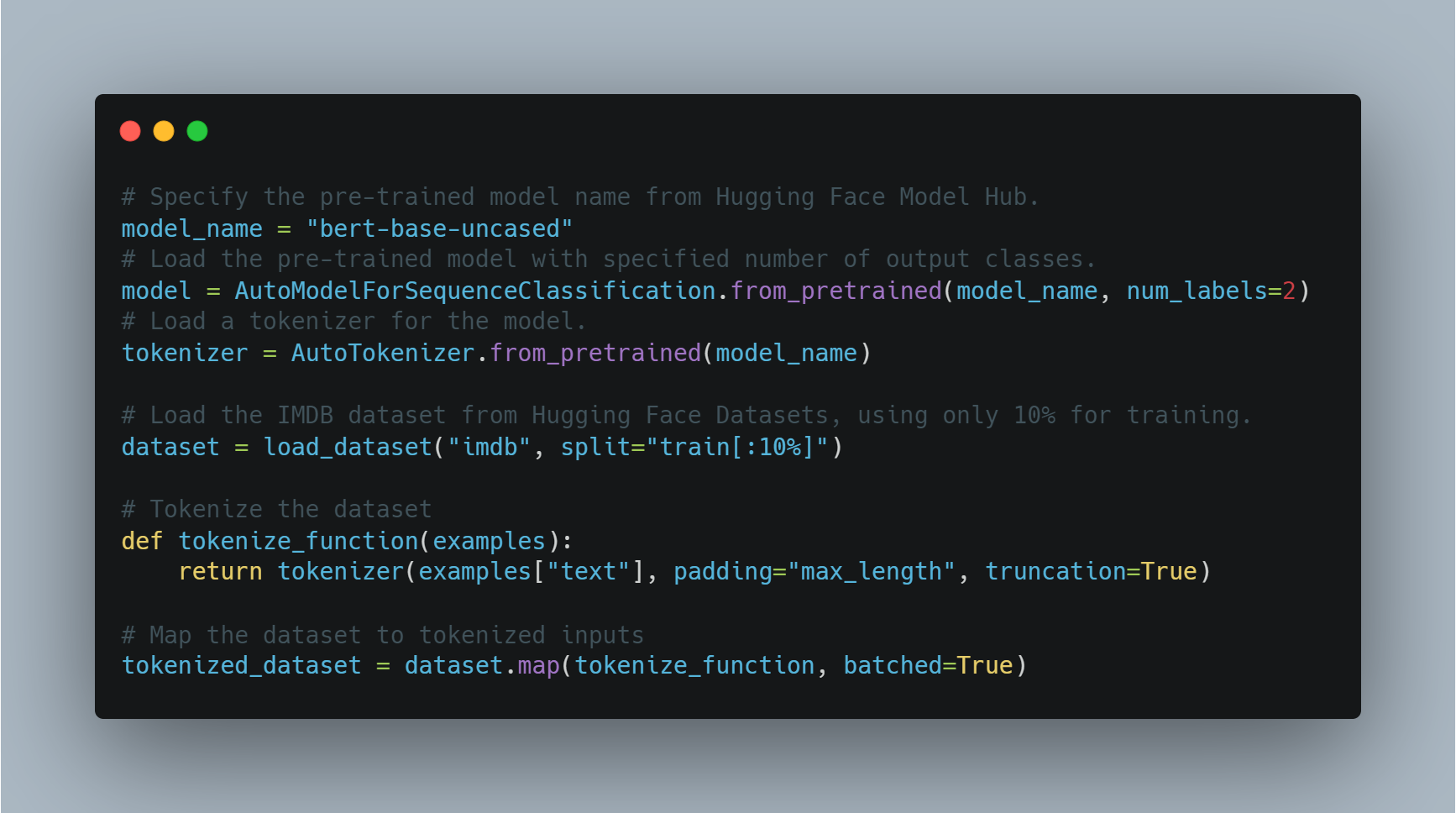

Alternativamente, um modelo híbrido, que combina LLMs com modelos especializados e finamente treinados, oferece flexibilidade, permitindo que o agente AI delegue tarefas ao modelo mais apropriado. Esta abordagem otimiza o desempenho e melhora a eficiência em uma ampla gama de aplicações, tornando-se particularmente eficaz em contextos operacionais diversos e variáveis (Liang et al., 2021).

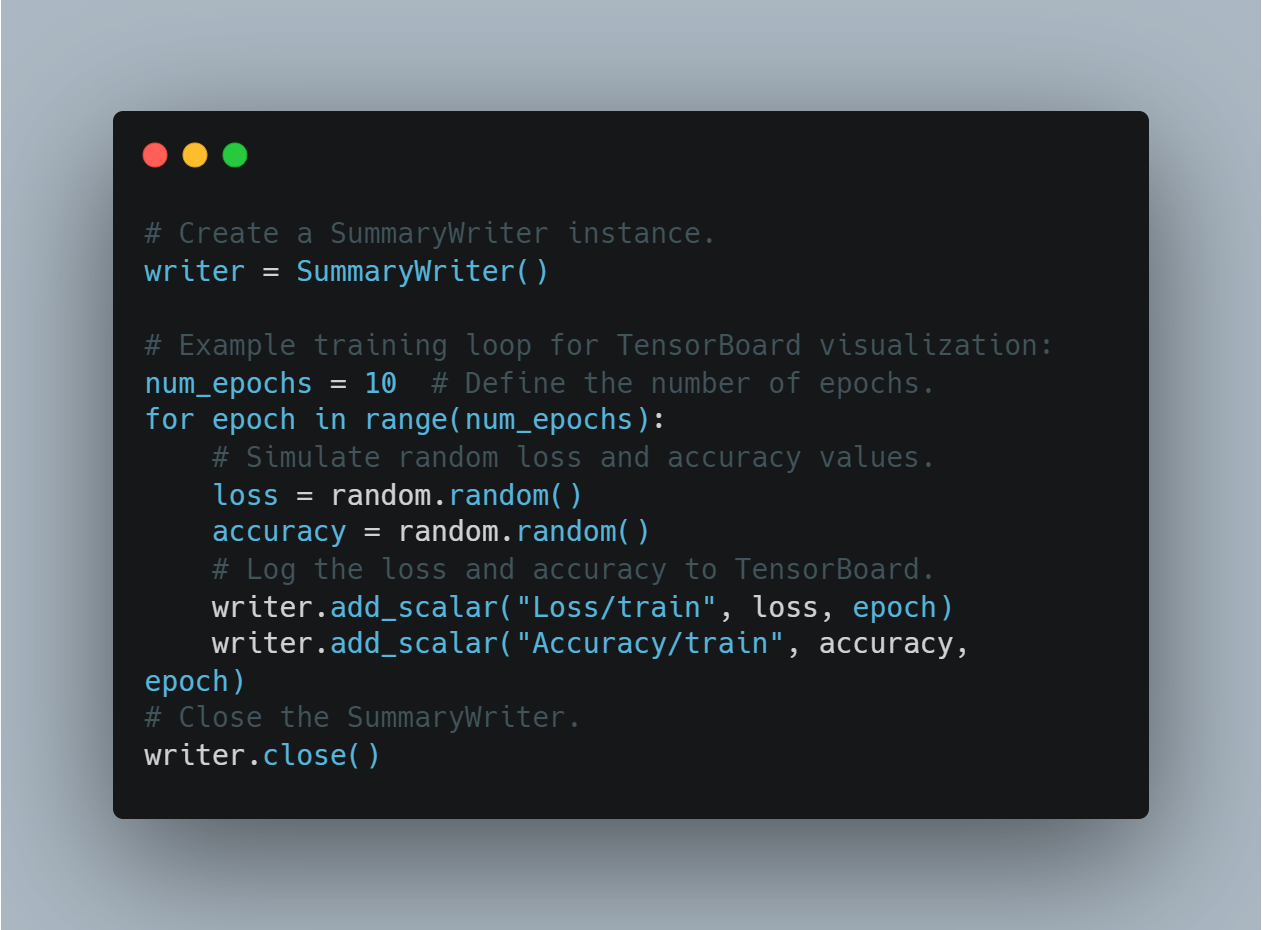

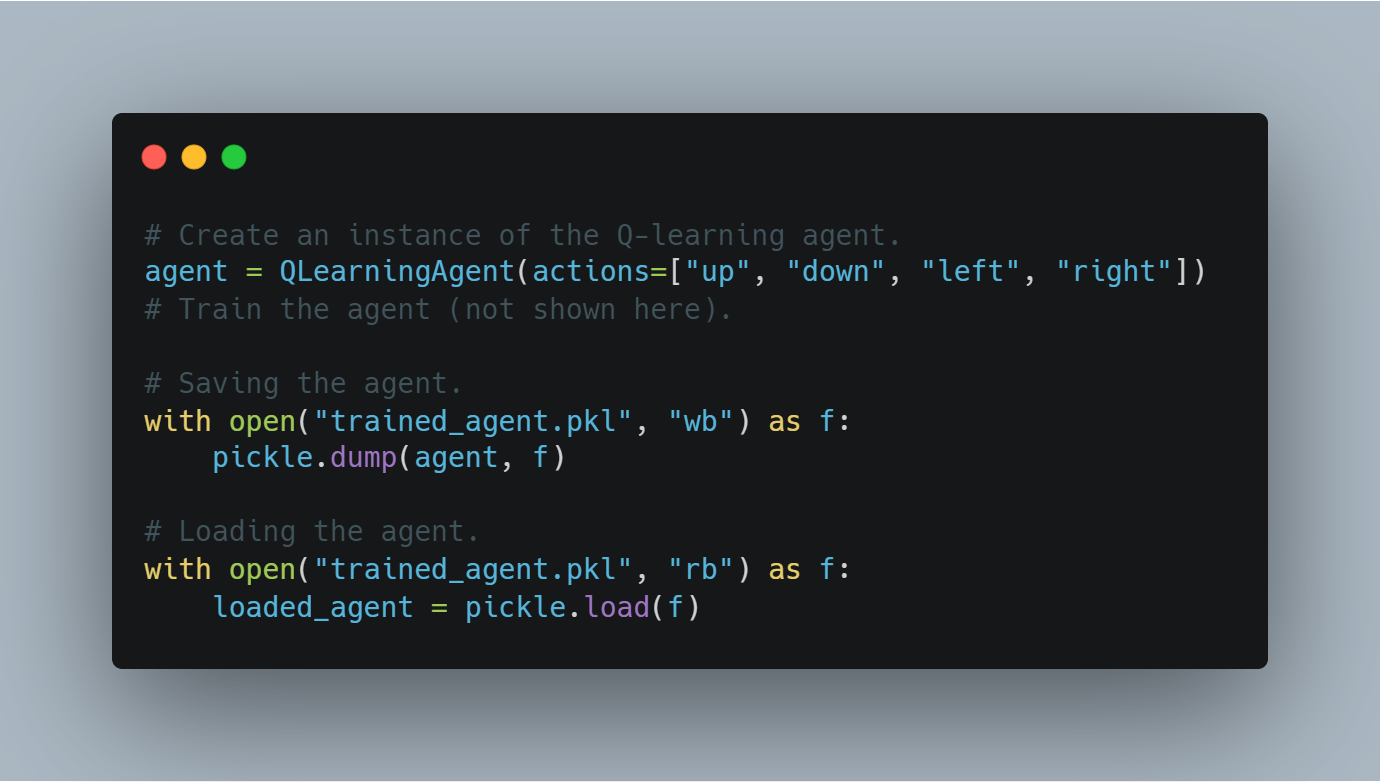

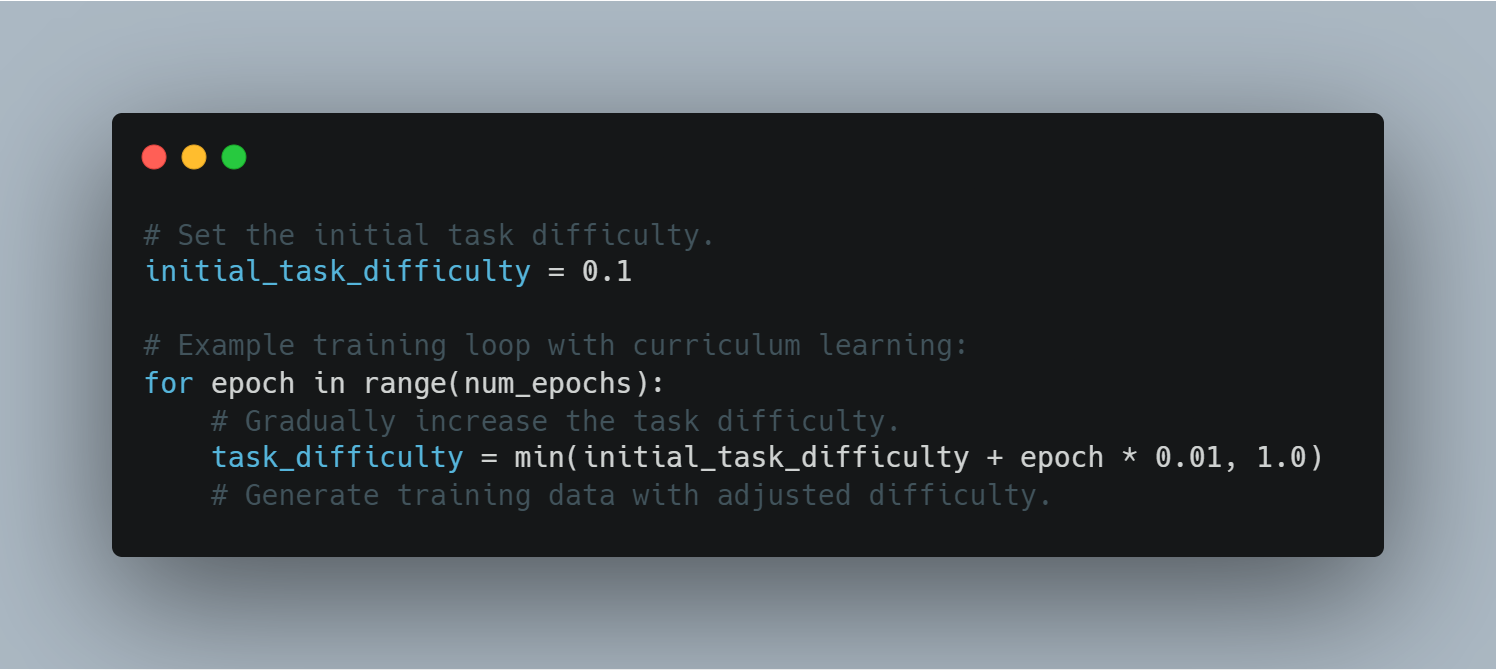

Metodologias de Treinamento e Melhores Práticas

O treinamento de agentes AI integrados com LLMs require uma abordagem sistemática que equilibra a generalização com a otimização específica das tarefas.

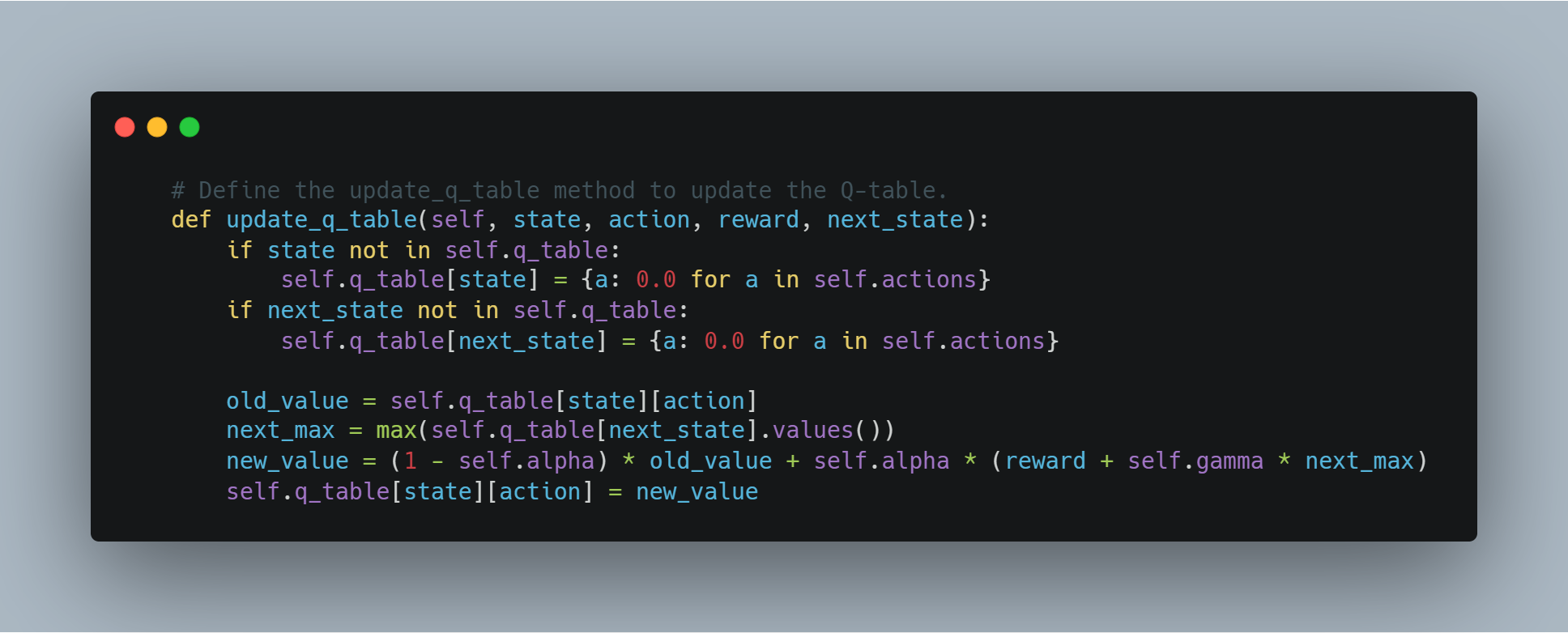

O transfer learning é uma técnica chave aqui, permitindo que um LLM que foi pré-treinado the um grande e diverso conjunto de dados seja finamente treinado em dados específicos do domínio relevantes às tarefas do agente AI. Este método mantém a base de conhecimento ampla do LLM enquanto o permite especializar em aplicações particulares, aumentando a eficácia global do sistema.