La rapida evoluzione dell’intelligenza artificiale (IA) ha creato una potente sinergia tra i grandi modelli di linguaggio (LLM) e gli agenti AI. Questo dinamico scambio è come una specie di storia di David e Golia (senza la lotta), dove gli agili agenti AI amplificano e migliorano le capacità dei colossali LLM.

Questo manuale esplorerà come gli agenti AI, simili a David, stanno supercaricando gli LLM – i nostri moderni Golia – per aiutare a rivoluzionare varie industrie e domini scientifici.

Indice

-

Capitolo 1: Introduzione agli agenti AI e ai modelli di linguaggio

-

Capitolo 2: La storia dell’intelligenza artificiale e degli agenti AI

-

Capitolo 3: dove i nostri AI-Agents risplendono il più luminoso

-

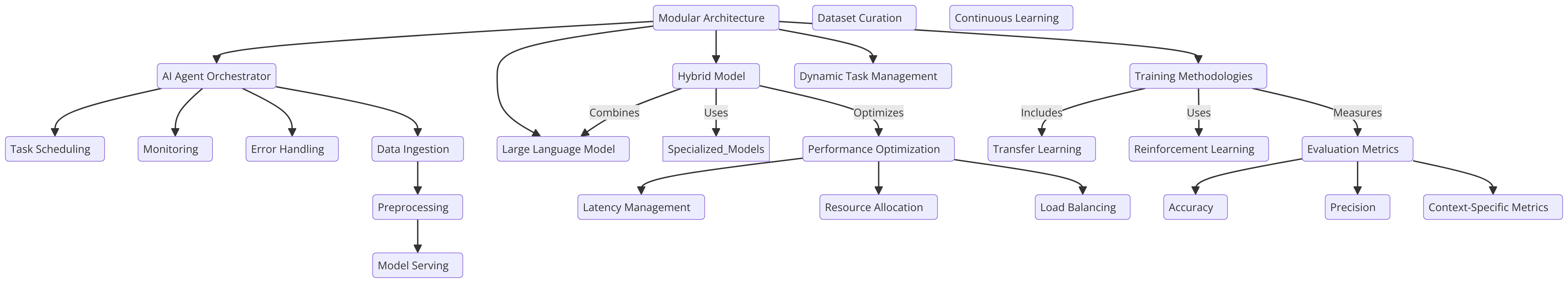

Capitolo 6: Progettazione architetturale per l’integrazione di AI Agents con LLMs

L’emergere degli agenti AI nei modelli linguistici

Gli agenti AI sono sistemi autonomi progettati per percepire l’ambiente, prendere decisioni e eseguire azioni per raggiungere obiettivi specifici. Quando integrati con le macro-macchine, questi agenti possono svolgere compiti complessi, ragionare sugli informazioni e generare soluzioni innovative.

Questa combinazione ha condotto a significative innovazioni in molti settori, dalla sviluppo software alla ricerca scientifica.

Impatto trasformativo su tutte le industrie

L’integrazione di agenti AI con macro-macchine ha avuto un profondo impatto su varie industrie:

-

Sviluppo Software: assistenti di codifica dotati di intelligenza artificiale, come GitHub Copilot, hanno dimostrato la capacità di generare fino al 40% del codice, portando a un incremento notevole del 55% nella velocità di sviluppo.

-

Educazione: assistenti di apprendimento dotati di intelligenza artificiale hanno mostrato promettere nell’ ridurre del 27% il tempo medio di completamento del corso, potenzialmente rivoluzionando il panorama educativo.

-

Trasporti: Con proiettazioni che prevedono che il 10% delle vetture sarà senza conducente entro il 2030, gli agenti AI autonomi negli autovetture guidate da soli stanno per rivoluzionare l’industria dei trasporti.

Avanzamento della Scoperta Scientifica

Una delle applicazioni più emozionanti degli agenti AI e delle MSL è nella ricerca scientifica:

-

Scoperta di medicinali: Gli agenti AI stanno accelerando il processo di scoperta di medicinali analizzando vasti dataset e predicendo candidati farmacologici potenziali, riducendo significativamente il tempo e i costi associati ai metodi tradizionali.

-

Fisica delle particelle: All’LHC del CERN, gli agenti AI sono impiegati per analizzare i dati delle collisioni di particelle, utilizzando la deteczione di anomalie per identificare indizi promettenti che potrebbero indicare l’esistenza di particelle non ancora scoperte.

-

Ricerca scientifica generale: Gli agenti AI stanno aumentando il ritmo e l’ambito delle scoperte scientifiche analizzando gli studi passati, identificando Collegamenti inaspettati e proponendo esperimenti nuovi.

La convergenza tra agenti artificiali e grandi modelli di linguaggio (LLM) sta spingendo l’intelligenza artificiale in una nuova era di capacità senza precedenti. Questo manuale completo esamina l’interazione dinamica tra queste due tecnologie, svelando il loro potenziale combinato per rivoluzionare le industrie e risolvere problemi complessi.

Tracceremo l’evoluzione dell’intelligenza artificiale dai suoi origini all’avvento degli agenti autonomi e del rise dei sofisticati LLM. Esploreremo anche considerazioni etiche, che sono fondamentali per lo sviluppo responsabile dell’intelligenza artificiale. Ciò ci aiuterà a garantire che queste tecnologie siano allineate con i nostri valori umani e con il benessere della società.

Al termine di questo manuale, otterrete una profonda comprensione del potere simbiotico degli agenti artificiali e degli LLM, così come le conoscenze e gli strumenti per sfruttare questa tecnologia all’avanguardia.

Capitolo 1: Introduzione agli Agenti Artificiali e ai Modelli di Linguaggio

Cos’è un Agente Artificiale e un Grande Modello di Linguaggio?

L’evoluzione rapida dell’intelligenza artificiale (IA) ha portato una sintesi trasformativa tra grandi modelli di linguaggio (LLM) e agenti artificiali.

Gli agenti AI sono sistemi autonomi progettati per percepire il loro ambiente, prendere decisioni e eseguire azioni per raggiungere obiettivi specifici. Mostrano caratteristiche come autonomia, percezione, reattività, ragionamento, decisione, apprendimento, comunicazione e orientamento verso gli obiettivi.

D’altro canto, le LLM sono sistemi AI sofisticati che utilizzano tecniche di apprendimento profondo e grandi dataset per comprendere, generare e predire testo umano-simile.

Questi modelli, come GPT-4, Mistral, LLama, hanno dimostrato capacità straordinarie in task di processamento del linguaggio naturale, inclusa la generazione del testo, la traduzione del linguaggio e gli agenti conversazionali.

Caratteristiche chiave degli agenti AI

Gli agenti AI hanno diverse caratteristiche che li distinguono dai software tradizionali:

-

Autonomia: Possono operare indipendentemente senza intervento umano costante.

-

Percezione: Gli agenti possono percepire e interpretare il loro ambiente attraverso varie entrate.

-

Reattività: Rispondono dinamicamente ai cambiamenti nel loro ambiente.

-

Ragionamento e decisioni: Gli agenti possono analizzare i dati e prendere scelte informate.

-

Apprendimento: migliorano le loro prestazioni con l’esperienza nel tempo.

-

Comunicazione: Gli agenti possono interagire con altri agenti o esseri umani usando diversi metodi.

-

Orientamento ai goal: sono progettati per raggiungere obiettivi specifici.

Capacità dei grandi modelli di linguaggio

I grandi modelli di linguaggio hanno dimostrato una vasta gamma di capacità, inclusi:

-

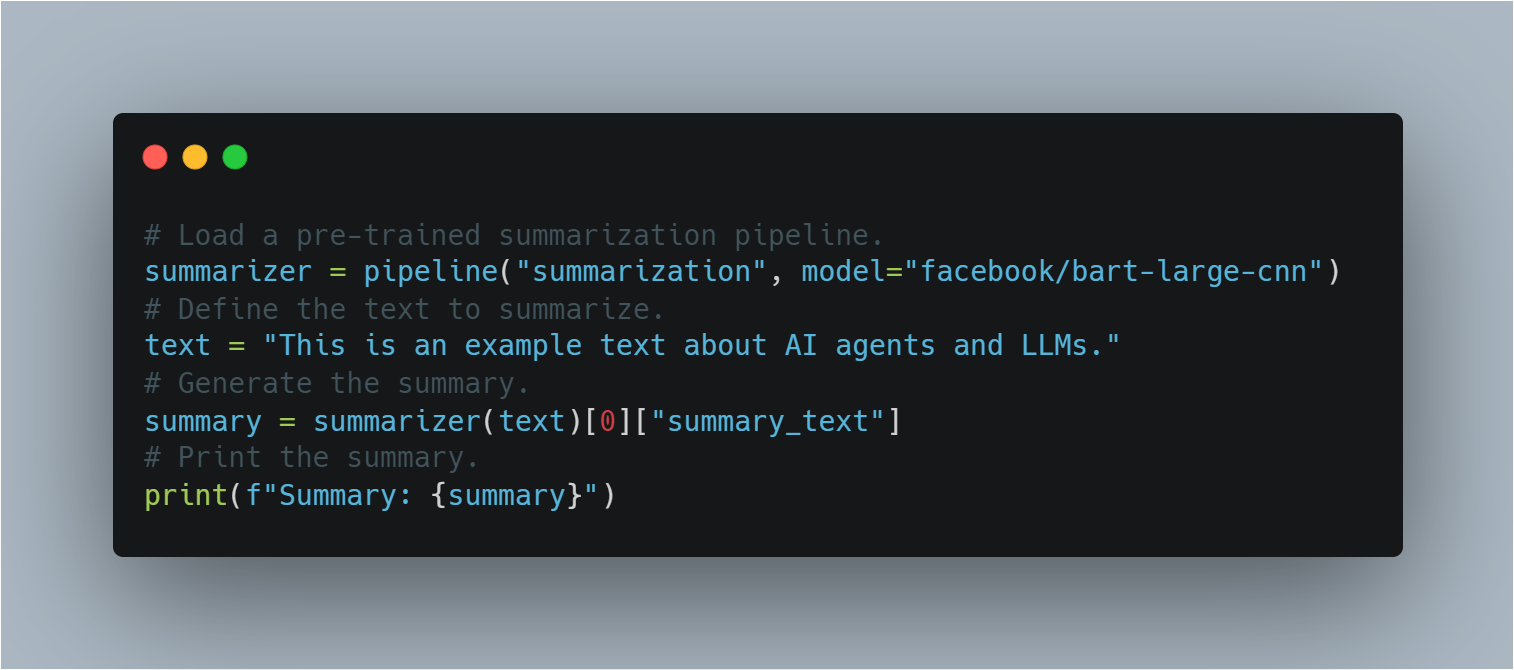

Generazione di testo: I grandi modelli di linguaggio possono produrre testo coerente e pertinente al contesto in base ai prompt.

-

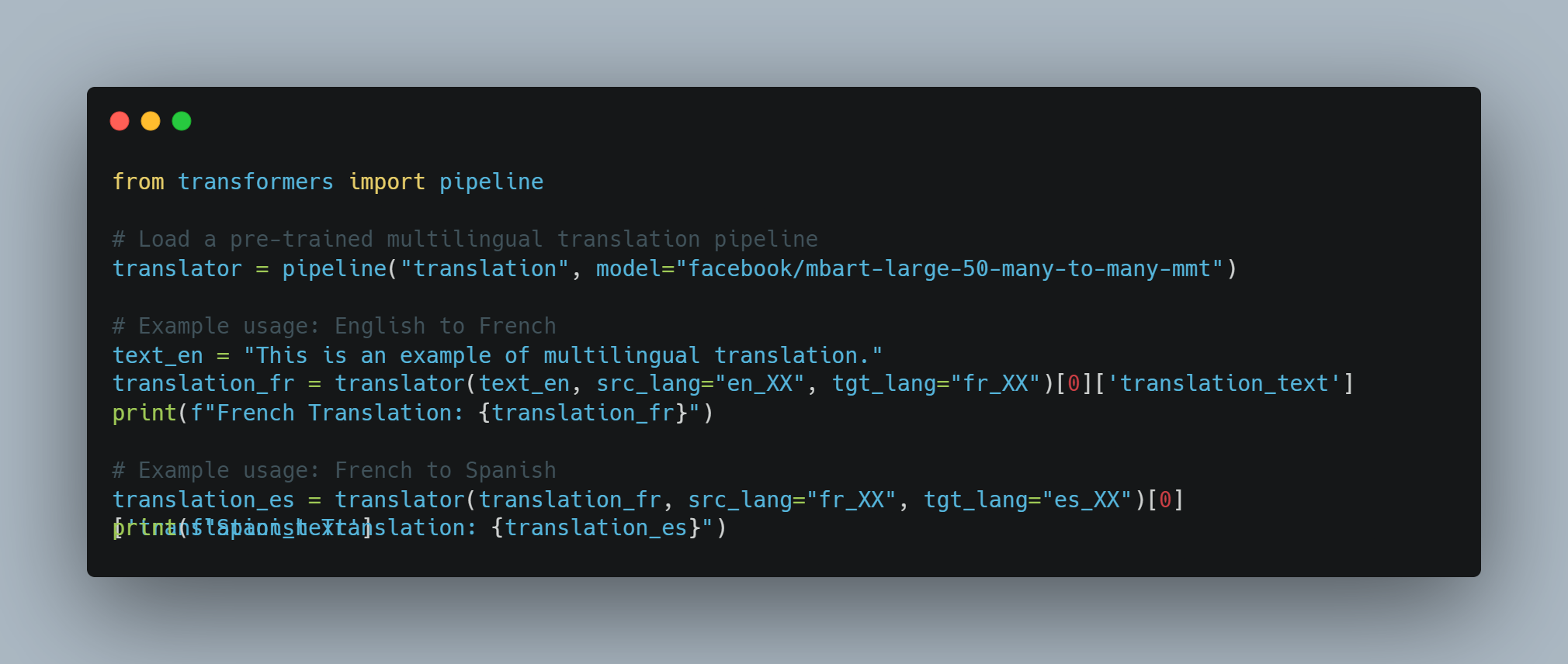

Traduzione di linguaggio: Possono tradurre testo tra differenti lingue con un alto grado di accuratezza.

-

Riassunto

: Gli LLM possono comporre riassunti concisi di testi lunghi conservando informazioni chiave.

-

Risposta alle domande: Possono fornire risposte accurate ai query basandosi sulla loro vasta base di conoscenze.

-

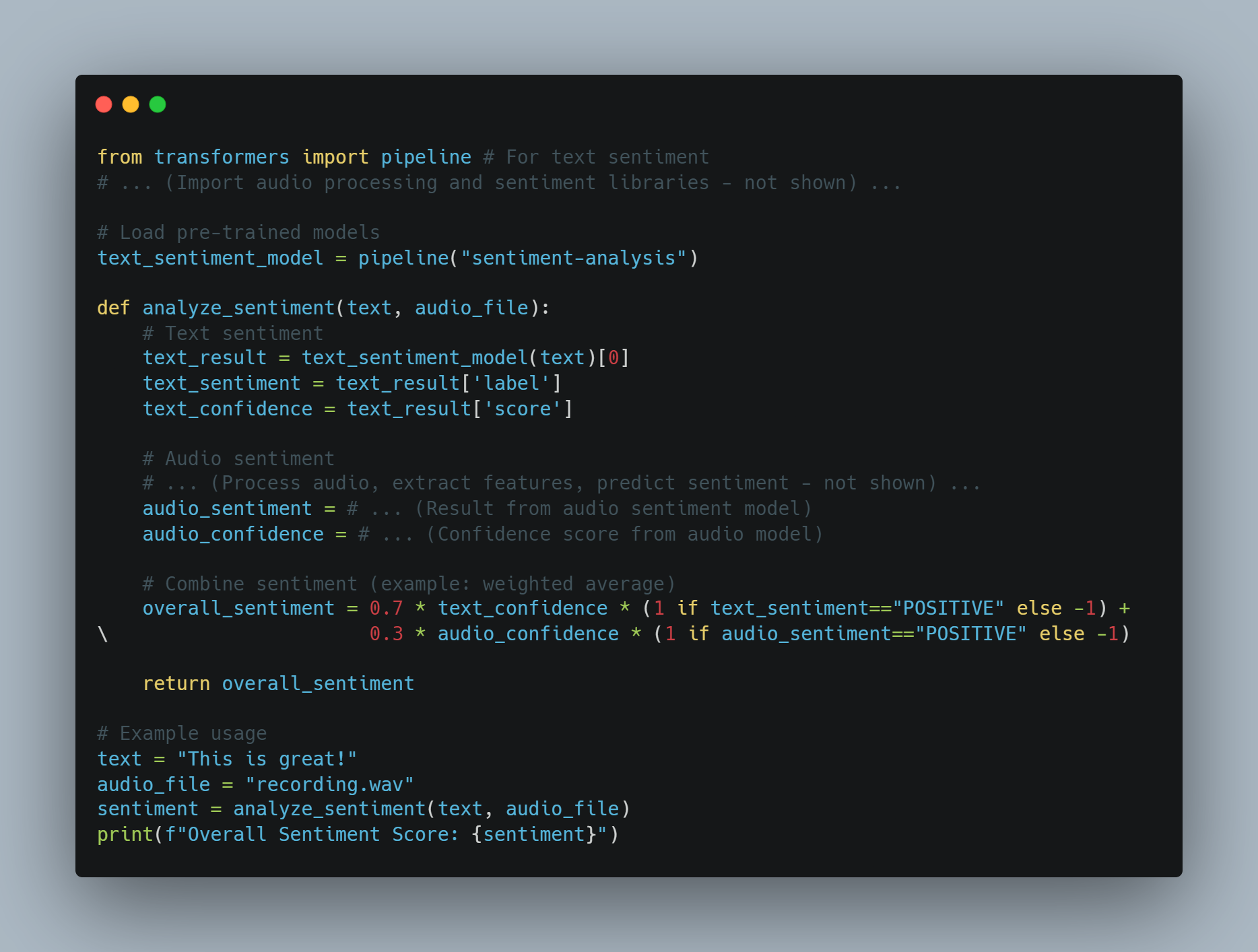

Analisi delle emozioni: Gli LLM possono analizzare e determinare l’emozione espressa in un dato testo.

-

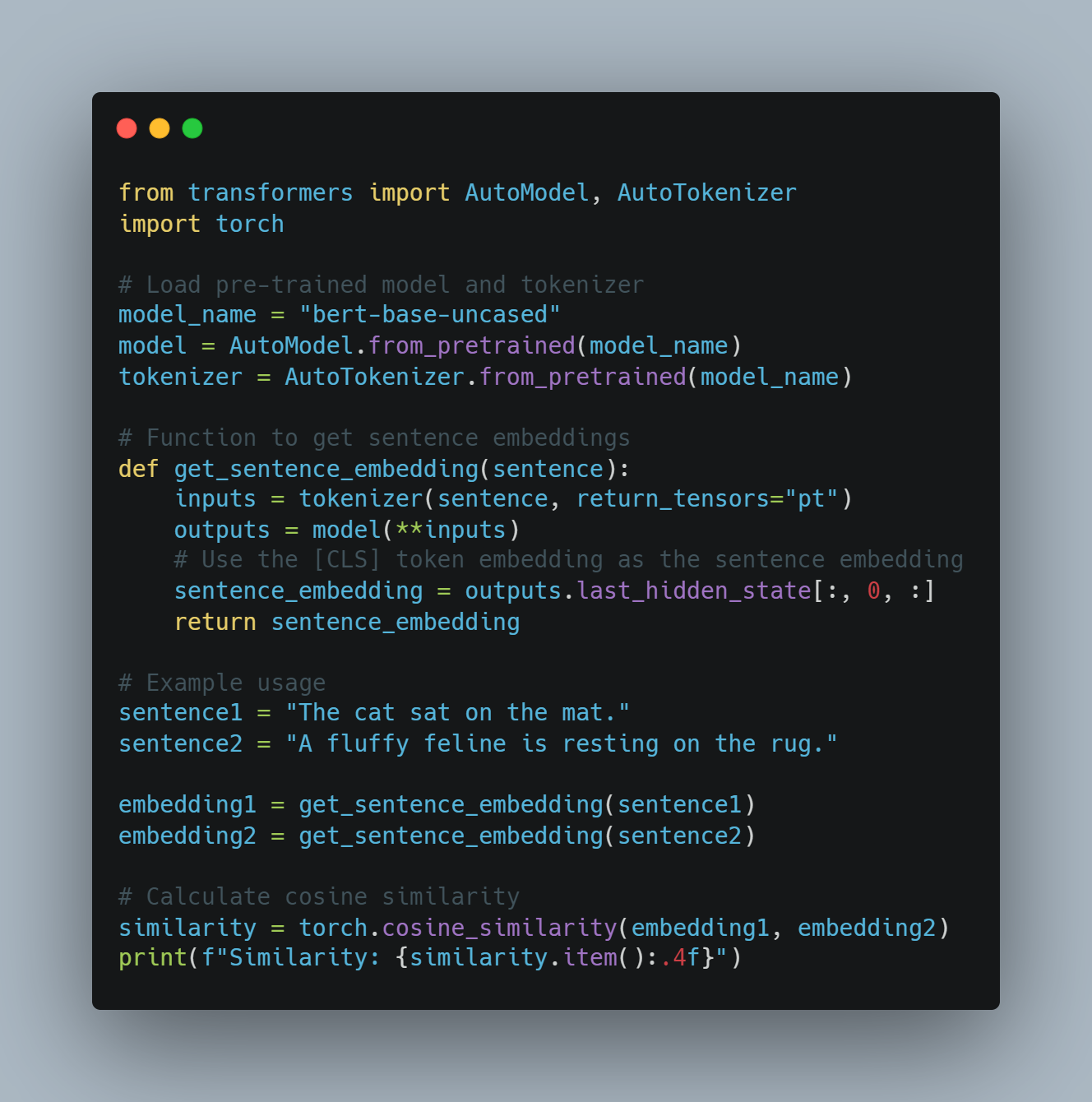

Generazione del codice: Possono generare snippet di codice o interi funzioni in base a descrizioni in linguaggio naturale.

Livelli degli agenti AI

Gli agenti AI possono essere classificati in diversi livelli in base alle loro capacità e complessità. Secondo un paper su arXiv, gli agenti AI sono classificati in cinque livelli:

-

Livello 1 (L1): Gli agenti AI come assistenti di ricerca, in cui gli scienziati impostano ipotesi e specificano compiti per raggiungere obiettivi.

-

Livello 2 (L2): agenti di intelligenza artificiale in grado di svolgere autonomamente compiti specifici all’interno di un ambito definito, come l’analisi dei dati o la semplice presa di decisioni.

-

Livello 3 (L3): agenti di intelligenza artificiale capaci di apprendere dall’esperienza e di adattarsi a nuove situazioni, migliorando i loro processi decisionali.

-

Livello 4 (L4): agenti di intelligenza artificiale con capacità avanzate di ragionamento e risoluzione dei problemi, in grado di gestire compiti complessi e multi-step.

-

Livello 5 (L5): agenti di intelligenza artificiale completamente autonomi che possono operare indipendentemente in ambienti dinamici, prendendo decisioni e agendo senza intervento umano.

Limitazioni dei modelli linguistici di grandi dimensioni

Costi di addestramento e vincoli di risorse

I modelli linguistici di grandi dimensioni (LLM) come GPT-3 e PaLM hanno rivoluzionato l’elaborazione del linguaggio naturale (NLP) sfruttando tecniche di deep learning e vasti set di dati.

Ma questi progressi sono accompagnati da un costo significativo. L’addestramento di LLM richiede risorse computazionali substantiali, spesso coinvolgendo migliaia di GPU e un consumo di energia esteso.

Secondo Sam Altman, CEO di OpenAI, il costo di addestramento di GPT-4 ha superato i 100 milioni di dollari. Questo si adatta alla scala e alla complessità del modello, con stime che suggeriscono che abbia circa 1 trilione di parametri. Tuttavia, altre fonti forniscono cifre differenti:

-

Un rapporto segreto ha indicato che i costi di addestramento di GPT-4 erano circa 63 milioni di dollari, considerando la potenza computazionale e la durata dell’addestramento.

-

A metà del 2023, alcune stime avevano suggerito che addestrare un modello simile a GPT-4 potesse costare circa 20 milioni di dollari e richiedere circa 55 giorni, riflettendo l’aumentata efficienza.

Il costo elevato dell’addestramento e della manutenzione di LLM limita la loro adozione diffusa e la loro scalabilità.

Limitazioni e Bias dei Dati

Il rendimento di LLM è fortemente dipendente dalla qualità e dalla diversità dei dati di addestramento. Nonostante siano stati addestrati su dataset di vasta dimensione, LLM possono ancora mostrare bias presenti nei dati, portando a risultati sbilanciati o inappropriati. Questi bias possono manifestarsi in varie forme, incluso gender, razziale e culturale, che possono perpetuare stereotipi e informazioni errate.

Anche la natura statica dei dati di addestramento significa che LLM potrebbero non essere aggiornati con le informazioni più recenti, limitando la loro efficacia in ambienti dinamici.

Specializzazione eComplessezza

Mentre LLM eccellono in task generali, spesso lottano con task specializzati che richiedono conoscenze specifiche del dominio e complessità di alto livello.

Per esempio, task nei campi come la medicina, il diritto e la ricerca scientifica richiedono una profonda comprensione deltermini specializzati e della ragione complessa, che LLM potrebbero non possedere in modo innato. Questa limitazione richiede l’integrazione di ulteriori livelli di esperto e la fine-tuning per renderli efficaci in applicazioni specializzate.

Limitazioni dell’Input e Sensoriali

Gli LLM processano prevalentemente input testuali, il che limita la loro capacità di interagire con il mondo in un modo multimodale. Mentre sono in grado di generare e comprendere testo, mancano della capacità di processare input visivi, uditivi o sensoriali direttamente.

Questa limitazione ostacola la loro applicazione in campi che richiedono integrazione sensoriale completa, come la robotica e i sistemi autonomi. Per esempio, un LLM non è in grado di interpretare i dati visivi da una macchina fotografica o i dati uditivi da un microfono senza strati di processamento aggiuntivi.

Constraints sulla Comunicazione e Interazione

Le capacità di comunicazione attuali degli LLM sono prevalentemente basate sul testo, che limita la loro capacità di partecipare a forme di comunicazione più immersive e interattive.

Ad esempio, sebbene gli LLM siano in grado di generare risposte testuali, non possono produrre contenuti video o rappresentazioni olografiche, che sono sempre più importanti nelle applicazioni di realtà virtuale e aumentata (leggete di più qui). Questa limitazione riduce l’efficacia degli LLM in ambienti che richiedono interazioni multimodali ricche.

Come Overcommer Limitations con gli AI Agents

Gli agenti AI offrono una soluzione promettente a molte delle limitazioni incontrate dagli LLM. Questi agenti sono progettati per operare autonomamente, percepire l’ambiente, prendere decisioni e svolgere azioni per raggiungere obiettivi specifici. Integrando agenti AI con LLM, è possibile ampliare le loro capacità e far fronte alle loro limitazioni innate.

-

Riduzione del carico di lavoro dell’utente: I nostri AI agenti sono in grado di mantenere il contesto attraverso varie interazioni, consentendo risposte più coerenti e pertinenti in base al contesto. Questa capacità è particolarmente utile nelle applicazioni che richiedono una memoria a lungo termine e continuità, come il servizio clienti e gli assistenti personali.

-

Integrazione multimodale: I nostri AI agenti possono incorporare input sensoriali da varie fonti, come telecamere, microfoni e sensori, consentendo a LLM di processare e rispondere ai dati visivi, uditivi e sensoriali. Questa integrazione è cruciale per le applicazioni in robotica e sistemi autonomi.

-

Conoscenza e Competenza Specializzate: Gli agenti AI possono essere raffinati con conoscenze specifiche del dominio, migliorando la capacità di LLM di svolgere compiti specializzati. Questo approcio consente la creazione di sistemi esperti in grado di gestire domande complesse in campi quali la medicina, la legge e la ricerca scientifica.

-

Comunicazione Interattiva e Immersiva: Gli agenti AI possono facilitare forme più immerse di comunicazione generando contenuti video, controllando display holografici e interagendo con ambienti virtuali e aumentati reali. questa capacità estende l’applicazione di LLM in campi che richiedono interazioni multimodali ricche.

Sebbene i grandi modelli di linguaggio abbiano dimostrato capacità notevoli nell’elaborazione del linguaggio naturale, non sono privi di limitazioni. I costi di training elevati, i bias dati, i problemi di specializzazione, le limitazioni sensoriali e le limitazioni di comunicazione presentano significative barriere.

Ma l’integrazione di agenti AI offre un percorso viabile per superare queste limitazioni. Utilizzando le peculiarità degli agenti AI, è possibile ampliare la funzionalità, l’adattabilità e l’applicabilità di LLM, aprendo la strada a sistemi AI più avanzati e versatile.

Capitolo 2: La Storia dell’Intelligenza Artificiale e degli AI-Agenti

La genesi dell’intelligenza artificiale

Il concetto di intelligenza artificiale (IA) ha radici che si estendono ben oltre l’era digitale moderna. L’idea di creare macchine capaci di ragionare come gli umani può essere ricondotta ai miti antichi e ai dibattiti filosofici. Ma l’inizio formale della IA come disciplina scientifica è avvenuto nel mezzo del ventesimo secolo.

La Conferenza di Dartmouth del 1956, organizzata da John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon, è generalmente considerata come il luogo di nascita dell’intelligenza artificiale come campo di studio. Questo evento storico ha riunito i principali studiosi per esplorare il potenziale di creare macchine in grado di simulare l’intelligenza umana.

Ottimismo iniziale e l’Era dell’Inverno dell’IA

Gli anni iniziali della ricerca sull’intelligenza artificiale erano caratterizzati da un ottimismo incontenibile. I ricercatori hanno fatto progressi significativi nell’sviluppo di programmi capaci di risolvere problemi matematici, giocare a giochi e persino impegnarsi in elaborazione del linguaggio naturale di base.

Ma questo entusiasmo iniziale è stato mitigato dalla realizzazione che la creazione di macchine davvero intelligenti era molto più complessa di quanto si fosse immaginato inizialmente.

Gli anni ’70 e ’80 hanno visto un periodo di riduzione del finanziamento e dell’interesse nella ricerca sull’intelligenza artificiale, comunemente denominato “Era dell’Inverno dell’IA“. Questo calo è stato principalmente dovuto al fallimento degli sistemi AI di non raggiungere le aspettative altisonanti dei pionieri iniziali.

Dai sistemi basati su regole alla machine learning

L’Era degli Sistemi Esperti

Gli anni ’80 hanno assistito ad un risveglio dell’interesse per l’intelligenza artificiale, principalmente guidato dalla creazione degli sistemi esperti. Questi programmi basati su regole erano progettati per emulare i processi decisionali degli esperti umani in determinati domini.

Sistemi esperti hanno trovato applicazioni in vari campi, incluso la medicina, le finanze e l’ingegneria. Ma erano limitati dalla loro incapacità di imparare dalla esperienza o di adattarsi a nuove situazioni fuori dalla loro regola programmata.

La rivoluzione dell’apprendimento automatico

Le limitazioni dei sistemi basati su regole hanno aperto la strada ad un cambiamento di paradigma verso l’apprendimento automatico. Questo approcio, che è stato messo in evidenza negli anni ’90 e 2000, si concentra sullo sviluppo di algoritmi che possono imparare da e fare previsioni o decisioni basate su dati.

Tecniche di apprendimento automatico, come le reti neurali e i supporto vettore macchine, hanno dimostrato un successo notevole in compiti come la riconoscimento di pattern e la classificazione dei dati. L’avvento di grandi quantità di dati e la potenza computazionale aumentata hanno ulteriormente accelerato lo sviluppo e l’applicazione di algoritmi di apprendimento automatico.

L’emergenza di agenti AI autonomi

Dall’IA stretta all’IA generale

Mentre le tecnologie dell’intelligenza artificiale hanno continuato ad evolversi, i ricercatori hanno iniziato a esplorare la possibilità di creare sistemi più versatili e autonomi. Questo cambiamento ha segnato il passaggio dall’IA stretta, progettata per compiti specifici, all’interesse per l’intelligenza artificiale generale (AGI).

AGI si propone di sviluppare sistemi in grado di svolgere qualsiasi compito intellettuale che un essere umano può fare. Mentre l’AGI vera e propria rimane un obiettivo lontano, sono stati fatti progressi significativi nella creazione di sistemi AI più flessibili e adattabili.

Il ruolo dell’apprendimento profondo e delle reti neurali

L’emergere dell’apprendimento profondo, un sottoinsieme dell’apprendimento automatico basato sulle reti neurali, ha giocato un ruolo chiave nell’avanzamento del campo dell’IA.

Algoritmi di apprendimento profondo, ispirati dalla struttura e dalla funzione del cervello umano, hanno dimostrato capacità notevoli in aree come la riconoscenza dell’immagine e del suono, il processamento del linguaggio naturale e il gioco di giochi. Questi progressi hanno fatto scuola per lo sviluppo di AI autonomi più sofisticati.

Caratteristiche e tipi di agenti AI

Gli agenti AI sono sistemi autonomi in grado di percepire il loro ambiente, prendere decisioni e compiere azioni per raggiungere obiettivi specifici. Possiedono caratteristiche quali l’autonomia, la percezione, la reattività, il ragionamento, la decisione, l’apprendimento, la comunicazione e l’orientamento verso gli obiettivi.

Esistono diversi tipi di agenti AI, ognuno con capacità uniche:

-

Agenti semplici a riflesso: Rispondono a specifici stimoli in base a regole predefinite.

-

Agenti di riflesso basati su modelli: Mantengono un modello interno dell’ambiente per la decisione.

-

Agenti basati su obiettivi: Eseguono azioni per raggiungere obiettivi specifici.

-

Agenti basati sulla utility: Considerano gli esiti potenziali e scelgono azioni che massimizzano l’utilità attesa.

-

Agenti in grado di apprendimento: Migliorano la decisione nel tempo tramite tecniche di apprendimento automatico.

Sfide e considerazioni etiche

Con l’aumento dell’avanzamento e dell’autonomia dei sistemi AI, vengono considerazioni critiche per assicurare che l’uso rimanga entro i limiti socialmente accettati.

I grandi modelli di linguaggio (LLM), in particolare, agiscono come supercaricatori della produttività. Ma questo solleva una domanda cruciale: cosa questi sistemi superchargeranno – un buon intento o un maleintento? Quando l’intenzione dietro l’uso dell’AI è maligna, diventa imperativo per questi sistemi di rilevare tale abuso utilizzando varie tecniche di NLP o altri strumenti a nostra disposizione.

Gli ingegneri di LLM hanno accesso a una gamma di strumenti e metodologie per affrontare questi挑战:

-

Analisi del sentimento: Attraverso l’utilizzo dell’analisi del sentimento, gli LLM possono valutare l’tono emotivo del testo per rilevare linguaggio dannoso o aggressivo, aiutando a identificare potenziali abusi nelle piattaforme di comunicazione.

-

Filtrazione del contenuto: Strumenti come il filtraggio per parole chiave e il riconoscimento di schemi possono essere utilizzati per prevenire la generazione o la diffusione di contenuti dannosi, come discorsi di odio, informazioni non accurate o materiale esplicito.

-

Strumenti di rilevamento della bias: L’implementazione di framework di rilevamento del bias, come AI Fairness 360 (IBM) o Fairness Indicators (Google), può aiutare a identificare e mitigare il bias nei modelli di linguaggio, garantendo che i sistemi AI operino in maniera equa e equitativa.

-

Tecniche di spiegabilità

: Utilizzando strumenti di spiegabilità come LIME (Local Interpretable Model-agnostic Explanations) o SHAP (SHapley Additive exPlanations), gli ingegneri possono comprendere e spiegare i processi decisionali degli LLM, rendendo così più semplice la rilevazione e la correzione di comportamenti non intenzionali.

- Testing Adversariale: Simulando attacchi maligni o input dannosi, gli ingegneri possono sottoporre gli LLM a test di stress utilizzando strumenti come TextAttack o Adversarial Robustness Toolbox, identificando vulnerabilità che potrebbero essere sfruttate per scopi maligni.

- Guidelines e schemi etici per l’IA: Adottando linee guida etiche per lo sviluppo dell’IA, come quelle fornite dall’IEEE o dalla Partnership on AI, si può guidare la creazione di sistemi AI responsabili che prioritizzino il benessere della società.

Oltre a questi strumenti, ecco perché serve un Team Red dedicato per l’IA — team specializzati che spingono i LM (Large Models) ai loro limiti per rilevare buchi nelle loro difese. I Red Teams simulano scenario avversari e svelano vulnerabilità che potrebbero altrimenti passare inosservate.

Ma è importante riconoscere che la gente dietro il prodotto ha certamente l’effetto più forte su di esso. Molti degli attacchi e dei challenge che ci confrontiamo oggi esistevano già prima che fossero sviluppati i LM, sottolineando che l’elemento umano rimane centrale per garantire che l’IA sia utilizzata eticamente e responsabilmente.

L’integrazione di questi strumenti e tecniche nella pipeline di sviluppo, insieme ad un attivo Team Red, è essenziale per garantire che i LM siano utilizzati per potenziare positivamente i risultati mentre rilevano e prevengono il loro abuso.

Capitolo 3: Dove gli Agenti AI Risplendono di Più

Le Forze Uniche degli Agenti AI

Gli Agenti AI si distinguono grazie alla loro capacità di percepire autonomamente l’ambiente, prendere decisioni e eseguire azioni per raggiungere obiettivi specifici. Questa autonomia, unita alle capacità avanzate di apprendimento macchina, permette agli Agenti AI di svolgere compiti troppo complessi o troppo ripetitivi per gli umani.

Ecco i punti di forza chiave che rendono brillanti gli agenti IA:

-

Autonomia ed Efficienza: Gli agenti IA possono operare in modo indipendente senza costante intervento umano. Questa autonomia permette loro di gestire compiti 24/7, migliorando significativamente l’efficienza e la produttività. Ad esempio, i chatbot alimentati dall’IA possono gestire fino all’80% delle richieste di assistenza clienti di routine, riducendo i costi operativi e migliorando i tempi di risposta.

-

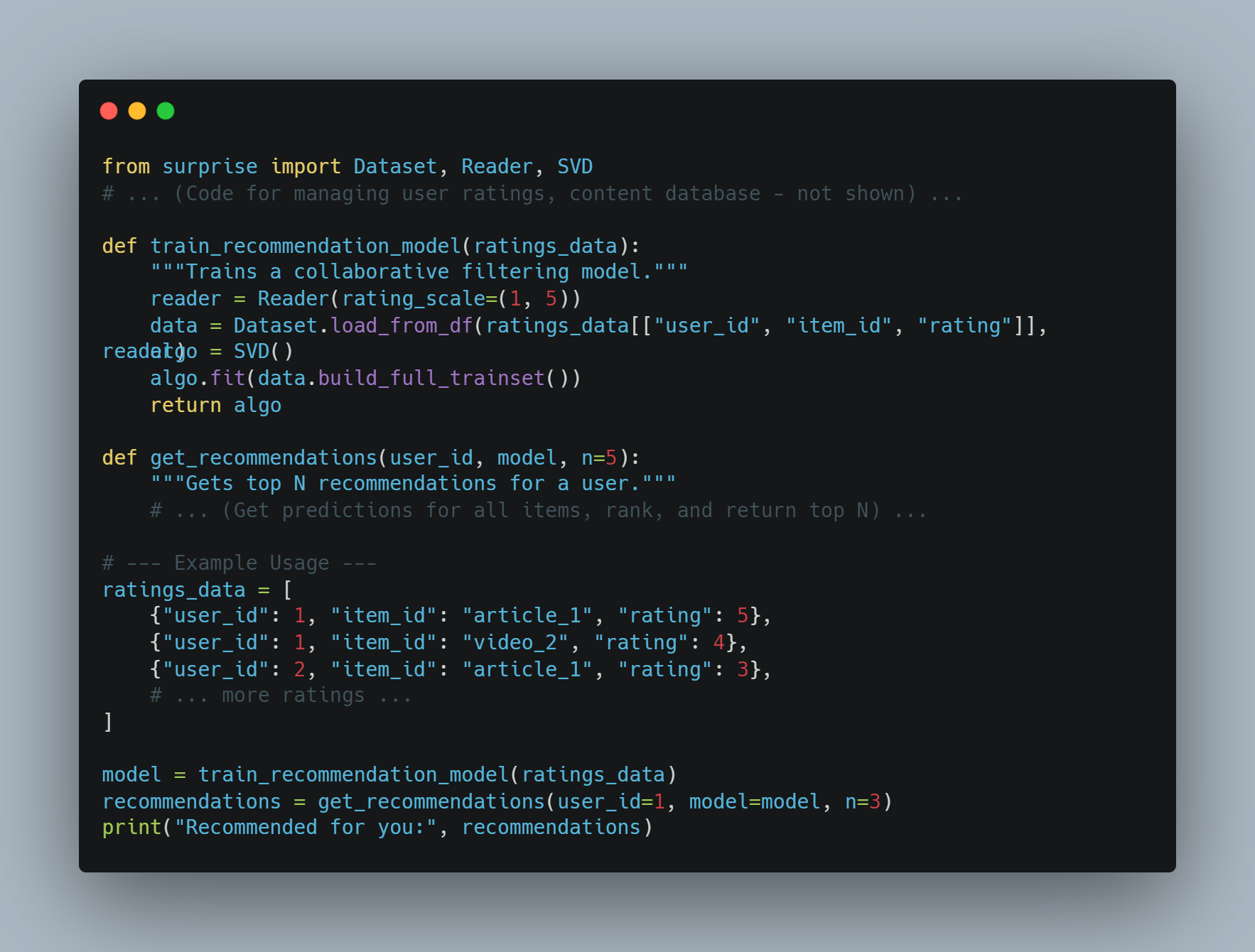

Processo Decisionale Avanzato: Gli agenti IA possono analizzare grandi quantità di dati per prendere decisioni informate. Questa capacità è particolarmente preziosa in settori come la finanza, dove i bot di trading IA possono aumentare notevolmente l’efficienza del trading.

-

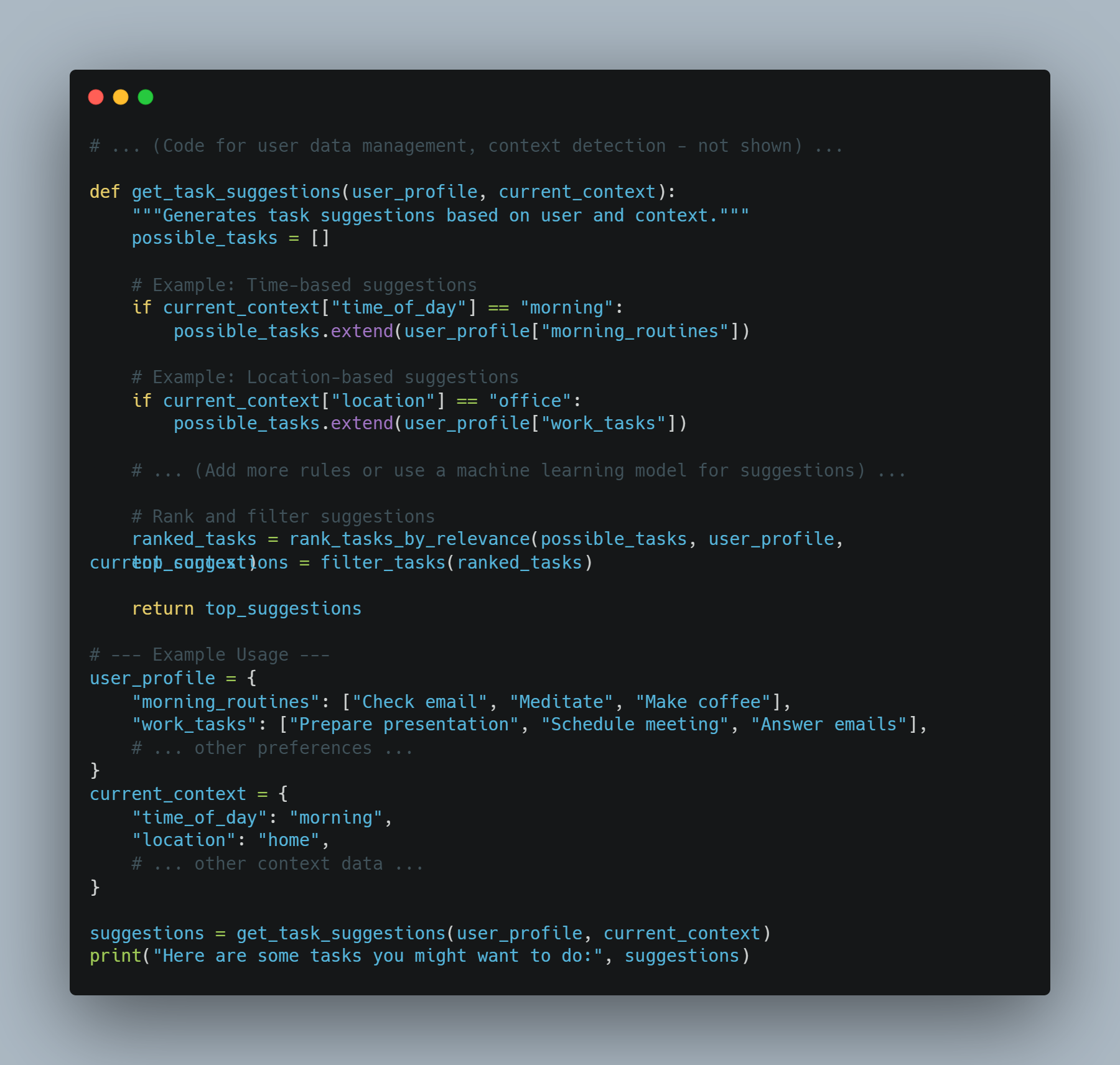

Apprendimento e Adattabilità: Gli agenti AI possono imparare dall’esperienza e adattarsi a nuove situazioni. Questa miglioramento continuo li consente di migliorare le loro performance nel tempo. Ad esempio, gli assistenti sanitari AI possono aiutare a ridurre gli errori diagnostici, migliorando i risultati dell’assistenza sanitaria.

-

Personalizzazione: Gli agenti AI possono offrire esperienze personalizzate analizzando il comportamento e le preferenze dell’utente. Il motore di raccomandazioni di Amazon, che genera il 35% delle sue vendite, è un esempio eclatante di come gli agenti AI possano migliorare l’esperienza utente e incrementare i ricavi.

Perché gli Agenti AI sono la Soluzione

Gli agenti AI offrono soluzioni a molti dei challenge affrontati dai software tradizionali e dai sistemi operati da esseri umani. Ecco perché sono la scelta preferita:

-

Scalabilità: Gli agenti AI possono scalare le operazioni senza incrementi proporzionali nei costi. Questa scalabilità è cruciale per le aziende che cercano di crescere senza aumentare significativamente il proprio personale o le spese operative.

-

Consistenza e affidabilità: Al contrario degli esseri umani, gli agenti AI non soffrono di stanchezza o inconsistenza. Possono svolgere attività ripetitive con alta precisione e affidabilità, garantendo un’efficienza costante.

-

Insight basati su dati: Gli agenti AI possono processare e analizzare grandi set di dati per scoprire pattern e insight che potrebbero essere persi dagli esseri umani. questa capacità è preziosa per la decisione in aree quali la finanza, la sanità e il marketing.

-

Risparmio di costi: Automatizzando compiti di routine, gli agenti di intelligenza artificiale possono ridurre la necessità di risorse umane, portando a significativi risparmi di costi. Ad esempio, i sistemi di rilevamento delle frodi alimentati da intelligenza artificiale possono risparmiare miliardi di dollari all’anno riducendo le attività fraudolente.

Condizioni necessarie per una buona performance degli agenti di intelligenza artificiale

Per garantire il corretto utilizzo e la buona performance degli agenti di intelligenza artificiale, devono essere soddisfatte determinate condizioni:

-

Obiettivi e casi d’uso chiari: Definire obiettivi specifici e casi d’uso è cruciale per il corretto utilizzo degli agenti di intelligenza artificiale. Questa chiarezza aiuta a stabilire aspettative e misurare il successo. Ad esempio, stabilire come obiettivo la riduzione del tempo di risposta del servizio clienti del 50% può guidare l’implementazione di chatbot basati su intelligenza artificiale.

-

Qualità Dati: Gli agenti AI si affidano a dati di alta qualità per l’addestramento e l’esecuzione. Assicurarsi che i dati siano accurate, rilevanti e aggiornati è essenziale per consentire agli agenti di prendere decisioni informate e di operare con efficacia.

-

Integrazione con Sistemi Esistenti: L’integrazione fluida con i sistemi esistenti e i flussi di lavoro è necessaria perché gli agenti AI funzionino al meglio. Questa integrazione garantisce che gli agenti AI possano accedere ai dati necessari e interagire con altri sistemi per svolgere le loro mansioni.

-

Monitoraggio Continuo e Ottimizzazione: Il monitoraggio regolare e l’ottimizzazione degli agenti AI sono cruciali per mantenere le loro prestazioni. Questo comporta il tracciamento di indicatori chiave di prestazione (KPIs) e la realizzazione di adeguati aggiustamenti in base alla feedback e ai dati di performance.

-

Considerazioni etiche e mitigazione dell’attribuzione pregiudiziale: affrontare le considerazioni etiche e mitigare i pregiudizi negli agenti AI è essenziale per garantire la correttezza e l’inclusività. L’adozione di misure per la rilevazione e la prevenzione del pregiudizio può aiutare a costruire la fiducia e a garantire un’implementazione responsabile.

Best Practices for Deploying AI Agents

Quando si implementano agenti AI, seguire le migliori pratiche può garantire il loro successo e l’efficacia:

-

Definire Obiettivi e Casi d’Uso: Identificare chiaramente i goal e i casi d’uso per l’implementazione di agenti AI. Questo aiuta a stabilire le aspettative e a misurare il successo.

-

Seleziona una piattaforma AI corretta

: Scegli una piattaforma AI che si adatta ai tuoi obiettivi, casi d’uso e infrastruttura esistente. Considera fattori come la capacità di integrazione, la scalabilità e il costo.

- Costruisci una base di conoscenza completa: Crea una base di conoscenza ben strutturata e precisa per consentire agli agenti AI di fornire risposte appropriate e affidabili.

- Assicurati un’integrazione fluida: Integra gli agenti AI con sistemi esistenti come il CRM e le tecnologie del call center per fornire unaesperienza clienti unificata.

- Addestra e ottimizza gli agenti AI: Addestra e ottimizza continuamente gli agenti AI utilizzando i dati dalle interazioni. Monitora il rendimento, identifica aree in cui migliorare e aggiorna i modelli appropriatamente.

-

Implementare Procedure di Escaleggiamento Appropriate: Stabilire protocolli per il trasferimento di chiamate complicate o emotive agli agenti umani, garantendo una transizione fluida e una risoluzione efficiente.

-

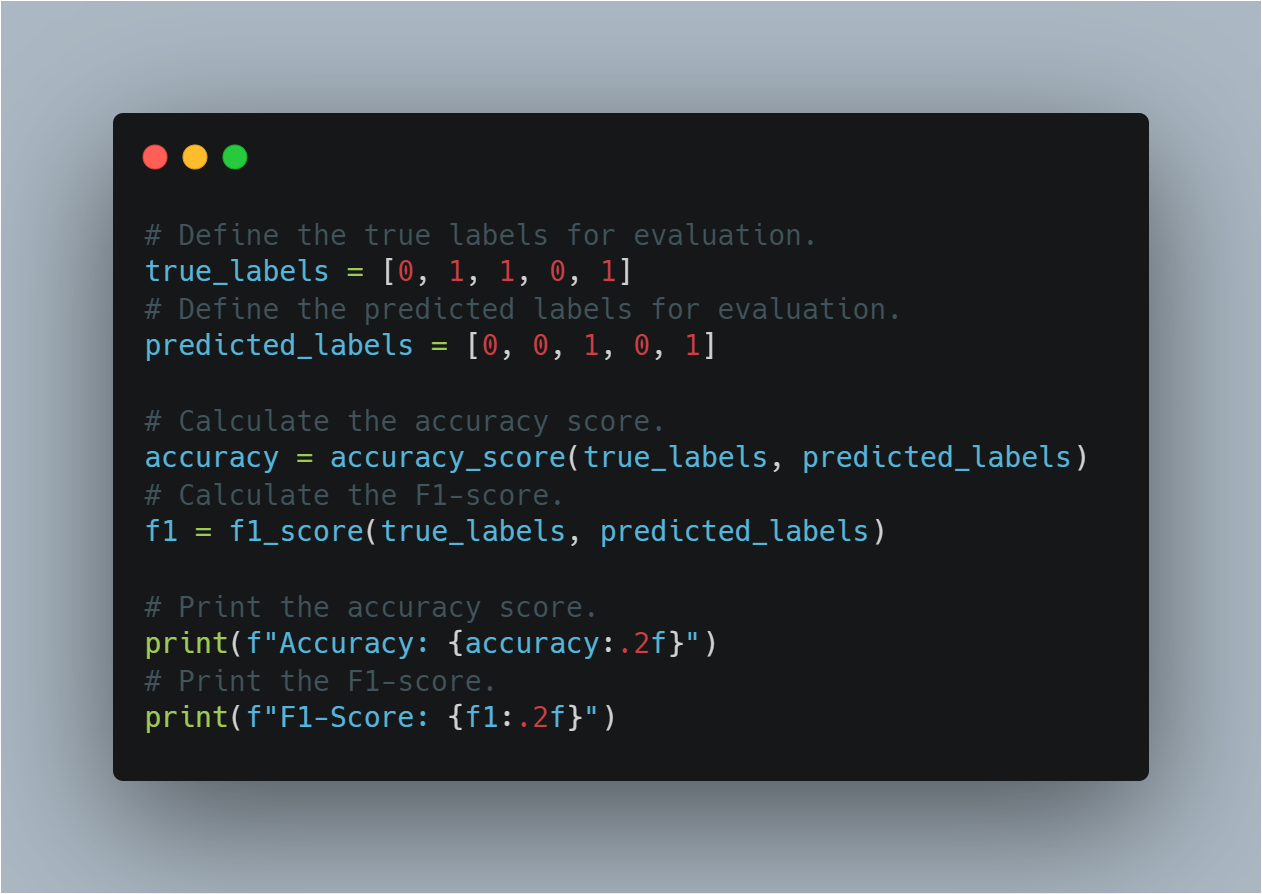

Monitorare e Analizzare il Rendimento: Seguire indicatori chiave del rendimento (KPIs) come le rate di risoluzione delle chiamate, il tempo di interfacciamento medio e i punteggi di soddisfazione del cliente. Utilizzare gli strumenti di analisi per avere insights dati-driven e prendere decisioni.

-

Assicurare la Privacy e la Sicurezza dei Dati: Misure di sicurezza robuste sono chiave, come rendere i dati anonimi, assicurare la sorveglianza umana, stabilire politiche per il mantenimento dei dati, e implementare misure di cifratura potenti per proteggere i dati cliente e mantenere la privacy.

AI Agents + LLMs: Un Nuovo periodo di Software Intelligente

Immaginate un software che non solo comprende le vostre richieste, ma che può anche portarle a termine. Questa è la promessa della combinazione di agenti AI con grandi modelli di linguaggio (LLM). questo potente insieme sta creando una nuova generazione di applicazioni che sono più intuitive, capaci e influenti di quanto non lo siano mai state prima.

AI Agents: Beyond Simple Task Execution

Mentre spesso paragonati a assistenti digitali, gli agenti AI sono molto di più di semplici seguaci di script. Essi comprendono una gamma di tecnologie sofisticate e operano su un framework che consente la decisione dinamica e l’adottamento di azioni.

-

Architettura: Un agente AI tipico comprende diversi componenti chiave:

-

Sensori: Questi consentono all’agente di percepire il suo ambiente, raccogliendo dati da diverse fonti come sensori, API o input utente.

-

Stato delle convinzioni: Questo rappresenta la comprensione dell’agente del mondo in base ai dati raccolti. È aggiornato costantemente man mano che nuova informazione diventa disponibile.

-

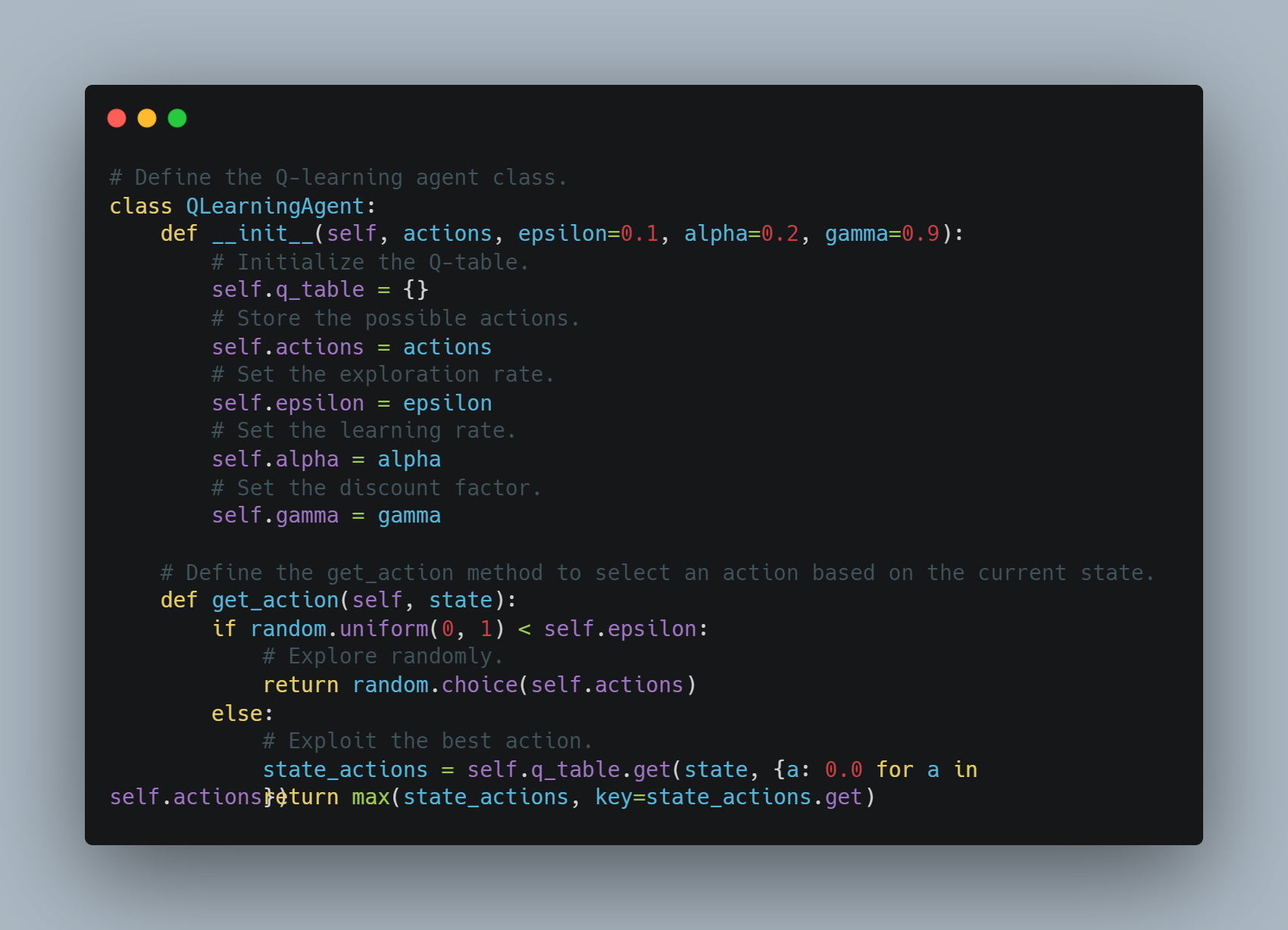

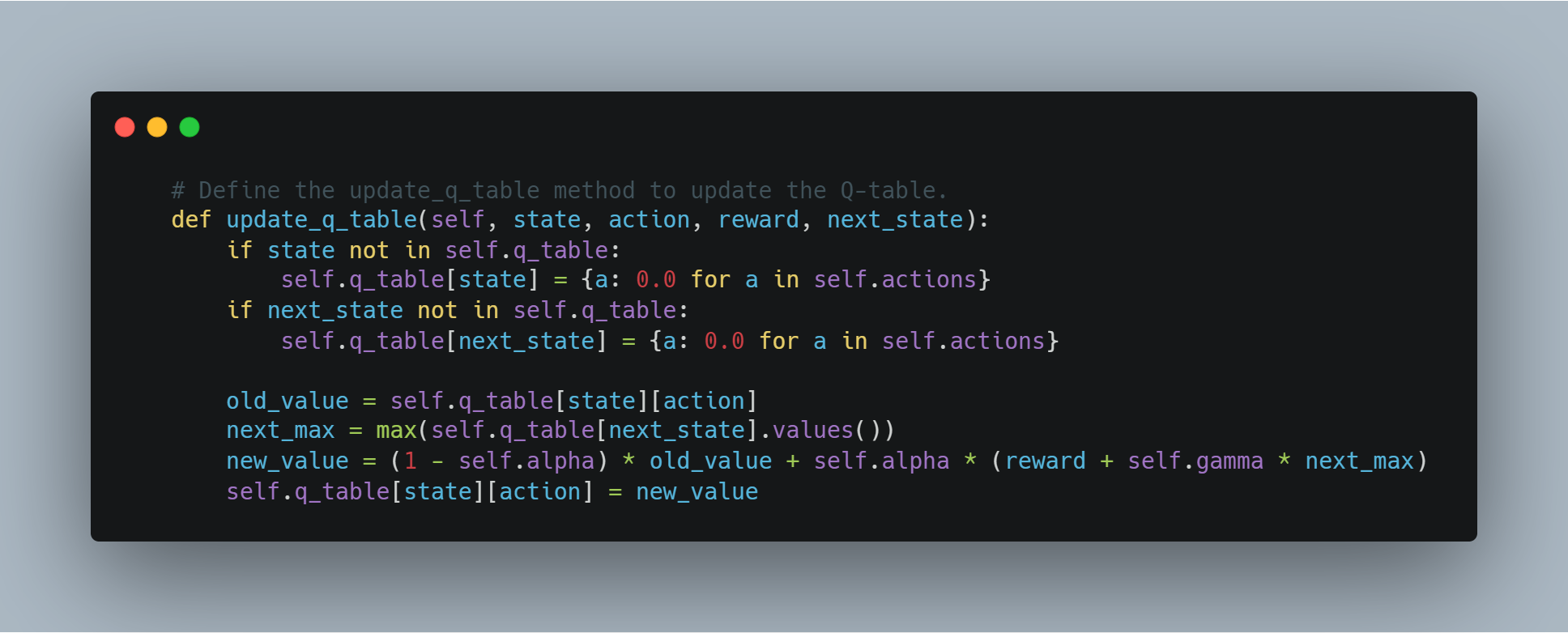

Motore di ragionamento: Questo è il cuore del processo decisionale dell’agente. Usa algoritmi, spesso basati sulla reinforcement learning o sulle tecniche di pianificazione, per determinare il migliore corso d’azione in base alle sue convinzioni e ai suoi obiettivi attuali.

-

Attuatori: Questi sono gli strumenti dell’agente per interagire con il mondo. Possono variare从发送API调用到 controllare robot fisici.

-

-

Sfide: Gli agenti tradizionali dell’IA, pur essendo capaci di gestire compiti ben definiti, spesso si trovano in difficoltà con:

-

Comprensione del Linguaggio Naturale: Interpretare il linguaggio umano complesso, gestire l’ ambiguità e estrarre il significato dal contesto rimangono sfide significative.

-

Ragionamento con Common Sense: Gli agenti dell’IA attuali spesso mancano delle conoscenze di senso comune e delle abilità di ragionamento che gli umani considerano acquisiti.

-

Generalizzazione: Addestrare gli agenti per svolgere bene compiti non visti o adattarsi a nuovi ambienti rimane un’area chiave di ricerca.

-

LLM: Sbloccare la Comprensione e la Generazione del Linguaggio

Le LLM, con il loro vasto know-how codificato in miliardi di parametri, portano nuove capacità linguistiche senza precedenti:

-

Architettura Transformer: La base della maggior parte delle moderne LLM è l’architettura transformer, un design di rete neurale che eccelle nel processare dati sequenziali come il testo. Ciò permette alle LLM di catturare le dipendenze a lungo raggio nel linguaggio, consentendo loro di capire il contesto e generare testo coerente e contestualmente rilevante.

-

Capacità: Le LLM si distinguono in una vasta gamma di compiti basati sul linguaggio:

-

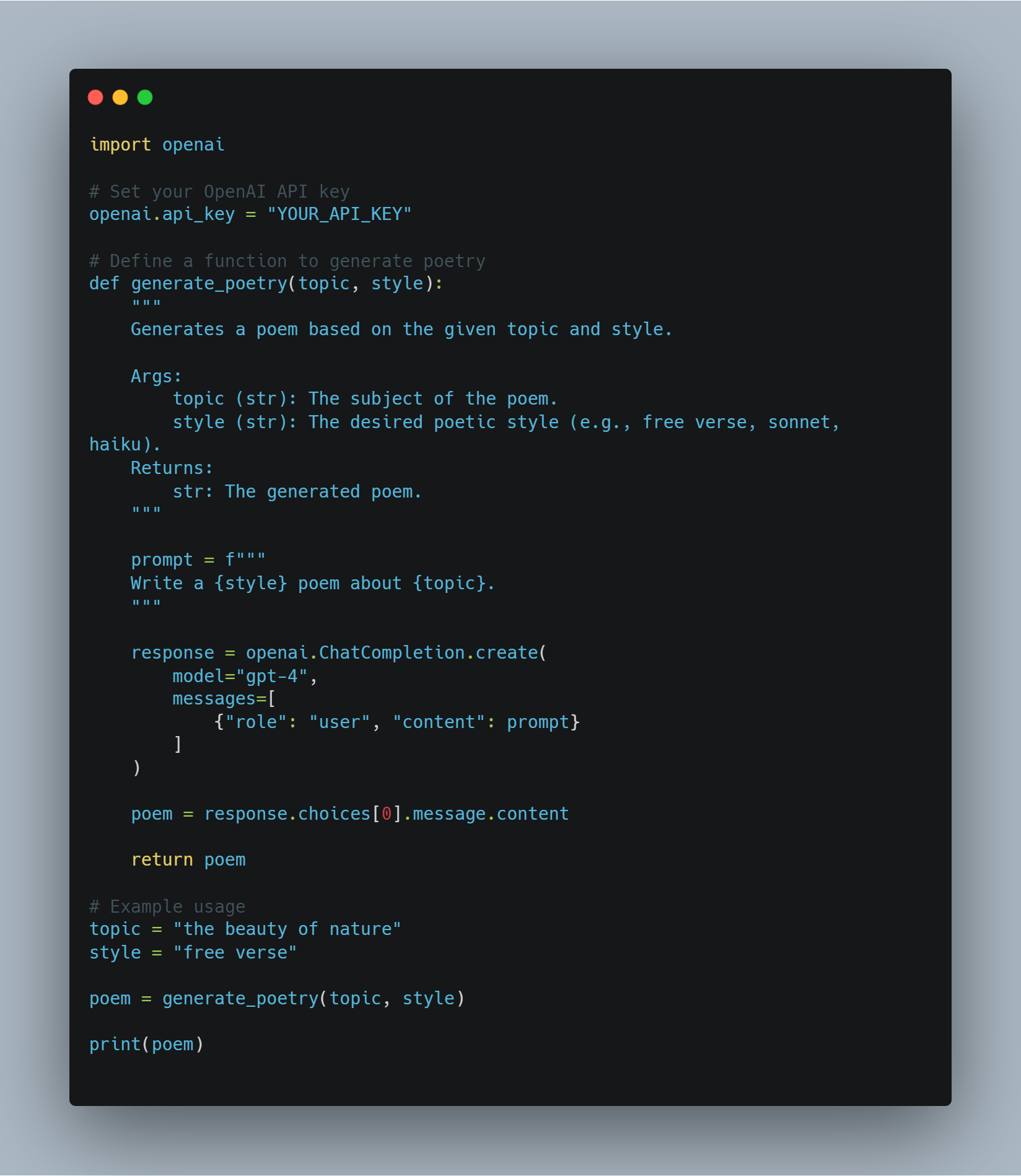

Generazione di Testo: Dalla scrittura di fiction creativa alla generazione di codice in più linguaggi di programmazione, le LLM mostrano una notevole fluentezza e creatività.

-

Risposta alle Domande: Possono fornire risposte concise e accurate alle domande, anche quando le informazioni sono disseminate in documenti lunghi.

-

Sommari: Le LLM possono condensare grandi volumi di testo in sintesi concisi, estrarre le informazioni chiave e scartare i dettagli irrilevanti.

-

-

Limitazioni: Nonostante le loro impressionanti capacità, le LLM hanno limitazioni:

-

Mancata G grounding nel mondo reale: Le LLM operano principalmente nel campo del testo e mancano dell’abilità di interagire direttamente con il mondo fisico.

-

Potenziale per Bias e allucinazione: Addestrate su dati massicci, non curati, le LLM possono ereditare i bias presenti nei dati e a volte generare informazioni factualmente errata o non sensica.

-

La sinergia: attraversare il gap tra lingua e azione

La combinazione di agenti AI e LLM risolve le limitazioni di ciascuno, creando sistemi sia intelligenti che capaci:

-

LLM come interpreti e pianificatori: Le LLM possono tradurre le istruzioni in linguaggio naturale in un formato che gli agenti AI possono capire, consentendo una interazione umano-计算机 più intuitiva. Possono anche sfruttare il loro know-how per assistere gli agenti nell’organizzare compiti complessi, dividendoli in step più piccoli e gestibili.

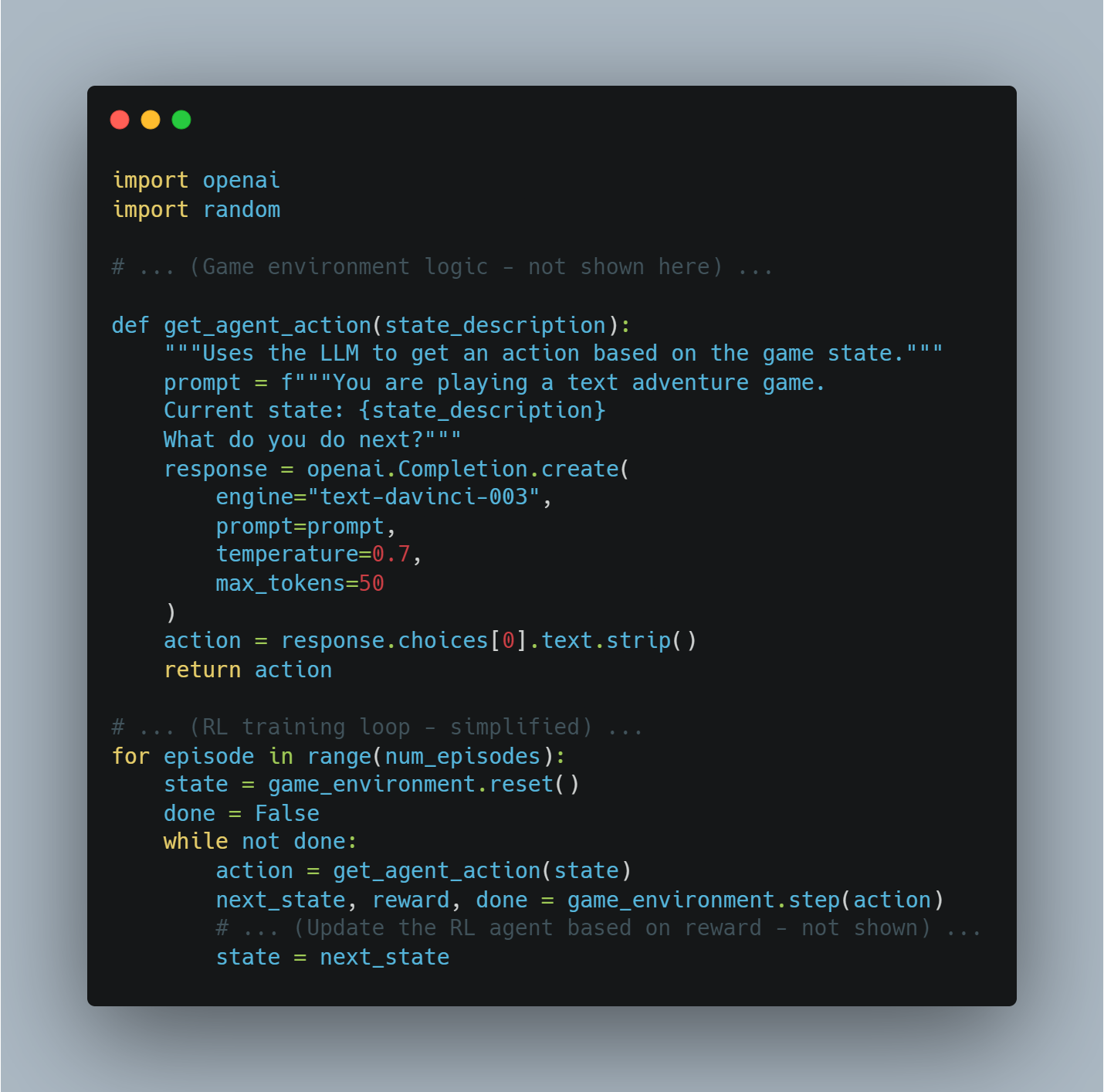

- AI Agents come esecutori e apprendisti: Gli agenti AI forniscono agli LLM la capacità di interagire con il mondo reale, di raccogliere informazioni e di ricevere feedback sulle loro azioni. Questa Collegamenti con il mondo reale possono aiutare gli LLM nell’apprendimento dalla esperienza e nell’aumento della loro performance nel tempo.

Questa potente sinergia sta guidando lo sviluppo di una nuova generazione di applicazioni che sono più intuitive, adattive e capaci di quanto non lo siano mai state prima. Con l’avanzamento continuo delle tecnologie sia degli agenti AI che degli LLM, ci si può aspettare di vedere l’emergere di applicazioni innovative e influenti, che rigirano il panorama dello sviluppo software e dell’interazione uomo-computer.

Esempi reali: Trasformazione delle industrie

Questa combinazione potente sta già scuotendo varie aree:

-

Gestione Servizio Clienti: Risoluzione di problemi con consapevolezza contextuale

- Esempio: Immaginate un cliente che contatta un negozio online riguardo un ritardo nella spedizione. Un agente AI alimentato da una PLL può capire la frustrazione del cliente, accedere alla storia dell’ordine, seguire il pacco in tempo reale e offrire proactive soluzioni come spedizione accelerata o sconto sulla prossima acquistazione.

-

Creazione Contenuti: Generazione di Contenuti di Alta Qualità a Scala

- Esempio: Un team di marketing può utilizzare un sistema AI agente + PLL per generare post social media mirati, scrivere descrizioni di prodotto o persino creare sceneggiature per video. La PLL garantisce che il contenuto sia coinvolgente e informativo, mentre l’agente AI gestisce il processo di pubblicazione e distribuzione.

-

Software Development: Accelerando il Coding e il Debugging

- Esempio: Un developer può descrivere una funzione di software che vuole implementare usando il linguaggio naturale. L’MML può quindi generare snippet di codice, identificare errori potenziali e suggerire miglioramenti, accelerando significativamente il processo di sviluppo.

-

Healthcare: Personalizzare il Trattamento e Migliorare la Cura del Paziente

- Esempio: Uno smart agent con accesso alla storia medica del paziente e dotato di un MML può rispondere alle loro domande relative alla salute, fornire promemoria personalizzati per la medicina e persino offrire diagnosi preliminari in base ai loro sintomi.

-

Diritto: ottimizzazione della ricerca giuridica e redazione documenti

- Esempio: Un avvocato deve redigere un contratto con specifiche clausole e precedenti legali. Un agente AI alimentato da una PdL può analizzare le istruzioni dell’avvocato, cercare attraverso vasti database legali, identificare clausole e precedenti rilevanti, e persino redigere parti del contratto, riducendo significativamente il tempo e il lavoro richiesti.

-

Creazione video: generazione di video coinvolgenti con facilità

- Esempio: Un team di marketing vuole creare un breve video per spiegare le caratteristiche del loro prodotto. Possono fornire a un agente AI + sistema PdL un outline del soggetto e le preferenze per lo stile visivo. La PdL può quindi generare uno script dettagliato, suggerire musica e immagini appropriate, e persino montare il video, automatizzando gran parte del processo di creazione del video.

-

Architettura: progettare edifici con insights basati su intelligenza artificiale

-

Esempio: Un architetto sta progettando un nuovo edificio per uffici. Può utilizzare un agente AI + il sistema LLM per inserire i suoi obiettivi di design, come massimizzare la luce naturale e ottimizzare l’utilizzo dello spazio. L’LLM può quindi analizzare questi obiettivi, generare diverse opzioni di design, e persino simulare come l’edificio avrebbe prestato il servizio sotto differenti condizioni ambientali.

-

Costruzione: migliorare la sicurezza e l’efficienza nei cantieri

- Esempio: Un agente AI equipaggiato con telecamere e sensori può monitorare un cantiere per pericoli di sicurezza. Se un operaio non indossa l’equipaggiamento di sicurezza corretto o un’attrezzatura è lasciata in una posizione pericolosa, l’MLL può analizzare la situazione, avvisare il supervisore del cantiere e persino sospendere automaticamente le operazioni se necessario.

Il futuro è qui: una nuova era della programmazione software

La convergenza tra agenti AI e MLL segna un significativo balzo in avanti nella programmazione software. Mentre queste tecnologie continuano a evolversi, ci si può aspettare ancora più applicazioni innovative emerse, trasformando le industrie, streamlining le flussi di lavoro e creando nuove possibilità per l’interazione uomo-计算机.

Gli agenti AI hanno il loro massimo nella loro capacità di elaborare vasti quantitativi di dati, automatizzare attività ripetitive, prendere decisioni complesse e fornire esperienze personalizzate. Incontrando le condizioni necessarie e seguendo le migliori pratiche, le organizzazioni possono sfruttare al massimo il potenziale degli agenti AI per guidare l’innovazione, l’efficienza e la crescita.

Capitolo 4: La Fondazione Filosofica degli Sistemi Intelligenti

Lo sviluppo di sistemi intelligenti, specialmente nel campo dell’intelligenza artificiale (AI), richiede un’approssimazione approfondita ai principi filosofici. Questo capitolo si immerge nelle idee filosofiche centrali che influiscono sulla progettazione, lo sviluppo e l’utilizzo dell’AI. Sottolinea l’importanza di allineare il progresso tecnologico con i valori etici.

La fondazione filosofica degli sistemi intelligenti non è solo un esercizio teorico – costituisce un quadro vitale che garantisce che le tecnologie dell’AI benefici l’umanità. Promuovendo la giustizia, l’inclusività e migliorando la qualità della vita, questi principi guidano l’AI a servire i nostri interessi migliori.

Considerazioni Etiche nell’ Sviluppo dell’AI

Con l’aumento dell’integrazione di sistemi AI in ogni aspetto della vita umana, dall’assistenza sanitaria e l’istruzione alla finanza e alla governanza, dobbiamo esaminare rigorosamente e applicare i comandamenti etici che guidano il loro design e la loro distribuzione.

La domanda etica fondamentale riguarda come possiamo creare AI in modo da riflettere e sostenere i valori umani e i principi morali. Questa domanda è centrale alla maniera in cui l’AI formerà il futuro delle società in tutto il mondo.

Al centro di questo discorso etico vi è il principio di beneficenza, una pietra miliare della filosofia morale che stabilisce che le azioni devono puntare a fare del bene e aumentare il benessere degli individui e della società in generale (Floridi & Cowls, 2019).

Nel contesto dell’IA, la beneficenza si traduce nel progettare sistemi che contribuiscono attivamente al benessere umano – sistemi che migliorano i risultati nella sanità, ampliano le opportunità educative e facilitano la crescita economica equitativa.

Ma l’applicazione della beneficenza nell’IA non è affatto semplice. richiede un approcio affinato che valuta attentamente i potenziali benefici dell’IA contro i possibili rischi e danni.

Un delle principali sfide nell’applicare il principio della beneficenza alla realizzazione dell’IA è il bisogno di un equilibrio delicato tra innovazione e sicurezza.

L’IA ha il potenziale di rivoluzionare settori come la medicina, dove algoritmi predittivi possono diagnosticare malattie più presto e con maggiore accuratezza rispetto ai dottori umani. Ma senza una stretta sorveglianza etica, queste stesse tecnologie potrebbero esasperare le disuguaglianze esistenti.

Ciò potrebbe accadere, ad esempio, se venissero principalmente implementate in regioni ricche mentre comunità non servite continuano a mancare dell’accesso base alla sanità.

Pertanto, lo sviluppo etico dell’IA richiede non solo un focus sull’massimizzazione dei benefici ma anche un approcio attivo alla mitigazione del rischio. Questo comporta l’implementazione di robuste misure di sicurezza per prevenire l’abuso dell’IA e garantire che queste tecnologie non causino danni inadvertatamente.

Il framework etico per l’IA deve anche essere inclusivo di per sé, garantendo che i benefici dell’IA siano distribuiti equamente tra tutti i gruppi sociali, inclusi quelli tradizionalmente marginalizzati. Questo richiede un impegno alla giustizia e alla fairness, garantendo che l’IA non solo rinforzi il status quo ma lavori attivamente a smantellare le disuguaglianze sistemiche.

Ad esempio, l’automazione del lavoro guidata dall’IA ha il potenziale di incrementare la produttività e la crescita economica. Ma potrebbe anche portare a un significativo spostamento del lavoro, colpendo in modo sproporzionato i lavoratori a basso reddito.

Come potete vedere, un quadro etico per l’IA deve includere strategie per il condivisione equitativa dei benefici e la fornitura di sistemi di supporto per coloro che sono colpiti in modo negativo dalle innovazioni dell’IA.

Lo sviluppo etico dell’IA richiede un coinvolgimento continuo con diversi stakeholder, inclusi gli eticisti, i tecnologi, i policy maker e le comunità che saranno maggiormente colpite da queste tecnologie. Questa collaborazione interdisciplinare assicura che i sistemi dell’IA non siano sviluppati in un vacuo ma siano invece influenzati da una ampia gamma di prospettive e esperienze.

È attraverso questo impegno collettivo che possiamo creare sistemi dell’IA che non solo riflettono ma anche sostengono i valori che definiscono la nostra umanità – compassione, equità, rispetto per l’autonomia e impegno per il bene comune.

Le considerazioni etiche nell’sviluppo dell’IA non sono solo linee guida, ma elementi essenziali che determinano se l’IA serve come forza buona nel mondo. Appoggiaando l’IA sui principi di beneficenza, giustizia e inclusività e mantenendo un approcio vigilante al bilanciamento tra innovazione e rischio, possiamo assicurarci che l’sviluppo dell’IA non solo avanzi la tecnologia ma anche migliori la qualità della vita di tutti i membri della società.

Mentre continuiamo a esplorare le capacità dell’IA, è imperativo che queste considerazioni etiche rimangano al centro dei nostri sforzi, guidandoci verso un futuro in cui l’IA davvero beneficia l’umanità.

L’imperativo dell’architettura AI centrata sull’uomo

L’architettura AI centrata sull’uomo non si limita ai soli aspetti tecnici. Ha radici in profonde principi filosofici che priorità la dignità umana, l’autonomia e l’agente umana.

Questo approcio alla realizzazione dell’IA è fondamentalmente ancorato nel quadro etico kantiano, secondo il quale gli umani devono essere considerati come fine a se stessi, non solo come strumenti per raggiungere altri obiettivi (Kant, 1785).

Le implicazioni di questo principio per l’architettura dell’IA sono profonde, richiedendo che i sistemi AI siano sviluppati con un focus inflessibile sulla servizio degli interessi umani, nella preservazione dell’autonomia umana e nel rispetto dell’autonomia individuale.

Implementazione tecnica dei principi dell’AI centrata sull’uomo

Enhancing Human Autonomy through AI: Il concetto di autonomia negli AI system è critico, soprattutto nel garantire che queste tecnologie empower gli utenti invece di controllare o influenzare in modo eccessivo.

In termini tecnici, questo coinvolge il design di AI system che priorità l’autonomia utente fornendogli gli strumenti e l’informazione necessaria per prendere decisioni informate. Questo richiede che i modelli AI siano contesto-sensibili, ovvero che comprendano il contesto specifico in cui viene presa una decisione e adattino le loro raccomandazioni di conseguenza.

Da un punto di vista di progettazione di sistemi, questo coinvolge l’integrazione dell’intelligenza contestuale nei modelli AI, che consente a questi sistemi di adattarsi dinamicamente all’ambiente utente, alle preferenze e ai bisogni.

Per esempio, nel settore sanitario, un sistema AI che assiste i dottori nella diagnosi di condizioni deve considerare il curriculum medico unico del paziente, i sintomi attuali e persino lo stato psicologico per offrire raccomandazioni che supportino l’esperto del dottore invece di sostituirlo.

Questa adattabilità contestuale assicura che l’AI rimanga uno strumento supportivo che migliora, piuttosto che diminuisce, l’autonomia umana.

Garantendo Processi Decisionali Trasparenti: La trasparenza nei sistemi AI è unarequisizione fondamentale per assicurare che gli utenti possano fidarsi e capire le decisioni fatte da queste tecnologie. Technically, questo si traduce nella necessità di AI spiegabile (XAI), che coinvolge lo sviluppo di algoritmi in grado di chiarire il ragionamento dietro le loro decisioni.

Questo è particolarmente cruciale nei domini come la finanza, la sanità e la giustizia penale, nei quali decisioni opache possono condurre a diffidenza e preoccupazioni etiche.

La spiegabilità può essere raggiunta attraverso diversi approcchi tecnici. Un metodo comune è l’interpretabilità post-hoc, in cui il modello AI genera una spiegazione dopo aver fatto la decisione. Questo potrebbe coinvolgere la scomposizione della decisione nei suoi fattori costitutivi e mostrare come ciascuno di essi abbia contribuito all’outcome finale.

Un’altra approcio sono modelli di percezione automatica, nei quali l’architettura del modello è progettata in modo da rendere le sue decisioni trasparenti in modo predefinito. Per esempio, modelli come gli alberi di decisione e i modelli lineari sono naturalmente trasparenti perché il loro processo decisionale è facile da seguire e comprendere.

Il challenge nell’implementare l’IA spiegabile sta nel bilanciare la trasparenza con la performance. Spesso, modelli più complessi, come le reti neurali profonde, sono meno spiegabili ma più accurate. Quindi, il design dell’IA centrate sull’uomo deve considerare il compromesso tra la spiegabilità del modello e la sua capacità predittiva, garantendo agli utenti di poter fidarsi e comprendere le decisioni dell’IA senza sacrificare la precisione.

Consentire una Oversight Umana Significativo: Una Oversight Umana Significativo è cruciale per garantire che i sistemi AI operino entro i limiti etici e operativi. Questo controllo comprende il design di sistemi AI con meccanismi di salvaguardia e override che consentono agli operatori umani di intervenire quando necessario.

L’implementazione tecnica dell’oversight umana può essere approcio in diversi modi.

Un approcio è quello di incorporare sistemi a uomo-in-the-loop, nei quali i processi di decision-making dell’IA sono monitorati e valutati in continuazione dagli operatori umani. Questi sistemi sono progettati per consentire un intervento umano a punti chiave, garantendo che l’IA non agisca autonomamente in situazioni in cui sono richieste giudizi etici.

Ad esempio, nei sistemi armi autonome, la sorveglianza umana è essenziale per impedire all’IA di prendere decisioni di vita o di morte senza input umano. Ciò potrebbe comportare la definizione di rigide limitazioni operative che l’IA non può superare senza autorizzazione umana, così come l’inserimento di garanzie etiche nel sistema.

Un’altra considerazione tecnica è lo sviluppo di tracciati di revisione, che sono registrazioni di tutte le decisioni e le azioni fatte dal sistema dell’IA. Questi tracciati forniscono una storia trasparente che può essere rivista dagli operatori umani per assicurare la conformità con standard etici.

I tracciati di revisione sono particolarmente importanti nei settori come quello finanziario e giuridico, in cui le decisioni devono essere documentate e giustificate per mantenere la fiducia pubblica e soddisfare i requisiti regolamentari.

Bilanciamento Autonomia e Controllo: Una sfida tecnica chiave nell’AI centrato sull’uomo è trovare il giusto equilibrio tra autonomia e controllo. Mentre i sistemi dell’IA sono progettati per operare autonomamente in molti scenari, è cruciale che questa autonomia non sottragga il controllo umano o la sorveglianza.

Questo equilibrio può essere raggiunto attraverso l’implementazione di livelli di autonomia, che determinano la gradazione di indipendenza che l’IA ha nell’ fare decisioni.

Ad esempio, nei sistemi semi-autonomi come le macchine guidate da soli, i livelli di autonomia vanno dall’assistenza base del guidatore (in cui il guidatore umano rimane a pieno controllo) alla automazione completa (in cui l’IA è responsabile per tutte le attività di guida).

Il design di questi sistemi deve garantire che, a qualsiasi livello di autonomia, l’operatore umano mantenga la capacità di intervenire e annullare l’IA se necessario. Ciò richiede interfacce di controllo sofisticate e sistemi di supporto per le decisioni che consentano agli umani di assumere rapidamente e efficientemente il controllo in caso di necessità.

Inoltre, lo sviluppo di schemi etici per le AI è essenziale per guidare le azioni autonome dei sistemi AI. Questi schemi sono insiemi di regole e linee guida integrate all’interno dell’AI che dicono come dovrebbe comportarsi in situazioni eticamente complesse.

Ad esempio, nel settore sanitario, un schema etico per una AI potrebbe includere regole riguardanti il consenso del paziente, la privacy e la priorità dei trattamenti in base alle necessità mediche invece che ai considerazioni economiche.

Inserendo questi principi etici direttamente nei processi decisionali dell’AI, gli sviluppatori possono garantire che l’autonomia del sistema sia esercitata in modo da allinearsi con i valori umani.

L’integrazione di principi centrate sull’uomo nel design dell’AI non è solo un ideal filosofico ma una necessità tecnica. Enhancing human autonomy, ensuring transparency, enabling meaningful oversight, and carefully balancing autonomy with control, AI systems can be developed in a way that truly serves humanity.

Queste considerazioni tecniche sono essenziali per la creazione di AI che non solo amplifichi le capacità umane ma anche rispetta e sostiene i valori fondamentali della nostra società.

Con l’evoluzione continua dell’AI, l’ impegno nei confronti del design centrato sull’uomo sarà cruciale per assicurarsi che queste potenti tecnologie siano utilizzate eticamente e responsabilmente.

Come assicurarsi che l’AI sia benefico per l’umanità: migliorare la qualità della vita

Mentre state impegnati nella sviluppo di sistemi AI, è essenziale che il vostro impegno sia basato sul quadro etico del Utilitarismo – una filosofia che dà importanza all’aumento della felicità e del benessere complessivo.

In questo contesto, l’AI ha il potenziale di affrontare sfide cruciali della società, specialmente nell’area della sanità, dell’educazione e della sostenibilità ambientale.

L’obiettivo è creare tecnologie che notevolmente migliorino la qualità della vita per tutti. Ma la ricerca di questo obiettivo comporta complessità. Il Utilitarismo offre un motivo appassionante per l’utilizzo diffuso dell’AI, ma ne fa emergere anche importanti domande etiche riguardanti chi beneficia e chi potrebbe essere lasciato indietro, specialmente tra le popolazioni vulnerabili.

Per affrontare questi challenge, abbiamo bisogno di un approcio sofisticato, tecnicamente informato – uno che equilibra la ricerca diffusa del bene della società con il bisogno di giustizia e equità.

Applicando i principi del Utilitarismo all’AI, il vostro focus dovrebbe essere sull’ottimizzazione degli outcome nei domini specifici. Ad esempio, nell’area sanitaria, le tool di diagnostica guidate dall’AI hanno il potenziale di migliorare significativamente i risultati per i pazienti permettendo diagnosi più timbriche e anticipate. Questi sistemi possono analizzare dataset estesi per rilevare schemi che potrebbero sfuggire ai pratici umani, espandendo così l’accesso alla cura di qualità, specialmente in ambienti sottoutilizzati.

Ma, per farlo, occorre considerare attentamente per evitare di rafforzare le diseguaglianze esistenti. I dati utilizzati per addestrare i modelli AI possono variare significativamente tra le regioni, influenzando l’accuratezza e la affidabilità di questi sistemi.

Questa disparità evidenzia l’importanza di stabilire framebuffer governativi robusti che garantiscano che le soluzioni sanitarie guidate da AI siano sia rappresentative che equitable.

Nell’ambito educativo, la capacità di personalizzare l’apprendimento offerta dall’AI è promettente. I sistemi AI possono adattare il contenuto educativo ai bisogni specifici di ogni studente, migliorando così i risultati di apprendimento. Analizzando i dati sulla performance e sul comportamento degli studenti, l’AI può identificare le aree in cui un studente potrebbe avere problemi e fornire supporto mirato.

Ma mentre si lavorano verso questi benefici, è cruciale fare attenzione ai rischi, come il potenziale di rafforzare i pregiudizi o di marginalizzare gli studenti che non si adattano ai tipici modelli di apprendimento.

Mitigare questi rischi richiede l’integrazione di meccanismi di equità nei modelli AI, garantendo che non favoriscano inadvertentemente certi gruppi. E mantienere il ruolo degli educatori è critico. La loro giudizio e esperienza sono indispensabili per rendere le tool AI davvero efficienti e supportive.

In termini di sostenibilità ambientale, il potenziale dell’AI è notevole. I sistemi AI possono ottimizzare l’uso delle risorse, monitorare i cambiamenti ambientali e prevedere gli impatti del cambiamento climatico con una precisione senza precedenti.

Ad esempio, l’intelligenza artificiale può analizzare vasti quantitativi di dati ambientali per prevedere i modelli meteorologici, ottimizzare il consumo energetico e minimizzare il waste – azioni che contribuiscono al benessere delle generazioni presenti e future.

Ma questo sviluppo tecnologico comporta anche una serie di sfide proprie, in particolare riguardo all’impatto ambientale stesso dei sistemi AI.

Il consumo energetico richiesto per operare sistemi AI a scala elevata può annullare i benefici ambientali che questi intendono raggiungere. Quindi, sviluppare sistemi AI efficienti in termini di energia è cruciale per assicurarsi che il loro impatto positivo sulla sostenibilità non venga minato.

Con il sviluppo di sistemi AI con obiettivi utilitaristici, è importante considerare anche le implicazioni per la giustizia sociale. Utilitarianesimo si concentra sulla massimizzazione del benessere complessivo ma non tratta in modo innato della distribuzione dei benefici e degli danni tra i diversi gruppi sociali.

Questo alza il potenziale per i sistemi AI di beneficiare in modo sproporzionato coloro che sono già privilegiati, mentre i gruppi marginalizzati potrebbero vedere poca o nessuna migliore situazione nei loro confronti.

Per contrarre questo fenomeno, il processo di sviluppo dell’IA dovrebbe incorporare principi focalizzati sull’uguaglianza, garantendo una distribuzione equa dei benefici e la mitigazione di eventuali danni. Ciò potrebbe comportare la progettazione di algoritmi finalizzati specificamente a ridurre le biassi e l’inclusione di una gamma diversa di punti di vista nel processo di sviluppo.

Nel lavoro di sviluppo di sistemi AI mirati ad migliorare la qualità della vita, è essenziale bilanciare il obiettivo utilitariano di massimizzare il benessere con il bisogno di giustizia e equità. Ciò richiede un approcio sofisticato, basato sulla tecnica, che consideri le implicazioni più ampie del deployaggio di AI.

Progettando attentamente sistemi AI sia efficaci che equi, puoi contribuire ad un futuro dove le evoluzioni tecnologiche servano realmente le varie esigenze della società.

Implementa barriere contro i potenziali danni

Nel corso dello sviluppo di tecnologie AI, devi riconoscere la potenziale per il danno inerente e stabilire preventivamente misure robuste per mitigare questi rischi. Questa responsabilità è profondamente radicata nellaetica deontologica. Questo ramo dell’etica sottolinea il dovere morale di adeguarsi alle regole e ai standard etici stabiliti, garantendo che la tecnologia creata risponda a principi morali fondamentali.

L’implementazione di protocolli di sicurezza stringenti non è solo una precauzione, ma anche un obbligo etico. questi protocolli dovrebbero includere test completi sulla biassenza, trasparenza nei processi algoritmici e meccanismi chiari di responsabilità.

Quindi, queste misure di sicurezza sono essenziali per prevenire che i sistemi AI causino danni imprevisti, sia per decisioni basate su bias, processi opachi o mancanza di sorveglianza.

In pratica, l’implementazione di queste misure richiede una profonda comprensione sia delle dimensioni tecniche che etiche dell’AI.

La testazione per bias, ad esempio, non riguarda solo l’identificazione e la correzione dei bias negli dati e negli algoritmi, ma anche l’understanding delle implicazioni sociali più ampie di questi bias. Devi assicurarti che i tuoi modelli AI siano addestrati su dataset diversi e rappresentativi e che siano ricorrentemente valutati per rilevare e correggere eventuali bias che potrebbero emergerne nel tempo.

La trasparenza, d’altro canto, richiede che i sistemi AI siano progettati in modo da consentire una comprensione e una sorveglianza facile da parte degli utenti e degli interessati. Questo comprende lo sviluppo di modelli AI spiegabili che forniscano output chiari e interpretabili, permettendo agli utenti di vedere come vengono fatte le decisioni e garantendo che queste decisioni siano giustificabili e equitable.

Inoltre, i meccanismi di responsabilità sono cruciali per mantenere la fiducia e garantire che i sistemi AI siano utilizzati responsabilmente. questi meccanismi dovrebbero includere linee guida chiare su chi è responsabile per i risultati delle decisioni di AI, nonché processi per affrontare e correggere eventuali danni che possono verificarsi.

Devi stabilire un framework in cui le considerazioni etiche siano integrate in ogni fase dello sviluppo dell’AI, dalla progettazione iniziale alla distribuzione e oltre. Questo comprende non solo la aderenza agli standard etici, ma anche la monitoraggio continuo e l’attuazione di AI sistemi mentre interagiscono con il mondo reale.

Impiantando queste garanzie nell’essenza dello sviluppo tecnologico, puoi aiutare a garantire che il progresso tecnologico serve il bene comune senza portare a conseguenze negative impreviste.

Il ruolo dell’osservanza umana e dei cicli di feedback

La sorveglianza umana negli sistemi AI è un componente chiave per garantire una distribuzione etica di AI. Il principio della responsabilità sostegna la necessità di una partecipazione umana continua nell’operazione di AI, in particolare in ambienti a rischi elevati come la sanità e la giustizia penale.

I cicli di feedback, nei quali l’input umano viene utilizzato per raffinare e migliorare i sistemi AI, sono essentiali per mantenere la responsabilità e l’adattabilità (Raji et al., 2020). Questi cicli consentono la correzione degli errori e l’integrazione di nuove considerazioni etiche man mano che i valori sociali evolvono.

Incorporando la sorveglianza umana negli sistemi AI, i sviluppatori possono creare tecnologie non solo efficienti ma anche allineate alle norme etiche e alle aspettative umane.

Codificare l’Etica: Tradurre i Principi Filosofici negli Sistemi AI

La traduzione dei principi filosofici negli sistemi AI è un compito complesso ma necessario. Questo processo coinvolge l’implementazione di considerazioni etiche nel codice che guidano gli algoritmi AI.

Concetti come la fairness, la giustizia e l’autonomia devono essere codificati negli sistemi AI per assicurare che operino in modi che riflettano i valori sociali. Ciò richiede un approcio multidisciplinare, nel quale filosofi, ingegneri e scienziati sociali collaborano per definire e implementare linee guida etiche nel processo di codifica.

L’obiettivo è creare AI system che siano non solo tecnicamente dotati ma anche morali, capaci di prendere decisioni che rispettino la dignità umana e promuovano il bene sociale (Mittelstadt et al., 2016).

Promuovere l’inclusività e l’accesso equo nell’sviluppo e nella distribuzione di AI.

L’inclusività e l’accesso equo sono fondamentali per lo sviluppo etico dell’intelligenza artificiale. Il concetto Rawlsiano di giustizia come equità fornisce una base filosofica per garantire che i sistemi AI siano progettati e implementati in modi che beneficiano tutti i membri della società, specialmente coloro che sono più vulnerabili (Rawls, 1971).

Questo richiede sforzi proattivi per includere diverse prospettive nel processo di sviluppo, specialmente da gruppi sottorappresentati e dal Sud del Mondo.

Incorporando questi diversi punti di vista, i sviluppatori AI possono creare sistemi che sono più equi e responsive ai bisogni di un range più vasto di utenti. Anche l’accesso equo alle tecnologie AI è cruciale per prevenire l’esacerbazione di esistenti disuguaglianze sociali.

Raddoppia la Bias negli Algoritmi e la Giustizia

Il bias negli algoritmi è una preoccupazione etica significativa nello sviluppo dell’intelligenza artificiale, poiché algoritmi biasi possono perpetuare e persino peggiorare le disuguaglianze sociali. Per affrontare questo problema è necessario un impegno nella giustizia procedurale, garantendo che i sistemi AI siano sviluppati attraverso processi equi che considerino l’impatto su tutti gli interessati (Nissenbaum, 2001).

Questo richiede l’identificazione e la mitigazione del bias nei dati di addestramento, lo sviluppo di algoritmi trasparenti e spiegabili e l’implementazione di verifiche di equità lungo tutto il ciclo di vita dell’AI.

Raddoppiare il bias negli algoritmi, i sviluppatori possono creare sistemi AI che contribuiscono a una società più giusta e equa, invece di rafforzare le disparità esistenti.

Includere Perspective Diverse nell’Sviluppo dell’AI

Incorporare diverse prospettive nell’sviluppo dell’intelligenza artificiale è essenziale per la creazione di sistemi inclusivi e equi. L’inclusione delle voci delle gruppi sottorepresentati garantisce che le tecnologie dell’intelligenza artificiale non riflettano solo i valori e le priorità di un piccolo segmento della società.

Questo approcio è allineato con il principio filosofico della democrazia deliberativa, che sottolinea l’importanza di processi decisionale inclusivi e partecipativi (Habermas, 1996).

Attraverso la promozione della partecipazione diversa nell’sviluppo dell’intelligenza artificiale, possiamo assicurarci che queste tecnologie siano progettate per servire gli interessi di tutta l’umanità, invece di una minoranza privilegiata.

Strategie per attraversare la divisione dell’intelligenza artificiale

La divisione dell’intelligenza artificiale, caratterizzata da un accesso ineguale alle tecnologie dell’intelligenza artificiale e ai loro benefici, presenta una sfida significativa all’equità globale. Attraversare questa divisione richiede un impegno alla giustizia distributiva, garantendo che i benefici dell’intelligenza artificiale siano condivisi ampiamente tra i diversi gruppi socioeconomici e regioni (Sen, 2009).

Possiamo fare questo attraverso iniziative che promuovono l’accesso all’educazione e ai risorse relative all’intelligenza artificiale nelle comunità non servite, così come dalle politiche che supportano la distribuzione equa dei guadagni guidati dall’intelligenza artificiale. Attraversando la divisione dell’intelligenza artificiale, possiamo assicurarci che l’intelligenza artificiale contribuisca al sviluppo globale in un modo inclusivo e equo.

Balance l’innovazione con le limitazioni etiche

Balancere la ricerca dell’innovazione con le limitazioni etiche è cruciale per l’avanzamento responsabile dell’intelligenza artificiale. Il principio precauzionista, che sostiene la cautela di fronte all’incertezza, è particolarmente rilevante nel contesto dello sviluppo dell’intelligenza artificiale (Sandin, 1999).

Mentre l’innovazione spinge avanti il progresso, deve essere temperato da considerazioni etiche che proteggano contro i possibili danni. Questo richiede un’attenta valutazione dei rischi e dei benefici delle nuove tecnologie AI, nonché l’adozione di schemi regolatori che sostengano gli standard etici.

Balanciando l’innovazione con le limitazioni etiche, possiamo incoraggiare lo sviluppo di tecnologie AI al passo avanzato e allineate con i più ampi obiettivi del benessere della società.

Come potete vedere, la base filosofica dei sistemi intelligenti fornisce un quadro critico per assicurare che le tecnologie AI siano sviluppate e impiegate in modi etici, inclusivi e beneficiosi per tutta l’umanità.

Appoggiaando lo sviluppo dell’intelligenza artificiale su questi principi filosofici, possiamo creare sistemi intelligenti in grado non solo di avanzare le capacità tecnologiche ma anche di migliorare la qualità della vita, promuovere la giustizia e garantire che i benefici dell’AI siano condivisi equamente nella società.

Capitolo 5: AI Agents come Enhancer per LLM

La fusione di agenti AI con Modelli a Larga Scala (LLM) rappresenta un cambiamento fondamentale nell’intelligenza artificiale, che colga le limitazioni critiche negli LLM che ne hanno limitato l’applicabilità più ampia.

Questo integrazione consente alle macchine di superare i loro ruoli tradizionali, avanzando da generatori passivi di testo a sistemi autonomi capaci di ragionamento dinamico e decisioni.

Con l’aumento delle macchine AI che guidano processi critici in vari domini, capire come gli agenti AI colmano le lacune nelle capacità di LLM è essenziale per realizzare il loro pieno potenziale.

Collegare i limiti nelle Capacità di LLM

Le LLM, sebbene potenti, sono inesorabilmente limitate dai dati su cui sono state addestrate e dalla natura statica della loro architettura. Questi modelli operano all’interno di un insieme fisso di parametri, generalmente definiti dal corpus di testo utilizzato durante la fase di addestramento.

Questa limitazione significa che le LLM non possono autonomamente cercare nuove informazioni o aggiornare la loro base di conoscenza dopo l’addestramento. Di conseguenza, le LLM spesso sono obsolete e mancano della capacità di fornire risposte appropriate in contesto che richiedono dati o informazioni in tempo reale oltre ai dati di addestramento iniziale.

Gli agenti AI attraversano questi limiti integrando dinamicamente fonti di dati esterni, il che può estendere l’orizzonte funzionale delle LLM.

Per esempio, una LLM addestrata su dati finanziari fino al 2022 potrebbe fornire analisi storiche accurate ma sarebbe in grado di generare solo difficilmente previsioni di mercato aggiornate. Un agente AI può ampliare questa LLM integrando dati in tempo reale dai mercati finanziari, applicando questi input per generare analisi più appropriate e aggiornate.

Questa integrazione dinamica garantisce che le uscite non siano solo accurate storicamente ma anche appropriate in contesto per le condizioni presenti.

Integrazione dell’Autonomia nell’Esecuzione delle Decisioni

Un’altra limitazione significativa delle LLM è la loro mancanza di capacità autonome nell’esecuzione delle decisioni. Le LLM eccellono nella generazione di output basati sul linguaggio ma non soddisfano compiti che richiedono complicate decisioni, specialmente in ambienti caratterizzati da incertezza e cambiamento.

Questo scarto è principalmente dovuto alla dipendenza del modello da dati preesistenti e all’assenza di meccanismi per la ragione adattativa o l’apprendimento da nuove esperienze post-implementazione.

Gli agenti AI affrontano questo problema fornendo l’infrastruttura necessaria per la decisione autonoma. Possono prendere le uscite statiche di un LLM e processarle attraverso framebuffer avanzati come sistemi basati su regole,uristiche o modelli di apprendimento ricorrente.

Ad esempio, in un contesto sanitario, un LLM potrebbe generare una lista di diagnosi potenziali in base ai sintomi e alle informazioni mediche del paziente. Ma senza un agente AI, il LLM non può valutare queste opzioni o raccomandare un trattamento.

Un agente AI può intervenire per valutare queste diagnosi rispetto alla letteratura medica corrente, ai dati del paziente e ai fattori contestuali, generando così una decisione più informata e suggerendo passi successivi attuabili. Questa sinergia trasforma le uscite LLM da semplici suggerimenti in decisioni attuabili e consapevoli del contesto.

Aggiungendo Completezza e coerenza

Completezza e coerenza sono fattori critici per garantire la affidabilità degli output LLM, specialmente in compiti di ragioneamento complessi. A causa della loro natura parametrizzata, gli LLM spesso generano risposte incomplete o logicamente incoerenti, soprattutto quando si devono occupare di processi multi-passo o richiedere una comprensione completa di più domini.

Questi problemi derivano dall’ambiente isolato in cui operano gli LLM, dove non sono in grado di fare riferimento o validare le loro uscite contro standard esterni o informazioni aggiuntive.

Gli agenti AI giocano un ruolo chiave nel mitigare questi problemi introdurre meccanismi di feedback iterativi e strati di validazione.

Per esempio, nel campo legale, un LLM potrebbe redigere una versione iniziale di un memoriale basandosi sul proprio dataset di addestramento. Ma questo bozzetto potrebbe non considerare alcuni precedenti o fallire nell’organizzare logicamente l’argomento.

Un agente AI può revisionare questo bozzetto, garantendo di rispettare i requisiti di completezza richiesti attraverso la cross-referenza con database legali esterni, il controllo per la coerenza logica e la richiesta di informazioni aggiuntive o chiarimenti quando necessario.

Questo processo iterativo consente la produzione di un documento più robusto e affidabile che rispetti i rigorosi requisiti della pratica legale.

Oltrepassare l’isolamento attraverso l’integrazione

Uno dei limiti più profondi degli LLM è l’isolamento innato rispetto ad altri sistemi e fonti di conoscenza.

Gli LLM, così come sono progettati, sono sistemi chiusi che non interagiscono in modo naturale con ambienti esterni o database. Questa isolazione limita significativamente la loro capacità di adattarsi a nuove informazioni o di operare in tempo reale, rendendoli meno efficaci in applicazioni richiedenti interazioni dinamiche o decisioni in tempo reale.

Gli agenti AI superano questo isolamento agendo come piattaforme integrate che collegano LLM a un’ecosistema più ampio di fonti di dati e strumenti computazionali. Attraverso API e altri framework di integrazione, gli agenti AI possono accedere a dati in tempo reale, collaborare con altri sistemi AI e persino interfacciarsi con dispositivi fisici.

Ad esempio, nelle applicazioni di servizio clienti, un PEM potrebbe generare risposte standard basate su script pre-addestrati. Ma queste risposte possono essere statiche e mancare della personalizzazione richiesta per un efficace coinvolgimento del cliente.

Un agente AI può arricchire queste interazioni integrando dati in tempo reale da profili clienti, interazioni precedenti e strumenti di analisi del sentimento, generando risposte non solo contextualmente appropriate ma anche personalizzate ai bisogni specifici del cliente.

Questa integrazione trasforma l’esperienza clienti da una serie di interazioni scriptate in una conversazione dinamica e personalizzata.

Ampliamento Creatività e Risoluzione Problemi

Sebbene i PEM siano potenti strumenti per la generazione di contenuti, la loro creatività e capacità di risoluzione sono limitate in natura dai dati su cui sono stati addestrati. Questi modelli spesso non sono in grado di applicare concetti teorici a nuovi o imprevisti挑战, poiché le loro capacità di risoluzione sono confinate dalla conoscenza preesistente e dai parametri di addestramento.

Gli agenti AI amplificano il potenziale creativo e di risoluzione dei PEM utilizzando tecniche avanzate di ragionamento e una gamma più ampia di strumenti di analisi. Questa capacità consente agli agenti AI di superare le limitazioni dei PEM, applicando schemi teorici ai problemi pratici in modi innovativi.

Per esempio, considerare il problema della combattimento della disinformazione sui social media. Un PEM potrebbe identificare pattern di disinformazione sulla base di analisi testuali, ma potrebbe lottare per sviluppare una strategia completa per mitigare la diffusione di informazioni false.

Un agente AI può prendere queste insight, applicare teorie interdisciplinari provenienti da settori come la sociologia, la psicologia e la teoria delle reti, e sviluppare un approcio robusto, multi-aspirato che include il monitoraggio in tempo reale, l’educazione utenti e tecniche di moderazione automatizzate.

Questa capacità di sintetizzare diversi schemi teorici e applicarli a sfide del mondo reale è un esempio delle capacità di risoluzione problemi potenziate che gli agenti AI portano alla tavola.

Esempi più specifici

Gli agenti AI, con la loro capacità di interagire con sistemi diversi, di accedere a dati in tempo reale e di eseguire azioni, affrontano queste limitazioni direttamente, trasformando i LML da potenti ma passivi modelli di linguaggio in soluzionisti dinamici e reali del mondo reale. Consideriamo qualche esempio:

1. Dai dati statici agli insight dinamici: tenendo i LML aggiornati

-

Il problema: Immaginate di chiedere ad un LMM addestrato prima del 2023, “Cosa sono i più recenti progressi nella terapia del cancro?” La sua conoscenza sarebbe obsoleta.

-

La soluzione dell’agente AI: Un agente AI può collegare il LMM a riviste mediche, banche dati di ricerca e fonti di notizie. Ora, il LMM può fornire informazioni aggiornate sui più recenti trial clinici, opzioni di trattamento e risultati di ricerca.

2. Da Analisi a Azione: Automatizzazione delle Attività Basata sulle Insights dell’LLM

-

Il problema: Un LLM che monitora i social media per una marca potrebbe identificare un aumento di sentimenti negativi ma non può fare nulla per risolverlo.

-

La Soluzione dell’Agente AI: Un agente AI collegato ai social media della marca e dotato di risposte pre approvate può risolvere automaticamente i problemi, rispondere a domande e persino elevare questioni complesse agli rappresentanti umani.

3. Da Primo Bozzetto a Prodotto Polito: Garantire Qualità e Precisione

-

Il problema: Un LLM incaricato di tradurre un manuale tecnico potrebbe produrre traduzioni grammaticalmente corrette ma tecnicamente imprecise a causa della sua mancanza di conoscenze specifiche del campo.

-

La Soluzione dell’Agente AI: Un agente AI può integrare la LLM the dizionari specializzati, glosari, e persino collegarla agli esperti del settore per feedback in tempo reale, garantendo che la traduzione finale sia sia linguisticamente corretta che tecnicamente attendibile.

4. Rottura delle Barriere: Collegamenti LLM al Mondo Reale

-

Il Problema: Una LLM progettata per il controllo delle abitazioni intelligenti potrebbe avere difficoltà ad adattarsi alle routine e ai gusti del utente in cambio.

-

La Soluzione dell’Agente AI: Un agente AI può collegare la LLM ai sensori, ai dispositivi intelligenti e ai calendari utente. Analizzando i pattern di行为 dell’utente, la LLM può imparare a anticipare le necessità, regolare automaticamente le impostazioni di illuminazione e temperatura e persino suggerire playlist musicali personalizzati in base all’ora del giorno e all’attività dell’utente.

5. Dall’imitazione all’innovazione: Espandendo la creatività dell’LLM

-

Il Problema: Un LLM incaricato di comporre musica potrebbe creare pezzi che suonano derivati o mancano di profondità emotiva, dato che si basa principalmente sui modelli presenti nei dati di allenamento.

-

L’ soluzione agente AI: Un agente AI può collegare l’LLM a sensori di biofeedback che misurano le risposte emotive di un compositore a diversi elementi musicali. Incorporando questo feedback in tempo reale, l’LLM può creare musica che sia non solo tecnicamente abile ma anche emotivamente coinvolgente e originale.