La rápida evolución de la inteligencia artificial (IA) ha resultado en una poderosa sinergía entre los grandes modelos de lenguaje (MMLL) y los agentes de IA. Esta dinámica interacción es como la historia de David y Goliat (sin la lucha), donde los ágiles agentes de IA amplifican y mejoran las capacidades de los colosales MMLL.

Este manual explorará cómo los agentes de IA, semejantes a David, están supercargando los MMLL, nuestros modernos Goliat, para ayudar a revolucionar varias industrias y dominios científicos.

Tabla de Contenidos

-

La Emergencia de los Agentes de IA en los Modelos de Lenguaje

-

Capítulo 1: Introducción a los Agentes de IA y los Modelos de Lenguaje

-

Capítulo 2: La Historia de la Inteligencia Artificial y los Agentes de IA

-

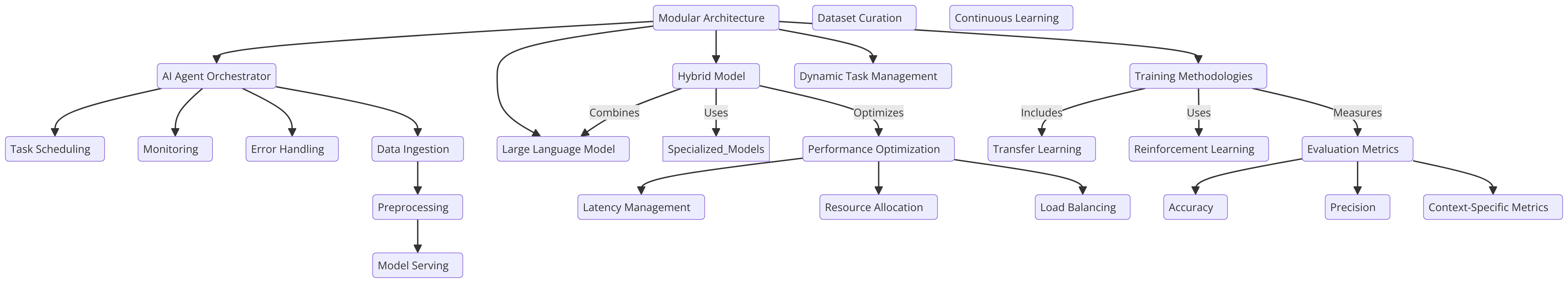

Capítulo 6: Diseño arquitectónico para integrar agentes AI con LLM

La emergencia de los agentes AI en las modelos de lenguaje

Los agentes AI son sistemas autónomos diseñados para percibir su entorno, tomar decisiones y ejecutar acciones para alcanzar objetivos específicos. Cuando se integran con las MLL, estos agentes pueden realizar tareas complejas, razonar sobre información y generar soluciones innovadoras.

Esta combinación ha llevado a avances significativos en varios sectores, desde el desarrollo de software hasta la investigación científica.

Impacto transformador en varias industrias

La integración de los agentes AI con MLL ha tenido un profundo impacto en varias industrias:

-

Desarrollo de Software: Asistentes de codificación basados en IA, como GitHub Copilot, han demostrado la capacidad de generar hasta el 40% del código, lo que resulta en un increíble aumento del 55% en la velocidad de desarrollo.

-

Educación: Asistentes de aprendizaje basados en IA han mostrado promesas en reducir el tiempo de finalización de cursos promedio en un 27%, potencialmente revolucionando el panorama educativo.

-

Transporte: Con proyecciones que sugieren que el 10% de los vehículos serán sin conductor para 2030, los agentes AI autónomos en coches autónomos están listos para transformar la industria del transporte.

Avance de la Descubrimiento Científico

Una de las aplicaciones más emocionantes de los agentes AI y las LLM es en la investigación científica:

-

Descubrimiento de Fármacos: Los agentes AI están acelerando el proceso de descubrimiento de fármacos al analizar grandes conjuntos de datos y predecir candidatos potenciales a fármacos, reduciendo significativamente el tiempo y el costo asociados con los métodos tradicionales.

-

Física de partículas: En el Gran Colisionador de Hadrones (LHC) del CERN, se emplean agentes de AI para analizar datos de colisiones de partículas, utilizando detección de anomalías para identificar pistas prometedoras que podrían indicar la existencia de partículas no descubiertas.

-

Investigación científica general: Los agentes de AI están ampliando el ritmo y el alcance de los descubrimientos científicos al analizar estudios anteriores, identificando enlaces inesperados y proponiendo experimentos novedosos.

La convergencia de los agentes de inteligencia artificial y los grandes modelos de lenguaje (LLMs) está impulsando a la inteligencia artificial hacia una nueva era de capacidades sin precedentes. Este manual comprensivo examina la dinámica interacción entre estas dos tecnologías, revelando su potencial combinado para revolucionar las industrias y resolver problemas complejos.

Retrataremos la evolución de la IA desde sus orígenes hasta el advenimiento de los agentes autónomos y el ascenso de los sofisticados LLMs. También exploraremos consideraciones éticas, que son fundamentales para el desarrollo responsable de la IA. Esto nos ayudará asegurar que estas tecnologías se alinean con nuestros valores humanos y el bienestar de la sociedad.

Al concluir este manual, tendrás una comprensión profunda de la potencia simbiótica de los agentes de IA y los LLMs, junto con el conocimiento y herramientas para aprovechar esta tecnología de vanguardia.

Capítulo 1: Introducción a los Agentes de Inteligencia Artificial y los Modelos de Lenguaje

¿Qué son los Agentes de Inteligencia Artificial y los Modelos de Lenguaje?

La rápida evolución de la inteligencia artificial (IA) ha traido una sinergia transformadora entre los grandes modelos de lenguaje (LLMs) y los agentes de IA.

Los agentes artificiales son sistemas autónomos diseñados para percibir su entorno, tomar decisiones y ejecutar acciones para alcanzar objetivos específicos. presentan características como la autonomía, la percepción, la reactividad, el razonamiento, la toma de decisiones, el aprendizaje, la comunicación y orientación a objetivos.

Por otra parte, los LMS son sistemas artificiales sofisticados que utilizan técnicas de aprendizaje profundo y grandes conjuntos de datos para comprender, generar y predecir texto humanoide.

Estos modelos, como GPT-4, Mistral, LLama, han demostrado capacidades destacadas en tareas de procesamiento de lenguaje natural, incluyendo la generación de texto, traducción de lenguaje y agentes conversacionales.

Características clave de los agentes artificiales

Los agentes artificiales poseen varias características definitorias que los diferencian de los software tradicionales:

-

Autonomía: Pueden operar de manera independiente sin intervención humana constante.

-

Percepción: Los agentes pueden sentir e interpretar su entorno a través de varias entradas.

-

Reactividad: Responden dinámicamente a los cambios en su entorno.

-

Pensamiento y Toma de Decisiones: Los agentes pueden analizar datos y tomar decisiones informadas.

-

Aprendizaje: Mejoran su rendimiento con el tiempo a través de la experiencia.

-

Comunicación: Los agentes pueden interactuar con otros agentes o humanos utilizando varios métodos.

-

Orientación hacia los objetivos: Están diseñados para alcanzar objetivos específicos.

Capacidades de los Modelos de Lenguaje de gran Escala

Los LLM han demostrado una amplia gama de capacidades, incluyendo:

-

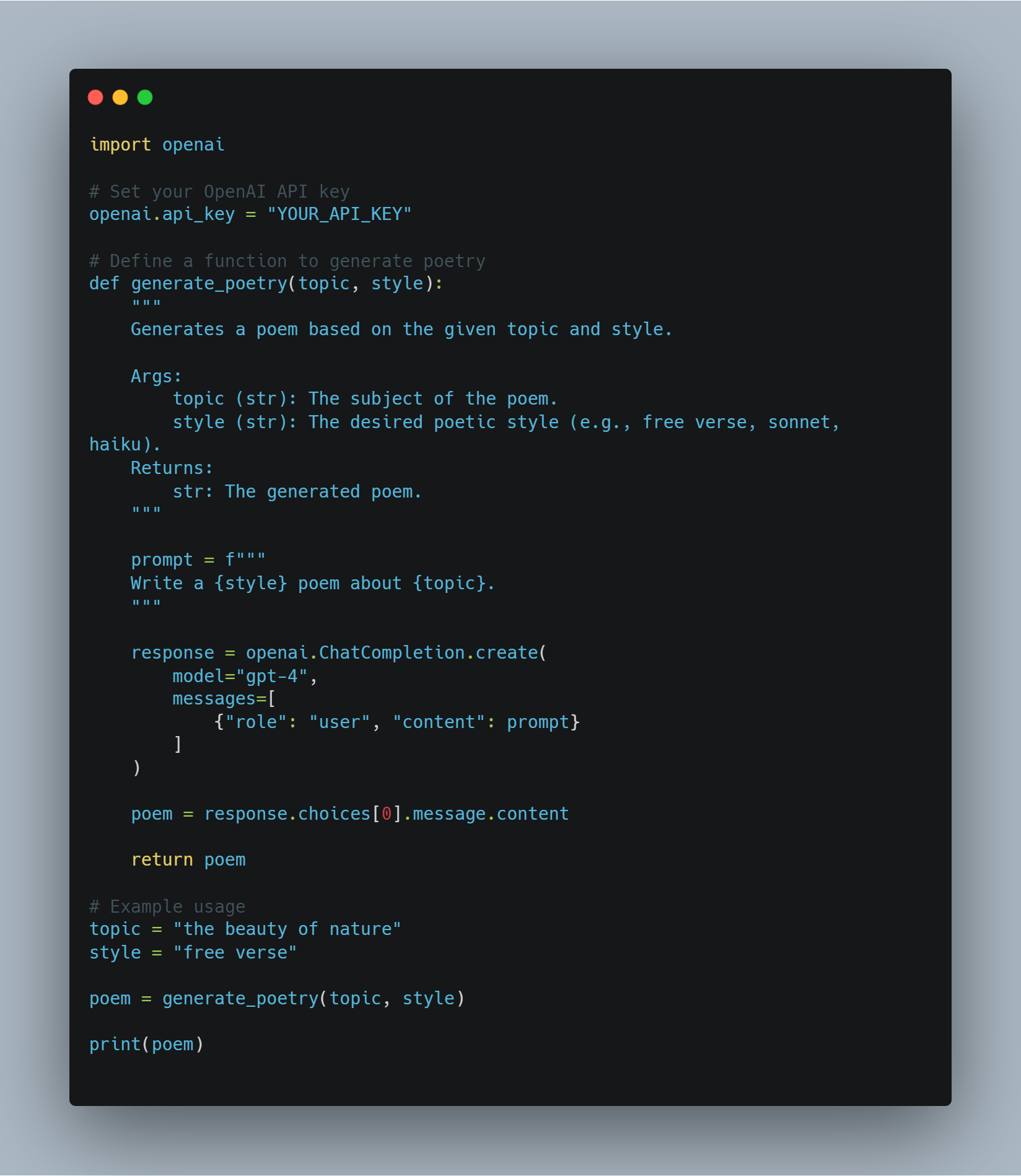

Generación de Texto: Los LLM pueden producir texto coherente y relevante contextualmente basado en los prompts.

-

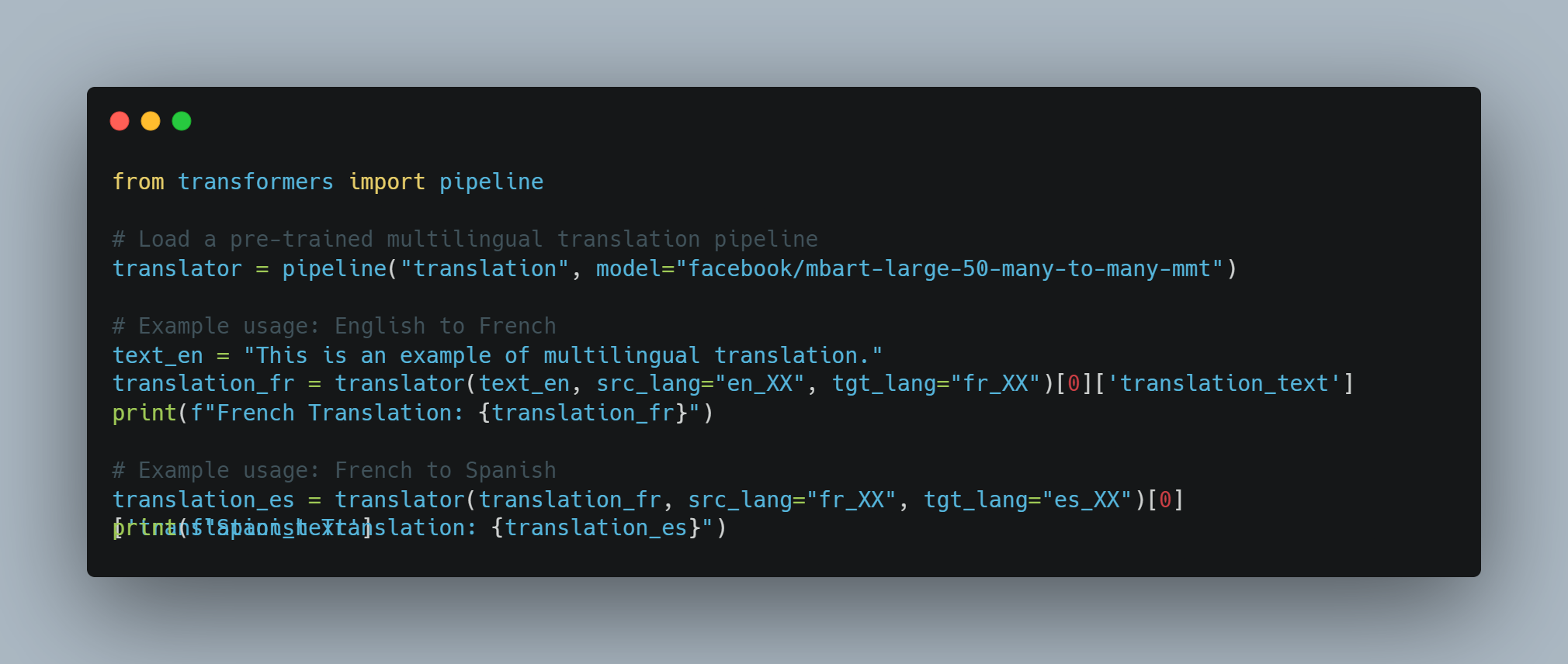

Traducción de Lenguaje: Pueden traducir texto entre diferentes lenguas con alta precisión.

-

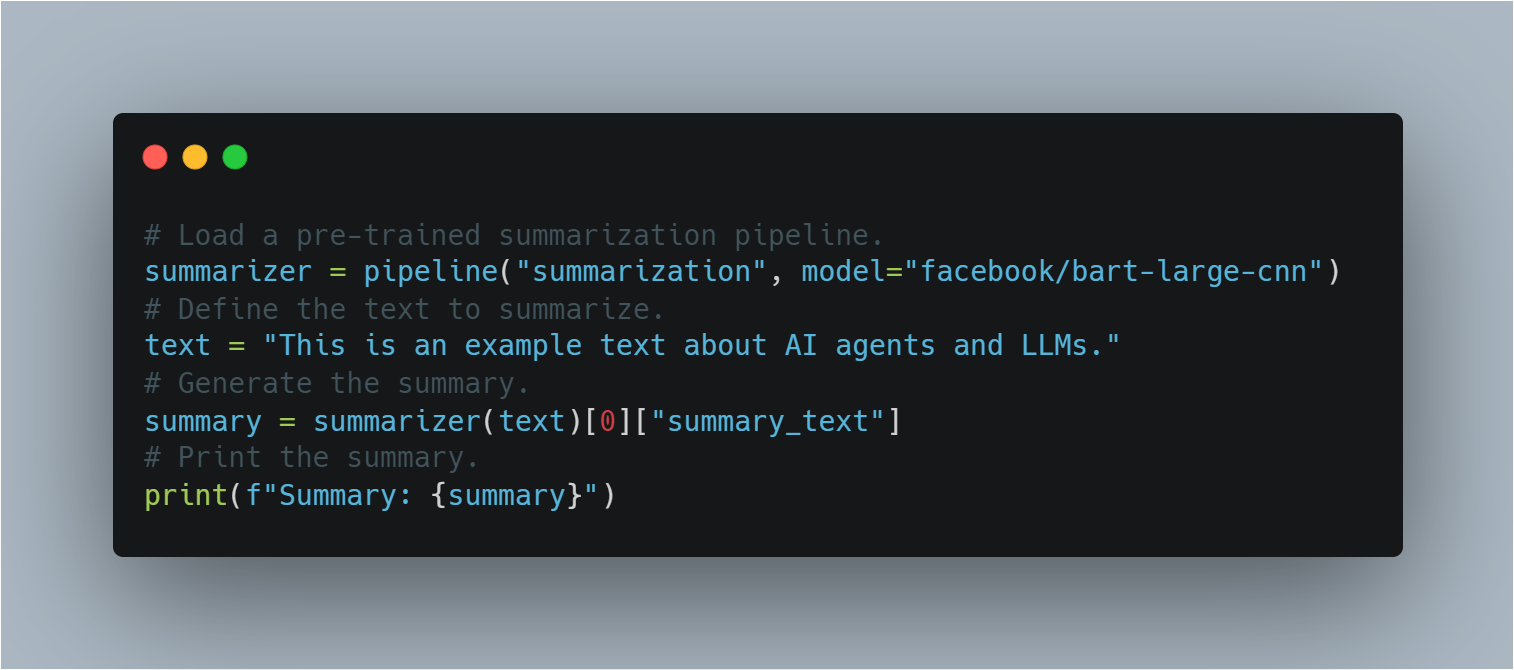

Resumen

: Las LLM pueden condensar textos largos en resúmenes concisos mientras retienen información clave.

-

Respuesta a preguntas: Pueden proporcionar respuestas precisas a preguntas basadas en su amplia base de conocimientos.

-

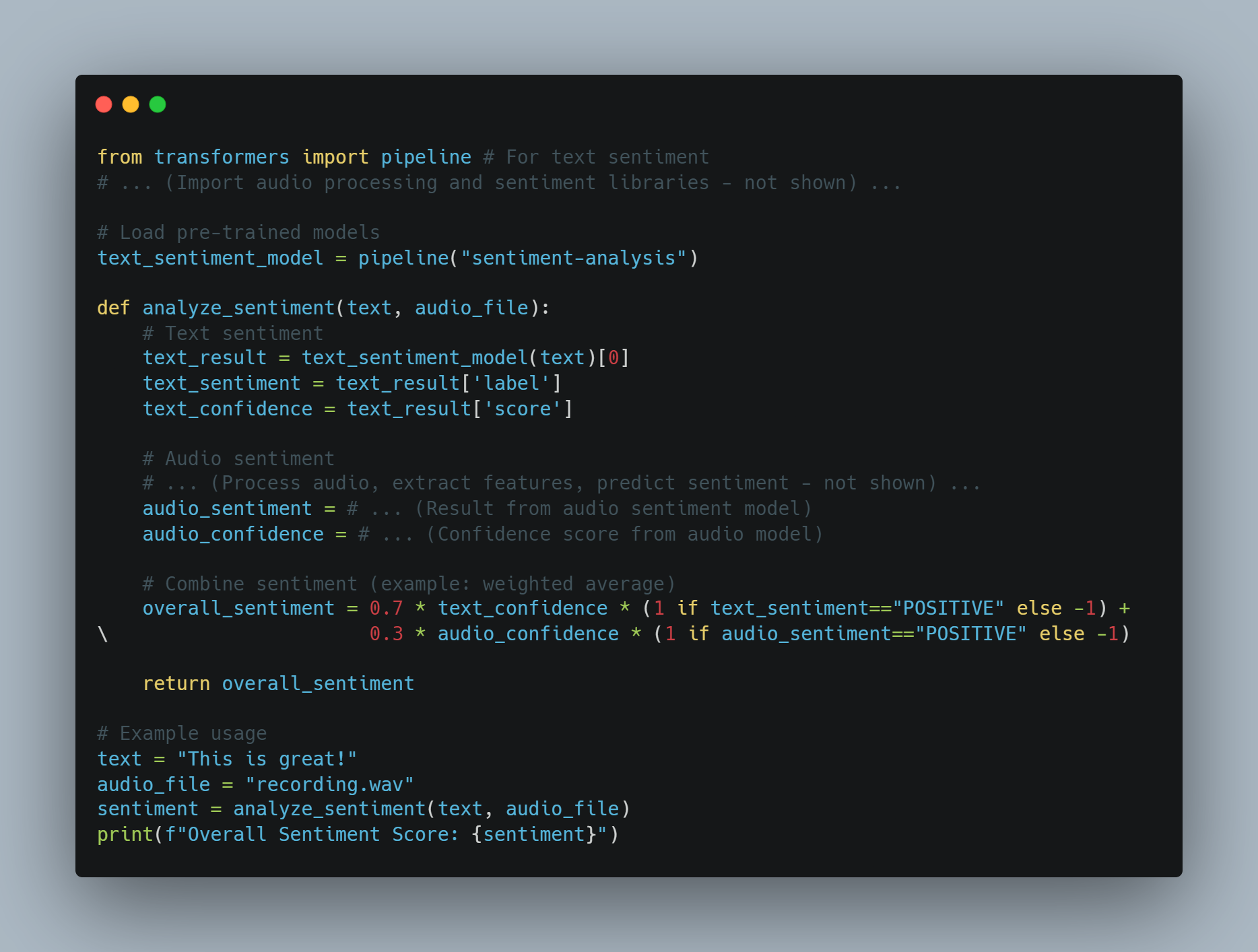

Análisis de sentimento: Las LLM pueden analizar y determinar el sentimiento expresado en un texto dado.

-

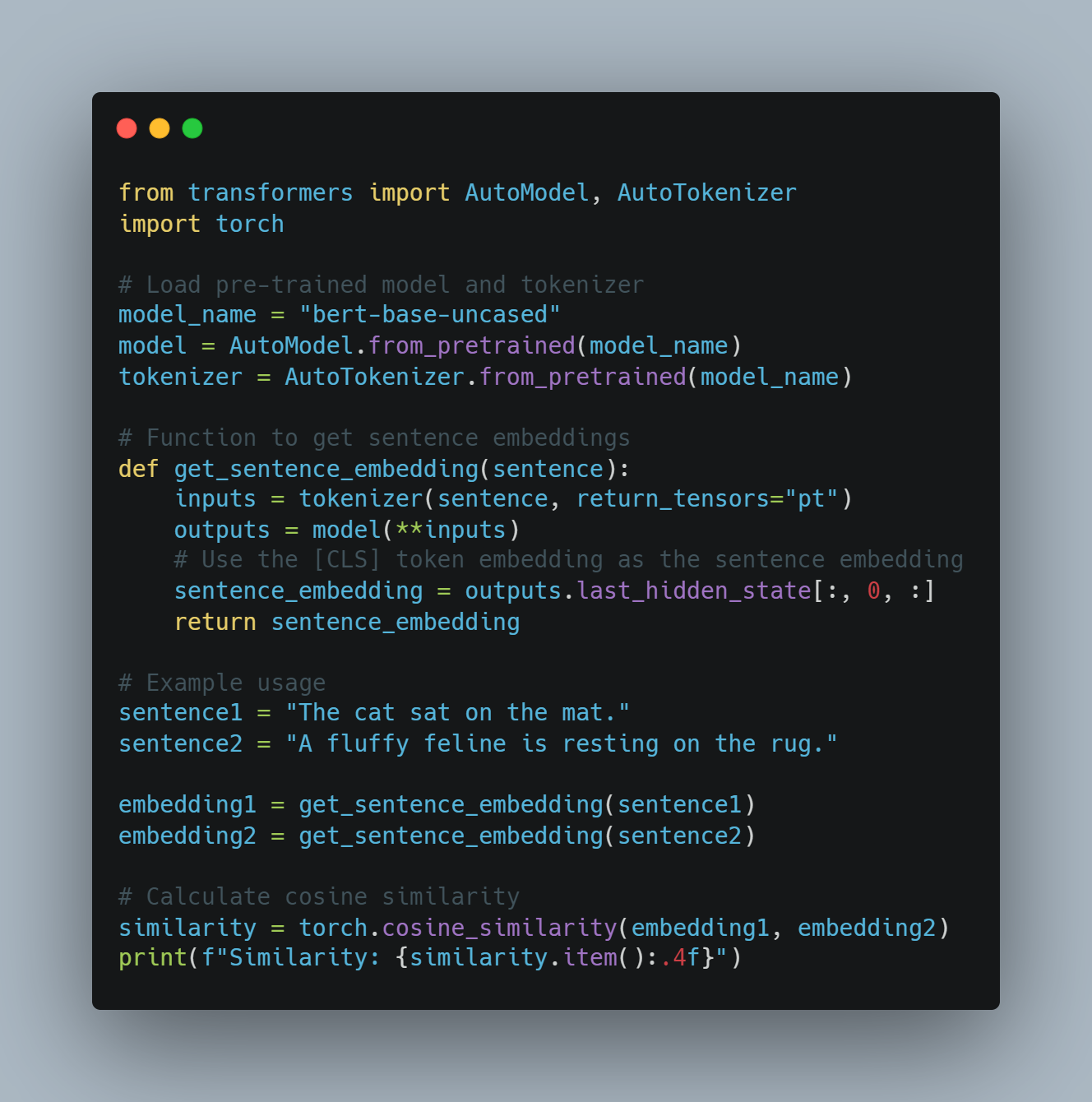

Generación de código: Pueden generar fragmentos de código o funciones enteras basado en descripciones en lenguaje natural.

Niveles de los agentes de AI

Los agentes de AI pueden clasificarse en diferentes niveles en función de sus capacidades y complejidad. Según un documento en arXiv, los agentes de AI se categorizan en cinco niveles:

-

Nivel 1 (L1): Agentes de AI como asistentes de investigación, donde los científicos establecen hipótesis y especifican tareas para alcanzar objetivos.

- Nivel 2 (L2): Agentes de AI que pueden realizar tareas específicas de forma autónoma en un ámbito definido, como análisis de datos o toma de decisiones simples.

-

Nivel 3 (L3): Agentes de AI capaces de aprender de la experiencia y adaptarse a nuevas situaciones, mejorando sus procesos de toma de decisiones.

-

Nivel 4 (L4): Agentes de AI con habilidades avanzadas de razonamiento y resolución de problemas, capaces de manejar tareas complejas de varios pasos.

-

Nivel 5 (L5): Agentes de AI completamente autónomos que pueden operar independientemente en entornos dinámicos, tomando decisiones y realizando acciones sin intervención humana.

Limitaciones de los Modelos de Lenguaje Grandes

Costos de Entrenamiento y Restricciones de Recursos

Los modelos de lenguaje grandes (LLM) como GPT-3 y PaLM han revolucionado el procesamiento del lenguaje natural (NLP) al aprovechar técnicas de aprendizaje profundo y conjuntos de datos vastos.

Pero estos avances van acompañados de un costo significativo. La capacitación de LLS requiere recursos computacionales sustanciales, generalmente implicando miles de GPUs y un consumo energético extensivo.

Según Sam Altman, director general de OpenAI, el costo de entrenamiento de GPT-4 superó los 100 millones de dólares. Esto se ajusta al tamaño y complejidad del modelo reportados, con estimaciones que sugieren que tiene alrededor de 1 billón de parámetros. Sin embargo, otras fuentes ofrecen cifras diferentes:

-

Un informe filtrado indicó que el costo de entrenamiento de GPT-4 fue de aproximadamente 63 millones de dólares, considerando la potencia computacional y la duración del entrenamiento.

-

A mediados de 2023, algunas estimaciones sugerían que entrenar un modelo similar a GPT-4 podría costar alrededor de 20 millones de dólares y tardar alrededor de 55 días, reflejando avances en eficiencia.

Este elevado costo del entrenamiento y la mantención de los LMM limita su adopción generalizada y escalabilidad.

Limitaciones de los Datos y Bias

El rendimiento de los LMM depende en gran medida de la calidad y diversidad de los datos de entrenamiento. A pesar de haber sido entrenados en datos masivos, los LMM pueden todavía mostrar prejuicios presentes en los datos, llevando a resultados sesgados o inadecuados. Estos prejuicios pueden manifestionarse en varias formas, incluyendo prejuicios de género, étnico y cultural, que pueden perpetuar estereotipos e información errónea.

También, la naturaleza estática de los datos de entrenamiento significa que los LMM pueden no estar actualizados con la información más reciente, limitando su efectividad en entornos dinámicos.

Especialización yComplejidad

Mientras que los LMM sobresalen en tareas generales, a menudo tienen dificultades con tareas especializadas que requieren conocimiento específico del dominio y complejidad alta.

Por ejemplo, las tareas en campos como la medicina, la ley y la investigación científica exigen un profundo entendimiento delterminología especializada y la lógica compleja, que los LMM pueden no poseer inicialmente. Esta limitación requiere la integración de capas adicionales de experiencia y afinado para hacer que los LMM sean efectivos en aplicaciones especializadas.

Límites de Entrada y Sensoriales

Las LLMs (Long Short-Term Memory) procesan principalmente entradas basadas en texto, lo que les impide interactuar de forma multimodal con el mundo. Aunque pueden generar y comprender texto, carecen de la capacidad de procesar entradas visuales, auditivas o sensoriales directamente.

Esta limitación obstaculiza su aplicación en campos que requieren una integración sensorial comprehensiva, como la robótica y los sistemas autónomos. Por ejemplo, una LLM no puede interpretar datos visuales de una cámara o datos auditivos de un micrófono sin capas de procesamiento adicionales.

Restricciones de Comunicación e Interacción

Las actuales capacidades de comunicación de las LLMs son predominantemente basadas en texto, lo que limita su capacidad para participar en formas más inmersivas e interactivas de comunicación.

Por ejemplo, mientras las LLMs pueden generar respuestas de texto, no pueden producir contenido de vídeo o representaciones holográficas, que son cada vez más importantes en las aplicaciones de realidad virtual y aumentada (leer más aquí). Esta restricción reduce la efectividad de las LLMs en entornos que demandan interacciones multimodales ricas.

Cómo Superar las Limitaciones con los Agentes de IA

Los agentes de inteligencia artificial ofrecen una solución prometedora para muchas de las limitaciones enfrentadas por las LLMs. Estos agentes están diseñados para operar de forma autónoma, percibir su entorno, tomar decisiones y ejecutar acciones para alcanzar metas específicas. Al integrar agentes de IA con LLMs, es posible mejorar sus capacidades y abordar sus limitaciones inherentes.

-

Mejorado Contexto y Memoria: Los agentes AI pueden mantener contexto a lo largo de múltiples interacciones, permitiendo respuestas más coherentes y pertinentes en contexto. Esta capacidad es particularmente útil en aplicaciones que requieren memoria a largo plazo y continuidad, como el servicio al cliente y los asistentes personales.

-

Integración Multimodal: Los agentes AI pueden incorporar entradas sensoriales de diferentes fuentes, como cámaras, micrófonos y sensores, permitiendo a los LLM procesar y responder a datos visuales, auditivos y sensoriales. Esta integración es crucial para aplicaciones en robótica y sistemas autónomos.

-

Conocimiento Especializado y Experiencia: Los agentes de AI se pueden afinar con conocimiento específico del dominio, mejorando la capacidad de LLM para realizar tareas especializadas. Este enfoque permite la creación de sistemas expertos que pueden manejar consultas complejas en campos como la medicina, la ley y la investigación científica.

-

Comunicación Interactiva e Inmersiva: Los agentes de AI pueden facilitar formas más inmersivas de comunicación generando contenido de video, controlando pantallas holográficas e interactuando con entornos virtuales y de realidad aumentada. Esta capacidad amplía la aplicación de LLM en campos que requieren interacciones ricas y multimodales.

Aunque las modelos de lenguaje grande han demostrado capacidades destacables en el procesamiento del lenguaje natural, no están exentos de limitaciones. Los altos costos de entrenamiento, los sesgos en los datos, los desafíos de especialización, las limitaciones sensoriales y las restricciones de comunicación presentan obstáculos significativos.

Pero la integración de los agentes inteligentes artificiales ofrece una vía viable para superar estas limitaciones. Al aprovechar las ventajas de los agentes inteligentes artificiales, es posible mejorar la funcionalidad, adaptabilidad y aplicabilidad de las MLL, abriendo camino a sistemas inteligentes artificiales más avanzados y versátiles.

Capítulo 2: La Historia de la Inteligencia Artificial y los Agentes AI

El origen de la Inteligencia Artificial

El concepto de inteligencia artificial (IA) tiene raíces que se extienden mucho más allá de la era digital moderna. La idea de crear máquinas capaces de razonar de manera similar a los humanos se puede rastrear hasta mitos antiguos y debates filosóficos. Pero la formalización de la IA como una disciplina científica tuvo lugar a mediados del siglo XX.

La Conferencia de Dartmouth de 1956, organizada por John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon, es ampliamente considerada como el lugar de nacimiento de la inteligencia artificial como campo de estudio. Este evento seminal reunió a investigadores líderes para explorar el potencial de crear máquinas que pudieran simular la inteligencia humana.

Optimismo Inicial y el Invierno de la IA

Los primeros años de la investigación en IA estuvieron caracterizados por optimismo desbordante. Los investigadores lograron importantes avances en el desarrollo de programas capaces de resolver problemas matemáticos, jugar juegos y incluso realizar procesamiento de lenguaje natural en su estado más rudimentario.

Pero este entusiasmo inicial se calmó con la comprensión de que la creación de máquinas realmente inteligentes era mucho más compleja de lo anticipado inicialmente.

La década de 1970 y 1980 vieron una época de financiación reducida y de interés en la investigación de la IA, comúnmente referida como el “Invierno de la IA“. este declive se debió principalmente al fracaso de los sistemas de IA para cumplir con las expectativas altas establecidas por los pioneros tempranos.

De los Sistemas Base en Reglas a Aprendizaje Automático

La Era de los Sistemas Expertos

La década de 1980 presenció un resurgimiento del interés en la IA, principalmente impulsado por el desarrollo de los sistemas expertos. Estos programas basados en reglas fueron diseñados para emular los procesos de toma de decisiones de expertos humanos en determinados dominios.

Sistemas expertos encontraron aplicaciones en varios campos, incluyendo la medicina, las finanzas y la ingeniería. Sin embargo, estaban limitados por su incapacidad para aprender de la experiencia o adaptarse a situaciones nuevas fuera de sus reglas programadas.

El ascenso de la Aprendizaje Automático

Las limitaciones de los sistemas basados en reglas abrieron la puerta a un cambio de paradigma hacia el aprendizaje automático. Este enfoque, que adquirió relevancia en la década de 1990 y 2000, se enfoca en desarrollar algoritmos que puedan aprender de datos y hacer predicciones o tomar decisiones basadas en estos.

Técnicas de aprendizaje automático, como redes neuronales y máquinas de soporte vectorial, demostraron un éxito destacado en tareas como la reconocimiento de patrones y la clasificación de datos. La aparición de los grandes datos y la potencia computacional aumentada impulsaron aún más el desarrollo y aplicación de algoritmos de aprendizaje automático.

La emergencia de agentes AI autónomos

De la IA Especializada a la IA General

Mientras tanto, como las tecnologías de AI seguían evolucionando, los investigadores comenzaron a explorar la posibilidad de crear sistemas más versátiles y autónomos. Este cambio marcó la transición de la IA especializada, diseñada para tareas específicas, hacia la búsqueda de la inteligencia artificial general (AGI).

AGI tiene como objetivo desarrollar sistemas capaces de realizar cualquier tarea intelectual que puede realizar un ser humano. Mientras que la AGI verdadera permanece como un objetivo lejano, se ha logrado un progreso significativo en la creación de sistemas AI más flexibles y adaptables.

El papel de la Aprendizaje Profundo y las Redes Neuronales

El surgimiento del aprendizaje profundo, un subconjunto del aprendizaje automático basado en redes neuronales artificiales, ha sido fundamental para avanzar en el campo de la IA.

Algoritmos de aprendizaje profundo, inspirados en la estructura y función del cerebro humano, han demostrado capacidades excepcionales en áreas como la reconocimiento de imágenes y voz, el procesamiento del lenguaje natural y el juego. Estos avances han puesto las bases para el desarrollo de agentes autónomos de IA más sofisticados.

Características y Tipos de Agentes AI

Los agentes AI son sistemas autónomos capaces de percibir su entorno, tomar decisiones y realizar acciones para alcanzar objetivos específicos. Tienen características como la autonomía, la percepción, la reactividad, el razonamiento, la toma de decisiones, el aprendizaje, la comunicación y la orientación hacia los objetivos.

Hay varios tipos de agentes AI, cada uno con capacidades únicas:

-

Agentes de Reflejo Simple: Responden a estímulos específicos basados en reglas predefinidas.

-

Agentes Reflejos Basados en Modelo: Mantienen un modelo interno del entorno para tomar decisiones.

-

Agentes Basados en Objetivos: Ejecutan acciones para alcanzar objetivos específicos.

-

Agentes Basados en Utilidad: Consideran resultados potenciales y eligen acciones que maximizan la utilidad esperada.

-

Agentes Aprendedores: Mejoran la toma de decisiones con el tiempo a través de técnicas de aprendizaje automático.

Retos y Consideraciones Éticas

Como los sistemas AI se hacen cada vez más avanzados y autónomos, traen consideraciones críticas para asegurar que su uso se mantiene dentro de los límites aceptados socialmente.

Los Modelos de Lenguaje Large (LLMs), en particular, actúan como supercargadores de la productividad. Pero esto plantea una cuestión crucial: ¿Qué harán estos sistemas supercargar -intenciones buenas o malas? Cuando la intención detrás del uso de AI es malévola, resulta imprescindible que estos sistemas detecten este uso indebido utilizando varias técnicas de NLP o otras herramientas a nuestro disposición.

Los ingenieros de ML tienen acceso a una gama de herramientas y metodologías para abordar estos desafíos:

-

Análisis de Sentimientos: Al emplear el análisis de sentimientos, los LLM pueden evaluar la tonalidad emocional del texto para detectar lenguaje dañino o agresivo, ayudando a identificar un posible uso indebido en plataformas de comunicación.

-

Filtrado de Contenido: herramientas como el filtrado por palabras clave y el ajuste de patrones se pueden utilizar para prevenir la generación o la difusión de contenido dañino, como el discurso de odio, la desinformación o material explícito.

-

Herramientas de Detección de Bias: La implementación de marcos de detección de sesgos, como AI Fairness 360 (IBM) o Fairness Indicators (Google), puede ayudar a identificar y mitigar los sesgos en los modelos de lenguaje, garantizando que los sistemas de AI operan de manera justa y equitativa.

-

Técnicas de Explicabilidad: Utilizando herramientas de explicabilidad como LIME (Local Interpretable Model-agnostic Explanations) o SHAP (SHapley Additive exPlanations), los ingenieros pueden comprender y explicar los procesos de toma de decisiones de los LLMs, facilitando la detección y el abordaje de comportamientos no intencionados.

-

Pruebas de Adversario: Simulando ataques maliciosos o entradas dañinas, los ingenieros pueden someter a prueba de estrés a los LLMs utilizando herramientas como TextAttack o Adversarial Robustness Toolbox, identificando vulnerabilidades que podrían ser explotadas con fines maliciosos.

-

Guías y Marcos de AI Ética: Adoptar guías de desarrollo de AI ético, como las proporcionadas por el IEEE o la Asociación en AI, puede guiar la creación de sistemas de AI responsables que prioricen el bienestar social.

Además de estas herramientas, es por eso que necesitamos un equipo Red Team dedicado para AI —equipos especializados que empujan a las LLM hasta sus límites para detectar lagunas en sus defensas. Los equipos Red Team simulan escenarios adversarios y descubren vulnerabilidades que podrían dejar de ser notadas.

Pero es importante reconocer que la gente detrás del producto tiene por mucho el mayor efecto sobre él. Muchos de los ataques y desafíos que enfrentamos hoy han existido incluso antes de que se desarrollaran las LLM, destacando que el elemento humano permanece central para asegurar que la AI sea utilizada éticamente y responsablemente.

La integración de estas herramientas y técnicas en la pipeline de desarrollo, junto con un vigilante equipo Red Team, es fundamental para asegurar que las LLM se utilizan para supercargar resultados positivos y detectar y prevenir su mal uso.

Capítulo 3: Dónde destacan más las inteligencias artificiales

Las fortalezas únicas de los agentes AI

Los agentes AI se destacan gracias a su capacidad para percibir autonomáticamente su entorno, tomar decisiones y ejecutar acciones para alcanzar objetivos específicos. Esta autonomía, combinada con capacidades avanzadas de aprendizaje automático, permite a los agentes AI realizar tareas que son demasiado complejas o demasiado repeticivas para los humanos.

Aquí están las principales ventajas que hacen brillar a los agentes artificiales inteligentes:

-

Autonomía y Eficiencia: Los agentes artificiales inteligentes pueden operar de manera independiente sin intervención humana constante. Esta autonomía les permite manejar tareas las 24 horas del día, los 7 días de la semana, mejorando significativamente la eficiencia y la productividad. Por ejemplo, los chatbots impulsados por inteligencia artificial pueden manejar hasta un 80% de las consultas de clientes habituales, reduciendo los costos operativos y mejorando los tiempos de respuesta.

-

Tomada de Decisiones Avanzada: Los agentes artificiales inteligentes pueden analizar grandes cantidades de datos para tomar decisiones informadas. Esta capacidad es particularmente valiosa en campos como la finanza, donde los bots de trading impulsados por inteligencia artificial pueden aumentar significativamente la eficiencia de los trades.

-

Aprendizaje y adaptabilidad: Los agentes de AI pueden aprender de la experiencia y adaptarse a nuevas situaciones. Esta mejora continua les permite mejorar su desempeño con el tiempo. Por ejemplo, los asistentes médicos de AI pueden ayudar a reducir los errores de diagnóstico, mejorando los resultados de la atención médica.

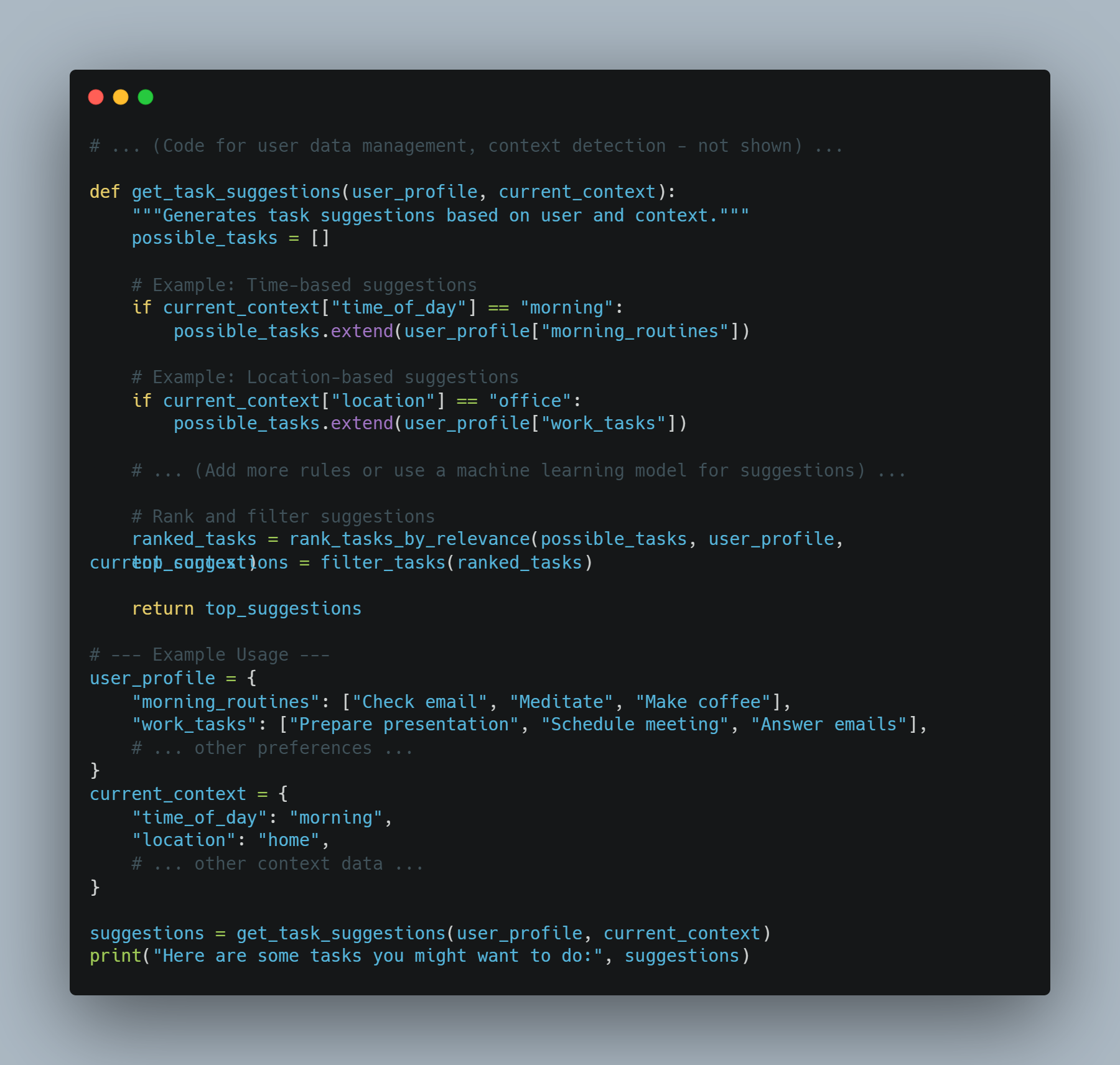

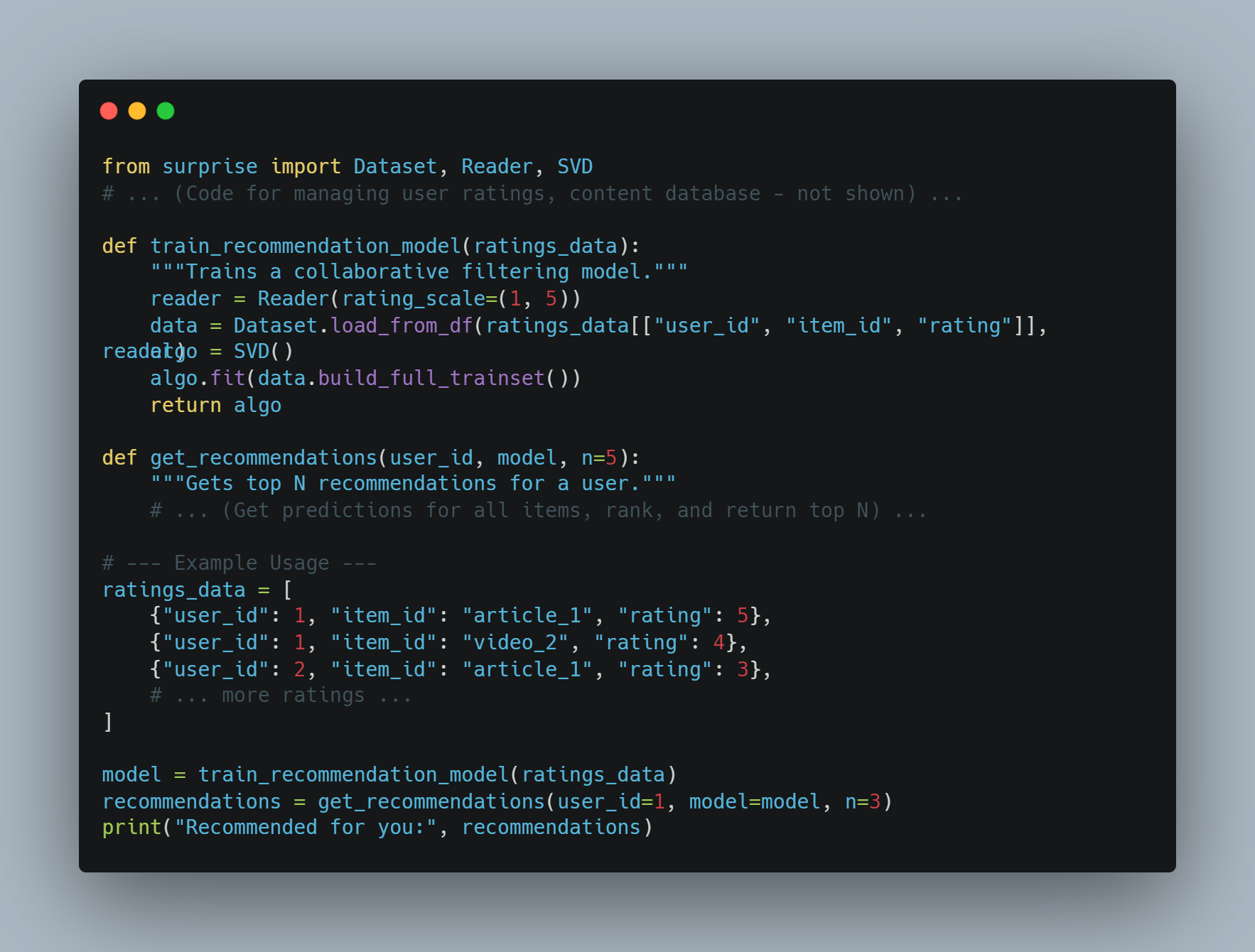

- Personalización: Los agentes de AI pueden proporcionar experiencias personalizadas analizando el comportamiento y las preferencias del usuario. El motor de recomendaciones de Amazon, que genera el 35% de sus ventas, es un ejemplo principal de cómo los agentes de AI pueden mejorar la experiencia del usuario y aumentar los ingresos.

Por qué los agentes de AI son la solución

Los agentes de inteligencia artificial ofrecen soluciones a muchos de los desafíos que enfrentan los sistemas de software tradicionales y operados por humanos. Esta es la razón por la cual son la opción preferida:

-

Escalabilidad: Los agentes de inteligencia artificial pueden escalar operaciones sin un aumento proporcional en los costos. Esta escalabilidad es crucial para las empresas que buscan crecer sin aumentar significativamente su fuerza laboral o gastos operacionales.

-

Consistencia y confiabilidad: A diferencia de los humanos, los agentes de inteligencia artificial no sufren de fatiga o inconsistencia. Pueden realizar tareas repetitivas con alta precisión y confiabilidad, garantizando un rendimiento consistente.

-

Información basada en datos: Los agentes de inteligencia artificial pueden procesar y analizar grandes conjuntos de datos para descubrir patrones e insights que podrían ser pasados por alto por los humanos. Esta capacidad es invaluable para la toma de decisiones en áreas como la finanza, la atención médica y la marketing.

-

Ahorro de costes: al automatizar las tareas rutinarias, los agentes de IA pueden reducir la necesidad de recursos humanos, lo que supone un importante ahorro de costes. Por ejemplo, los sistemas de detección de fraude potenciados por IA pueden ahorrar miles de millones de dólares anuales al reducir las actividades fraudulentas.

Condiciones necesarias para que los agentes de IA funcionen bien

Para garantizar el éxito del despliegue y el rendimiento de los agentes de IA, deben cumplirse ciertas condiciones:

-

Objetivos y casos de uso claros: Definir objetivos y casos de uso específicos es crucial para el despliegue eficaz de los agentes de IA. Esta claridad ayuda a establecer expectativas y medir el éxito. Por ejemplo, establecer un objetivo para reducir los tiempos de respuesta del servicio de atención al cliente en un 50% puede guiar el despliegue de chatbots de IA.

-

Calidad de los Datos: Los agentes de AI dependen de datos de alta calidad para su entrenamiento y funcionamiento. Asegurar que los datos sean precisos, relevantes y actualizados es fundamental para que los agentes tomen decisiones informadas y funcionen efectivamente.

-

Integración con Sistemas Existentes: La integración sin problemas con sistemas existentes y flujos de trabajo es necesaria para que los agentes de AI funcionen de manera óptima. Esta integración garantiza que los agentes de AI puedan acceder a los datos necesarios y interactuar con otros sistemas para realizar sus tareas.

-

Monitoreo y Optimización Continuos: El monitoreo y optimización periódicos de los agentes de AI son cruciales para mantener su rendimiento. Esto implica la supervisión de indicadores clave de rendimiento (KPIs) y la realización de ajustes necesarios basados en retroalimentación y datos de rendimiento.

-

Consideraciones éticas y mitigación de sesgos: La atención a consideraciones éticas y la mitigación de sesgos en los agentes AI es fundamental para garantizar equidad e inclusividad. La implementación de medidas para detectar y prevenir sesgos puede ayudar en la construcción de confianza y en la garantía de un despliegue responsable.

Mejores prácticas para el despliegue de agentes AI

Al desplegar agentes AI, siguiendo las mejores prácticas puede asegurar su éxito y efectividad:

-

Defina objetivos y casos de uso: Identifique claramente los objetivos y casos de uso para el despliegue de agentes AI. Esto ayuda en la establecimiento de expectativas y la medición del éxito.

-

Seleccione la Plataforma AI correcta: Elija una plataforma AI que se ajuste a sus objetivos, casos de uso y infraestructura existente. Considere factores como las capacidades de integración, la escalabilidad y el costo.

-

Desarrolle una Base de Conocimiento Comprensiva: Construya una base de conocimiento bien estructurada y precisa para permitir que los agentes AI proporcionen respuestas relevantes y confiables.

-

Asegúrese de una Integración Seamless: Integre los agentes AI con sistemas existentes como CRM y tecnologías de centro de llamadas para proporcionar una experiencia de cliente unificada.

-

Capacite y Optimice los Agentes AI: Capacite y optimice continuamente los agentes AI utilizando datos de interacciones. Monitorice el rendimiento, identifique áreas para mejorar y actualice los modelos correspondientemente.

-

Implementar Procedimientos de E escalación Apropiados: Establecer protocolos para transferir llamadas complejas o emotivas a agentes humanos, garantizando una transición suave y una resolución eficiente.

-

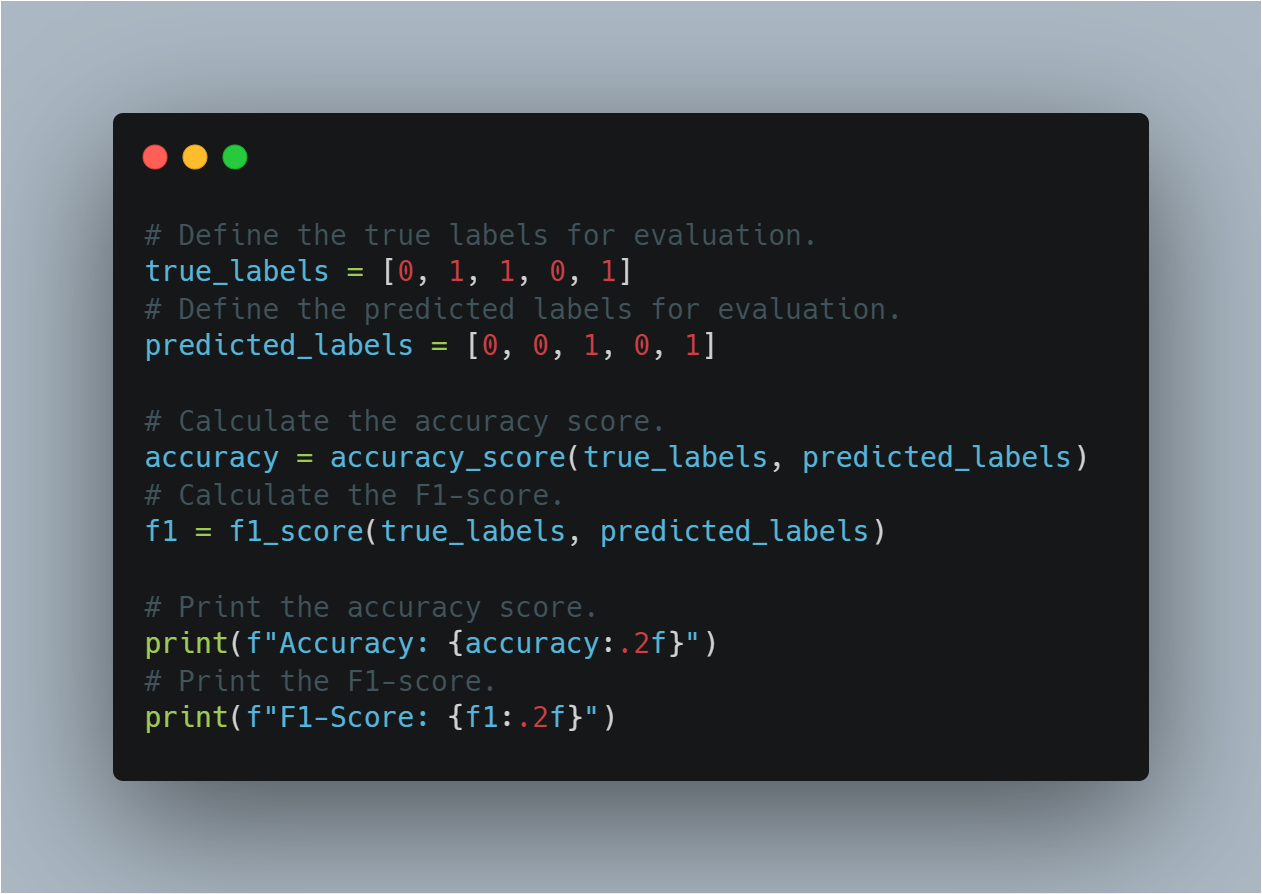

Monitorear y Analizar Rendimiento: Realizar seguimiento de indicadores clave de rendimiento (KPIs) como las tasas de resolución de llamadas, el tiempo de atención promedio y las puntuaciones de satisfacción del cliente. Utilizar herramientas de análisis para obtener insights y tomar decisiones basadas en datos.

-

Asegurar Privacidad y Seguridad de Datos: Las medidas de seguridad robustas son claves, como hacer que los datos sean anónimos, garantizar una supervisión humana, establecer políticas para la retención de datos y poner en marcha medidas de cifrado fuertes para proteger los datos del cliente y mantener la privacidad.

Agentes AI + LLM: Una Nueva Era de Software Inteligente

Imagine un software que no solo entiende tus solicitudes sino que también las lleva a cabo. Esa es la promesa de combinar agentes AI con Modelos de Lenguaje Largos (LLMs). Esta poderosa pareja está creando una nueva generación de aplicaciones que son más intuitivas, capaces y impactantes que nunca antes.

Agentes AI: Más allá de la Ejecución de Tareas Simples

Mientras que a menudo se compara con asistentes digitales, los agentes AI son mucho más que seguidores de guiones exagerados. Incluyen una gama de tecnologías sofisticadas y operan en un marco que permite tomar decisiones dinámicas y tomar acciones.

-

Arquitectura: Un agente AI típico comprende varios componentes clave:

-

Sensores: Estos permiten que el agente perciba su entorno, recopilando datos de varias fuentes como sensores, API o entrada del usuario.

-

Estado de Creencias: Representa la comprensión del mundo del agente basada en los datos recopilados. Se actualiza constantemente a medida que se hace disponible nueva información.

-

Motor de Razonamiento: Este es el núcleo del proceso de toma de decisiones del agente. Utiliza algoritmos, a menudo basados en aprendizaje por reforzamiento o técnicas de planificación, para determinar la mejor acción en base a sus creencias actuales y objetivos.

-

Actuadores: Estos son las herramientas del agente para interactuar con el mundo. Pueden variar desde enviar llamadas a API hasta controlar robots físicos.

-

-

Retos: Los agentes de inteligencia artificial tradicionales, aunque expertos en manejar tareas bien definidas, a menudo tienen dificultades con:

-

Comprensión del Lenguaje Natural: La interpretación del lenguaje humano complejo, el manejo de ambigüedades y la extracción de significado del contexto siguen siendo desafíos importantes.

-

Razonamiento con Sentido Común: Actualmente, los agentes de inteligencia artificial a menudo carecen de los conocimientos de sentido común y las habilidades de razonamiento que los humanos toman por sentado.

-

Generalización: La formación de agentes para que funcionen bien en tareas no vistas o adaptarse a nuevos entornos sigue siendo un área clave de investigación.

-

LLMs: Desbloqueando la Comprensión y la Generación del Lenguaje

Los LLMs, con su vasto conocimiento codificado dentro de miles de millones de parámetros, traen una capacidad sin precedente del lenguaje a la mesa:

-

Arquitectura de Transformer: La base de la mayoría de los actuales LLMs es la arquitectura de transformer, un diseño de red neuronal que destaca en la procesación de datos secuenciales como el texto. Esto permite que los LLMs capture dependencias a largo plazo en el lenguaje, lo que les permite comprender el contexto y generar texto coherente y relevante contextualmente.

-

Capacidades: Los LLMs sobresalen en una amplia gama de tareas basadas en el lenguaje:

-

Generación de Texto: Desde la escritura de ficción creativa hasta la generación de código en varios lenguajes de programación, los LLMs muestran una fluidez y creatividad destacadas.

-

Respuesta a Preguntas: Pueden proporcionar respuestas concisas y precisas a las preguntas, incluso cuando la información se encuentra distribuida a lo largo de documentos largos.

-

Resumir: Los LLMs pueden condensar grandes volúmenes de texto en resúmenes concisos, extraeniendo información clave y descartando detalles irrelevantes.

-

-

Limitaciones: A pesar de sus impresionantes habilidades, los LLM tienen limitaciones:

-

Falta de Anclaje en el Mundo Real: Los LLM principalmente operan en el ámbito del texto y carecen de la capacidad de interactuar directamente con el mundo físico.

-

Potencial para el Bias y la Alucinación: Entrenados en bases de datos masivas, no curadas, los LLM pueden heredar prejuicios presentes en los datos y, a veces, generar información factíamente incorrecta o no sensata.

-

La Sinergia: Puente entre el Lenguaje y la Acción

La combinación de agentes AI y LLM aborda las limitaciones de cada uno, creando sistemas que son tanto inteligentes como capaces:

-

LLMs como Intérpretes y Planificadores: Las LLM pueden traducir las instrucciones en lenguaje natural a un formato que los agentes AI puedan entender, permitiendo una interacción humano-computadora más intuitiva. También pueden aprovechar su conocimiento para asistir a los agentes en la planificación de tareas complejas, dividiéndolas en pasos más pequeños y manejables.

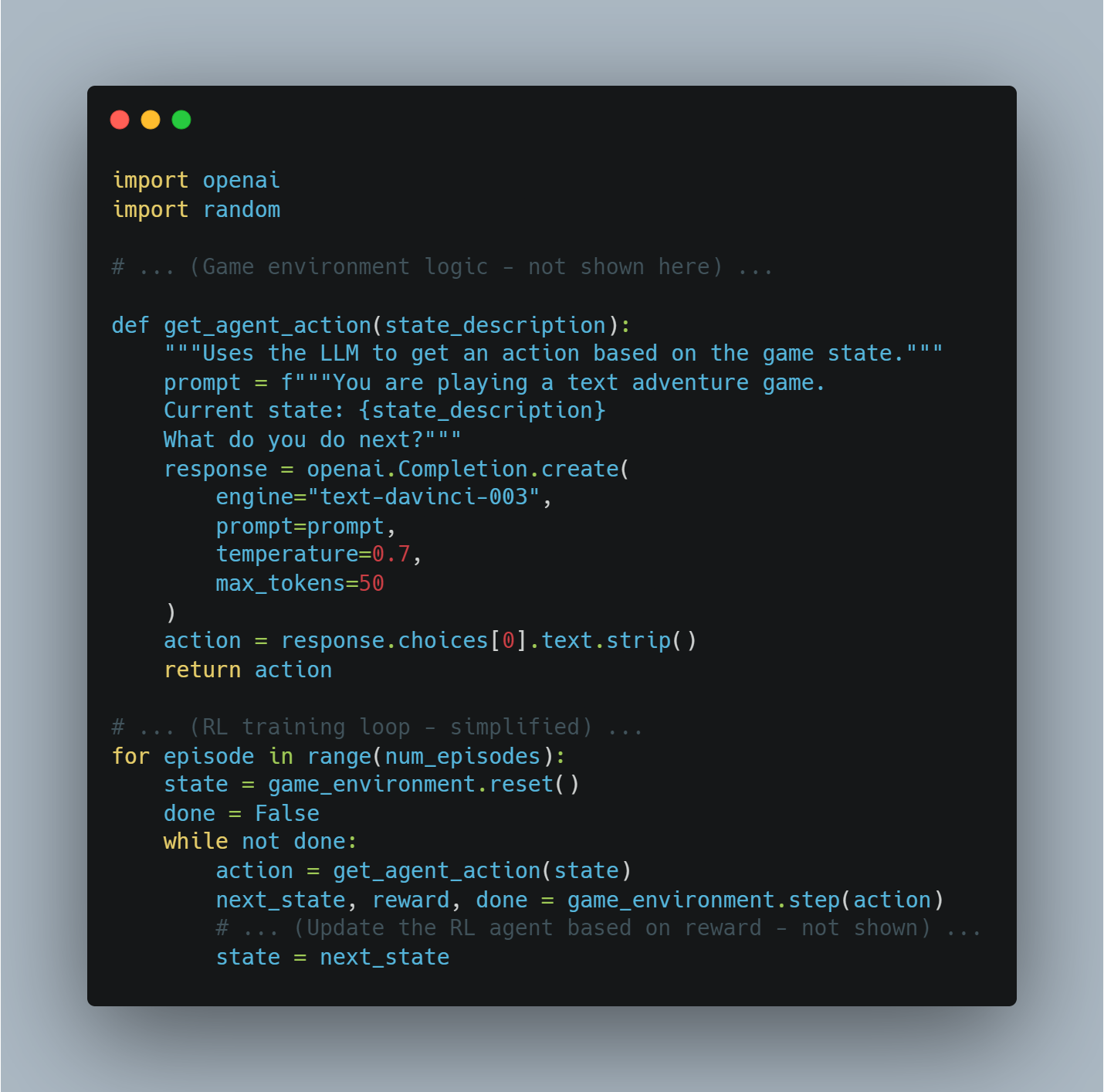

- Agentes de inteligencia artificial como ejecutores y aprendices: Los agentes de inteligencia artificial proporcionan a las LLM la capacidad de interactuar con el mundo, obtener información y recibir retroalimentación sobre sus acciones. Esta base real del mundo puede ayudar a las LLM a aprender de la experiencia y mejorar su rendimiento con el tiempo.

Esta potente sinergia está impulsando el desarrollo de una nueva generación de aplicaciones que son más intuitivas, adaptables y capaces que nunca antes. Con la continua evolución tanto de las tecnologías de los agentes de inteligencia artificial como de las LLM, podemos esperar ver emerger aún más aplicaciones innovadoras e impactantes, que transformen el paisaje de desarrollo de software y la interacción humano-ordenador.

Ejemplos reales: Transformación de industrias

Este poderoso combinación ya está haciendo olas en varios sectores:

-

Servicio al Cliente: Resolución de problemas con conciencia contextual

- Ejemplo: Imagina un cliente que contacta a un minorista en línea sobre un envío retrasado. Un agente de AI alimentado por una MLG puede comprender la frustración del cliente, acceder a su historial de pedidos, rastrear el paquete en tiempo real y ofrecer proactivamente soluciones como envío prioritario o un descuento en su próxima compra.

-

Creación de Contenido: Generación de Contenido de Alta Calidad a Escala

- Ejemplo: Un equipo de marketing puede utilizar un sistema de AI agente + MLG para generar publicaciones de redes sociales dirigidas, escribir descripciones de productos o incluso crear guiones de videos. La MLG garantiza que el contenido es atractivo e informativo, mientras que el agente de AI se encarga del proceso de publicación y distribución.

-

Desarrollo de Software: acelerar el código y la depuración

- Ejemplo: Un desarrollador puede describir una característica de software que desea construir usando el lenguaje natural. La PAA (Agente de Lenguaje Largamente Maduro) puede generar fragmentos de código, identificar errores potenciales y proponer mejoras, acelerando significativamente el proceso de desarrollo.

-

Atención médica: personalizar el tratamiento y mejorar la atención al paciente

- Ejemplo: Un agente de AI con acceso a la historia clínica de un paciente y equipado con una PAA puede responder a sus preguntas de salud, proporcionar recordatorios de medicación personalizados y ofrecer incluso diagnosticos preliminares basados en sus síntomas.

-

Legalidad: Agilizar la Investigación Legal y la Redacción de Documentos

- Ejemplo: Un abogado necesita redactar un contrato con cláusulas específicas y precedentes legales. Un agente de AI alimentado por una MLG puede analizar las instrucciones del abogado, buscar a través de bases de datos legales vastas, identificar cláusulas y precedentes relevantes e incluso redactar partes del contrato, reduciendo significativamente el tiempo y el esfuerzo requeridos.

-

Creación de Vídeos: Generar Vídeos Engañosos con Facilidad

- Ejemplo: Un equipo de marketing quiere crear un vídeo corto explicando las características de su producto. Pueden proporcionar a un agente de AI + sistema de MLG con un esquema de guión y preferencias de estilo visual. La MLG entonces puede generar un guión detallado, sugiriendo música y imágenes apropiadas e incluso editar el vídeo, automatizando gran parte del proceso de creación de vídeos.

-

Arquitectura: Diseño de edificios con inteligencia artificial

- Ejemplo: Un arquitecto está diseñando un nuevo edificio de oficinas. Pueden utilizar un agente de IA + sistema LLM para introducir sus objetivos de diseño, como maximizar la luz natural y optimizar la utilización del espacio. A continuación, el LLM puede analizar estos objetivos, generar diferentes opciones de diseño e incluso simular cómo funcionaría el edificio en diferentes condiciones ambientales.

-

Construcción: Mejorar la Seguridad y la Eficiencia en los Sitios de Construcción

- Ejemplo: Un agente AI equipado con cámaras y sensores puede monitorear un sitio de construcción para detectar peligros de seguridad. Si un trabajador no lleva el equipo de seguridad adecuado o un equipo está dejado en una posición peligrosa, el LLM puede analizar la situación, alertar al supervisor del sitio y incluso detener automáticamente las operaciones si es necesario.

El Futuro ya está aquí: Una Nueva Era de Desarrollo de Software

La convergencia de agentes AI y LLMs marca un importante salto adelante en el desarrollo de software. Mientras estas tecnologías continúan evolucionando, podemos esperar ver incluso más aplicaciones innovadoras emerger, transformando industrias, simplificando flujos de trabajo y creando posibilidades completamente nuevas para la interacción hombre-ordenador.

Los agentes AI destacan especialmente en áreas que requieren el procesamiento de grandes cantidades de datos, automatización de tareas repetitivas, toma de decisiones complejas y proporcionación de experiencias personalizadas. Al cumplir las condiciones necesarias y siguiendo las mejores prácticas, las organizaciones pueden aprovechar el potencial completo de los agentes AI para impulsar la innovación, la eficiencia y el crecimiento.

Capítulo 4: La Base Filosófica de los Sistemas Inteligentes

El desarrollo de los sistemas inteligentes, especialmente en el ámbito de la inteligencia artificial (IA), requiere un entendimiento profundo de los principios filosóficos. Este capítulo se adentra en las ideas filosóficas centrales que modelan el diseño, desarrollo y uso de la IA. Destaca la importancia de alinear el progreso tecnológico con los valores éticos.

La base filosófica de los sistemas inteligentes no es solo un ejercicio teórico, es un marco vital que garantiza que las tecnologías de la IA sean beneficiosas para la humanidad. Promoviendo la equidad, inclusividad y mejorando la calidad de vida, estos principios ayudan a guiar a la IA para servir nuestros mejores intereses.

Consideraciones Éticas en el Desarrollo de la AI

Conforme los sistemas de AI se integran cada vez más en todos los aspectos de la vida humana, desde la atención médica y la educación hasta la finanza y la gobernanza, necesitamos examinar y aplicar rigurosamente los imperativos éticos que guían su diseño y despliegue.

La cuestión éticamente fundamental gira en torno a cómo se puede crear a la AI para que refleje y sostenga los valores humanos y los principios morales. Esta cuestión es central a la manera en que la IA forjará el futuro de las sociedades alrededor del mundo.

El corazón de este discurso éticos está en el principio de la beneficencia, una piedra angular de la filosofía moral que dicta que las acciones deben tener como objetivo hacer el bien y mejorar el bienestar de los individuos y de la sociedad en su conjunto (Floridi & Cowls, 2019).

En el contexto de la IA, la beneficencia se traduce en diseñar sistemas que contribuyen activamente al progreso humano -sistemas que mejoran los resultados de la atención médica, amplían las oportunidades educativas y facilitan el crecimiento económico equitativo.

Pero la aplicación de la beneficencia en IA no es nada simple. Requiere un enfoque matizado que cuide de manera cuidadosa el equilibrio entre los posibles beneficios de la IA y los posibles riesgos y daños.

Uno de los mayores desafíos en la aplicación del principio de la beneficencia al desarrollo de la IA es la necesidad de un balance delicado entre la innovación y la seguridad.

La IA tiene el potencial para revolucionar campos como la medicina, donde los algoritmos predictivos pueden diagnosticar enfermedades más pronto y con mayor precisión que los médicos humanos. Sin embargo, sin un control ético estricto, estas mismas tecnologías podrían agravar las desigualdades existentes.

Esto podría ocurrir, por ejemplo, si se desplegaran principalmente en regiones prósperas mientras que las comunidades subservidas continúan sin acceso básico a la atención médica.

Debido a esto, el desarrollo ético de la IA require no solo una concentración en la maximización de los beneficios sino también una aproximación proactiva para mitigar el riesgo. Esto implica implementar salvaguardas robustas para prevenir el mal uso de la IA y asegurar que estas tecnologías no causen daño accidentalmente.

El marco ético para la IA también debe ser intrínsecamente inclusivo, garantizando que los beneficios de la IA se distribuyan equitativamente entre todos los grupos sociales, incluyendo aquellos que son tradicionalmente marginados. Esto exige un compromiso con la justicia y la equidad, asegurando que la IA no simplemente refuerza el status quo sino que trabaja activamente para desmantelar las desigualdades sistémicas.

Por ejemplo, la automatización de trabajos impulsada por AI tiene el potencial para aumentar la productividad y el crecimiento económico. Sin embargo, también podría llevar a un reemplazo sustancial de empleos, afectando de manera desproporcionada a los trabajadores de bajos ingresos.

Como pueden ver, un marco ético para la AI debe incluir estrategias para el reparto equitativo de beneficios y la provisión de sistemas de apoyo para aquellos afectados adversamente por los avances de la IA.

El desarrollo ético de la AI requiere una participación continua con stakeholders diversos, incluyendo a eticistas, tecnólogos, responsables políticos y las comunidades que serán más afectadas por estas tecnologías. Esta colaboración interdisciplinaria garantiza que los sistemas de AI no se desarrollan en un vacío sino que se modelan a partir de una amplia gama de perspectivas y experiencias.

A través de este esfuerzo colectivo podemos crear sistemas de AI que no solo reflejan sino que también respaldan los valores que definen nuestra humanidad: compasión, equidad, respeto por la autonomía y una commitments to the common good.

Los considerandos éticos en el desarrollo de la AI no son sólo guías, sino elementos esenciales que determinarán si la AI sirve como una fuerza buena en el mundo. Al basar la AI en los principios de la bondad, la justicia y la inclusividad, y manteniendo un enfoque vigilante en el equilibrio entre la innovación y el riesgo, podemos asegurar que el desarrollo de la AI no avanza sólo la tecnología sino que también mejora la calidad de vida para todos los miembros de la sociedad.

Mientras exploramos las capacidades de la AI, es imprescindible que estos considerandos éticos permanezcan en el centro de nuestros esfuerzos, guiándonos hacia un futuro en el que la AI realmente beneficie a la humanidad.

La Imperativa de un Diseño de AI Centrado en el Ser Humano

El diseño de AI centrado en el ser humano supera las consideraciones técnicas puras. Tiene sus raíces en los profundos principios filosóficos que priorizan la dignidad humana, la autonomía y la agencia.

Este enfoque en el desarrollo de AI se basa fundamentalmente en el marco ético kantiano, que sostiene que las personas deben ser consideradas como fines en sí mismas, no solo como instrumentos para lograr otros fines (Kant, 1785).

Las implicaciones de este principio para el diseño de AI son profundas, requiriendo que los sistemas de AI se desarrollen con un enfoque inflexible en servir los intereses humanos, preservar la agencia humana y respetar la autonomía individual.

Implementación Técnica de Principios Centrados en el Ser Humano

Mejorar la Autonomía Humana a través de la AI: El concepto de autonomía en los sistemas de AI es fundamental, particularmente en asegurar que estas tecnologías empodernen a los usuarios en lugar de controlar o influir de manera indebida sobre ellos.

En términos técnicos, esto implica diseñar sistemas de AI que priorizan la autonomía de los usuarios proporcionándoles las herramientas e información necesarias para tomar decisiones informadas. Esto requiere que los modelos de AI sean contextualmente conscientes, lo que significa que deben comprender el contexto específico en el que se toma una decisión y ajustar sus recomendaciones en consecuencia.

Desde el punto de vista del diseño de sistemas, esto implica la integración de inteligencia contextual en los modelos de AI, lo que permite que estos sistemas se adapten dinámicamente al entorno, preferencias y necesidades del usuario.

Por ejemplo, en la atención médica, un sistema AI que ayuda a los médicos en la diagnose de condiciones debe considerar el historial médico único del paciente, los síntomas actuales, e incluso el estado psicológico para ofrecer recomendaciones que sostengan la experiencia del médico, en lugar de sustituirla.

Esta adaptación contextual garantiza que el AI permanezca como una herramienta de apoyo que refuerce, en lugar de disminuir, la autonomía humana.

Asegurar procesos de toma de decisiones transparentes: La transparencia en los sistemas AI es un requisito fundamental para garantizar que los usuarios puedan confiar y entender las decisiones tomadas por estas tecnologías. Técnicamente, esto se traduce en la necesidad de AI explicable (XAI), que implica desarrollar algoritmos que puedan expresar claramente la lógica detrás de sus decisiones.

Esto es especialmente crucial en dominios como la finanza, la atención médica y la justicia penal, donde la toma de decisiones opacas puede llevar a la desconfianza y a preocupaciones éticas.

La explicabilidad se puede lograr a través de varias aproximaciones técnicas. Un método común es la interpretabilidad post-hoc, donde el modelo AI genera una explicación después de tomar la decisión. Esto podría implicar desglosar la decisión en sus factores constitutivos y mostrar cómo cada uno contribuyó al resultado final.

Otro enfoque son modelos inherentemente interpretables, donde la arquitectura del modelo está diseñada de manera que sus decisiones son transparentes por defecto. Por ejemplo, modelos como árboles de decisión y modelos lineales son naturalmente interpretables porque su proceso de toma de decisiones es fácil de seguir y entender.

El reto en la implementación de la inteligencia artificial explicable radica en equilibrar la transparencia con el rendimiento. A menudo, modelos más complejos, como las redes neuronales profundas, son menos interpretables pero más precisos. Así, el diseño de la IA centrada en humanos debe considerar el compromiso entre la interpretabilidad del modelo y su poder predictivo, garantizando que los usuarios puedan confiar y comprender decisiones de IA sin sacrificar precisión.

Permitir un Control Humano Significativo: Un control humano significativo es crucial para asegurar que los sistemas de IA operan dentro de los límites éticos y operacionales. Este control implica diseñar sistemas de IA con salvaguardas y mecanismos de override que permitan a los operadores humanos intervenir cuando sea necesario.

La implementación técnica del control humano puede abordarse de varias maneras.

Una aproximación es la de incorporar sistemas con humano en el ciclo, donde los procesos de toma de decisiones de la IA son monitoreados y evaluados continuamente por operadores humanos. Estos sistemas están diseñados para permitir la intervención humana en puntos críticos, garantizando que la IA no actúe de manera autónoma en situaciones donde se requieren juicios éticos.

Por ejemplo, en el caso de los sistemas de armas autónomos, la supervisión humana es fundamental para evitar que la IA tome decisiones de vida o muerte sin input humano. Esto podría implicar fijar límites operacionales estrictos que la IA no puede superar sin autorización humana, incorporando así salvaguardas éticas en el sistema.

Otra consideración técnica es el desarrollo de rastreos de auditoría, que son registros de todas las decisiones y acciones tomadas por el sistema IA. Estas trazas proporcionan una historia transparente que puede ser revisada por operadores humanos para asegurar el cumplimiento de los estándares éticos.

Los rastreos de auditoría son particularmente importantes en sectores como la finanza y el derecho, donde las decisiones deben ser documentadas y justificables para mantener la confianza pública y cumplir con los requisitos regulatorios.

Balance entre Autonomía y Control: Uno de los mayores desafíos técnicos en la IA centrada en el ser humano es encontrar el equilibrio correcto entre autonomía y control. Aunque los sistemas AI están diseñados para operar de manera autónoma en muchos escenarios, es crucial que esta autonomía no socava el control o supervisión humana.

Este equilibrio se puede lograr a través de la implementación de niveles de autonomía, que determinan la grado de independencia que tiene la IA en la toma de decisiones.

Por ejemplo, en sistemas semi-autónomos como los coches autónomos, los niveles de autonomía van desde asistencia básica al conductor (donde el conductor humano permanece en control total) hasta la automatización completa (donde la IA es responsable de todas las tareas de conducción).

El diseño de estos sistemas debe garantizar que, independientemente del nivel de autonomía, el operador humano conserva la capacidad para intervenir y anular la IA si es necesario. Esto requiere interfaces de control sofisticadas y sistemas de apoyo a decisiones que permitan a los humanos tomar el control rápidamente y efectivamente cuando sea necesario.

Además, el desarrollo de marcos éticos para la IA es fundamental para guiar las acciones autónomas de los sistemas de IA. Estos marcos son conjuntos de reglas y directrices integradas en la IA que dictan cómo debe comportarse en situaciones éticamente complejas.

Por ejemplo, en la atención médica, un marco ético para la IA podría incluir reglas sobre el consentimiento del paciente, la privacidad y la priorización de tratamientos en función de las necesidades médicas en lugar de consideraciones financieras.

Al integrar directamente estos principios éticos en los procesos de toma de decisiones de la IA, los desarrolladores pueden asegurar que la autonomía del sistema se ejerce de una manera que se ajusta a los valores humanos.

La integración de principios humano-centrados en el diseño de la IA no es sólo un ideal filosófico sino una necesidad técnica. Al potenciar la autonomía humana, garantizar la transparencia, permitir la supervisión significativa y equilibrar la autonomía con el control, los sistemas de IA se pueden desarrollar de manera que realmente sirvan a la humanidad.

Estas consideraciones técnicas son esenciales para crear IA que no solo amplíe las capacidades humanas sino que respete y defienda los valores que son fundamentales para nuestra sociedad.

Con la evolución continua de la IA, el compromiso con el diseño humano-centrado será crucial para asegurar que estas poderosas tecnologías se utilicen ética y responsablemente.

Cómo asegurar que los beneficios de la IA sean para la humanidad: Mejorar la calidad de vida

Al participar en el desarrollo de sistemas de IA, es fundamental basar sus esfuerzos en el marco ético del utilitarismo —un filosofía que enfatiza la mejora de la felicidad y el bienestar general.

En este contexto, la IA posee el potencial para abordar desafíos críticos de la sociedad, particularmente en áreas como la atención médica, la educación y la sostenibilidad ambiental.

El objetivo es crear tecnologías que mejoren significativamente la calidad de vida de todos. Sin embargo, esta búsqueda trae complejidades. El utilitarismo ofrece una razón convincente para desplegar ampliamente la IA, pero también pone en primer plano importantes cuestiones éticas sobre quién se beneficia y quién podría quedar rezagado, especialmente entre las poblaciones vulnerables.

Para navegar estos desafíos, necesitamos un enfoque sofisticado y técnicamente informado —uno que equilibre la búsqueda amplia del bien de la sociedad con la necesidad de justicia y equidad.

Cuando se aplican los principios utilitaristas a la IA, su enfoque debería ser en optimizar los resultados en determinados dominios. En el área de la atención médica, por ejemplo, las herramientas de diagnóstico impulsadas por la IA tienen el potencial para mejorar drásticamente los resultados de los pacientes mediante la posibilidad de realizar diagnósticos más tempranos y precisos. Estos sistemas pueden analizar grandes conjuntos de datos para detectar patrones que podrían pasar desapercibidos para los profesionales humanos, ampliando así el acceso a atención médica de calidad, particularmente en entornos con recursos insuficientes.

Sin embargo, el despliegue de estas tecnologías requiere una cuidadosa consideración para evitar reforzar las desigualdades existentes. Los datos utilizados para entrenar los modelos de IA pueden variar significativamente de una región a otra, lo que afecta a la precisión y fiabilidad de estos sistemas.

Esta disparidad pone de relieve la importancia de establecer marcos sólidos de gobernanza de datos que garanticen que sus soluciones sanitarias basadas en IA sean representativas y justas.

En el ámbito educativo, la capacidad de la IA para personalizar el aprendizaje es prometedora. Los sistemas de IA pueden adaptar el contenido educativo para satisfacer las necesidades específicas de cada estudiante, mejorando así los resultados del aprendizaje. Mediante el análisis de los datos sobre el rendimiento y el comportamiento de los alumnos, la IA puede identificar los puntos en los que un alumno puede tener dificultades y proporcionarle apoyo específico.

Pero mientras se trabaja para obtener estos beneficios, es crucial ser consciente de los riesgos, como el potencial de reforzar los prejuicios o marginar a los alumnos que no se ajustan a los patrones típicos de aprendizaje.

Mitigar estos riesgos requiere la integración de mecanismos de equidad en los modelos de IA, asegurando que no favorezcan inadvertidamente a ciertos grupos. Y mantener el papel de los educadores es fundamental. Su juicio y experiencia son indispensables para que las herramientas de IA sean realmente eficaces y solidarias.

En términos de sostenibilidad medioambiental, el potencial de la IA es considerable. Los sistemas de IA pueden optimizar el uso de los recursos, vigilar los cambios medioambientales y predecir las repercusiones del cambio climático con una precisión sin precedentes.

Por ejemplo, la IA puede analizar vastas cantidades de datos ambientales para predecir patrones climáticos, optimizar el consumo de energía y minimizar el desperdicio, acciones que contribuyen al bienestar de las generaciones actuales y futuras.

Pero este avance tecnológico trae consigo su propio conjunto de desafíos, particularmente respecto al impacto ambiental de los propios sistemas de IA.

El consumo de energía necesario para operar sistemas IA a gran escala puede anular los beneficios ambientales que buscan alcanzar. Así que desarrollar sistemas IA eficientes en términos de energía es crucial para asegurar que su impacto positivo en la sostenibilidad no sea minado.

Al desarrollar sistemas IA con objetivos utilitaristas, es importante considerar también las implicaciones para la justicia social. El utilitarismo se enfoca en maximizar la felicidad general pero no aborda necesariamente la distribución de los beneficios y daños entre diferentes grupos sociales.

Esto plantea el potencial de que los sistemas IA puedan beneficiar desproporcionadamente a aquellos que ya están privilegiados, mientras que los grupos marginados pueden ver poco o ningún mejoramiento en sus circunstancias.

Para contrarrestar esto, su proceso de desarrollo de IA debe Incorporar principios enfocados en la equidad, asegurando que los beneficios se distribuyen equitativamente y que cualquier daño potencial se aborda. Esto puede implicar diseñar algoritmos que específicamente busquen reducir las biases y involucrar una amplia gama de perspectivas en el proceso de desarrollo.

Al trabajar en el desarrollo de sistemas de inteligencia artificial dirigidos a mejorar la calidad de vida, es fundamental equilibrar el objetivo utilitario de maximizar el bienestar con la necesidad de justicia y equidad. Esto requiere un enfoque sofisticado, técnicamente fundado, que considere las implicaciones más amplias del despliegue de AI.

Mediante la diseño cuidadoso de sistemas de AI que sean tanto efectivos como equitativos, puedes contribuir a un futuro en el que los avances tecnológicos realmente sirvan a las diversas necesidades de la sociedad.

Implementar salvaguardas contra el potencial de daño

Cuando se desarrollan tecnologías de AI, debes reconocer el potencial innato para el daño y establecer proactivamente salvaguardas robustas para mitigar estos riesgos. Esta responsabilidad está profundamente arraigada en la ética deontológica . Este subcampo de la ética subraya la obligación moral de adherir a las reglas establecidas y a los estándares éticos, garantizando que la tecnología que creas se alinea con los principios morales fundamentales.

La implementación de protocolos de seguridad estrictos no es solo una precaución sino una obligación ética. Estos protocolos deberían abarcar pruebas de sesgo comprensivas, transparencia en los procesos algorítmicos y mecanismos claros para la responsabilidad.

tales salvaguardas son esenciales para prevenir que los sistemas de AI cause daño no intencional, ya sea a través de decisiones sesgadas, procesos opacos o falta de supervisión.

En la práctica, la implementación de estas salvaguardas requiere un profundo entendimiento de ambas dimensiones técnica y ética de la IA.

La prueba de sesgos, por ejemplo, implica no sólo la identificación y corrección de sesgos en datos y algoritmos sino también la comprensión de las implicaciones sociales más amplias de esos sesgos. Debes asegurarte de que tus modelos de AI se entrenen en conjuntos de datos diversos y representativos y se evalúan regularmente para detectar y corregir cualquier sesgo que pueda emerger con el tiempo.

Por otra parte, la transparencia exige que los sistemas de AI se desarrollen de manera que sus procesos de toma de decisiones sean fácilmente comprensibles y revisables por los usuarios y los interesados. Esto implica desarrollar modelos de AI explicables que proporcionen salidas claras e interpretables, permitiendo a los usuarios ver cómo se toman las decisiones y asegurando que dichas decisiones sean justificables y equitativas.

También, los mecanismos de responsabilidad son cruciales para mantener la confianza y asegurar que los sistemas de AI se utilizan de manera responsable. Estos mecanismos deben incluir directrices claras sobre quién es responsable de los resultados de las decisiones de AI, así como procesos para abordar y corregir cualquier daño que pueda ocurrir.

Debes establecer un marco donde las consideraciones éticas se integran en cada etapa del desarrollo de AI, desde el diseño inicial hasta la implementación y más allá. Esto incluye no sólo la adherencia a directrices éticas sino también el monitoreo continuo y ajuste de los sistemas de AI a medida que interactúan con el mundo real.

Al integrar estas salvaguardas en la propia estructura del desarrollo de AI, puedes ayudar a asegurar que el progreso tecnológico sirva el bien común sin llevar a consecuencias negativas no intencionadas.

El papel del control humano y los ciclos de retroalimentación

La supervisión humana en los sistemas AI es un componente crítico para asegurar la implementación ética de AI. El principio de responsabilidad subyace a la necesidad de la participación humana continua en la operación de AI, particularmente en entornos de alto riesgo como la atención médica y la justicia penal.

Los ciclos de retroalimentación, donde la entrada humana se utiliza para refinar y mejorar los sistemas AI, son esenciales para mantener la responsabilidad y la adaptabilidad (Raji et al., 2020). Estos ciclos permiten la corrección de errores y la integración de nuevas consideraciones éticas a medida que los valores sociales evolucionan.

Al integrar la supervisión humana en los sistemas AI, los desarrolladores pueden crear tecnologías que no solo son efectivas sino que también están alineadas con normas éticas y expectativas humanas.

Código Ético: Traducir Principios Filosóficos en Sistemas AI

La traducción de los principios filosóficos en los sistemas AI es una tarea compleja pero necesaria. Este proceso implica integrar consideraciones éticas en el código que impulsa los algoritmos de AI.

Conceptos como la equidad, la justicia y la autonomía deben ser codificados dentro de los sistemas AI para asegurar que operan de maneras que reflejen los valores sociales. Esto requiere un enfoque interdisciplinario, donde los éticos, ingenieros y científicos sociales colaboran para definir e implementar directrices éticas en el proceso de codificación.

El objetivo es crear sistemas AI que no solo sean técnicamente competentes sino también morales, capaces de tomar decisiones que respeten la dignidad humana y promuevan el bien social (Mittelstadt et al., 2016).

Promover la inclusión y el acceso equitativo en el desarrollo y la implementación de AI.

La inclusividad y el acceso equitativo son fundamentales para el desarrollo ético de la IA. El concepto racionalista de justicia como equidad proporciona una base filosófica para asegurar que los sistemas de IA se diseñen y desplieguen de maneras que benefician a todos los miembros de la sociedad, especialmente a aquellos que son más vulnerables (Rawls, 1971).

Esto implica esfuerzos proactivos para incluir perspectivas diversas en el proceso de desarrollo, especialmente de grupos subrepresentados y del Sur Global.

Al integrar estas diversas opiniones, los desarrolladores de IA pueden crear sistemas que sean más equitativos y respondan mejor a las necesidades de un espectro más amplio de usuarios. Además, garantizar un acceso equitativo a las tecnologías de IA es crucial para prevenir la exacerbación de las desigualdades sociales existentes.

Abordar la Bias Algorítmico y la Justicia

El bias algorítmico representa una preocupación ética significativa en el desarrollo de la IA, ya que los algoritmos sesgados pueden perpetuar e incluso agravar las desigualdades sociales. Enfrentar este problema requiere un compromiso con la justicia procesal, asegurando que los sistemas de IA se desarrollan a través de procesos justos que consideren el impacto en todos los interesados (Nissenbaum, 2001).

Esto implica identificar y mitigar los sesgos en los datos de entrenamiento, desarrollar algoritmos transparentes y explicables, y implementar comprobaciones de equidad a lo largo de toda la vida del AI.

Al abordar el bias algorítmico, los desarrolladores pueden crear sistemas de IA que contribuyen a una sociedad más justa y equitativa, en lugar de reforzar las desigualdades existentes.

Incorporar Perspectivas Diversas en el Desarrollo de la IA

Incorporar perspectivas diversas al desarrollo de la IA es esencial para crear sistemas inclusivos y equitativos. La inclusión de voces de grupos infrarrepresentados garantiza que las tecnologías de IA no reflejen simplemente los valores y prioridades de un estrecho segmento de la sociedad.

Este enfoque se alinea con el principio filosófico de la democracia deliberativa, que subraya la importancia de los procesos de toma de decisiones inclusivos y participativos (Habermas, 1996).

Al fomentar una participación diversa en el desarrollo de la IA, podemos garantizar que estas tecnologías se diseñen para servir a los intereses de toda la humanidad, en lugar de a los de unos pocos privilegiados.

Estrategias para superar la brecha de la IA

La brecha de la IA, caracterizada por un acceso desigual a las tecnologías de la IA y a sus beneficios, supone un reto importante para la equidad global. Para superar esta brecha es necesario un compromiso con la justicia distributiva, que garantice que los beneficios de la IA se compartan ampliamente entre los diferentes grupos socioeconómicos y regiones (Sen, 2009).

Podemos hacerlo a través de iniciativas que promuevan el acceso a la educación y los recursos de la IA en las comunidades desatendidas, así como mediante políticas que apoyen la distribución equitativa de las ganancias económicas impulsadas por la IA. Al abordar la brecha de la IA, podemos garantizar que la IA contribuya al desarrollo global de forma inclusiva y equitativa.

Equilibrar la innovación con las restricciones éticas

Equilibrar la búsqueda de la innovación con las restricciones éticas es crucial para el avance responsable de la IA. El principio de precaución, que aboga por la cautela ante la incertidumbre, es especialmente pertinente en el contexto del desarrollo de la IA (Sandin, 1999).

Mientras que la innovación impulsa el progreso, debe ser temperada por consideraciones éticas que protegen contra los posibles daños. Esto requiere una evaluación cuidadosa de los riesgos y beneficios de las nuevas tecnologías de AI, así como la implementación de marcos regulatorios que garanticen el mantenimiento de estándares éticos.

Al equilibrar la innovación con las restricciones éticas, podemos fomentar el desarrollo de tecnologías de AI que sean tanto innovadoras como alineadas con los objetivos más amplios del bienestar societal.

Como puede ver, la base filosófica de los sistemas inteligentes proporciona un marco crítico para asegurar que las tecnologías de AI se desarrollen y se desplieguen de maneras éticas, inclusivas y beneficiosas para toda la humanidad.

Al basar el desarrollo de AI en estos principios filosóficos, podemos crear sistemas inteligentes que no solo avancen en las capacidades tecnológicas sino que también mejoren la calidad de vida, promuevan la justicia y aseguran que los beneficios de AI se compartan equitativamente entre la sociedad.

Capítulo 5: Agentes de AI como Enhancers de LLM

La fusión de agentes de AI con Modelos de Lenguaje Largos (LLMs) representa un cambio fundamental en la inteligencia artificial, abordando limitaciones críticas en LLMs que han limitado su aplicabilidad general.

Esta integración permite que las máquinas superan sus roles tradicionales, avanzando de generadores de texto pasivos a sistemas autónomos capaces de razonamiento dinámico y toma de decisiones.

Conforme las sistemas de AI cada vez más dirigen procesos críticos en diversos campos, entender cómo los agentes de AI llenan los huecos en las capacidades de LLM es fundamental para realizar su potencial completo.

Pasando los Puentes en las Capacidades de los Lenguajes de Modelado de Máquina (LLM)

Los LLM, aunque potentes, están inherentemente limitados por los datos en los que se entrenaron y por la naturaleza estática de su arquitectura. Estos modelos operan dentro de un conjunto fijo de parámetros, generalmente definidos por el corpus de texto utilizado durante su fase de entrenamiento.

Esta limitación significa que los LLM no pueden buscar autónomamente información nueva o actualizar su base de conocimientos postentrenamiento. En consecuencia, los LLM a menudo están desactualizados y carecen de la capacidad para proporcionar respuestas relevantes en contexto que requieran datos o insumos en tiempo real más allá de sus datos de entrenamiento iniciales.

Los agentes de IA brindan soluciones a estas limitaciones al integrar dinámicamente fuentes de datos externos, lo que puede ampliar el radio de acción funcional de los LLM.

Por ejemplo, un LLM entrenado con datos financieros hasta 2022 podría proporcionar análisis históricos precisos, pero podría luchar para generar previsiónes de mercado actuales. Un agente de IA puede complementar este LLM al extraer datos en tiempo real de los mercados financieros y aplicar estos inputs para generar análisis más relevantes y actualizados.

Esta integración dinámica garantiza que las salidas no solo son precisas históricamente sino también apropiadas contextualmente para las condiciones actuales.

Mejorar la Autonomía en la Toma de Decisiones

Otro límite significativo de los LLM es su falta de capacidades de toma de decisiones autónomas. Los LLM excelen en la generación de salidas basadas en lenguaje pero fallan en tareas que requieren una toma de decisiones complejas, especialmente en entornos caracterizados por incertidumbre y cambio.

Esta deficiencia se debe principalmente al modelo que depende de datos pre-existentes y la falta de mecanismos para el razonamiento adaptativo o aprendizaje de experiencias nuevas post-deploy.

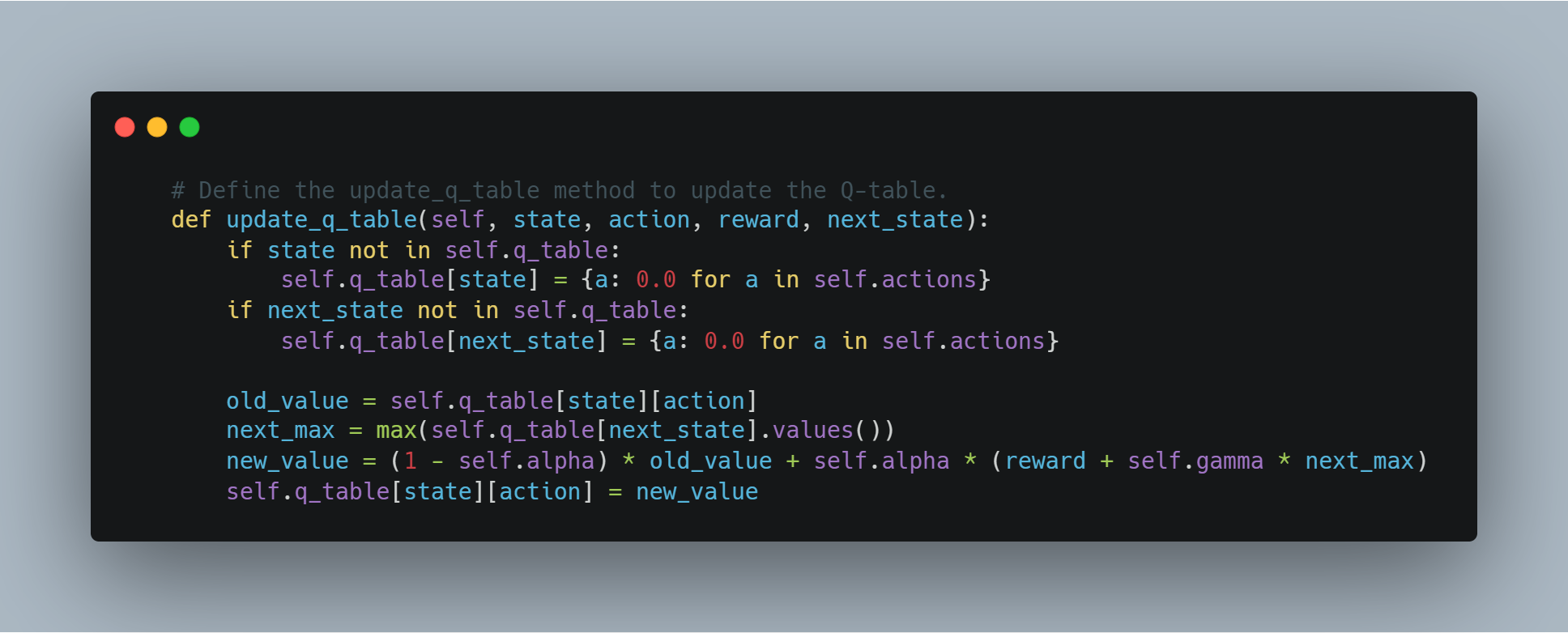

Los agentes de AI abordan esto proporcionando la infraestructura necesaria para la toma de decisiones autónomas. Pueden tomar las salidas estáticas de un LLM y procesarlas a través de marcos de razonamiento avanzado como sistemas basados en reglas, heurísticas o modelos de aprendizaje por reforzamiento.

Por ejemplo, en un entorno de atención médica, un LLM podría generar una lista de diagnosticos potenciales basados en los síntomas y el historial médico del paciente. Sin embargo, sin un agente de AI, el LLM no puede ponderar estas opciones o recomendar una acción.

Un agente de AI puede intervinir para evaluar estos diagnósticos en comparación con la literatura médica actual, los datos del paciente y factores contextuales, al finalizar una decisión más informada y sugiriendo pasos siguientes accionables. Esta sinergia transforma las salidas de LLM de sólo sugerencias en decisiones ejecutables y conscientes del contexto.

Abordando la Completitud y la Coherencia

La completitud y la coherencia son factores críticos para asegurar la confiabilidad de las salidas de LLM, particularmente en tareas de razonamiento complejas. Debido a su naturaleza parametrizada, los LLM a menudo generan respuestas que son incompletas o carecen de coherencia lógica, especialmente cuando se trata de procesos multiestep o se requiere un entendimiento comprensivo en varios dominios.

Estos problemas surgen del entorno aislado en el que opera el LLM, donde no pueden hacer referencias cruzadas o validar sus salidas contra normas externas o información adicional.

Los agentes inteligentes AI tienen un papel crucial en mitigar estos problemas al introducir mecanismos de retroalimentación iterativa y capas de validación.

Por ejemplo, en el ámbito legal, una LLM podría redactar una versión inicial de una memoria legal basada en sus datos de entrenamiento. Sin embargo, este borrador podría pasar por alto ciertos precedentes o no estructurar lógicamente el argumento.

Un agente inteligente AI puede revisar este borrador, garantizando que cumple con los requeridos estándares de completitud al hacer referencias cruzadas con bases de datos legales externas, comprobando la coherencia lógica y solicitando información adicional o aclaración donde sea necesario.

Este proceso iterativo permite la producción de un documento más robusto y fiable que cumple con los estrictos requerimientos de la práctica legal.

Superar la Isolación a través de la Integración

Uno de los límites más profundos de las LLM es su aislamiento inherente de otros sistemas y fuentes de conocimiento.

Las LLM, tal como están diseñadas, son sistemas cerrados que no interactúan de forma nativa con entornos externos o bases de datos. Esta isolación limita significativamente su capacidad para adaptarse a nueva información o operar en tiempo real, lo que les hace menos efectivas en aplicaciones que requieren interacción dinámica o toma de decisiones en tiempo real.

Los agentes inteligentes AI superan este aislamiento actuando como plataformas integrativas que conectan LLMs con un ecosistema más amplio de fuentes de datos y herramientas computacionales. A través de API y otras estructuras de integración, los agentes inteligentes AI pueden acceder a datos en tiempo real, colaborar con otros sistemas inteligentes y incluso interfaces con dispositivos físicos.

Por ejemplo, en aplicaciones de servicio al cliente, una MLG podría generar respuestas estándar basadas en guiones preentrenados. Sin embargo, estas respuestas pueden ser estáticas y carecer de la personalización necesaria para un engagement efectivo con el cliente.

Un agente IA puede enriquecer estas interacciones integrando datos en tiempo real de perfiles de clientes, interacciones previas y herramientas de análisis de sentimento, lo que ayuda a generar respuestas no solo contextualmente relevantes sino también adaptadas a las necesidades específicas del cliente.

Esta integración transforma la experiencia del cliente de una serie de interacciones guionadas en una conversación dinámica y personalizada.

Ampliar Creatividad y Solución de Problemas

Mientras que las MLG son herramientas poderosas para la generación de contenido, su creatividad y habilidades para resolver problemas son inherentemente limitadas por los datos en los que se entrenaron. Estos modelos a menudo no pueden aplicar conceptos teóricos a nuevos o imprevistos retos, ya que sus capacidades para resolver problemas están limitadas por su conocimiento preexistente y los parámetros de entrenamiento.

Los agentes IA potencian el potencial creativo y para resolver problemas de las MLG utilizando técnicas de razonamiento avanzadas y una gama más amplia de herramientas analíticas. Esta capacidad permite a los agentes IA superar las limitaciones de las MLG, aplicando frameworks teóricos a problemas prácticos de manera innovadora.

Por ejemplo, considere el problema de luchar contra la desinformación en plataformas de medios sociales. Una MLG podría identificar patrones de desinformación basándose en análisis textual, pero podría luchar para desarrollar una estrategia completa para mitigar la propagación de información falsa.

Un agente de IA puede tomar estas ideas, aplicar teorías interdisciplinares de campos como la sociología, la psicología y la teoría de redes, y desarrollar un enfoque sólido y polifacético que incluya la supervisión en tiempo real, la educación de los usuarios y técnicas de moderación automatizadas.

Esta capacidad para sintetizar diversos marcos teóricos y aplicarlos a retos del mundo real ejemplifica las capacidades mejoradas de resolución de problemas que aportan los agentes de IA.

Ejemplos más concretos

Los agentes de IA, con su capacidad para interactuar con diversos sistemas, acceder a datos en tiempo real y ejecutar acciones, abordan estas limitaciones de frente, transformando los LLM de modelos lingüísticos potentes pero pasivos en solucionadores de problemas dinámicos del mundo real. Veamos algunos ejemplos:

1. De datos estáticos a conocimientos dinámicos. De datos estáticos a conocimientos dinámicos: Keeping LLMs in the Loop

-

The Problem: Imagine que le pregunta a un LLM formado en investigación médica anterior a 2023: “¿Cuáles son los últimos avances en el tratamiento del cáncer?”. Sus conocimientos estarían desfasados.

-

La solución del agente de IA: Un agente de IA puede conectar el LLM a revistas médicas, bases de datos de investigación y fuentes de noticias. Ahora, el LLM puede proporcionar información actualizada sobre los últimos ensayos clínicos, opciones de tratamiento y hallazgos de la investigación.

2. Del análisis a la acción: Automatización de tareas basadas en las percepciones del LLM

-

El problema: Un LLM que supervisa las redes sociales de una marca puede identificar un aumento del sentimiento negativo, pero no puede hacer nada para solucionarlo.

-