Die schnelle Entwicklung der künstlichen Intelligenz (KI) hat zu einer kraftvollen Synergie zwischen großen Sprachmodelle (LM) und KI-Agenten geführt. Diese dynamische Interaktion ist wie die Geschichte von David und Goliath (ohne die Kämpfe), wo agile KI-Agenten die Fähigkeiten der riesigen LM verstärken und vergrößern.

Dieses Handbuch wird untersuchen, wie KI-Agenten – ähnlich wie David – die LM – unsere moderne Goliaths – superaufladen, um verschiedene Branchen und wissenschaftliche Bereiche zu revolutionieren.

Inhaltsverzeichnis

-

Kapitel 2: Geschichte der künstlichen Intelligenz und KI-Agenten

-

Kapitel 4: Die philosophische Grundlage intelligenter Systeme

-

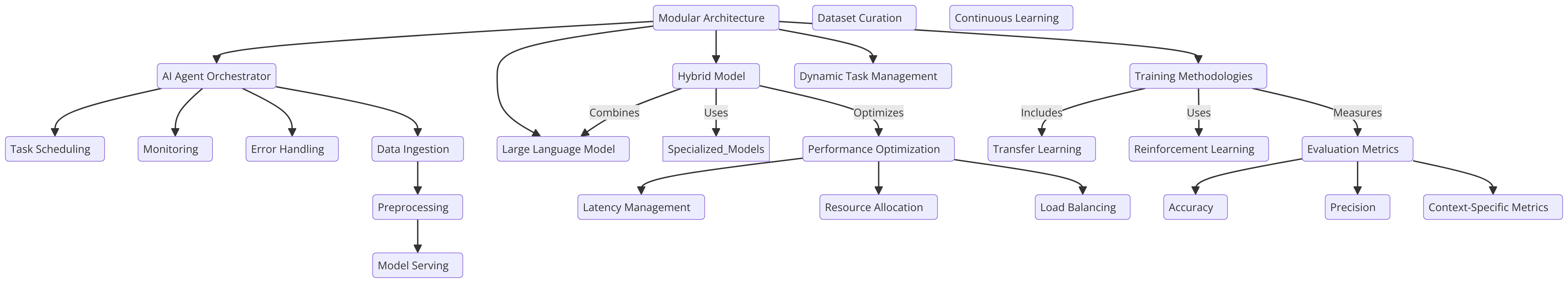

Kapitel 6: Architektur-Design zur Integration von AI-Agenten mit LLM

Die Entstehung von AI-Agenten in Sprachmodellen

AI-Agenten sind selbständige Systeme, die für die Wahrnehmung ihrer Umgebung, die Entscheidungsfindung und die Ausführung von Aktionen zu bestimmten Zielen konzipiert sind. Durch die Integration mit LLM können diese Agenten komplexe Aufgaben erledigen, Informationen überdenken und innovative Lösungen generieren.

Diese Kombination hat zu bedeutenden Fortschritten in verschiedenen Sektoren geführt, von Softwareentwicklung bis zur wissenschaftlichen Forschung.

Umwälzende Auswirkungen in verschiedenen Branchen

Die Integration von AI-Agenten mit LLM hat eine tiefgreifende Wirkung auf verschiedene Branchen gehabt:

-

Softwareentwicklung: AI-gesteuerte Programmierassistenten, wie z.B. GitHub Copilot, haben gezeigt, dass sie bis zu 40% des Codes generieren können, was zu einer bemerkenswerten Verdoppelung der Entwicklungsgeschwindigkeit führt.

-

Bildung: AI-gesteuerte Lernassistenten haben Potenzial gezeigt, die durchschnittliche Kursdauer um 27% zu verkürzen, was die Bildungslandschaft möglicherweise revolutionieren kann.

-

Verkehr

: Mit Projektionen, die suggestieren, dass 10% der Fahrzeuge bis 2030 fahrerlos sein werden, sind selbstfahrende Autos mit autonomen AI-Agenten dazu prädestiniert, die Verkehrsbranche zu revolutionieren.

Wissenschaftliche Entdeckungen vorantreiben

Eine der spannendsten Anwendungen von AI-Agenten und LLM ist in der wissenschaftlichen Forschung zu finden:

-

Arzneimittelentwicklung: AI-Agenten beschleunigen den Arzneimittelentwicklungsprozess durch Analyse von umfangreichen Datenmengen und Prognose potenzieller Arzneimittelkandidaten, was die Zeit und Kosten, die mit traditionellen Methoden verbunden sind, erheblich reduziert.

-

Teilchenphysik: Am Large Hadron Collider des CERN werden KI-Agenten eingesetzt, um Kollisionsdaten von Teilchen zu analysieren. Mit Hilfe der Anomalieerkennung können vielversprechende Hinweise identifiziert werden, die auf das Vorhandensein von noch unentdeckten Teilchen hinweisen könnten.

-

Allgemeine wissenschaftliche Forschung: KI-Agenten verbessern das Tempo und den Umfang wissenschaftlicher Entdeckungen, indem sie vergangene Studien analysieren, unerwartete Verbindungen identifizieren und neue Experimente vorschlagen.

Die Konvergenz von AI-Agenten und großen Sprachmodellen (LLM) befördert die Kunstliche Intelligenz in eine neue Ära von beispielloser Kraft. Dieses umfassende Handbuch untersucht die dynamische Wechselwirkung zwischen diesen beiden Technologien und offenbart ihre kombinierte Potenzialität, um Branchen zu revolutionieren und komplexe Probleme zu lösen.

Wir werden die Entwicklung von AI von ihren Ursprüngen bis zum Aufkommen autonomer Agenten und dem Aufstieg von komplexen LLM verfolgen. Wir werden auch ethische Überlegungen untersuchen, die grundlegend für die verantwortungsvolle AI-Entwicklung sind. Dies hilft uns, sicherzustellen, dass diese Technologien mit unseren menschlichen Werten und der sozialen Wohlfahrt in Einklang stehen.

Bei dem Abschluss dieses Handbuchs werden Sie eine tiefgreifende Verständnis der synergistischen Kraft von AI-Agenten und LLM haben, zusammen mit dem Wissen und den Werkzeugen, um diese fortschrittliche Technologie auszuschöpfen.

Kapitel 1: Einführung in AI-Agenten und Sprachmodelle

Was sind AI-Agenten und große Sprachmodelle?

Die schnelle Entwicklung der künstlichen Intelligenz (AI) hat eine transformative Synergie zwischen großen Sprachmodellen (LLM) und AI-Agenten hervorgerufen.

KI-Agenten sind selbstständige Systeme, die dazu konzipiert sind, ihr Umfeld wahrzunehmen, Entscheidungen zu fassen und Aktionen auszuführen, um bestimmte Ziele zu erreichen. Sie zeigen Merkmale wie Autonomie, Wahrnehmung, Reaktivität, Schlussfolgerung, Entscheidungsfindung, Lernen, Kommunikation und Zielorientierung auf.

Andererseits sind LLM (Langzeitspeicherungs-Maschinen) komplexe AI-Systeme, die auf Deep Learning-Techniken und umfangreiche Datensets zur Verständigung, Generierung und Vorhersage menschlicher Textart zurückgreifen.

Diese Modelle, wie z.B. GPT-4, Mistral, LLama, haben beachtliche Fähigkeiten in NLP-Aufgaben gezeigt, einschließlich Textgenerierung, Sprachübersetzung und Konversationsagenten.

Wesentliche Merkmale von KI-Agenten

KI-Agenten haben mehrere definierende Eigenschaften, die sie von traditioneller Software unterscheiden:

-

Autonomie: Sie können unabhängig von menschlicher Intervention agieren.

-

Wahrnehmung: Agenten können ihr Umfeld durch verschiedene Eingaben wahrnehmen und interpretieren.

-

Reaktivität: Sie reagieren dynamisch auf Änderungen in ihrem Umfeld.

-

Reasoning und Entscheidungsfindung: Agenten können Daten analysieren und fundierte Entscheidungen treffen.

-

Lernen: Sie verbessern ihre Leistung mit der Zeit durch Erfahrung.

-

Kommunikation: Agenten können mit Hilfe verschiedener Methoden mit anderen Agenten oder Menschen interagieren.

-

Zielorientierung: Sie sind darauf ausgelegt, bestimmte Ziele zu erreichen.

Fähigkeiten großer Sprachmodelle

LLMs haben ein breites Spektrum an Fähigkeiten gezeigt, darunter:

-

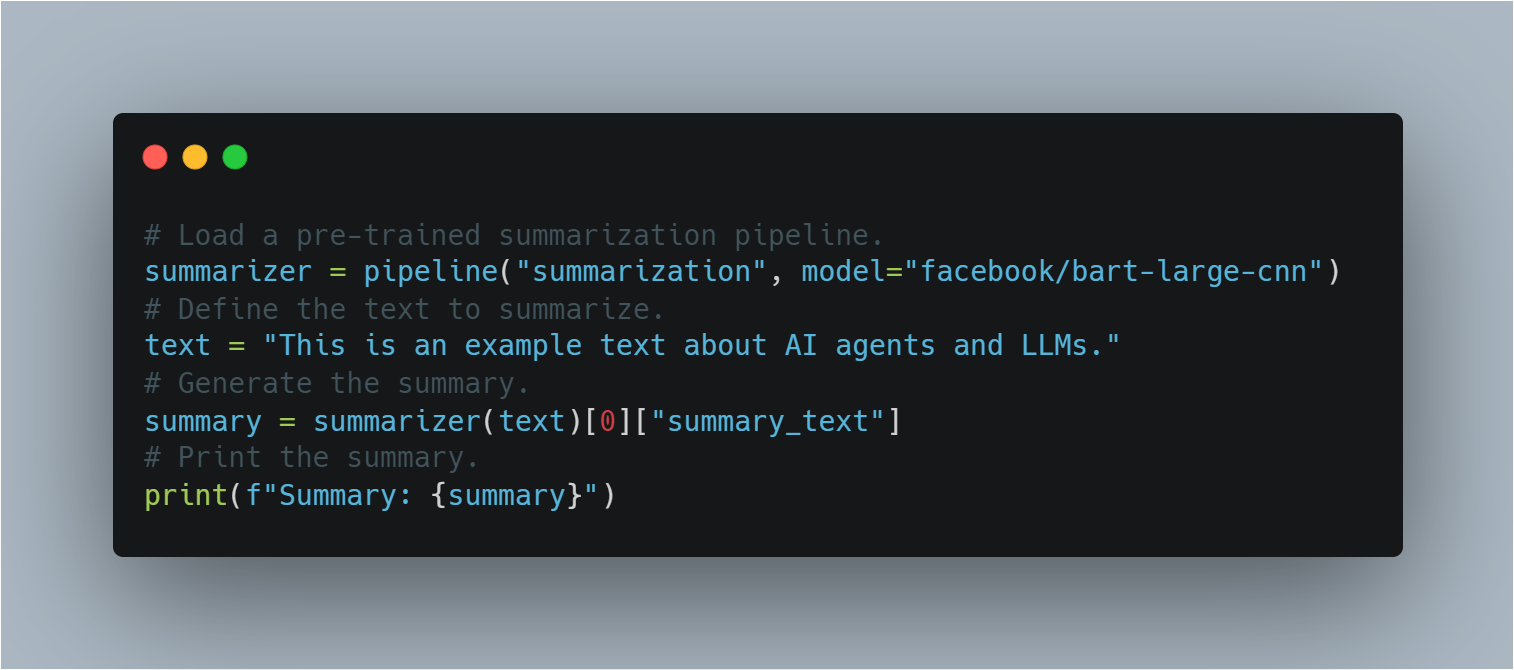

Texterzeugung: LLMs können kohärente und kontextuell relevante Texte auf der Grundlage von Aufforderungen produzieren.

-

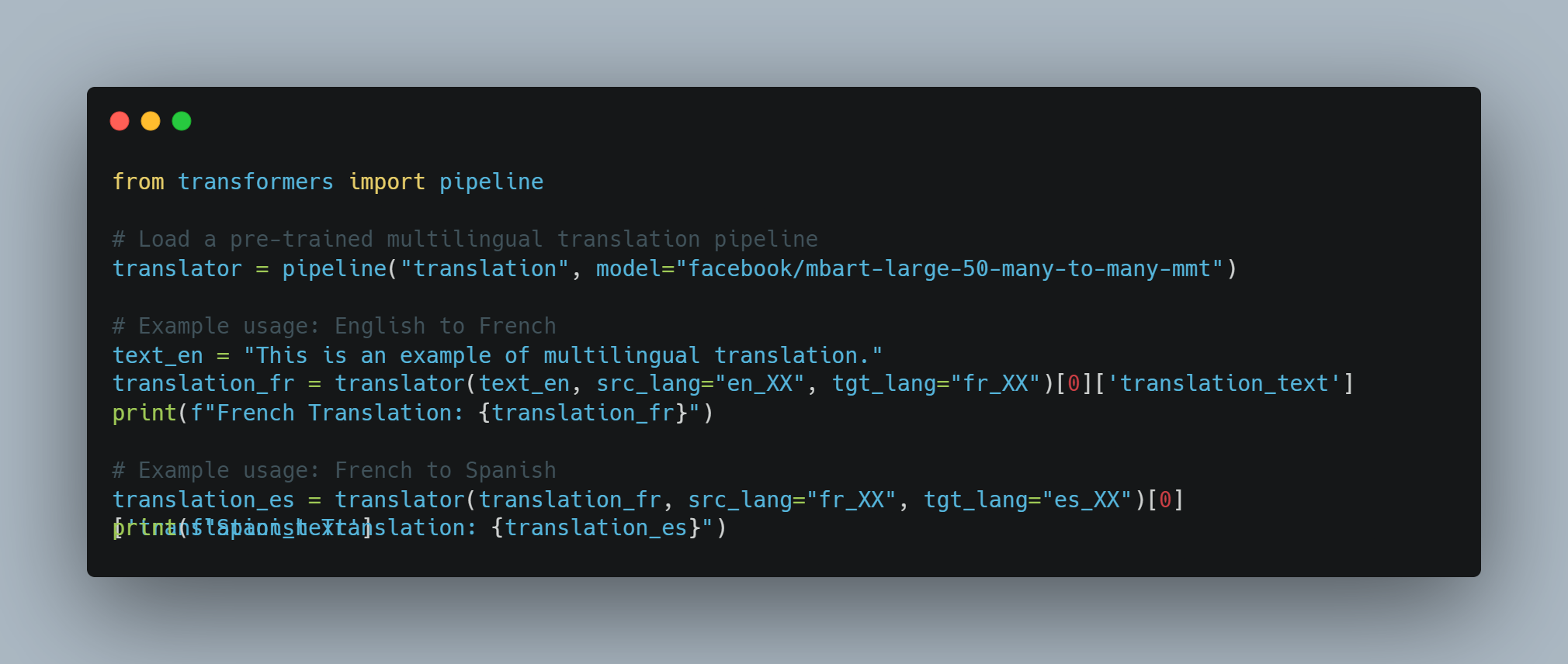

Sprachübersetzung: Sie können Text zwischen verschiedenen Sprachen mit hoher Genauigkeit übersetzen.

-

Zusammenfassung: LLMs können lange Texte zu prägnanten Zusammenfassungen verdichten, wobei die wichtigsten Informationen erhalten bleiben.

-

Fragebeantwortung: Sie können auf der Grundlage ihrer umfangreichen Wissensbasis präzise Antworten auf Anfragen geben.

-

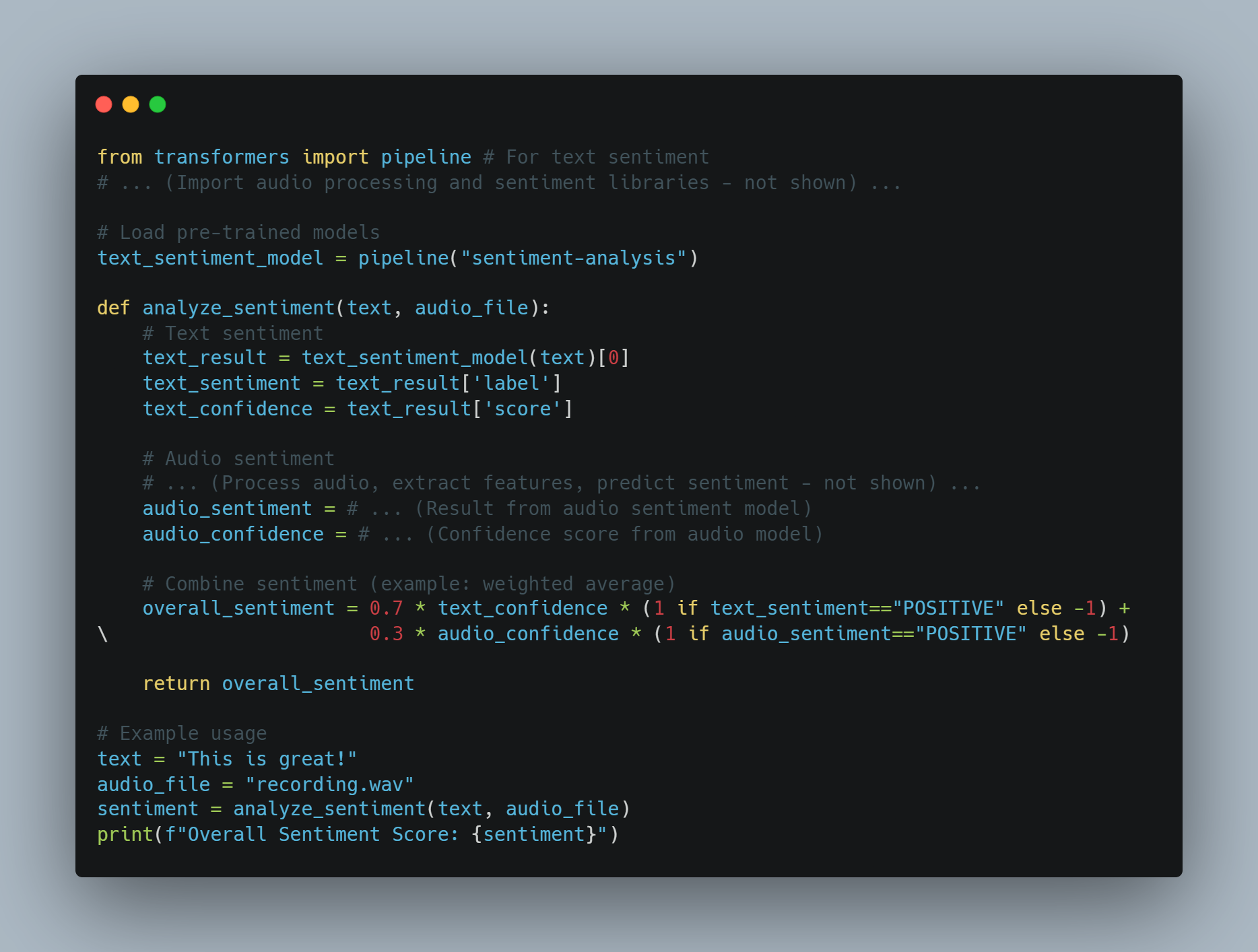

Sentiment Analysis: LLMs können die in einem bestimmten Text ausgedrückte Stimmung analysieren und bestimmen.

-

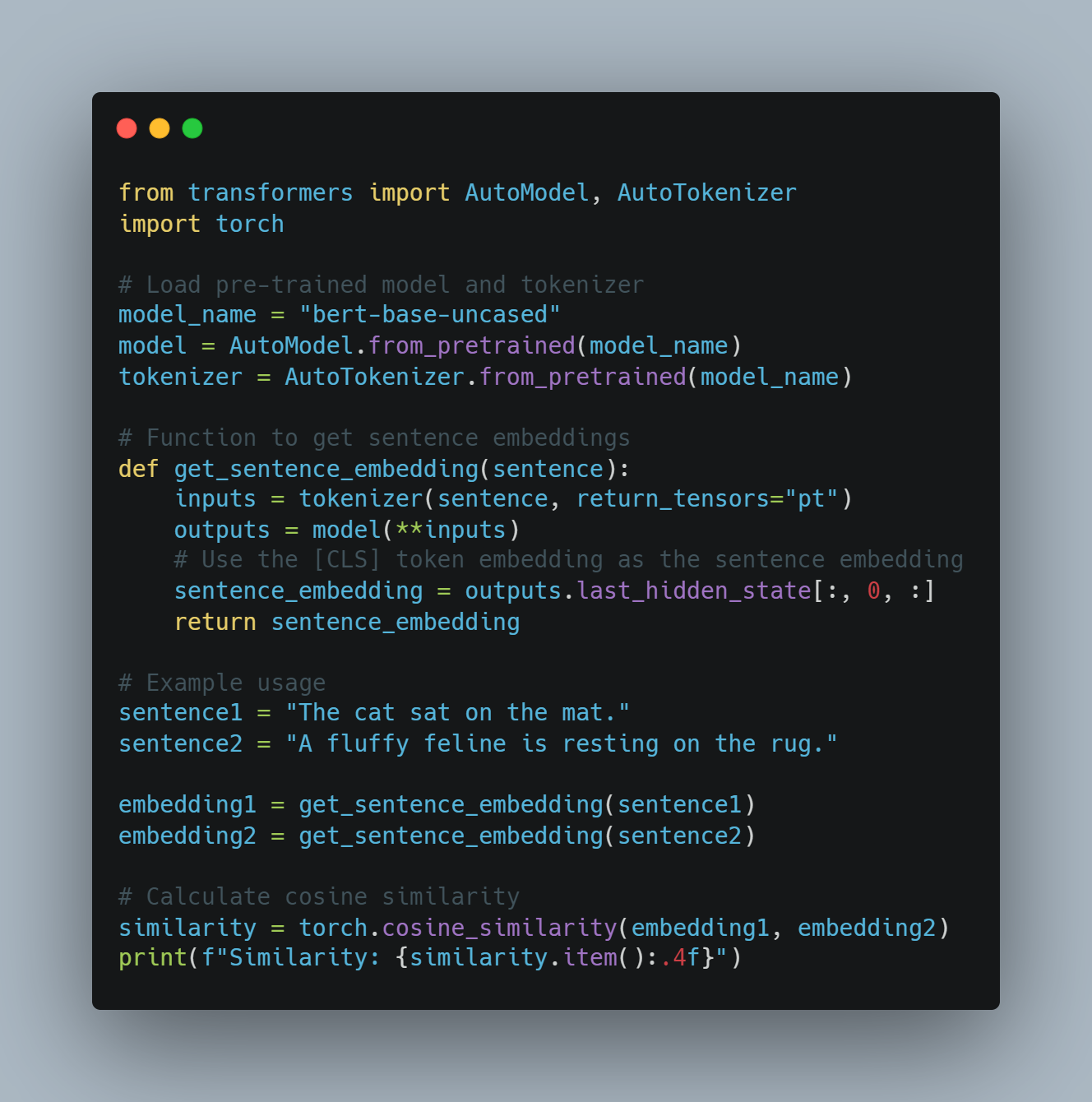

Codegenerierung: Sie können auf der Grundlage natürlichsprachlicher Beschreibungen Codeschnipsel oder ganze Funktionen generieren.

Stufen von KI-Agenten

KI-Agenten können aufgrund ihrer Fähigkeiten und Komplexität in verschiedene Stufen eingeteilt werden. Nach einem Paper auf arXiv werden KI-Agenten in fünf Stufen eingeteilt:

-

Stufe 1 (L1): KI-Agenten als Forschungsassistenten, bei denen Wissenschaftler Hypothesen aufstellen und Aufgaben festlegen, um Ziele zu erreichen.

-

Stufe 2 (L2): KI-Agenten, die autonom spezifische Aufgaben innerhalb eines definierten Bereichs ausführen können, wie z. B. Datenanalyse oder einfache Entscheidungsfindung.

-

Stufe 3 (L3): KI-Agenten, die in der Lage sind, aus Erfahrungen zu lernen und sich an neue Situationen anzupassen, was ihre Entscheidungsprozesse verbessert.

-

Stufe 4 (L4): KI-Agenten mit fortgeschrittenen Denk- und Problemlösungsfähigkeiten, die komplexe, mehrstufige Aufgaben bewältigen können.

-

Stufe 5 (L5): Vollständig autonome KI-Agenten, die unabhängig in dynamischen Umgebungen operieren können, Entscheidungen treffen und Maßnahmen ergreifen, ohne menschliches Eingreifen.

Beschränkungen großer Sprachmodelle

Trainingskosten und Ressourcenbeschränkungen

Große Sprachmodelle (LLMs) wie GPT-3 und PaLM haben die natürliche Sprachverarbeitung (NLP) revolutioniert, indem sie tiefe Lernmethoden und umfangreiche Datensätze nutzen.

Diese Fortschritte jedoch kommen mit erheblichen Kosten. Die Ausbildung von LLM erfordert erhebliche Rechenressourcen und beträgt oft Tausende von GPUs und umfassendem Energieverbrauch.

Laut Sam Altman, dem CEO von OpenAI, wurden die Ausbildungskosten für GPT-4 über 100 Millionen USD erreicht. Dies entspricht der gemeldeten Größe und Komplexität des Modells, mit Schätzungen, die etwa 1 Trillion Parameter aufweisen lassen. Allerdings bieten andere Quellen unterschiedliche Zahlen:

-

Ein veröffentlichtes Berichts zeigte, dass die Ausbildungskosten für GPT-4 etwa 63 Millionen USD betrugen, anhand der Rechenleistung und der Trainingsdauer.

-

Mit dem Jahreswechsel 2023 gab es Schätzungen, dass die Ausbildung eines Modells ähnlicher Größe wie GPT-4 etwa 20 Millionen USD kosten könnte und etwa 55 Tage dauern würde, was Fortschritte in der Effizienz widerspiegelt.

Der hohe Preis für die Training und Wartung von LLM begrenzt ihre allgemeine Verbreitung und Skalierbarkeit.

Datenbegrenzungen und Verzerrungen

Der Leistung von LLM ist stark von der Qualität und Vielfalt der Trainingsdaten abhängig. Obwohl LLM auf großen Datensets trainiert werden, können sie immer noch Verzerrungen in den Daten anzeigen, was zu verzogenen oder unangemessenen Ausgaben führt. Diese Verzerrungen können in verschiedenen Formen auftreten, einschließlich Geschlechts-, Rassen- und Kulturverzerrungen, die Stereotype und Falschinformation fortführen können.

Darüber hinaus bedeutet die statische Natur der Trainingsdaten, dass LLM nicht auf die neuesten Informationen auf dem neuesten Stand sind, was ihre Effektivität in dynamischen Umgebungen begrenzt.

Spezialisierung und Komplexität

Obwohl LLM im allgemeinen Aufgaben hervorragend leisten, haben sie oft Schwierigkeiten mit spezialisierten Aufgaben, die Erkenntnisse von besonderen Bereichen und hohe Komplexität erfordern.

Zum Beispiel erfordern Aufgaben in Bereichen wie Medizin, Recht und wissenschaftlicher Forschung eine tiefe Verständnis von fachspezifischen Begriffen und differenziertem Denken, die LLM möglicherweise nicht von Haus aus besitzen. Diese Begrenzung erfordert die Integration zusätzlicher Expertenebene und eine Feineinstellung, um LLM für spezialisierte Anwendungen effektiv zu machen.

Eingabe- und Sinnesbegrenzungen

LLMs verarbeiten hauptsächlich textbasierte Eingaben, was ihre Fähigkeit einschränkt, auf multimodale Weise mit der Welt zu interagieren. Während sie Text generieren und verstehen können, fehlt ihnen die Fähigkeit, visuelle, auditive oder sensorische Eingaben direkt zu verarbeiten.

Diese Einschränkung behindert ihre Anwendung in Bereichen, die eine umfassende sensorische Integration erfordern, wie Robotik und autonome Systeme. Zum Beispiel kann ein LLM ohne zusätzliche Verarbeitungsschichten keine visuellen Daten von einer Kamera oder auditive Daten von einem Mikrofon interpretieren.

Kommunikations- und Interaktionsbeschränkungen

Die aktuellen Kommunikationsfähigkeiten von LLMs sind überwiegend textbasiert, was ihre Fähigkeit einschränkt, sich an immersiveren und interaktiveren Kommunikationsformen zu beteiligen.

Zum Beispiel können LLMs zwar Textantworten generieren, aber sie können keine Videoinhalte oder holografischen Darstellungen produzieren, die in virtuellen und erweiterten Realität Anwendungen zunehmend wichtig sind (mehr dazu hier). Diese Einschränkung verringert die Effektivität von LLMs in Umgebungen, die reichhaltige, multimodale Interaktionen erfordern.

Wie man Einschränkungen mit AI-Agenten überwindet

AI-Agenten bieten eine vielversprechende Lösung für viele der von LLMs erlebten Einschränkungen. Diese Agenten sind so konzipiert, dass sie autonom arbeiten, ihre Umgebung wahrnehmen, Entscheidungen treffen und Aktionen ausführen, um spezifische Ziele zu erreichen. Durch die Integration von AI-Agenten mit LLMs ist es möglich, deren Fähigkeiten zu erweitern und ihre inhärenten Einschränkungen zu überwinden.

-

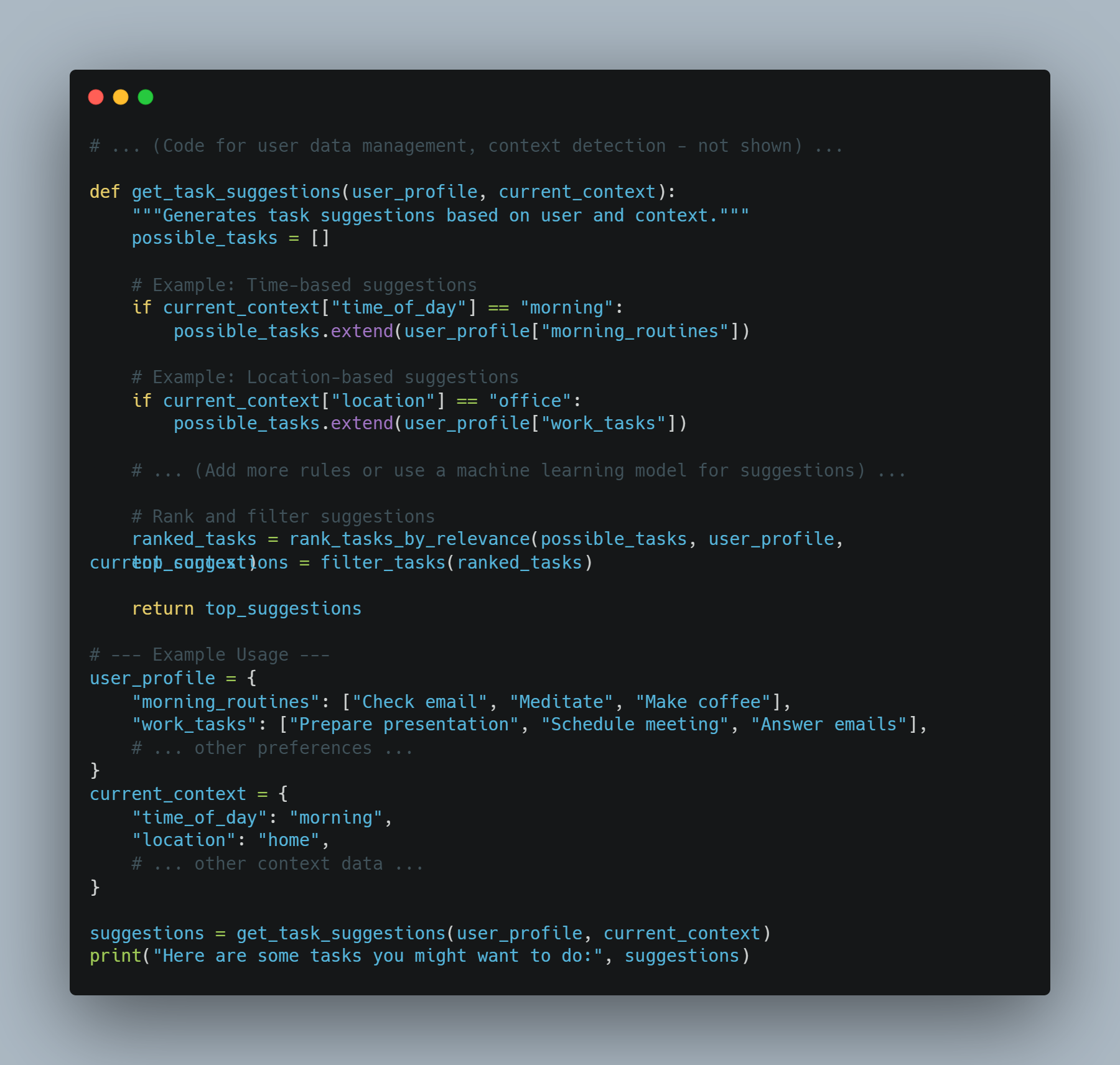

Verbesserte Kontext- und Speicherfunktion: KI-Agenten können über mehrere Interaktionen hinweg den Kontext beibehalten, was zu kohärenteren und kontextuell relevanteren Antworten führt. Diese Fähigkeit ist besonders nützlich in Anwendungen, die eine Langzeitgedächtnis und Kontinuität erfordern, wie z.B. Kundenservice und persönliche Assistenten.

-

Multimodale Integration: KI-Agenten können sensorische Eingaben aus verschiedenen Quellen, wie Kameras, Mikrofone und Sensoren, einbeziehen, was LLMs ermöglicht, visuelle, auditive und sensorische Daten zu verarbeiten und darauf zu reagieren. Diese Integration ist entscheidend für Anwendungen in Robotik und autonomen Systemen.

-

Spezialisierte Kenntnisse und Fachwissen: AI-Agenten können mit domain-spezifischer Kenntnis fein abgestimmt werden, was die Fähigkeit von LLM, spezialisierte Aufgaben zu erledigen, verstärkt. Dieser Ansatz ermöglicht die Erstellung von Expertenystemen, die komplexe Abfragen in Bereichen wie Medizin, Recht und wissenschaftlicher Forschung verarbeiten können.

-

Interaktives und immersives Kommunizieren: AI-Agenten können durch die Generierung von Videoinhalten, die Steuerung von Hologrammen und die Interaktion mit virtuellen und erweiterten Realitäten immersivere Formen der Kommunikation fördern. Diese Fähigkeit erweitert die Anwendbarkeit von LLM in Bereichen, die reiche, multimodale Interaktionen erfordern.

Obwohl große Sprachmodelle bemerkenswerte Fähigkeiten in der natürlichen Sprachverarbeitung gezeigt haben, gibt es auch Grenzen. Die hohen Trainingskosten, Datenbias, Spezialisierungschallenges, sensorische Einschränkungen und Kommunikationsbeschränkungen stellen erhebliche Hindernisse dar.

Die Integration von KI-Agenten bietet jedoch eine praktikable Lösung, um diese Grenzen zu überwinden. Durch die Nutzung der Stärken von KI-Agenten ist es möglich, die Funktionalität, Anpassbarkeit und Anwendbarkeit von LLM zu verbessern, was den Weg für fortschrittlichere und vielseitigere AI-Systeme ebnet.

Kapitel 2: Die Geschichte der Künstlichen Intelligenz und KI-Agenten

Die Entstehung der Künstlichen Intelligenz

Der Begriff der künstlichen Intelligenz (KI) hat seinen Ursprung weitaus länger zurückliegend als in der heutigen digitalen Ära. Der Gedanke, Maschinen zu schaffen, die menschenähnliche Denkvermögen aufweisen, kann bis in die alten Mythen und philosophischen Debatten zurückverfolgt werden. Der formale Ursprung von AI als wissenschaftliche Disziplin ereignete sich jedoch in der Mitte des 20. Jahrhunderts.

Die Dartmouth-Konferenz von 1956, organisiert von John McCarthy, Marvin Minsky, Nathaniel Rochester und Claude Shannon, gilt allgemein als Geburtsort der künstlichen Intelligenz (AI) als Forschungsbereich. Diese grundlegende Veranstaltung brachte führende Forscher zusammen, um die Möglichkeiten der Erstellung von Maschinen zu erforschen, die die menschliche Intelligenz simulieren könnten.

Frühes Optimismus und die AI-Winter

Die Anfänge der AI-Forschung waren geprägt von unbegrenztem Optimismus. Forscher machten bedeutende Fortschritte in der Entwicklung von Programmen, die mathematische Probleme lösen, Spiele spielen und sogar rudimentäre natursprachliche Verarbeitung erledigen konnten.

Aber diese anfängliche Begeisterung wurde gemäßigt durch die Erkenntnis, dass die Schaffung wirklich intelligenter Maschinen viel komplexer war als ursprünglich angenommen.

Die 1970er und 1980er Jahre sahen eine Periode des abnehmender Finanzierung und Interesses in der AI-Forschung, die allgemein als „AI-Winter“ bezeichnet wird. Diese Abnahme war hauptsächlich auf das Versagen der AI-Systeme bei der Erfüllung der hohen Erwartungen der frühen Pioniere zurückzuführen.

Von Regelbasierten Systemen zu Machine Learning

Die Ära der ExpertenSysteme

Die 1980er Jahre sahen eine Wiederbelebung des Interesses in der AI, primär durch die Entwicklung von Expertensystemen initiiert. Diese regelbasierten Programme waren dafür konzipiert, die Entscheidungsprozesse menschlicher Experten in bestimmten Bereichen zu emulieren.

Expertsysteme finden Anwendungen in verschiedenen Bereichen, einschließlich der Medizin, der Finanzen und der Ingenieurwissenschaften. Allerdings waren sie durch ihre Unfähigkeit, aus Erfahrungen zu lernen oder sich an neue Situationen außerhalb ihrer programmierten Regeln anzupassen, eingeschränkt.

Der Aufstieg der Maschinellem Lerne

Die Grenzen von regelbasierten Systemen legten den Weg frei für einen Paradigmenwechsel hin zur maschinellen Lerne. Dieser Ansatz, der ab den 1990er Jahren und den 2000er Jahren hervortrat, konzentriert sich auf die Entwicklung von Algorithmen, die aus Daten lernen und basierend auf diesen Daten Prognosen oder Entscheidungen treffen können.

Maschinelle Lerneverfahren wie neuronale Netze und Support-Vector-Maschinen zeigten bemerkenswerter Erfolg in Aufgaben wie Mustererkennung und Datenklassifizierung. Die Zeit des Big Data und die zunehmende Rechenleistung beschleunigten weiter die Entwicklung und Anwendung von maschinellen Lernalgorithmen.

Die Emergenz selbständiger AI-Agenten

Von beschränkter AI zu allgemeiner AI

Als AI-Technologien weiter evolved, begannen Forscher, die Möglichkeit zu erforschen, um mehr universelle und autonom arbeitende Systeme zu schaffen. Dieser Übergang markierte den Wechsel von beschränkter AI, die für bestimmte Aufgaben entwickelt wurde, hin zur Suche nach künstlicher allgemeiner Intelligenz (AGI).

AGI zielt auf die Entwicklung von Systemen ab, die jeder intellektuellen Aufgabe, die ein Mensch ausführen kann, fähig sind. Obwohl reale AGI immer noch ein weit entferntes Ziel ist, wurden bereits erhebliche Fortschritte bei der Schaffung flexibler und anpassbarer AI-Systeme erzielt.

Die Rolle von Tieflern und Neuronalen Netzwerken

Der Aufstieg von Tieflern, einem Subsystem von Maschinenlernen, das auf künstlichen neuronalen Netzwerken basiert, hat maßgeblich zu einer Verbesserung des AI-Felds beigetragen.

Tieflearn-Algorithmen, die durch die Struktur und Funktion des menschlichen Gehirns inspiriert sind, haben bei Bereichen wie Bild- und Spracherkennung, natürlicher Sprachverarbeitung und Spielen bemerkenswerte Fähigkeiten gezeigt. Diese Fortschritte haben den Grundstein für die Entwicklung komplexerer selbständiger AI-Agenten gelegt.

Eigenschaften und Arten von AI-Agenten

AI-Agenten sind selbständige Systeme, die in der Lage sind, ihr Umfeld wahrzunehmen, Entscheidungen zu treffen und Aktionen durchzuführen, um bestimmte Ziele zu erreichen.Sie verfügen über Eigenschaften wie Autonomie, Wahrnehmung, Reaktivität, Rechnung, Entscheidungsfindung, Lernen, Kommunikation und Zielorientierung.

Es gibt verschiedene Arten von AI-Agenten, die jeweils unterschiedliche Fähigkeiten haben:

-

Einfache Reflex-Agenten: Reagieren auf bestimmte Stimuli basierend auf vorher definierten Regeln.

-

Modellbasierte Reflexagenten: Halten ein internes Modell der Umgebung bereit, um Entscheidungen zu treffen.

-

Zielbasierte Agenten: Führen Aktionen aus, um bestimmte Ziele zu erreichen.

-

Nutzenbasierte Agenten: Berücksichtigen potenzielle Ergebnisse und wählen Aktionen aus, die erwartete Nutzen maximieren.

-

Lernende Agenten: Verbessern die Entscheidungsfindung mit der Zeit durch maschinelles Lernen.

Herausforderungen und ethische Überlegungen

Als AI-Systeme zunehmend fortschrittn und unabhängiger werden, gehen mit ihnen kritische Überlegungen einher, um sicherzustellen, dass ihre Nutzung innerhalb der sozial anerkannten Grenzen bleibt.

Insbesondere Large Language Models (LLMs) agieren als Leistungserhöhungsfaktoren für die Produktivität. Dies löst jedoch eine entscheidende Frage auf: Was werden diese Systeme supercharge—gute Absichten oder böse Absichten? Wenn die Absicht hinter der Nutzung von AI böse ist, ist es dringend erforderlich, dass diese Systeme solche Missbrauchsabsichten mithilfe verschiedener NLP-Techniken oder anderer verfügbarer Tools erkennen.

Ingenieure von LLM haben Zugriff auf eine Reihe von Werkzeugen und Methodologien, um diese Herausforderungen zu bewältigen:

-

Sentiment Analyse: Durch die Verwendung von Sentiment Analyse können LLMs den emotionalen Tone des Textes bewerten, um schädliche oder aggressives Sprachverhalten zu erkennen, was dazu beitragen kann, potenzielle Fehlverwendungen auf Kommunikationsplattformen zu erkennen.

-

Inhaltsfilterung: Werkzeuge wie Schlüsselwortfilterung und Mustererkennung können verwendet werden, um die Generierung oder Verbreitung schädlicher Inhalte zu vermeiden, wie z.B. Hassrede, Falschmeldungen oder explizites Material.

-

Voreingenommenheiterkennung: Durch die Implementierung von Voreingenommenheiterkennungssystemen, wie z.B. AI Fairness 360 (IBM) oder Fairness Indicators (Google), kann die Voreingenommenheit in Sprachmodelle erkannt und abgemildert werden, sicherstellend, dass AI-Systeme faire und gleichberechtigteoperationen haben.

-

Erklärbarkeitstechniken: Mit Erklärbarkeitstools wie LIME (Local Interpretable Model-agnostic Explanations) oder SHAP (SHapley Additive exPlanations) können Ingenieure die Entscheidungsprozesse von LLMs verstehen und erklären, was es erleichtert, unbeabsichtigte Verhaltensweisen zu erkennen und zu beheben.

-

Adversarial Testing: Durch die Simulation von bösartigen Angriffen oder schädlichen Eingaben können Ingenieure LLMs mit Tools wie TextAttack oder dem Adversarial Robustness Toolbox Stresstests unterziehen, um Schwachstellen zu identifizieren, die für böswillige Zwecke ausgenutzt werden könnten.

-

Ethische KI-Richtlinien und -Rahmenwerke: Die Übernahme ethischer KI-Entwicklungsrichtlinien, wie sie vom IEEE oder der Partnership on AI bereitgestellt werden, kann die Schaffung verantwortungsbewusster KI-Systeme leiten, die das gesellschaftliche Wohl priorisieren.

Neben diesen Werkzeugen benötigen wir deshalb ein dediziertes Red Team für KI – spezialisierte Teams, die LLMs an ihre Grenzen bringen, um Lücken in ihren Verteidigungen zu erkennen. Red Teams simulieren gegnerische Szenarien und decken Schwachstellen auf, die sonst unbemerkt bleiben könnten.

Doch es ist wichtig zu erkennen, dass die Menschen hinter dem Produkt den stärksten Einfluss darauf haben. Viele der Angriffe und Herausforderungen, denen wir heute gegenüberstehen, existierten bereits, bevor LLMs entwickelt wurden, was zeigt, dass der menschliche Faktor zentral bleibt, um sicherzustellen, dass KI ethisch und verantwortungsvoll eingesetzt wird.

Die Integration dieser Werkzeuge und Techniken in die Entwicklungspipeline, zusammen mit einem wachsamen Red Team, ist entscheidend, um sicherzustellen, dass LLMs positive Ergebnisse verstärken und deren Missbrauch erkennen und verhindern.

Kapitel 3: Wo KI-Agenten am stärksten glänzen

Die einzigartigen Stärken von KI-Agenten

KI-Agenten zeichnen sich durch ihre Fähigkeit aus, ihre Umgebung autonom wahrzunehmen, Entscheidungen zu treffen und Aktionen auszuführen, um spezifische Ziele zu erreichen. Diese Autonomie, kombiniert mit fortschrittlichen maschinellen Lernfähigkeiten, ermöglicht es KI-Agenten, Aufgaben zu übernehmen, die entweder zu komplex oder zu repetitiv für Menschen sind.

Hier sind die wichtigsten Stärken, die KI-Agenten glänzen lassen:

-

Autonomie und Effizienz: KI-Agenten können eigenständig ohne ständige menschliche Intervention arbeiten. Diese Autonomie ermöglicht es ihnen, Aufgaben rund um die Uhr zu erledigen, was die Effizienz und Produktivität erheblich steigert. Zum Beispiel können KI-gesteuerte Chatbots bis zu 80% der routinemäßigen Kundenanfragen bearbeiten, was die Betriebskosten senkt und die Reaktionszeiten verbessert.

-

Erweiterte Entscheidungsfindung: KI-Agenten können riesige Datenmengen analysieren, um fundierte Entscheidungen zu treffen. Diese Fähigkeit ist besonders wertvoll in Bereichen wie der Finanzbranche, wo KI-Handelsbots die Handelseffizienz erheblich steigern können.

-

Lernen und Anpassungsfähigkeit: KI-Agenten können aus Erfahrung lernen und sich an neue Situationen anpassen. Diese kontinuierliche Verbesserung ermöglicht es ihnen, ihre Leistung im Laufe der Zeit zu steigern. Zum Beispiel können KI-Gesundheitsassistenten dazu beitragen, Diagnosefehler zu reduzieren und somit die Gesundheitsergebnisse zu verbessern.

-

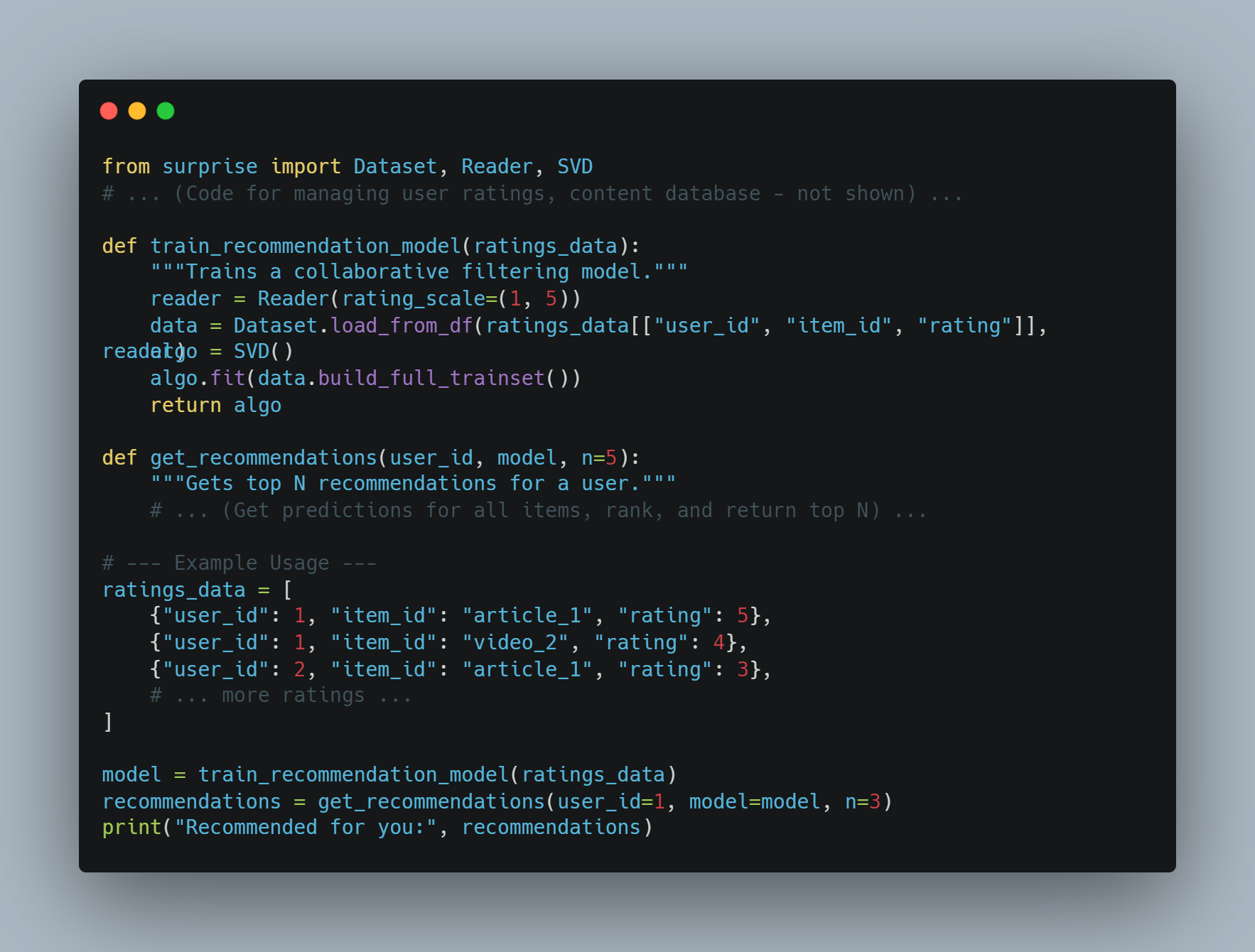

Personalisierung: KI-Agenten können personalisierte Erlebnisse bieten, indem sie das Benutzerverhalten und die Vorlieben analysieren. Amazon’s Empfehlungs-Engine, die 35 % seines Umsatzes ausmacht, ist ein hervorragendes Beispiel dafür, wie KI-Agenten das Benutzererlebnis verbessern und den Umsatz steigern können.

Warum KI-Agenten die Lösung sind

AI-Agenten bieten Lösungen für viele der Herausforderungen an, die traditionelle Software und menschlich bediente Systeme erdulden. Hier ist warum sie die bevorzugte Wahl sind:

-

Skalierbarkeit: AI-Agenten können Operationen skalieren, ohne dass die Kosten proportional ansteigen. Diese Skalierbarkeit ist für Geschäfte von Bedeutung, die wachsen wollen, ohne dass ihre Beschäftigtezahl oder ihre operationellen Ausgaben signifikant ansteigen.

-

Konsistenz und Zuverlässigkeit: Im Gegensatz zu Menschen litten AI-Agenten nicht an Erschöpfung oder Unterschiedlichkeit. Sie können repetitive Aufgaben mit hoher Genauigkeit und Zuverlässigkeit erledigen, was eine konsequente Leistung gewährleistet.

-

Datenbasierte Einsichten: AI-Agenten können große Datenmengen verarbeiten und analysieren, um Muster und Einsichten zu entdecken, die möglicherweise von Menschen verpasst werden. Diese Fähigkeit ist unentbehrlich für Entscheidungen in Bereichen wie Finanzen, Gesundheitswesen und Marketing.

-

Kosteneinsparungen: Durch die Automatisierung von Routinetasks können AI-Agenten die Notwendigkeit für menschliche Ressourcen reduzieren, was zu signifikanten Kosteneinsparungen führt. Zum Beispiel können AI-gesteuerte Betrugserkennungssysteme jährlich Milliarden von Dollar sparen, indem sie betrügerische Aktivitäten reduzieren.

Bedingungen für die gut ablaufende Arbeit von AI-Agenten

Um die erfolgreiche Einführung und Leistung von AI-Agenten sicherzustellen, müssen bestimmte Bedingungen erfüllt werden:

-

Klare Ziele und Anwendungsfälle: Die Definition von spezifischen Zielen und Anwendungsfällen ist entscheidend für die effektive Einführung von AI-Agenten. Diese Klarheit hilft bei der Festlegung von Erwartungen und der Messung von Erfolg. Zum Beispiel kann das Setzen eines Ziels, die Reaktionszeiten des Kunden-Service um 50% zu verringern, die Einführung von AI-Chatbots beeinflussen.

-

Qualität von Daten

: AI-Agenten verlassen sich auf hochwertige Daten für die Ausbildung und den Betrieb. Die Gewährleistung, dass die Daten korrekt, relevant und aktuell sind, ist unerlässlich, um das effektive Handeln der Agenten zu gewährleisten.

-

Integration mit bestehenden Systemen: Eine nahtlose Integration mit bestehenden Systemen und Workflows ist notwendig, um die AI-Agenten optimal zu funktionieren. Diese Integration stellt sicher, dass AI-Agenten auf die notwendigen Daten zugreifen und mit anderen Systemen interagieren können, um ihre Aufgaben zu erfüllen.

-

Kontinuierliches Überwachen und Optimieren: Die regelmäßige Überwachung und Optimierung von AI-Agenten ist entscheidend, um ihre Leistung zu halten. Dies umfasst das Verfolgen von Schlüsselperformanceindikatoren (KPIs) und die notwendigen Anpassungen auf der Basis von Rückmeldungen und Leistungsdaten.

-

Ethische Überlegungen und Bias-Minderung: Die Berücksichtigung ethischer Aspekte und die Minderung von Voreingenommenheit bei KI-Agenten sind entscheidend, um Fairness und Inklusivität zu gewährleisten. Die Implementierung von Maßnahmen zur Erkennung und Verhinderung von Voreingenommenheit kann dazu beitragen, Vertrauen aufzubauen und eine verantwortungsvolle Bereitstellung sicherzustellen.

Best Practices für die Bereitstellung von KI-Agenten

Bei der Bereitstellung von KI-Agenten können folgende bewährte Verfahren zu ihrem Erfolg und ihrer Effektivität beitragen:

-

Ziele und Anwendungsfälle definieren: Identifizieren Sie klar die Ziele und Anwendungsfälle für die Bereitstellung von KI-Agenten. Dies hilft dabei, Erwartungen festzulegen und den Erfolg zu messen.

-

Wähle die richtige AI-Plattform

: Wähle eine AI-Plattform, die mit deinen Zielen, Anwendungsfällen und bestehenden Infrastrukturen alignmentiert. Berücksichtige Faktoren wie integrierbare Kapazitäten, Skalierbarkeit und Kosten.

-

Erstelle eine umfassende Wissensbasis: Erstelle eine gut strukturierte und präzise Wissensbasis, um AI-Agenten zu ermöglichen, relevante und zuverlässige Antworten zu liefern.

-

Stelle sicher, dass die Integration flüssig ist: Integriere AI-Agenten mit bestehenden Systemen wie CRM und Callcenter-Technologien, um eine integrierte Kundererfahrung zu bieten.

-

Trainiere und optimiere AI-Agenten: Trainiere und optimiere AI-Agenten kontinuierlich mit Daten aus Interaktionen. Überwache die Leistung, identifiziere Bereiche für Verbesserungen und aktualisiere Modelle entsprechend.

-

Zeichne geeignete Eskalationsverfahren ab

: Definiere Protokolle für das Weiterleiten komplexer oder emotionaler Anrufe an menschliche Agenten, um eine glaubhafte Übergabe und eine effiziente Lösung zu gewährleisten.

-

Monitoriere und analysiere Leistung: Verfolge Schlüsselleistungsindikatoren (KPIs) wie Verfahrenslösungsraten, Durchschnittsverarbeitungszeit und Kundenzufriedenheitspunkte. Nutze Analyse工具 für datengesteuerte Einsichten und Entscheidungen.

-

Stelle sicher, dass Datenvertraulichkeit und -sicherheit gewahrt werden: starke Sicherheit ist Schlüssel, wie Daten anonymisiert, menschlicher Aufsicht sichergestellt, Richtlinien für Datenerhaltung eingerichtet und starke Verschlüsselungsmaßnahmen festgelegt, um Kunden Daten zu schützen und Vertraulichkeit zu halten.

AI-Agenten + LLMs: Eine neue Ära von intelligenten Software-Lösungen

Stellen Sie sich vor, es gäbe Software, die Ihre Anfragen nicht nur versteht, sondern auch selbständig diese ausführt. Dies ist die Zusage der Kombination von künstlichen Intelligenz-Agenten mit Großen Sprachmodellen (LLM). Diese kraftvollen Paarung schafft eine neue Kategorie von Anwendungen, die intuitiverer, kapazitäterferner und wirkungsvoller sind als je zuvor.

AI-Agenten: Jenseits von einfachen Aufgabenausführung

Obwohl oft mit digitalen Assistenten verglichen, sind AI-Agenten weit mehr als verklärte Skriptfollower. Sie umfassen eine Reihe von fortschrittlichen Technologien und arbeiten auf einem Rahmenwerk, das dynamische Entscheidungsprozesse und Handlungsvorgänge ermöglicht.

-

Architektur: Ein typischer AI-Agent besteht aus mehreren Schlüsselkomponenten:

-

Sensoren: Diese ermöglichen es dem Agenten, seine Umgebung wahrzunehmen, indem er Daten von verschiedenen Quellen wie Sensoren, APIs oder Benutzereingaben erfasst.

-

Glauber-Zustand: Dies repräsentiert das Verständnis des Agenten von der Welt auf der Basis der gesammelten Daten. Es wird laufend aktualisiert, wenn neue Informationen verfügbar sind.

-

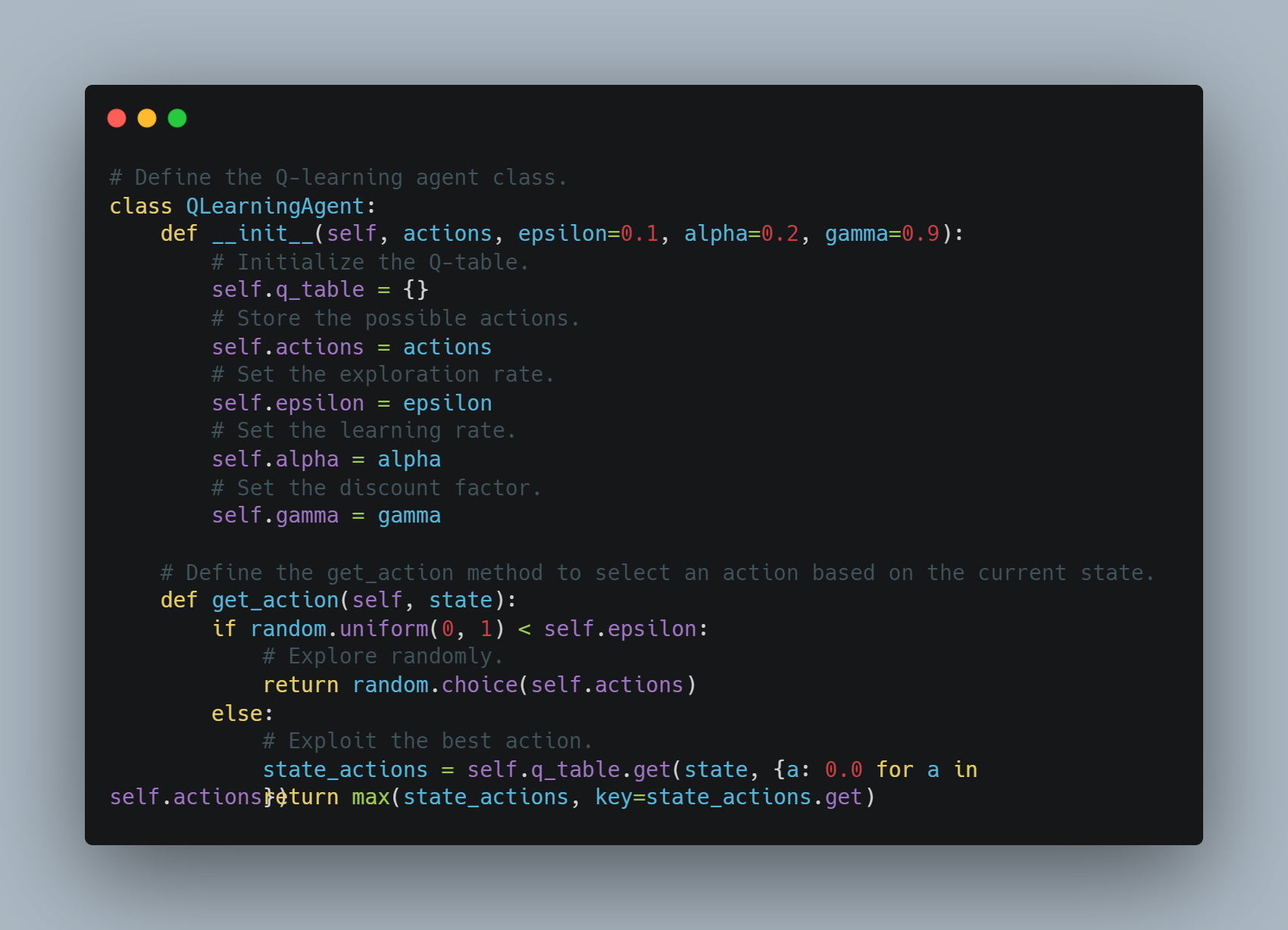

Reasoning Engine: Dies ist der Kern des Entscheidungsprozesses des Agenten. Er nutzt Algorithmen, oft auf der Basis von Lernverfahren wie z.B. Verstärkungslernen oder Planungstechniken, um die beste Handlung basierend auf seinen aktuellen Glaubensüberzeugungen und Zielen zu bestimmen.

-

Aktuatoren: Dies sind die Werkzeuge des Agenten für die Interaktion mit der Welt. Sie können von API-Aufrufen bis hin zu physischen Robotern reichen.

-

-

Herausforderungen:

traditionelle AI-Agenten sind zwar in der Lage, klar definierte Aufgaben zu erledigen, zeigen jedoch oft Schwierigkeiten bei:

-

Natürliche Sprachverständnis: Die Interpretation des nuancierten menschlichen Sprachverständnisses, die Handhabung von Unterscheidungen und die Extraktion von Bedeutungen aus dem Kontext stellen nach wie vor erhebliche Herausforderungen dar.

-

Alltagsreasoning: Derzeitige AI-Agenten verfügen oft nicht über das allgemeine Wissen und die Reasoning-Fähigkeiten, die Menschen für selbstverständlich halten.

-

Generalisierung: Die Ausbildung von Agenten, um gut auf unbekannte Aufgaben zu performen oder an neuen Umgebungen anzupassen, bleibt ein Schlüsselbereich der Forschung.

-

LLM: Sprachverständnis und -generierung freischalten

LLM mit ihrer ungeheuerlichen Kenntnis, die in Milliarden von Parametern codiert ist, bringen bisher unvorhergesehene Sprachfähigkeiten auf den Tisch:

-

Transformer-Architektur: Der Grundstein der meisten modernen LLM ist die Transformer-Architektur, ein neuronales Netzdesign, das sich hervorragend für die Verarbeitung sequentieller Daten wie Text bewährt. Dies ermöglicht es LLM, Sprachabhängigkeiten über lange Distanzen zu erkennen, was sie in der Lage macht, den Kontext zu verstehen und kohärente und inhaltlich relevante Texte zu generieren.

-

Fähigkeiten: LLM sind hervorragend in einer Vielzahl von sprachbasierten Aufgaben:

-

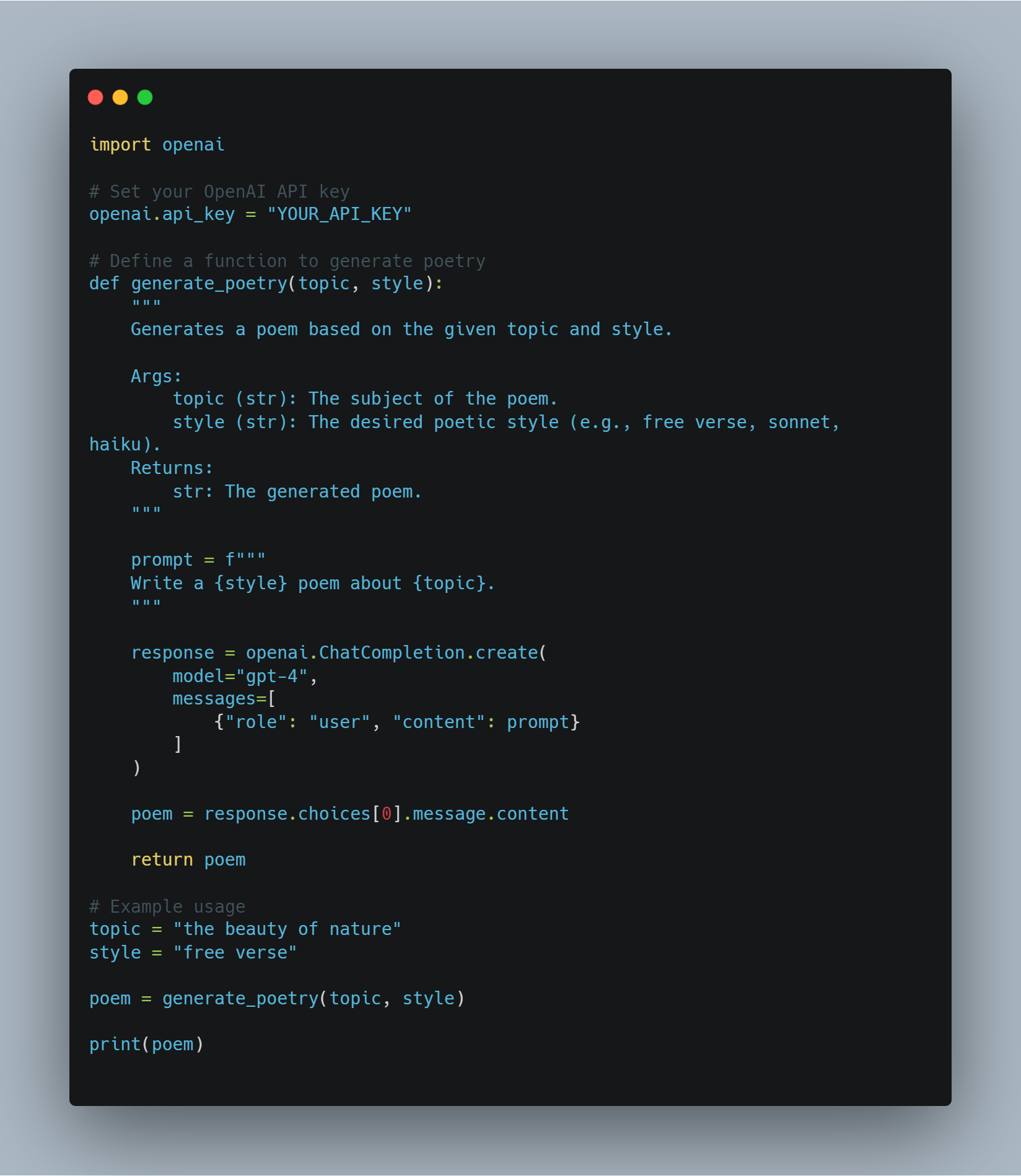

Textgenerierung: Von der Schaffung von kreativem Fiktion bis zur Generierung von Code in mehreren Programmiersprachen, zeigen LLM bemerkenswerte Flüssigkeit und Kreativität.

-

Fragebeantwortung: Sie können kurze und präzise Antworten auf Fragen liefern, selbst wenn die Information über lange Dokumente verstreut ist.

-

Zusammenfassung: LLM können große Textmengen in kurze Zusammenfassungen verwandeln, indem sie wichtige Informationen extrahieren und irrelevante Details verwerfen.

-

-

Einschränkungen: Trotz ihrer beeindruckenden Fähigkeiten haben LLMs Einschränkungen:

-

Fehlende Realitätsgrundlage: LLMs arbeiten primär im Bereich der Textverarbeitung und verfügen nicht über die Fähigkeit, direkt mit der physikalischen Welt zu interagieren.

-

Mögliche Voreingenommenheit und Halluzination: Trainiert auf massiven, ungefilterten Datensätzen können LLMs biassierte Informationen aus den Daten erben und manchmal faktisch falsche oder unvernünftige Informationen generieren.

-

Die Synergie: Die Brücke zwischen Sprache und Handlung

Die Kombination von AI-Agenten und LLM lässt die Einschränkungen jedes vermeiden und schafft Systeme, die sowohl intelligent als auch fähig sind:

-

LLM als Interpreten und Planer: LLM können natürliche Sprachanweisungen in eine Formate umwandeln, die AI-Agenten verstehen können, was zu einer intuitiveren Mensch-Computer-Interaktion führt. Sie können auch ihr Wissen nutzen, um Agenten bei der Planung komplexer Aufgaben zu assistieren, indem sie diese in kleinere, bewältigbare Schritte aufteilen.

-

KI-Agenten als Ausführende und Lernende: KI-Agenten bieten LLMs die Fähigkeit, mit der Welt zu interagieren, Informationen zu sammeln und auf ihre Handlungen反馈 zu erhalten. Diese reale Grundlage kann LLMs dabei helfen, von Erfahrungen zu lernen und ihr Verhalten mit der Zeit zu verbessern.

Diese kraftvolle Synergie treibt die Entwicklung einer neuen Generation von Anwendungen an, die intuitiverer, anpassbarer und kapabler sind als je zuvor. Angesichts der Weiterentwicklung beider KI-Agenten und LLM-Technologien können wir erwarten, dass sich weitere innovative und bedeutsame Anwendungen entwickeln und die Landschaft der Softwareentwicklung und der Mensch-Computer-Interaktion verändern werden.

Reale Beispiele: Veränderung der Branchen

Diese starke Kombination hat bereits Wellen in verschiedenen Sektoren ausgelöst:

-

Kundendienst: Problemlösung mit kontextuellem Bewusstsein

- Beispiel: Stellen Sie sich vor, ein Kunde kontaktiert einen Online-Händler wegen einer verspäteten Lieferung. Ein von einem LLM betriebener KI-Agent kann den Ärger des Kunden verstehen, auf die Bestellhistorie zugreifen, das Paket in Echtzeit verfolgen und proaktiv Lösungen wie beschleunigten Versand oder einen Rabatt auf den nächsten Einkauf anbieten.

-

Inhaltserstellung: Hochwertige Inhalte in großem Maßstab generieren

- Beispiel: Ein Marketingteam kann ein KI-Agent + LLM-System verwenden, um gezielte Social-Media-Beiträge zu generieren, Produktbeschreibungen zu schreiben oder sogar Videoskripte zu erstellen. Das LLM sorgt dafür, dass der Inhalt ansprechend und informativ ist, während der KI-Agent den Veröffentlichungs- und Verteilungsprozess übernimmt.

-

Softwareentwicklung: Beschleunigung der Programmierung und Fehlerdiagnose

- Beispiel: Ein Entwickler kann eine Softwarefunktion, die er erstellen möchte, mithilfe der natürlichen Sprache beschreiben. Die LLM kann dann Codeabschnitte generieren, potenzielle Fehler identifizieren und Verbesserungen vorschlagen, was die Entwicklungsprozesse wesentlich beschleunigen kann.

-

Gesundheitswesen: Individuelle Behandlung und Verbesserung der Patientenpflege

- Beispiel: Ein mit einem LLM ausgestatteter AI-Agent, der auf eine Patientenmedizinische Geschichte zugreifen kann, kann auf ihre gesundheitsbezogenen Fragen antworten, personalisierte Medikamentenhinweise bereitstellen und sogar vorläufige Diagnosen aufgrund ihrer Symptome aussprechen.

-

Recht: Rationalisierung der juristischen Forschung und der Abfassung von Dokumenten

- Beispiel: Ein Anwalt muss einen Vertrag mit bestimmten Klauseln und rechtlichen Präzedenzfällen entwerfen. Ein KI-Agent, der von einem LLM unterstützt wird, kann die Anweisungen des Anwalts analysieren, umfangreiche juristische Datenbanken durchsuchen, relevante Klauseln und Präzedenzfälle identifizieren und sogar Teile des Vertrags entwerfen, was den Zeit- und Arbeitsaufwand erheblich reduziert.

-

Videoerstellung: Mit Leichtigkeit fesselnde Videos erstellen

- Beispiel: Ein Marketing-Team möchte ein kurzes Video erstellen, in dem die Funktionen seines Produkts erklärt werden. Sie können einem KI-Agenten + LLM-System eine Skript-Skizze und visuelle Stilpräferenzen zur Verfügung stellen. Das LLM-System kann dann ein detailliertes Skript erstellen, geeignete Musik und Bildmaterial vorschlagen und das Video sogar bearbeiten, wodurch ein Großteil des Videoerstellungsprozesses automatisiert wird.

-

Architektur: Gebäude mit künstlicher Intelligenz gestalten

- Beispiel: Ein Architekt entwirft ein neues Bürogebäude. Er kann ein KI-Agenten + LLM-System verwenden, um seine Designziele einzugeben, wie z. B. maximales natürliches Licht und optimierte Räumlichkeitsnutzung. Die LLM kann diese Ziele dann analysieren, verschiedene Designoptionen generieren und sogar simulieren, wie das Gebäude unter verschiedenen Umweltbedingungen performen würde.

-

Bau: Verbesserung der Sicherheit und Effizienz auf Baustellen

- Beispiel: Ein KI-Agent, der mit Kameras und Sensoren ausgestattet ist, kann eine Baustelle auf Sicherheitsgefahren überwachen. Wenn ein Arbeiter keine ordnungsgemäße Schutzausrüstung trägt oder ein Gerät in einer gefährlichen Position steht, kann das LLM die Situation analysieren, den Baustellenleiter benachrichtigen und bei Bedarf sogar automatisch die Arbeiten einstellen.

Die Zukunft ist da: Eine neue Ära der Softwareentwicklung

Die Konvergenz von KI-Agenten und LLMs markiert einen bedeutenden Fortschritt in der Softwareentwicklung. Während sich diese Technologien weiterentwickeln, können wir mit noch innovativeren Anwendungen rechnen, die Branchen transformieren, Arbeitsabläufe optimieren und völlig neue Möglichkeiten für die Interaktion zwischen Mensch und Computer schaffen.

KI-Agenten glänzen am meisten in Bereichen, die die Verarbeitung großer Datenmengen, die Automatisierung repetitiver Aufgaben, das Treffen komplexer Entscheidungen und die Bereitstellung personalisierter Erlebnisse erfordern. Indem sie die notwendigen Bedingungen erfüllen und bewährte Verfahren befolgen, können Organisationen das volle Potenzial von KI-Agenten nutzen, um Innovation, Effizienz und Wachstum voranzutreiben.

Kapitel 4: Die philosophische Grundlage von Intelligentensystemen

Die Entwicklung intelligenter Systeme, insbesondere in der künstlichen Intelligenz (KI), erfordert einen gründlichen Verständnis von philosophischen Prinzipien. Dieses Kapitel geht der Ausführung der zentralen philosophischen Ideen, die das Design, die Entwicklung und die Nutzung von KI beeinflussen, näher. Es betont die Bedeutung, dass technologischer Fortschritt mit ethischen Werten in Einklang gebracht wird.

Die philosophische Grundlage von intelligenten Systemen ist nicht nur eine theoretische Übung – sie ist ein lebenswichtiges Framework, das sicherstellt, dass KI-Technologien der Menschheit nutzen. Durch die Förderung von Fairness, Inklusivität und Verbesserung der Lebensqualität leiten diese Prinzipien AI dazu, unsere besten Interessen zu dienen.

Ethische Überlegungen in der KI-Entwicklung

Als KI-Systeme zunehmend in jeden Aspekt des menschlichen Lebens integriert werden, von Gesundheitswesen und Bildung bis hin zu Finanzen und Verwaltung, müssen wir ihre Entwicklung und Anwendung gründlich prüfen und ethische Grundsätze umsetzen.

Das grundlegende ethische Thema dreht sich um, wie KI so konzipiert werden kann, dass menschliche Werte und moralische Prinzipien aufrecht erhalten werden. Diese Frage ist zentral für die Art und Weise, wie KI die Zukunft der Gesellschaften weltweit formen wird.

An der Herzstelle dieser ethischen Diskussion steht das Prinzip der Barmherzigkeit, ein Cornerstone der moralischen Philosophie, der besagt, dass Handlungen auf das Gute und die Verbesserung der Wohlbefinden von Individuen und der gesamten Gesellschaft hinwirken sollten (Floridi & Cowls, 2019).

Im Zusammenhang mit KI besteht das Prinzip der Barmherzigkeit darin, Systeme zu entwerfen, die aktiv zum Wohlergehen der Menschen beitragen – Systeme, die die Gesundheitsergebnisse verbessern, Bildungschancen ergänzen und eine gerechte Wirtschaftsentwicklung fördern.

Allerdings ist die Anwendung von Barmherzigkeit in KI nicht einfach. Es fordert einen subtlen Ansatz, der die potenziellen Vorteile von KI gegenüber den möglichen Risiken und Schäden sorgfältig abwägt.

Eines der Hauptchallenges bei der Anwendung des Prinzips der Barmherzigkeit in der KI-Entwicklung besteht in der Notwendigkeit für einen delikaten Balanceakt zwischen Innovation und Sicherheit.

KI hat das Potenzial, Bereiche wie die Medizin revolutioniert zu werden, wo prädiktive Algorithmen größere Genauigkeit und frühere Diagnosestellung als menschliche Ärzte erreichen können. Allerdings könnten diese selben Technologien bestehende Ungleichheiten verstärken, wenn nicht ein strenges ethisches Overseeing vorhanden ist.

Das könnte beispielsweise dazu führen, dass diese Technologien primär in reichen Regionen eingesetzt werden, währendCommunities weiterhin keinen Zugang zu grundlegendem Gesundheitswesen haben.

Aufgrund dessen ist eine ethische KI-Entwicklung nicht nur darauf beschränkt, die maximale Leistung zu maximieren, sondern auch eine proaktive Herangehensweise an die Risikominimierung. Dies umfasst das Implementieren robuster Schutz Mechanismen, um die Missbrauchsgefahr von AI zu vermeiden und sicherzustellen, dass diese Technologien versehentlich keinen Schaden zufügen.

Das ethische Framework für AI muss auch von Anfang an inklusiv sein, indem sichergestellt wird, dass die Vorteile von AI gleichmäßig across allen gesellschaftlichen Gruppen verteilt werden, einschließlich solcher, die traditionell marginalisiert sind. Dies fordert eine Verpflichtung zu Gerechtigkeit und Fairness, um sicherzustellen, dass AI nicht einfach das Status Quo bestätigt, sondern aktiv an der Auflösung systemischer Ungleichheiten arbeitet.

Beispielsweise hat die von AI getriebene Arbeitsautomatisierung das Potenzial, die Produktivität und Wirtschaftswachstum zu erhöhen. Allerdings könnte dies auch zu einer bedeutenden Arbeitsplatzverlagerung führen, die insbesondere niedrig verdienende Arbeitnehmer betrifft.

Wie Sie sehen können, muss ein ethisch solides AI-Rahmenwerk Strategien für eine gerechte Nutzenverteilung und die Bereitstellung von Unterstützungssystemen für die von AI-Fortschritten beeinträchtigten Personen umfassen.

Die ethische Entwicklung von AI erfordert eine kontinuierliche Beteiligung verschiedener Interessengruppen, einschließlich von Ethikern, Technologen, politischen Entscheidungsträgern und den Gemeinschaften, die am meisten von diesen Technologien betroffen sein werden. Diese interdisziplinäre Zusammenarbeit stellt sicher, dass AI-Systeme nicht in einem Vakuum entwickelt werden, sondern stattdessen von einem breiten Spektrum an Perspektiven und Erfahrungen geprägt werden.

Durch diese gemeinsame Bemühung können wir AI-Systeme schaffen, die nicht nur die unsere menschliche Wesensart widerspiegeln, sondern auch deren Werte aufrecht erhalten – Menschlichkeit, Gerechtigkeit, Respekt für die Autonomie und eine Verpflichtung zum Gemeinwohl.

Die ethischen Überlegungen in der AI-Entwicklung sind nicht nur Richtlinien, sondern grundlegende Elemente, die bestimmen, ob AI eine positive Kraft in der Welt ist. Indem wir AI auf das Prinzip der Barmherzigkeit, Gerechtigkeit und Inklusivität gründen und eine wachsende Herangehensweise an die Balance von Innovation und Risiko pflegen, können wir sicherstellen, dass die AI-Entwicklung nicht nur die Technologie vorwärts bringt, sondern auch das Leben aller Mitglieder der Gesellschaft verbessert.

Während wir die Möglichkeiten von AI weiter erforschen, ist es unerlässlich, dass diese ethischen Überlegungen bei all unseren Bemühungen im Vordergrund stehen, und uns auf einen zukünftigen Weg leiten, der wirklich der Menschheit förderlich ist.

Die Notwendigkeit eines Menschenzentrierten AI-Entwurfs

Der Menschenzentrierte AI-Entwurf ist mehr als nur eine technische Betrachtung. Er ist begründet in tiefgreifenden philosophischen Prinzipien, die die Menschenwürde, die Autonomie und die Handlungskompetenz priorisieren.

Dieser Ansatz der AI-Entwicklung ist grundlegend mit dem kantischen ethischen Rahmenwerks verbunden, das behauptet, dass Menschen als Ziele an sich betrachtet werden müssen und nicht nur als Instrumente zur Erreichung anderer Ziele (Kant, 1785).

Die Auswirkungen dieses Prinzips auf die AI-Entwicklung sind tiefgreifend, und es erfordert, dass AI-Systeme mit einer unerbittlichen Konzentration auf die Dienstleistung für menschliche Interessen entwickelt werden, die Bewahrung der menschlichen Agentur und die Achtung der individuellen Autonomie.

Technische Umsetzung von Menschenzentrierten Prinzipien

Erhöhung der menschlichen Autonomie durch AI: Der Begriff der Autonomie in AI-Systemen ist entscheidend, insbesondere im Hinblick darauf, dass diese Technologien die Benutzer befähigen sollten, anstatt sie zu kontrollieren oder unerlaubte Einfluss auszuüben.

In technischen Begriffen umfasst dies das Design von AI-Systemen, die die Benutzerautonomie priorisieren, indem sie ihnen die notwendigen Werkzeuge und Informationen bereitstellen, um informierte Entscheidungen treffen zu können. Dies erfordert, dass AI-Modelle konztextsensitiv entwickelt werden, d. h., sie müssen verstehen, in welchem konkreten Kontext eine Entscheidung getroffen wird, und ihre Empfehlungen entsprechend anpassen.

Aus Sicht des Systemsdesigns umfasst dies die Integration konztextueller Intelligenz in AI-Modelle, die diesen Systemen erlaubt, dynamisch auf die Benutzereinstellungen, Präferenzen und Bedürfnisse einzugreifen.

Beispielsweise im Gesundheitswesen muss ein AI-System, das Ärzten bei der Diagnose von Zuständen assistiert, die individuelle medizinische Geschichte des Patienten, die aktuellen Symptome und sogar die psychologische Verfassung des Patienten in Betracht ziehen, um Empfehlungen zu offerieren, die die Sachkenntnis der Ärzte unterstützen und nicht ihre Substitution darstellen. Diese kontextuelle Anpassung gewährleistet, dass AI weiterhin ein supportive Werkzeug ist, das die menschliche Autonomie verstärkt und nicht reduziert.

Sicherstellung transparenter Entscheidungsprozesse

: Transparenz in AI-Systemen ist eine grundlegende Voraussetzung dafür, dass Nutzer die Entscheidungen dieser Technologien Vertrauen schenken und verstehen können. Technisch bedeutet dies, dass erklärbare AI (XAI) gefordert ist, was mit der Entwicklung von Algorithmen verbunden ist, die ihre Entscheidungen nachvollziehen können.

Dies ist insbesondere in Bereichen wie Finanzen, Gesundheitswesen und Strafjustiz von erheblicher Bedeutung, da ein unklarartiges Entscheidungsverfahren zu Misstrauen und ethischen Bedenken führen kann.

Die Erklärbarkeit kann durch mehrere technische Ansätze erreicht werden. Ein häufig verwendetes Verfahren ist die post-hoc Interpretierbarkeit, bei der das AI-Modell eine Erklärung nach der Entscheidung erstellt. Dies könnte darin bestehen, die Entscheidung in ihre bestehenden Faktoren aufzusplitten und anzuzeigen, wie jedes einzelne zu dem endgültigen Ergebnis beigetragen hat.

Ein anderer Ansatz sind von Natur aus interpretierbare Modelle, bei denen die Architektur des Modells so gestaltet ist, dass seine Entscheidungen standardmäßig transparent sind. Zum Beispiel sind Modelle wie Entscheidungsbäume und lineare Modelle von Natur aus interpretierbar, weil ihr Entscheidungsprozess leicht zu verfolgen und zu verstehen ist.

Die Herausforderung bei der Implementierung erklärbarer KI besteht darin, Transparenz und Leistung in Einklang zu bringen. Oftmals sind komplexere Modelle, wie tiefe neuronale Netzwerke, weniger interpretierbar, aber genauer. Daher muss das Design von menschenzentrierter KI den Kompromiss zwischen der Interpretierbarkeit des Modells und seiner Vorhersagekraft berücksichtigen, um sicherzustellen, dass Benutzer KI-Entscheidungen vertrauen und verstehen können, ohne die Genauigkeit zu opfern.

Bedeutungsvolle menschliche Aufsicht ermöglichen: Bedeutungsvolle menschliche Aufsicht ist entscheidend, um sicherzustellen, dass KI-Systeme innerhalb ethischer und betrieblicher Grenzen operieren. Diese Aufsicht beinhaltet das Design von KI-Systemen mit Sicherheitsvorkehrungen und Übersteuerungsmechanismen, die es menschlichen Bedienern ermöglichen, bei Bedarf einzugreifen.

Die technische Implementierung der menschlichen Aufsicht kann auf mehrere Weisen angegangen werden.

Ein Ansatz besteht darin, mensch-in-the-loop-Systeme zu integrieren, bei denen die KI-Entscheidungsprozesse kontinuierlich von menschlichen Bedienern überwacht und bewertet werden. Diese Systeme sind so konzipiert, dass menschliches Eingreifen an kritischen Punkten ermöglicht wird, um sicherzustellen, dass die KI nicht autonom in Situationen handelt, in denen ethische Urteile erforderlich sind.

Beispielsweise sind beim autonomen Waffensystem menschliche Überwachungsvorschriften unabdingbar, um zu verhindern, dass das AI von ohne menschliche Einbindung lebens oder tod entscheidet. Dies könnte darin bestehen, strenge operationellen Grenzen zu setzen, die das AI ohne menschliche Autorisierung nicht übersteigen kann, und somit ethische Schutzvorkehrungen in das System einzubinden.

Eine weitere technische Überlegung ist die Entwicklung von Audit-Trails, die Aufzeichnungen aller durch das AI-System getroffenen Entscheidungen und Handlungen sind. Diese Spuren bieten eine transparentierte Verlaufskunde, die von menschlichen Betreibern überprüft werden kann, um die Einhaltung von ethischen Standards zu gewährleisten.

Audit-Trails sind insbesondere in Sektoren wie Finanzen und Recht von Bedeutung, wo Entscheidungen dokumentiert und zu rechtfertigen werden müssen, um die öffentliche Vertrauen aufrechtzuerhalten und die regulatorischen Anforderungen zu erfüllen.

Autonomie und Kontrolle ausgleichen: Ein Haupttechnisches Herausforderungen in menschenzentrierter AI ist der rechte Mischung zwischen Autonomie und Kontrolle zu finden. Obwohl AI-Systeme dafür konzipiert sind, autonom in vielen Szenarien zu agieren, ist es wichtig, dass diese Autonomie die menschliche Kontrolle oder die Überwachung nicht unterminiert.

Dieses Gleichgewicht kann durch die Implementierung von Autonomie-Stufen erreicht werden, die die Grad der Unabhängigkeit des AI bei der Entscheidungsfindung festlegen.

Zum Beispiel in halbautonomen Systemen wie selbstfahrenden Autos reichen Autonomie-Stufen von grundständiger Fahrerassistenz (bei der der menschliche Fahrer vollständig Kontrolle behält) bis zur volle Automatisierung (bei der das AI für alle Fahrtägkeiten verantwortlich ist).

Die Entwicklung solcher Systeme muss sicherstellen, dass der menschliche Operator bei jeder angegebenen Autonomieebene die Fähigkeit behält, einzugreifen und das AI gegebenenfalls zu überschreiben. Dies erfordert komplexe Steuerungsinterfaces und Entscheidungssupportsysteme, die es Menschen ermöglichen, schnell und effektiv den Steuervorgang zu übernehmen.

Zusätzlich ist die Entwicklung von ethischen AI-Frameworks unerlässlich, um die selbständigen Aktionen von AI-Systemen zu lenken. Diese Frameworks sind Sets von Regeln und Leitlinien, die innerhalb des AI eingebettet sind und festlegen, wie es in ethisch komplexen Situationen verhalten soll.

Zum Beispiel in der Gesundheitsfürsorge könnten ethische AI-Frameworks Regeln beinhalten wie Patientenconsens, Privatsphäre und die Priorisierung von Behandlungen aufgrund medizinischer Bedürfnisse anstatt finanzieller Überlegungen.

Indem diese ethischen Prinzipien direkt in die Entscheidungsprozesse des AI eingebettet werden, können Entwickler sicherstellen, dass die Autonomie des Systems in Übereinstimmung mit menschlichen Werten ausgeübt wird.

Die Integration menschentricher Prinzipien in die AI-Design ist nicht nur eine philosophische Idealisierung, sondern eine technische Notwendigkeit. Durch die Verstärkung der menschlichen Autonomie, die Transparenz gewährleisten, die sinnvolle Überwachung ermöglichen und die Autonomie mit Kontrolle sorgfältig ausbalancieren, können AI-Systeme entwickelt werden, die wirklich der Menschheit dienen.

Diese technischen Überlegungen sind für die Schaffung von AI unerlässlich, die nicht nur die menschlichen Fähigkeiten verstärken, sondern auch die Grundwerte respektieren und aufrechterhalten, die unserer Gesellschaft grundlegend sind.

Angesichts der weiteren Entwicklung von AI bleibt die Verpflichtung zur menschlichen Zentrierung im Design eine entscheidende Voraussetzung für die Gewährleistung, dass diese potentiell mächtigen Technologien ethisch und verantwortungsvoll verwendet werden.

Wie man sicherstellt, dass KI der Menschheit zugute kommt: Verbesserung der Lebensqualität

Bei der Entwicklung von KI-Systemen ist es entscheidend, Ihre Bemühungen in den ethischen Rahmen des Utilitarismus einzubetten – eine Philosophie, die die Steigerung des allgemeinen Glücks und Wohlbefindens betont.

In diesem Kontext hat KI das Potenzial, kritische gesellschaftliche Herausforderungen anzugehen, insbesondere in Bereichen wie Gesundheitswesen, Bildung und Umweltverträglichkeit.

Das Ziel ist es, Technologien zu schaffen, die die Lebensqualität für alle erheblich verbessern. Doch diese Bestrebung ist mit Komplexitäten verbunden. Der Utilitarismus bietet einen überzeugenden Grund, KI weitreichend einzusetzen, bringt jedoch auch wichtige ethische Fragen darüber auf, wer davon profitiert und wer möglicherweise zurückgelassen wird, insbesondere unter den verletzlichen Bevölkerungsgruppen.

Um diese Herausforderungen zu meistern, benötigen wir einen ausgeklügelten, technisch fundierten Ansatz – einen, der das breite Streben nach gesellschaftlichem Wohl mit der Notwendigkeit von Gerechtigkeit und Fairness in Einklang bringt.

Bei der Anwendung utilitaristischer Prinzipien auf KI sollte Ihr Fokus darauf liegen, Ergebnisse in spezifischen Bereichen zu optimieren. Im Gesundheitswesen zum Beispiel haben KI-gesteuerte Diagnosetools das Potenzial, Patientenergebnisse erheblich zu verbessern, indem sie frühere und genauere Diagnosen ermöglichen. Diese Systeme können umfangreiche Datensätze analysieren, um Muster zu erkennen, die menschlichen Praktikern entgehen könnten, und somit den Zugang zu qualitativ hochwertiger Versorgung, insbesondere in unterversorgten Gebieten, erweitern.

jedoch bedarf die Implementierung dieser Technologien einer sorgfältigen Überlegung, um bestehende Ungleichheiten nicht zu verstärken. Die Daten, die zur Trainingszeit von AI-Modellen verwendet werden, können zwischen Regionen hin und her stark variieren, was die Genauigkeit und Verlässlichkeit dieser Systeme beeinträchtigt.

Diese Diskrepanz betont die Bedeutung der Festlegung robuster Datenverwaltungssysteme, die sicherstellen, dass Ihre AI-gesteuerte Gesundheitslösungen sowohl repräsentativ als auch Fair sind.

Im Bildungsbereich verspricht AI die Persönlichkeitsanpassung des Lernens. AI-Systeme können pädagogisches Material an die spezifischen Bedürfnisse von einzelnen Schülern anpassen, wodurch die Lernergebnisse verbessert werden. Durch die Analyse von Daten zu Schülerleistungen und Verhaltens kann AI erkennen, wo ein Schüler möglicherweise Schwierigkeiten hat und zielgerichtete Unterstützung bereitstellen.

Während Sie diese Vorteile erreichen, ist es unerlässlich, die Risiken zu beachten – wie z.B. die potenzielle Verstärkung von Vorurteilen oder die Marginalisierung von Schülern, die nicht typischen Lernmustern entsprechen.

Die Minderung dieser Risiken erfordert die Integration von Fairness-Mechanismen in AI-Modelle, die keineswegs versehentlich bestimmte Gruppen begünstigen sollten. Und die Aufrechterhaltung der Rolle von Pädagogen ist kritisch. Ihr Urteil und ihre Erfahrung sind unerlässlich, um AI-Tools wirklich effektiv und unterstützend zu machen.

Hinsichtlich der Umweltverträglichkeit besitzt AI erhebliches Potenzial. AI-Systeme können Ressourcennutzung optimieren, Umweltänderungen überwachen und die Auswirkungen des Klimawandels mit bisher unerreichter Präzision vorhersagen.

Beispielsweise kann AI umfangreiche Umweltdaten analysieren, um Wettermuster vorherzusagen, Energieverbrauch optimiert und Abfälle reduziert – Aktionen, die zum Wohlbefinden der aktuellen und künftigen Generationen beitragen.

Diese technologische Entwicklung bringt jedoch ihre eigenen Herausforderungen, insbesondere was die Umweltauswirkungen der AI-Systeme selbst angeht.

Der für den Betrieb großskaliger AI-Systeme notwendige Energieverbrauch kann die erhofften umweltpolitischen Vorteile ausgleichen. Daher ist es wichtig, Energiesparende AI-Systeme zu entwickeln, um sicherzustellen, dass ihre positive Auswirkung auf die Nachhaltigkeit nicht unterminiert wird.

Wenn Sie AI-Systeme mit utilitaristischen Zielen entwickeln, ist es auch wichtig, die Implikationen für die soziale Gerechtigkeit zu berücksichtigen. Utilitarismus konzentriert sich auf die maximale Glückseligkeit, betrachtet aber nicht unbedingt die Verteilung von Vorteilen und Schaden auf verschiedene gesellschaftliche Gruppen.

Dies lässt die Möglichkeit aufkommen, dass AI-Systeme disproportional Vorteile für die bereits privilegierten ausüben, während benachteiligte Gruppen wenig bis gar keine Verbesserung in ihren Umständen erfahren könnten.

Um dies zu kompensieren, sollten Sie Ihren AI-Entwicklungsprozess mit fokussierten Prinzipien für Gleichheit ergänzen, sicherstellen, dass Vorteile fair verteilt werden und dass mögliche Schäden behandelt werden. Dies könnte darin bestehen, Algorithmen zu entwerfen, die speziell dazu gedacht sind, Bias zu reduzieren und eine vielfältige Palette an Perspektiven in den Entwicklungsprozess einzubinden.

Während du daran arbeitest, AI-Systeme zu entwickeln, die das Leben verbessern sollen, ist es wichtig, den utilitaristischen Ziel des Maximieren des Wohlergehens mit der Notwendigkeit für Gerechtigkeit und Fairness in Balance zu halten. Dies erfordert einen subtileren, technisch fundierten Ansatz, der die breiteren Implikationen der AI-Einsatz erörtert.

Durch sorgfältige Design von AI-Systemen, die sowohl effektiv als auch gleichwertig sind, kannst du zu einer Zukunft beitragen, in der technologische Fortschritte wirklich den verschiedenen Bedürfnissen der Gesellschaft dienen.

Schütze vor möglichem Schaden

Bei der Entwicklung von AI-Technologien musst du die grundlegende Gefahr von Schaden erkennen und aktiv starke Schutzvorkehrungen einrichten, um diese Risiken zu reduzieren. Diese Verantwortung ist tief in deontologischer Ethik verwurzelt. Dieser ethischen Richtung geht es um die moralische Pflicht, sich an geltende Regeln und ethische Standards zu halten, um sicherzustellen, dass die von dir geschaffene Technologie mit grundlegenden moralischen Prinzipien aligniert ist.

Das Einführen stringenter Sicherheitsprotokolle ist nicht nur eine Vorsichtsmaßnahme, sondern eine moralische Verpflichtung. Diese Protokolle sollten umfassende Vorhersage von Bias, Transparenz in den algorithmischen Prozessen und klare Mechanismen für Rechenschaftslegung gehen.

Solche Schutzvorkehrungen sind unerlässlich, um zu verhindern, dass AI-Systeme versehentlich Schaden anrichten, durch biassierte Entscheidungen, unzugängliche Prozesse oder mangelnde Überwachung.

In der Praxis erfordert die Implementierung dieser Schutzvorkehrungen ein tiefes Verständnis sowohl der technischen als auch der ethischen Aspekte von AI.

Vorhersageprüfungen beinhalten nicht nur die Identifizierung und Korrektur von Vorhersagefehlern in Daten und Algorithmen, sondern auch das Verständnis der allgemeinen gesellschaftlichen Auswirkungen dieser Fehler. Sie müssen sicherstellen, dass Ihre AI-Modelle auf vielfältigen, repräsentativen Datensätzen trainiert werden und regelmäßig überprüft werden, um festzustellen und Fehler zu korrigieren, die mit der Zeit auftreten könnten.

Transparenz fordert andererseits, dass AI-Systeme so konzipiert werden, dass ihre Entscheidungsprozesse von Benutzern und Interessengruppen leicht verstanden und überprüft werden können. Dies umfasst die Entwicklung von erklärbaren AI-Modellen, die klare, interpretierbare Ausgaben liefern, die Benutzer zugänglich machen, wie Entscheidungen getroffen werden und sicherstellen, dass diese Entscheidungen gerechtfertigt und faire sind.

Außerdem sind Mechanismen zur Verantwortlichkeitsabwicklung für den Erhalt des Vertrauens und die Gewährleistung, dass AI-Systeme verantwortungsvoll genutzt werden, von größter Bedeutung. Diese Mechanismen sollten klare Richtlinien beinhalten, wer für die Ergebnisse von AI-Entscheidungen verantwortlich ist, sowie Prozesse für die Behandlung und Korrektur von Schäden, die auftreten könnten.

Sie müssen ein System etablieren, in dem ethische Überlegungen in jedem Entwicklungsstadium von AI integriert werden, von der initialen Designphase bis hin zu Implementierung und darüber hinaus. Dies umfasst nicht nur die Befolgung ethischer Richtlinien, sondern auch die ständige Überwachung und Anpassung von AI-Systemen, während sie mit der realen Welt interagieren.

Indem Sie diese Schutzvorkehrungen in die Substanz der AI-Entwicklung integrieren, können Sie helfen, sicherzustellen, dass der technologische Fortschritt dem größeren Guten dient und nicht zu unerwünschten negativen Konsequenzen führt.

Die Rolle von menschlicher Überwachung und Rückkopplungsmustern

Menschliche Aufsicht in AI-Systemen ist ein kritischer Bestandteil zur Gewährleistung einer ethischen AI-Einsatz. Der Grundsatz der Verantwortung stützt den Bedarf an kontinuierlicher menschlicher Beteiligung in der Operation von AI, insbesondere in high-stakes Umfeldern wie dem Gesundheitswesen und der Strafjustiz.

Feedback-Schleifen, in denen menschlicher Input verwendet wird, um AI-Systeme zu verfeinern und zu verbessern, sind entscheidend für die Aufrechterhaltung von Verantwortbarkeit und Anpassbarkeit (Raji et al., 2020). Diese Schleifen ermöglichen die Korrektur von Fehlern und die Integration neuer ethischer Überlegungen, während sich gesellschaftliche Werte weiterentwickeln.

Durch die Integration von menschlicher Aufsicht in AI-Systeme können Entwickler Technologien schaffen, die nicht nur effektiv sondern auch ethischen Normen und menschlichen Erwartungen entsprechen.

Ethikprogrammierung: Philosophische Prinzipien in AI-Systeme übersetzen

Die Übersetzung von philosophischen Prinzipien in AI-Systeme ist eine komplizierte, aber notwendige Aufgabe. Dieser Prozess umfasst das Einbetten ethischer Überlegungen in den Code, der die AI-Algorithmen treibt.

Begriffe wie Fairness, Gerechtigkeit und Selbstbestimmtheit müssen innerhalb von AI-Systemen kodiert werden, um sicherzustellen, dass sie auf Weise agieren, die die gesellschaftlichen Werte widerspiegeln. Dies erfordert eine interdisziplinäre Herangehensweise, in der Ethiker, Ingenieure und Sozialwissenschaftler zusammenarbeiten, um ethische Leitlinien in den Codeprozess einzubringen.

Das Ziel ist es, AI-Systeme zu schaffen, die nicht nur technisch kompetent sondern auch moralisch solide sind und Entscheidungen treffen, die die Menschenwürde respektieren und den sozialen Guten fördern (Mittelstadt et al., 2016).

Fördere Inklusivität und gleichberechtigten Zugang in der AI-Entwicklung und -Einsatz.

Inklusivität und gleichberechtigter Zugang sind grundlegend für die ethische Entwicklung von AI. Das Rawlsianische Konzept der Gerechtigkeit als Fairness bietet eine philosophische Grundlage dafür, dass AI-Systeme auf eine Art und Weise entwickelt und eingesetzt werden, die allen Mitgliedern der Gesellschaft nützt, insbesondere den am stärksten gefährdeten Personen (Rawls, 1971).

Dazu gehört, aktiv Anstrengungen zu unternehmen, um eine Vielfalt von Perspektiven in den Entwicklungsprozess aufzunehmen, insbesondere aus unterrepräsentierten Gruppen und dem Globalen Süden.

Durch die Integration dieser unterschiedlichen Ansichten können AI-Entwickler Systeme schaffen, die gerechter und auf die Bedürfnisse eines breiteren Nutzerspektrums reagieren. Außerdem ist die Gewährleistung eines gleichberechtigten Zugangs zu AI-Technologien für die Verhütung der Verstärkung bestehender sozialer Ungleichheiten von größter Bedeutung.

Beeinflussen Sie Algorithmusbias und Fairness

Algorithmusbias ist eine bedeutende ethische Angelegenheit in der AI-Entwicklung, da baisierte Algorithmen die sozialen Ungleichheiten verstärken und sogar verschärfen können. Um mit diesem Thema aufzukommen, ist ein Engagement für prozessuale Gerechtigkeit erforderlich, d.h. AI-Systeme müssen über faire Prozesse entwickelt werden, die die Auswirkungen auf alle Interessengruppen berücksichtigen (Nissenbaum, 2001).

Dies umfasst das Identifizieren und abmildern von Bias in Trainingsdaten, die Entwicklung von transparenten und erklärbaren Algorithmen und die Durchführung von Fairnessprüfungen während der gesamten AI-Lebensdauer.

Durch die Behandlung von Algorithmusbias können Entwickler AI-Systeme schaffen, die zu einer gerechteren und inklusiveren Gesellschaft beitragen, anstatt bestehende Unterschiede zu verstärken.

Integrieren Sie vielfältige Perspektiven in die AI-Entwicklung

Die Einbeziehung verschiedener Perspektiven in die Entwicklung vonKI ist unerlässlich für die Schaffung von Systemen, die inklusiv und gleichwertig sind. Die Beteiligung von Stimmen aus unterrepräsentierten Gruppen gewährleistet, dass KI-Technologien nicht nur die Werte und Prioritäten eines kleinen Teils der Gesellschaft widerspiegeln.

Dieser Ansatz entspricht dem philosophischen Grundsatz der deliberativen Demokratie, der die Bedeutung inklusiver und partizipatorischer Entscheidungsprozesse betont (Habermas, 1996).

Durch die Förderung der vielfältigen Beteiligung in der KI-Entwicklung können wir sicherstellen, dass diese Technologien zu den Interessen aller Menschheit entwickelt werden, anstatt nur für eine privilegierte Elite.

Strategien zur Überbrückung der KI-Kluft

Die KI-Kluft, charakterisiert durch ungleichen Zugang zu KI-Technologien und ihren Vorteilen, stellt eine bedeutende Herausforderung an die globale Gleichwertigkeit dar. Die Überbrückung dieser Kluft erfordert eine Verpflichtung zur verteilten Gerechtigkeit, indem sichergestellt wird, dass die Vorteile von KI breit across verschiedene sozioökonomischen Gruppen und Regionen verbreitet werden (Sen, 2009).

Dies kann durch Initiativen erreicht werden, die den Zugang zu KI-Bildung und Ressourcen in unterversorgten Gemeinschaften fördern, sowie durch Politiken, die die gerechte Verteilung der durch KI驱动ökonomischen Gewinne unterstützen. Indem die KI-Kluft behandelt wird, kann sichergestellt werden, dass KI zur globalen Entwicklung beiträgt, die inklusiv und gleichwertig ist.

Innovation mit ethischen Beschränkungen im Gleichgewicht halten

Das Gleichgewicht zwischen der Jagd nach Innovation und ethischen Beschränkungen ist für die verantwortungsvolle Fortentwicklung von AI entscheidend. Der Vorsorgegrundsatz, der für Vorsicht in der Anwendung ungewisser Informationen plädiert, ist im Zusammenhang mit der AI-Entwicklung besonders relevant (Sandin, 1999).

Während Innovation die Fortschritte treibt, muss sie durch ethische Überlegungen begleitet werden, die Schutz vor potenziellen Schäden bieten. Dies erfordert eine sorgfältige Bewertung der Risiken und Vorteile der neuen AI-Technologien sowie die Implementierung von Regelungssystemen, die die Ethikkriterien gewährleisten.

Durch die Ausgewogenheit von Innovation und ethischen Beschränkungen können wir die Entwicklung von AI-Technologien fördern, die sowohl an der Spitze der Technologie stehen als auch mit den allgemeinen Zielen des gesellschaftlichen Wohlstands in Einklang stehen.

Wie Sie sehen können, stellt die philosophische Grundlage intelligenter Systeme einen entscheidenden Rahmen dar, um sicherzustellen, dass AI-Technologien auf eine ethische, inklusive und für die gesamte Menschheit nutzbare Weise entwickelt und eingesetzt werden.

Indem die AI-Entwicklung auf diese philosophischen Prinzipien gegründet wird, können wir intelligente Systeme schaffen, die nicht nur die technologischen Kapazitäten fördern, sondern auch das Lebensqualitätsverständnis verbessern, Gerechtigkeit fördern und sicherstellen, dass die Vorteile von AI gleichmäßig durch die Gesellschaft geteilt werden.

Kapitel 5: AI-Agenten als LLM-Verstärker

Die Fusion von AI-Agenten mit Großen Sprachmodellen (LLM) stellt einen grundlegenden Wechsel in der artifizellen Intelligenz dar und behebt kritische Einschränkungen in LLM, die ihre breitere Anwendbarkeit behindert haben.

Diese Integration ermöglicht es Maschinen, ihre traditionellen Rollen zu überschreiten und von passiven Textgeneratoren zu selbständigen Systemen zu werden, die dynamisches Denken und Entscheiden können.

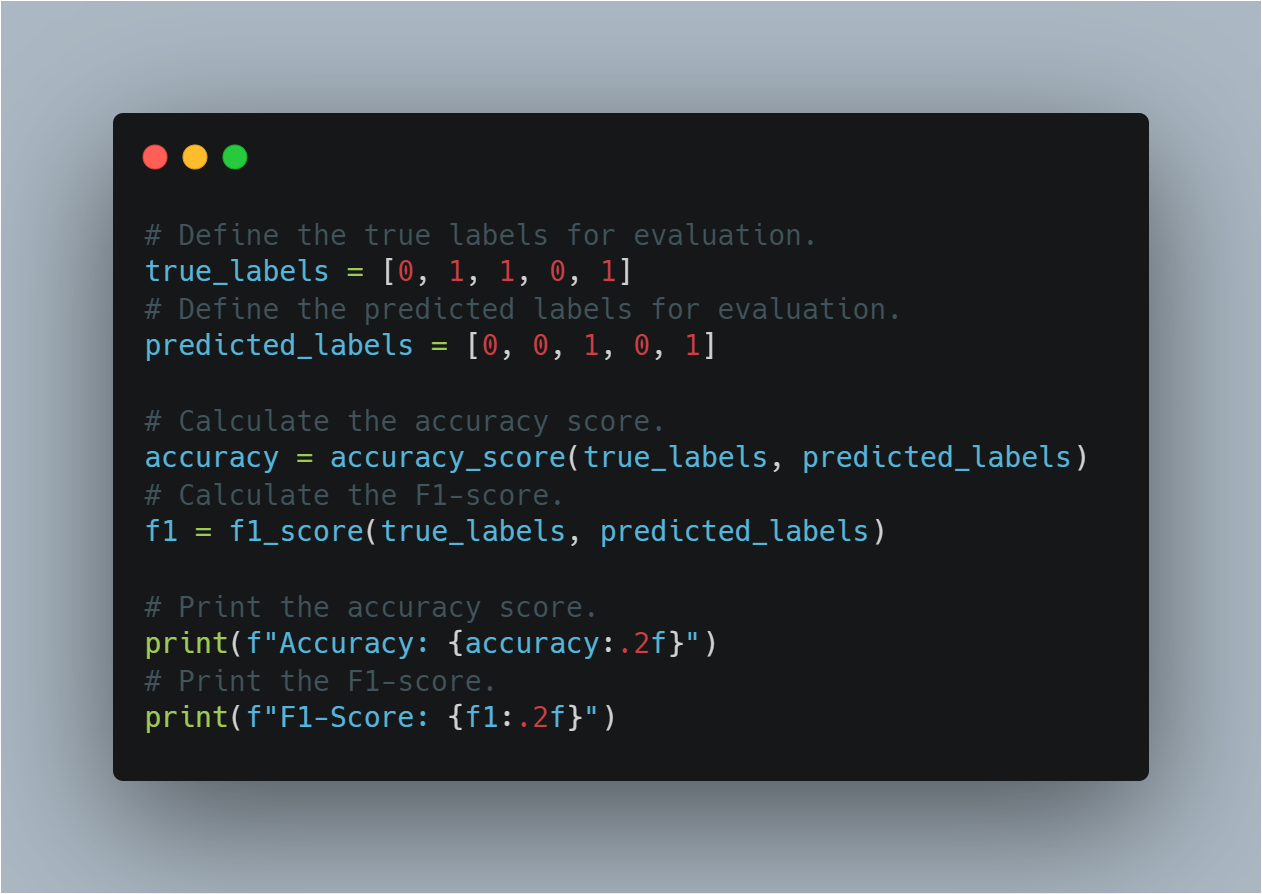

Angesichts der zunehmenden Beteiligung von AI-Systemen an kritischen Prozessen in verschiedenen Bereichen ist es wichtig, zu verstehen, wie AI-Agenten die Lücken in den Fähigkeiten von LLM schließen.

Die Überbrückung der Lücken in den Fähigkeiten von LLM

LLM sind zwar mächtig, sind aber von ihrer Natur her durch die Daten begrenzt, die sie trainiert wurden und durch die statische Natur ihrer Architektur. Diese Modelle arbeiten innerhalb eines festen Satzes von Parametern, typischerweise definiert durch den Textkorpus, der während ihrer Trainingsphase verwendet wurde.

Diese Einschränkung bedeutet, dass LLM nicht selbständig neue Informationen suchen oder ihre Wissensbasis aktualisieren können, nachdem sie ausgebildet wurden. Folglich sind LLM oft veraltet und fehlen den Fähigkeiten, um kontextuell relevante Antworten zu liefern, die realtime Daten oder Einblicke benötigen, die über ihre ursprüngliche Trainingsdaten hinausgehen.

KI-Agenten schließen diese Lücken, indem sie dynamisch externe Datenquellen integrieren, was die funktionale Horizont von LLM vergrößern kann.

Zum Beispiel könnte eine bis 2022 auf finanziellen Daten trainierte LLM genaue historische Analysen liefern, aber Schwierigkeiten haben, aktuelle Marktprognosen zu generieren. Ein KI-Agent kann diese LLM durch die Einbindung von Echtzeitdaten aus den Finanzmärkten verstärken, indem er diese Eingaben verwendet, um relevantere und aktuelle Analysen zu erstellen.

Diese dynamische Integration gewährleistet, dass die Ausgaben nicht nur historisch korrekt sind, sondern auch für die aktuellen Bedingungen konztextuell angemessen.

Erhöhung der Entscheidungsfähigkeit beim Entscheidungsprozess

Eine weitere bedeutende Einschränkung von LLM ist ihre mangelnde Fähigkeit, selbständig zu entscheiden. LLM sind hervorragend in der Generierung von Sprachbasierten Ausgaben, aber sie fallen kurz beim erforderlichen komplexen Entscheidungsprozess, insbesondere in Umfeldern, die von Unsicherheit und Veränderung gekennzeichnet sind.

Dieser Mangel ist primär auf die Abhängigkeit des Modells von vorhandenen Daten und das Fehlen von Mechanismen für adaptives Denken oder Lernen aus neuen Erfahrungen nach der Inbetriebnahme zurückzuführen.

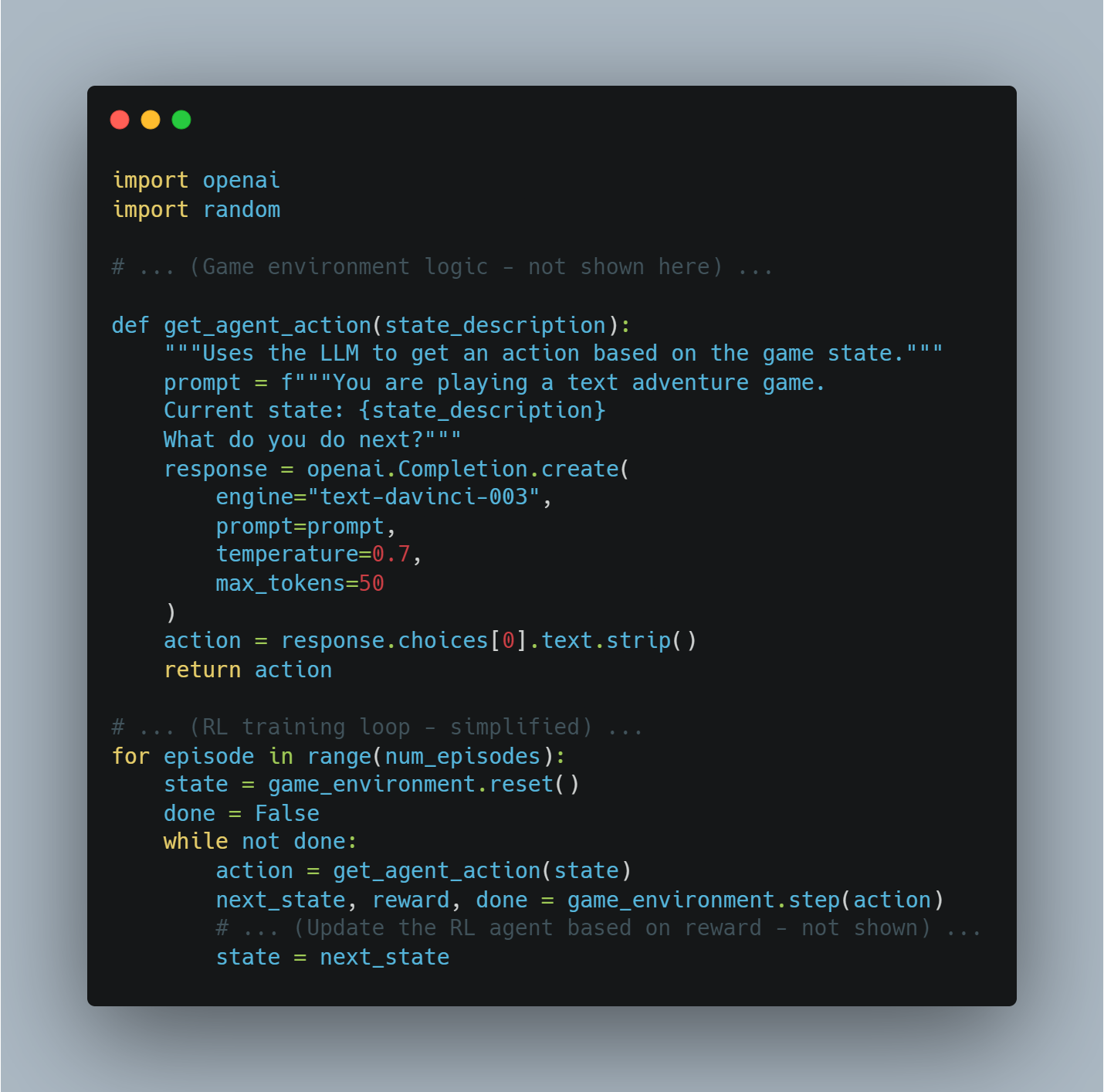

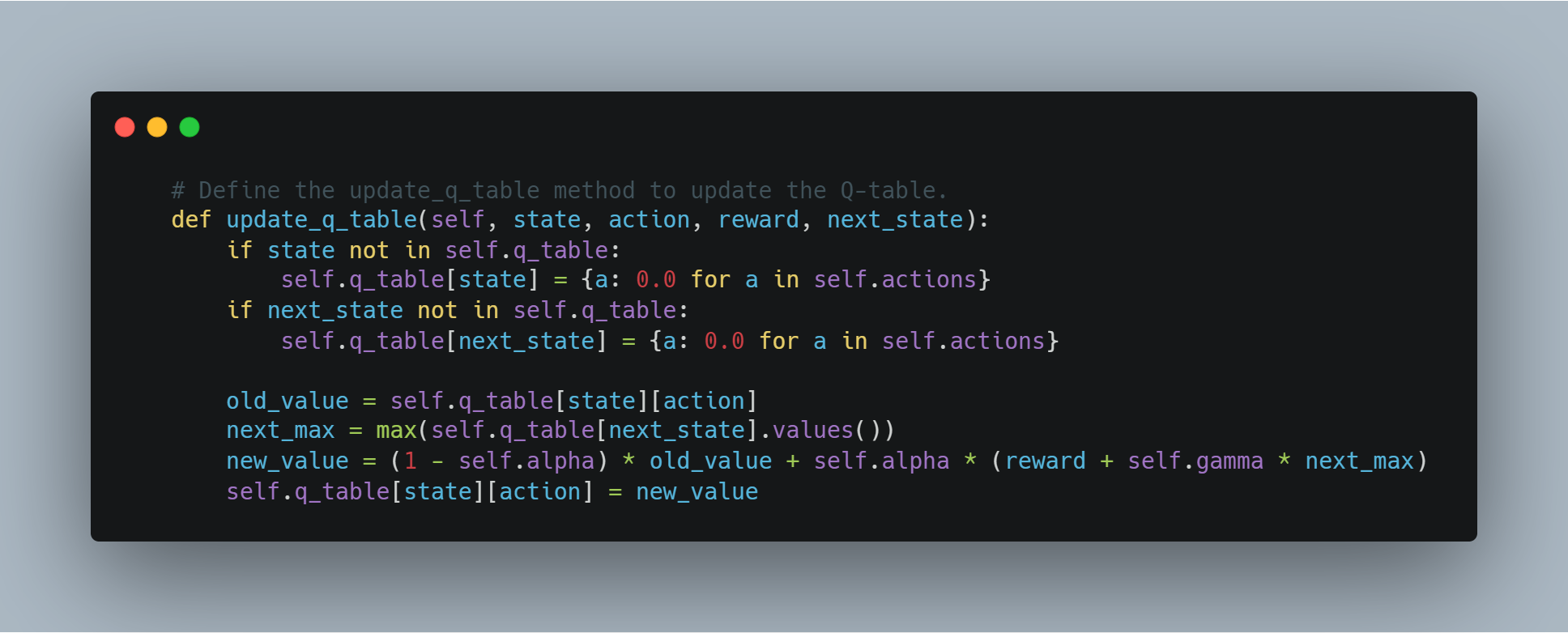

KI-Agenten beheben dies, indem sie die notwendige Infrastruktur für selbständiges Entscheidungsfinden bereitstellen. Sie können die statischen Ausgaben eines LLM verarbeiten und diese durch fortschrittliche Denkframeworks wie regelbasierte Systeme, Heuristiken oder Verstärkungs-Lernmodelle bearbeiten.

Beispielsweise kann eine LLM in einem Gesundheitswesen aufgrund von Symptomen und medizinischer Geschichte eines Patienten eine Liste von möglichen Diagnosen erzeugen. Ohne einen KI-Agenten kann die LLM diese Optionen jedoch nicht bewerten oder einen Handlungsweg empfehlen.

Ein KI-Agent kann einsteigen, um diese Diagnosen mit aktueller medizinischer Literatur, Patientendaten und kontextuellen Faktoren abgleichen, schließlich eine informiertere Entscheidung treffen und handhabbare nächste Schritte vorschlagen. Diese Synergie wandelt LLM-Ausgaben von reinen Vorschlägen in ausführbare, konztextabhängige Entscheidungen um.

Beschränktheit und Konsistenz behandeln

Vollständigkeit und Konsistenz sind entscheidende Faktoren zur Gewährleistung der Zuverlässigkeit von LLM-Ausgaben, insbesondere bei komplexen Denkaufgaben. Aufgrund ihrer Parametrisierung erzeugen LLMs oft Antworten, die unvollständig sind oder keine logische Kohärenz aufweisen, insbesondere beim Umgang mit mehreren Schritten oder der Verlangen nach umfassendem Verständnis across verschiedenen Bereichen.

Diese Probleme entstammen der isolierten Umgebung, in der LLMs arbeiten, wo sie nicht in der Lage sind, ihre Ausgaben gegen externe Standarde oder zusätzliche Informationen abzurechnen oder zu validieren.

AI-Agenturen spielen eine Schlüsselrolle in der Eindämmung dieser Probleme, indem sie iterative Feedback-Mechanismen und Validierungs-Schichten einführen.

Beispielsweise könnte ein LLM im Rechtsbereich eine erste Fassung eines rechtlichen Memorandums auf der Basis seiner Trainingsdaten erzeugen. Dieser Entwurf könnte jedoch bestimmte Vorgängerfälle auslassen oder argumentative Logik fehlen lassen.

Ein AI-Agent kann diesen Entwurf überprüfen, indem er sicherstellt, dass er die erforderlichen Standards an Vollständigkeit erfüllt, indem er auf externe rechtliche Datenbanken verweist, logische Kohärenz prüft und gegebenenfalls zusätzliche Informationen oder Klärung anfordert.

Dieser iterative Prozess ermöglicht die Herstellung eines fundierteren und zuverlässigeren Dokuments, das den strengen Anforderungen der rechtlichen Praxis gerecht wird.

Überwindung der Isolation durch Integration

Eine der größten Begrenzungen von LLM ist ihre innere Isolation von anderen Systemen und Wissensquellen.

LLM, wie sie konzipiert sind, sind geschlossene Systeme, die nicht von Haus aus mit externen Umgebungen oder Datenbanken interagieren. Diese Isolation begrenzt deutlich ihre Fähigkeit, sich an neue Informationen anzupassen oder in Echtzeit zu agieren, was sie weniger effektiv für Anwendungen macht, die dynamische Interaktion oder Echtzeitentscheidungen erfordern.

AI-Agenten überwinden diese Isolation, indem sie als integrierende Plattformen agieren, die LLM mit einem breiteren Ökosystem von Datenquellen und Berechnungswerkzeugen verknüpfen. Durch APIs und andere Integrationsoberflächen können AI-Agenten auf Echtzeitdaten zugreifen, mit anderen AI-Systemen zusammenarbeiten und sogar mit physischen Geräten interagieren.

In Kundenbindungsanwendungen könnten LLM standarde Musterantworten basierend auf vorbereiteten Skripten generieren. Diese Antworten können jedoch statisch sein und die Personalisierung vermissen, die für eine effektive Kundeninteraktion notwendig ist.

Ein KI-Agent kann diese Interaktionen durch die Integration von Echtzeitdaten aus Kundenprofilen, vorherigen Interaktionen und Sentiment-Analysetools anreichern, was hilft, Antworten zu generieren, die nicht nur kontextuell relevant sind, sondern auch auf die spezifischen Bedürfnisse des Kunden zugeschnitten sind.

Diese Integration verwandelt die Kundenerfahrung aus einer Reihe von skriptierten Interaktionen in eine dynamische, personalisierte Unterhaltung.

Erweiterung von Kreativität und Problemlösung

Obwohl LLMs leistungsfähige Werkzeuge für die Inhaltsgenerierung sind, sind ihre Kreativität und Problemlösefähigkeiten von dem Daten, auf denen sie trainiert wurden, begrenzt. Diese Modelle sind oft nicht in der Lage, theoretische Konzepte auf neue oder unerwartete Herausforderungen anzuwenden, da ihre Problemlösefähigkeiten durch ihre vorherige Wissensbasis und Trainingsparameter eingeschränkt sind.

KI-Agenten erhöhen die kreative und problemlösende Potenzial von LLMs durch die Nutzung fortschrittlicher Schließtechniken und eines breiteren Spektrums an Analysetools. Diese Fähigkeit ermöglicht es KI-Agenten, die Grenzen von LLMs zu überwinden und theoretische Rahmenwerke auf praktische Probleme in innovativer Weise anzuwenden.

Zum Beispiel denkt man an das Problem der Bekämpfung von Fehlinformationen auf sozialen Medienplattformen. Ein LLM könnte anhand von textueller Analyse Muster von Fehlinformationen identifizieren, könnte jedoch Schwierigkeiten haben, eine umfassende Strategie für die Reduzierung der Verbreitung falscher Informationen zu entwickeln.

Ein AI-Agent kann diese Einsichten aufnehmen, interdisziplinäre Theorien aus Bereichen wie Soziologie, Psychologie und Netzwerktheorie anwenden und eine robuste, vielseitige Herangehensweise entwickeln, die Real-Time-Monitoring, Nutzererziehung und automatisierte Moderationstechniken umfasst.