A extração de características em aprendizado de máquina transforma dados brutos em um conjunto de características significativas, capturando informações essenciais e reduzindo a redundância. Pode envolver técnicas de redução de dimensionalidade e métodos que criam novas características a partir de dados existentes.

Imagine que você está tentando identificar frutas em um mercado. Enquanto poderia considerar incontáveis atributos (peso, cor, textura, forma, cheiro, etc.), você pode perceber que apenas algumas características-chave como cor e tamanho são suficientes para distinguir entre maçãs e laranjas. Isso é exatamente o que a extração de características faz. Ela ajuda a focar nas características mais informativas dos seus dados.

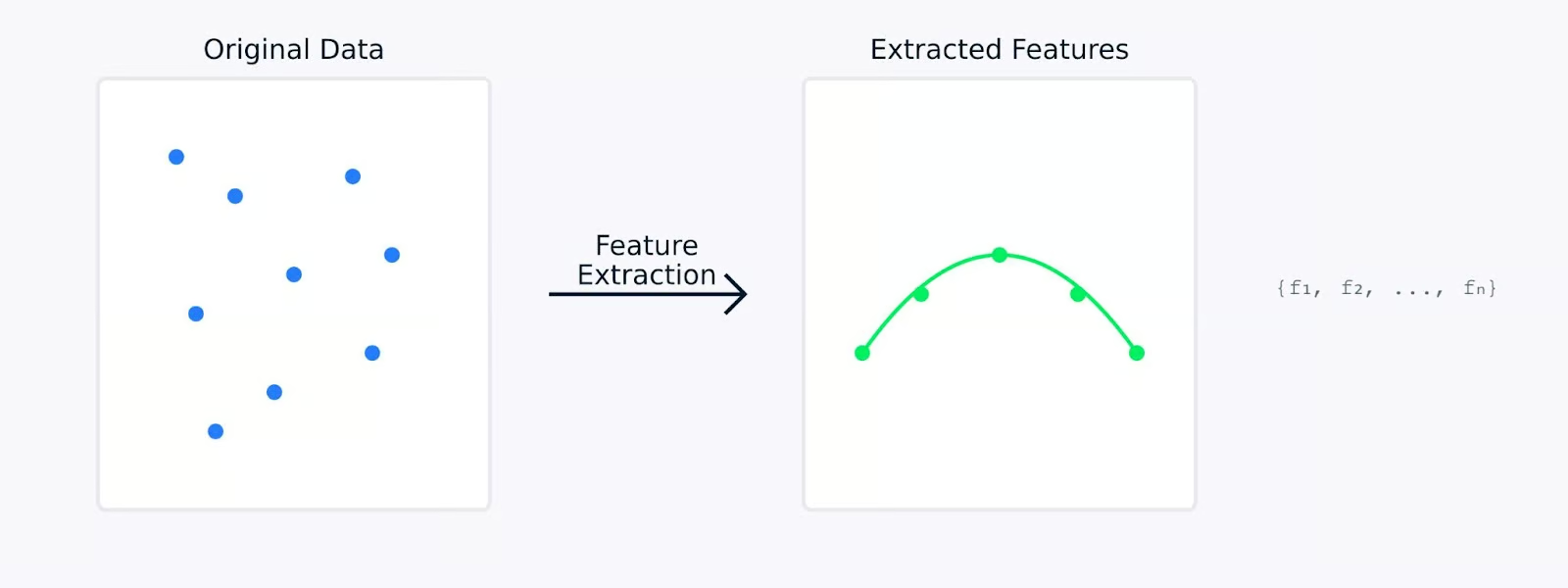

Ao realizar a extração de características, os dados originais são matematicamente transformados em um novo conjunto de características. Essas novas características são projetadas para capturar os aspectos mais importantes dos dados, potencialmente reduzindo sua complexidade. As características extraídas frequentemente representam padrões ou estruturas subjacentes que podem não ser imediatamente aparentes nos dados originais.

Extração de Características

Nas próximas seções, exploraremos por que a extração de características é tão importante em aprendizado de máquina e veremos diversos métodos para extrair características de diferentes tipos de dados, juntamente com seus códigos. Se você deseja alguns exemplos práticos, confira nosso curso de Redução de Dimensionalidade em Python, que possui um capítulo dedicado à extração de características.

Por que a Extração de Características é importante em Aprendizado de Máquina?

A extração de características desempenha um papel importante em aprendizado de máquina. Pode fazer a diferença entre um modelo que falha e um que tem sucesso. Vamos ver por que isso é tão fundamental para a construção de modelos de aprendizado de máquina eficazes.

Melhorando a precisão e eficiência do modelo

Ao trabalhar com dados brutos, aprendizado de máquina frequentemente tem dificuldade em distinguir entre padrões significativos e ruído. A extração de características serve como uma etapa de pré-processamento de dados que pode melhorar significativamente a capacidade de aprendizado e desempenho de seus modelos.

Desempenho do Modelo versus Tempo de Treinamento

Por exemplo, quando um modelo atinge 85% de precisão com dados brutos, o mesmo modelo pode alcançar 95% de precisão quando treinado em características cuidadosamente extraídas. Essa melhoria não vem da mudança do modelo, mas sim de fornecer a ele dados de entrada de melhor qualidade dos quais aprender.

Gerenciando conjuntos de dados de alta dimensão

Os conjuntos de dados modernos frequentemente vêm com centenas ou milhares de características. Isso traz vários desafios que a extração de características ajuda a abordar.

- A maldição da dimensionalidade: À medida que o número de features aumenta, os dados se tornam cada vez mais esparsos no espaço de features. Isso torna mais difícil para os modelos encontrar padrões significativos. A extração de features cria uma representação mais compacta que preserva relacionamentos importantes ao mesmo tempo em que reduz a dimensionalidade.

- Alto uso de memória: Dados de alta dimensionalidade exigem mais armazenamento e memória durante o processamento. Ao extrair apenas as features mais relevantes, podemos reduzir significativamente a pegada de memória de nossos conjuntos de dados mantendo seu valor informativo.

- Visualização de dados: É impossível visualizar dados com mais de três dimensões diretamente. A extração de características pode reduzir a dimensionalidade para duas ou três características, tornando possível plotar e entender a estrutura dos dados visualmente.

A extração de características aborda esses desafios ao reduzir a dimensionalidade, preservando informações essenciais. Essa redução transforma dados amplos e de alta dimensionalidade em uma forma mais compacta e gerenciável, levando a um aumento no desempenho do modelo.

Reduzindo a complexidade computacional e evitando overfitting

A extração de características fornece dois benefícios críticos para modelos de aprendizado de máquina:

- Menor requisitos computacionais

- Menos recursos significam tempos de treinamento mais rápidos

- Uso reduzido de memória durante a implantação do modelo

- Geração de previsões mais eficiente

- Melhor generalização

- Spaces de recursos mais simples ajudam a prevenir overfitting

- Modelos aprendem padrões mais robustos

- Desempenho aprimorado em novos dados não vistos

Extração de Características versus Sem Extração de Características

A visualização acima ilustra como a extração de características pode levar a modelos mais simples e robustos. O gráfico da esquerda mostra um modelo complexo tentando se ajustar a dados ruidosos e de alta dimensão, enquanto o gráfico da direita mostra como a extração de características pode revelar um padrão mais claro e generalizável.

Trabalhar com características extraídas em vez de dados brutos é como fornecer ao seu modelo uma versão clara e destilada das informações das quais precisa aprender. Isso não apenas torna o processo de aprendizado mais eficiente, mas também leva a modelos que têm mais chances de se sair bem em aplicações do mundo real.

A seguir, vamos ver diferentes métodos de extração de características.

Métodos de Extração de Características

Os métodos de extração de características podem ser amplamente categorizados em duas abordagens principais: engenharia de características manual e extração de características automatizada. Vamos analisar ambos os métodos para entender como ajudam a transformar dados brutos em características significativas.

Engenharia de características manual

A engenharia de características manual envolve o uso de conhecimento de domínio para identificar e criar características relevantes a partir de dados brutos. Esta abordagem prática depende da nossa compreensão do problema e dos dados para criar características significativas.

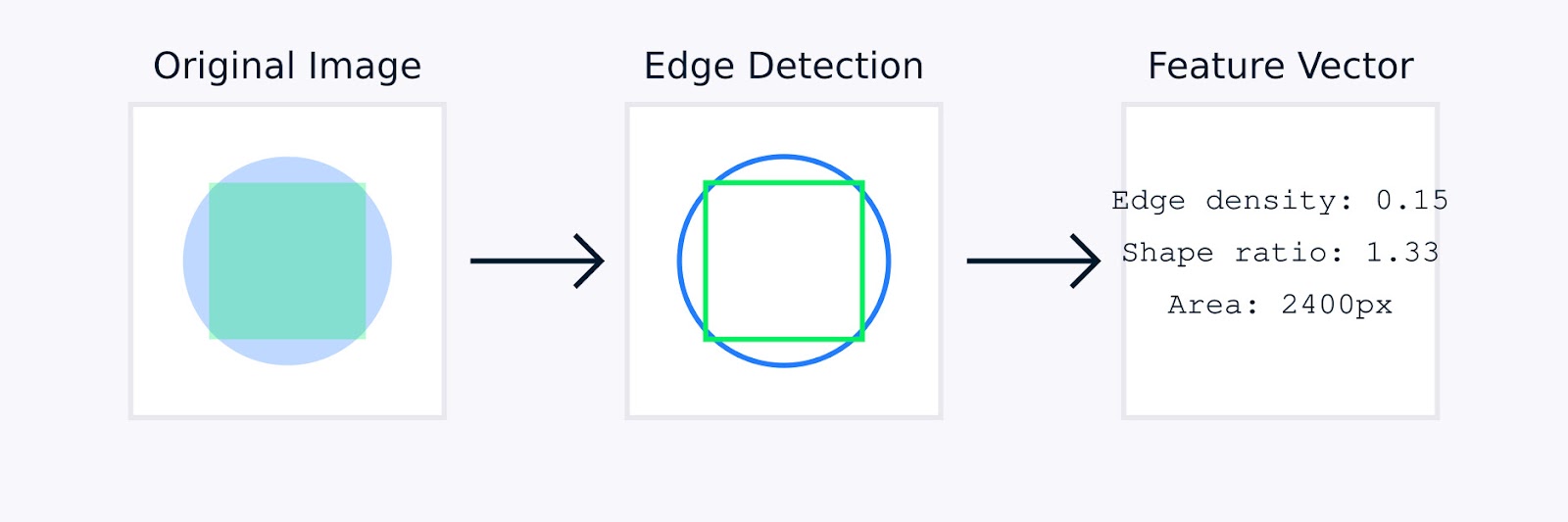

No processamento de imagem, a engenharia de recursos manual pode envolver técnicas como detecção de bordas para identificar limites de objetos, histogramas de cores para capturar distribuição de cores, análise de textura para quantificar padrões e descritores de forma para caracterizar a geometria do objeto.

Extração de Recursos de Imagem

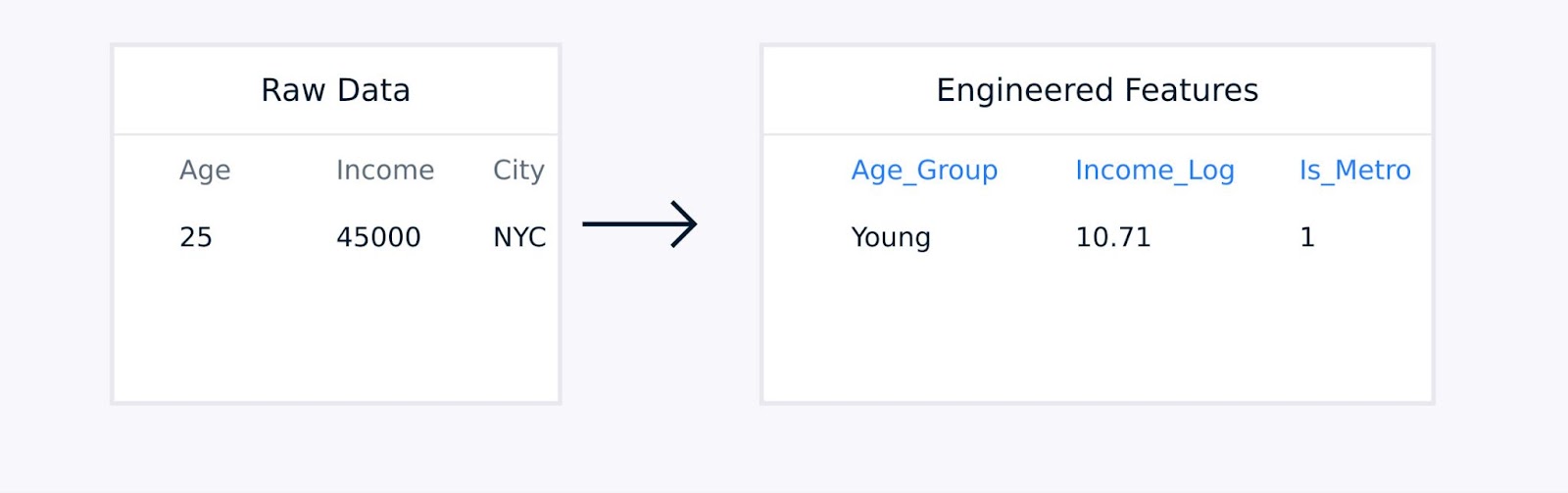

Para dados tabulares, a engenharia de recursos manual envolve a criação de termos de interação entre recursos existentes, a transformação de variáveis usando funções logarítmicas ou polinomiais, a agregação de pontos de dados em estatísticas significativas e a codificação de variáveis categóricas.

Extração de características de dados tabulares

Essas técnicas, guiadas por expertise de domínio, aprimoram a qualidade da representação dos dados e podem melhorar significativamente o desempenho do modelo.

Extração de características automatizada

A extração de características automatizada utiliza algoritmos para descobrir e criar características sem orientação humana explícita. Esses métodos são particularmente úteis ao lidar com conjuntos de dados complexos nos quais a engenharia de características manual pode ser impraticável ou ineficiente.

Abordagens automatizadas comuns incluem:

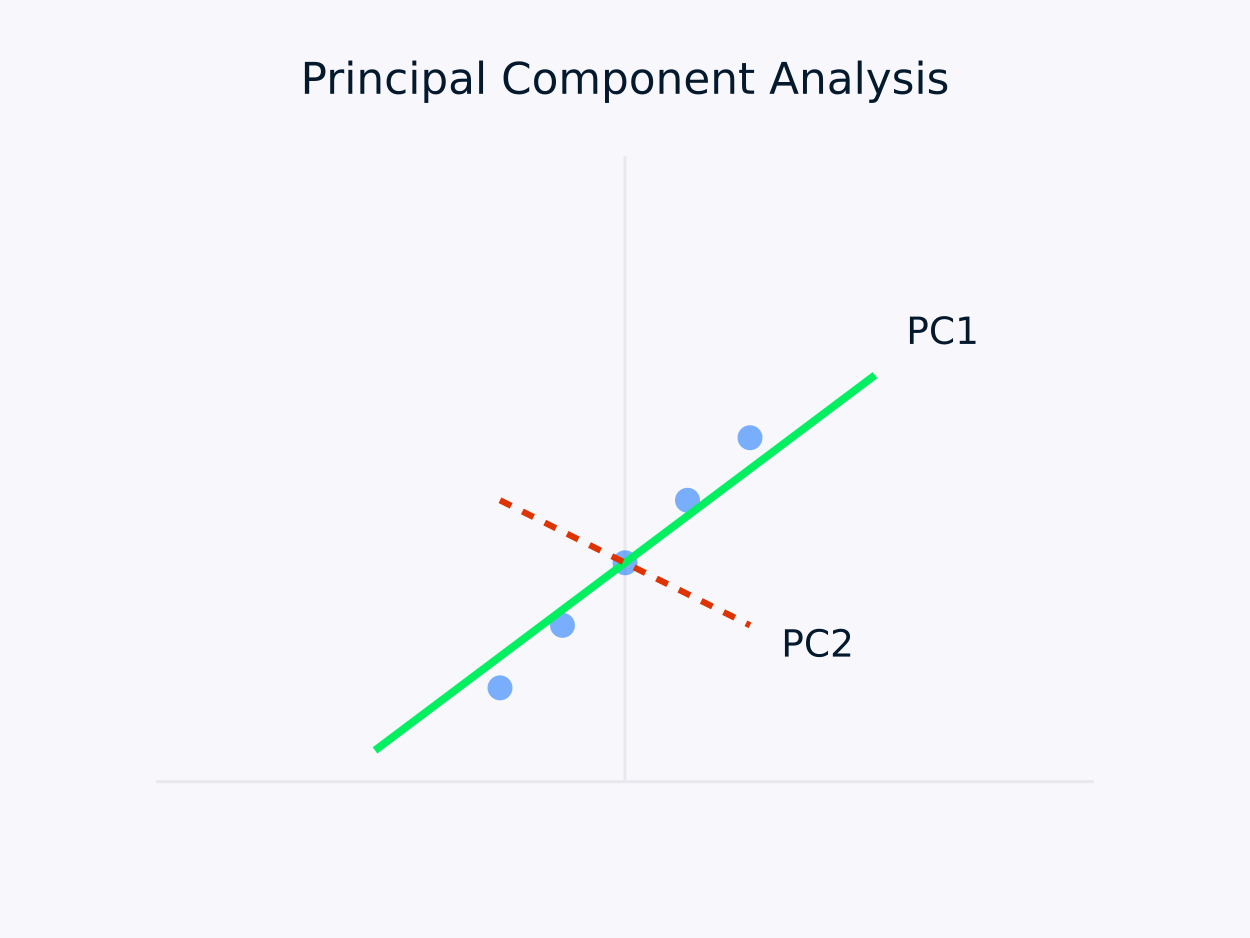

Análise de Componentes Principais (PCA): Transforma os dados em um conjunto de componentes não correlacionados, sendo que cada componente captura a máxima variância restante. Essa abordagem é particularmente útil para redução de dimensionalidade, pois preserva as informações essenciais nos dados enquanto simplifica sua estrutura.

Análise de Componentes Principais (PCA)

Autoencoders:Estes são redes neurais que aprendem representações comprimidas de dados, capturando relações não lineares. Eles são particularmente eficazes para conjuntos de dados de alta dimensão, onde métodos lineares tradicionais podem não ser suficientes.

Diversas ferramentas e bibliotecas surgiram para simplificar tarefas de engenharia de recursos. Por exemplo, o módulo de decomposição do Scikit-learn oferece uma variedade de métodos para redução de dimensionalidade, e o PyCaret fornece capacidades de seleção automática de recursos.

Ambas abordagens manuais e automatizadas têm suas vantagens. Vamos analisar as vantagens de cada abordagem.

|

Engenharia Manual |

Extração Automatizada |

|

Integração de conhecimento de domínio |

Escalabilidade |

|

Recursos interpretáveis |

Manuseia padrões complexos |

|

Controle refinado |

Reduz o viés humano |

|

Personalizado para necessidades específicas |

Descobre relacionamentos ocultos |

A escolha entre métodos manuais e automatizados frequentemente depende de fatores como complexidade do conjunto de dados, disponibilidade de expertise de domínio, requisitos de interpretabilidade, recursos computacionais e restrições de tempo.

Para conjuntos de dados altamente complexos ou quando o tempo e os recursos são limitados, métodos automatizados podem gerar rapidamente recursos úteis. Por outro lado, métodos manuais podem ser preferíveis quando há expertise de domínio disponível e interpretabilidade é uma prioridade, permitindo a engenharia de recursos personalizada que se alinha de perto com o problema em questão.

Na prática, muitos projetos bem-sucedidos de aprendizado de máquina combinam ambas as abordagens, utilizando a expertise de domínio para orientar a engenharia de recursos enquanto alavancam métodos automatizados para descobrir padrões adicionais que podem não ser imediatamente aparentes para especialistas humanos.

Na próxima seção, veremos várias técnicas de extração de recursos em diversos domínios.

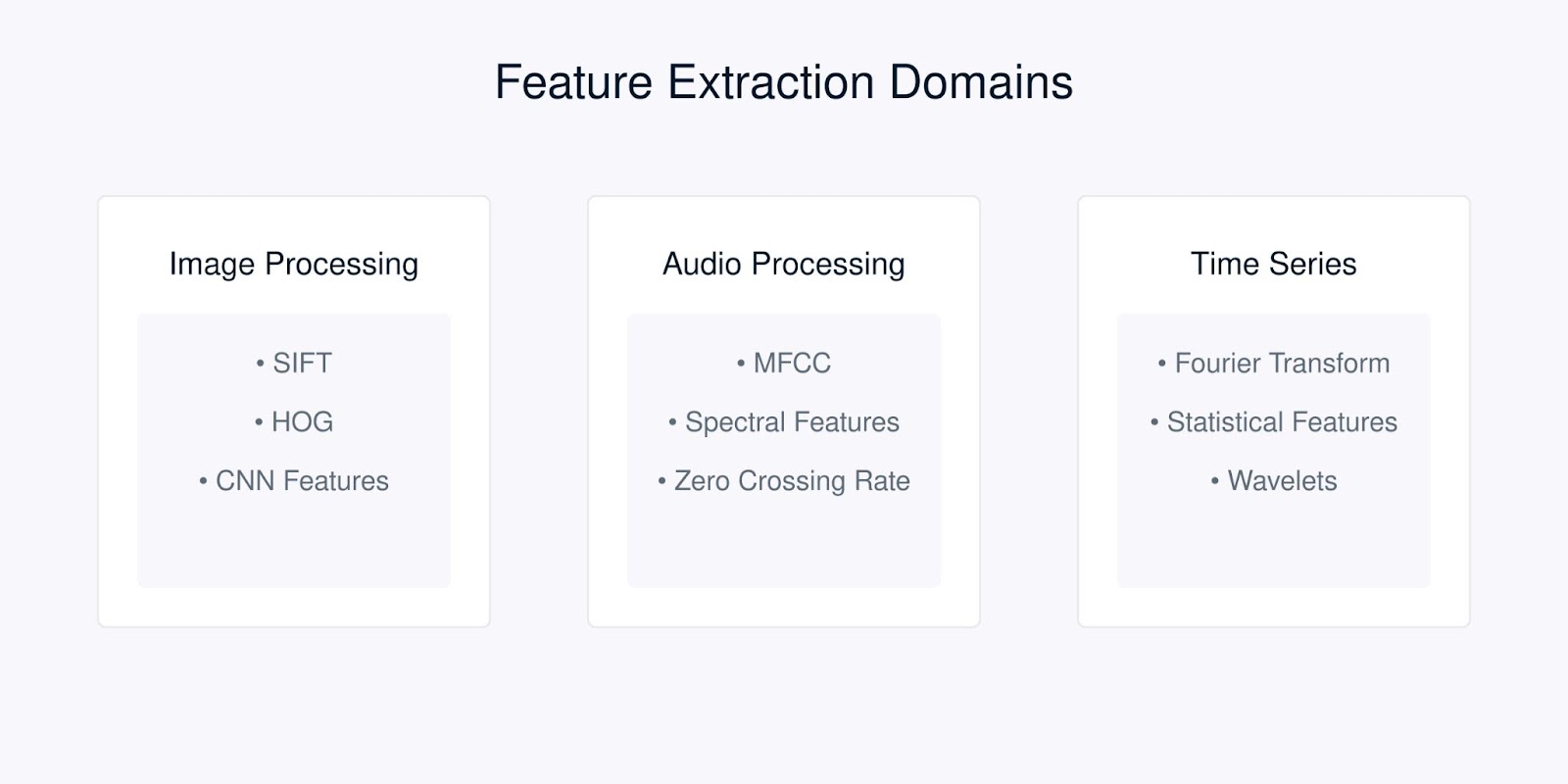

Técnicas de Extração de Recursos

Cada tipo de dados requer técnicas específicas de extração de recursos otimizadas para suas características únicas. Vamos analisar as técnicas mais comuns para diferentes tipos de dados.

Técnicas de Extração de Características

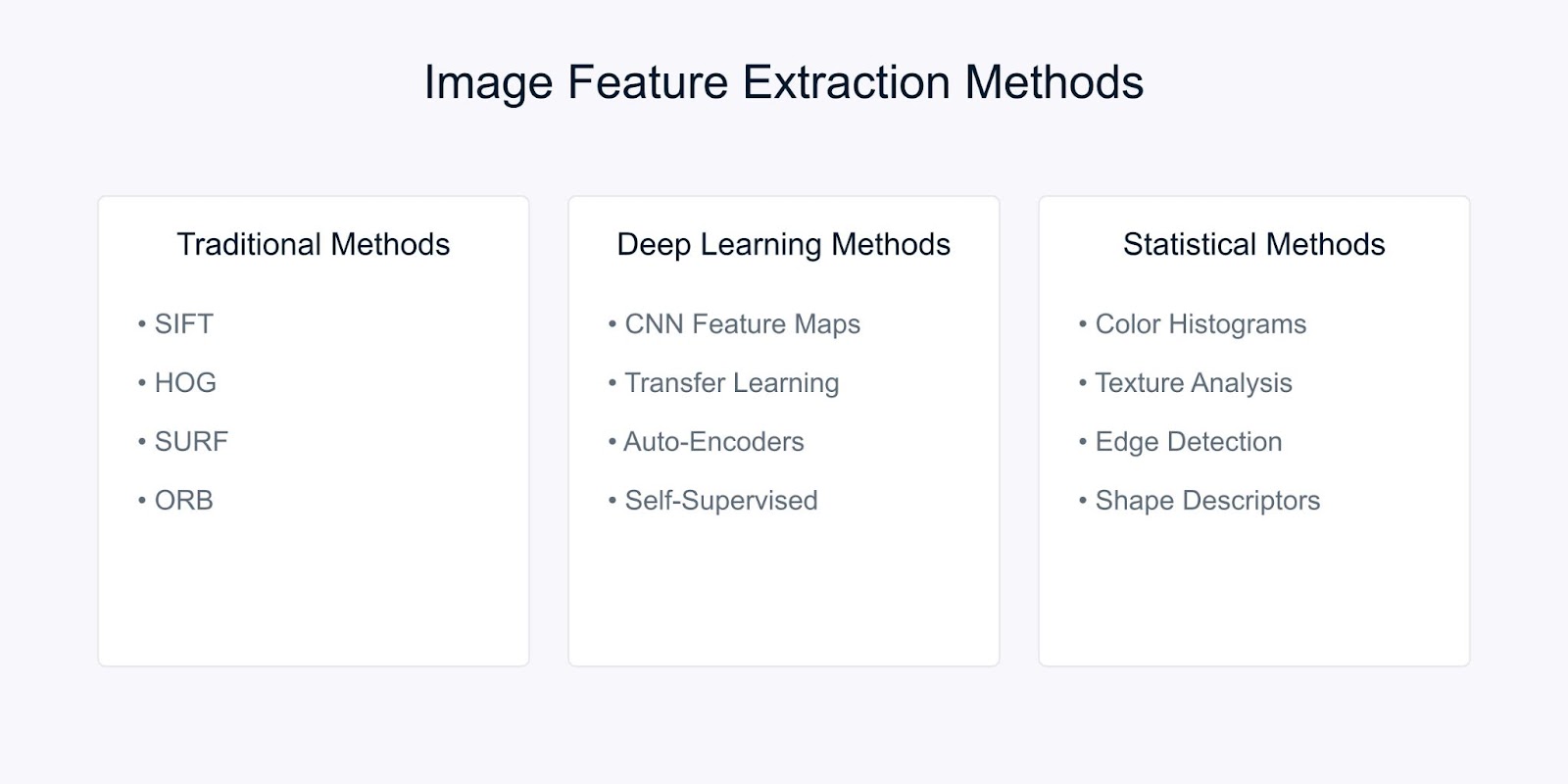

Extração de características de imagem

A extração de características de imagem transforma dados de pixels brutos em representações significativas que capturam informações visuais essenciais. Existem três categorias principais de técnicas usadas na visão computacional moderna. São os métodos tradicionais, baseados em aprendizado profundo e métodos estatísticos.

Métodos de Extração de Características de Imagem

Vamos analisar cada um dos métodos.

Métodos tradicionais de visão computacional

Transformada de Recursos Invariantes à Escala (SIFT) é um método robusto que detecta características locais distintivas em imagens. Ele funciona identificando pontos-chave e gerando descritores que são:

- Invariantes à escala e rotação da imagem

- Parcialmente invariantes a mudanças na iluminação

- Robustos à distorção geométrica local

O algoritmo SIFT processa imagens por várias etapas. Ele começa com a detecção de máximos no espaço de escala para identificar pontos-chave potenciais que são invariantes à escala. Em seguida, a localização dos pontos-chave refina esses candidatos, apontando suas localizações precisas e descartando pontos instáveis.

Seguindo isso, a atribuição de orientação determina uma orientação consistente para cada ponto-chave, garantindo a invariância à rotação. Por fim, a geração de descritor de ponto-chave cria descritores distintos com base nos gradientes de imagem locais, facilitando a correspondência robusta entre imagens.

Outro método é o Histograma de Gradientes Orientados (HOG). Ele captura informações locais de forma analisando padrões de gradiente em uma imagem. O processo começa calculando gradientes em toda a imagem para destacar detalhes de borda.

A imagem é então dividida em pequenas células e, para cada célula, é criado um histograma de orientações de gradiente para resumir a estrutura local. Por fim, esses histogramas são normalizados em blocos maiores para garantir robustez contra variações na iluminação e contraste, resultando em um descritor de características robusto para tarefas como detecção e reconhecimento de objetos.

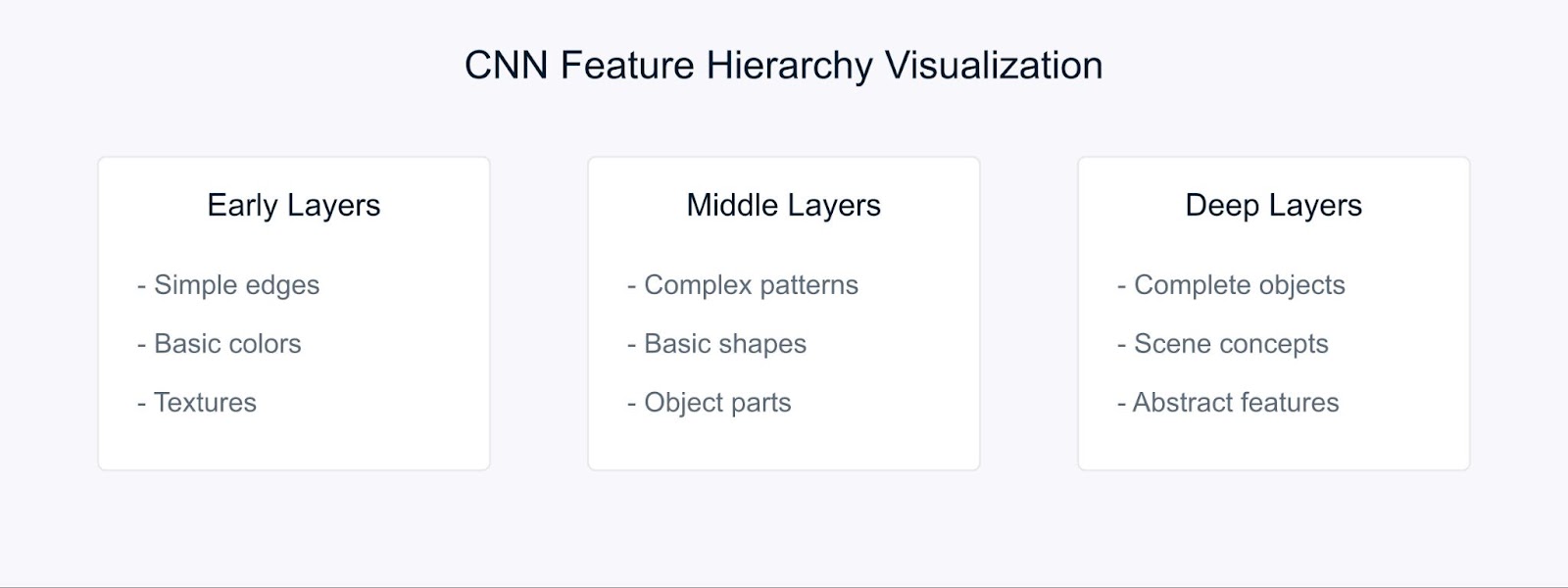

Aprendizagem profunda

Redes Neurais Convolucionais (CNNs) mudaram a forma como fazemos extração de características ao aprender automaticamente representações hierárquicas.

Extração de Características com CNN

As CNNs aprendem recursos por meio de sua estrutura hierárquica. Nas camadas iniciais, elas detectam elementos visuais básicos como bordas e cores. As camadas intermediárias combinam esses elementos para reconhecer padrões e formas, enquanto as camadas mais profundas capturam objetos complexos e possibilitam a compreensão da cena.

A transferência de aprendizado nos permite usar esses recursos pré-aprendidos de modelos treinados em grandes conjuntos de dados, tornando-os particularmente valiosos ao trabalhar com dados limitados.

Métodos Estatísticos

Os métodos estatísticos extraem padrões globais e locais das imagens, facilitando a análise e interpretação robustas de imagens.

Por exemplo, histogramas de cores representam a distribuição de cores dentro de uma imagem e fornecem características invariantes de rotação e escala, tornando-os particularmente úteis para tarefas como classificação e recuperação de imagens.

Análise de textura captura padrões repetidos e características de superfície usando técnicas como Matrizes de Coocorrência de Níveis de Cinza (GLCM), que são eficazes para aplicações, incluindo reconhecimento de materiais e classificação de cenas.

Além disso, detecção de bordas identifica limites e mudanças significativas de intensidade por meio de métodos como operadores Sobel, Canny e Laplacianos, desempenhando um papel crucial na detecção de objetos e análise de formas.

A escolha do método de extração de características depende de vários fatores. Deve estar alinhada com os requisitos específicos da sua tarefa, considerar os recursos computacionais disponíveis e levar em conta a necessidade de interpretabilidade.

Além disso, as características do seu conjunto de dados—como seu tamanho, níveis de ruído e complexidade—desempenham um papel crucial, assim como as propriedades de invariância necessárias como escala, rotação e iluminação.

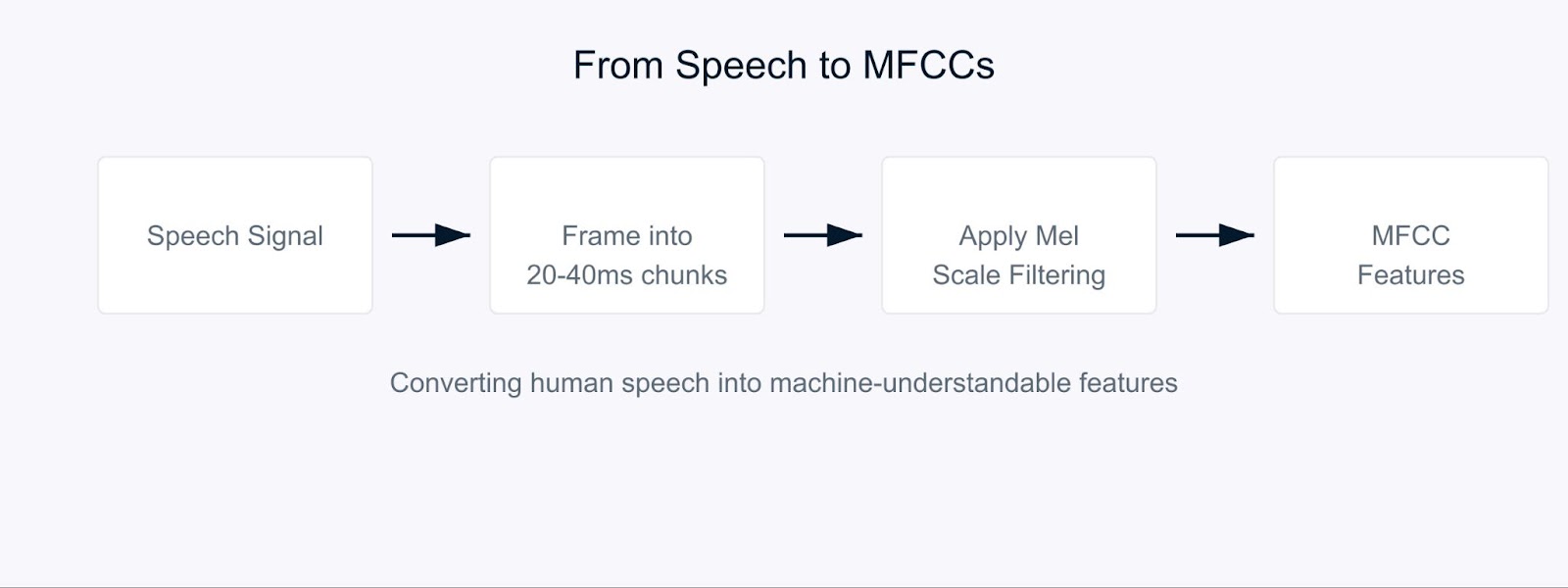

Extração de características de áudio

Imagine tentar ensinar um computador a entender a fala da maneira que os humanos fazem. É aqui que entram os Coeficientes Cepstrais em Mel (MFCC).

Os MFCCs são características de áudio especiais que decompõem o som de uma maneira semelhante à forma como nossos ouvidos o processam. Eles são particularmente eficazes porque se concentram nas frequências às quais os humanos são mais sensíveis. Pense neles como uma tradução do som para um formato que tanto computadores quanto a audição humana considerariam significativo.

Coeficientes Cepstrais em Mel

O processo começa decompondo o sinal de áudio em pequenos trechos, geralmente de 20 a 40 milissegundos de duração. Para cada trecho, aplicamos uma série de transformações matemáticas que convertem as ondas sonoras brutas em componentes de frequência. É aqui que fica interessante. Em vez de tratar todas as frequências igualmente, usamos algo chamado escala Mel.

![]()

Esta fórmula pode parecer complexa, mas é simplesmente um mapeamento de frequências para corresponder à forma como os humanos percebem o som. Nossos ouvidos são melhores em detectar diferenças em frequências mais baixas do que em frequências mais altas, e a escala Mel leva em conta esse viés natural.

No reconhecimento de voz, os MFCCs servem como a base para entender quem está falando e o que estão dizendo. Quando você fala com o assistente virtual do seu telefone, é provável que ele esteja usando MFCCs para processar sua voz. Esses coeficientes ajudam a capturar as características únicas da voz de cada pessoa, tornando-os inestimáveis para sistemas de identificação de locutores.

Para análise de sentimentos na fala, os MFCCs ajudam a detectar variações sutis na voz que indicam emoções. Eles podem capturar mudanças em altura, tom e taxa de fala que podem indicar se alguém está feliz, triste, bravo ou neutro. Por exemplo, ao analisar chamadas de serviço ao cliente, os MFCCs podem ajudar a identificar níveis de satisfação do cliente com base em como eles falam, e não apenas no que dizem.

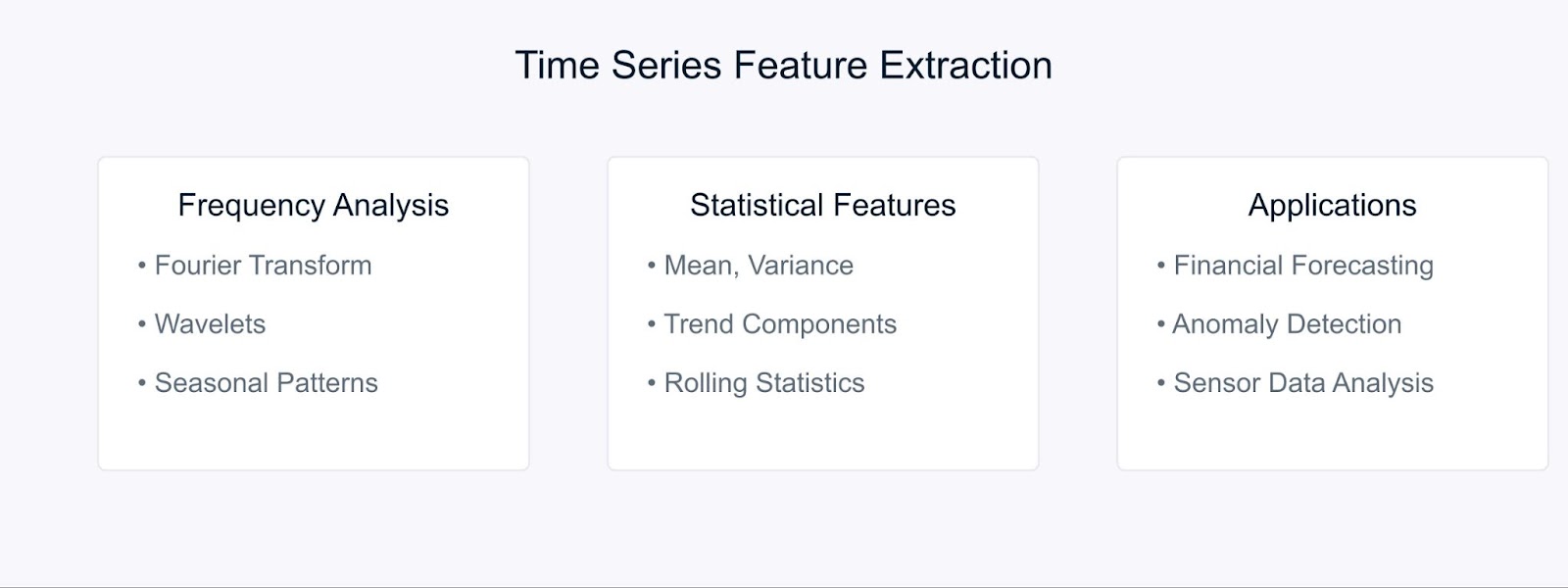

Extração de características de séries temporais

Ao trabalhar com séries temporais de dados, extrair características significativas nos ajuda a capturar padrões e tendências que evoluem ao longo do tempo. Vamos analisar algumas técnicas-chave usadas para transformar dados brutos de séries temporais em características úteis.

Métodos de Extração de Características de Séries Temporais

A Transformada de Fourier decompõe os dados de séries temporais em seus componentes de frequência, revelando padrões periódicos ocultos. A fórmula é:

Métodos estatísticos complementam a análise de frequência ao capturar características temporais. Características comuns incluem médias móveis, desvios padrão e componentes de tendência. Essas técnicas são particularmente poderosas em previsão financeira, onde ajudam a identificar tendências e anomalias do mercado.

Por exemplo, na análise do mercado de ações, combinar características de Fourier com medidas estatísticas pode revelar tanto tendências de longo prazo quanto padrões cíclicos. Da mesma forma, em ambientes industriais, esses métodos ajudam a detectar anomalias em equipamentos ao analisar padrões de dados de sensores ao longo do tempo.

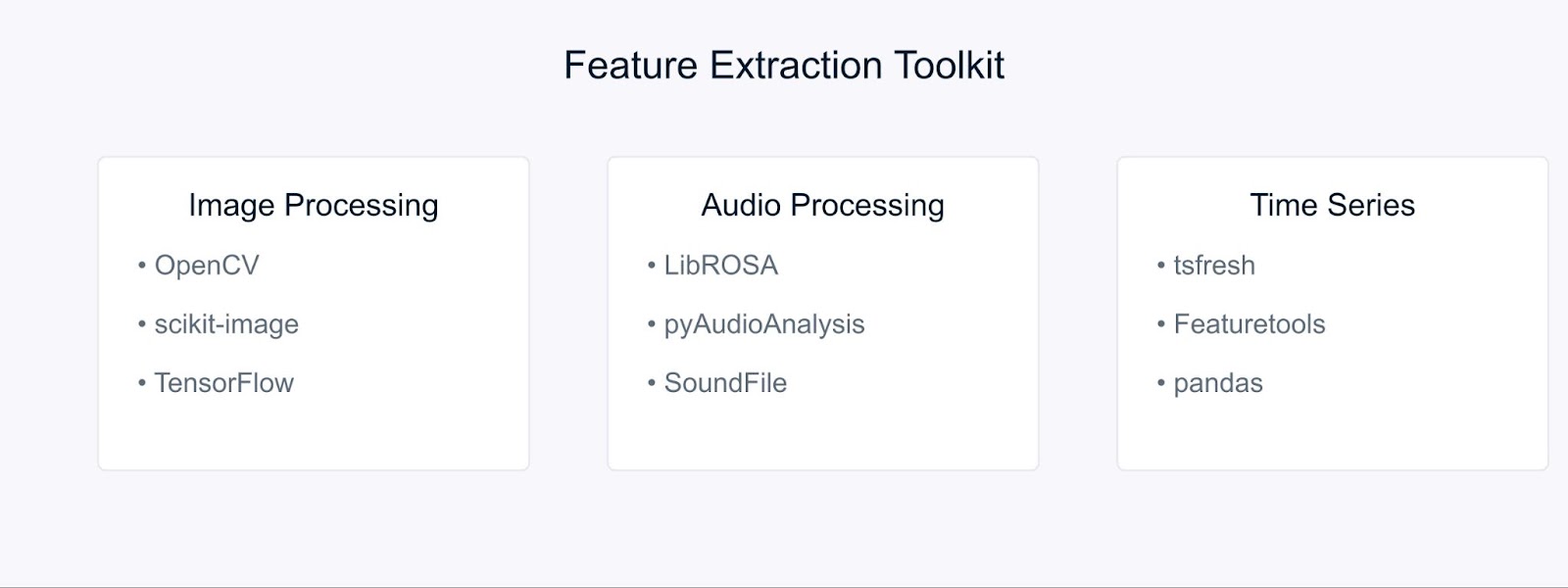

Ferramentas e Bibliotecas para Extração de Características

Vamos ver algumas ferramentas essenciais que tornam a implementação desses métodos de extração de características simples e eficiente.

Ferramentas e Bibliotecas para Extração de Características

Para processamento de imagem, o OpenCV e o scikit-image fornecem ferramentas abrangentes para implementar várias técnicas de extração de características. Essas bibliotecas oferecem implementações eficientes de SIFT, HOG e outros algoritmos que discutimos anteriormente. Ao trabalhar com abordagens de aprendizado profundo, frameworks como TensorFlow e PyTorch se tornam inestimáveis. Você pode começar com nosso tutorial do OpenCV para saber mais.

Tarefas de processamento de áudio são simplificadas com bibliotecas como LibROSA, que se destaca na extração de MFCCs e outras características acústicas. PyAudioAnalysis estende essas capacidades com interfaces de alto nível para tarefas de análise de áudio.

Para dados de séries temporais, tsfresh e Featuretools automatizam o processo de extração de características. Essas bibliotecas podem gerar e selecionar automaticamente características relevantes dos seus dados temporais, facilitando o foco no desenvolvimento de modelos em vez de engenharia de características.

Exemplo de Extração de Características

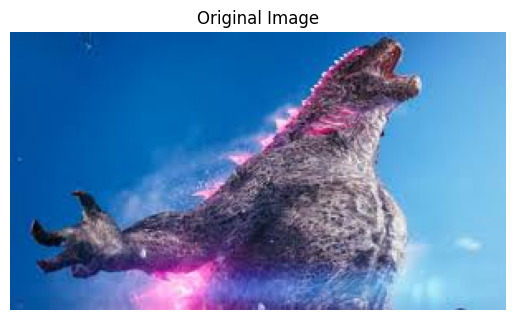

Vamos colocar nosso conhecimento em prática com alguns exemplos práticos. Começaremos com a extração de características de imagem, uma das aplicações mais comuns em visão computacional.

Extração de características de imagem usando OpenCV

Primeiro, vamos importar as bibliotecas necessárias

# Importar bibliotecas necessárias import cv2 import numpy as np import matplotlib.pyplot as plt

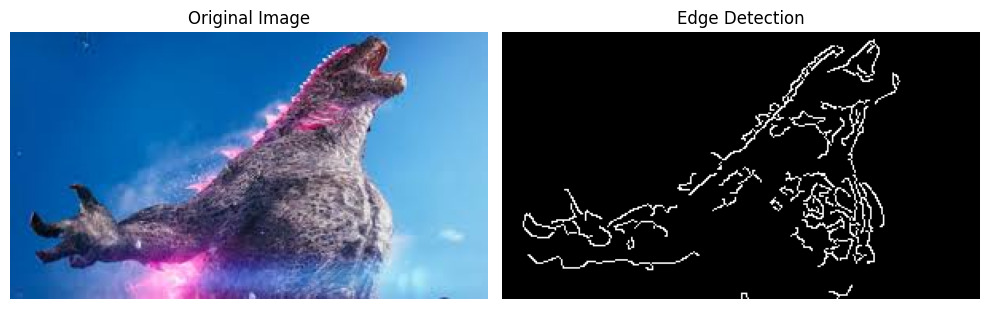

Agora, vamos carregar uma imagem para extrair características relevantes. Para este exemplo, usaremos uma imagem do Godzilla baixada da internet.

# Carregar a imagem image = cv2.imread('godzilla.jpg') # Converter BGR para RGB (OpenCV carrega no formato BGR) image_rgb = cv2.cvtColor(image, cv2.COLOR_BGR2RGB) # Exibir a imagem original plt.imshow(image_rgb) plt.title('Original Image') plt.axis('off') plt.show()

Saída:

Antes de aplicar a detecção de bordas, precisamos pré-processar nossa imagem. Fazemos isso da seguinte forma:

# Converter a imagem para escala de cinza gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY) # Aplicar desfoque gaussiano para reduzir o ruído blurred = cv2.GaussianBlur(gray_image, (5, 5), 0)

Finalmente, vamos aplicar o algoritmo de detecção de bordas Canny e visualizar os resultados:

# Aplicar detecção de borda Canny edges = cv2.Canny(blurred, threshold1=100, threshold2=200) # Exibir os resultados plt.figure(figsize=(10, 5)) plt.subplot(1, 2, 1) plt.imshow(image_rgb) plt.title('Original Image') plt.axis('off') plt.subplot(1, 2, 2) plt.imshow(edges, cmap='gray') plt.title('Edge Detection') plt.axis('off') plt.tight_layout() plt.show()

Saída:

O detector de borda Canny nos ajuda a identificar limites importantes e características em nossa imagem, que podem ser usados para análises posteriores ou como entrada para modelos de aprendizado de máquina.

Extraindo MFCC do áudio usando LibROSA

Antes de podermos começar a processar arquivos de áudio, precisamos instalar as bibliotecas necessárias. Como o LibROSA não está incluído na biblioteca padrão do Python, usaremos o pip para instalá-lo:

# Instalar bibliotecas necessárias # Execute esses comandos no seu terminal ou prompt de comando pip install librosa pip install numpy pip install matplotlib

O LibROSA é uma biblioteca poderosa projetada para análise de música e áudio, então vamos começar importando-a junto com outras bibliotecas necessárias:

# Importar bibliotecas necessárias import librosa import librosa.display import numpy as np import matplotlib.pyplot as plt

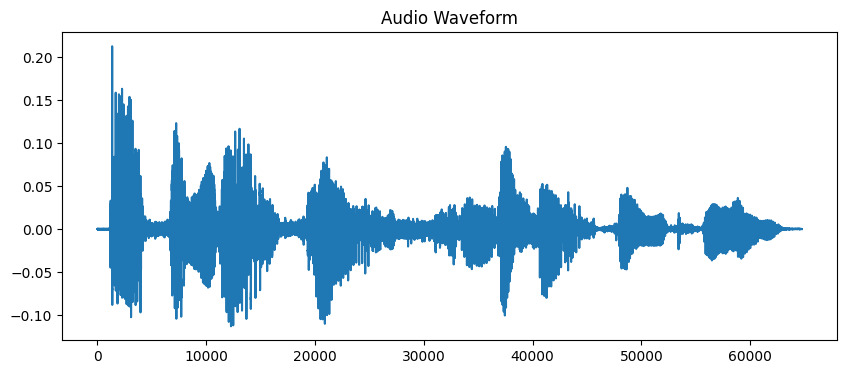

Os arquivos de som contêm muitas informações em formato de onda. Para trabalhar com esses dados, precisamos primeiro carregá-los em nosso programa. O LibROSA nos ajuda a fazer isso convertendo o arquivo de áudio em um formato que podemos analisar:

# Carregar o arquivo de áudio # A duração é limitada a 10 segundos para este exemplo audio_path = 'audio_sample.wav' y, sr = librosa.load(audio_path, duration=10) # Exibir a forma de onda plt.figure(figsize=(10, 4)) plt.plot(y) plt.title('Audio Waveform') plt.show()

Saída:

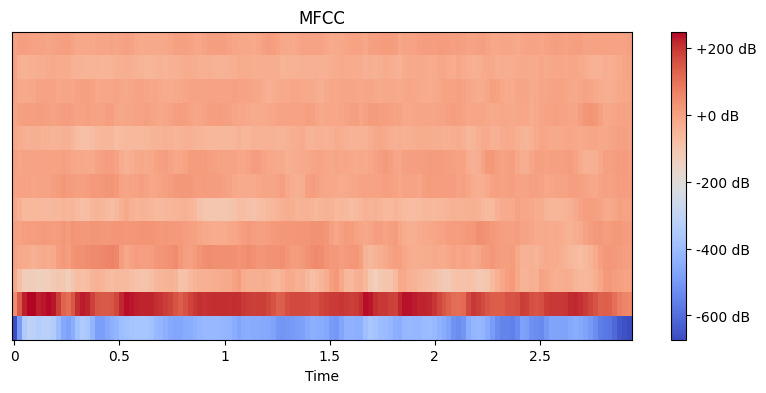

Agora que temos nosso áudio carregado, precisamos extrair características significativas dele. Nossos ouvidos naturalmente decompõem o som em diferentes componentes de frequência, e o MFCC imita esse processo. Usamos a função de extração de características do librosa para calcular esses coeficientes:

# Extrair características MFCC mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13) # Exibir o MFCC plt.figure(figsize=(10, 4)) librosa.display.specshow(mfccs, x_axis='time') plt.colorbar(format='%+2.0f dB') plt.title('MFCC') plt.show()

Saída:

Aqui, definimos n_mfcc=13 porque os primeiros 13 coeficientes normalmente capturam os aspectos mais importantes do som que ajudam em tarefas como reconhecimento de fala. A visualização resultante mostra como essas características mudam ao longo do tempo, onde cores mais brilhantes representam valores mais altos.

Extração de características de dados de séries temporais com tsfresh

Primeiro, vamos instalar as bibliotecas necessárias. Vamos usar o yfinance para obter dados financeiros, juntamente com o tsfresh para extração de características:

# Instalar bibliotecas necessárias # Execute esses comandos no seu terminal ou prompt de comando pip install tsfresh pip install pandas pip install numpy pip install matplotlib pip install yfinance

Agora vamos importar nossas bibliotecas e buscar alguns dados financeiros reais:

# Importe as bibliotecas necessárias import pandas as pd import numpy as np from tsfresh import extract_features from tsfresh.feature_extraction import MinimalFCParameters import matplotlib.pyplot as plt import yfinance as yf

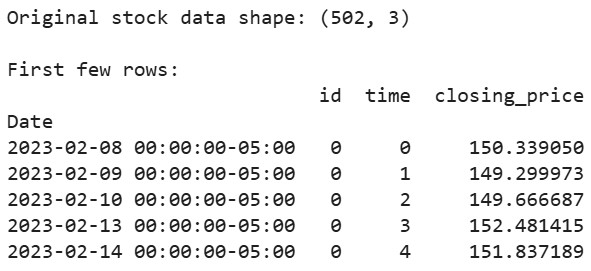

Vamos obter alguns dados reais do mercado de ações. Vamos usar os dados da Apple como exemplo:

# Baixe os dados de ações da Apple dos últimos 2 anos aapl = yf.Ticker("AAPL") df = aapl.history(period="2y") # Prepare os dados no formato esperado pelo tsfresh df_tsfresh = pd.DataFrame({ 'id': [0] * len(df), # Cada série temporal precisa de um ID 'time': range(len(df)), 'closing_price': df['Close'] # Vamos usar os preços de fechamento }) # Exibir as primeiras linhas dos nossos dados print("Original stock data shape:", df_tsfresh.shape) print("\nFirst few rows:") print(df_tsfresh.head())

Saída:

Agora vamos extrair características dos nossos dados financeiros de séries temporais:

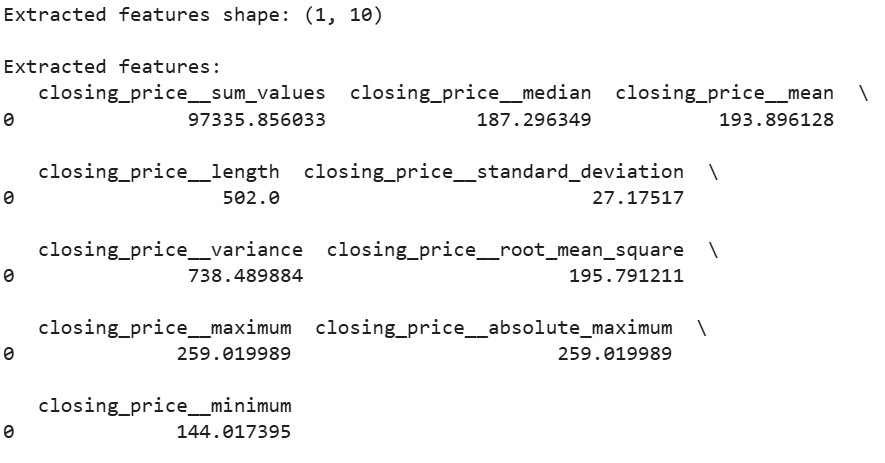

# Configure os parâmetros de extração de características extraction_settings = MinimalFCParameters() # Extraia características automaticamente extracted_features = extract_features(df_tsfresh, column_id='id', column_sort='time', column_value='values', default_fc_parameters=extraction_settings) # Exiba as características extraídas print("\nExtracted features shape:", extracted_features.shape) print("\nExtracted features:") print(extracted_features.head())

Saída:

Aqui, usamos MinimalFCParameters() para especificar quais características extrair. Isso nos fornece um conjunto básico de características significativas de séries temporais, como média, variância e características de tendência, que são essenciais para entender os padrões em nossos dados.

Desafios na Extração de Características

Ao trabalhar com extração de características, frequentemente encontramos desafios.

A alta dimensionalidade e restrições computacionais frequentemente surgem ao lidar com grandes conjuntos de dados. Por exemplo, extrair características de imagens de alta resolução ou arquivos de áudio longos pode consumir memória significativa e poder de processamento.

O sobreajuste devido a características irrelevantes ou redundantes é outro desafio comum. Quando muitas características são extraídas, os modelos podem aprender ruído em vez de padrões significativos. Isso é especialmente comum em processamento de imagem e áudio, onde milhares de características podem ser geradas.

Para superar esses desafios, considere estas estratégias:

- Use conhecimento de domínio para selecionar características relevantes

- Aplique métodos de seleção de características para reduzir a dimensionalidade

- Implemente técnicas adequadas de engenharia de características com base no tipo de dado

Esses desafios exigem uma consideração cuidadosa e equilíbrio entre riqueza de recursos e eficiência computacional.

Conclusão

A extração de características é uma habilidade fundamental em aprendizado de máquina que transforma dados brutos em representações significativas. Através de nossos exemplos práticos com OpenCV, LibROSA e tsfresh, vimos como extrair características de diferentes tipos de dados. Ao entender essas técnicas e seus desafios, podemos construir modelos de aprendizado de máquina eficazes.

Pronto para se aprofundar? Confira estes recursos:

Source:

https://www.datacamp.com/tutorial/feature-extraction-machine-learning