近年来,AI取得了巨大的飞跃,这主要得益于大型语言模型(LLM)。LLM在理解和生成类人文本方面确实很出色,它们导致了高级聊天机器人、AI作家等一些新工具的诞生。

尽管LLM在生成流畅、类似人类的文本方面很出色,但它们有时在确保事实准确性方面存在困难。当准确性非常重要时,这可能会成为一个巨大的问题

那么这个问题该如何解决呢?答案是检索增强生成(RAG)。

RAG集成了像GPT这样的模型的所有强大功能,同时还增加了从外部来源查找信息的能力,比如专有数据库、文章和内容。这帮助AI生成的文本不仅写得很好,而且在事实和语境上更加准确。

通过将文本生成能力和查找和使用准确、相关信息的能力相结合,RAG开启了许多新的可能性。它帮助弥合了仅仅编写文本的AI和使用实际知识的AI之间的差距。

在这篇文章中,我们将更深入地了解RAG,它的工作原理、应用领域,以及它可能如何改变我们未来与AI的互动。

什么是检索增强生成(RAG)?

让我们从RAG的正式定义开始:

检索增强生成(RAG)是一个AI框架,通过将大型语言模型(LLM)与外部知识库连接起来,从而增强它们。这使得能够访问最新、准确的信息,提高了其结果的相关性和事实准确性。

现在,让我们用简单易懂的语言来解释。

在过去的两年里,我们都使用过像ChatGPT这样的AI聊天机器人,它们可以回答我们的问题。这些聊天机器人是由大型语言模型(LLM)驱动的,后者是在大量互联网内容/数据上进行训练和构建的。它们在几乎所有主题上都能生成类人文本。看起来它们完全能够回答我们所有的问题,但并非总是如此。它们有时会分享可能不准确和事实不正确信息。

这就是RAG发挥作用的地方。以下是它的基本工作方式(从很高层次上来说):

- 你提出一个问题。

- RAG搜索一个精心筛选的、可靠的 information知识库。

- 它检索相关信息。

- 然后把它传递给LLM。

- LLM利用这些准确的信息来回答你。

这个过程的结果是,回答有准确信息的支持。

让我们用一个例子来理解这个问题:假设你想了解国际航班的行李允许重量。一个传统LLM(如ChatGPT)可能会说:“通常,你可以托运一个最多50磅的行李和一个17磅的手提行李。但请与你的航空公司核实具体规定。” 一个RAG增强型系统会说:“对于X航空公司,经济舱乘客可以托运一个50磅的行李和一个17磅的手提行李,商务舱乘客可以托运两个70磅的行李。请注意特殊规定,比如运动装备等,并且在办理登机手续时进行核实。”

你注意到了区别吗?RAG提供了更具体、更准确的信息,符合实际航空公司的政策。总的来说,RAG使得这些系统更加可靠和值得信赖。在开发对现实世界应用更加可靠的AI系统时,这是非常关键的。

RAG的工作原理

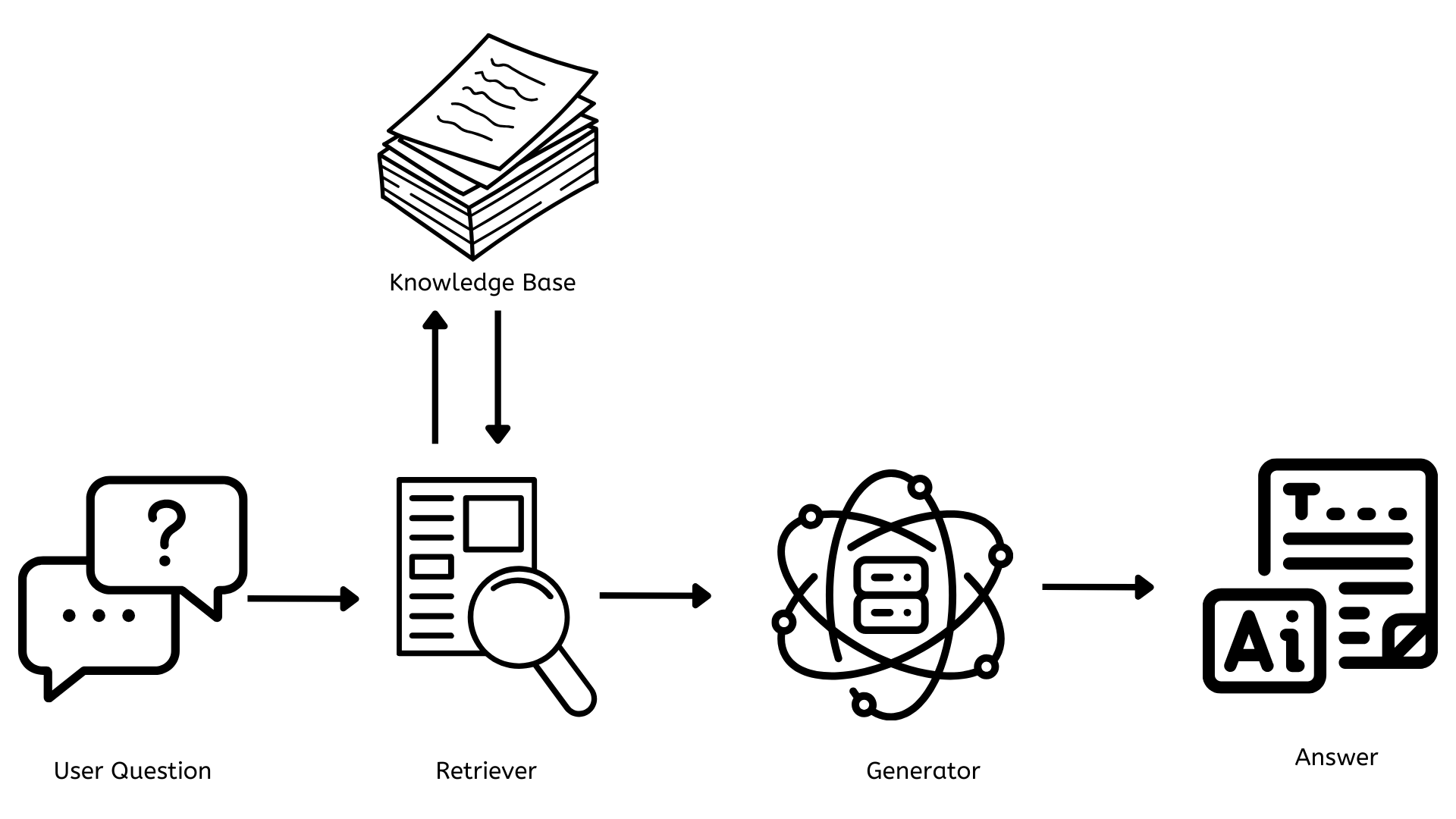

现在我们已经对RAG有了大致的了解,接下来让我们看看它是如何工作的。首先,我们从简单的架构图开始。

RAG的关键组成部分

从上面的架构图中可以看出,在用户问题和问题的最终答案之间,有三个对RAG工作至关重要的关键组件。

- 知识库

- 检索器

- 生成器

接下来,让我们逐一了解这些组件。

知识库

这是包含所有文档、文章或数据的地方,可以参考这些信息来回答所有问题。这需要不断更新,包含新的相关信息,以便回答准确,并为用户提供最相关、最新的信息。

从技术角度来看,这通常使用向量数据库,如Pinecone、FAISS等,以数值表示(嵌入)存储文本,从而实现快速高效搜索。

检索器

它负责找到与用户问题相关的文档或数据。当提出一个问题时,检索器会快速搜索知识库,找到最相关的信息。

从技术角度来看,这通常使用密集检索方法,如密集段落检索或BM25。这些方法将用户问题转换为与知识库中相同的数值表示,并与其相关信息匹配。

生成器

它负责生成与用户问题在上下文上相关且连贯的内容。它获取检索器的信息,并使用它来构建一个回答问题的回复。

从技术角度来看,这是由大型语言模型(如GPT-4)或开源替代品如LLAMA或BERT提供支持的。这些模型在大量数据上进行训练,能够根据接收到的输入生成类似人类的文本。

RAG的优势和应用

既然我们知道RAG是什么以及它是如何工作的,让我们探讨一些RAG所提供的优势以及RAG的应用。

RAG的优势

知识更新

与只能使用训练数据的传统AI模型(ChatGPT)不同,RAG系统可以访问并利用知识库中最最新的信息。

提高准确性和减少幻觉

RAG通过在知识库中使用事实性的、最新的信息来提高响应的准确性。这在很大程度上减少了AI生成更合理但错误信息的问题,即“幻觉”。

定制和专业化

公司可以通过使用专业知识库和创建AI助手来实现RAG系统的定制化,使其在特定领域成为专家。

透明度和可解释性

RAG系统通常能提供其信息的来源,这使得用户更容易理解信息来源,验证声明,并了解回应背后的推理。

可扩展性与效率

RAG允许高效利用计算资源。组织可以通过更新知识库,而不是不断重新训练大型模型或构建新模型,从而更容易扩展和维护AI系统。

RAG的应用

客户服务

RAG使客户支持聊天机器人变得更智能、更有帮助。这些聊天机器人可以访问知识库中最新的信息,并提供精确和上下文相关的答案。

个性化助手

公司可以创建定制的AI助手,这些助手可以访问他们独特和专有的数据。通过利用组织内部的文件,包括政策、程序和其他数据,这些助手可以迅速有效地回答员工的问题。

客户声音

组织可以使用RAG来分析,并从各种客户反馈渠道中提取有价值的洞察力,以创建对客户体验、情感和需求的全面理解。这使他们能够迅速识别并解决关键问题,做出基于数据的决定,并根据客户在各接触点的完整反馈情况不断改进产品。

RAG的未来

RAG作为人工智能领域的一项颠覆性技术,将大规模语言模型的力量与动态信息检索相结合。许多组织已经在利用这一点,并为自己的需求构建定制化解决方案。

展望未来,RAG将改变我们与信息互动和做决策的方式。未来的RAG系统将:

- 具有更强的上下文理解能力和增强的个性化

- 超越文本,同时整合图像、音频/视频等多模态

- 实现实时知识库更新

- 与许多工作流程无缝集成,以提高生产力和增强协作

结论

总之,RAG将改变我们与人工智能和信息的互动方式。通过缩小AI生成内容与其事实准确性之间的差距,RAG将为更智能、更准确、更值得信赖的AI系统奠定基础。随着这一领域的不断发展,我们将以比以往更高效、更准确的方式处理信息。

Source:

https://dzone.com/articles/rag-enhancing-ai-language-models