Negli ultimi anni, l’intelligenza artificiale ha fatto grandi progressi, soprattutto grazie alle grosse modelli di linguaggio (LLMs). I modelli di linguaggio sono davvero bravi a capire e generare testo simile all’umano, e hanno portato alla creazione di diverse nuove risorse come chatbot avanzati e scrittori AI.

Mentre i modelli di linguaggio sono grandiose nell’ generazione di testo fluente e simile all’umano, a volte si scontrano con il problema di non avere sempre le informazioni corrette. Questo può essere un grosso problema quando è importante l’accuratezza.

Quindi, qual è la soluzione a questo problema? La risposta è Retrieval Augmented Generation (RAG).

RAG integra tutte le caratteristiche potenti dei modelli come GPT e aggiunge anche la capacità di cercare informazioni da fonti esterne, come database proprietari, articoli e contenuti. Ciò aiuta l’AI a produrre testo non solo ben scritto ma anche più corretto in termini di fatti e contesto.

Combinando la capacità di generare testo con il potere di trovare e utilizzare informazioni accurate e relative, RAG apre nuove possibilità. aiuta a colmare il gap tra l’AI che solo scrive testo e l’AI che può usare una conoscenza reale.

In questo articolo, guarderemo da vicino RAG, come funziona, dove viene utilizzato e come potrebbe cambiare le nostre interazioni con l’AI futuro.

Cos’è la Retrieval Augmented Generation (RAG)?

Iniziamo con una definizione formale di RAG:

Ricerca Augmentata Generazione (RAG) è un framework AI che migliora i grandi modelli di linguaggio (LLM) collegandoli con basi di conoscenza esterne. Questo consente l’accesso a informazioni aggiornate e accurate, migliorando la rilevanza e l’accuratezza fattuale dei suoi risultati.

Adesso, spiegheremo in linguaggio semplice così da renderlo facile da capire.

Tutti abbiamo usato chatbot AI come ChatGPT negli ultimi 2 anni che possono rispondere alle nostre domande. Questi sono alimentati da grandi modelli di linguaggio (LLM), che sono stati addestrati e costruiti su una quantità ingente di contenuti/dati internet. Sono grandi capaci di produrre testo simile all’uomo su quasi qualsiasi argomento. Sembra che siano perfettamente capaci di rispondere a tutte le nostre domande, ma non è sempre così. A volte condividono informazioni che potrebbero non essere accurate e corrette.

Ecco dove entra in gioco RAG. Ecco come funziona (a un alto livello):

- Fai una domanda.

- RAG cerca una base di conoscenza curata di informazioni affidabili.

- Recupera informazioni relative.

- Le passa al LLM.

- Il LLM usa queste informazioni accurate per rispondere a te.

Il risultato di questo processo sono risposte supportate da informazioni accurate.

Pensiamo ad un esempio: immaginate di voler sapere le norme sulla valigia per un volo internazionale. Un tradizionaleLM come ChatGPT potrebbe rispondere: “Di solito, puoi avere una valigia da 50 libbre e una valigetta da porto. Ma controlla con la tua compagnia aerea per i dettagli.” Un sistema RAG- migliorato direbbe: “Per la compagnia aerea X, i passeggeri经济a ricevono una valigia da 50 libbre e una valigetta da 17 libbre. Con la classe business, si ricevono due valigie da 70 libbre. Bada a regolamenti speciali su oggetti come attrezzature sportive, e sempre verifica all’ check-in.”

Notate la differenza? RAG fornisce informazioni specifiche, più accurate, personalizzate alle politiche reali delle compagnie aeree. In sintesi, RAG rende questi sistemi più affidabili e attendibili. È molto importante nell’sviluppo di AI sistemi che sono più affidabili per applicazioni reali.

Come funziona RAG

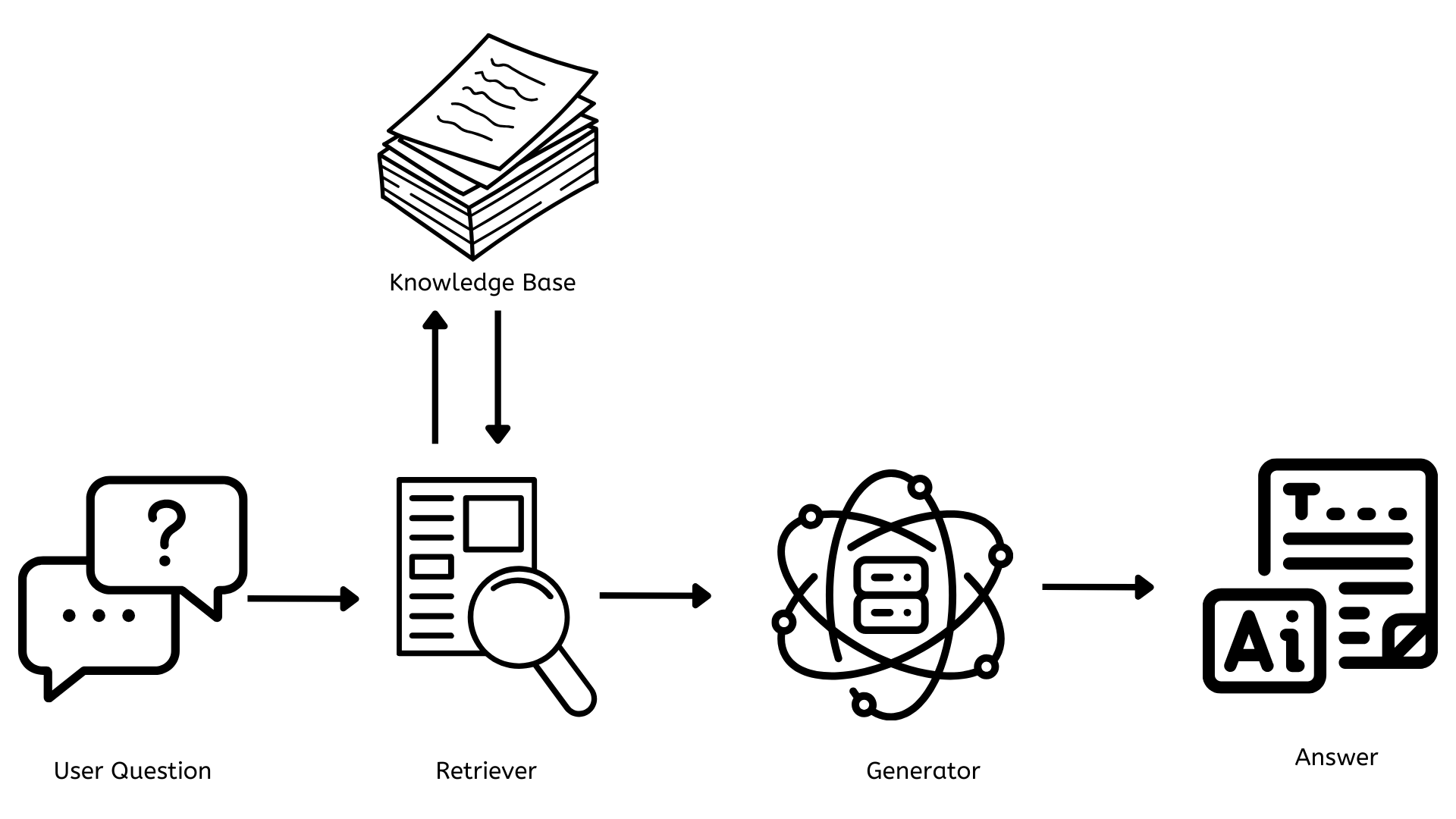

Ora che abbiamo una buona idea di cosa sia RAG, capiamo come funziona. Prima di tutto, cominciamo con un diagramma di architettura semplice.

I Key Componenti di RAG

Da diagramma di architettura sopra, tra la domanda dell’utente e la risposta finale alla domanda, ci sono 3 componenti chiave cruciali per far funzionare RAG.

- Base di conoscenza

- Ricercatore

- Generatore

Ora, capiamo ognuna separatamente.

La Base di Conoscenza

Questo è il repository che contiene tutti i documenti, gli articoli o i dati che possono essere citati per rispondere a tutte le domande. Ci serve aggiornare costantemente con nuove informazioni rilevanti perché le risposte siano accurate e gli utenti siano forniti delle informazioni più rilevanti e aggiornate.

Da un punto di vista tecnologico, questo di solito utilizza database vettoriali come Pinecone, FAISS ecc. per memorizzare il testo come rappresentazioni numeriche (embeddings), consentendo così ricerche veloci ed efficienti.

Il Recuperatore

Questo è responsabile per trovare documenti o dati rilevanti che sono collegati alla domanda dell’utente. Quando viene fatta una domanda, il recuperatore cerca rapidamente nella base di conoscenza le informazioni più rilevanti.

Da un punto di vista tecnologico, questo spesso utilizza metodi di recupero densi come Dense Passage Retrieval o BM25. Questi metodi convertiscono le domande dell’utente nello stesso tipo di rappresentazione numerica utilizzata nella base di conoscenza e le corrispondono alle informazioni rilevanti.

Il Generatore

Questo è responsabile per generare contenuto coerente e rilevante contestualmente all’utente. Prende le informazioni dal recuperatore e le utilizza per creare una risposta che risponde alla domanda.

Dall’aspetto tecnologico, questo è alimentato da un Grande Modello di Linguaggio (LLM) come GPT-4 o alternative open-source come LLAMA o BERT. Questi modelli sono addestrati su grandi dataset e possono generare testo simile all’uomo in base all’input che ricevono.

Benefici e applicazioni di RAG

Ora che sappiamo cosa sia RAG e come funziona, esploriamo alcuni dei benefici che offre oltre alle applicazioni di RAG.

Benefici di RAG

Conoscenza aggiornata

A differenza dei modelli AI tradizionali (ChatGPT) limitati ai loro dati di addestramento, i sistemi RAG possono accedere e utilizzare le informazioni più recenti disponibili nel loro database di conoscenza.

Accuratezza migliorata e hallucinazioni ridotte

RAG migliora l’accuratezza delle risposte utilizzando informazioni concrete, aggiornate nel database di conoscenza. Questo riduce per gran parte il problema delle “allucinazioni” – casi in cui l’AI genera informazioni più plausibili ma errate.

Personalizzazione e specializzazione

Le aziende possono costruire sistemi RAG secondo le loro specifiche necessità utilizzando database di conoscenza specializzati e creando assistenti AI esperti in specifici domini.

Trasparenza e spiegabilità

I sistemi RAG spesso possono fornire le fonti delle loro informazioni, rendendo così più facile per gli utenti comprendere le fonti, verificare le affermazioni e capire il ragionamento dietro le risposte.

Scalabilità e Efficienza

RAG consente l’utilizzo efficiente delle risorse computazionali. Invece di riaddestrare in continuazione modelli grandi o costruirne di nuovi, le organizzazioni possono aggiornare le loro basi di conoscenza, rendendo così più semplice la scalabilità e la manutenzione dei sistemi AI.

Applicazioni di RAG

Servizio Clienti

RAG rende i chatbot di assistenza clienti più intelligenti e utili. Questi chatbot possono accedere alle informazioni più aggiornate dalla base di conoscenza e fornire risposte precise e contestualizzate.

Assistenti Personalizzati

Le aziende possono creare assistenti AI personalizzati che possono integrare le loro informazioni proprie e riservate. Tramite l’utilizzo dei documenti interni delle organizzazioni su politiche, procedure e altri dati, questi assistenti possono rispondere rapidamente e efficientemente alle domande degli impiegati.

Voce del Cliente

Le organizzazioni possono utilizzare RAG per analizzare e trarre insight attivi da una vasta gamma di canali di feedback clienti, permettendo di creare una comprensione completa delle esperienze, sentimenti e necessità del cliente. Questo li rende in grado di identificare e risolvere rapidamente problemi critici, prendere decisioni basate su dati e continuamente migliorare i loro prodotti sulla base di una panoramica completa del feedback clienti in tutti i touch point.

Il Futuro di RAG

RAG è diventata una tecnologia rivoluzionaria nel campo dell’intelligenza artificiale, combinando il potere di grandi modelli di linguaggio con l’integrazione dinamica di informazioni. Molte organizzazioni stanno già approfittando di questa tecnologia e stanno sviluppando soluzioni personalizzate per i loro bisogni.

guardando al futuro, RAG cambierà il modo in cui interagiamo con le informazioni e prenderemo decisioni. I futuri sistemi RAG avranno:

- Un maggior comprensione contestuale e personalizzazione migliorata

- Saranno multi-modali, superando il solo testo e incorporando immagini, audio/video

- Aggiornamenti in tempo reale del database delle conoscenze

- Integrazioni fluide con molti flussi di lavoro per aumentare la produttività e migliorare la collaborazione

Conclusione

In conclusione, RAG rivoluzionerà il modo in cui interagiamo con l’AI e le informazioni.

Tramite il colpo di grazia tra il contenuto generato dall’AI e la sua accuratezza fattuale, RAG imposterà le basi per sistemi intelligenti dell’AI che non solo saranno più capaci, ma anche più precisi e affidabili. Con l’evoluzione di questo processo, la nostra interazione con le informazioni sarà più efficiente e precisa di quanto non lo sia mai stato prima.

Source:

https://dzone.com/articles/rag-enhancing-ai-language-models