nos últimos anos, a IA fez grandes avanços, principalmente devido a modelos de linguagem grande (LLMs). Os LLMs são muito bons em entender e gerar texto humanoide, e levaram à criação de várias ferramentas novas, como bots de chat avançados e escritores de AI.

Enquanto os LLMs são ótimos para gerar texto fluente e humanoide, eles às vezes têm dificuldade em conseguir as informações corretas. Isso pode ser um problema grande quando a precisão é muito importante

Então, qual é a solução para isso? A resposta é Retrieval Augmented Generation (RAG).

O RAG integra todas as funcionalidades poderosas de modelos como o GPT e também adiciona a capacidade de procurar informações de fontes externas, como bases de dados próprias, artigos e conteúdo. Isso ajuda o AI a produzir texto que não só é bem-escrito, mas também é mais factual e contextualmente correto.

Ao combinar a capacidade de gerar texto com o poder de encontrar e usar informações precisas e relevantes, o RAG abre muitas novas possibilidades. Ele ajuda a atingir o gap entre o AI que apenas escreve texto e o AI que pode usar conhecimento real.

Neste post, vamos olhar mais de perto o RAG, como funciona, onde está sendo usado, e como isso pode mudar as nossas interações com o AI no futuro.

O que é Retrieval Augmented Generation (RAG)?

Vamos começar com uma definição formal de RAG:

Recuperação Aumentada de Geração (RAG) é um framework de IA que melhora os modelos de linguagem grande (LLMs) conectando-os com bases de conhecimento externas. Isso permite o acesso a informações atualizadas e precisas, melhorando a relevância e a precisão factual de seus resultados.

Agora, vamos simplificar para que seja fácil de entender.

Todos nós usamos bots de IA como ChatGPT no último 2 anos que podem responder às nossas perguntas. Eles são alimentados por Modelos de Linguagem Grande (LLMs), que foram treinados e construídos com grande quantidade de conteúdo/dados da internet. Eles são excelentes em produzir texto humanóides em quase qualquer tópico. Parece que são perfeitamente capazes de responder a todas as nossas perguntas, mas nem sempre é verdade. Eles às vezes partilham informações que podem não ser precisas e corretas factualmente.

É aqui que entra o RAG. Aqui é como ele funciona (em um nível muito alto):

- Você faz uma pergunta.

- O RAG procura uma base de conhecimento curadora de informações confiáveis.

- Ele recupera informações relevantes.

- Ele passa isso para o LLM.

- O LLM usa essas informações precisas para responder a você.

O resultado deste processo são respostas apoiadas por informações precisas.

Vamos entender isso com um exemplo: Imagine que você quer saber sobre a política de bagagem de um voo internacional. Um modelo tradicional de LLM como ChatGPT poderia dizer: “Tipicamente, você recebe um bagagem aéreo até 50 libras e um equipamento de mão. Mas verifique com a sua companhia aérea para detalhes.” Um sistema melhorado com RAG diria: “Para a companhia aérea X, os passageiros da classe econômica recebem um bagagem de até 50 libras e um equipamento de mão de até 17 libras. A classe negócios recebe dois bagagens de até 70 libras. Fique atento a regras especiais sobre itens como equipamento esportivo e sempre verifique na chegada.”

Apercebeu-se da diferença? O RAG fornece informações específicas e mais precisas, personalizadas para as políticas reais das companhias aéreas.

Como o RAG Funciona

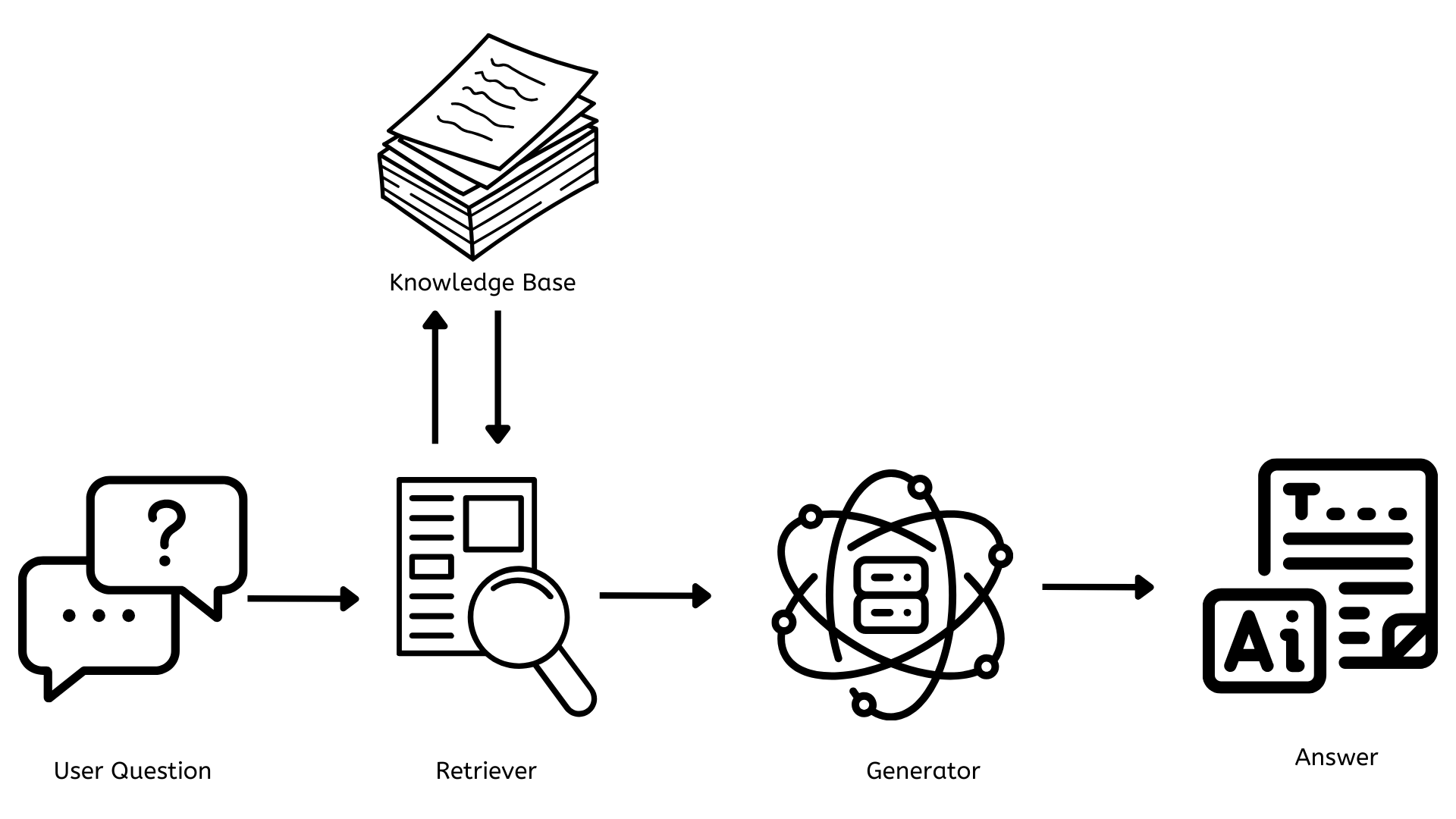

Agora que temos uma boa noção do que é o RAG, vamos entender como ele funciona. Primeiro, vamos começar com um diagrama de arquitetura simples.

Componentes Chave do RAG

Ao longo do diagrama de arquitetura acima, entre a pergunta do usuário e a resposta final para a pergunta, há 3 componentes chave que são críticos para o funcionamento do RAG.

- Base de conhecimento

- Retrator

- Gerador

Agora, vamos entender cada um deles separadamente.

Base de Conhecimento

Este é o repositório que contém todos os documentos, artigos ou dados que podem ser referenciados para responder a todas as questões. Isso precisa ser atualizado constantemente com novas informações relevantes para que as respostas sejam precisas e os usuários sejam fornecidos com a informação mais relevante e atual.

Do ponto de vista tecnológico, isso normalmente usa bancos de dados vetoriais como Pinecone, FAISS, etc., para armazenar texto como representações numéricas (embeddings), permitindo assim buscas rápidas e eficientes.

O Retorcador

Ele é responsável por encontrar documentos ou dados relevantes que estão relacionados à pergunta do usuário. Quando uma pergunta é feita, o retorcador pesquisa rápida e eficientemente pela base de conhecimento para encontrar a informação mais relevante.

Do ponto de vista tecnológico, isso frequentemente usa métodos de retorno denso, como Busca de Passagem Dense ou BM25. Esses métodos convertem as perguntas do usuário em a mesma representação numérica usada na base de conhecimento e as correspondem com informações relevantes.

O Gerador

Ele é responsável pela geração de conteúdo que é coerente e contextualmente relevante à pergunta do usuário. Ele pega a informação do retorcador e usa-a para criar uma resposta que responde à pergunta.

A partir de uma perspectiva tecnológica, isso é feito com um Modelo de Linguagem Grande (LLM) como GPT-4 ou alternativas de código aberto como LLAMA ou BERT. Esses modelos são treinados em massivos conjuntos de dados e podem gerar texto humanóide com base na entrada que recebem.

Benefícios e Aplicações do RAG

Agora que sabemos o que é o RAG e como ele funciona, vamos explorar alguns dos benefícios que ele oferece bem como as aplicações do RAG.

Benefícios do RAG

Conhecimento Atualizado

Diferentemente de modelos de IA tradicionais (ChatGPT) que estão limitados a seus dados de treinamento, sistemas RAG podem acessar e utilizar a informação mais atual disponível em sua base de conhecimento.

Aumento da Exatidão e Redução de Ilusões

O RAG melhora a exatidão das respostas usando informação factível e atualizada na base de conhecimento. Isto reduz o problema de “ilusões” em grande parte – instâncias onde a IA gera informação mais credível mas incorreta.

Customização e Especialização

Empresas podem construir sistemas RAG de acordo com suas necessidades específicas usando bases de conhecimento especializadas e criando assistentes de IA que são expertos em domínios específicos.

Transparência e Explicabilidade

Sistemas RAG frequentemente podem fornecer as fontes de suas informações, tornando mais fácil para os usuários entender as fontes, verificar as alegações e entender o raciocínio por trás das respostas.

Escala e Eficiência

O RAG permite o uso eficiente de recursos computacionais. Em vez de re-treinar modelos grandes constantemente ou construir novos, as organizações podem atualizar suas bases de conhecimento, tornando mais fácil a escala e o manutenção de sistemas AI.

Aplicações do RAG

Serviço de Cliente

O RAG torna os chatbots de suporte ao cliente mais inteligentes e úteis. Estes chatbots podem acessar a informação mais atualizada da base de conhecimento e fornecer respostas precisas e contextuais.

Assistentes Personalizados

Empresas podem criar assistentes AI personalizados que possam acessar seus dados exclusivos e próprios. Ao aproveitar os documentos internos das organizações sobre políticas, procedimentos e outros dados, esses assistentes podem responder a perguntas de funcionários rapidamente e eficientemente.

Voz do Cliente

As organizações podem usar o RAG para analisar e obter insigtes ação de uma ampla variedade de canais de feedback do cliente, permitindo criar um entendimento abrangente das experiências, sentimentos e necessidades do cliente. Isso os permite identificar e resolver issues críticas rapidamente, tomar decisões baseadas em dados e contínuamente melhorar seus produtos com base na imagem completa do feedback do cliente em todos os pontos de contato.

O Futuro do RAG

RAG emergiu como tecnologia revolucionária no campo da inteligência artificial, combinando o poder de modelos de linguagem grandes com recuperação de informação dinâmica. Muitas organizações já estão aproveitando isso e construindo soluções personalizadas para suas necessidades.

Enquanto olhamos para o futuro, o RAG vai transformar a nossa interação com informação e as nossas decisões. Sistemas futuros do RAG vão:

- Tiver um melhor entendimento contextual e personalização aprimorada

- Ser multimodal, passando além do texto e incluindo imagem, áudio/vídeo

- Tiver atualizações de base de conhecimento em tempo real

- Tiver integração fácil com muitos fluxos de trabalho para melhorar a produtividade e aumentar a colaboração

Conclusão

Em conclusão, o RAG vai revolucionar a nossa interação com AI e informação. Ao encerrar o gap entre o conteúdo gerado por AI e sua precisão factual, o RAG vai criar o palco para sistemas inteligentes de AI que não são apenas capazes mas também mais precisos e confiáveis. Como isso continua a evoluir, nossa interação com informação será mais eficiente e precisa do que nunca.

Source:

https://dzone.com/articles/rag-enhancing-ai-language-models