En los últimos años, la IA ha logrado grandes avances, principalmente debido a los grandes modelos de lenguaje (LLMs). Los LLMs son muy buenos para entender y generar texto similar a humano, y han llevado a la creación de varias herramientas nuevas, como chatbots avanzados y escritores de AI.

Aunque los LLMs son excelentes para generar texto fluido y similar a humano, a veces tienen dificultades para conseguir las cosas correctas. Esto puede ser un gran problema cuando la precisión es realmente importante

¿Cuál es la solución para esto? La respuesta es Retrieval Augmented Generation (RAG).

RAG integra todas las características poderosas de los modelos como GPT y además agrega la capacidad de buscar información de fuentes externas, como bases de datos propietarias, artículos y contenido. Esto ayuda a la IA para producir texto que no solo está bien escrito sino que también es más preciso y contextualmente correcto.

Al combinar la capacidad de generar texto con el poder de buscar y usar información exacta y relevante, RAG abre muchas nuevas posibilidades. Ayuda a reducir la brecha entre la IA que solo escribe texto y la IA que puede usar conocimientos reales.

En este post, exploraremos más de cerca RAG, cómo funciona, dónde se utiliza y cómo podría cambiar nuestras interacciones con la IA en el futuro.

¿Qué es Retrieval Augmented Generation (RAG)?

Vamos con una definición formal de RAG:

La Retrieval Augmented Generation (RAG) es un marco de AI que mejora los modelos de lenguaje grande (LLMs) conectándolos con bases de conocimiento externas. Esto permite el acceso a información actualizada y precisa, mejorando la relevancia y la precisión factual de sus resultados.

Ahora, vamos a descomponer esto en lenguaje sencillo para que sea fácil de entender.

Todos hemos utilizado chatbots de IA como ChatGPT en los últimos 2 años que pueden responder a nuestras preguntas. Estos están impulsados por modelos de lenguaje grande (LLMs), que fueron entrenados y construidos sobre grandes cantidades de contenido/datos de internet. Son excelentes para producir texto humanoide en casi cualquier tema. Parece que están perfectamente capaces de responder a todas nuestras preguntas, pero eso no es exactamente cierto todo el tiempo. A veces comparten información que puede no ser precisa y correcta facturalmente.

Esto es donde entra en juego RAG. Aquí es cómo funciona (a un nivel muy alto):

- Usted hace una pregunta.

- RAG busca una base de conocimiento curada de información confiable.

- Recupera información relevante.

- La pasa al LLM.

- El LLM utiliza esta información precisa para responderle a usted.

El resultado de este proceso son respuestas respaldadas por información precisa.

Vamos a entender esto con un ejemplo: Imagina que quieres saber acerca de la asignación de equipaje para un vuelo internacional. Un modelo de LLM tradicional como ChatGPT podría decir: “Típicamente, te dan un equipaje de embarque hasta 50 libras y un equipaje de mano. Pero verifica con tu aerolínea para especificaciones.” Un sistema mejorado con RAG diría: “Para la aerolínea X, los pasajeros de economía obtienen un equipaje de embarque de hasta 50 libras y un equipaje de mano de 17 libras. Los pasajeros de clase negocios obtienen dos equipajes de hasta 70 libras. Ten cuidado con las reglas especiales sobre artículos como el equipo deportivo y siempre verifica en el registro de embarque.”

¿Observaste la diferencia? RAG proporciona información específica y más precisa adaptada a las políticas reales de las aerolíneas. En resumen, RAG hace que estos sistemas sean más confiables y fiables. Es muy importante en el desarrollo de sistemas de IA que sean más dependibles para aplicaciones reales.

Cómo funciona RAG

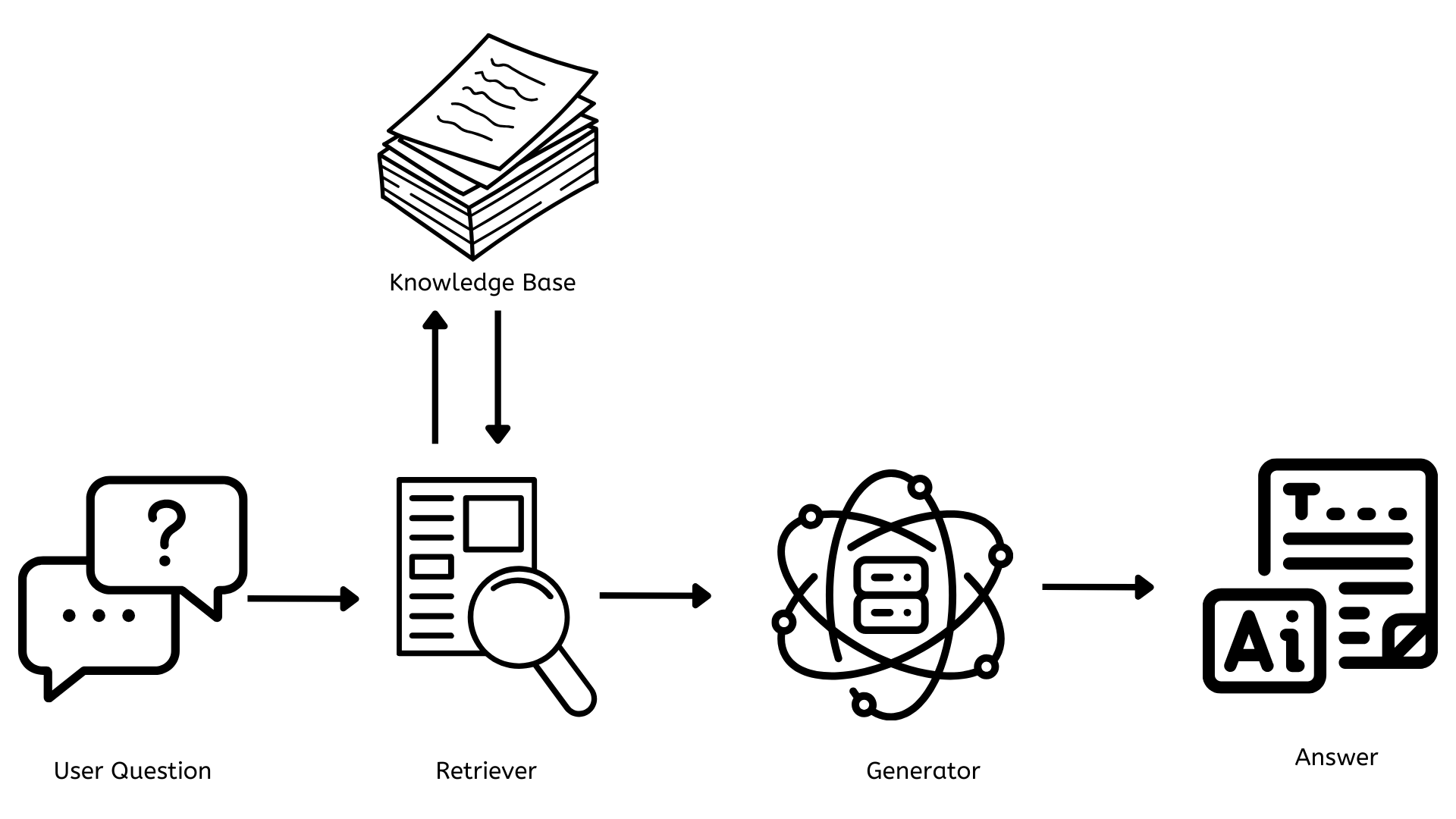

Ahora que tenemos una buena idea de qué es RAG, vamos a entender cómo funciona. Primero, vamos a empezar con un diagrama de arquitectura simple.

Los Componentes Clave de RAG

Desde el diagrama de arquitectura anterior, entre la pregunta del usuario y la respuesta final a la pregunta, hay 3 componentes clave que son cruciales para que RAG funcione.

- Base de conocimiento

- Retriever

- Generador

Ahora, vamos a entender cada uno uno a la vez.

La Base de Conocimiento

Este es el repositorio que contiene todos los documentos, artículos o datos que se pueden referenciar para responder a todas las preguntas. Esto necesita ser actualizado constantemente con información nueva y relevante para que las respuestas sean precisas y se brinden a los usuarios la información más relevante y actualizada.

Desde una perspectiva tecnológica, esto normalmente utiliza base de datos vectoriales como Pinecone, FAISS, etc., para almacenar texto como representaciones numéricas (embebidas), lo que permite búsquedas rápidas y eficientes.

El Buscador

Este es responsable de encontrar documentos o datos relevantes que están relacionados con la pregunta del usuario. Cuando se hace una pregunta, el buscador rápidamente busca a través de la base de conocimiento para encontrar la información más relevante.

Desde una perspectiva tecnológica, esto a menudo utiliza métodos de búsqueda denso, como la Búsqueda de Pasajes Densos o BM25. Estos métodos convierten las preguntas del usuario en el mismo tipo de representación numérica utilizada en la base de conocimiento y las matchean con información relevante.

El Generador

Este es responsable de generar contenido que sea coherente y contextualmente relevante a la pregunta del usuario. Toma la información del buscador y la utiliza para elaborar una respuesta que responda a la pregunta.

Desde una perspectiva tecnológica, esto está impulsado por un Modelo de Lenguaje Grande (LLM) como GPT-4 o alternativas de código abierto como LLAMA o BERT. Estos modelos se entrenan en conjuntos de datos masivos y pueden generar texto humanoide basado en la entrada que reciben.

Beneficios y Aplicaciones de RAG

Ahora que sabemos qué es RAG y cómo funciona, vamos a explorar algunos de los beneficios que ofrece así como aplicaciones de RAG.

Beneficios de RAG

Conocimiento Actualizado

A diferencia de los modelos de AI tradicionales (ChatGPT) que están limitados a sus datos de entrenamiento, los sistemas RAG pueden acceder y utilizar la información más actual disponible en su base de conocimiento.

Mejor Precisión y Reducción de la Ilusión

RAG mejora la precisión de las respuestas utilizando información factual y actualizada en la base de conocimiento. Esto reduce en gran medida el problema de las ilusiones – casos en los que la AI genera información más plausible pero incorrecta.

Personalización y Especialización

Las empresas pueden construir sistemas RAG según sus necesidades específicas utilizando bases de conocimiento especializadas y creando asistentes de AI que son expertos en dominios específicos.

Transparencia y Explicabilidad

Los sistemas RAG a menudo pueden proporcionar las fuentes de su información, lo que facilita a los usuarios comprender las fuentes, verificar las afirmaciones y entender la lógica detrás de las respuestas.

Escalabilidad y Eficiencia

RAG permite el uso eficiente de recursos computacionales. En lugar de reentrenar constantemente modelos grandes o construir nuevos modelos, las organizaciones pueden actualizar sus bases de conocimiento, lo que facilita la escalabilidad y el mantenimiento de los sistemas de AI.

Aplicaciones de RAG

Servicio al Cliente

RAG hace que los chatbots de soporte al cliente sean más inteligentes y útiles. Estos chatbots pueden acceder a la información más actualizada de la base de conocimiento y proporcionar respuestas precisas y contextuales.

Asistentes Personalizados

Las empresas pueden crear asistentes de AI personalizados que pueden acceder a sus datos propios y exclusivos. Al aprovechar los documentos internos de la organización sobre políticas, procedimientos y otros datos, estos asistentes pueden responder rápidamente y eficientemente a las preguntas de los empleados.

Voz del Cliente

Las organizaciones pueden utilizar RAG para analizar y extraer insights acciónables de una amplia gama de canales de retroalimentación del cliente que permiten crear una comprensión completa de las experiencias, sentimientos y necesidades del cliente. Esto les permite identificar y abordar rápidamente problemas críticos, tomar decisiones basadas en datos y mejorar continuamente sus productos según una imagen completa de la retroalimentación del cliente en todos los puntos de contacto.

El Futuro de RAG

RAG ha emergido como una tecnología revolucionaria en el campo de la inteligencia artificial, combinando el poder de los grandes modelos de lenguaje con la recuperación de información dinámica. muchas organizaciones ya están aprovechando esto y construyendo soluciones personalizadas para sus necesidades.

Mirando al futuro, RAG va a transformar la manera en que interactuamos con la información y toma decisiones. Los futuros sistemas RAG serán:

- Tengan un mejor entendimiento contextual y personalización avanzada

- Sean multimodales al superar solo el texto e incluir imagen, audio/video

- Tengan actualizaciones de base de conocimiento en tiempo real

- Tengan una integración fluida con muchos flujos de trabajo para mejorar la productividad y Enhance collaboration

Conclusión

En conclusión, RAG va a revolucionar cómo interactuamos con la IA y la información. Al reducir el espacio entre el contenido generado por AI y su exactitud factual, RAG va a poner la base para sistemas inteligentes de AI que no solo sean más capaces sino también más precisos y confiables. Con la evolución de esto, nuestra participación con la información será más eficiente y precisa que nunca antes.

Source:

https://dzone.com/articles/rag-enhancing-ai-language-models