今天的大型虛擬基礎設施產生了大量的數據。這導致了備份數據的增加以及在備份存儲基礎設施上的支出增加,其中包括存儲設備及其維護。因此,網絡管理員尋找在頻繁備份關鍵機器和應用程序時節省存儲空間的方法。

其中一種廣泛使用的技術是備份去重。本博客文章涵蓋了什麼是數據去重,去重類型以及重點在於備份的用例。

什麼是去重?

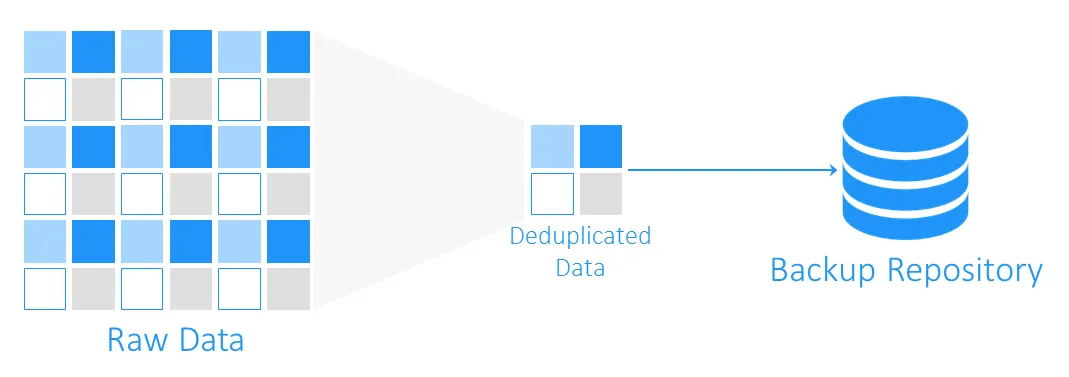

數據去重是一種存儲容量優化技術。數據去重涉及讀取源數據和已存儲的數據,以轉移或僅保存唯一的數據塊。重複數據的引用被維護。通過使用此技術來避免卷上的重複,您可以節省磁盤空間並減少存儲開銷。

數據去重的起源

數據去重的前身是分別於1977年和1978年引入的LZ77和LZ78壓縮算法。它們涉及將重複的數據序列替換為對原始數據的引用。

這一概念影響了其他流行的壓縮方法。其中最著名的是DEFLATE,它用於PNG圖像和ZIP文件格式。現在讓我們看看去重在虛擬機器備份中是如何工作的,以及它如何幫助節省存儲空間和基礎設施支出成本。

什麼是備份中的去重?

在備份過程中,資料去重檢查源存儲和目標備份存儲之間的相同資料塊。重複的內容不會被複製,而是在目標備份存儲中創建對現有資料塊的引用或指針。

資料去重可以為您節省多少空間?

要了解通過去重可以節省多少存儲空間,讓我們考慮一個例子。安裝Windows Server 2016的最低系統要求至少是32 GB的可用磁盤空間。如果您有十個運行此操作系統的虛擬機器,備份至少將達到320 GB,這僅僅是一個乾淨的操作系統,沒有任何應用程序或數據庫。

如果您需要部署多個具有相同系統的虛擬機器(VM),您可能會使用模板,這意味著最初您將擁有十個相同的機器。這也意味著您將獲得10組重複的資料塊。在這個例子中,您將擁有10:1的存儲空間節省比率。一般來說,5:1至10:1的節省被認為是很好的。

資料去重比率

數據重複消除比率是一種用於衡量原始數據大小與去除冗餘部分後數據大小之間的指標。這個指標可以讓您評估數據重複消除過程的效果。要計算這個值,您應該將重複消除之前的數據量除以經過重複消除後這些數據所佔用的存儲空間。

例如,5:1的重複消除比率意味著您可以在備份存儲中存儲比不經過重複消除所需存儲的數據多五倍的數據。

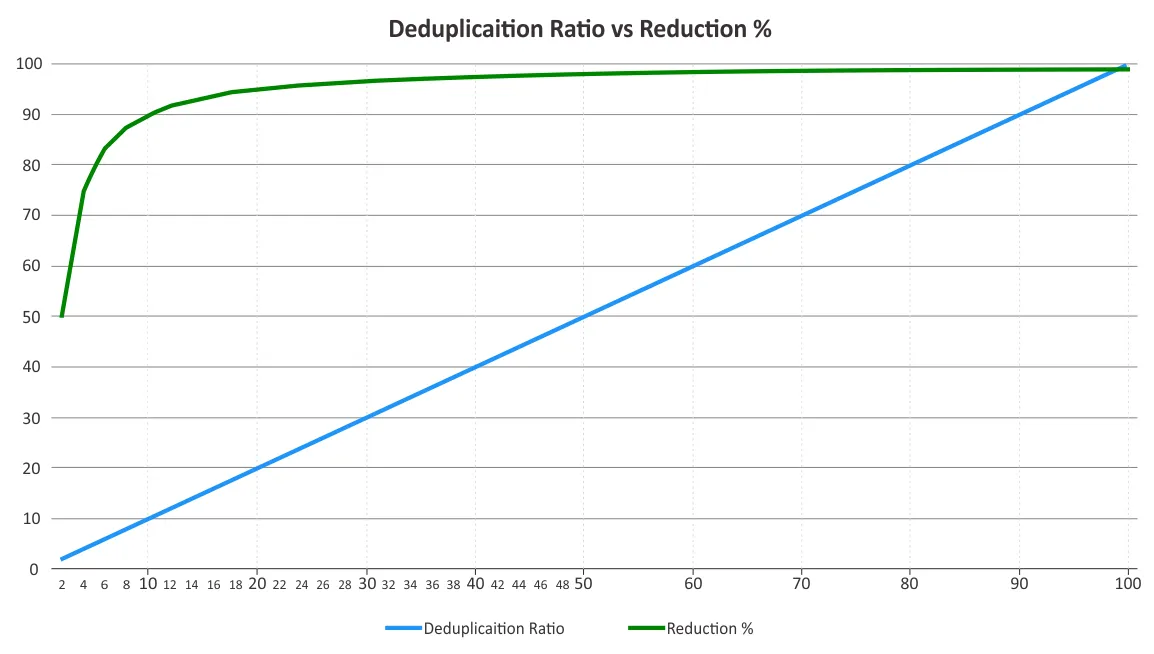

您應該確定重複消除比率和存儲空間減少。這兩個參數有時會混淆。重複消除比率不會與數據減少效益成比例地變化,因為在某一點之後,遞減收益的法則必然會發揮作用。請參見下面的圖表。

這意味著較低的比率可能帶來比較高的節省,而不是較高的比率。例如,50:1的重複消除比率並不比10:1的比率好五倍。10:1的比率可以將所消耗的存儲空間減少90%,而50:1的比率則將這個值增加到98%,考慮到大部分冗餘已經被消除。有關這些百分比是如何計算的更多信息,您可以參考存儲網絡行業協會(SNIA)關於數據重複消除的文件。

影響數據重複消除效率的因素

數據去重效率很難預測,直到實際去重數據時才能確定,這是由於幾個因素。以下是在使用去重時影響數據減少的一些因素:

- 數據備份類型和策略。對於完整備份,去重效果比增量或差異備份更有效。

- 變更率。如果有許多數據變更需要備份,那麼去重比例就會降低。

- 保留設置。您在備份存儲中存儲數據備份的時間越長,則該存儲上的數據去重效果就越好。

- 數據類型。對於已經壓縮數據的文件,如JPG、PNG、MPG、AVI、MP4、ZIP、RAR等,去重效果不佳。對於元數據豐富和加密數據也是如此。包含重複部分的數據類型更適合去重。

- 數據範圍。對於大範圍的數據,數據去重效果更好。全局去重可以節省比本地去重更多的存儲空間。

注意: 本機重複刪除僅在單一節點/磁碟裝置上運作。全域重複刪除會分析所有節點/磁碟裝置上的完整資料集,以消除資料重複。如果您有多個已啟用本機重複刪除的節點,與其為這些節點啟用全域重複刪除相比,重複刪除效率會降低。

- 軟體和硬體。 結合軟體解決方案和重複刪除硬體可以提供比僅使用軟體更好的重複刪除率。例如,NAKIVO 的備份解決方案可與 HP StoreOnce、Dell EMC Data Domain 和 NEC HYDRAstor 重複刪除設備整合,提供高達 17:1 的重複刪除率。

備份重複刪除技術

可根據以下準則將備份重複刪除技術分類:

- 重複資料刪除的位置

- 執行重複刪除的時間

- 重複刪除的方式

重複資料刪除的位置

備份重複刪除可以在來源端或目標端執行,這些技術分別稱為來源端重複刪除和目標端重複刪除。

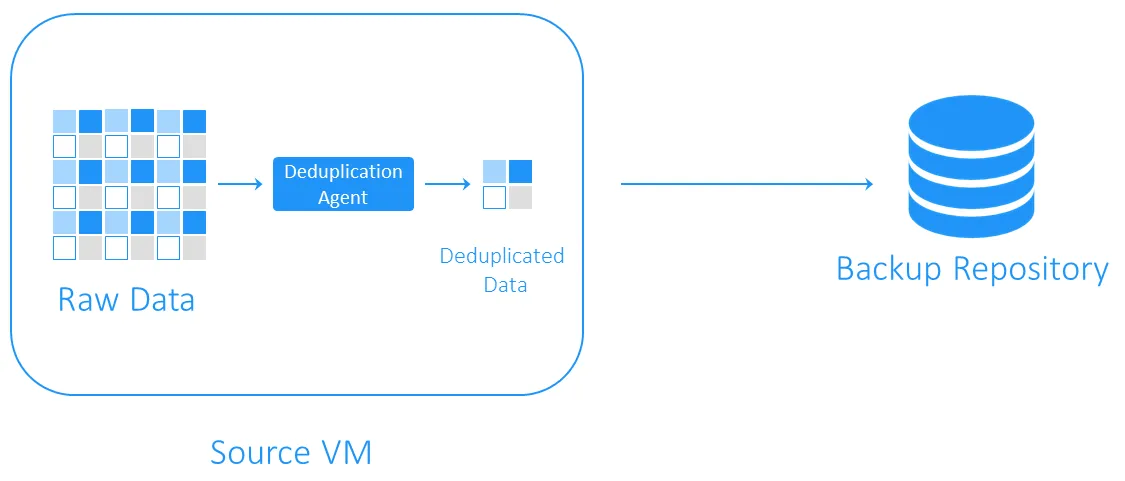

來源端重複刪除

來源端重複資料刪除降低了網路負載,因為在備份過程中傳輸的資料減少。然而,它需要在每個虛擬機器或每台主機上安裝一個重複資料刪除代理。另一個缺點是,來源端重複資料刪除可能會由於識別重複資料塊而減慢虛擬機器的運行速度,需要進行計算。

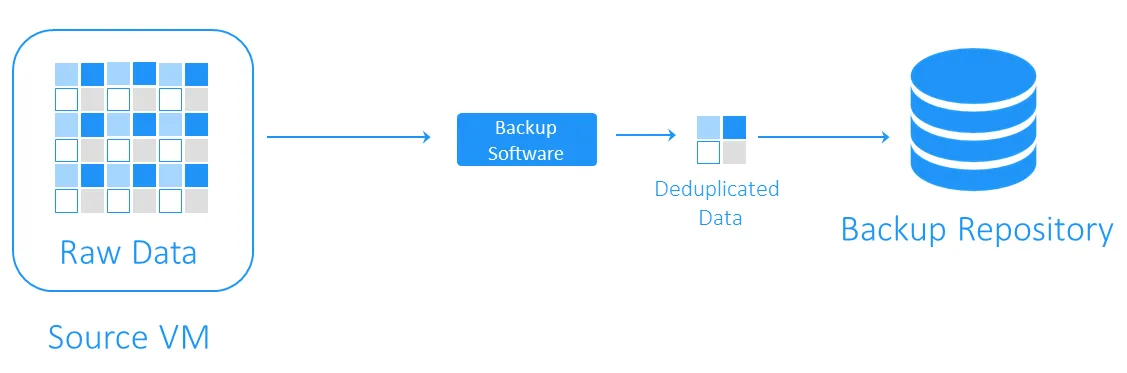

目標端重複資料刪除

目標端重複資料刪除首先將資料傳輸到備份存儲庫,然後執行重複資料刪除。重複資料刪除的軟體負責執行繁重的計算任務。

資料重複刪除的執行方式

備份重複資料刪除可以是即時執行或後置處理。

- 即時執行的重複資料刪除在將資料寫入備份存儲庫之前檢查資料的重複。這種技術需要較少的備份存儲空間,因為它消除了備份數據流中的冗余,但會導致備份時間較長,因為即時執行的重複資料刪除發生在備份作業期間。

- 後置處理的重複資料刪除在將資料寫入備份存儲庫後處理資料。顯然,這種方法需要存儲庫中有更多的可用空間,但備份運行速度較快,所有必要的操作都在之後進行。後置處理的重複資料刪除也被稱為非同步重複資料刪除。

資料重複刪除的執行方式

識別重複資料的最常見方法是基於哈希和修改後的基於哈希的方法。

- 使用基於哈希的方法,去重複軟件將數據分為固定或可變長度的塊,並使用MD5、SHA-1或SHA-256等加密算法為每個塊計算哈希。這些方法中的每一個均產生數據塊的唯一指紋,因此具有相似哈希的塊被認為是相同的。這種方法的缺點是可能需要大量的計算資源,特別是在進行大型備份時。

- 修改後的基於哈希的方法使用較簡單的哈希生成算法,如CRC,僅生成16位(與SHA-256中的256位相比)。然後,如果塊具有相似的哈希,它們將逐字節進行比較。如果它們完全相同,則將這些塊視為相同。這種方法比基於哈希的方法稍慢,但需要更少的計算資源。

選擇備份去重複軟件

備份去重複是去重複的最受歡迎的用例之一。但是,您需要適當的軟件解決方案和存儲硬件來實施這種數據減少技術。

NAKIVO備份與複製是一個支持使用全球目標後處理去重複的備份解決方案,具有修改後的基於哈希的重複檢測。您還可以利用源端去重複,通過集成去重複設備,如DELL EMC Data Domain with DD Boost、NEC HYDRAstor和HP StoreOnce with Catalyst支持與NAKIVO解決方案。

Source:

https://www.nakivo.com/blog/backup-deduplication-explained/