Les infrastructures virtuelles d’aujourd’hui génèrent une quantité considérable de données. Cela entraîne une augmentation des données de sauvegarde et des dépenses liées à l’infrastructure de stockage de sauvegarde, comprenant les appareils de stockage et leur maintenance. Pour cette raison, les administrateurs réseau recherchent des moyens d’économiser de l’espace de stockage lors de la création de sauvegardes fréquentes des machines et des applications critiques.

Une des techniques largement utilisées est la déduplication des sauvegardes. Cet article de blog couvre ce qu’est la déduplication des données, les types de déduplication et les cas d’utilisation en mettant l’accent sur les sauvegardes.

Qu’est-ce que la déduplication?

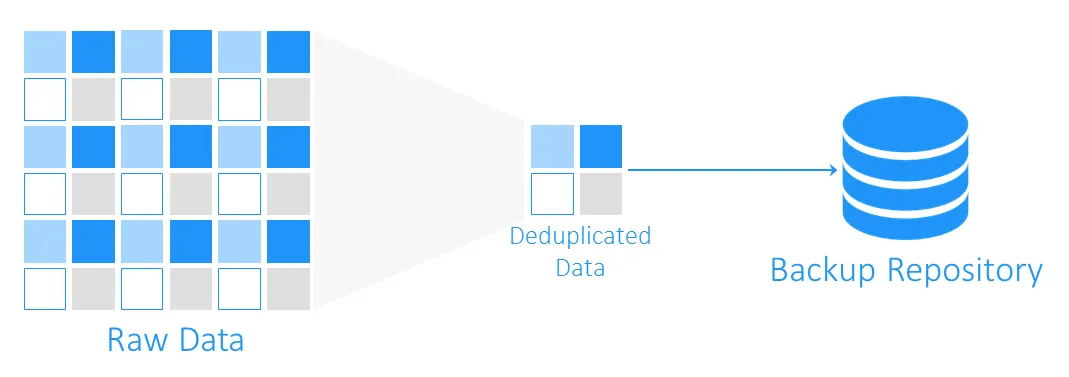

La déduplication des données est une technologie d’optimisation de la capacité de stockage. Elle consiste à lire les données sources et les données déjà stockées pour transférer ou sauvegarder uniquement des blocs de données uniques. Les références aux données en double sont conservées. En utilisant cette technologie pour éviter les doublons sur un volume, vous pouvez économiser de l’espace disque et réduire les frais de stockage.

Origines de la déduplication des données

Les prédécesseurs de la déduplication des données sont les algorithmes de compression LZ77 et LZ78 introduits respectivement en 1977 et 1978. Ils consistent à remplacer les séquences de données répétées par des références aux originaux.

Ce concept a influencé d’autres méthodes de compression populaires. La plus connue d’entre elles est DEFLATE, utilisée dans les formats d’image PNG et les fichiers ZIP. Voyons maintenant comment fonctionne la déduplication avec les sauvegardes VM et en quoi elle aide précisément à économiser de l’espace de stockage et des coûts liés à l’infrastructure.

Qu’est-ce que la déduplication dans les sauvegardes?

Pendant une sauvegarde, la déduplication des données vérifie les blocs de données identiques entre le stockage source et le référentiel de sauvegarde cible. Les doublons ne sont pas copiés, et une référence, ou un pointeur, vers les blocs de données existants dans le stockage de sauvegarde cible est créé.

Combien d’espace la déduplication des données peut-elle vous faire économiser?

Pour comprendre combien d’espace de stockage peut être gagné avec la déduplication, considérons un exemple. Les exigences système minimales pour l’installation de Windows Server 2016 sont d’au moins 32 Go d’espace disque libre. Si vous avez dix VM exécutant ce système d’exploitation, les sauvegardes totaliseront au moins 320 Go, et il s’agit simplement d’un système d’exploitation propre sans aucune application ou base de données dessus.

Il est probable que si vous avez besoin de déployer plus d’une machine virtuelle (VM) avec le même système, vous utiliserez un modèle, ce qui signifie qu’initialement, vous aurez dix machines identiques. Et cela signifie aussi que vous obtiendrez 10 ensembles de blocs de données dupliqués. Dans cet exemple, vous aurez un ratio d’économie d’espace de stockage de 10:1. En général, des économies allant de 5:1 à 10:1 sont considérées comme bonnes.

Taux de Déduplication des Données

Le taux de déduplication des données est une mesure utilisée pour évaluer la taille des données originales par rapport à la taille des données après la suppression des parties redondantes. Cette mesure vous permet d’évaluer l’efficacité du processus de déduplication des données. Pour calculer la valeur, vous devez diviser la quantité de données avant la déduplication par l’espace de stockage consommé par ces données après déduplication.

Par exemple, un taux de déduplication de 5:1 signifie que vous pouvez stocker cinq fois plus de données sauvegardées dans votre stockage de sauvegarde que ce qui est nécessaire pour stocker les mêmes données sans déduplication.

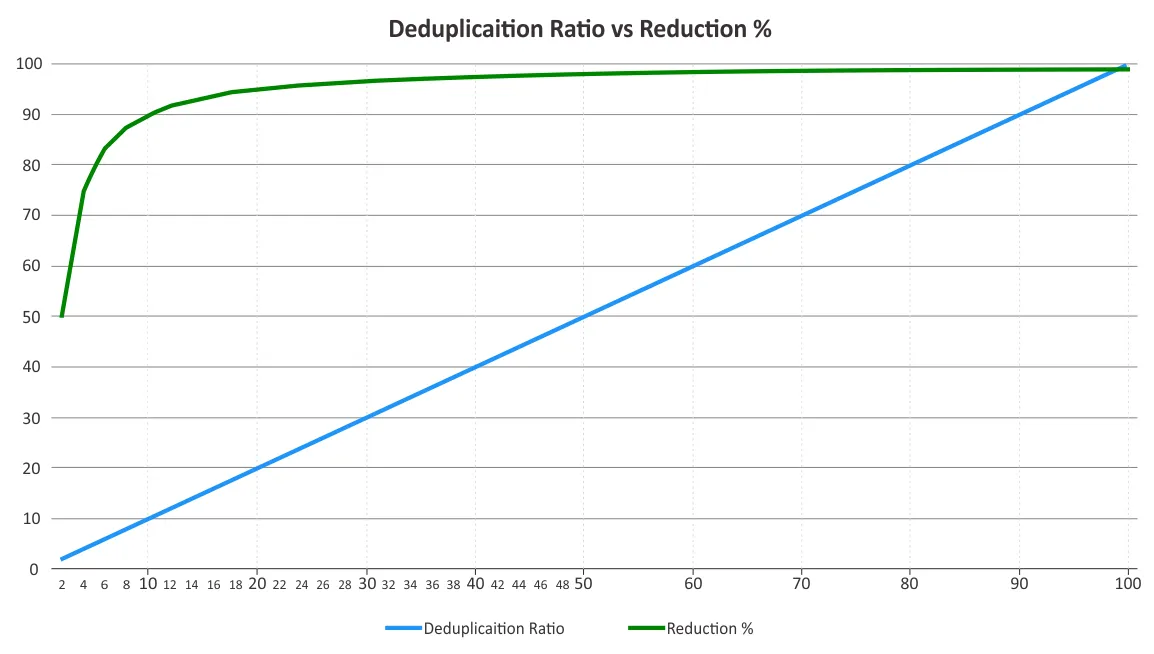

Vous devez déterminer le taux de déduplication et la réduction de l’espace de stockage. Ces deux paramètres sont parfois confondus. Les taux de déduplication ne changent pas proportionnellement aux avantages de réduction des données, car la loi des rendements décroissants est appelée à entrer en jeu au-delà d’un certain point. Voir le graphique ci-dessous.

Cela signifie que les ratios plus bas peuvent apporter des économies plus significatives que les ratios plus élevés. Par exemple, un ratio de déduplication de 50:1 n’est pas cinq fois meilleur qu’un ratio de 10:1. Le ratio de 10:1 permet une réduction de 90 % de l’espace de stockage consommé, tandis que le ratio de 50:1 augmente cette valeur à 98 %, étant donné que la plupart de la redondance a déjà été éliminée. Pour plus d’informations sur la façon dont ces pourcentages sont calculés, vous pouvez consulter le document de l’Association de l’industrie du stockage en réseau (SNIA) sur la déduplication des données.

Les facteurs qui influent sur l’efficacité de la déduplication des données

Il est difficile de prédire l’efficacité de la réduction des données avant que les données ne soient effectivement dédupliquées en raison de plusieurs facteurs. Voici quelques-uns des facteurs qui ont un impact sur la réduction des données lors de l’utilisation de la déduplication:

- Types et politiques de sauvegarde de données. La déduplication pour les sauvegardes complètes est plus efficace que pour les sauvegardes incrémentielles ou différentielles.

- Taux de changement. Si de nombreuses modifications de données doivent être sauvegardées, le taux de déduplication est plus faible.

- Paramètres de rétention. Plus vous stockez les sauvegardes de données dans le stockage de sauvegarde, plus efficace peut être la déduplication des données sur ce stockage.

- Type de données. La déduplication pour les fichiers dans lesquels les données ont déjà été compressées, telles que JPG, PNG, MPG, AVI, MP4, ZIP, RAR, etc., n’est pas efficace. Il en va de même pour les données riches en métadonnées et chiffrées. Les types de données contenant des parties répétitives sont mieux adaptés à la déduplication.

- Portée des données. La déduplication des données est plus efficace pour une large portée de données. La déduplication globale peut économiser plus d’espace de stockage par rapport à la déduplication locale.

Remarque: La déduplication locale fonctionne sur un seul nœud/disque. La déduplication globale analyse l’ensemble des données sur tous les nœuds/disques pour éliminer les doublons de données. Si vous avez plusieurs nœuds avec la déduplication locale activée sur chacun d’eux, la déduplication ne serait pas aussi efficace que si la déduplication globale était activée pour eux.

- Logiciel et matériel. Combiner des solutions logicielles et du matériel de déduplication peut offrir de meilleurs ratios de déduplication que le logiciel seul. Par exemple, la solution de sauvegarde de NAKIVO offre une intégration avec les appareils de déduplication HP StoreOnce, Dell EMC Data Domain, et NEC HYDRAstor pour des ratios de déduplication allant jusqu’à 17:1.

Techniques de déduplication de sauvegarde

Les techniques de déduplication de sauvegarde peuvent être catégorisées en fonction de ce qui suit:

- Où la déduplication des données est effectuée

- Quand la déduplication est effectuée

- Comment la déduplication est effectuée

Où la déduplication des données est effectuée

La déduplication de sauvegarde peut être effectuée côté source ou côté cible, et ces techniques sont appelées respectivement déduplication côté source et déduplication côté cible.

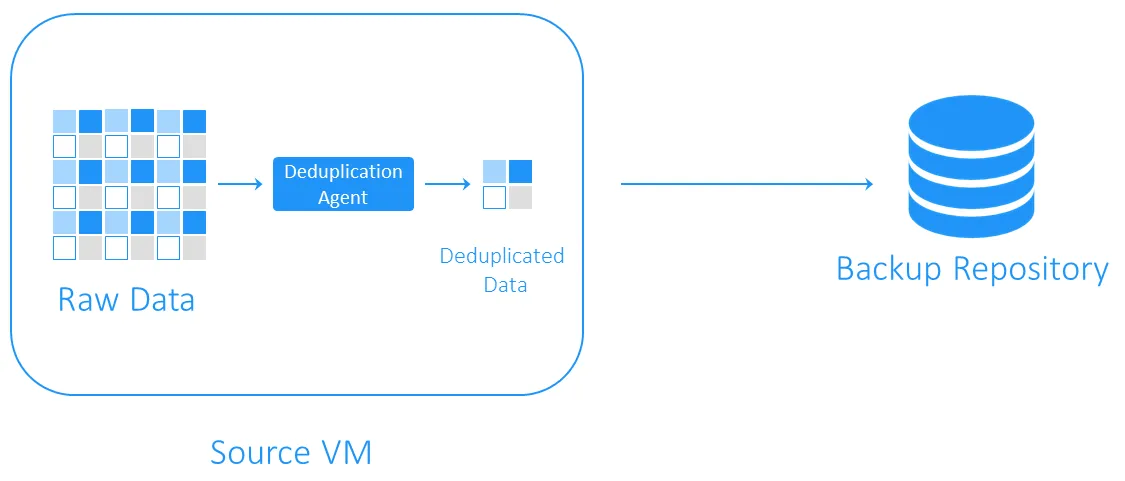

Déduplication côté source

La déduplication côté source réduit la charge réseau car moins de données sont transférées pendant la sauvegarde. Cependant, elle nécessite un agent de déduplication installé sur chaque VM ou sur chaque hôte. L’autre inconvénient est que la déduplication côté source peut ralentir les VMs en raison des calculs nécessaires pour identifier les blocs de données duplicatifs.

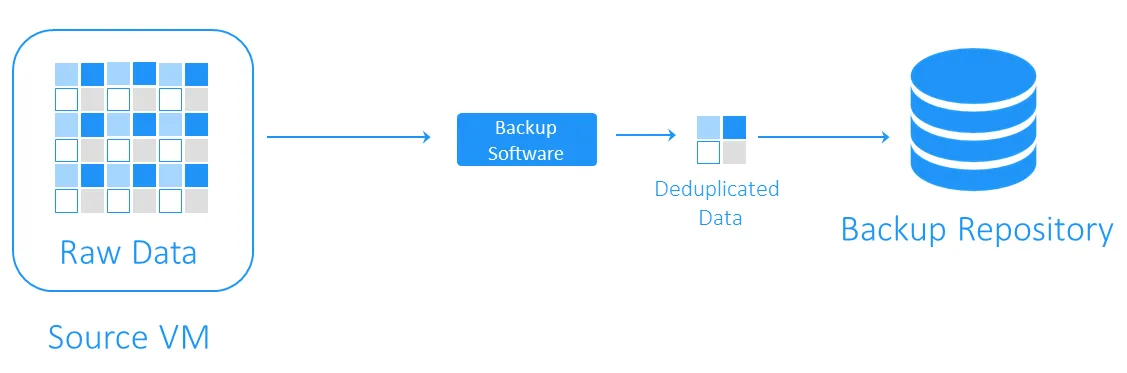

La déduplication côté cible

La déduplication côté cible transfère d’abord les données vers le dépôt de sauvegarde et effectue ensuite la déduplication. Les tâches de calcul intensives sont exécutées par le logiciel responsable de la déduplication.

Lorsque la déduplication des données est effectuée

La déduplication de la sauvegarde peut être en ligne ou post-traitement.

- La déduplication en ligne vérifie les duplicats de données avant qu’elles ne soient écrites dans un dépôt de sauvegarde. Cette technique nécessite moins d’espace de stockage dans le dépôt de sauvegarde car elle nettoie le flux de données de la sauvegarde des redondances, mais elle entraîne un temps de sauvegarde plus long car la déduplication en ligne se produit pendant le job de sauvegarde.

- La déduplication post-traitement traite les données après qu’elles aient été écrites dans le dépôt de sauvegarde. Il est évident que cette approche nécessite davantage d’espace libre dans le dépôt, mais les sauvegardes fonctionnent plus rapidement et toutes les opérations nécessaires sont effectuées ultérieurement. La déduplication post-traitement est également appelée déduplication asynchrone.

Comment la déduplication des données est effectuée

Les méthodes les plus communes pour identifier les duplicats sont les méthodes basées sur les hachages et les modifications d’hachages.

- Avec la méthode basée sur le hachage, le logiciel de déduplication divise les données en blocs de longueur fixe ou variable et calcule un hachage pour chacun d’eux en utilisant des algorithmes cryptographiques tels que MD5, SHA-1 ou SHA-256. Chacune de ces méthodes donne une empreinte unique des blocs de données, de sorte que les blocs avec des hachages similaires sont considérés comme identiques. L’inconvénient de cette méthode est qu’elle peut nécessiter des ressources informatiques importantes, en particulier dans le cas de sauvegardes volumineuses.

- La méthode de hachage modifiée utilise des algorithmes de hachage plus simples tels que CRC, qui ne produisent que 16 bits (par rapport à 256 bits dans SHA-256). Ensuite, si les blocs ont des hachages similaires, ils sont comparés octet par octet. S’ils sont totalement similaires, les blocs sont considérés comme identiques. Cette méthode est un peu plus lente que la méthode basée sur le hachage mais nécessite moins de ressources informatiques.

Choisir un logiciel de déduplication de sauvegarde

La déduplication de sauvegarde est l’un des cas d’utilisation les plus populaires de la déduplication. Cependant, vous devez disposer d’une solution logicielle appropriée et d’un matériel de stockage pour mettre en œuvre cette technologie de réduction des données.

NAKIVO Backup & Replication est une solution de sauvegarde qui prend en charge l’utilisation de la déduplication de post-traitement cible mondiale avec la détection de doublons basée sur le hachage modifié. Vous pouvez également tirer parti de la déduplication côté source en intégrant un appareil de déduplication tel que DELL EMC Data Domain avec DD Boost, NEC HYDRAstor et HP StoreOnce avec le support de Catalyst avec la solution NAKIVO.

Source:

https://www.nakivo.com/blog/backup-deduplication-explained/