管理サービスプロバイダー(MSP)にとって、高性能でスケーラブルなネットワークの構築は基盤となる成功の要素です。以前のブログ投稿で、基本的なネットワークトポロジータイプについて取り上げましたが、この投稿では、サービスプロバイダーにとってより複雑なネットワークトポロジータイプを、MSPネットワーク向けに好まれるものを含めて検討します。このブログ投稿を読んで、MSPデータセンターに最適なネットワークトポロジーが何であり、その理由を知りましょう。

従来の3層階層型ネットワーク

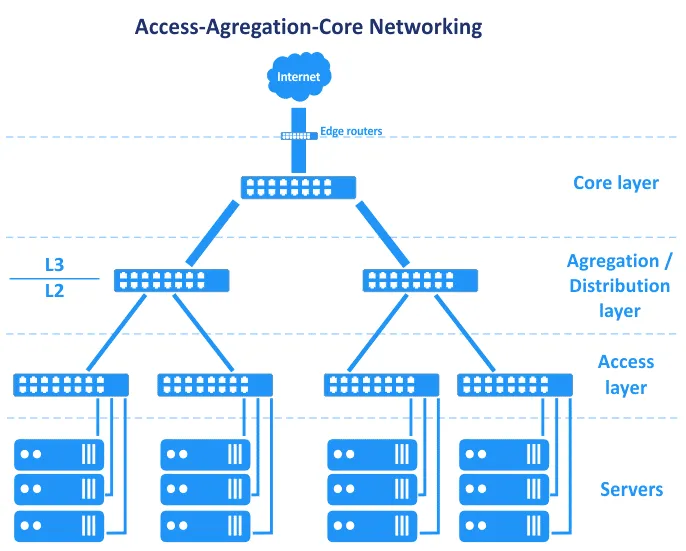

ソフトウェア定義ネットワークが一般的になる前、データセンターのネットワークは階層ツリーネットワークトポロジーに基づいていました。このトポロジーは、主に3つのレイヤーに分かれています:コアレイヤー、集約または配布レイヤー、およびアクセスレイヤー。このトポロジーでは、サーバーはアクセスレイヤーのスイッチに接続されます。エッジルーターはコアに接続され、WAN(広域ネットワーク)およびインターネットへのアクセスを提供します。これらのルーターは、以下のスキームのコアとインターネットの間に配置されます。

OSI(オープンシステムインターコネクション)モデルの観点では、ネットワークをデータリンクレイヤー(L2)やネットワークレイヤー(L3)などに分割しますが、アクセス-集約-コアネットワークトポロジーは、グラフィックで見られるように、レイヤーをまたいでいます。

それでは、これらの3つのレイヤーを順番に見てみましょう。

コアレイヤー

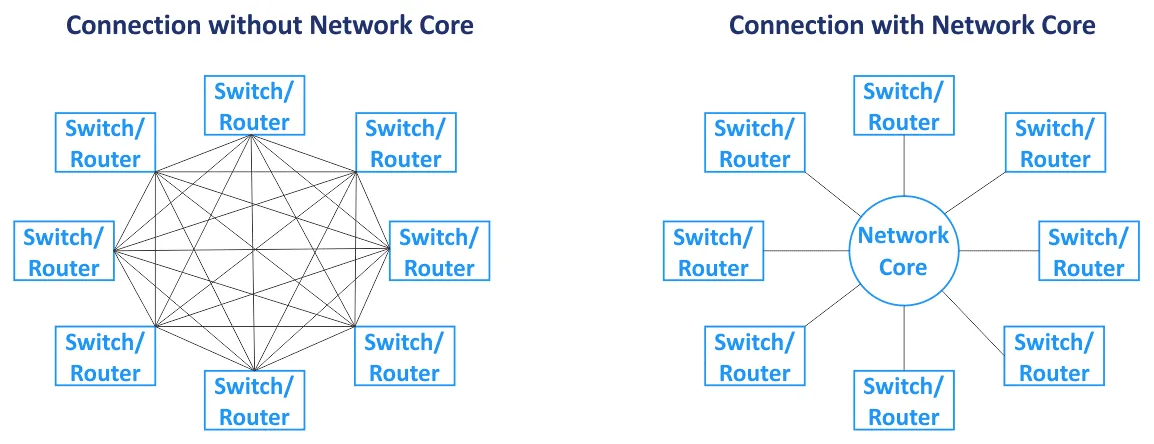

ネットワークコア(またはコアネットワークとも呼ばれます)は、ネットワーク全体の中心的なコンポーネントです。主要ノードはコアに接続されています。コアネットワークは通常、メッシュネットワークトポロジに基づいており、コア内のすべてのノードがお互いに接続されています(完全メッシュネットワークトポロジタイプの場合)。ネットワークコアのスイッチとルーターは、高速リンク(バックボーン接続とも呼ばれる)で相互接続されています。ネットワークコアではルーターが使用されるため、コア層はL3トラフィックで動作します。

配布/集約層

これは、下位層のアクセス層(L2で動作する)からネットワークコア層(通常はL3で動作する)に向けたアップリンクを集約する中間層です。分配層は、多数の低速ポートと少数の高速トランクポートを組み合わせています。このネットワークトポロジの配布/集約層では、アクセス層からデータが転送されるときにルーティングが開始されます。ファイアウォール、ロードバランシング、およびその他のセキュリティ設定は、集約層に設定されています。集約/配布層は、データセンター内の配線計画を簡素化し、管理をより便利にするために使用されます。集約層にインストールされたスイッチは、メモリ内のMACアドレステーブルにより多くのMACアドレスを保存する必要があります。アクセス層はL2トラフィックで動作する一方で、配布層はL2およびL3トラフィックで動作します。

アクセス層

このレイヤーは、L2で動作するスイッチで構成されています。サーバーとワークステーションはアクセスレイヤースイッチに接続されています。通常、L2ブロードキャストドメインを分離し、ブロードキャストトラフィックを減少させ、セキュリティを向上させるためにVLAN(仮想ローカルエリアネットワーク)が使用されます。

ボトルネックを回避するために、ネットワークコアに近い場所ではより厚いリンクが使用されます。たとえば、サーバーは10-Gbit/sのネットワークインターフェイスを使用してアクセススイッチに接続され、アクセススイッチは10-Gbit/sのインターフェースを使用して集約スイッチに接続され、集約レイヤーのスイッチ/ルーターは100-Gbit/sのリンクを使用してネットワークコアスイッチ/ルーターに接続されます。この場合、リンク集約を使用して帯域幅と冗長性を増やすことができます。サーバーからのすべてのトラフィックはアップリンクに転送されます。このネットワークトポロジーの階層の頂点には、’神ボックス’というニックネームのインテリジェントネットワーク機器のセットがあります。神ボックスはルーティングおよびすべてのその他のサービスに責任を負います。階層化されたネットワークトポロジーを使用すると、モジュラーなネットワークを作成できます。

前の図で見たネットワークトポロジーでは、1つのリンクの障害がそのネットワークセグメントの障害につながります。このため、このネットワークトポロジータイプでは(以下の図を参照)、各ネットワークレイヤーに予約チャネルと冗長性が使用されます。1つのデバイスまたはリンクの障害により、パフォーマンスが低下しますが、ネットワークは動作を継続します。この冗長なネットワークトポロジーでは通常、STP(スパニングツリープロトコル)が必要です。

メンテナンス。この3層ネットワークトポロジータイプの上部にあるネットワーク機器の一部を切断してソフトウェアを更新したり、他のメンテナンスタスクを実行したりすると、ネットワークのパフォーマンスが低下します。一部のサービスが一時的に利用できなくなる場合があります。

拡張性。 サーバー上で実行されるサービスの数は年々増加し、それに応じてトラフィック量も増加しています。この状況では、MSPネットワークでのネットワーク帯域幅のアップグレードと増加が必要です。クラシックなデータセンターでのネットワーク帯域幅の増加には通常、次のことが必要です:

- リンクアグリゲーション(LAG)接続の増加

- ネットワークカードの購入

- ネットワークカードを取り付けるためのスロットが利用できない場合、新しいサーバーまたは関連機器の購入

データセンターの新しいモジュールとして新しいサーバーラック(ラックキャビン)を追加する必要がある場合、このラックとこのラックにインストールされたサーバーへのネットワーク帯域幅を増加させることができます。この種のネットワークトポロジは、STPやMSTP(Multiple Spanning Tree Protocol)などのL2プロトコルの機能によるリンク予約と冗長性の高いレベルを確保できません。

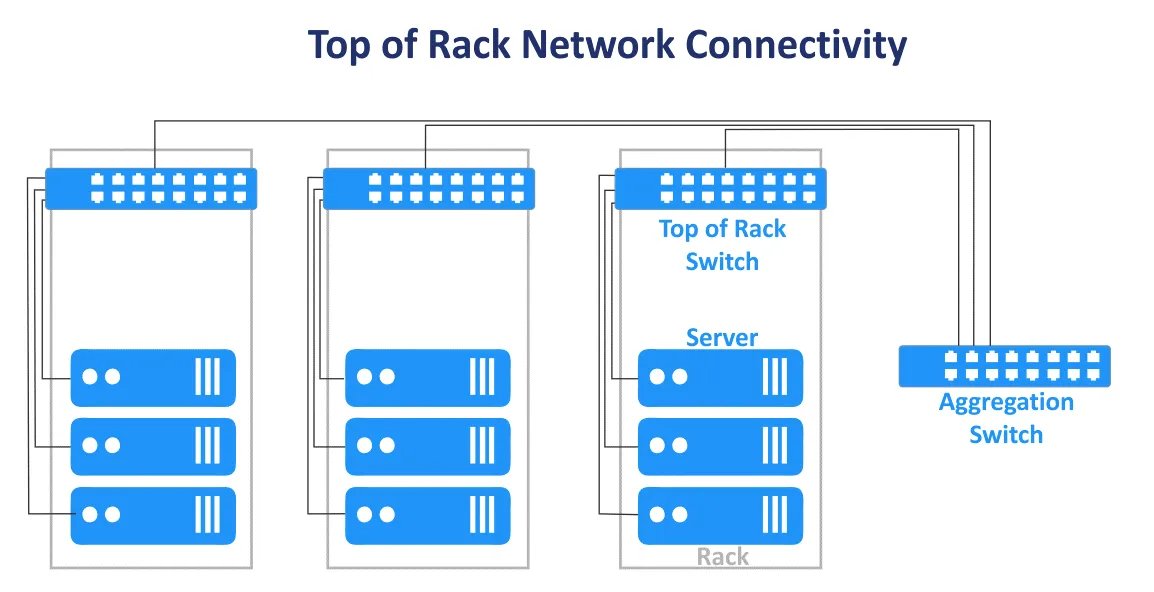

データセンターのクラシックな三層ネットワークトポロジーは、エンドオブロウとトップオブラックの設計と組み合わせることができます。トップオブラック接続スキームは現在より人気があります。この名前は、サーバーとスイッチが各ラックのメインスイッチに接続されているため使用されます。トップオブラックスイッチ(ToRスイッチ)は、MSPネットワークのより高いレベルのスイッチ/ルーターに接続されています。ToRスイッチはユーザーエッジスイッチとは異なり、複数の追加の高速アップリンクポート(例:10ギガビット/秒ポート)と多数のサーバーに接続するためのポートを持っています。ToRスイッチは冗長性を持たせるためにペアでインストールされ、スイッチのメンテナンスを可能にします。このToR接続スキームの利点は、ラック内およびラック間のデバイスのケーブル長が短くなることです。多層階層型ネットワークトポロジーのアクセススイッチは通常、ToRスイッチとして使用されます。

トラフィックの方向

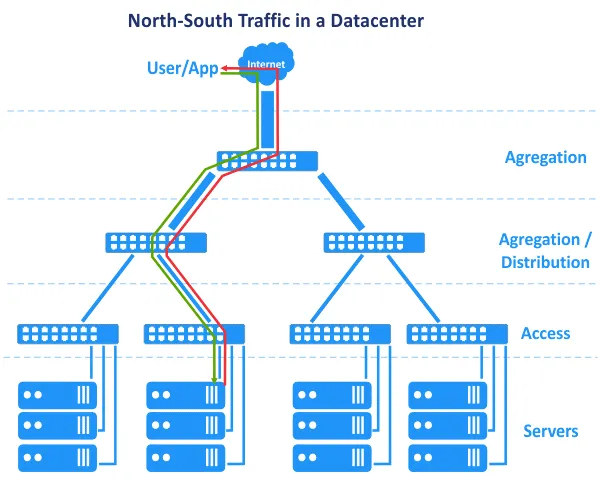

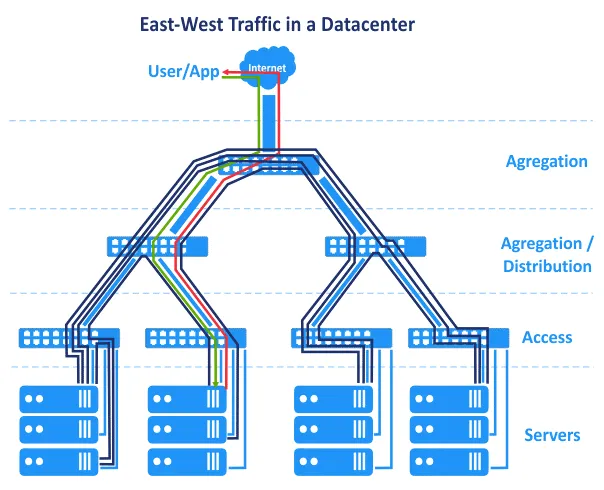

以前に説明された欠点はそれほど重大ではなく、適切な管理があればデータセンターのネットワークは成功裏に機能することができます。L2からL3への一部のネットワークの変更は、一連の問題を解決するのに役立ちます。データセンターがどのように進化したか、そしてアプリケーションが今日どのように異なって実行されているかに関連する別の機能があります。2000年代には、アプリケーションは集中型のアーキテクチャを使用して作成され、クライアントサーバーアーキテクチャのアプリケーションは主にモノリシックでした。つまり、アプリケーションのコンポーネントは単一のサーバー上に配置できました。その結果、図では、ユーザー要求がネットワークの上部から送信され、アプリケーションによって生成された要求が下部サーバーレベルからネットワークの上部に戻りました。ユーザー要求は単一のホストで処理されました。ホスト間(東西)トラフィックは最小限であり、南北トラフィックが優位でした。データセンターのMSPネットワークで使用される階層型のマルチティアール伝統的なネットワークトポロジは、これらの要件を満たします。しかし、時間が経つにつれて、アプリケーションを開発する際に新しいアーキテクチャが好まれるようになりました。

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

マイクロサービスアーキテクチャは、アプリケーションのコンポーネント(サービス)がネットワーク上で互いに接続された独立した論理的に分離されたコンテナで実行されることを想定しています。コンテナはクラスター内の異なるホストで実行できます。このアーキテクチャは非常にスケーラブルであり、現在クラウドで広く使用されています。

さらに、データセンターは今やビッグデータ、大規模なデータベース、分析、コンテキスト広告、人工知能に基づくアプリケーション、および他のソフトウェアを運用しており、これらは複数のサーバー、ストレージアレイ、仮想マシン、またはコンテナとの相互接続が必要です。アプリケーションコンポーネントはデータセンター内の複数のサーバーやVMに分散されています。

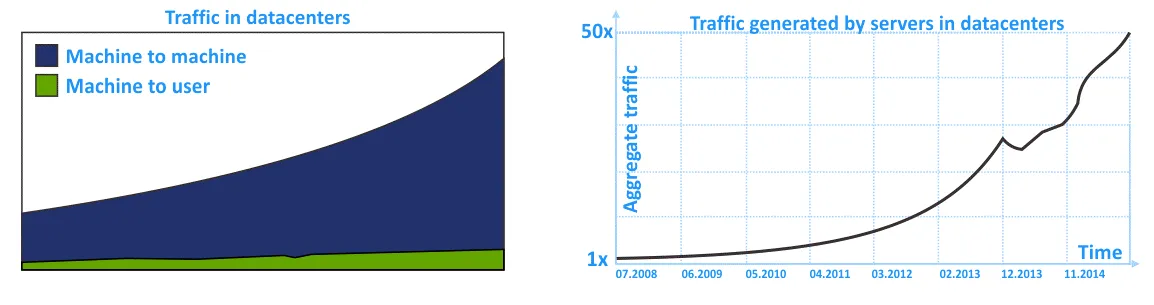

その結果、MSPネットワークで南北方向のトラフィックよりも東西方向のトラフィックが多くなっています。データセンターネットワーク内の内部トラフィック(データセンター内トラフィック)は、データセンターにリクエストを送信する外部ユーザーからのトラフィックよりも多いです。ストレージシステム間の内部トラフィック、データベースレプリケーション、データバックアップ、および他のサービス活動によるデータセンター内のネットワーク利用も忘れないでください。

次の図では、過去数年間のデータセンター内のMSPネットワークでの内部トラフィックの増加がグラフィカルに表現されています。この傾向から、データセンター内トラフィックが入出力トラフィックよりも増加していることがわかります。

従来のネットワークは、従来の階層型3層ネットワークトポロジを使用して構築されており、信頼性はありますが、横断的なトラフィックフローには最適化されていません。これはL2ネットワーキングと南北方向のトラフィックに重点が置かれているためです。

Closネットワークトポロジ

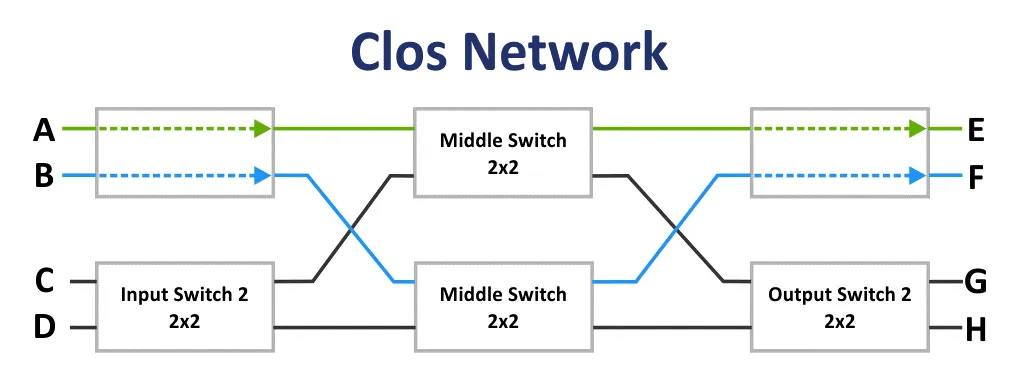

初めに、Closネットワークは1938年にEdson Erwinによって発明されました。 1953年、Charles Closは、クロスバーコミュニケーション方式と比較して、電話システムで非ブロッキングスイッチングネットワークをより合理的に使用するために決定しました。接続スキームは最初の見るからに難しく見えますが、接続ポイントの数が低いため、Closネットワークはより複雑ではありません。公式によると:6n^(3/2)-3n。この事実は、36個の接続端点から明らかになります。

もしmが入力スイッチの数であり、nが出力スイッチの数である場合、Closネットワークのブロッキング特性は次の式を使用して計算されます。Closの定理によれば、Closネットワークは、第2段階のスイッチの数がm ≥ 2n−1である場合に厳密に非ブロッキングです。

ブロッキングネットワークは、空いている入力ポートから空いている出力ポートへの通信パスを見つけることが不可能なネットワークです。

非ブロッキングネットワークは、任意の入力と出力ポートを接続するパスが常に存在するネットワークです。非ブロッキングネットワークは、追加の交換段階を追加することで作成されます。

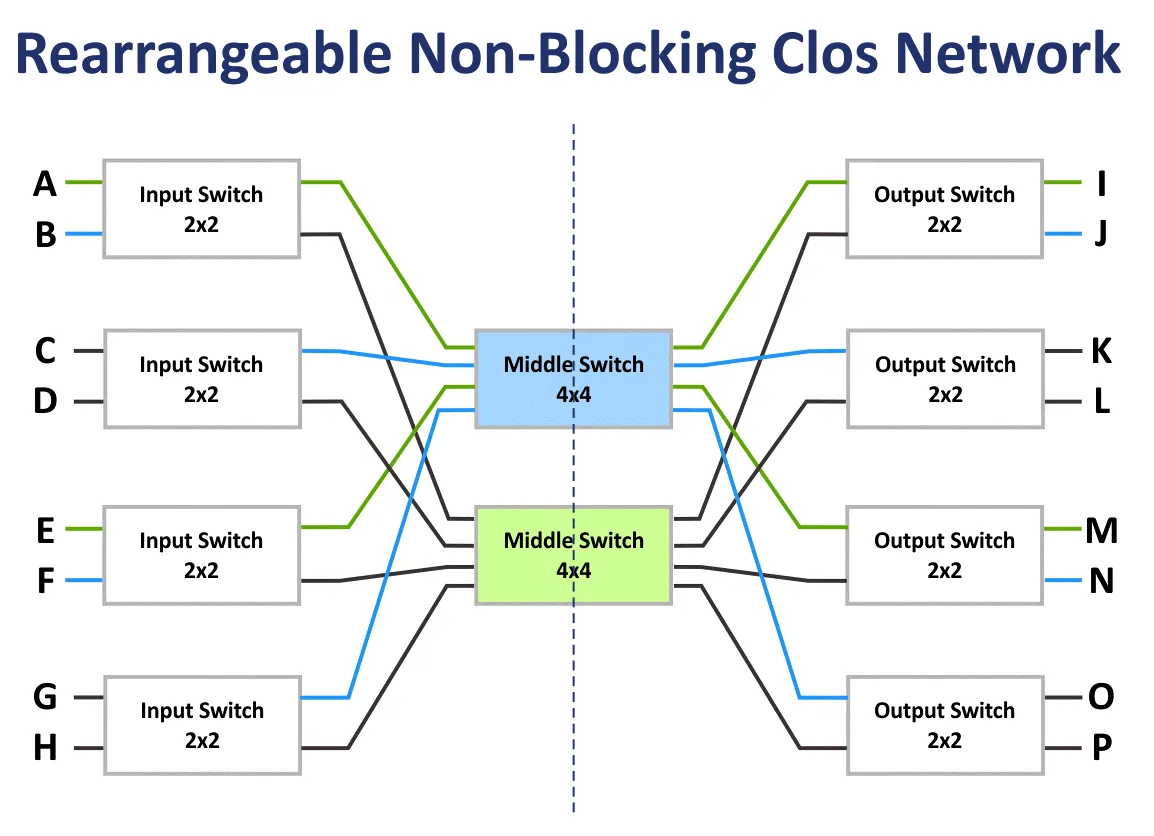

再配置可能な非ブロッキングネットワークは、すべての入力および出力ポートを接続するすべての可能なパスを再配置できるネットワークです。

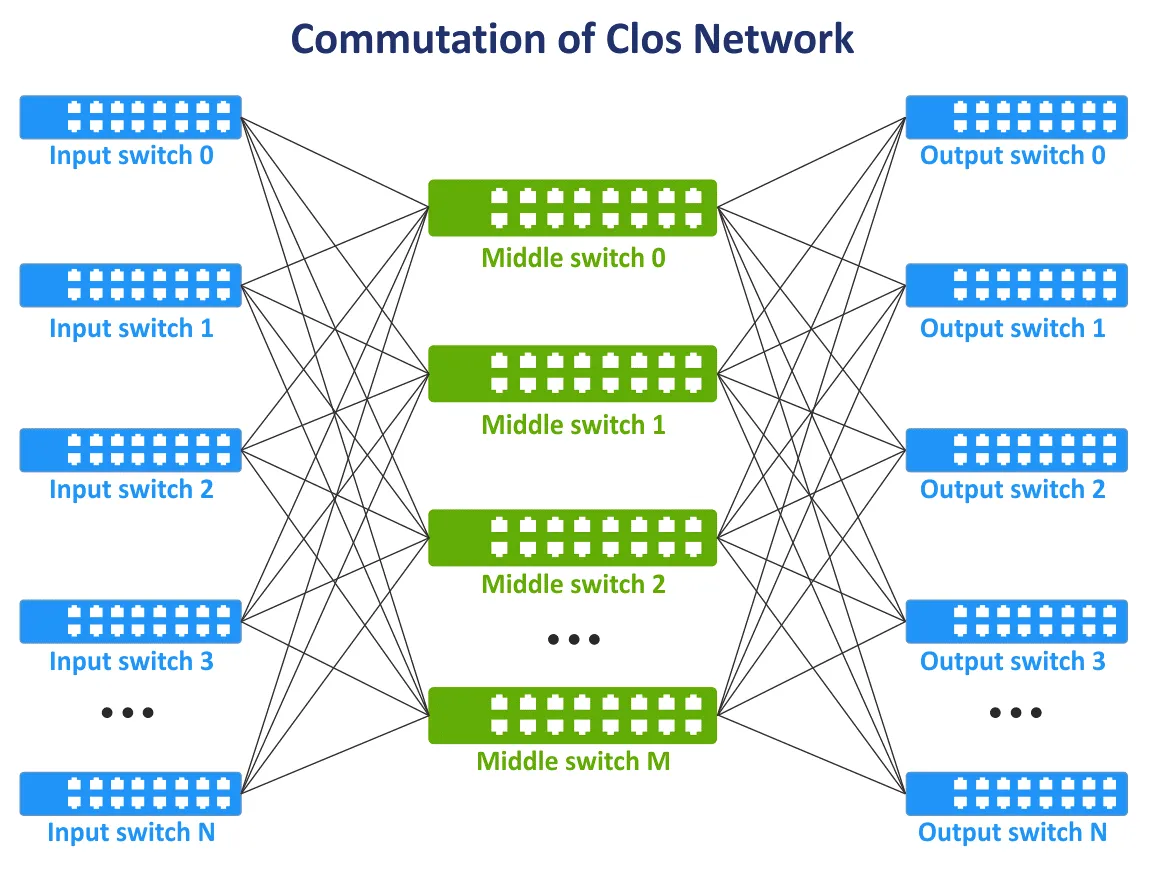

1990年代末、通信技術とコンピュータネットワークの進化により、Closネットワークの概念が再び関連性を持つようになりました。ネットワークファブリック内のすべてのノードが通信する必要があり、可能であれば全てのデバイスが相互接続されたフルメッシュトポロジーを使用しないようにする必要があります。ネットワークデバイスを相互接続するための新しい通信層が追加されました。その結果、Closネットワークの概念は新たな形で復活しました。以下のイメージでは、典型的な3層Closネットワークのスキームが示されています。

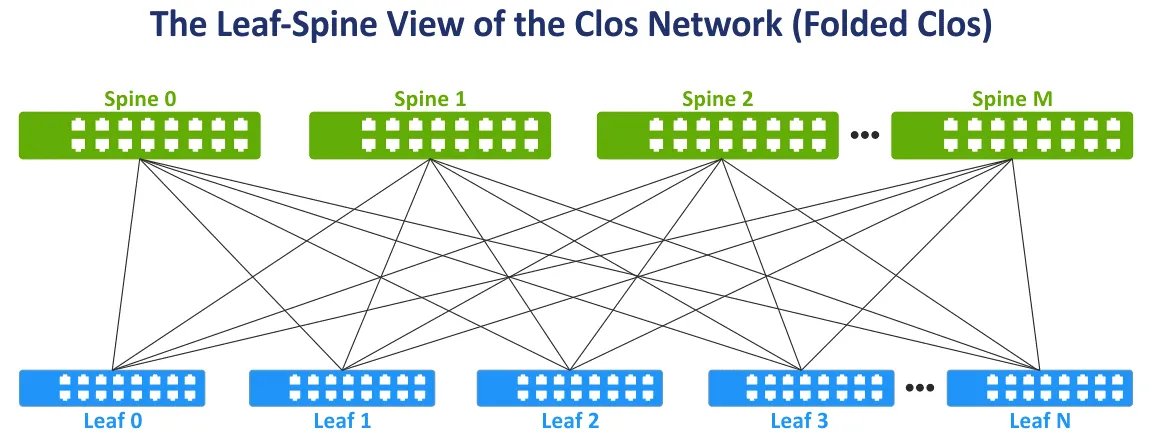

左右の側面を折りたたむことにより、Closネットワークのビューを使いやすいように変更しましょう。このネットワークトポロジーはLeaf-Spineビューとしても知られており、Folded Clos、3ステージClosネットワークとも呼ばれています(以下のイメージをご覧ください)。

スパイン層。スパインスイッチは、フルメッシュネットワークトポロジーですべてのリーフスイッチを相互接続するために使用されます。スパイン層は、従来の3層階層型ネットワークトポロジーで使用される集約層を一部置き換えますが、スパイン層は集約層とは直接的な対応関係にはありません。スパイン層の主な役割は、1つのリーフから別のリーフへのデータの高速転送です。エンドポイントデバイスはスパインスイッチに接続されません。

リーフ層。このモデルでは、データセンターのサーバーまたは他のエンドポイントデバイスがリーフに接続されます。すべてのリーフはすべてのスパインに接続されています。その結果、すべてのサーバー間で等しい帯域幅の高い数のネットワーク接続があります。スパインとリーフ間にはL3接続(OSIモデルのL3)があります。

ネットワーク内でソースから宛先にトラフィックを送信する際、ホップ数は同じです(たとえば、次のスキームの2層リーフスパインネットワーク内のサーバー間でデータを転送するには3つのホップが必要です)。遅延は予測可能で低いです。ネットワーク容量も増加しているため、今はSTPを使用する必要がありません。スイッチ間の冗長接続にSTPが使用されると、一度に1つのリンクだけがアクティブになります。

リーフスパインネットワークトポロジーでは、ECMP(Equal-Cost Multipath)ルーティングプロトコルを使用してトラフィックを負荷分散し、ネットワークループを防ぐことができます(L3ネットワーク接続向け)。BGP、OSPF、EIGRP、ISISプロトコルも使用できます。

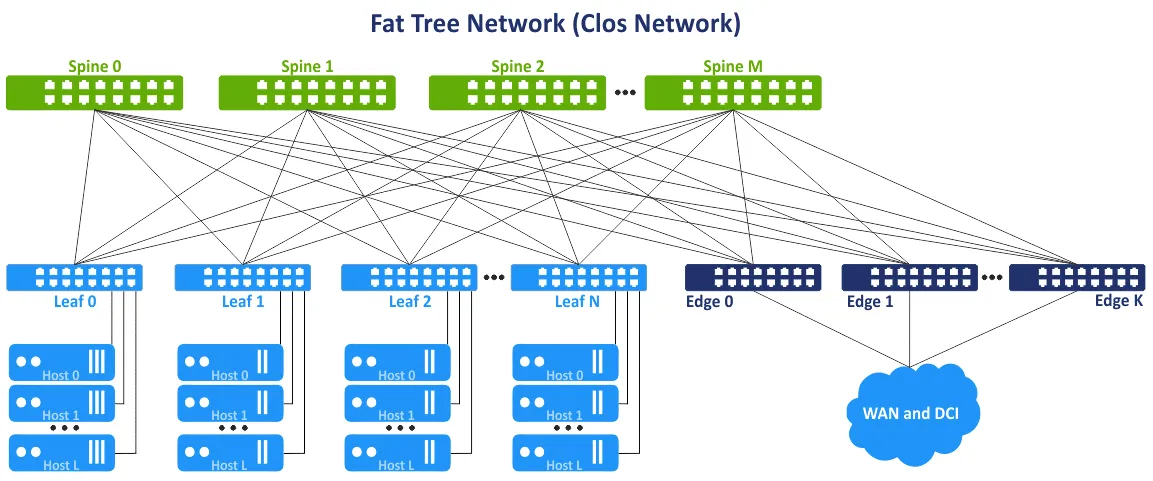

このネットワークコンセプトは、マルチレイヤーファットツリーネットワークトポロジーとも呼ばれます。このアイデアは、ツリーの上位層(ツリーの根に近い部分)でボトルネックを避け、これらのセグメントで帯域幅を増やすために追加のリンクを追加することです。その結果、根に向かってリンクの容量が増加します。ファットツリーはClosネットワークの特別なケースです。3層Closネットワークは折りたたまれた後、2層リーフスパインネットワークに変換されます。リーフスイッチまたはリーフエッジスイッチ/ルーターを使用して、外部ネットワークや他のデータセンターにアクセスできます。

リーフスパインネットワークトポロジーの利点

リーフスパインネットワークトポロジーは、アクセス集約コアネットワークトポロジーよりも一連の利点を提供します。この一連の利点がデータセンターでリーフスパインネットワークトポロジータイプを使用する理由です。

最適化された接続。ネットワークデバイス間の帯域幅が高いリンクは、東西トラフィックに最適です。未使用のリンクはありません(L3が使用されているためL2ではありません)。高効率のためにECMPが推奨され、STPは必要ありません。

信頼性。1つのデバイスの障害や1つのリンクの切断でも、著しいマイナスの結果や不利益は発生しません。リーフスイッチとして機能するToRスイッチが故障した場合、対応するラックに影響があります。スパインスイッチが故障した場合、ネットワーク帯域幅は伝統的な3層階層型ネットワークトポロジに比べて著しく低下しますが、それほどではありません。スパイン-リーフトポロジの帯域幅低下率は1/nであり、nはスパインの数です。この場合、階層型トポロジの帯域幅低下率は50%です。

高い拡張性。スパインに空いているポートがある限り、新しいリーフを追加できます。新しいスパインを追加することで、リーフのアップリンクを増やすことができます。外部ネットワークへの帯域幅を増やすには、エッジスイッチ/ルータを追加します。ツリーレイヤー階層型ネットワークトポロジで帯域幅を増やし、より多くのサーバーを接続する従来のアプローチは、より多くのポートを持つより多くのネットワークカード、より高速なネットワークインターフェースを持つネットワーク機器、および一般的により強力なハードウェアを追加することです。この伝統的なアプローチはスケールアップまたは垂直スケーラビリティと呼ばれます。

データセンターやMSPネットワークでリーフ-スパインネットワークトポロジを使用する場合、スパインの追加レイヤーを追加できます。このアプローチは水平スケーラビリティまたはスケールアウトと呼ばれます。通常のスイッチ/ルータなどのネットワークデバイスを1つ追加することで、拡張性が直線的に増加します。

メンテナンス。ネットワークからスパインを容易に切断してメンテナンスや交換ができます。スパイン上のメンテナンス作業は、ゴッドボックスと比較してリスクが少なく、スパインに知能機能がないため、切断後の帯域幅の削減も最小限です。

マルチティアクロスネットワーク

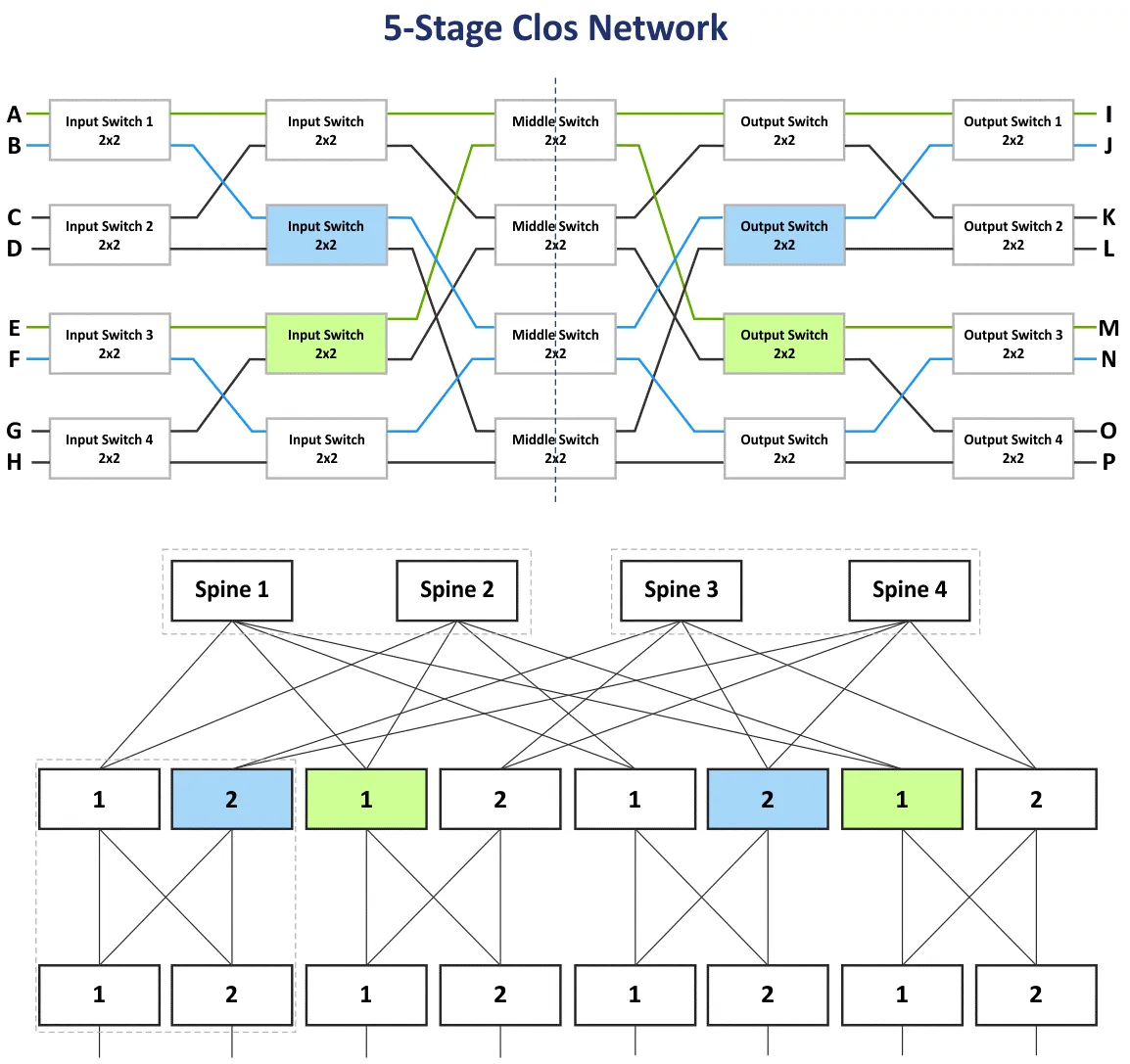

前のセクションでは、入力スイッチ、中間スイッチ、出力スイッチという段階を持つ三段階のクロスネットワークを説明しました。入力および出力段のデバイスはデータの受信/送信に使用されるため、中間ラインを使用して二層のリーフスパインネットワークトポロジーで折り畳むことにより、ネットワークスキームを折り畳むことができます。さらにステージを追加し、より多くのネットワークデバイスをこのネットワークに接続するためのマルチティアクロスネットワークを構築できます。この場合、入力スイッチ、中間スイッチ1、中間スイッチ2、中間スイッチ3、出力スイッチの5つのステージがあります。

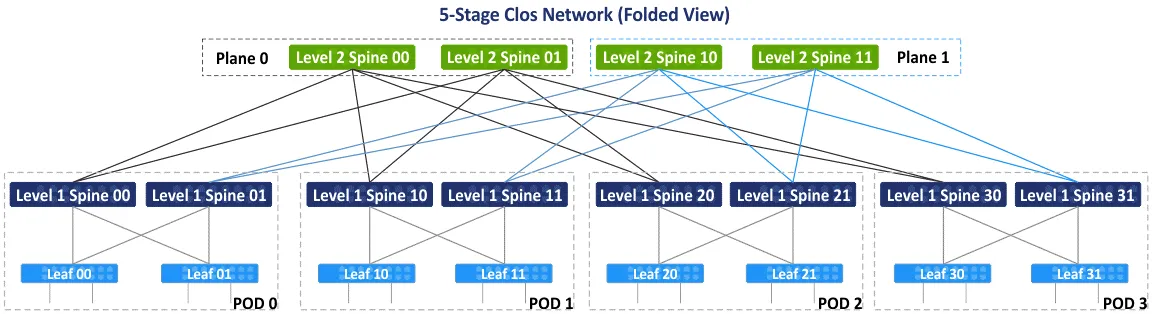

以下の図では、青色と緑色のブロックの再配置後の5段階のノンブロッキングクロスネットワークの初期スキームを示しています。また、折りたたまれたリーフスパインビューまたはファットツリー(4,3)ビューもあります(スパインスイッチが4つでリーフスパインスキームのステージが3つあるため)、しかし、どのようにしてデバイスを5段階のクロスネットワークに接続するかを一歩ずつ見ていきましょう。5段以上のステージを持つクロスネットワークのトポロジータイプは一般的ではなく、実践では使用されません。接続数が多すぎるためです。

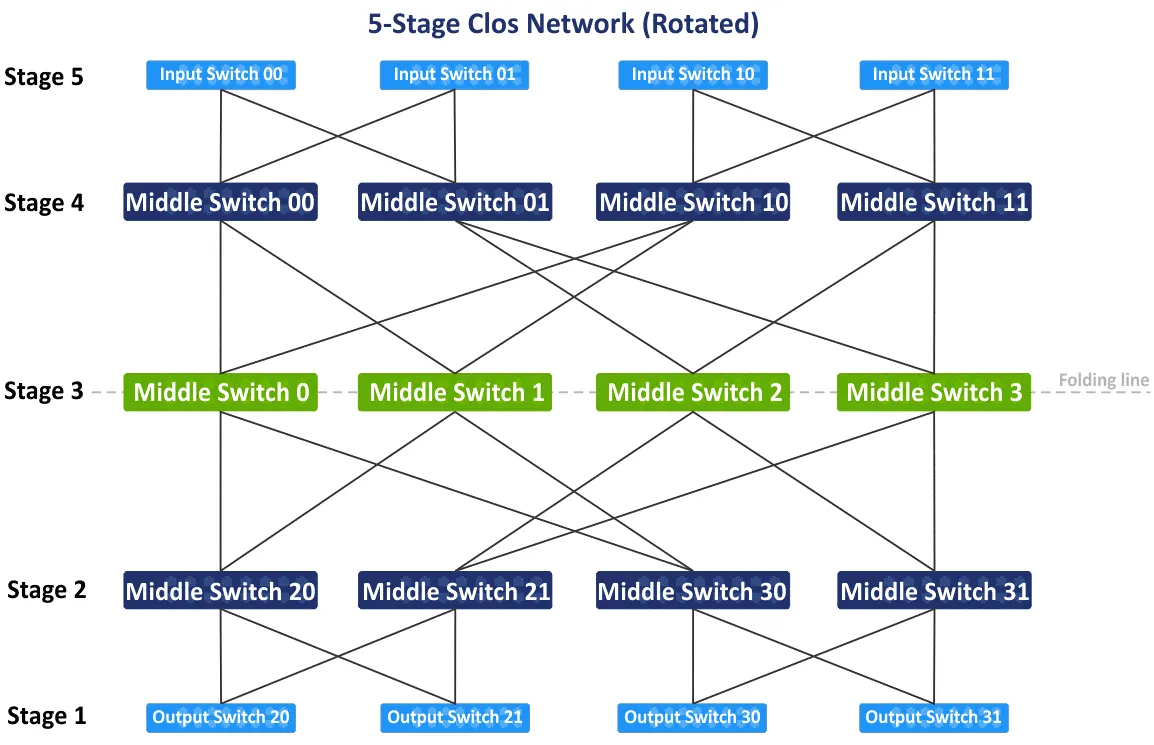

最初の5段階クロスネットワークの配置を時計回りに90度回転させると、入力スイッチ、出力スイッチ、および中間スイッチの3段階の伝統的な視点が得られます。スキームの中央にある中間スイッチを介して折り目を描き、5段階クロスネットワークの折りたたまれたビューを作成しましょう。

スキームを折りたたむと、このタイプのネットワークトポロジの折りたたまれたビューまたはリーフスパインビューが得られます(以下のスキームを参照)。ポイント・オブ・デリバリ(POD)として機能する4つの個別グループがあります。PODはデータセンターを構築するための汎用ユニットです。PODは第1レベルのスパインに接続されています。データセンターを拡張したり、サーバー/ネットワーク機器を追加する必要がある場合は、新しいPODを追加し、それらをネットワークファブリックに接続します。1つのPODのスパインは、第2レベルのスパインを介して他のPODのスパインに接続されています。同時に、すべてのL1スパインがすべてのL2スパインに接続されているわけではなく、平面で分割されています。

以下のスキームには、Plane 0とPlane 1の2つの平面があります。この概念は、スパイン上のポート数が制限されているため、完全に接続されたネットワークトポロジを作成することができない場合に使用されます。以下のスキームでは、各スパインには4つのポートの制限があります。主要なアイデアによれば、ノンブロッキングClosネットワークは同じ要素(以下参照)に基づいています(4ポートスイッチ)。

一見すると、Clos、折りたたまれたClos、リーフスパイン、およびファットツリーなどの用語に混乱するかもしれません。これらの用語を明確にします。

ClosまたはClosネットワークは、Closネットワークトポロジの理論的基礎をカバーする用語です。

フォールドクロスは、入力と出力が同じ役割を持ち、同じ場所に配置される、Closネットワークのより便利な表現です。

リーフスパインは、データセンターなどのネットワークを構築する実践的なClosネットワークスキームに基づくネットワークトポロジーです。

ファットツリーは、通常、Closネットワークの変形として言及されます。この用語は最も混乱を招くものの1つです。なぜなら、一部の記事ではファットツリーをクラシックなアクセス・アグリゲーション・コアネットワークとして言及しているからです。私はRFC 7938文書を参照しています。それによれば、ファットツリーはフォールドクロスネットワークトポロジーに基づいています。

計算

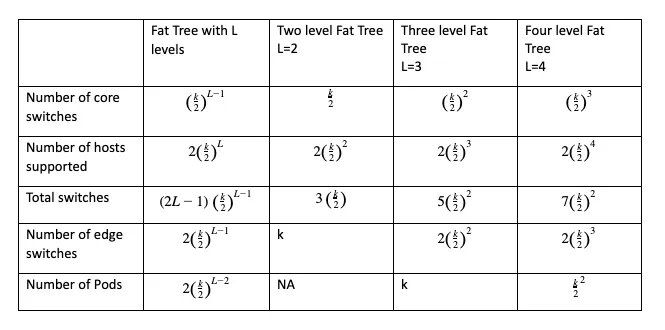

選択した構成のネットワークに接続できるコアスイッチ、エッジスイッチ、合計スイッチの数、およびネットワークに接続できるホストの総数を計算することができます。これには、以下のような式を使用します:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

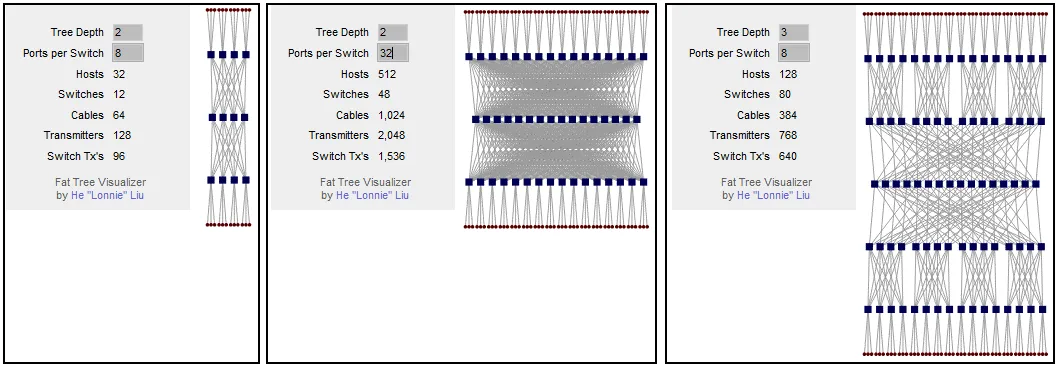

ネットワークを構築する前に計算する主要なパラメータは、サポートされるホストの数です。ファットツリー構成はFT(k, L)として書くことができます。たとえば、FT(32,3)は32ポートスイッチを備えた3レベルのファットツリーネットワークです。選択した構成の可視化スキームを生成するこの無料計算機を使用できます。

あなたがファットツリーネットワークスキームが2つのレベルとスイッチあたり8つのポートを持つ場合、ネットワークに32台のホストを接続できることを計算できます。スイッチあたりのポート数を増やすと、サポートされるホスト数が512に増加します。接続されたホストの数は、各スイッチのポート数に依存することがわかります。ファットツリーを2つのレベルに残し(3段階のクロスネットワーク)、スイッチあたりのポート数を増やすと、スパインの数が大幅に増加します。この問題は、ファットツリーに1つのレベルを追加することで解決できます。3レベルのファットツリーの場合、スイッチあたりのポート数が8つの場合、128台のホストを接続できます。

スイッチあたりのポート数を32に増やすと、このネットワークトポロジを使用して8192台のホストを接続できます。この数値は、5段階のクロスネットワークに対する3段階のクロスネットワークのそれよりも16倍です。データセンター内のサーバーラックの制限を考慮して、サーバーとネットワーク機器のインストールスキームを計画する際に注意してください。

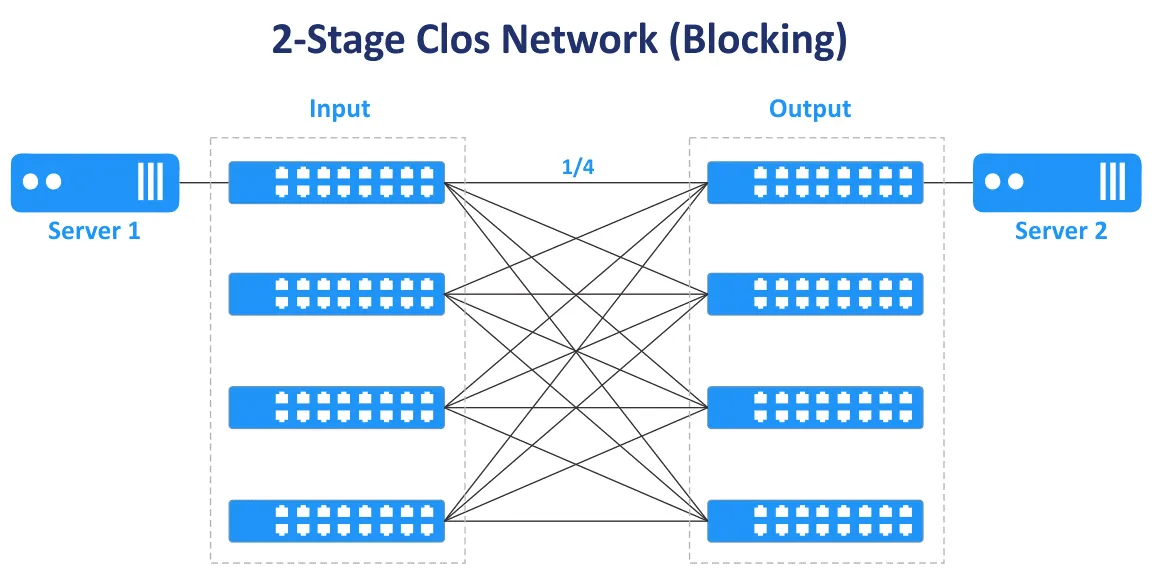

奇数段のステージは、ノンブロッキングクロスネットワーク(3、5、7など)を構築するために使用されます。2段階のクロスネットワークはノンブロッキング接続やスイッチ間の複数接続を提供しません。

次の図では、2段階のクロスネットワークの場合、Server 1とServer 2を接続するための伝送経路が1つしかないことがわかります。接続されるポートは1/4のみで、他のポートは接続されておらず、ブロックされています。

オーバーサブスクリプション比は、下位層から上位層への方向の入力帯域幅と出力帯域幅の比率です。オーバーサブスクリプション比は通常2から4の範囲で変動します。

スイッチには48ポートの10ギガビットポートと4つの40ギガビットのアップリンクポートがあります。サーバーへのダウンリンクの合計帯域幅は48×10=480ギガビット/秒です。アップリンクの合計速度は4×40=160ギガビット/秒です。オーバーサブスクリプション比は480/160=4です。

スイッチのすべてのダウンリンクポートとアップリンクポートの合計帯域速度が等しい場合、スイッチはオーバーサブスクライブされず、この場合にはボトルネックはありません。1:1のオーバーサブスクリプション比が理想的なケースです。適切な速度とポート数のスイッチを購入する前に、異なる方向のトラフィックを見積もってください。

オーバーサブスクリプション比が1より高いスイッチは、リーフスパインネットワークトポロジーのリーフステージでよく使用されます。非オーバーサブスクライブされたスイッチは、スパインステージで使用する必要があります。リーフスパインネットワークトポロジータイプのリーフレベルのスイッチは通常、ToRスイッチとして使用されます。ただし、リーフスイッチをEnd of Rowスイッチとしてインストールすることも可能です。

基本的な違い

ネットワークを作成する際、いくつかの決定がネットワークのレイアウトに影響します。ここに、ネットワークの機能に影響を与えるいくつかのエイザーオアの決定があります。

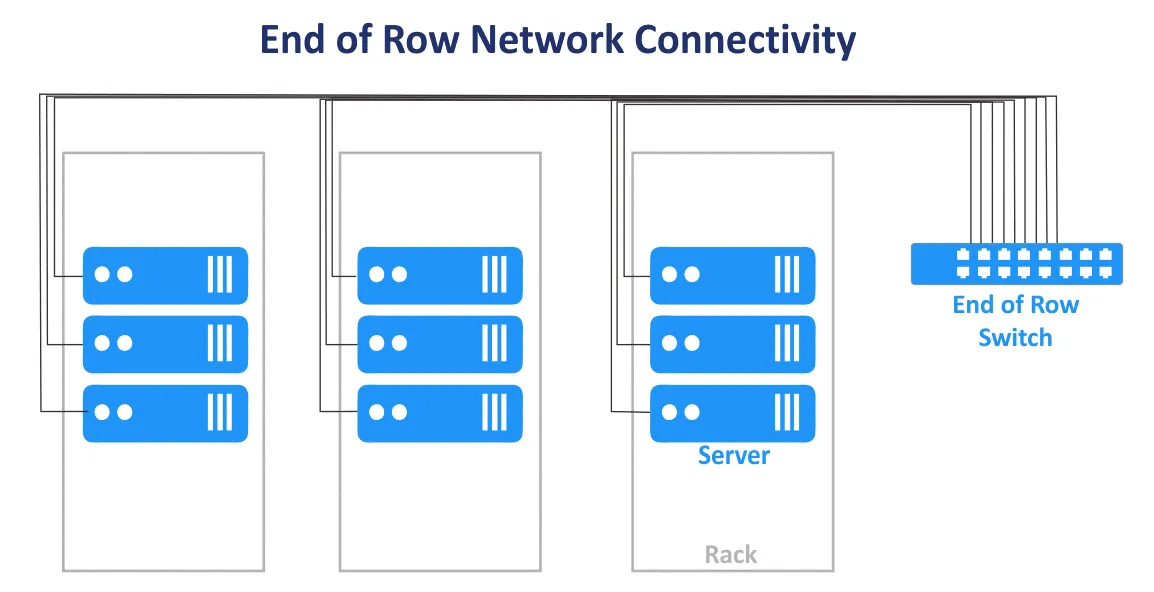

ラックの頂上 vs 行の終わり

データセンターのラックトップ(ToR)ネットワーク接続スキームでは、1つまたは複数のスイッチが各ラックに設置されます。短いパッチケーブルを使用して、ラック内の他のネットワーク機器やサーバーとラックトップスイッチを接続します。ToRスイッチには通常、上位のスイッチ/ルーターとの高速アップリンクがあり、光ファイバーケーブルで接続できます。この接続スキームをMSPネットワークに使用する場合、データセンターの各ラックから太い束のケーブルをインストールする必要がありません。ToRスキームを使用すると、データセンター内でのケーブル使用量が合理的になります。この場合、配線費用が削減され、ケーブル管理が向上します。各ラックを単一のモジュールとして管理できるため、データセンター内の他のラックに影響を与えることなく、1つのラックだけが影響を受けます。スキーム名にもかかわらず、各ラックの中央または底部にスイッチを取り付けることができます。

行末(EoR)ネットワーク接続スキームでは、行末のサーバーラックにネットワーク機器が含まれます。この機器には、行内のすべてのサーバーラックのすべてのサーバーおよび他のデバイスを接続するための共通ネットワークスイッチが含まれます。 EoRサーバーラックに設置されたネットワーク機器からのケーブルは、各ラックに取り付けられたパッチパネルを使用して、行内のすべてのラックのデバイスに接続されます。その結果、行内のすべてのネットワーク機器を接続するために長いケーブルが使用されます。冗長なネットワーク接続を使用する場合、ケーブルの数も増加します。太い束のケーブルが機器への空気アクセスをブロックする可能性があります。

データセンターでは、通常、サーバーラックは横一列に並べられます。1つの列には、例えば10または12のラックが含まれることがあります。全列は、データセンターのMSPネットワークにおけるEoR接続方式を使用する際に単一の管理ユニットと見なされます。この場合、1列ごとの管理モデルが使用されます。EoRネットワーク接続モデルでは、個々のスイッチが少なくて済みます。メンテナンスやスイッチのアップグレードを行う必要がある場合、EoRスイッチを切断すると影響を受けるデバイスが増えるため、柔軟性が低下します。名前の通り、共通のスイッチ(スイッチ)を備えたラックは、列の中央に配置することができます。

Layer 2 vs Layer 3 Connection

ネットワーク内の接続を決定することは、信頼性、速度、費用、および作成されるトポロジーを含む計算です。

例えば、3層のAccess-Aggregation-CoreネットワークトポロジやLeaf-Spineトポロジのネットワークセグメントがあります。そこでは、トラフィックはOSIモデルL2およびL3で転送されます。階層化された3層ネットワークでは、アクセス層はL2で動作し、配布/集約層はL2リンクを集約し、L3ルーティングを提供し、コアネットワーク層はOSIモデルの第3層でルーティングを行います。マルチティアLeaf-Spineトポロジのネットワークは、VLANを使用したL2とIPルーティングおよびサブネットを使用して構成できます。

L2ネットワーク機器はL3ネットワーク機器よりも手頃ですが、データセンターのMSPネットワークでネットワークデバイスを接続する際にL2ネットワーキングを使用するといくつかの欠点があります。 VLANは、通常、同じ物理的環境を使用してネットワークを論理的に分離するために使用されます。 VLANの最大数は4095です(0、4095、1002-1005など、一部の予約済みVLANを除く)。

別の欠点は、以前に述べたように、L2上でSTPを使用する際に冗長なリンクを使用できないことです。これは、同時に1つのリンクしかアクティブにできないためであり、すべてのリンクの利用可能な帯域幅が使用されないためです。したがって、STPを使用したL2ドメインが大きくなると、不適切なケーブリングや人為的なエラーによる問題の発生確率が増加し、トラブルシューティングが困難になります。

L3ネットワーク構成により、エンジニアはMSPネットワークやデータセンターネットワーク全般の安定性と拡張性を向上させることができます。

次のネットワークプロトコルは、L3ネットワークを管理しトラフィックをルーティングするのに役立ちます。

BGP(Border Gateway Protocol)は、広く使用されており、多くの大規模データセンターで標準とされている動的ルーティングのためのプロトコルです。BGPは非常にスケーラブルで拡張可能で効率的なプロトコルです。

ECMP(Equal Cost Multipath Routing)は、第3層のOSIモデルのメトリクスによって定義された複数の最適パスを使用してトラフィックを分散するネットワークルーティング技術です。ルーティングプロトコルとのECMPを使用した負荷分散は、大規模ネットワークで使用されます。BGP、EIGRP、IS-IS、OSPFを含むほとんどのルーティングプロトコルがECMPテクノロジーをサポートしています。

常により進歩的なネットワークプロトコルを使用しようとしてください。ただし、ネットワークで使用されるプロトコルが少ないほど、ネットワーク管理が便利になります。

NVおよびSDNのネットワークトポロジ

ハードウェア仮想化と仮想マシンの使用に加えて、アプリケーション中心のアプローチを採用したネットワーク仮想化も人気を博しています。VMware NSX、OpenStackネットワーキング、およびCisco ASIなどのネットワーク仮想化(NV)ソリューションは、物理ネットワークで東西のトラフィックを積極的に利用し、そのためにリーフ-スパインネットワークトポロジがネットワーク仮想化ソリューションに適しています。VMware NSXに関するブログ記事を読んで、ネットワーク仮想化について詳しく学んでください。

ソフトウェア定義ネットワーキング(SDN)は、効果的なリソース使用、柔軟性、および集中管理のためにネットワークを仮想化するために使用されます。これは、ネットワークに接続された仮想マシンが使用される仮想化されたデータセンターでの最適なソリューションです。仮想マシンはサーバ間で移動できるため、データセンター内で東西のトラフィックが発生します。SDNは、IaaS(インフラストラクチャーサービス)を提供するMSPが使用するMSPネットワークで広く使用されています。

ソフトウェア定義ネットワークを設定するのは、リーフ-スパインネットワークトポロジの基礎として効果的です。これには、動的ルーティング、固定数のホップ、低予測可能なレイテンシ、およびデータセンター内のサーバ間通信のための東西のトラフィック最適化が含まれます。

VXLAN

VXLAN(Virtual eXtensible Local Area Network)は、オーバーレイネットワークでVLANの代わりに使用される改良されたネットワークプロトコルです。VXLANでは、従来のVLANの制限なしにL2ネットワーク接続性を提供するために、基礎となるL3ネットワーク(L3ネットワークアンダーレイ)を使用してL2トンネルが作成されます。VXLANを使用すると、L3ネットワーク上でL2ネットワークを構成できます。仮想トポロジーは、基礎となるネットワークの物理的なトポロジーとは異なる場合があります。

VXLANフレームは、MAC-in-UDPカプセル化スキームを使用してIPパケットにカプセル化されます。VNIはVLAN IDの相当です。VNIの最大数は2^24であり、およそ1600万です。VXLANは、地理的に広がる環境でL2ネットワークを作成するために使用されます。例えば、地理的に分散した2つのデータセンター間でネットワークを作成する必要がある場合です。

VXLANとネットワーク仮想化を使用することで、ToRスイッチのMACアドレステーブルのサイズを最適化できます。これは、VXLANを使用してL2オーバーレイネットワーク経由でVMおよび関連するL2トラフィックで使用されるMACアドレスが転送されるためです。これにより、物理スイッチのMACアドレステーブルは、スイッチの利用可能なテーブル容量の最大値を超えることはありません。

結論

伝統的に、データセンターのネットワークは、クラシックな3層のアクセス-集約-コアのトポロジーを使用して構築されていました。進化する現代のクライアントサーバーや分散アプリケーション、マイクロサービス、および他のソフトウェアは、MSPネットワーク内の東西トラフィックのソースであり、クロスネットワーク概念に基づいたリーフ-スパインネットワークトポロジーが、現代のデータセンターでは好まれ、より一般的なネットワークトポロジーの1つです。リーフ-スパインネットワークトポロジーは、大規模なデータセンターに最適なネットワークトポロジーです。なぜなら、このトポロジーは非常に信頼性が高く、スケーラブルであるからです。データセンターにネットワークをインストールする前に、生成されるトラフィックとワークロードを計算し、見積もります。ネットワーク内のバックアップやレプリケーショントラフィックなどのサービストラフィックを考慮してください。

NAKIVO Backup & Replicationは、VMware Cloud Directorのワークロード、VMware VM、Hyper-V VM、および物理的なLinuxおよびWindowsマシン、Oracleデータベースを保護できる強力な仮想マシンバックアップソフトウェアです。インフラストラクチャーをサービスとして提供する(IaaS)、バックアップをサービスとして提供する(BaaS)、および災害復旧をサービスとして提供する(DRaaS)マネージドサービスプロバイダーは、マルチテナントモードでインストールされたNAKIVO Backup & Replicationを使用できます。マルチテナンシーインストールモードをサポートするMSP向けのNAKIVO Backup & Replicationの無料トライアルをダウンロードしてください。

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/