Pour les fournisseurs de services gérés (MSP), la construction d’un réseau performant et évolutif est un pilier du succès. Dans un précédent billet de blog, nous avons couvert les types de topologies de réseau de base, et dans ce billet, nous examinons des types de topologies de réseau plus complexes pour les fournisseurs de services, y compris ceux privilégiés pour les réseaux MSP. Lisez ce billet de blog pour découvrir quelle est la meilleure topologie de réseau pour un centre de données MSP, et pourquoi.

Réseaux hiérarchiques traditionnels à 3 niveaux

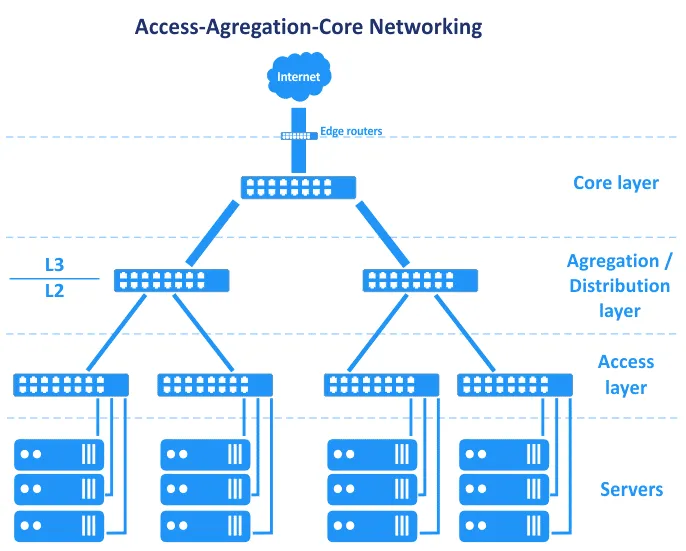

Avant que les Réseaux Définis par Logiciel ne deviennent courants, les réseaux dans les centres de données étaient basés sur la topologie en arbre hiérarchique. Cette topologie se décompose en trois couches principales : la couche centrale, la couche d’agrégation ou de distribution, et la couche d’accès. Dans cette topologie, les serveurs sont connectés à des commutateurs dans la couche d’accès. Les routeurs de bordure sont connectés au cœur pour fournir l’accès depuis/vers le WAN (réseau étendu) et l’internet. Ces routeurs sont situés entre le cœur et l’internet sur le schéma ci-dessous.

En termes du modèle OSI (Interconnexion de Systèmes Ouverts), qui divise le réseau en une couche de liaison de données (L2) et une couche réseau (L3), entre autres, la topologie de réseau Access-Aggregation-Core chevauche les couches, comme on peut le voir sur le graphique.

Examinons ces trois couches tour à tour.

Couche centrale

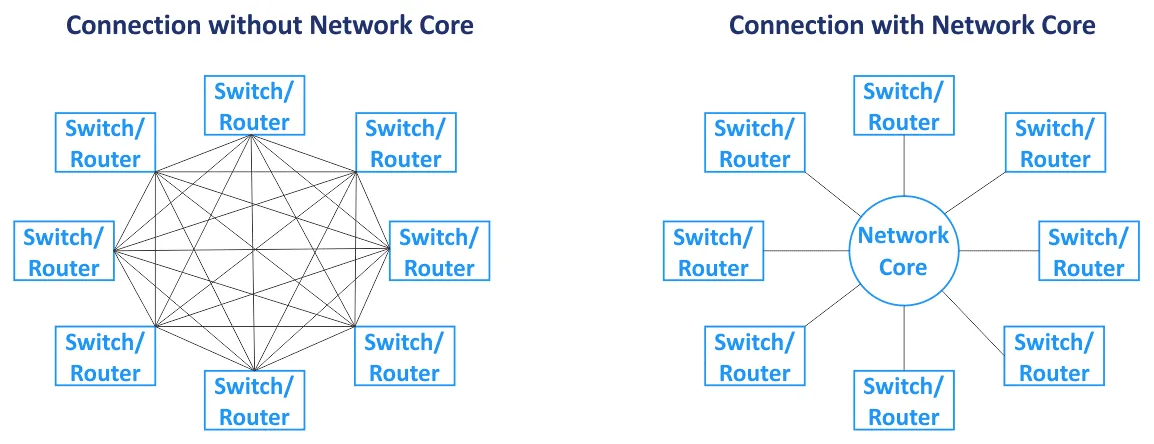

Le cœur du réseau (également appelé réseau central) est le composant central du réseau dans son ensemble. Les nœuds principaux sont connectés au cœur. Le réseau central est généralement basé sur la topologie de réseau maillé, où tous les nœuds sont connectés à tous les autres nœuds au sein du cœur (pour un type de topologie de réseau maillé complet). Les commutateurs et routeurs dans le cœur du réseau sont interconnectés avec des liens haute vitesse (également appelés connexions dorsales). Comme des routeurs sont utilisés dans le cœur du réseau, la couche centrale fonctionne avec du trafic L3.

Couche de distribution/agrégation

Il s’agit d’une couche intermédiaire utilisée pour agréger les liaisons montantes de la couche sous-jacente de la topologie de réseau à trois niveaux (la couche d’accès, qui fonctionne en L2) à la couche centrale du réseau (qui fonctionne généralement en L3) en utilisant des liaisons à bande passante plus élevée. La couche de distribution combine un grand nombre de ports à faible vitesse avec un petit nombre de ports de tronc à grande vitesse. Le routage commence sur la couche de distribution/agrégation de cette topologie de réseau lorsque les données sont transférées de la couche d’accès. Le pare-feu, l’équilibrage de charge et d’autres configurations de sécurité sont définis sur la couche d’agrégation. La couche d’agrégation/distribution est utilisée pour réduire et simplifier le schéma de câblage dans le centre de données pour une gestion plus pratique. Les commutateurs installés sur la couche d’agrégation doivent prendre en charge le stockage de plus d’adresses MAC dans la table d’adresses MAC dans leur mémoire. Alors que la couche d’accès fonctionne avec du trafic L2, la couche de distribution fonctionne avec du trafic L2 et L3.

Couche d’accès

Cette couche se compose de commutateurs qui fonctionnent sur le niveau 2. Les serveurs et les postes de travail sont connectés aux commutateurs de la couche d’accès. Les VLAN (réseau local virtuel) sont généralement utilisés pour séparer les domaines de diffusion de niveau 2 afin de réduire le trafic de diffusion et d’augmenter la sécurité.

Pour éviter les goulets d’étranglement, des liens plus épais sont utilisés plus près du cœur du réseau. Par exemple, les serveurs sont connectés aux commutateurs d’accès à l’aide d’interfaces réseau de 10 Gbit/s, les commutateurs d’accès sont connectés aux commutateurs d’agrégation à l’aide d’interfaces de 10 Gbit/s, et les commutateurs/routeurs de la couche d’agrégation sont connectés aux commutateurs/routeurs du cœur du réseau via des liens de 100 Gbit/s. Dans ce cas, l’agrégation de liens peut être utilisée pour augmenter la bande passante et la redondance. Tout le trafic des serveurs est transféré vers les liens montants. Il existe un ensemble d’équipements réseau intelligents, surnommés « boîtes divines », situés en haut de la hiérarchie de cette topologie de réseau. Les boîtes divines sont responsables du routage et de tous les autres services. La topologie de réseau hiérarchique vous permet de créer un réseau modulaire.

Dans la topologie de réseau vue dans le diagramme précédent, la défaillance d’un lien entraîne la défaillance de ce segment du réseau. Pour cette raison, des canaux réservés et une redondance sont utilisés pour ce type de topologie de réseau (voir le schéma suivant) sur chaque couche réseau. La défaillance d’un appareil ou d’un lien entraîne une dégradation des performances, mais le réseau continue de fonctionner. Cette topologie de réseau redondante nécessite généralement le protocole STP (Spanning Tree Protocol).

Entretien. Si vous déconnectez une partie de l’équipement réseau en haut de ce type de topologie de réseau à 3 niveaux pour mettre à jour le logiciel ou effectuer d’autres tâches de maintenance, les performances du réseau se dégradent. Certains services peuvent être temporairement indisponibles.

Évolutivité. Le nombre de services s’exécutant sur les serveurs augmente chaque année et la quantité de trafic augmente en conséquence. Cette situation nécessite une mise à niveau et une augmentation de la bande passante réseau dans le réseau MSP. Augmenter la bande passante réseau dans un centre de données classique nécessite généralement ce qui suit :

- Augmentation des connexions d’agrégation de liens (LAG)

- Achat de cartes réseau

- S’il n’y a pas d’emplacements disponibles pour l’installation de cartes réseau, achat de nouveaux serveurs ou d’équipements connexes

Si vous devez ajouter une nouvelle baie de serveurs (rack) comme nouveau module dans votre centre de données, vous pouvez augmenter la bande passante réseau vers cette baie et les serveurs installés dans cette baie. Ce type de topologies réseau ne peut pas garantir un niveau élevé de réservation de lien et de redondance en raison des fonctionnalités du protocole L2 telles que STP et MSTP (protocole de l’arbre couvrant multiple).

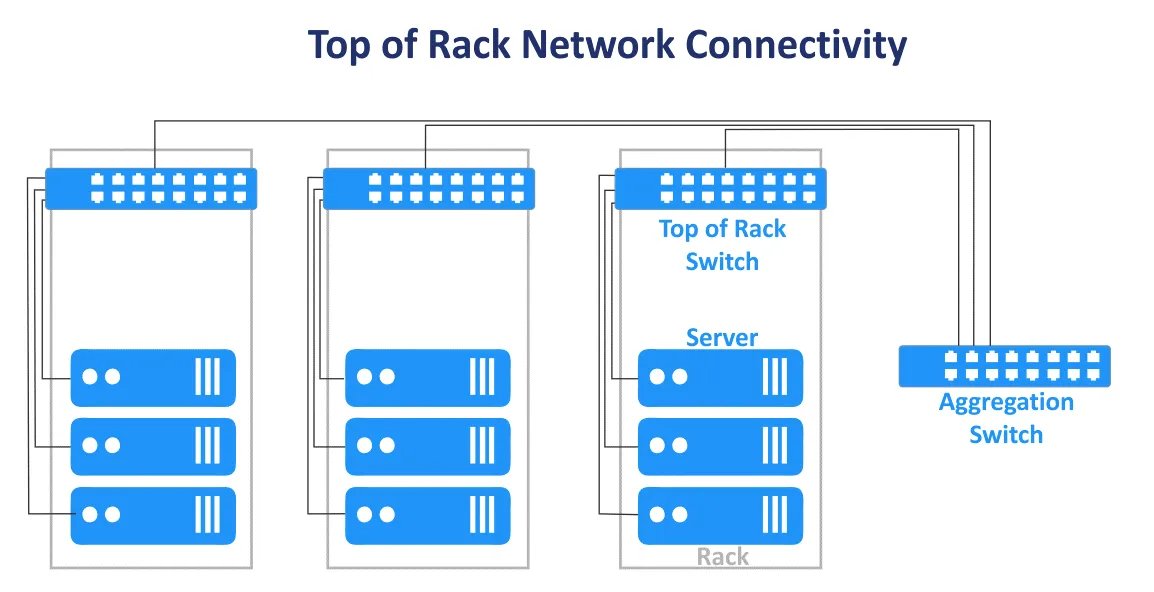

La topologie classique en trois niveaux dans un centre de données peut être combinée avec les conceptions Extrémité de Rangée et Sommet de Rack. Le schéma de connexion Sommet de Rack est désormais plus populaire. Ce nom est utilisé car les serveurs et les commutateurs sont connectés au commutateur principal sur chaque rack. Les commutateurs Sommet de Rack (commutateurs ToR) sont connectés aux commutateurs/routeurs des niveaux supérieurs dans le réseau MSP. Les commutateurs ToR sont différents des commutateurs d’extrémité utilisateur et disposent de plusieurs ports de liaison montante supplémentaires à haute vitesse (tels que des ports 10-Gbit/s) et d’un grand nombre de ports pour connecter les serveurs. Les commutateurs ToR sont installés par paire pour la redondance et pour permettre la maintenance des commutateurs. Les avantages de ce schéma de connexion ToR sont la plus petite longueur de câble lors du câblage des appareils dans un rack et entre les racks. Les commutateurs d’accès de la topologie de réseau hiérarchique multi-niveau sont généralement utilisés comme commutateurs ToR.

Direction du trafic

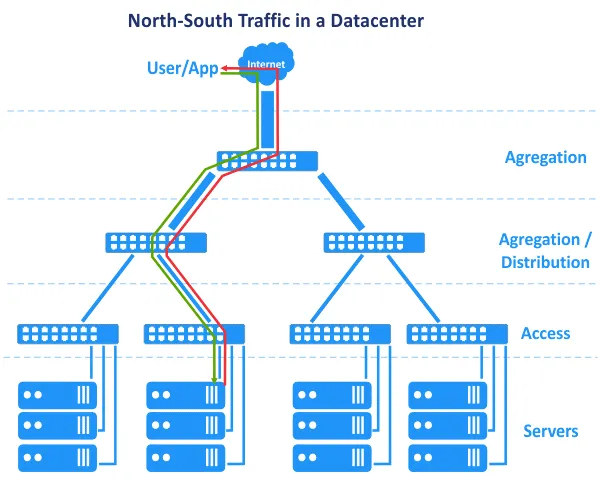

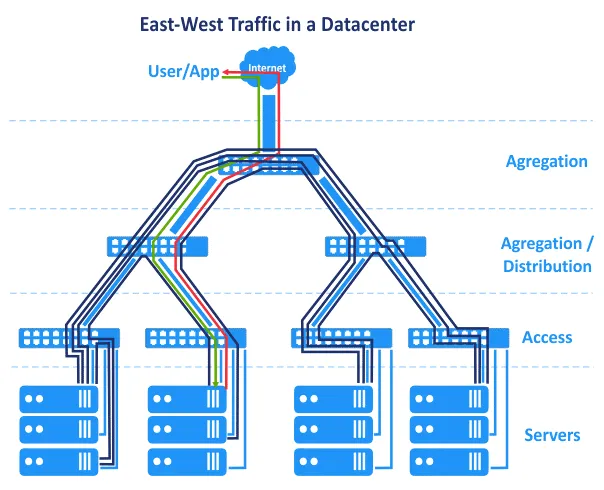

Les inconvénients précédemment expliqués ne sont pas trop critiques, et un réseau de centre de données peut fonctionner avec succès avec une administration adéquate. Le passage de L2 à L3 dans une partie du réseau permet de résoudre un ensemble de problèmes. Il existe une autre caractéristique liée à l’évolution des centres de données et à la manière dont les applications s’exécutent différemment aujourd’hui par rapport à avant. Dans les années 2000, les applications étaient créées en utilisant une architecture centralisée, et les applications de l’architecture client-serveur étaient principalement monolithiques. Cela signifie que les composants d’une application pouvaient être situés sur un seul serveur. Par conséquent, dans notre diagramme, la demande de l’utilisateur était envoyée depuis le sommet du réseau, et la demande générée par l’application était renvoyée du niveau du serveur inférieur vers le sommet du réseau. La demande de l’utilisateur était traitée sur un seul hôte. Le trafic horizontal (est-ouest) entre les hôtes était minimal, et le trafic nord-sud était privilégié. La topologie de réseau traditionnelle hiérarchique à plusieurs niveaux utilisée pour les réseaux MSP dans les centres de données répond à ces exigences. Cependant, au fil du temps, de nouvelles architectures ont été privilégiées dans le développement d’applications.

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

L’architecture de microservices suppose que les composants d’une application (services) s’exécutent dans des conteneurs logiquement isolés séparés qui sont connectés les uns aux autres via un réseau. Les conteneurs peuvent s’exécuter sur différents hôtes dans des clusters. Cette architecture est hautement évolutive et est largement utilisée dans les clouds de nos jours.

En outre, les centres de données fonctionnent désormais avec le Big Data, de grandes bases de données, des analyses, de la publicité contextuelle, des applications basées sur l’intelligence artificielle et d’autres logiciels nécessitant une interconnexion avec de multiples serveurs, baies de stockage, machines virtuelles ou conteneurs. Les composants des applications sont répartis sur plusieurs serveurs ou machines virtuelles dans le centre de données.

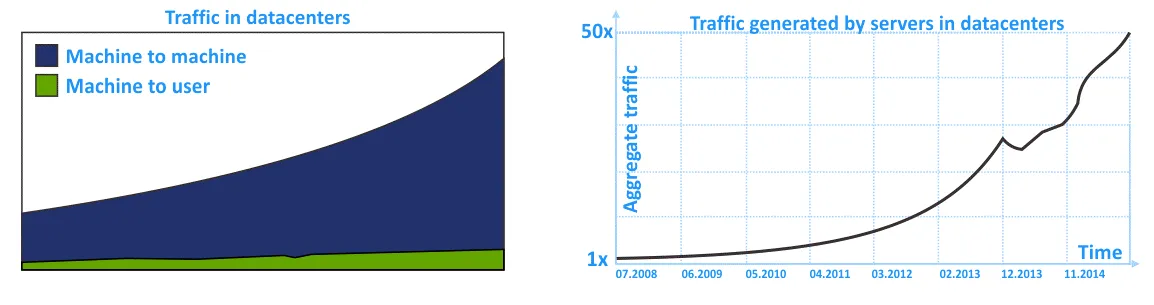

Par conséquent, le trafic est-ouest est plus élevé que le trafic nord-sud dans le réseau MSP. Le trafic interne dans un réseau de centre de données (trafic intra-DC) est plus élevé que le trafic de/vers un utilisateur externe qui envoie une demande au centre de données. N’oubliez pas le trafic interne entre les systèmes de stockage, la réplication de base de données, la sauvegarde de données et d’autres activités de service utilisant le réseau dans un centre de données.

Sur les schémas suivants, vous pouvez voir la représentation graphique de l’augmentation du trafic interne dans les réseaux MSP à l’intérieur des centres de données au cours des dernières années. La tendance montre que le trafic intra-DC augmente plus que le trafic entrant/sortant.

Les réseaux traditionnels, construits selon la topologie de réseau hiérarchique à trois niveaux traditionnelle, sont fiables mais ne sont pas adaptés de la manière la plus rationnelle pour les flux de trafic latéral. Cela est dû à l’accent mis sur le réseau L2 et le trafic nord-sud.

Topologie de réseau Clos

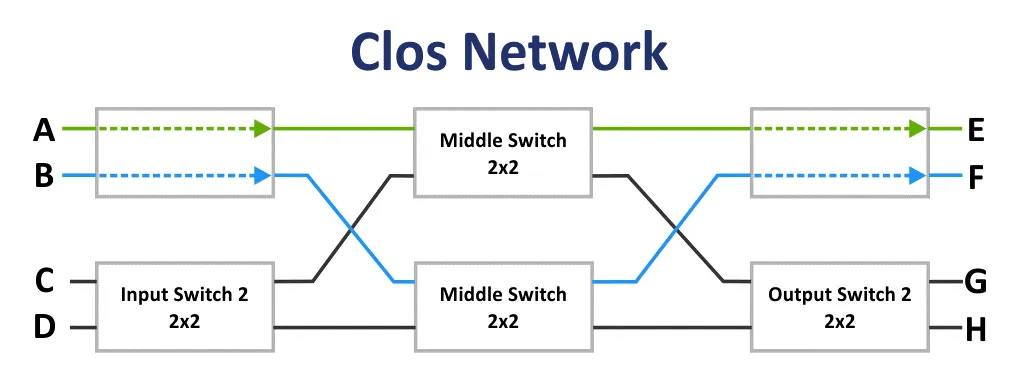

Initialement, le réseau Clos a été inventé par Edson Erwin en 1938. En 1953, Charles Clos a décidé d’utiliser des réseaux de commutation non bloquants dans les systèmes téléphoniques pour une utilisation plus rationnelle des communications par rapport au schéma de communication à barres croisées. Avec des matrices ayant un faible nombre d’interconnexions, d’entrées et de sorties, le schéma de connexion semble difficile à première vue. Cependant, le réseau Clos est moins complexe en raison d’un nombre inférieur de points de connexion selon la formule: 6n^(3/2)-3n. Ce fait devient clair à partir de 36 points de connexion.

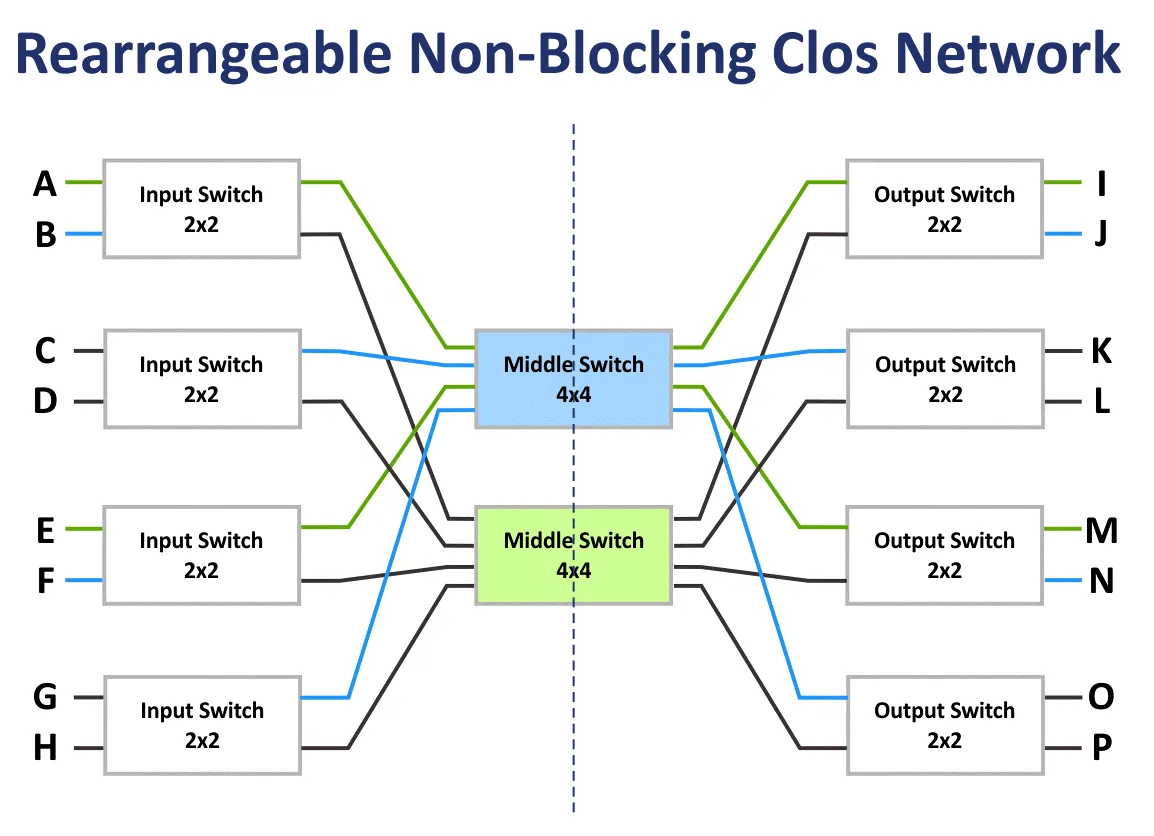

Si m est le nombre de commutateurs d’entrée et n est le nombre de commutateurs de sortie, alors les caractéristiques de blocage du réseau Clos sont calculées en utilisant la formule. Selon le théorème de Clos, un réseau Clos est strictement non bloquant si le nombre de commutateurs de deuxième étage m ≥ 2n−1.

Le réseau de blocage est un réseau dans lequel il est impossible de trouver un chemin de communication d’un port d’entrée libre à un port de sortie libre.

Le réseau non bloquant est le réseau dans lequel un chemin pour connecter n’importe quel port d’entrée et de sortie existe toujours. Les réseaux non bloquants sont créés en ajoutant un stade de commutation supplémentaire.

Le réseau non bloquant réarrangeable est le réseau dans lequel tous les chemins possibles pour connecter tous les ports d’entrée et de sortie peuvent être réarrangés.

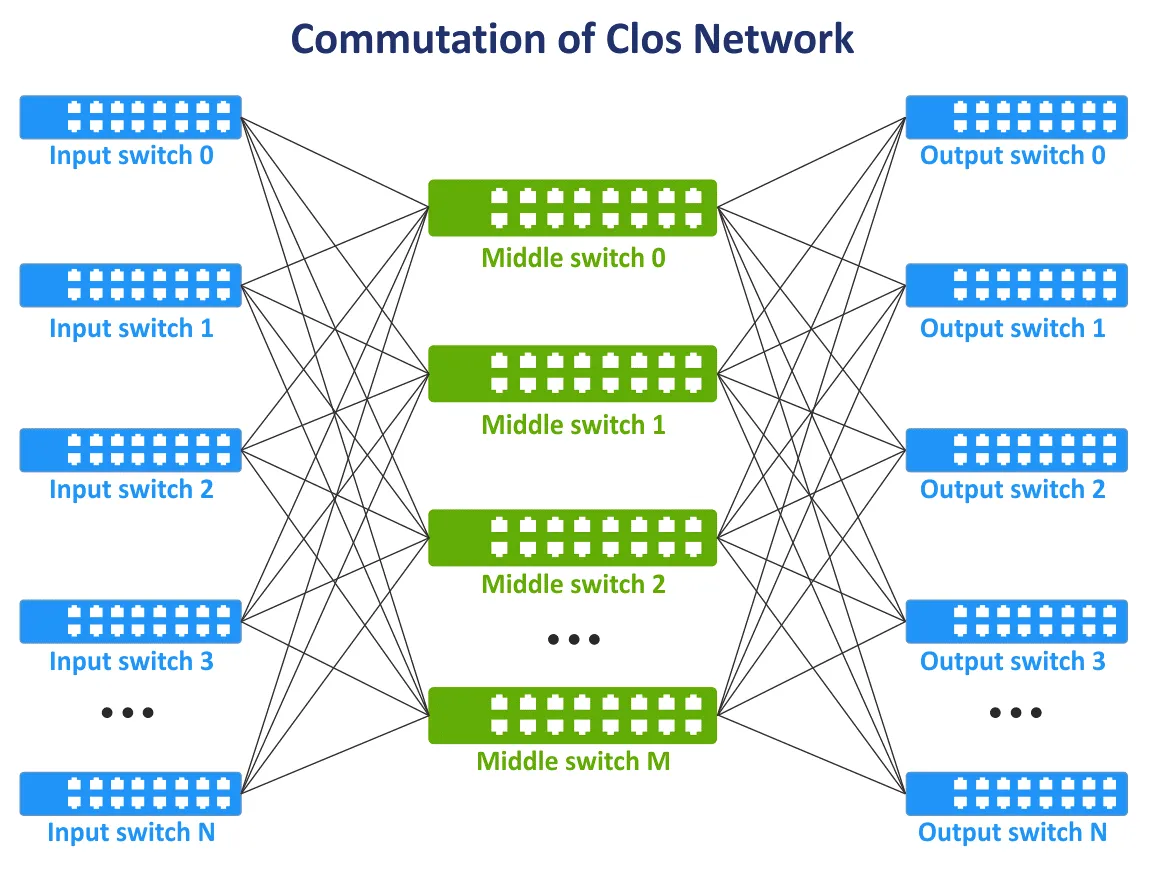

À la fin des années 1990, avec l’évolution des technologies de télécommunication et des réseaux informatiques, le concept de réseaux Clos est devenu à nouveau pertinent. Il est nécessaire que tous les nœuds communiquent entre eux dans la structure du réseau et, si possible, qu’ils n’utilisent pas la topologie en maillage complet lorsque tous les appareils sont interconnectés. Une nouvelle couche de communication a été ajoutée pour interconnecter les dispositifs réseau. En conséquence, le concept de réseau Clos a été relancé dans une nouvelle incarnation. Sur l’image suivante, vous pouvez voir un schéma typique du réseau Clos à trois couches.

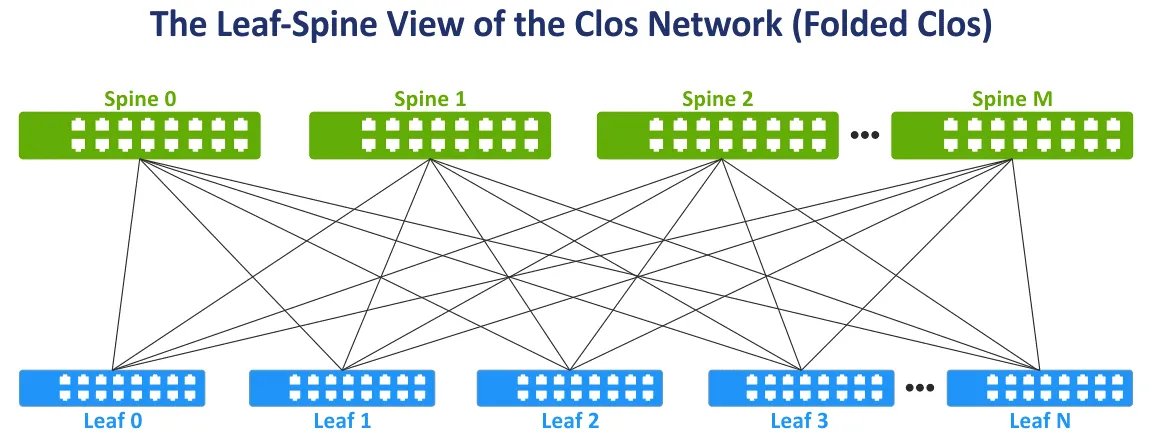

Modifions la vue du réseau Clos en vue feuille-épine largement utilisée pour plus de commodité en repliant les côtés gauche et droit du schéma. Cette topologie réseau est connue sous le nom de vue Feuille-Épine, Réseau Clos replié et Réseau Clos à 3 étages (voir l’image suivante).

La couche épineuse. Les commutateurs épineux sont utilisés pour interconnecter tous les commutateurs feuilles dans la topologie du réseau maillé complet. La couche épineuse remplace, dans une certaine mesure, la couche d’agrégation utilisée dans la topologie réseau hiérarchique traditionnelle à trois niveaux. Mais la couche épineuse n’est pas un équivalent direct de la couche d’agrégation. La tâche principale de la couche épineuse est le transfert rapide de données d’une feuille à une autre. Les appareils de point de terminaison ne sont pas connectés aux commutateurs épineux.

La couche feuille. Dans ce modèle, les serveurs ou autres appareils de point de terminaison dans le centre de données sont connectés aux feuilles. Toutes les feuilles sont connectées à toutes les épines. En conséquence, il y a un grand nombre de connexions réseau avec une bande passante égale entre tous les serveurs. Il y a des connexions L3 entre les épineux et les feuilles (L3 dans le modèle OSI).

Lorsque le trafic est transmis de la source à la destination dans le réseau, le nombre de sauts est le même (par exemple, trois sauts sont nécessaires pour transférer des données entre n’importe quels serveurs au sein du réseau à deux niveaux en étoile sur le schéma suivant). La latence est prévisible et faible. La capacité du réseau est également augmentée car il n’est plus nécessaire d’utiliser le STP. Lorsque le STP est utilisé pour les connexions redondantes entre les commutateurs, seul un lien peut être actif à la fois.

Dans la topologie de réseau en étoile, le protocole de routage multipath à coût égal (ECMP) peut être utilisé pour répartir la charge du trafic et éviter les boucles réseau (pour les connexions de réseau de couche 3). Les protocoles BGP, OSPF, EIGRP, ISIS peuvent également être utilisés.

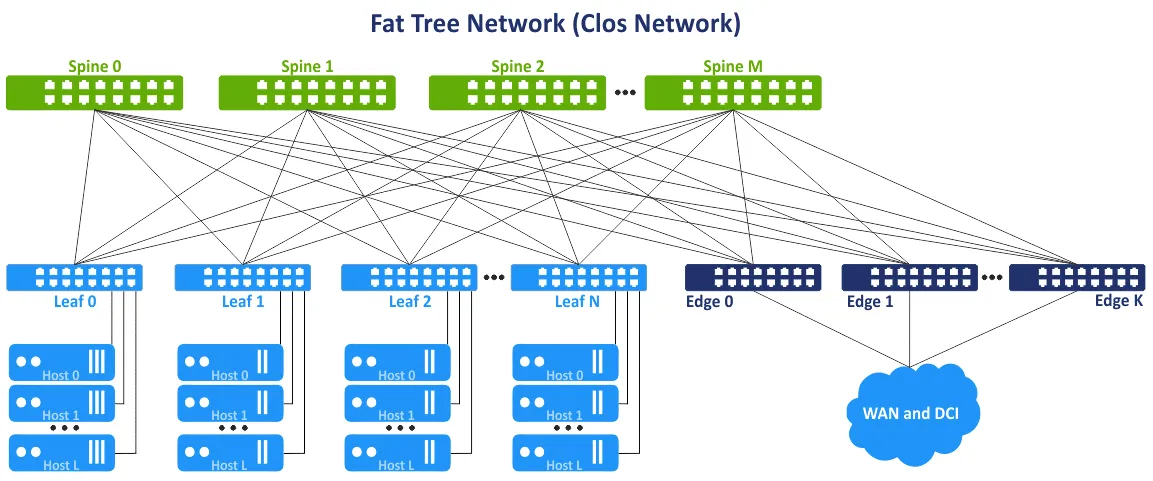

Ce concept de réseau est également appelé topologie de réseau multi-couche en arbre gras. L’idée est d’éviter les goulots d’étranglement dans les couches supérieures de l’arbre (près de la racine de l’arbre) et d’ajouter des liens supplémentaires pour augmenter la bande passante à ces segments. En conséquence, il y a une capacité de liaison croissante vers la racine. L’arbre gras est un cas particulier du réseau Clos. Le réseau Clos à trois niveaux est transformé en un réseau à deux niveaux en étoile après repliement. Des commutateurs en étoile ou des commutateurs/routeurs en bordure d’étoile peuvent être utilisés pour accéder aux réseaux externes et à d’autres centres de données.

Avantages de la topologie de réseau en étoile

La topologie de réseau en étoile offre un ensemble d’avantages par rapport à la topologie de réseau d’accès-agrégation-cœur. Cet ensemble d’avantages est la raison d’utiliser le type de topologie de réseau en étoile dans un centre de données.

Connexions optimisées. Les liens à large bande passante entre les appareils réseau sont optimaux pour le trafic est-ouest. Il n’y a pas de liens inutilisés (car le niveau 3 est utilisé au lieu du niveau 2). ECMP est recommandé pour une haute efficacité, et STP n’est pas nécessaire.

Fiable. La défaillance d’un appareil ou la déconnexion d’un lien ne cause pas de résultats négatifs significatifs et d’inconvénients. Si le commutateur ToR qui agit comme un commutateur leaf échoue, le rack correspondant est affecté. Si un commutateur spine échoue, la bande passante du réseau se dégrade mais pas de manière significative par rapport à la topologie de réseau hiérarchique traditionnelle à 3 niveaux. La dégradation de la bande passante pour la topologie épine-leaf est de 1/n, où n est le nombre d’épines. La dégradation de la bande passante pour la topologie hiérarchique est de 50% dans ce cas.

Haute évolutivité. Vous pouvez ajouter de nouvelles feuilles jusqu’à ce que vous ayez des ports libres sur les épines. Ajouter de nouvelles épines vous permet d’augmenter les liens montants des feuilles. Ajoutez des commutateurs/routeurs de bord pour augmenter la bande passante vers les réseaux externes. L’approche traditionnelle pour augmenter la bande passante et connecter plus de serveurs pour la topologie de réseau hiérarchique en couches d’arbre est d’ajouter plus de cartes réseau avec plus de ports, des équipements réseau avec des interfaces réseau plus rapides, et un matériel plus puissant en général. Cette approche traditionnelle est appelée mise à l’échelle verticale ou mise à l’échelle verticale.

Lors de l’utilisation de la topologie de réseau feuille-épine dans les centres de données et pour les réseaux MSP, vous pouvez ajouter une couche supplémentaire d’épines. Cette approche est appelée mise à l’échelle horizontale ou mise à l’échelle horizontale. Ajouter un appareil réseau typique tel qu’un commutateur/routeur augmente l’évolutivité de manière linéaire.

Entretien. Vous pouvez facilement déconnecter les épines du réseau pour l’entretien ou le remplacement. Les tâches de maintenance sur l’épine ne présentent pas de risques par rapport aux boîtes de dieu car il n’y a pas de fonctionnalité d’intelligence sur les épines, et la réduction de la bande passante est minimale après la déconnexion.

Réseau en Clos à plusieurs niveaux

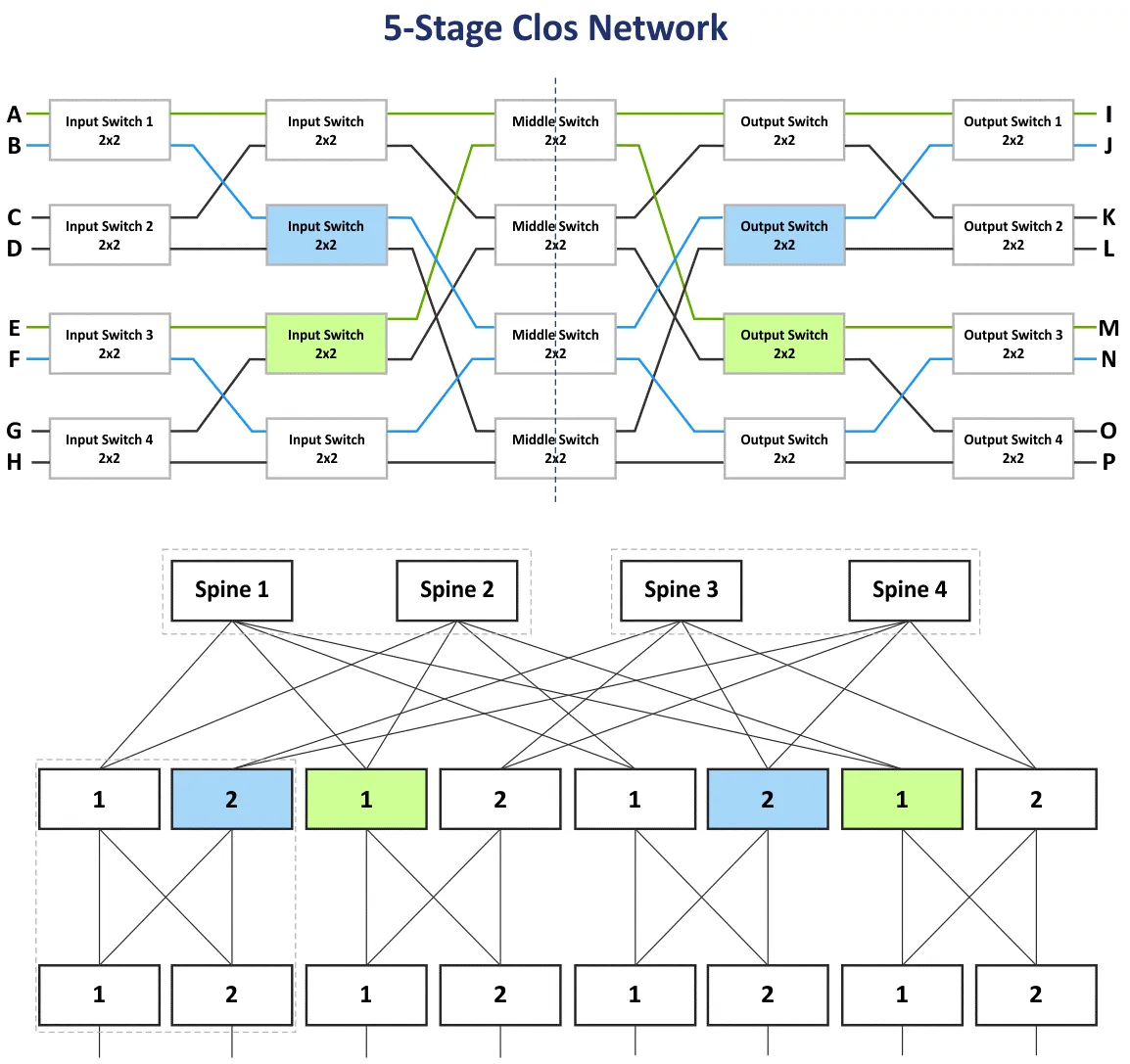

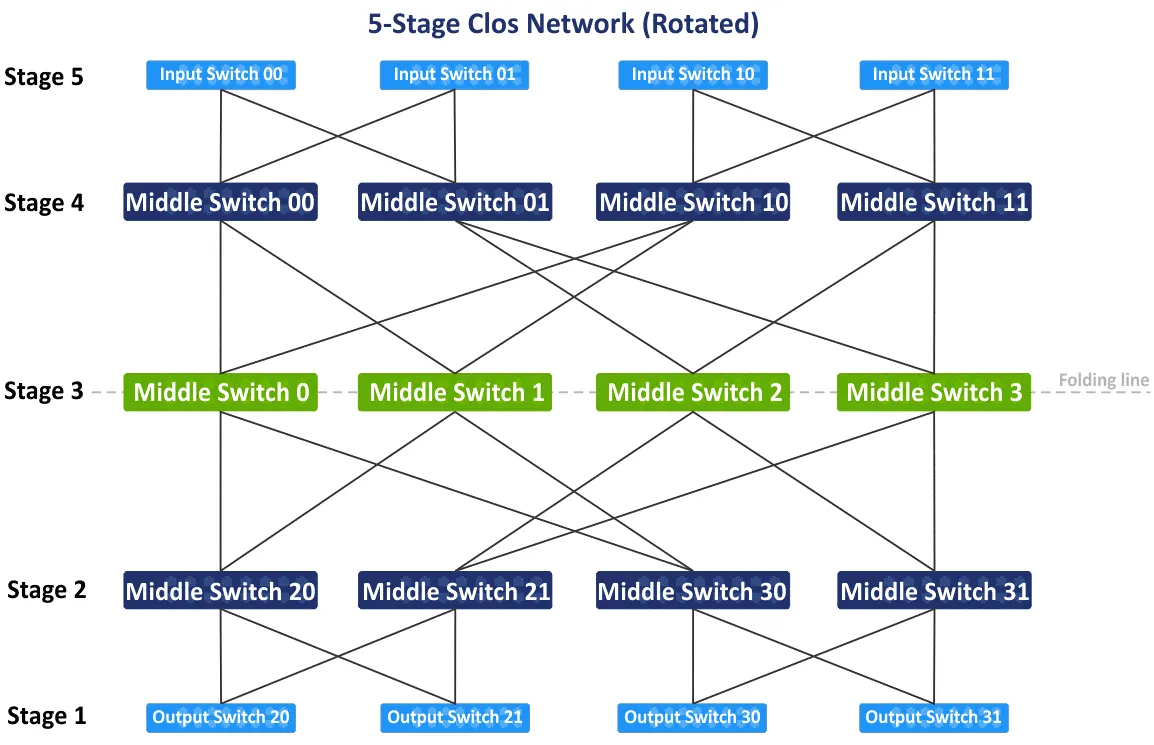

Dans la section précédente, j’ai expliqué le réseau Clos à trois étages avec les étapes : Commutateur d’entrée, Commutateur intermédiaire et Commutateur de sortie. Comme les appareils sur les étapes d’entrée et de sortie sont utilisés pour recevoir/envoyer des données, le schéma du réseau peut être plié en utilisant une ligne intermédiaire constituée d’une topologie de réseau en feuille-épine à deux niveaux. Vous pouvez ajouter plus d’étages et construire le réseau Clos à plusieurs niveaux pour connecter plus de dispositifs réseau à ce réseau. Dans ce cas, vous avez cinq étapes : Commutateur d’entrée, Commutateur intermédiaire 1, Commutateur intermédiaire 2, Commutateur intermédiaire 3, Commutateur de sortie.

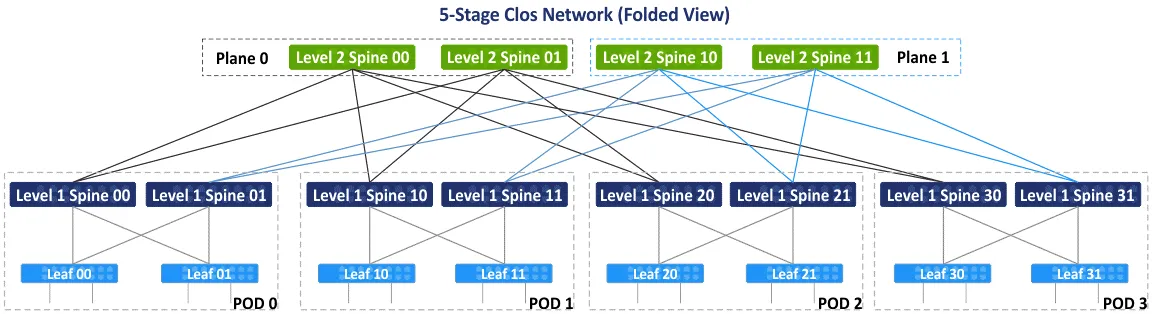

Sur le diagramme suivant, vous pouvez voir le schéma initial du réseau Clos à cinq étages non bloquant après le réarrangement des blocs bleus et verts. Il y a aussi la vue feuille-épine pliée ou la vue arbre gras (4,3) (parce qu’il y a 4 commutateurs épineux et 3 étapes sur le schéma feuille-épine), mais regardons comment connecter les dispositifs dans le réseau Clos à 5 étages étape par étape. Un type de topologie de réseau Clos avec plus de 5 étages n’est pas courant et n’est pas utilisé en pratique car le nombre de connexions est trop élevé.

Après avoir tourné le schéma initial du réseau Clos à cinq étages de 90 degrés dans le sens des aiguilles d’une montre, vous obtiendrez la vue traditionnelle avec des commutateurs d’entrée, des commutateurs de sortie et trois étages de commutateurs intermédiaires. Dessinons la ligne de pliage via les commutateurs intermédiaires au centre du schéma pour obtenir la vue pliée du réseau Clos à cinq étages.

Après avoir plié le schéma, vous obtenez la vue pliée ou la vue feuille-épine de ce type de topologies de réseau (voir le schéma suivant). Il y a 4 groupes individuels agissant comme points de distribution (POD). Le POD est l’unité universelle pour la construction des centres de données. Les POD sont connectés aux épines du premier niveau. Si vous avez besoin d’étendre votre centre de données, ou d’ajouter plus de serveurs/équipements réseau, ajoutez alors de nouveaux POD et connectez-les au tissu réseau. Les épines d’un POD sont connectées aux épines d’autres POD via les épines de deuxième niveau. En même temps, toutes les épines L1 ne sont pas connectées à toutes les épines L2, et elles sont divisées par des plans.

Il y a deux plans – Plan 0 et Plan 1 sur le schéma suivant. Ce concept est utilisé en raison du nombre limité de ports sur les épines, et la création d’une topologie de réseau entièrement connectée n’est pas possible dans ce cas. Sur le schéma suivant, chaque épine a une limite de 4 ports. Selon l’idée principale, le réseau Clos non bloquant est basé sur les mêmes éléments (commutateurs à 4 ports, comme indiqué ci-dessous).

À première vue, vous pouvez être confus avec des termes tels que Clos, Clos plié, feuille-épine et arbre gras. Permettez-moi de clarifier ces termes.

Clos ou réseau Clos est le terme qui couvre les bases théoriques du type de topologie de réseau Clos.

Le Clos replié est une représentation plus pratique du réseau Clos, où les entrées et les sorties ont le même rôle et sont situées au même endroit.

Le spine-leaf est une topologie de réseau basée sur le schéma du réseau Clos qui est utilisée en pratique dans les centres de données pour construire des réseaux, y compris les réseaux MSP.

L’arbre grassouillet est généralement considéré comme une variation du réseau Clos. Ce terme est le plus confus car certains articles mentionnent l’arbre grassouillet comme le réseau classique d’accès-agrégation-nœud central. Je me réfère au document RFC 7938 qui indique que l’arbre grassouillet est basé sur la topologie du réseau Clos replié.

Calculs

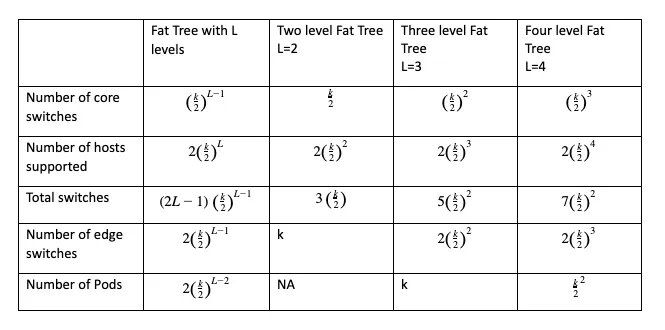

Vous pouvez calculer le nombre de commutateurs centraux, de commutateurs de bord, le nombre total de commutateurs nécessaires et le nombre total d’hôtes pouvant être connectés au réseau de la configuration sélectionnée en utilisant des formules où:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

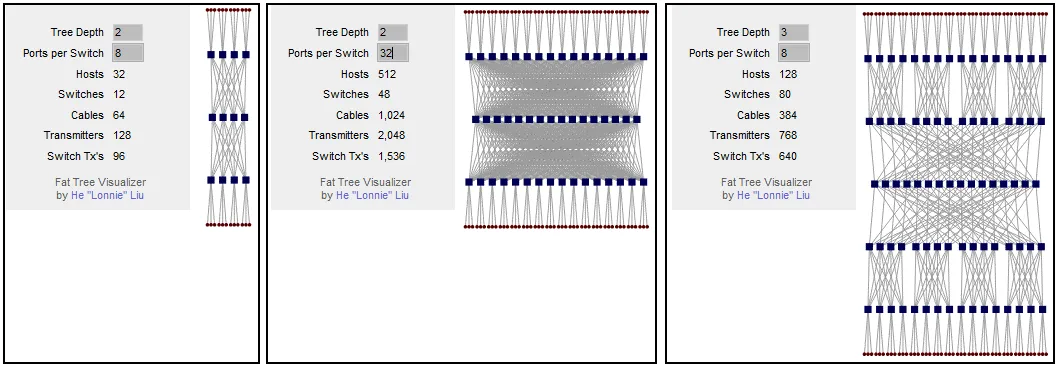

Le principal paramètre à calculer avant de construire votre réseau est le nombre d’hôtes pris en charge. La configuration de l’arbre grassouillet peut être écrite sous la forme FT(k, L). Par exemple, FT(32,3) est un réseau en arbre grassouillet à trois niveaux avec des commutateurs à 32 ports. Vous pouvez utiliser ce calculateur gratuit pour les réseaux Clos qui génère également le schéma de visualisation pour la configuration sélectionnée.

Vous pouvez calculer que si votre schéma de réseau en arbre gras a 2 niveaux et 8 ports par commutateur, vous pouvez connecter 32 hôtes au réseau. Si vous augmentez le nombre de ports par commutateur, le nombre d’hôtes pris en charge augmente à 512. Comme vous pouvez le voir, le nombre d’hôtes connectés dépend du nombre de ports sur chaque commutateur. Si vous laissez l’arbre gras à 2 niveaux (le réseau de Clos à 3 étages) et augmentez le nombre de ports par commutateur, le nombre d’épines augmente considérablement. Vous pouvez résoudre ce problème en ajoutant un niveau supplémentaire à l’arbre gras. Pour un arbre gras à trois niveaux, si le nombre de ports par commutateur est de 8, vous pouvez connecter 128 hôtes.

Si vous augmentez le nombre de ports par commutateur à 32, vous pouvez connecter 8192 hôtes en utilisant cette topologie de réseau. Ce nombre pour le réseau de Clos à 5 étages est 16 fois plus élevé que celui du réseau de Clos à 3 étages. Gardez à l’esprit les limitations de la baie de serveurs lorsque vous planifiez le schéma d’installation des serveurs et de l’équipement réseau dans le centre de données.

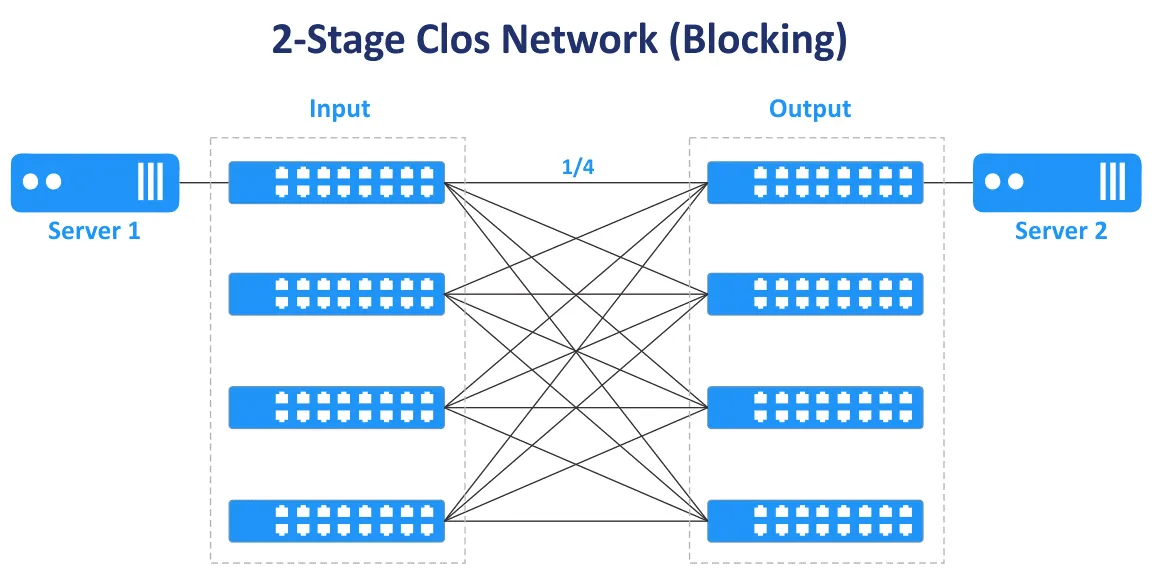

Les nombres impairs d’étages sont utilisés pour construire des réseaux Clos non bloquants (3, 5, 7, etc.). Le réseau de Clos à 2 étages ne fournit pas une connectivité non bloquante et des connexions multiples entre commutateurs.

Dans le diagramme suivant, vous pouvez voir que dans le cas du réseau de Clos à deux étages, il n’y a qu’un seul chemin de transmission pour connecter le Serveur 1 et le Serveur 2. Seuls ¼ des ports sont connectés, les autres ports ne le sont pas et ils vous bloquent.

Le ratio de surabonnement est le rapport de la bande passante d’entrée à la bande passante de sortie dans le sens des couches inférieures aux couches supérieures. Le ratio de surabonnement varie généralement de 2 à 4.

Exemple : Un commutateur a 48 ports 10-Gbit et 4 ports montants 40-Gbit. La bande passante totale des liaisons descendantes vers les serveurs est de 48×10=480 Gbit/s. La vitesse totale des liaisons montantes est de 4×40=160 Gbit/s. Le taux de surabonnement est de 480/160=4.

Si la vitesse totale de la bande passante est égale pour tous les ports descendants et montants du commutateur, le commutateur n’est pas surabonné, et il n’y a pas de goulot d’étranglement dans ce cas. Un ratio de surabonnement de 1:1 est le cas idéal. Estimez le trafic dans différentes directions avant d’acheter des commutateurs avec la vitesse et le nombre de ports appropriés.

Les commutateurs qui ont un taux de surabonnement supérieur à 1 sont souvent utilisés au niveau des feuilles dans les réseaux de la topologie de réseau en étoile-feuille. Des commutateurs non surabonnés doivent être utilisés au niveau de l’épine dorsale. Les commutateurs au niveau des feuilles dans le type de topologie de réseau en étoile-feuille sont généralement utilisés comme commutateurs ToR. Cependant, il est possible d’installer des commutateurs de feuilles en tant que commutateurs de bout de rangée.

Différences essentielles

Lors de la création d’un réseau, certaines décisions affectent la disposition du réseau. Voici quelques décisions soit-ou qui affectent le fonctionnement du réseau.

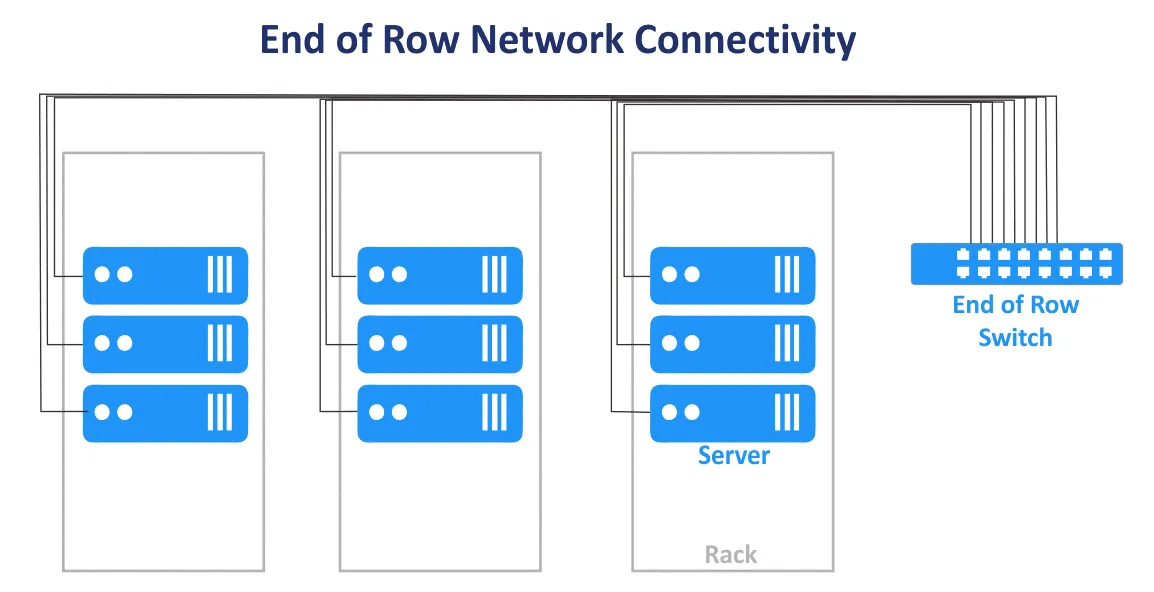

Top of Rack vs End of Row

Le schéma de connexion réseau Top of Rack (ToR) dans un centre de données consiste à installer un ou plusieurs commutateurs dans chaque baie. Des câbles de liaison courts sont utilisés pour connecter le commutateur en haut de la baie avec les autres équipements réseau et serveurs à l’intérieur de la baie. Les commutateurs ToR ont généralement des liaisons montantes haute vitesse vers les commutateurs/routeurs de niveau supérieur et peuvent être connectés avec des câbles à fibre optique. L’avantage est que lors de l’utilisation de ce schéma de connexion pour un réseau MSP, vous n’avez pas besoin d’installer une épaisse masse de câbles provenant de chaque baie dans le centre de données. L’utilisation de câbles dans le centre de données est plus rationnelle lors de l’utilisation du schéma ToR. Dans ce cas, vous dépensez moins en câblage et bénéficiez d’une meilleure gestion des câbles. Vous pouvez gérer chaque baie comme un seul module sans affecter les autres baies à l’intérieur d’un centre de données car seuls les serveurs dans une seule baie sont affectés. Malgré le nom du schéma, vous pouvez monter un commutateur au milieu ou en bas de chaque baie.

Le schéma de connexion réseau End of Row (EoR) est lorsque une baie de serveurs à l’extrémité de la rangée contient des équipements réseau. Les équipements comprennent un commutateur réseau commun pour connecter tous les serveurs et autres dispositifs de toutes les baies de serveurs dans la rangée. Les câbles provenant des équipements réseau installés dans la baie de serveurs EoR sont connectés aux dispositifs dans toutes les baies de la rangée en utilisant des panneaux de brassage montés dans chaque baie. Par conséquent, des câbles longs sont utilisés pour connecter tous les dispositifs réseau dans une rangée. Si des connexions réseau redondantes sont utilisées, le nombre de câbles augmente également. Des masses épaisses de câbles peuvent bloquer l’accès à l’air des équipements.

Les baies de serveurs sont généralement situées en rangées côte à côte dans un centre de données. Une rangée peut contenir 10 ou 12 baies, par exemple. L’ensemble de la rangée est considéré comme une unité de gestion unique lors de l’utilisation du schéma de connexion EoR pour le réseau MSP dans un centre de données. Le modèle de gestion par rangée est utilisé dans ce cas. Moins de commutateurs individuels sont nécessaires dans le modèle de connexion réseau EoR. La flexibilité est plus faible lorsque vous devez effectuer la maintenance ou mettre à niveau les commutateurs car plus d’appareils sont affectés lorsqu’un commutateur EoR est déconnecté. Malgré son nom, une baie avec un commutateur commun (des commutateurs) peut être placée au milieu de la rangée.

Connexion de couche 2 contre connexion de couche 3

La décision sur les connexions au sein d’un réseau est un calcul impliquant la fiabilité, la vitesse et les coûts, ainsi que la topologie en cours de création.

Par exemple, il existe des segments de réseau pour les topologies de réseau à trois niveaux Accès-Agrégation-Noyau et Feuille-Épine. Là, le trafic est transféré sur le modèle OSI L2 et L3. Dans le réseau hiérarchique à trois niveaux, la couche d’accès fonctionne sur L2, la couche de distribution/agrégation agrège les liens L2 et fournit un routage L3, la couche réseau principale effectue le routage sur le troisième niveau du modèle OSI. Le réseau de la topologie Feuille-Épine à plusieurs niveaux peut être configuré en utilisant L2 avec des VLAN et L3 avec un routage IP et des sous-réseaux.

Les équipements réseau de couche 2 sont moins coûteux que les équipements réseau de couche 3, mais il y a quelques inconvénients lors de l’utilisation du réseau L2 pour connecter des appareils réseau dans le réseau MSP d’un centre de données. Les VLAN sont généralement utilisés pour isoler logiquement des réseaux utilisant le même environnement physique. Le nombre maximum de VLAN est de 4095 (moins certains VLAN réservés tels que 0, 4095, 1002-1005).

Un autre inconvénient, comme mentionné précédemment, est l’incapacité d’utiliser des liens redondants lorsque le STP est utilisé sur L2. Cela s’explique par le fait qu’un seul lien peut être actif à la fois, et toute la bande passante disponible de tous les liens n’est pas utilisée. Ensuite, le domaine L2 avec STP devient grand, la probabilité de problèmes causés par un câblage incorrect et des erreurs humaines augmente, et le dépannage devient difficile.

Une configuration réseau L3 permet aux ingénieurs d’améliorer la stabilité et la scalabilité du réseau MSP et des réseaux de centres de données en général.

Les protocoles réseau suivants vous aident à gérer le réseau L3 et à router le trafic.

Le BGP (Border Gateway Protocol) est un protocole de routage dynamique largement utilisé et considéré comme la norme dans de nombreuses organisations possédant des centres de données à grande échelle. Le BGP est un protocole hautement scalable, extensible et efficace.

L’ECMP (Equal Cost Multipath Routing) est une technologie de routage réseau utilisée pour distribuer le trafic en utilisant plusieurs meilleurs chemins définis par des métriques sur la troisième couche du modèle OSI. L’ECMP avec des protocoles de routage est utilisé pour l’équilibrage de charge dans de grands réseaux. La plupart des protocoles de routage, y compris le BGP, l’EIGRP, l’IS-IS, l’OSPF, prennent en charge la technologie ECMP.

Essayez toujours d’utiliser les protocoles réseau les plus progressistes. Mais rappelez-vous que moins de protocoles utilisés dans le réseau, plus l’administration du réseau est pratique.

Topologie du réseau pour NV et SDN

En plus de la virtualisation matérielle et de l’utilisation des machines virtuelles, la virtualisation réseau avec une approche centrée sur l’application est également devenue populaire. Les solutions de virtualisation réseau (NV) telles que VMware NSX, le réseau OpenStack et Cisco ASI utilisent intensivement le trafic est-ouest dans le réseau physique, et une topologie réseau en feuille-épine convient aux solutions de virtualisation réseau pour cette raison. Lisez l’article de blog sur VMware NSX pour en savoir plus sur la virtualisation réseau.

La mise en réseau définie par logiciel (SDN) est utilisée pour virtualiser les réseaux afin d’utiliser efficacement les ressources, d’offrir de la flexibilité et une administration centralisée. C’est une solution optimale dans un centre de données virtualisé où des machines virtuelles connectées au réseau sont utilisées. Les machines virtuelles peuvent migrer entre les serveurs, créant ainsi du trafic est-ouest au sein du centre de données. Le SDN est largement utilisé pour les réseaux MSP par les MSP qui fournissent des services d’infrastructure (IaaS).

La configuration des réseaux définis par logiciel est efficace lors de l’utilisation de la topologie sous-jacente en feuille-épine avec un routage dynamique, un nombre fixe de sauts, une latence prévisible faible et une optimisation du trafic est-ouest pour la communication de serveur à serveur dans un centre de données.

VXLAN

VXLAN (Virtual eXtensible Local Area Network) est un protocole réseau amélioré utilisé à la place de VLAN dans les réseaux superposés. Les tunnels L2 sont créés en utilisant les réseaux L3 sous-jacents (sous-réseau L3) pour fournir une connectivité réseau L2 sans les limitations VLAN traditionnelles. Avec VXLAN, vous pouvez configurer le réseau L2 sur le réseau L3. La topologie virtuelle peut être différente de la topologie physique du réseau sous-jacent.

Les trames VXLAN sont encapsulées dans des paquets IP en utilisant le schéma d’encapsulation MAC-in-UDP. VNI est l’équivalent de l’ID VLAN. Le nombre maximal de VNI est de 2^24, soit environ 16 millions. VXLAN est utilisé pour créer des réseaux L2 dans des environnements étendus géographiquement, par exemple, lorsque vous devez créer un réseau à travers deux centres de données géographiquement distribués.

L’utilisation de VXLAN et de la virtualisation réseau permet d’optimiser la taille de la table d’adresses MAC pour les commutateurs ToR. Cela est dû au transfert des adresses MAC utilisées par les VM et le trafic L2 associé via le réseau de superposition L2 en utilisant VXLAN. Ils ne surchargent pas les tables MAC des commutateurs physiques. Les tables d’adresses MAC des commutateurs physiques n’excèdent pas la capacité maximale de table disponible des commutateurs.

Conclusion

Traditionnellement, les réseaux dans les centres de données étaient construits en utilisant la topologie classique en trois niveaux : accès-agrégation-noyau. Étant donné l’évolution des applications client-serveur modernes et des applications distribuées, des microservices et d’autres logiciels qui sont des sources de trafic est-ouest à l’intérieur des réseaux des MSP, la topologie du réseau feuille-épine, basée sur le concept de réseau Clos, est préférée dans les centres de données modernes et est l’une des topologies réseau les plus courantes. La topologie du réseau feuille-épine est la meilleure topologie réseau pour les grands centres de données car cette topologie est très fiable et évolutive. Avant d’installer un réseau dans un centre de données, effectuez les calculs et estimez le trafic généré et les charges de travail. Tenez compte du trafic de service tel que le trafic de sauvegarde et de réplication dans le réseau.

NAKIVO Backup & Replication est un puissant logiciel de sauvegarde de machines virtuelles qui peut protéger les charges de travail VMware Cloud Director, les VM VMware, les VM Hyper-V, ainsi que les machines physiques Linux et Windows, les bases de données Oracle. Les fournisseurs de services gérés qui fournissent une infrastructure en tant que service (IaaS), une sauvegarde en tant que service (BaaS) et une reprise après sinistre en tant que service (DRaaS) peuvent utiliser NAKIVO Backup & Replication installé en mode multi-locataire. Téléchargez l’essai gratuit de NAKIVO Backup & Replication pour les MSP qui prend en charge le mode d’installation multi-locataire.

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/