Für Managed Service Provider (MSPs) ist der Aufbau eines leistungsstarken und skalierbaren Netzwerks ein Eckpfeiler des Erfolgs. In einem vorherigen Blog-Beitrag haben wir die grundlegenden Netzwerktopologietypen behandelt, und in diesem Beitrag untersuchen wir komplexere Netzwerktopologietypen für Dienstleister, einschließlich derjenigen, die für MSP-Netzwerke bevorzugt werden. Lesen Sie diesen Blog-Beitrag, um herauszufinden, welche Topologie die beste Netzwerktopologie für ein MSP-Rechenzentrum ist und warum.

Traditionelle 3-Tier-Hierarchienetzwerke

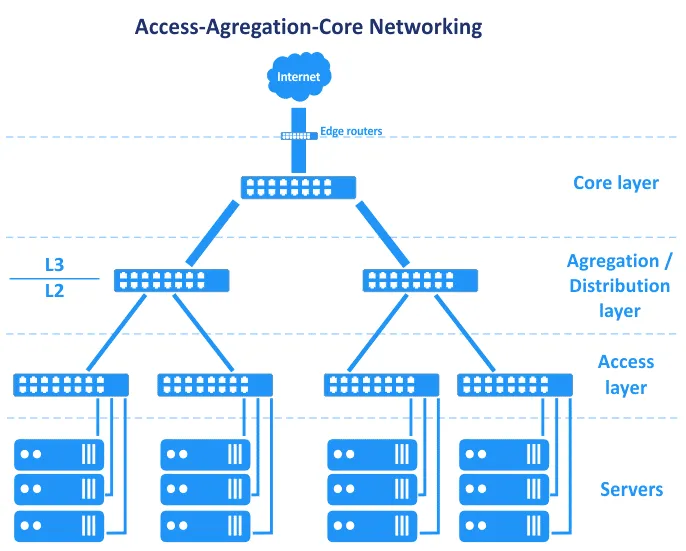

Bevor Software Defined Networks üblich wurden, basierten Netzwerke in Rechenzentren auf der hierarchischen Baumnetzwerktopologie. Diese Topologie unterteilt sich in drei primäre Ebenen: die Kernschicht, die Aggregations- oder Verteilungsschicht und die Zugriffsschicht. In dieser Topologie sind Server mit Switches in der Zugriffsschicht verbunden. Edge-Router sind mit dem Kern verbunden, um den Zugriff von/zu WAN (Wide Area Network) und dem Internet bereitzustellen. Diese Router befinden sich zwischen dem Kern und dem Internet im folgenden Schema.

Im Hinblick auf das OSI-Modell (Open Systems Interconnection), das das Netzwerk in eine Datenverbindungsschicht (L2) und eine Netzwerkschicht (L3) unter anderem unterteilt, erstreckt sich die Zugriff-Aggregations-Kern-Netzwerktopologie über Schichten, wie in der Grafik zu sehen.

Lassen Sie uns diese drei Ebenen nacheinander betrachten.

Kernschicht

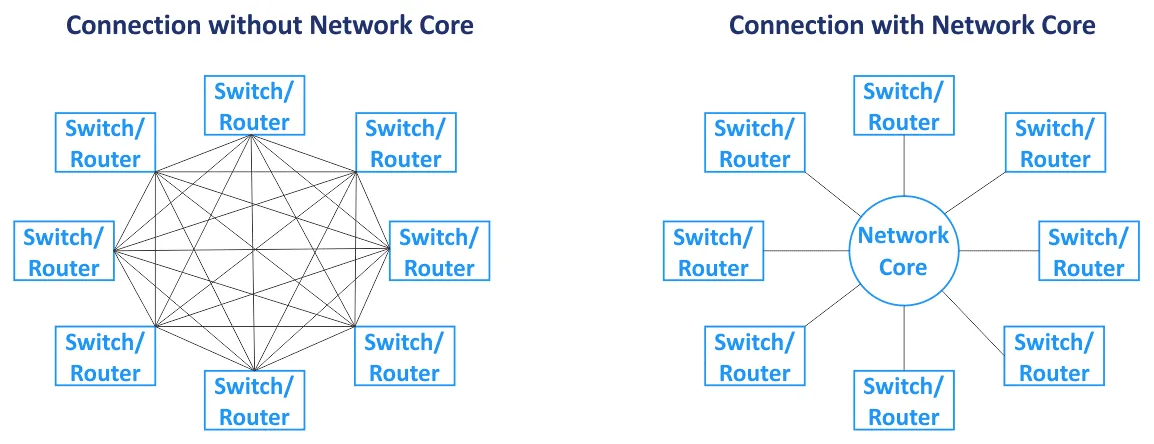

Das Kernnetzwerk (auch Kernnetz genannt) ist die zentrale Komponente des gesamten Netzwerks. Primäre Knoten sind mit dem Kern verbunden. Das Kernnetzwerk basiert normalerweise auf der Maschennetzwerk-Topologie, bei der alle Knoten mit allen anderen Knoten innerhalb des Kerns verbunden sind (für eine Vollmaschenetzwerk-Topologie). Switches und Router im Kernnetzwerk sind über Hochgeschwindigkeitsverbindungen verbunden (die auch Backbone-Verbindungen genannt werden). Da Router im Kernnetzwerk verwendet werden, arbeitet die Kernschicht mit L3-Verkehr.

Verteilungs-/Aggregationsschicht

Dies ist eine mittlere Schicht, die dazu dient, Uplinks von der unterliegenden Schicht der dreistufigen Netzwerk-Topologie (der Zugriffsschicht, die auf L2 arbeitet) zur Kernnetzwerkschicht (die normalerweise auf L3 arbeitet) mithilfe von Links mit höherer Bandbreite zu aggregieren. Die Verteilungsschicht kombiniert eine hohe Anzahl von Ports mit geringer Geschwindigkeit mit einer kleinen Anzahl von Hochgeschwindigkeits-Trunk-Ports. Die Routen beginnen auf der Verteilungs-/Aggregationsschicht dieser Netzwerk-Topologie, wenn Daten von der Zugriffsschicht übertragen werden. Die Firewall, Lastverteilung und andere Sicherheitskonfigurationen werden auf der Aggregationsschicht festgelegt. Die Aggregations-/Verteilungsschicht wird verwendet, um das Verkabelungsschema im Rechenzentrum zu reduzieren und zu vereinfachen, um eine bequemere Verwaltung zu ermöglichen. Switches, die auf der Aggregationsschicht installiert sind, müssen mehr MAC-Adressen im MAC-Adressentable in ihrem Speicher speichern können. Während die Zugriffsschicht mit L2-Verkehr arbeitet, arbeitet die Verteilungs-/Aggregationsschicht mit L2- und L3-Verkehr.

Zugriffsschicht

Diese Schicht besteht aus Switches, die auf L2 arbeiten. Server und Arbeitsstationen sind mit den Access-Layer-Switches verbunden. VLANs (virtuelle lokale Netzwerke) werden in der Regel verwendet, um L2-Broadcast-Domänen zu trennen, um den Broadcast-Verkehr zu reduzieren und die Sicherheit zu erhöhen.

Um Engpässe zu vermeiden, werden dickere Verbindungen näher am Netzwerkkern verwendet. Zum Beispiel sind Server über 10-Gbit/s-Netzwerkschnittstellen mit den Access-Switches verbunden, Access-Switches sind über 10-Gbit/s-Schnittstellen mit den Aggregations-Switches verbunden, und Switches/Router der Aggregations-Schicht sind über 100-Gbit/s-Verbindungen mit den Netzwerkkern-Switches/Routern verbunden. In diesem Fall kann die Linkaggregation verwendet werden, um die Bandbreite und Redundanz zu erhöhen. Der gesamte Datenverkehr von den Servern wird zu den Uplinks übertragen. Es gibt eine Reihe intelligenter Netzwerkausrüstungen, die als „Gott-Boxen“ bezeichnet werden und sich oben in der Hierarchie dieser Netzwerktopologie befinden. Gott-Boxen sind für das Routing und alle anderen Dienste verantwortlich. Die hierarchische Netzwerktopologie ermöglicht es, ein modulares Netzwerk zu erstellen.

In der Netzwerktopologie, die im vorherigen Diagramm zu sehen ist, führt das Versagen einer Verbindung zum Ausfall dieses Segments des Netzwerks. Aus diesem Grund werden für diesen Netzwerktopologietyp (siehe folgendes Schema) auf jeder Netzwerkschicht reservierte Kanäle und Redundanz verwendet. Das Ausfallen eines Geräts oder einer Verbindung führt zu einer Leistungsminderung, aber das Netzwerk funktioniert weiterhin. Diese redundante Netzwerktopologie erfordert normalerweise STP (Spanning Tree Protocol).

Wartung. Wenn Sie einige der Netzwerkausrüstungen an der Spitze dieses 3-stufigen Netzwerktopologietyps trennen, um die Software zu aktualisieren oder andere Wartungsaufgaben durchzuführen, nimmt die Netzwerkperformance ab. Einige Dienste können vorübergehend nicht verfügbar sein.

Skalierbarkeit. Die Anzahl der auf Servern ausgeführten Dienste wächst jedes Jahr und die Menge des Datenverkehrs nimmt entsprechend zu. Diese Situation erfordert eine Aufrüstung und eine Erhöhung der Netzwerkbandbreite im MSP-Netzwerk. Die Erhöhung der Netzwerkbandbreite in einem klassischen Rechenzentrum erforderte in der Regel folgendes:

- Erhöhung der Verbindung von Link-Aggregation (LAG)

- Kauf von Netzwerkkarten

- Wenn keine Steckplätze für die Installation von Netzwerkkarten verfügbar sind, Kauf neuer Server oder zugehöriger Ausrüstung

Wenn Sie einen neuen Serverschrank (Rack-Gehäuse) als neues Modul in Ihrem Rechenzentrum hinzufügen müssen, können Sie die Netzwerkbandbreite für diesen Schrank und die darin installierten Server erhöhen. Diese Art von Netzwerktopologien können kein hohes Maß an Link-Reservierung und Redundanz sicherstellen, das auf Funktionen von L2-Protokollen wie STP und MSTP (Multiple Spanning Tree Protocol) zurückzuführen ist.

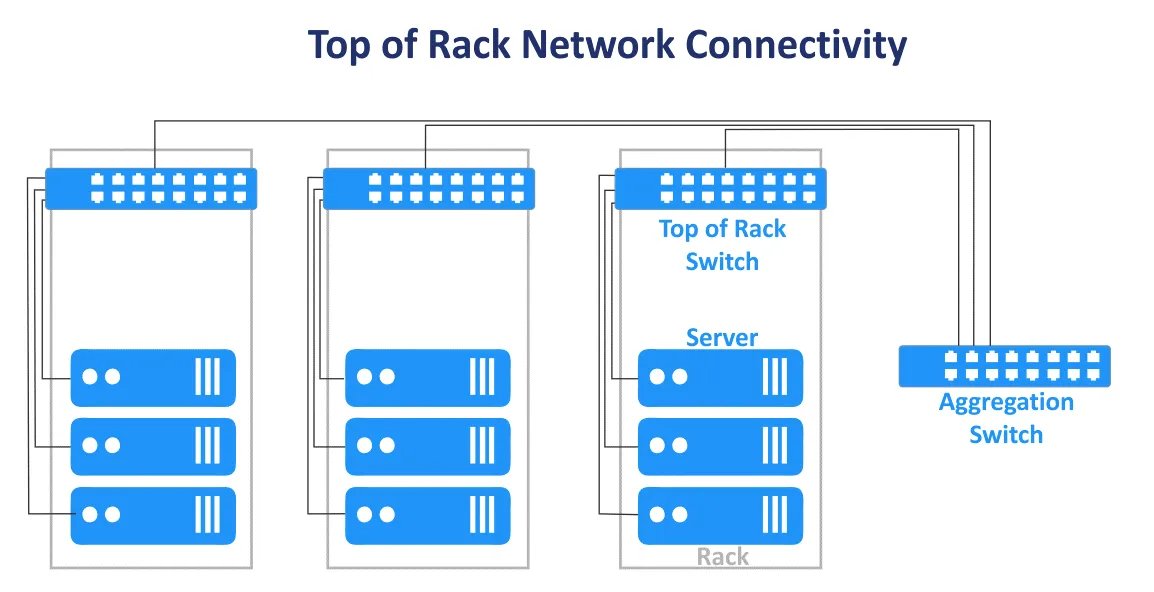

Die klassische Dreischichtnetzwerktopologie in einem Rechenzentrum kann mit den End-of-Row- und Top-of-Rack-Designs kombiniert werden. Das Top-of-Rack-Verbindungsschema ist jetzt beliebter. Dieser Name wird verwendet, weil Server und Switches mit dem Hauptswitch in jedem Rack verbunden sind. Die Top-of-Rack-Switches (ToR-Switches) sind mit Switches/Routern der höheren Ebenen im MSP-Netzwerk verbunden. ToR-Switches unterscheiden sich von Benutzerkantenswitches und verfügen über mehrere zusätzliche Hochgeschwindigkeits-Uplink-Ports (wie 10-Gbit/s-Ports) und eine hohe Anzahl von Ports zur Verbindung von Servern. ToR-Switches werden paarweise für Redundanz installiert und ermöglichen die Switch-Wartung. Die Vorteile dieses ToR-Verbindungsschemas sind die kürzere Kabelstrecke beim Verkabeln von Geräten in einem Rack und zwischen Racks. Zugriffsswitches der mehrstufigen hierarchischen Netzwerktopologie werden normalerweise als ToR-Switches verwendet.

Verkehrsrichtung

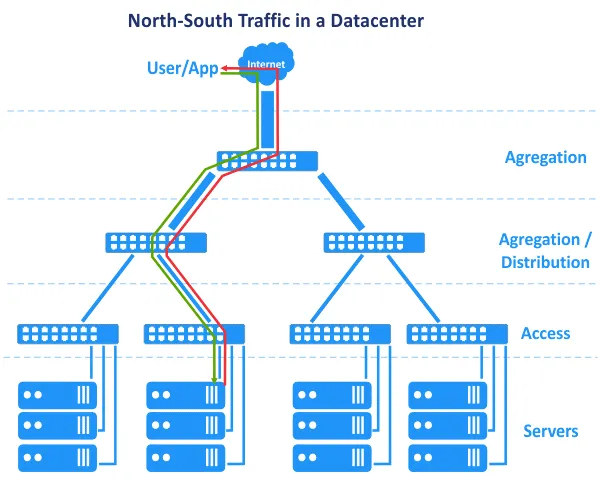

Die zuvor erklärten Nachteile sind nicht zu kritisch, und ein Rechenzentrumnetzwerk kann mit ordnungsgemäßer Verwaltung erfolgreich arbeiten. Die Änderung von L2 zu L3 in einem Teil des Netzwerks hilft, eine Reihe von Problemen zu lösen. Es gibt ein weiteres Merkmal, das damit zusammenhängt, wie Rechenzentren sich entwickelt haben und wie Anwendungen heute anders laufen als früher. In den 2000er Jahren wurden Anwendungen mit einer zentralisierten Architektur erstellt, und Anwendungen der Client-Server-Architektur waren hauptsächlich monolithisch. Dies bedeutet, dass die Komponenten einer Anwendung auf einem einzelnen Server liegen konnten. Als Ergebnis wurde in unserem Diagramm die Benutzeranfrage von oben im Netzwerk gesendet, und die Anfrage, die von der Anwendung generiert wurde, wurde vom unteren Serverlevel zurück nach oben im Netzwerk gesendet. Die Benutzeranfrage wurde auf einem einzelnen Host behandelt. Der horizontale (Ost-West-) Verkehr zwischen Hosts war minimal, und der Nord-Süd-Verkehr war bevorzugt. Die hierarchische Mehrebenen-Traditionelle Netzwerk-Topologie, die für MSP-Netzwerke in Rechenzentren verwendet wird, erfüllt diese Anforderungen. Im Laufe der Zeit wurden jedoch neue Architekturen bevorzugt, wenn Anwendungen entwickelt wurden.

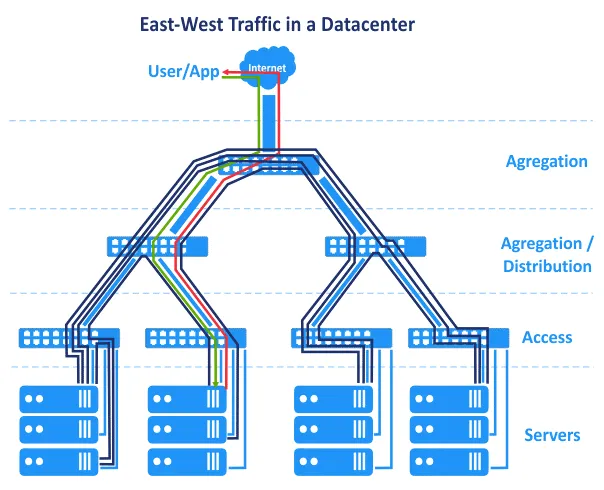

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

Mikroservice-Architektur nimmt an, dass die Komponenten einer Anwendung (Dienste) in separaten logisch isolierten Containern ausgeführt werden, die über ein Netzwerk miteinander verbunden sind. Container können auf verschiedenen Hosts in Clustern ausgeführt werden. Diese Architektur ist hoch skalierbar und wird heutzutage weit verbreitet in Clouds verwendet.

Datenzentren arbeiten heute mit Big Data, großen Datenbanken, Analytik, Kontextwerbung, Anwendungen auf Basis künstlicher Intelligenz und anderen Softwarelösungen, die eine Verbindung mit mehreren Servern, Speicherarrays, virtuellen Maschinen oder Containern erfordern. Die Anwendungskomponenten sind über mehrere Server oder VMs im Rechenzentrum verteilt.

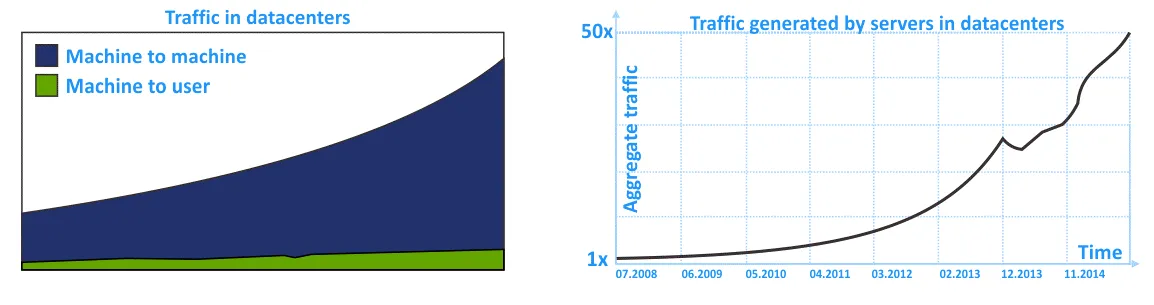

Als Folge ist der Verkehr von Ost nach West im MSP-Netzwerk höher als der von Nord nach Süd. Der interne Datenverkehr in einem Rechenzentrum (intra-DC-Verkehr) ist höher als der Verkehr von/zu einem externen Benutzer, der eine Anfrage an das Rechenzentrum sendet. Vergessen Sie nicht den internen Verkehr zwischen Speichersystemen, Datenbankreplikation, Datensicherung und anderen Serviceaktivitäten, die das Netzwerk in einem Rechenzentrum nutzen.

Auf den folgenden Diagrammen sehen Sie die grafische Darstellung des wachsenden internen Verkehrs in MSP-Netzwerken innerhalb von Rechenzentren in den letzten Jahren. Der Trend zeigt, dass der intra-DC-Verkehr stärker wächst als der ein- und ausgehende Verkehr.

Traditionelle Netzwerke, die mit der traditionellen hierarchischen Drei-Ebenen-Netzwerktopologie aufgebaut sind, sind zuverlässig, aber nicht optimal für laterale Verkehrsflüsse angepasst. Dies liegt daran, dass der Fokus auf L2-Netzwerken und Nord-Süd-Verkehr liegt.

Clos-Netzwerktopologie

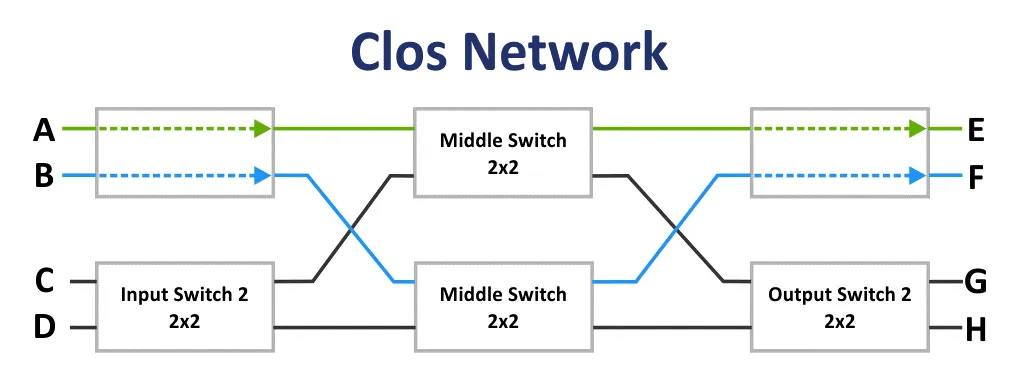

Ursprünglich wurde das Clos-Netzwerk von Edson Erwin im Jahr 1938 erfunden. Im Jahr 1953 entschied sich Charles Clos, nicht blockierende Schaltnetzwerke in Telefonsystemen zur rationelleren Nutzung der Kommunikation im Vergleich zum Kreuzschienenkommunikationsschema einzusetzen. Mit Arrays mit einer geringen Anzahl von Verbindungen, Eingängen und Ausgängen scheint das Verbindungsschema auf den ersten Blick schwierig zu sein. Das Clos-Netzwerk ist jedoch aufgrund einer geringeren Anzahl von Verbindungen weniger komplex, gemäß der Formel: 6n^(3/2)-3n. Diese Tatsache wird ab 36 Verbindungsstellen deutlich.

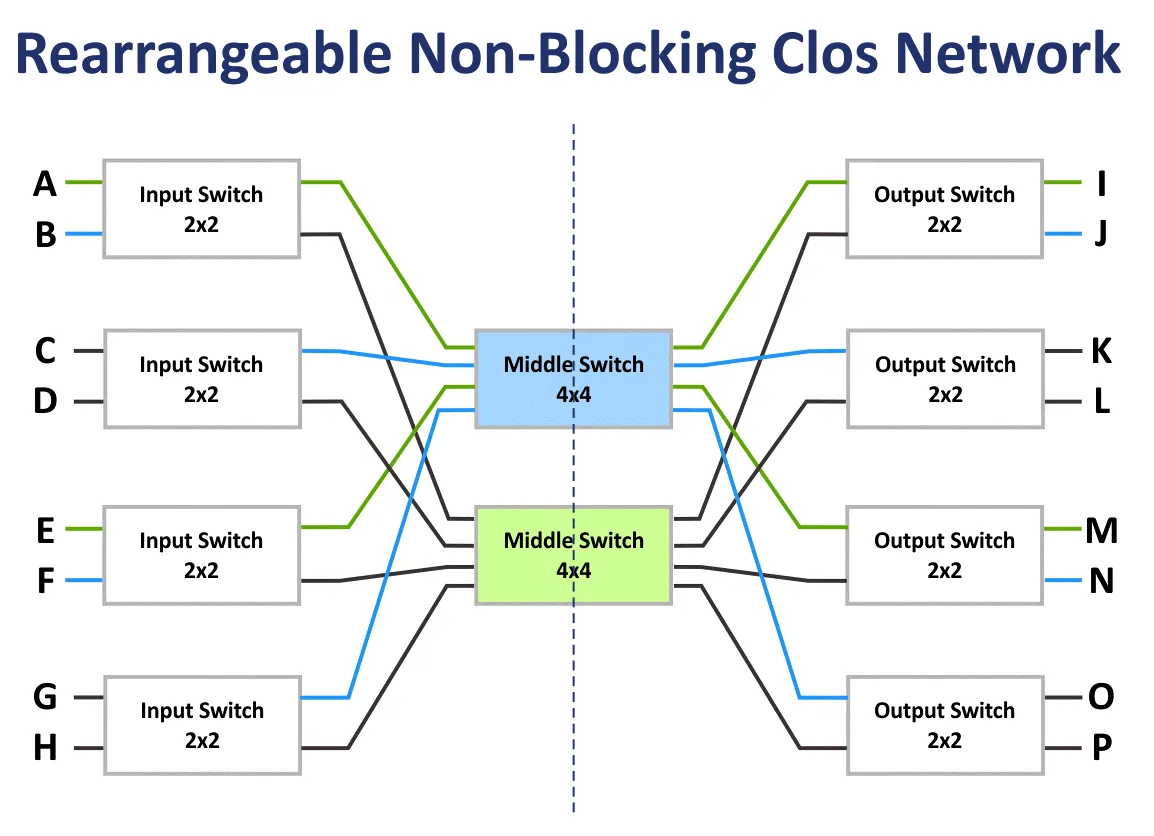

Wenn m die Anzahl der Eingangsschalter und n die Anzahl der Ausgangsschalter ist, werden die blockierenden Eigenschaften des Clos-Netzwerks mithilfe der Formel berechnet. Gemäß dem Clos-Theorem ist ein Clos-Netzwerk streng nicht blockierend, wenn die Anzahl der Schalter der zweiten Stufe m ≥ 2n−1 beträgt.

Das blockierende Netzwerk ist ein Netzwerk, in dem es unmöglich ist, einen Kommunikationspfad von einem freien Eingangsport zu einem freien Ausgangsport zu finden.

Das nicht blockierende Netzwerk ist das Netzwerk, in dem immer ein Pfad zur Verbindung eines beliebigen Eingangs- und Ausgangsports existiert. Nicht blockierende Netzwerke werden durch Hinzufügen einer zusätzlichen Umschaltstufe erstellt.

Das umschaltbare nicht blockierende Netzwerk ist das Netzwerk, in dem alle möglichen Pfade zur Verbindung aller Eingangs- und Ausgangsports neu angeordnet werden können.

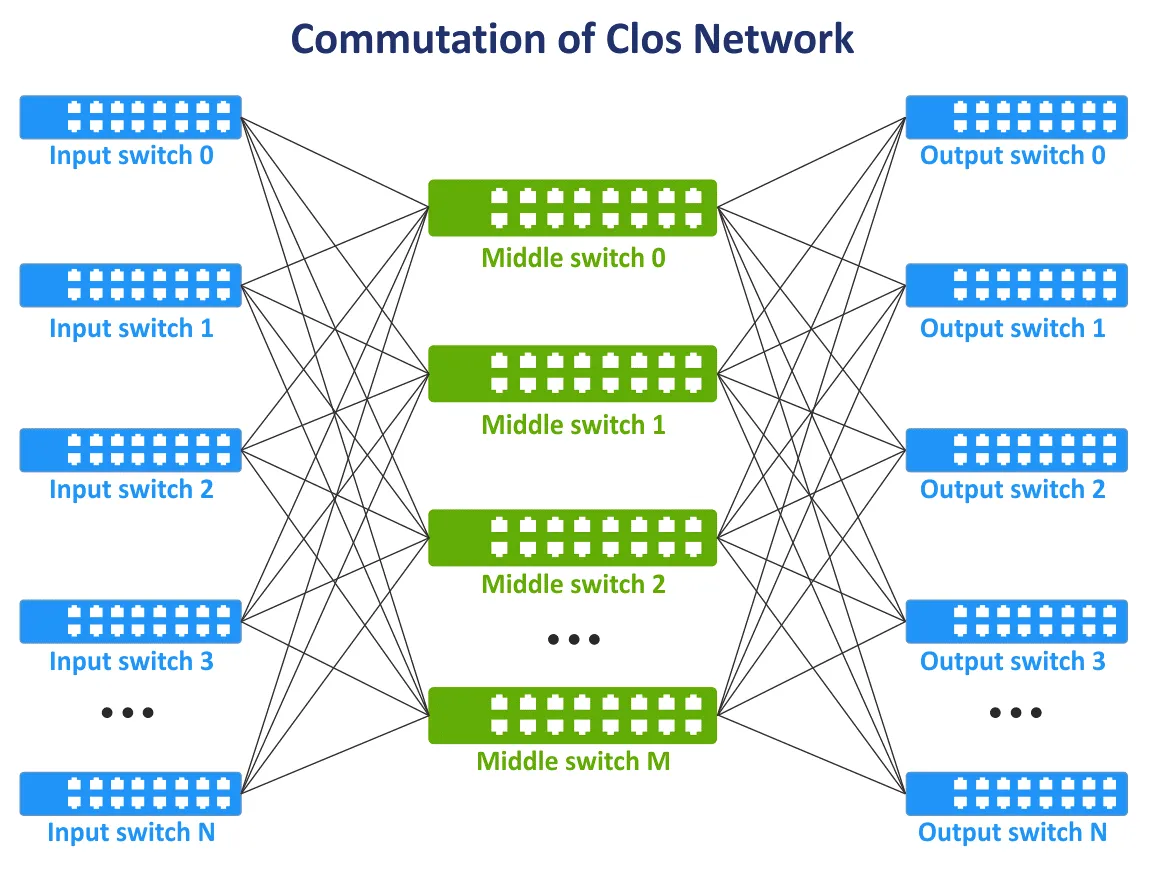

Am Ende der 1990er Jahre wurde mit der Entwicklung von Telekommunikationstechnologien und Computernetzwerken das Konzept der Clos-Netzwerke wieder relevant. Es besteht die Notwendigkeit, dass alle Knoten miteinander im Netzwerkgewebe kommunizieren, und wenn möglich, die Vollvermaschungstopologie nicht zu verwenden, wenn alle Geräte miteinander verbunden sind. Eine neue Kommunikationsschicht wurde hinzugefügt, um Netzwerkgeräte miteinander zu verbinden. Als Ergebnis wurde das Clos-Netzwerkkonzept in einer neuen Inkarnation wiederbelebt. Auf dem folgenden Bild sehen Sie ein typisches Schema des dreischichtigen Clos-Netzwerks.

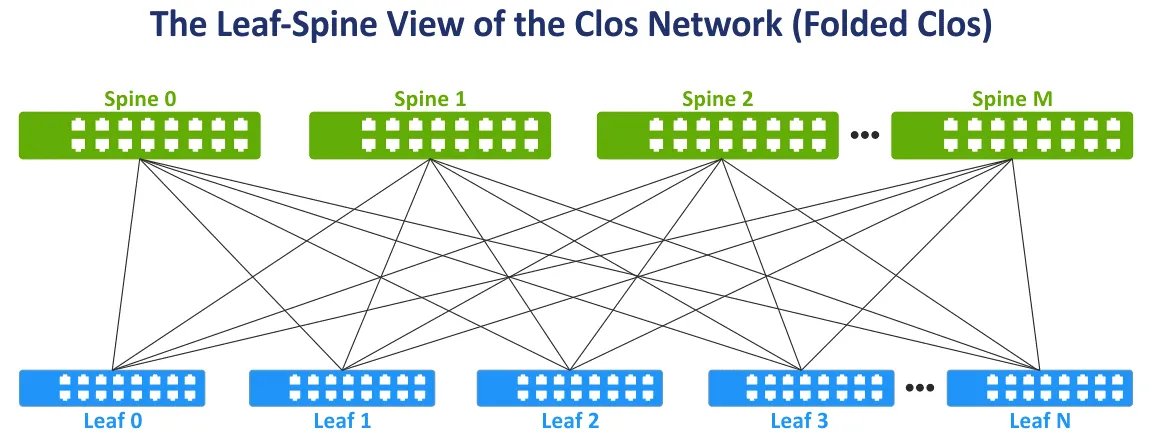

Ändern wir die Ansicht des Clos-Netzwerks in die weit verbreitete Leaf-Spine-Ansicht für mehr Bequemlichkeit, indem wir die linke und rechte Seite des Schemas falten. Diese Netzwerktopologie ist als Leaf-Spine, Gefaltete Clos- und 3-Stufen-Clos-Netzwerk bekannt (siehe das folgende Bild).

Die Spine-Schicht. Spine-Switches werden verwendet, um alle Leaf-Switches in der Vollvermaschungstopologie miteinander zu verbinden. Die Spine-Schicht ersetzt teilweise die Aggregationsschicht, die in der traditionellen dreistufigen hierarchischen Netzwerktopologie verwendet wird. Die Spine-Schicht ist jedoch kein direktes Äquivalent zur Aggregationsschicht. Die Hauptaufgabe der Spine-Schicht besteht darin, Daten schnell von einem Leaf zum anderen zu übertragen. Endgeräte sind nicht mit Spine-Switches verbunden.

Die Leaf-Schicht. In diesem Modell sind Server oder andere Endgeräte im Rechenzentrum mit den Leaves verbunden. Alle Leaves sind mit allen Spines verbunden. Als Ergebnis gibt es eine hohe Anzahl von Netzwerkverbindungen mit gleicher Bandbreite zwischen allen Servern. Zwischen Spines und Leaves gibt es L3-Verbindungen (L3 im OSI-Modell).

Wenn der Datenverkehr im Netzwerk von der Quelle zum Ziel übertragen wird, ist die Anzahl der Hops gleich (zum Beispiel werden drei Hops benötigt, um Daten zwischen beliebigen Servern im Zweischicht-Leaf-Spine-Netzwerk gemäß dem folgenden Schema zu übertragen). Die Latenz ist vorhersehbar und gering. Die Netzwerkkapazität wird ebenfalls erhöht, da STP jetzt nicht mehr verwendet werden muss. Wenn STP für redundante Verbindungen zwischen Switches verwendet wird, kann immer nur eine Verbindung gleichzeitig aktiv sein.

In der Leaf-Spine-Netzwerktopologie kann das Equal-Cost Multipath (ECMP) Routing-Protokoll verwendet werden, um den Datenverkehr auszubalancieren und Netzwerkschleifen zu verhindern (für L3-Netzwerkverbindungen). Auch die Protokolle BGP, OSPF, EIGRP und ISIS können verwendet werden.

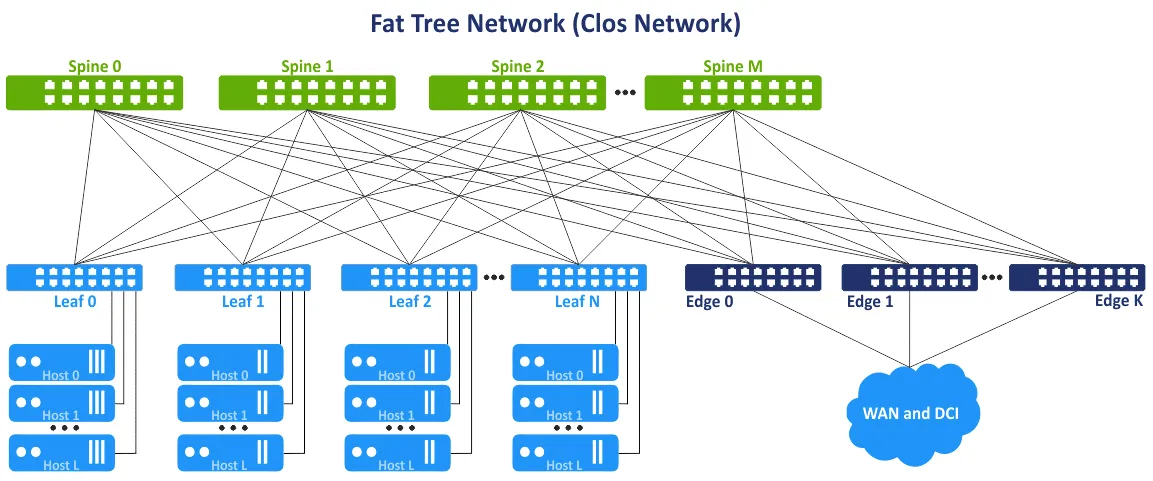

Dieses Netzwerkkonzept wird auch als Multi-Layer Fat-Tree-Netzwerktopologie bezeichnet. Die Idee besteht darin, Engpässe in den oberen Ebenen des Baums (in der Nähe der Wurzel des Baums) zu vermeiden und zusätzliche Verbindungen hinzuzufügen, um die Bandbreite in diesen Segmenten zu erhöhen. Dadurch wächst die Verbindungskapazität in Richtung Wurzel. Der Fat-Tree ist ein spezieller Fall des Clos-Netzwerks. Das dreistufige Clos-Netzwerk wird nach dem Falten zu einem zweistufigen Leaf-Spine-Netzwerk. Leaf-Switches oder Leaf-Edge-Switches/Router können verwendet werden, um auf externe Netzwerke und andere Rechenzentren zuzugreifen.

Vorteile der Leaf-Spine-Netzwerktopologie

Die Leaf-Spine-Netzwerktopologie bietet eine Reihe von Vorteilen gegenüber der Zugriff-Aggregation-Core-Netzwerktopologie. Diese Vorteile sind der Grund für die Verwendung des Leaf-Spine-Netzwerktopologie-Typs in einem Rechenzentrum.

Optimierte Verbindungen. Verbindungen mit hoher Bandbreite zwischen Netzwerkgeräten sind optimal für den Ost-West-Verkehr. Es gibt keine ungenutzten Verbindungen (da L3 anstelle von L2 verwendet wird). ECMP wird für hohe Effizienz empfohlen, und STP ist nicht notwendig.

Zuverlässigkeit. Der Ausfall eines Geräts oder die Trennung einer Verbindung führt nicht zu signifikanten negativen Ergebnissen und Nachteilen. Wenn der ToR-Switch, der als Leaf-Switch fungiert, ausfällt, ist das entsprechende Rack betroffen. Wenn ein Spine-Switch ausfällt, verringert sich die Netzwerkbandbreite, aber nicht signifikant im Vergleich zur traditionellen hierarchischen 3-Tier-Netzwerk-Topologie. Die Bandbreitenverschlechterung für die Spine-Leaf-Topologie beträgt 1/n, wobei n die Anzahl der Spines ist. Die Bandbreitenverschlechterung für die hierarchische Topologie beträgt in diesem Fall 50%.

Hohe Skalierbarkeit. Sie können neue Leafs hinzufügen, bis Sie freie Ports auf den Spines haben. Das Hinzufügen neuer Spines ermöglicht es Ihnen, die Uplinks der Leafs zu erhöhen. Fügen Sie Edge-Switches/Router hinzu, um die Bandbreite zu externen Netzwerken zu erhöhen. Der traditionelle Ansatz zur Erhöhung der Bandbreite und zum Anschließen von mehr Servern für die hierarchische Netzwerk-Topologie mit drei Ebenen besteht darin, mehr Netzwerkkarten mit mehr Ports, Netzwerkgeräte mit schnelleren Netzwerkschnittstellen und insgesamt leistungsfähigere Hardware hinzuzufügen. Dieser traditionelle Ansatz wird als Skalierung nach oben oder vertikale Skalierbarkeit bezeichnet.

Bei Verwendung der Leaf-Spine-Netzwerk-Topologie in Rechenzentren und für MSP-Netzwerke können Sie eine zusätzliche Ebene von Spines hinzufügen. Dieser Ansatz wird als horizontale Skalierbarkeit oder ausgegliederte Skalierung bezeichnet. Das Hinzufügen eines typischen Netzwerkgeräts wie eines Switches/Routers erhöht die Skalierbarkeit linear.

Wartung. Sie können die Verbindungen der Wirbelsäulen leicht für Wartungs- oder Austauschzwecke vom Netzwerk trennen. Wartungsaufgaben an den Wirbelsäulen sind im Vergleich zu All-in-One-Geräten nicht riskant, da auf den Wirbelsäulen keine Intelligenzfunktionalität vorhanden ist und die Bandbreitenreduzierung nach dem Trennen minimal ist.

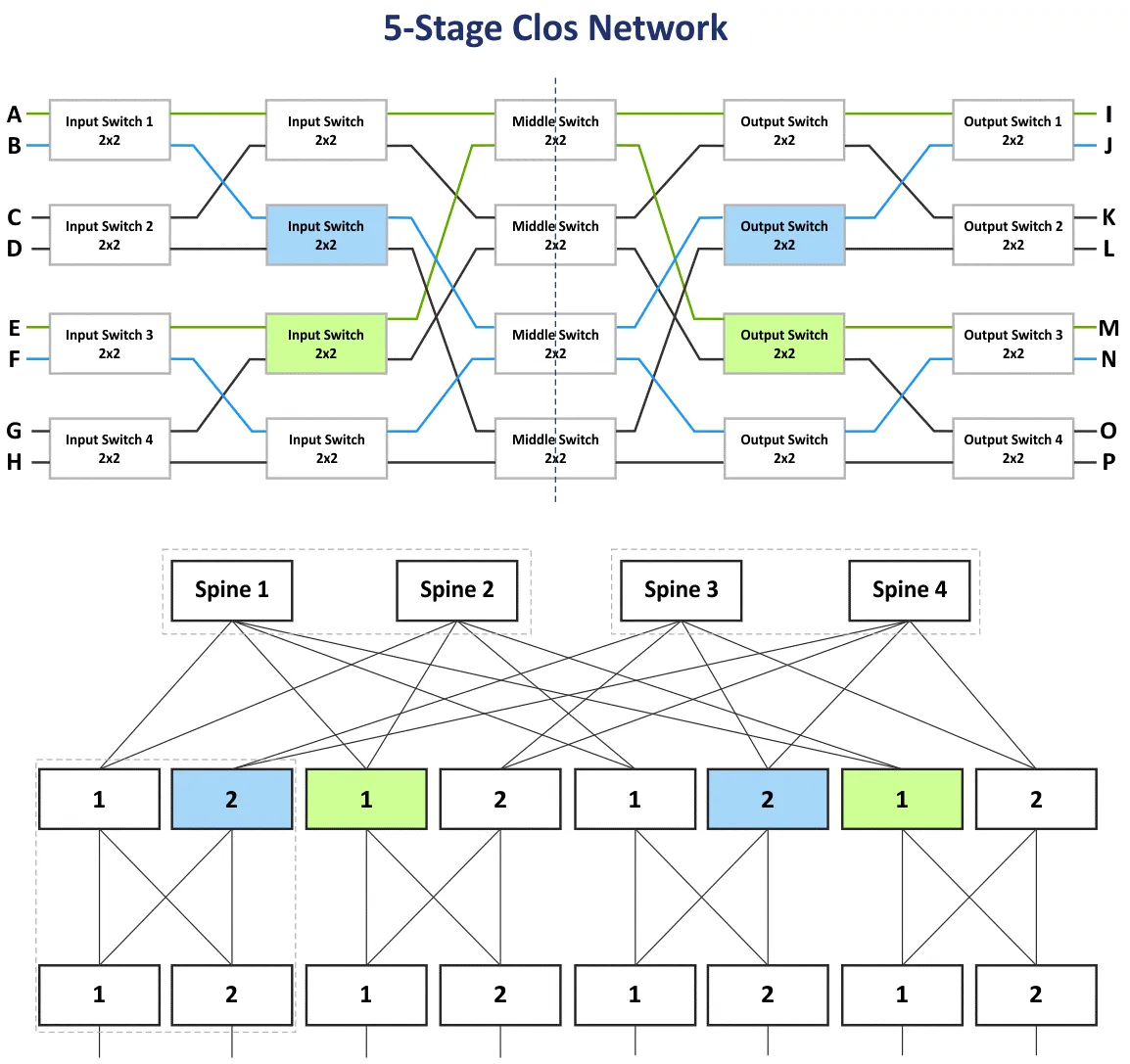

Mehrstufiges Clos-Netzwerk

Im vorherigen Abschnitt habe ich das dreistufige Clos-Netzwerk mit den Stufen: Eingangsschalter, Mittelschalter und Ausgangsschalter erklärt. Da Geräte auf den Eingangs- und Ausgangsstufen zum Empfangen/Senden von Daten verwendet werden, kann das Netzwerkschema durch Verwendung einer Mittellinie aus einem zweistufigen Blatt-Wirbelsäulen-Netzwerktopologie gefaltet werden. Sie können weitere Stufen hinzufügen und das mehrstufige Clos-Netzwerk erstellen, um mehr Netzwerkgeräte an dieses Netzwerk anzuschließen. In diesem Fall haben Sie fünf Stufen: Eingangsschalter, Mittelschalter 1, Mittelschalter 2, Mittelschalter 3, Ausgangsschalter.

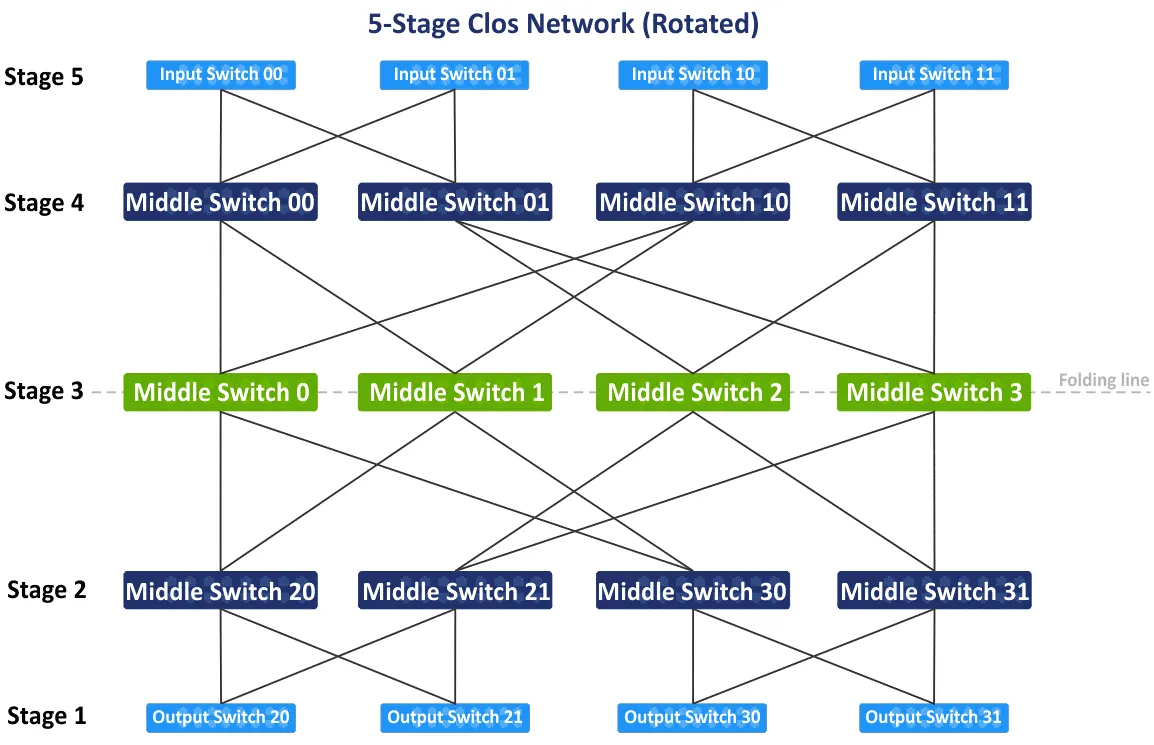

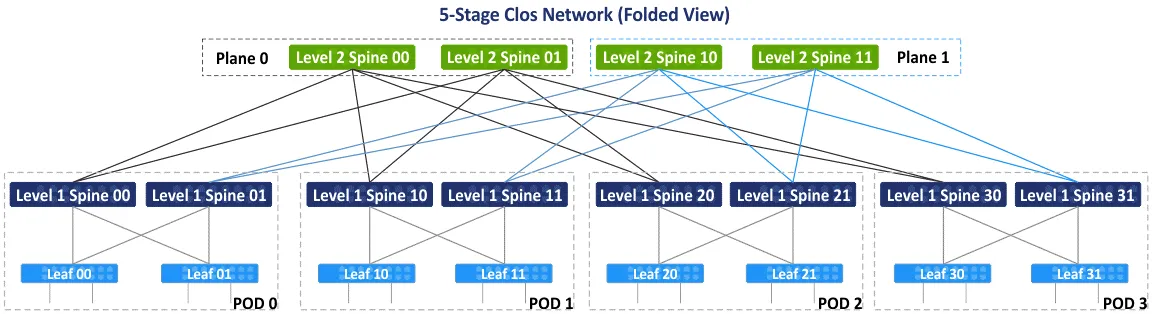

Auf dem folgenden Diagramm sehen Sie das ursprüngliche Schema des fünfstufigen nicht blockierenden Clos-Netzwerks nach der Neuordnung der blauen und grünen Blöcke. Es gibt auch die gefaltete Blatt-Wirbelsäulen-Ansicht oder die Fettbaum (4,3)-Ansicht (weil es 4 Wirbelsäulenschalter und 3 Stufen im Blatt-Wirbelsäulen-Schema gibt), aber lassen Sie uns Schritt für Schritt betrachten, wie Geräte in das 5-stufige Clos-Netzwerk eingebunden werden. Ein Clos-Netzwerktopologietyp mit mehr als 5 Stufen ist nicht üblich und wird in der Praxis nicht verwendet, da die Anzahl der Verbindungen zu groß ist.

Nachdem Sie das ursprüngliche Schema des Fünf-Stufen-Clos-Netzwerks um 90 Grad im Uhrzeigersinn gedreht haben, erhalten Sie die traditionelle Ansicht mit Eingangsschaltern, Ausgangsschaltern und drei Stufen der mittleren Schalter. Lassen Sie uns die Faltungslinie über die mittleren Schalter in der Mitte des Schemas zeichnen, um die gefaltete Ansicht des Fünf-Stufen-Clos-Netzwerks zu erstellen.

Nachdem das Schema gefaltet wurde, erhalten Sie die gefaltete Ansicht oder die Blatt-Spinalansicht dieser Art von Netzwerktopologien (siehe folgendes Schema). Es gibt 4 individuelle Gruppen, die als Punkte der Lieferung (PODs) fungieren. Der POD ist die universelle Einheit zum Aufbau von Rechenzentren. PODs sind mit den Spinalen der ersten Ebene verbunden. Wenn Sie Ihr Rechenzentrum erweitern müssen oder mehr Server/Netzwerkgeräte hinzufügen müssen, fügen Sie neue PODs hinzu und verbinden Sie sie mit dem Netzwerkverbund. Die Spinalen eines PODs sind über Spinalen der zweiten Ebene mit den Spinalen anderer PODs verbunden. Gleichzeitig sind nicht alle L1-Spinalen mit allen L2-Spinalen verbunden, und sie sind durch Ebenen getrennt.

Es gibt zwei Ebenen – Ebene 0 und Ebene 1 im folgenden Schema. Dieses Konzept wird aufgrund der begrenzten Anzahl von Ports auf Spinalen verwendet, und es ist in diesem Fall nicht möglich, eine vollständig verbundene Netzwerktopologie zu erstellen. In dem folgenden Schema hat jede Wirbelsäule eine Grenze von 4 Ports. Gemäß der Hauptidee basiert das nicht blockierende Clos-Netzwerk auf denselben Elementen (4-Port-Schalter, wie unten dargestellt).

Auf den ersten Blick können Sie mit Begriffen wie Clos, gefalteter Clos, Blatt-Spinal- und Fat-Tree-Verwirrung haben. Lassen Sie mich diese Begriffe klären.

Clos oder Clos-Netzwerk ist der Begriff, der die theoretischen Grundlagen des Clos-Netzwerktyps abdeckt.

Der gefaltete Clos ist eine bequemere Darstellung des Clos-Netzwerks, bei dem Eingänge und Ausgänge die gleiche Rolle haben und sich am selben Ort befinden.

Blatt-Stängel ist eine Netzwerktopologie, die auf dem Clos-Netzwerkschema basiert und in der Praxis in Rechenzentren verwendet wird, um Netzwerke aufzubauen, einschließlich MSP-Netzwerke.

Fettbaum wird in der Regel als Variation des Clos-Netzwerks bezeichnet. Dieser Begriff ist am verwirrendsten, weil einige Artikel den Fettbaum als das klassische Zugriff-Aggregat-Kernnetzwerk erwähnen. Ich beziehe mich auf das RFC 7938-Dokument, das besagt, dass der Fettbaum auf der Topologie des gefalteten Clos-Netzwerks basiert.

Berechnungen

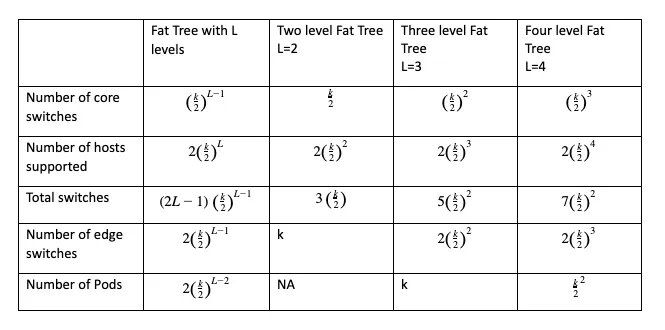

Sie können die Anzahl der Kernschalter, Kantenumschalter, insgesamt benötigten Schalter und die Gesamtanzahl der Hosts, die mit dem Netzwerk der ausgewählten Konfiguration verbunden werden können, berechnen, indem Sie Formeln verwenden, bei denen:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

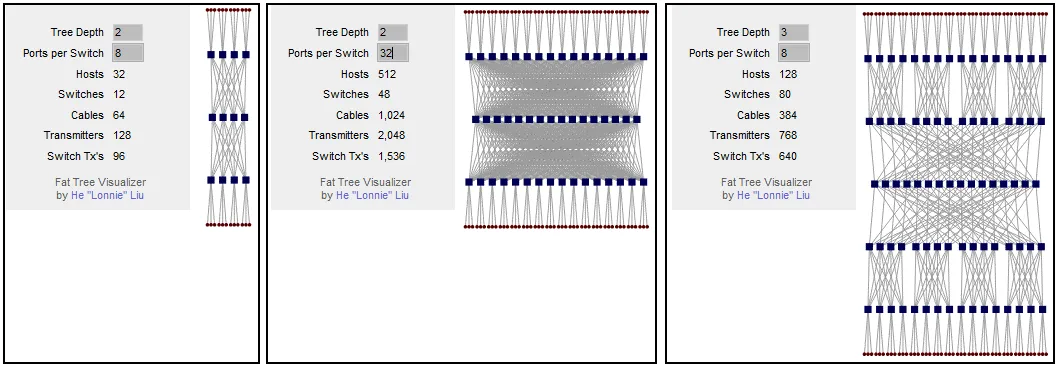

Der wichtigste Parameter, der vor dem Aufbau Ihres Netzwerks berechnet werden muss, ist die Anzahl der unterstützten Hosts. Die Fettbaumkonfiguration kann als FT(k, L) geschrieben werden. Zum Beispiel ist FT(32,3) ein Fettbaumnetzwerk mit drei Ebenen und 32-Port-Schaltern. Sie können diesen kostenlosen Rechner für Clos-Netzwerke verwenden, der auch das Visualisierungsschema für die ausgewählte Konfiguration generiert.

Sie können berechnen, dass bei einem Fat-Tree-Netzwerkplan mit 2 Ebenen und 8 Ports pro Switch 32 Hosts mit dem Netzwerk verbunden werden können. Wenn Sie die Anzahl der Ports pro Switch erhöhen, erhöht sich die Anzahl der unterstützten Hosts auf 512. Wie Sie sehen können, hängt die Anzahl der verbundenen Hosts von der Anzahl der Ports an jedem Switch ab. Wenn Sie den Fat Tree bei 2 Ebenen belassen (das 3-stufige Clos-Netzwerk) und die Anzahl der Ports pro Switch erhöhen, steigt die Anzahl der Spines signifikant an. Sie können dieses Problem lösen, indem Sie dem Fat Tree eine weitere Ebene hinzufügen. Bei einem dreistufigen Fat Tree können Sie bei 8 Ports pro Switch 128 Hosts verbinden.

Wenn Sie die Anzahl der Ports pro Switch auf 32 erhöhen, können Sie mithilfe dieser Netzwerktopologie 8192 Hosts verbinden. Diese Zahl für das 5-stufige Clos-Netzwerk ist 16 Mal höher als die für das 3-stufige Clos-Netzwerk. Beachten Sie die Einschränkungen des Serverschranks, wenn Sie den Installationsplan für Server und Netzwerkgeräte im Rechenzentrum planen.

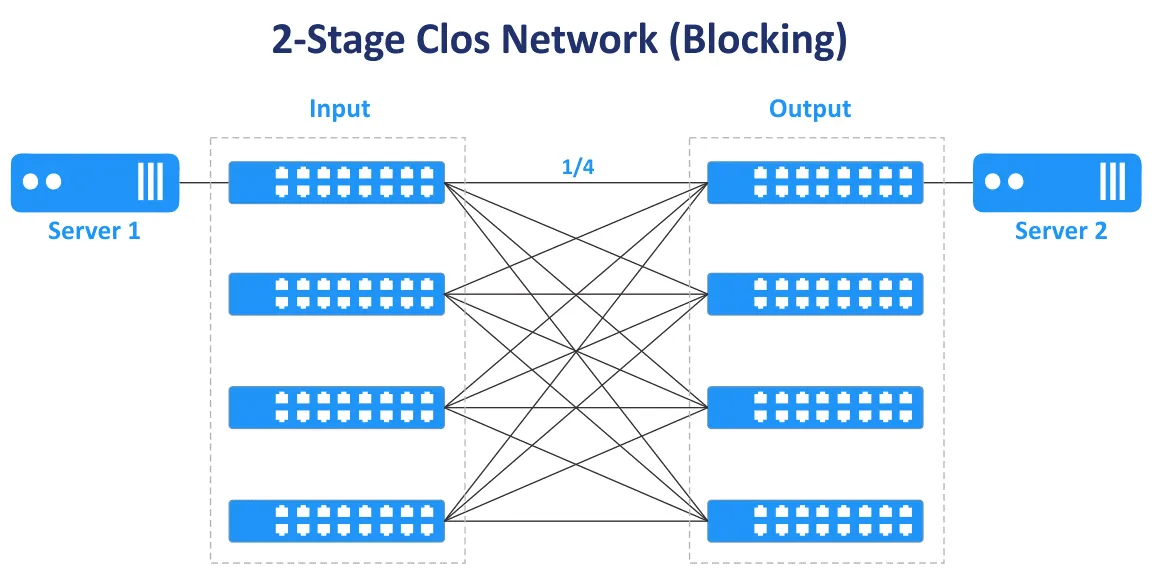

Ungerade Stufen werden verwendet, um nicht blockierende Clos-Netzwerke zu erstellen (3, 5, 7 usw.). Das 2-stufige Clos-Netzwerk bietet keine nicht blockierende Konnektivität und mehrere Verbindungen zwischen Switches.

In dem folgenden Diagramm können Sie sehen, dass im Fall des zweistufigen Clos-Netzwerks nur ein Übertragungspfad vorhanden ist, um Server 1 und Server 2 zu verbinden. Nur ¼ der Ports sind verbunden, andere Ports sind nicht verbunden und blockieren Sie.

Das Überbuchungsverhältnis ist das Verhältnis von Eingangsbandbreite zu Ausgangsbandbreite in Richtung von unteren Schichten zu oberen Schichten. Das Überbuchungsverhältnis variiert normalerweise zwischen 2 und 4.

Beispiel: Ein Switch hat 48 10-Gbit-Ports und 4 40-Gbit-Uplink-Ports. Die Gesamtbandbreite der Downlinks zu den Servern beträgt 48×10=480 Gbit/s. Die Gesamtgeschwindigkeit der Uplinks beträgt 4×40=160 Gbit/s. Das Überzeichnungsverhältnis beträgt 480/160=4.

Wenn die Gesamtbandbreitengeschwindigkeit für alle Downlink- und Uplink-Ports des Switches gleich ist, ist der Switch nicht überzeichnet, und es gibt in diesem Fall keine Engpässe. Ein Überzeichnungsverhältnis von 1:1 ist der ideale Fall. Schätzen Sie den Datenverkehr in verschiedenen Richtungen ab, bevor Sie Switches mit der geeigneten Geschwindigkeit und Anzahl von Ports kaufen.

Switches, die ein Überzeichnungsverhältnis von mehr als 1 haben, werden oft auf der Leaf-Ebene in Netzwerken der Leaf-Spine-Netzwerktopologie verwendet. Nicht überzeichnete Switches sollten auf der Spine-Ebene verwendet werden. Switches auf der Leaf-Ebene im Leaf-Spine-Netzwerktopologie-Typ werden normalerweise als ToR-Switches verwendet. Es ist jedoch möglich, Leaf-Switches als End-of-Row-Switches zu installieren.

Essentielle Unterschiede

Bei der Erstellung eines Netzwerks beeinflussen einige Entscheidungen die Struktur des Netzwerks. Hier sind einige Entweder-oder-Entscheidungen, die die Funktionsweise des Netzwerks beeinflussen.

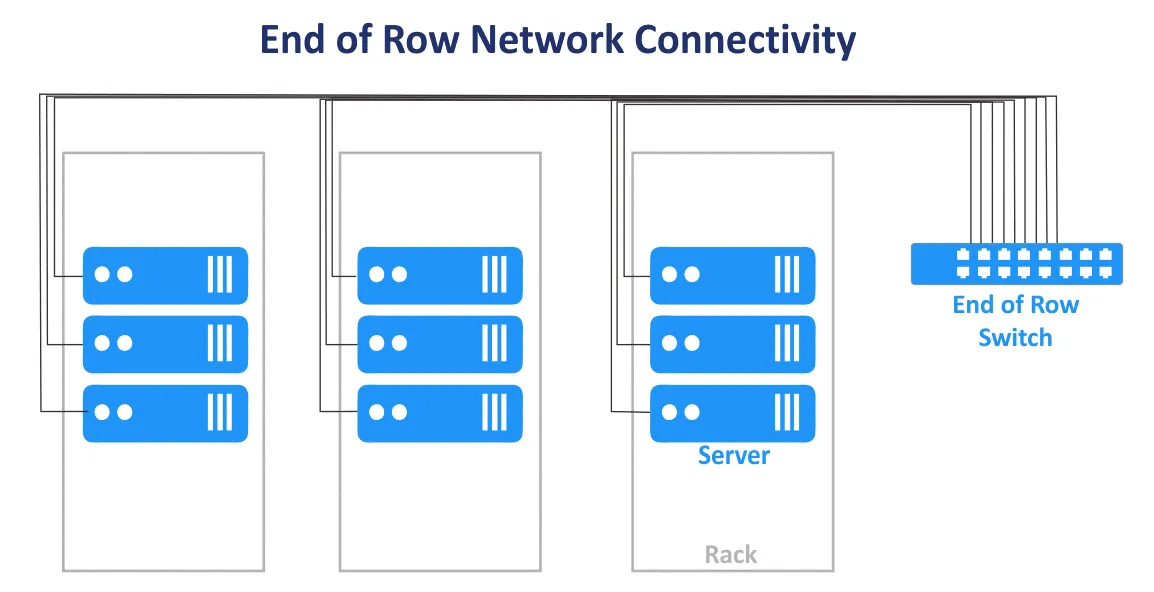

Top of Rack vs. End of Row

Die Top of Rack (ToR) Netzwerkverbindungsschema in einem Rechenzentrum ist, wo ein oder mehrere Switches in jedem Rack installiert sind. Kurze Patchkabel werden verwendet, um den Switch oben im Rack mit anderen Netzwerkgeräten und Servern innerhalb des Racks zu verbinden. ToR-Switches haben normalerweise Hochgeschwindigkeits-Uplinks zu den Switches/Routern der höheren Ebene und können mit Glasfaserkabeln verbunden werden. Der Vorteil besteht darin, dass bei Verwendung dieses Verbindungsschemas für ein MSP-Netzwerk keine dickes Bündel von Kabeln aus jedem Rack im Rechenzentrum installiert werden müssen. Die Kabelnutzung im Rechenzentrum ist rationaler, wenn das ToR-Schema verwendet wird. In diesem Fall geben Sie weniger für die Verkabelung aus und haben eine bessere Kabelverwaltung. Sie können jedes Rack als einzelnes Modul verwalten, ohne andere Racks innerhalb eines Rechenzentrums zu beeinträchtigen, da nur Server in einem Rack betroffen sind. Trotz des Schemanamens können Sie einen Switch in der Mitte oder am Boden jedes Racks montieren.

Das End of Row (EoR) Netzwerkverbindungsschema besteht darin, dass ein Serverschrank am Ende der Reihe Netzwerkgeräte enthält. Die Ausrüstung umfasst einen gemeinsamen Netzwerkswitch, um alle Server und anderen Geräte aller Serverschränke in der Reihe zu verbinden. Kabel von den im EoR-Serverschrank installierten Netzwerkgeräten sind mit Geräten in allen Racks der Reihe verbunden, indem Patchpanels in jedem Rack montiert werden. Als Ergebnis werden lange Kabel verwendet, um alle Netzwerkgeräte in einer Reihe zu verbinden. Wenn redundante Netzwerkverbindungen verwendet werden, erhöht sich auch die Anzahl der Kabel. Dicke Bündel von Kabeln können den Luftzugang zur Ausrüstung blockieren.

Server-Racks sind in der Regel als nebeneinander liegende Reihen in einem Rechenzentrum positioniert. Eine Reihe kann beispielsweise 10 oder 12 Racks enthalten. Die gesamte Reihe wird als einzelne Verwaltungseinheit betrachtet, wenn im Rechenzentrum das EoR-Verbindungsschema für das MSP-Netzwerk verwendet wird. In diesem Fall wird das pro-Reihen-Verwaltungsmodell verwendet. Im EoR-Netzwerkverbindungsmodell sind weniger einzelne Switches erforderlich. Die Flexibilität ist geringer, wenn Wartungsarbeiten durchgeführt werden müssen oder Switches aktualisiert werden müssen, da mehr Geräte betroffen sind, wenn ein EoR-Switch getrennt wird. Trotz seines Namens kann ein Rack mit einem gemeinsamen Switch (Switches) in die Mitte der Reihe gestellt werden.

Schicht-2 vs. Schicht-3-Verbindung

Die Entscheidung über die Verbindungen innerhalb eines Netzwerks ist eine Berechnung, die Zuverlässigkeit, Geschwindigkeit und Kosten sowie die erstellte Topologie umfasst.

Zum Beispiel gibt es Netzwerksegmente für die dreistufige Access-Aggregation-Core-Netzwerktopologie und die Leaf-Spine-Topologie. Dort wird der Datenverkehr auf dem OSI-Modell L2 und L3 übertragen. Im hierarchischen dreistufigen Netzwerk arbeitet die Zugangsschicht auf L2, die Verteilungs-/Aggregationsschicht aggregiert L2-Verbindungen und bietet L3-Routing, die Kernnetzwerkschicht führt Routing auf der dritten Schicht des OSI-Modells durch. Das Netzwerk der mehrstufigen Leaf-Spine-Topologie kann durch die Verwendung von L2 mit VLANs und L3 mit IP-Routing und Subnetzen konfiguriert werden.

L2-Netzwerkgeräte sind kostengünstiger als L3-Netzwerkgeräte, aber es gibt einige Nachteile bei der Verwendung von L2-Netzwerken zum Verbinden von Netzwerkgeräten im MSP-Netzwerk eines Rechenzentrums. VLAN wird normalerweise verwendet, um Netzwerke logisch zu isolieren, die dieselbe physische Umgebung nutzen. Die maximale Anzahl von VLANs beträgt 4095 (abzüglich einiger reservierter VLANs wie 0, 4095, 1002-1005).

Ein weiterer Nachteil, wie zuvor erwähnt, ist die Unfähigkeit, redundante Links zu verwenden, wenn STP auf L2 angewendet wird. Dies liegt daran, dass gleichzeitig nur ein Link aktiv sein kann und die gesamte verfügbare Bandbreite aller Links nicht genutzt wird. Wenn das L2-Domäne mit STP groß wird, steigt die Wahrscheinlichkeit von Problemen aufgrund unsachgemäßer Verkabelung und menschlicher Fehler, und die Fehlerbehebung wird schwierig.

Eine L3-Netzwerkkonfiguration ermöglicht es Ingenieuren, die Stabilität und Skalierbarkeit des MSP-Netzwerks und der Rechenzentrumnetzwerke im Allgemeinen zu verbessern.

Die folgenden Netzwerkprotokolle helfen Ihnen, das L3-Netzwerk zu verwalten und den Datenverkehr zu routen.

BGP (Border Gateway Protocol) ist ein Protokoll für dynamisches Routing, das weit verbreitet ist und in vielen Organisationen mit großen Rechenzentren als Standard gilt. BGP ist ein hoch skalierbares, erweiterbares und effizientes Protokoll.

ECMP (Equal Cost Multipath Routing) ist eine Netzwerk-Routing-Technologie, die verwendet wird, um den Verkehr durch die Verwendung mehrerer bester Pfade zu verteilen, die durch Metriken auf der dritten Ebene des OSI-Modells definiert sind. ECMP mit Routing-Protokollen wird für die Lastverteilung in großen Netzwerken verwendet. Die meisten Routing-Protokolle, einschließlich BGP, EIGRP, IS-IS, OSPF, unterstützen die ECMP-Technologie.

Versuchen Sie immer, die fortschrittlicheren Netzwerkprotokolle zu verwenden. Aber denken Sie daran, dass je weniger Protokolle im Netzwerk verwendet werden, desto bequemer ist die Netzwerkverwaltung.

Netzwerktopologie für NV und SDN

Zusätzlich zur Hardwarevirtualisierung und der Verwendung von Virtual Machines ist auch die Netzwerkvirtualisierung mit einem anwendungsorientierten Ansatz populär geworden. Netzwerkvirtualisierungslösungen (NV) wie VMware NSX, OpenStack Networking und Cisco ASI nutzen intensiv den Ost-West-Verkehr im physischen Netzwerk, und eine Leaf-Spine-Netzwerktopologie eignet sich aus diesem Grund für Netzwerkvirtualisierungslösungen. Lesen Sie den Blogbeitrag über VMware NSX, um mehr über Netzwerkvirtualisierung zu erfahren.

Softwaredefiniertes Networking (SDN) wird verwendet, um Netzwerke für effektive Ressourcennutzung, Flexibilität und zentrale Verwaltung zu virtualisieren. Dies ist eine optimale Lösung in einem virtualisierten Rechenzentrum, in dem virtuelle Maschinen, die mit dem Netzwerk verbunden sind, verwendet werden. Virtuelle Maschinen können zwischen Servern migrieren, wodurch Ost-West-Verkehr innerhalb des Rechenzentrums entsteht. SDN wird von MSPs (Managed Service Providers) weit verbreitet für MSP-Netzwerke verwendet, die IaaS (Infrastructure as a Service) bereitstellen.

Die Konfiguration von softwaredefinierten Netzwerken ist effektiv, wenn die zugrunde liegende Leaf-Spine-Netzwerktopologie mit dynamischem Routing, einer festen Anzahl von Hops, geringer vorhersehbarer Latenz und Optimierung des Ost-West-Verkehrs für die Server-zu-Server-Kommunikation in einem Rechenzentrum verwendet wird.

VXLAN

VXLAN (Virtual eXtensible Local Area Network) ist ein verbessertes Netzwerkprotokoll, das anstelle von VLANs in Overlay-Netzwerken verwendet wird. L2-Tunnel werden durch Verwendung der zugrunde liegenden L3-Netzwerke (L3-Netzwerk-Underlay) erstellt, um L2-Netzwerkverbindungen ohne die traditionellen VLAN-Beschränkungen bereitzustellen. Mit VXLAN können Sie das L2-Netzwerk über das L3-Netzwerk konfigurieren. Die virtuelle Topologie kann sich von der physischen Netzwerktopologie des zugrunde liegenden Netzwerks unterscheiden.

VXLAN-Frames werden mithilfe des MAC-in-UDP-Encapsulationschemas in IP-Pakete eingekapselt. VNI entspricht der VLAN-ID. Die maximale Anzahl von VNI beträgt 2^24, das sind etwa 16 Millionen. VXLAN wird verwendet, um L2-Netzwerke in geografisch ausgedehnten Umgebungen zu erstellen, beispielsweise wenn Sie ein Netzwerk über zwei geografisch verteilte Rechenzentren erstellen müssen.

Durch die Verwendung von VXLAN und Netzwerkvirtualisierung wird die Größe der MAC-Adresstabelle für ToR-Switches optimiert. Dies liegt daran, dass MAC-Adressen, die von VMs und dem entsprechenden L2-Verkehr verwendet werden, über das L2-Overlay-Netzwerk mithilfe von VXLAN übertragen werden. Sie überlasten nicht die MAC-Tabellen physischer Switches. Die MAC-Adresstabellen physischer Switches überschreiten nicht die maximale verfügbare Tabellenkapazität der Switches.

Conclusion

Traditionell wurden Netzwerke in Rechenzentren unter Verwendung der klassischen Drei-Ebenen-Zugriffs-Aggregations-Kern-Topologie aufgebaut. Angesichts sich entwickelnder moderner Client-Server- und verteilter Anwendungen, Microservices und anderer Software, die Quellen für Ost-West-Verkehr innerhalb von MSP-Netzwerken sind, ist die Blatt-Stängel-Netzwerktopologie, basierend auf dem Konzept des Clos-Netzwerks, in modernen Rechenzentren bevorzugt und gehört zu den häufigeren Netzwerktopologien. Die Blatt-Stängel-Netzwerktopologie ist die beste Netzwerktopologie für große Rechenzentren, weil diese Topologie äußerst zuverlässig und skalierbar ist. Bevor Sie ein Netzwerk in einem Rechenzentrum installieren, führen Sie die Berechnungen durch und schätzen Sie den generierten Verkehr und die Arbeitslasten ab. Berücksichtigen Sie den Serviceverkehr wie Backup- und Replikationsverkehr im Netzwerk.

NAKIVO Backup & Replication ist leistungsstarke Virtual-Machine-Backup-Software, die VMware Cloud Director-Workloads, VMware-VMs, Hyper-V-VMs sowie physische Linux- und Windows-Maschinen, Oracle-Datenbanken schützen kann. Managed Service Provider, die Infrastruktur als Dienstleistung (IaaS), Backup als Dienstleistung (BaaS) und Katastrophenschutz als Dienstleistung (DRaaS) bereitstellen, können NAKIVO Backup & Replication im Multi-Tenant-Modus installieren. Laden Sie die kostenlose Testversion von NAKIVO Backup & Replication für MSPs herunter, die den Multi-Tenancy-Installationsmodus unterstützt.

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/