Per i provider di servizi gestiti (MSPs), costruire una rete ad alta prestazione e scalabile è un pilastro del successo. In un precedente post sul blog, abbiamo trattato i tipi di topologia di rete di base, e in questo post, esaminiamo tipi di topologia di rete più complessi per i provider di servizi, compresi quelli preferiti per le reti MSP. Leggi questo post sul blog per scoprire quale topologia è la migliore per un data center MSP e perché.

Reti gerarchiche tradizionali a 3 livelli

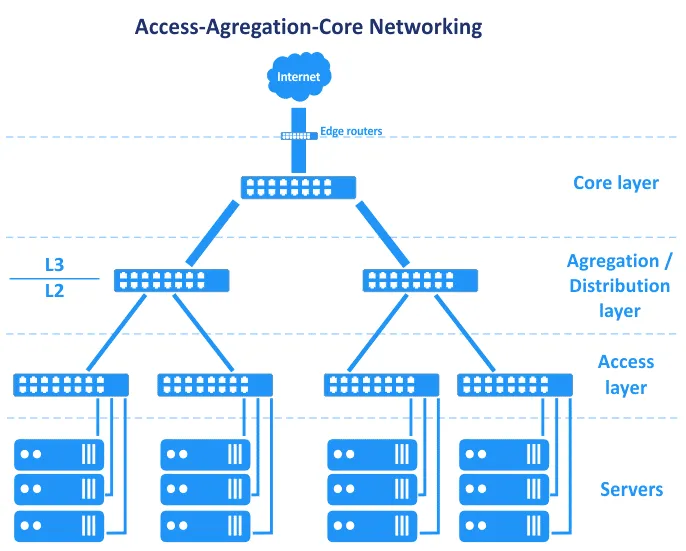

Prima che le reti definito dallo software diventassero comuni, le reti nei data center erano basate sulla topologia ad albero gerarchico. Questa topologia si suddivide in tre livelli principali: il livello di core, il livello di aggregazione o distribuzione e il livello di accesso. In questa topologia, i server sono collegati a switch nel livello di accesso. I router periferici sono collegati al core per fornire l’accesso da/verso la WAN (wide area network) e internet. Questi router si trovano tra il core e internet nello schema sottostante.

In termini del modello OSI (Open Systems Interconnection), che divide la rete in uno strato di collegamento dati (L2) e strato di rete (L3), tra gli altri, la topologia di rete Access-Aggregation-Core attraversa gli strati, come si vede nel grafico.

Esaminiamo a turno questi tre livelli.

Livello di core

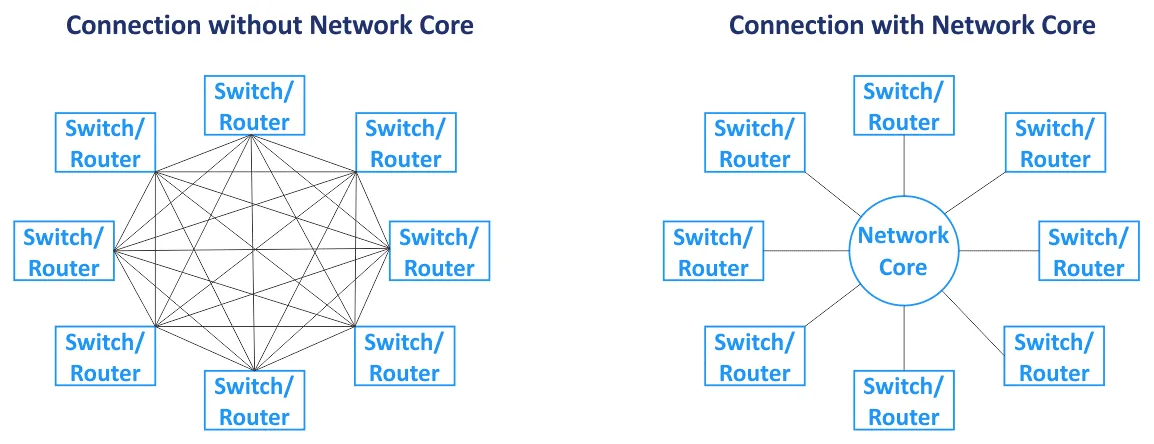

Il nucleo di rete (anche chiamato rete centrale) è il componente centrale dell’intera rete. I nodi primari sono collegati al nucleo. La rete centrale si basa di solito sulla topologia di rete a maglia, in cui tutti i nodi sono collegati tra loro all’interno del nucleo (per un tipo di topologia di rete a maglia completa). Switch e router nel nucleo di rete sono interconnessi con collegamenti ad alta velocità (che vengono anche chiamati connessioni di backbone). Poiché vengono utilizzati router nel nucleo di rete, lo strato di nucleo opera con traffico L3.

Strato di distribuzione/aggregazione

Questo è uno strato intermedio utilizzato per aggregare le uplink dal livello sottostante della topologia di rete a tre livelli (lo strato di accesso, che opera su L2) allo strato di rete centrale (che di solito lavora su L3) utilizzando collegamenti a banda più alta. Lo strato di distribuzione combina un gran numero di porte a bassa velocità con un piccolo numero di porte trunk ad alta velocità. Il routing inizia sullo strato di distribuzione/aggregazione di questa topologia di rete quando i dati vengono trasferiti dallo strato di accesso. Il firewall, il bilanciamento del carico e altre configurazioni di sicurezza vengono impostati sullo strato di aggregazione. Lo strato di aggregazione/distribuzione viene utilizzato per ridurre e semplificare lo schema di cablaggio nel data center per una gestione più comoda. Gli switch installati sullo strato di aggregazione devono supportare lo stoccaggio di un numero maggiore di indirizzi MAC nella tabella degli indirizzi MAC nella loro memoria. Mentre lo strato di accesso opera con traffico L2, lo strato di distribuzione opera con traffico L2 e L3.

Strato di accesso

Questo strato consiste in switch che lavorano su L2. I server e le workstation sono collegati agli switch del layer di accesso. Le VLAN (reti locali virtuali) vengono di solito utilizzate per separare i domini di broadcast L2 al fine di ridurre il traffico di broadcast e aumentare la sicurezza.

Per evitare i collo di bottiglia, vengono utilizzati collegamenti più spessi più vicino al core di rete. Ad esempio, i server sono collegati agli switch di accesso utilizzando interfacce di rete da 10-Gbit/s, gli switch di accesso sono collegati agli switch di aggregazione utilizzando interfacce da 10-Gbit/s, e gli switch/router del layer di aggregazione sono collegati agli switch/router di core di rete tramite collegamenti da 100-Gbit/s. In questo caso, l’aggregazione di collegamenti può essere utilizzata per aumentare la larghezza di banda e la ridondanza. Tutto il traffico dai server viene trasferito agli uplink. Esiste un insieme di apparecchiature di rete intelligenti, soprannominate ‘god boxes’, posizionate in cima alla gerarchia di questa topologia di rete. Le god boxes sono responsabili del routing e di tutti gli altri servizi. La topologia di rete gerarchica consente di creare una rete modulare.

Nella topologia di rete vista nel diagramma precedente, il fallimento di un collegamento porta al fallimento di quel segmento della rete. Per questo motivo, vengono utilizzati canali riservati e ridondanza per questo tipo di topologia di rete (vedi lo schema seguente) su ogni layer di rete. Il fallimento di un dispositivo o di un collegamento causa una riduzione delle prestazioni, ma la rete continua a funzionare. Questa topologia di rete ridondante richiede di solito lo STP (Spanning Tree Protocol).

Mantenimento. Se si disconnette parte delle apparecchiature di rete in cima a questa topologia di rete a 3 livelli per aggiornare il software o eseguire altre attività di manutenzione, le prestazioni di rete diminuiscono. Alcuni servizi possono essere temporaneamente non disponibili.

Scalabilità. Il numero di servizi in esecuzione sui server sta crescendo ogni anno e la quantità di traffico aumenta di conseguenza. Questa situazione richiede un aggiornamento e un aumento della larghezza di banda di rete nella rete MSP. Aumentare la larghezza di banda di rete in un data center classico di solito richiedeva quanto segue:

- Aumento delle connessioni di aggregazione link (LAG)

- Acquisto di schede di rete

- Se non ci sono slot disponibili per l’installazione di schede di rete, acquisto di nuovi server o attrezzature correlate

Se è necessario aggiungere una nuova scaffalatura per server (cabinetto rack) come nuovo modulo nel proprio data center, è possibile aumentare la larghezza di banda di rete verso questa scaffalatura e i server installati in essa. Questo tipo di topologie di rete non possono garantire un elevato livello di riserva e ridondanza del link a causa delle caratteristiche del protocollo L2 come STP e MSTP (Multiple Spanning Tree Protocol).

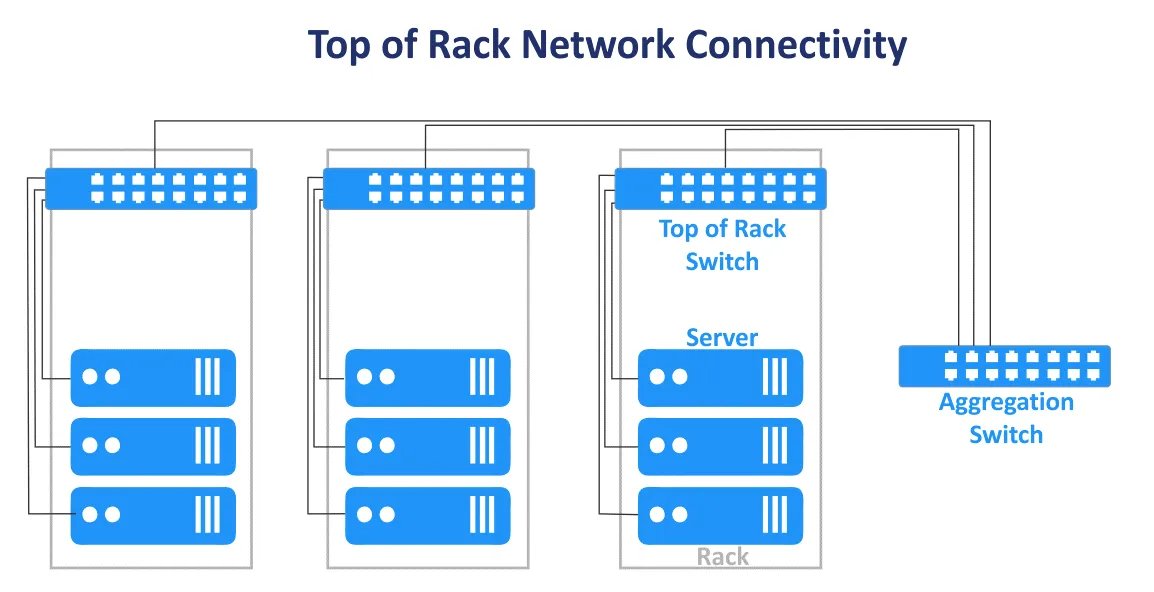

La classica topologia di rete a tre livelli in un data center può essere combinata con i design End of Row e Top of Rack. Lo schema di connessione Top of Rack è ora più popolare. Questo nome è utilizzato perché i server e gli switch sono collegati allo switch principale su ogni rack. Gli switch Top of Rack (ToR switches) sono collegati agli switch/router dei livelli superiori nella rete MSP. Gli switch ToR sono diversi dagli switch di bordo dell’utente e hanno più porte di uplink ad alta velocità aggiuntive (come porte da 10 Gbit/s) e un elevato numero di porte per collegare i server. Gli switch ToR sono installati a coppie per garantire la ridondanza e consentire la manutenzione degli switch. I vantaggi di questo schema di connessione ToR sono la lunghezza dei cavi più ridotta durante il cablaggio dei dispositivi in un rack e tra i rack. Gli switch di accesso della topologia di rete gerarchica a più livelli di solito vengono utilizzati come switch ToR.

Direzione del traffico

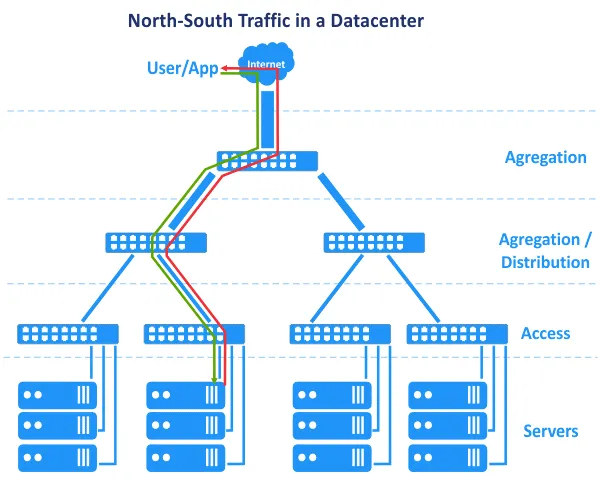

I precedenti svantaggi spiegati non sono troppo critici, e una rete di data center può funzionare con successo con una corretta amministrazione. Cambiare da L2 a L3 in una parte della rete aiuta a risolvere un insieme di problemi. C’è un’altra caratteristica legata a come i data center si sono evoluti e a come le applicazioni funzionano diversamente oggi rispetto a prima. Negli anni 2000, le applicazioni venivano create utilizzando un’architettura centralizzata, e le applicazioni dell’architettura client-server erano principalmente monolitiche. Ciò significa che i componenti di un’applicazione potevano trovarsi su un singolo server. Di conseguenza, nel nostro diagramma, la richiesta dell’utente veniva inviata dall’alto della rete, e la richiesta generata dall’applicazione veniva inviata dal livello del server inferiore di nuovo all’alto della rete. La richiesta dell’utente veniva gestita su un singolo host. Il traffico orizzontale (est-ovest) tra gli host era minimo, e il traffico nord-sud era favorito. La topologia di rete tradizionale multi-tier gerarchica utilizzata per le reti MSP nei data center soddisfa questi requisiti. Tuttavia, nel tempo, sono state preferite nuove architetture nello sviluppo delle applicazioni.

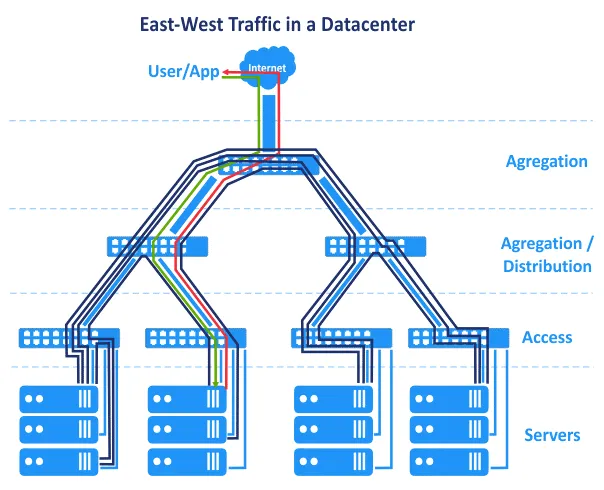

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

L’architettura a microservizi presuppone che i componenti di un’applicazione (servizi) funzionino in contenitori logicamente isolati separati che sono connessi tra loro tramite una rete. I contenitori possono essere eseguiti su host diversi in cluster. Questa architettura è altamente scalabile e viene ampiamente utilizzata nei cloud al giorno d’oggi.

Inoltre, i data center ora operano con Big Data, grandi database, analisi, pubblicità contestuale, applicazioni basate sull’intelligenza artificiale e altri software che richiedono l’interconnessione con più server, array di storage, macchine virtuali o contenitori. I componenti dell’applicazione sono distribuiti su più server o VM nel data center.

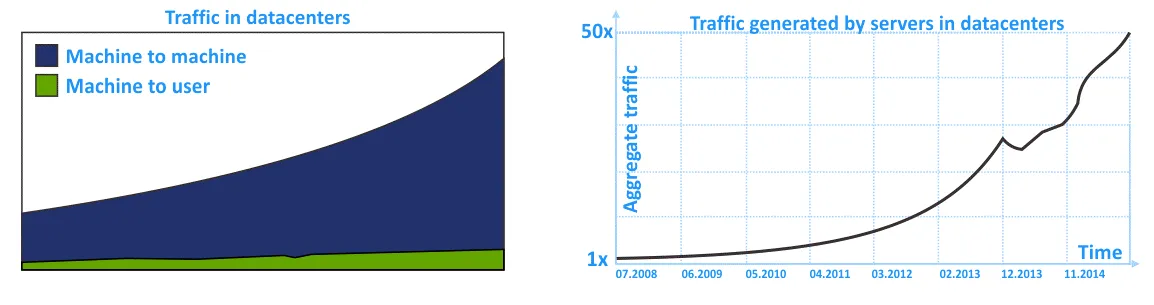

Di conseguenza, il traffico est-ovest è più elevato rispetto al traffico nord-sud nella rete MSP. Il traffico interno in una rete del data center (traffico intra-DC) è superiore al traffico da/per un utente esterno che invia una richiesta al data center. Non dimenticare il traffico interno tra i sistemi di archiviazione, la replica del database, il backup dei dati e altre attività di servizio che utilizzano la rete in un data center.

Nelle seguenti diagrammi, puoi vedere la rappresentazione grafica del crescente traffico interno nelle reti MSP all’interno dei data center negli ultimi anni. La tendenza mostra che il traffico intra-DC sta crescendo più del traffico in ingresso/uscita.

Le reti tradizionali, costruite utilizzando la tradizionale topologia di rete a tre livelli gerarchici, sono affidabili ma non adattate per i flussi di traffico laterale nel modo più razionale. Ciò è dovuto all’enfasi sulla rete L2 e sul traffico nord-sud.

Topologia di rete Clos

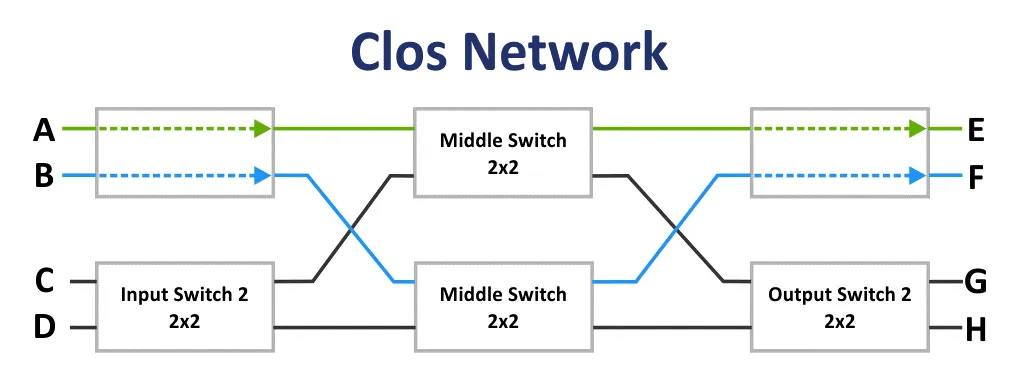

Inizialmente, la rete Clos è stata inventata da Edson Erwin nel 1938. Nel 1953, Charles Clos decise di utilizzare reti di commutazione non bloccanti nei sistemi telefonici per un utilizzo più razionale delle comunicazioni rispetto allo schema di comunicazione a crocebarre. Con array con un basso numero di interconnessioni, ingressi e uscite, lo schema di connessione sembra essere difficile a prima vista. Tuttavia, la rete Clos è meno complessa a causa di un minor numero di punti di connessione secondo la formula: 6n^(3/2)-3n. Questo fatto diventa chiaro a partire da 36 punti di connessione.

Se m è il numero di commutatori di input e n è il numero di commutatori di output, quindi le caratteristiche di blocco della rete Clos vengono calcolate utilizzando la formula. Secondo il teorema di Clos, una rete Clos è strettamente non bloccante se il numero di commutatori del secondo stadio m ≥ 2n−1.

La rete bloccante è una rete in cui è impossibile trovare un percorso di comunicazione da una porta di input libera a una porta di output libera.

La rete non bloccante è la rete in cui esiste sempre un percorso per collegare qualsiasi porta di input e output. Le reti non bloccanti vengono create aggiungendo uno stadio di commutazione aggiuntivo.

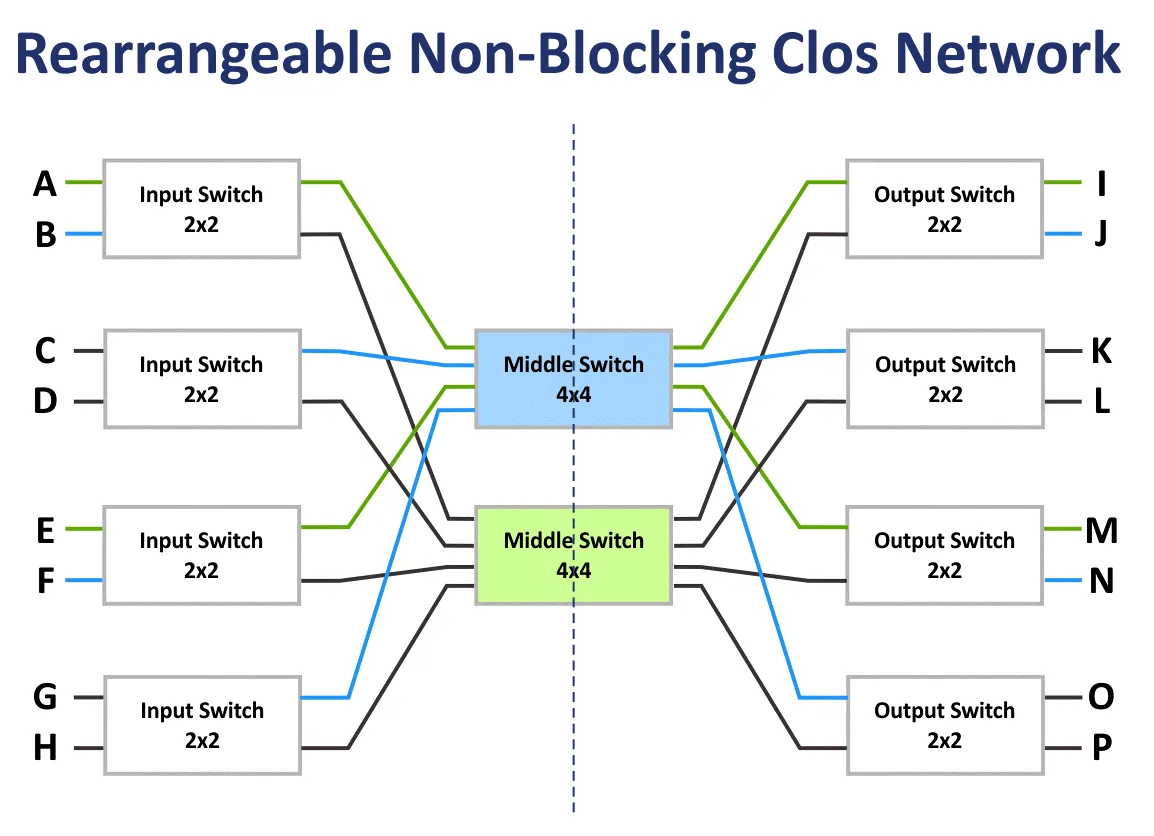

La rete non bloccante riconfigurabile è la rete in cui tutti i percorsi possibili per collegare tutte le porte di input e output possono essere riorganizzati.

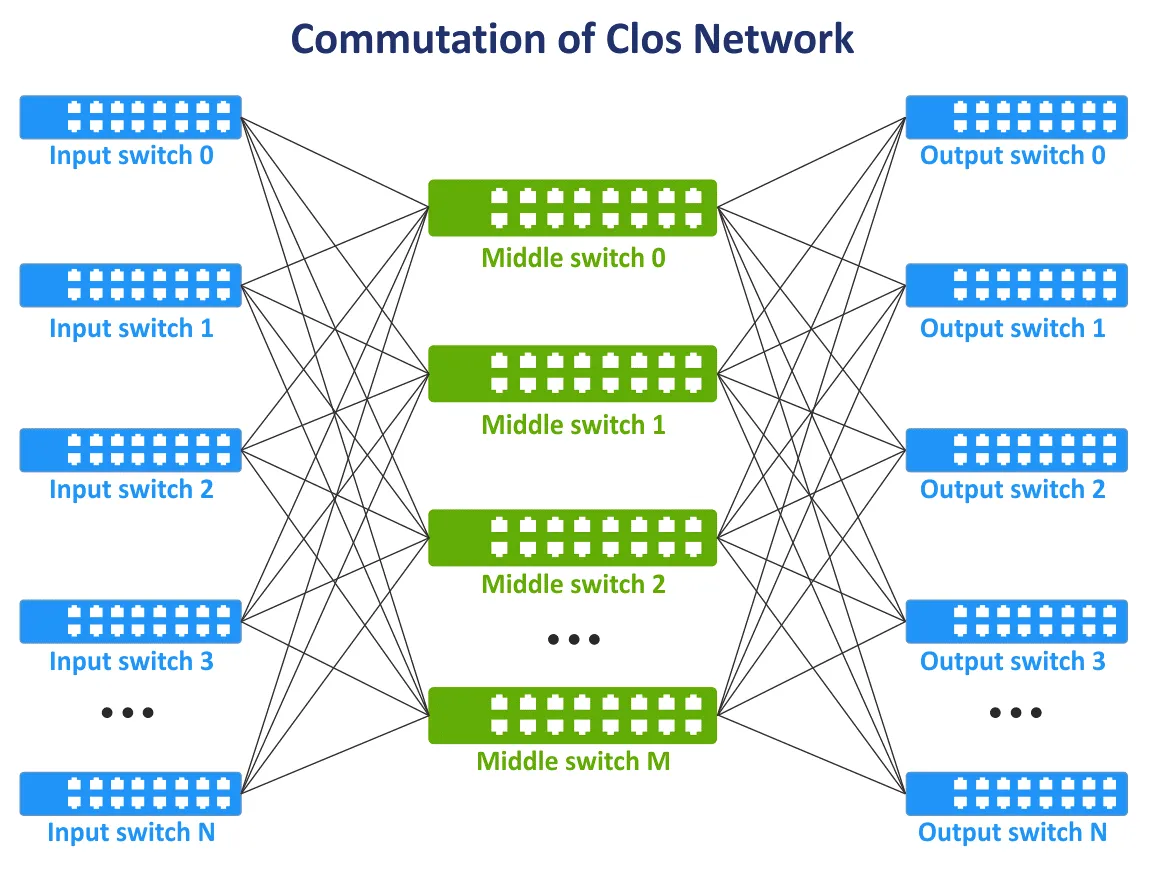

Alla fine degli anni ’90, con l’evoluzione delle tecnologie delle telecomunicazioni e delle reti informatiche, il concetto di reti Clos è diventato nuovamente rilevante. C’è bisogno che tutti i nodi comunichino tra loro nella struttura di rete e, se possibile, non utilizzino la topologia a maglia completa quando tutti i dispositivi sono interconnessi. È stata aggiunta un nuova strato di comunicazione per interconnettere i dispositivi di rete. Di conseguenza, il concetto di rete Clos è stato riproposto in una nuova incarnazione. Nell’immagine seguente, puoi vedere uno schema tipico della rete Clos a tre livelli.

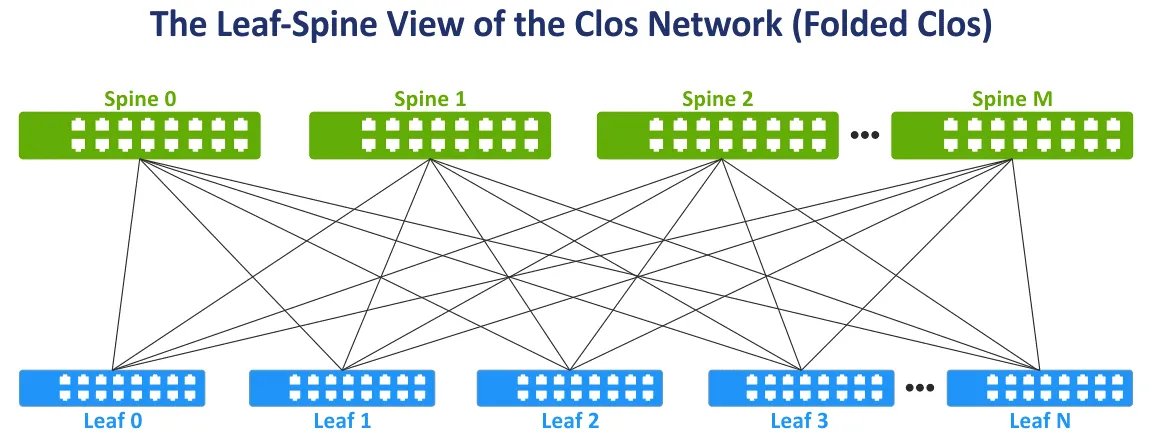

Modifichiamo la visualizzazione della rete Clos al più ampiamente utilizzato Leaf-Spine view per maggiore comodità piegando i lati sinistro e destro dello schema. Questa topologia di rete è conosciuta come Leaf-Spine, Clos piegata e rete Clos a 3 livelli (vedi l’immagine seguente).

Lo strato spine. Gli switch spine sono utilizzati per interconnettere tutti gli switch leaf nella topologia di rete a maglia completa. Lo strato spine sostituisce, in parte, lo strato di aggregazione utilizzato nella tradizionale topologia di rete gerarchica a tre livelli. Ma lo strato spine non è un equivalente diretto dello strato di aggregazione. Il compito principale dello strato spine è il trasferimento rapido dei dati da un leaf all’altro. I dispositivi endpoint non sono collegati agli switch spine.

Lo strato leaf. In questo modello, server o altri dispositivi endpoint nel data center sono collegati ai leaf. Tutti i leaf sono collegati a tutti gli spine. Di conseguenza, ci sono un alto numero di connessioni di rete con larghezza di banda uguale tra tutti i server. Ci sono connessioni L3 tra spine e leaf (L3 nel modello OSI).

Quando il traffico viene trasmesso dalla sorgente alla destinazione nella rete, il numero di salti è lo stesso (ad esempio, sono necessari tre salti per trasferire dati tra qualsiasi server all’interno della rete foglia-spina a due livelli nello schema seguente). La latenza è prevedibile e bassa. La capacità della rete è anche aumentata perché non è più necessario utilizzare STP. Quando STP è utilizzato per connessioni ridondanti tra switch, solo un collegamento può essere attivo alla volta.

Nella topologia della rete foglia-spina, il protocollo di instradamento Equal-Cost Multipath (ECMP) può essere utilizzato per bilanciare il carico del traffico e prevenire loop di rete (per connessioni di rete L3). Possono essere utilizzati anche i protocolli BGP, OSPF, EIGRP, ISIS.

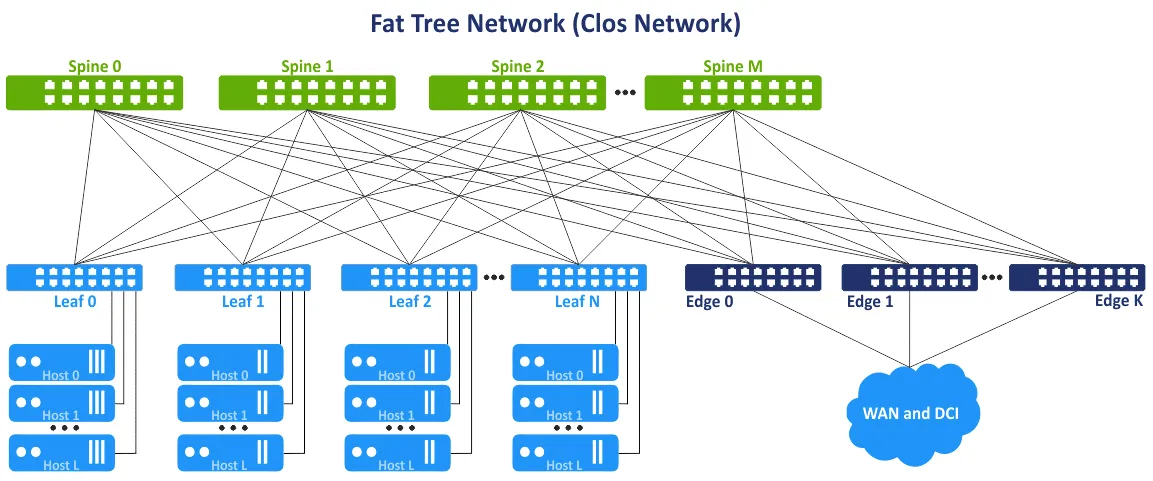

Questo concetto di rete è anche chiamato topologia della rete ad albero a strati multipli. L’idea è evitare i colli di bottiglia nei livelli superiori dell’albero (vicino alla radice dell’albero) e aggiungere collegamenti aggiuntivi per aumentare la larghezza di banda in questi segmenti. Di conseguenza, c’è una crescente capacità di collegamento verso la radice. L’albero grasso è un caso speciale della rete Clos. La rete Clos a tre livelli viene trasformata in una rete a due livelli foglia-spina dopo il ripiegamento. Gli switch foglia o gli switch/ router edge foglia possono essere utilizzati per accedere a reti esterne e ad altri data center.

Vantaggi della topologia della rete foglia-spina

La topologia della rete foglia-spina offre una serie di vantaggi rispetto alla topologia della rete accesso-aggregazione-core. Questa serie di vantaggi è il motivo per cui utilizzare il tipo di topologia della rete foglia-spina in un data center.

Connessioni ottimizzate. I collegamenti con un’elevata larghezza di banda tra i dispositivi di rete sono ottimali per il traffico est-ovest. Non ci sono collegamenti inutilizzati (poiché si utilizza L3 invece di L2). Si consiglia ECMP per un’elevata efficienza e STP non è necessario.

Affidabilità. Il fallimento di un dispositivo o la disconnessione di un collegamento non comporta significativi risultati negativi e svantaggi. Se lo switch ToR che funge da switch leaf fallisce, viene influenzato il rack corrispondente. Se fallisce uno switch spine, la larghezza di banda di rete si degrada ma non in modo significativo rispetto alla topologia di rete gerarchica tradizionale a 3 livelli. Il degrado della larghezza di banda per la topologia spine-leaf è 1/n, dove n è il numero di spine. Il degrado della larghezza di banda per la topologia gerarchica è 50% in questo caso.

Alta scalabilità. È possibile aggiungere nuovi leaf fino a disporre di porte libere sulle spine. Aggiungere nuove spine consente di aumentare i collegamenti di uplink dei leaf. Aggiungere switch/router periferici per aumentare la larghezza di banda verso le reti esterne. L’approccio tradizionale per aumentare la larghezza di banda e collegare più server per la topologia di rete a tre strati è quello di aggiungere più schede di rete con più porte, apparecchiature di rete con interfacce di rete più veloci e hardware più potente in generale. Questo approccio tradizionale è chiamato scale up o scalabilità verticale.

Quando si utilizza la topologia di rete leaf-spine nei data center e per le reti MSP, è possibile aggiungere uno strato aggiuntivo di spine. Questo approccio è chiamato scalabilità orizzontale o scaled out. Aggiungere un tipico dispositivo di rete come uno switch/router aumenta la scalabilità in modo lineare.

Manutenzione. È possibile scollegare facilmente le spine dalla rete per la manutenzione o la sostituzione. Le attività di manutenzione sullo spine non sono rischiose rispetto alle god boxes perché non vi è alcuna funzionalità di intelligenza sulle spine, e la riduzione della larghezza di banda è minima dopo lo scollegamento.

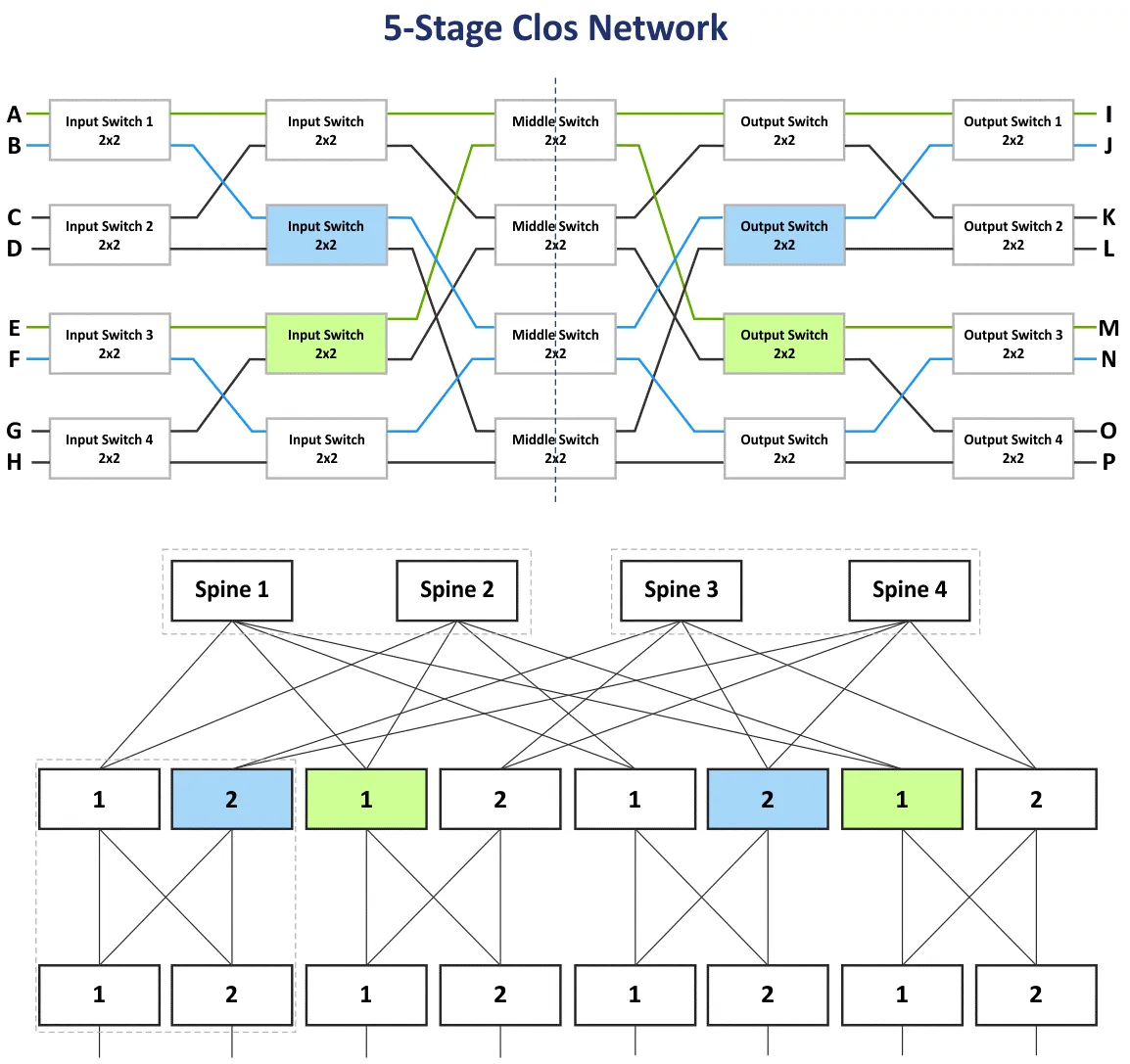

Rete Clos a più livelli

Nella sezione precedente, ho spiegato la rete Clos a tre stadi con i livelli: Switch di ingresso, Switch centrale e Switch di uscita. Poiché i dispositivi sui livelli di ingresso e uscita sono utilizzati per ricevere / inviare dati, lo schema di rete può essere piegato utilizzando una linea centrale composta da una topologia di rete leaf-spine a due livelli. È possibile aggiungere più livelli e costruire la rete Clos a più livelli per collegare più dispositivi di rete a questa rete. In questo caso, ci sono cinque livelli: Switch di ingresso, Switch centrale 1, Switch centrale 2, Switch centrale 3, Switch di uscita.

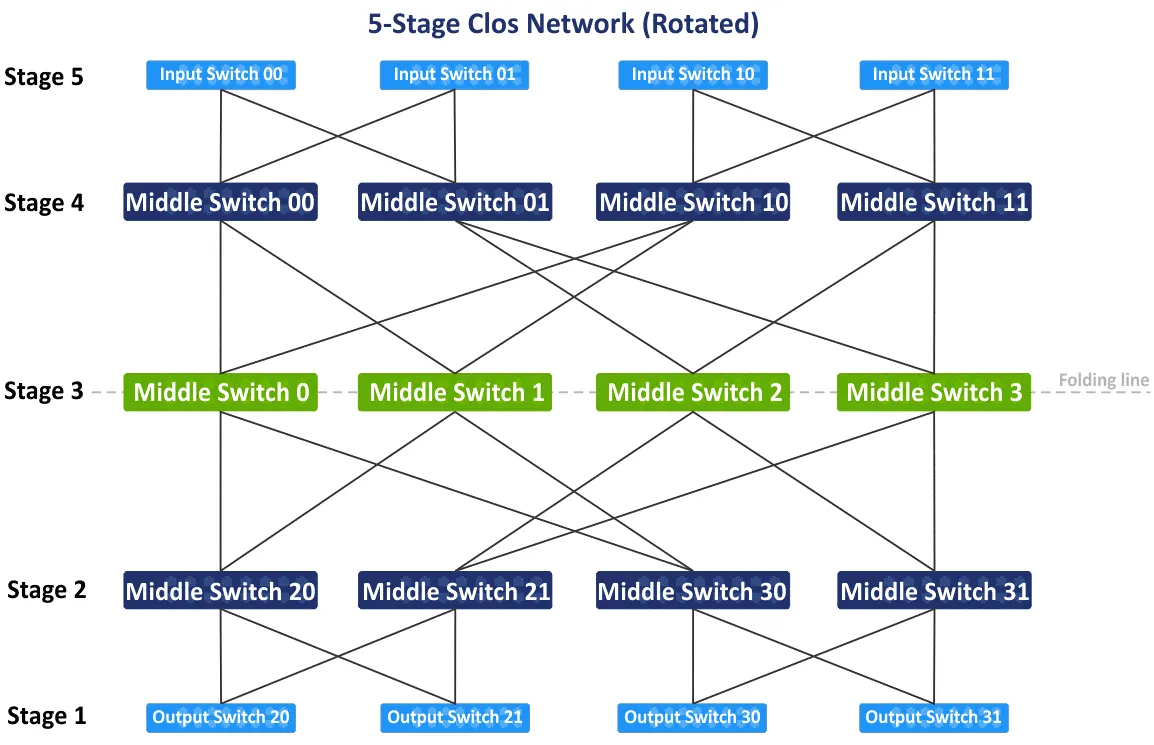

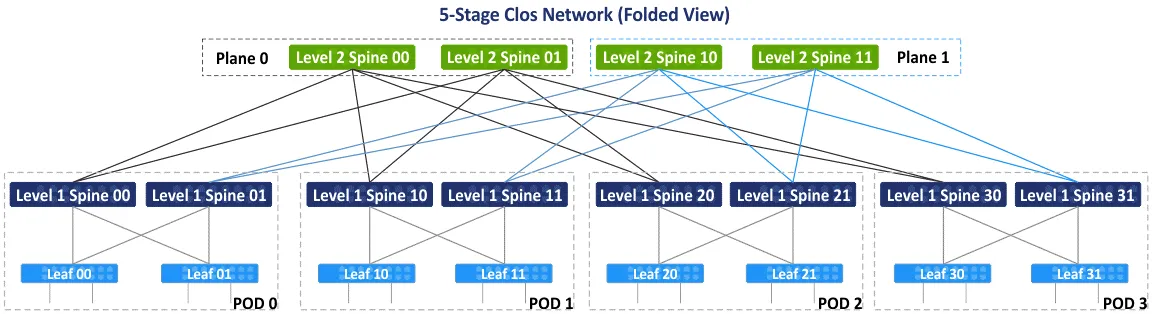

Nel diagramma seguente, è possibile vedere lo schema iniziale della rete Clos a cinque livelli non bloccante dopo il riarrangiamento dei blocchi blu e verdi. Vi è anche la vista leaf-spine piegata o la vista fat-tree (4,3) (poiché ci sono 4 spine switch e 3 stadi sullo schema leaf-spine), ma vediamo come collegare i dispositivi nella rete Clos a 5 stadi passo dopo passo. Un tipo di topologia di rete Clos con più di 5 stadi non è comune e non viene utilizzato in pratica perché il numero di connessioni è troppo grande.

Dopo aver ruotato lo schema iniziale della rete Clos a cinque stadi di 90 gradi in senso orario, avrai la visualizzazione tradizionale con gli switch di input, gli switch di output e i tre stadi degli switch intermedi. Disegniamo la linea di piegatura tramite gli switch intermedi al centro dello schema per ottenere la visualizzazione piegata della rete Clos a cinque stadi.

Dopo aver piegato lo schema, otterrai la visualizzazione piegata o la visualizzazione foglia-spinetta di questo tipo di topologie di rete (vedi lo schema seguente). Ci sono 4 gruppi individuali che fungono da punti di consegna (POD). Il POD è l’unità universale per la costruzione dei data center. I POD sono collegati alle spine del primo livello. Se hai bisogno di espandere il tuo data center o aggiungere più server/equipaggiamento di rete, aggiungi nuovi POD e connettili alla struttura di rete. Le spine di un POD sono collegate alle spine di altri POD tramite spine di secondo livello. Allo stesso tempo, non tutte le spine L1 sono collegate a tutte le spine L2 e sono divise per piani.

Ci sono due piani – Piano 0 e Piano 1 nello schema seguente. Questo concetto è utilizzato a causa del numero limitato di porte sulle spine e la creazione di una topologia di rete completamente connessa non è possibile in questo caso. Nello schema seguente, ogni spina ha un limite di 4 porte. Secondo l’idea principale, la rete Clos non bloccante si basa sugli stessi elementi (switch a 4 porte, come si vede di seguito).

A prima vista, si può essere confusi con termini come Clos, Clos piegato, foglia-spinetta e albero grasso. Permettimi di chiarire questi termini.

Clos o rete Clos è il termine che copre le basi teoriche del tipo di topologia di rete Clos.

Il Clos piegato è una rappresentazione più conveniente della rete Clos, dove gli ingressi e le uscite hanno lo stesso ruolo e sono situati nello stesso luogo.

Leaf-spine è una topologia di rete basata sullo schema di rete Clos che viene utilizzata in pratica nei data center per costruire reti, inclusi le reti MSP.

Albero grasso è generalmente considerato una variante della rete Clos. Questo termine è il più confusionario perché alcuni articoli menzionano l’albero grasso come la classica rete accesso-aggregazione-core. Mi riferisco al documento RFC 7938 che afferma che l’albero grasso si basa sulla topologia della rete Clos piegata.

Calcoli

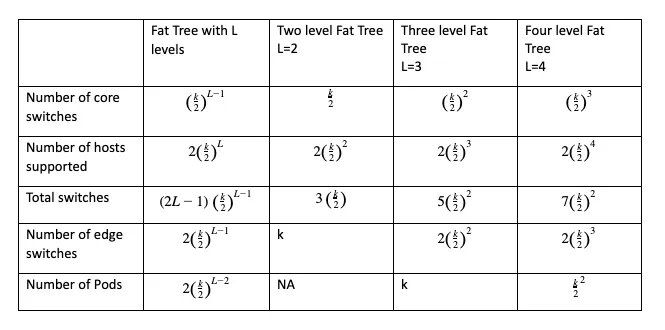

Puoi calcolare il numero dei commutatori core, dei commutatori edge, il numero totale di commutatori necessari e il numero totale di host che possono essere collegati alla rete della configurazione selezionata utilizzando formule dove:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

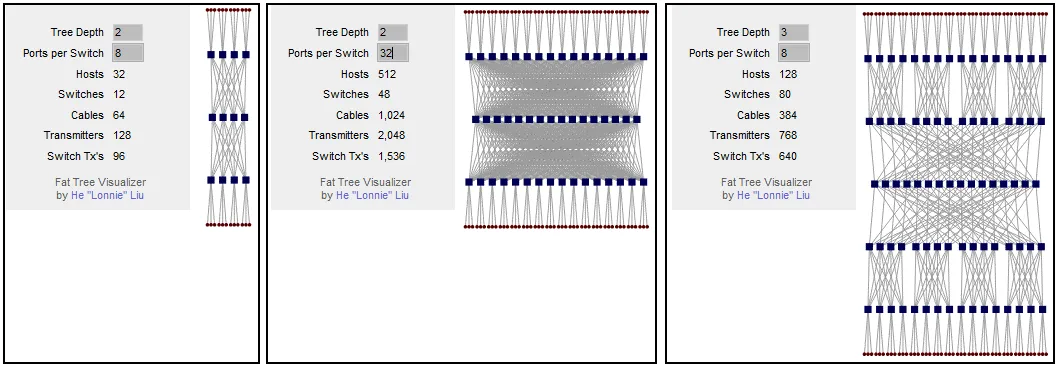

Il parametro principale da calcolare prima di costruire la tua rete è il numero di host supportati. La configurazione dell’albero grasso può essere scritta come FT(k, L). Ad esempio, FT(32,3) è una rete ad albero grasso a tre livelli con commutatori a 32 porte. Puoi utilizzare questo calcolatore gratuito per reti Clos che genera anche lo schema di visualizzazione per la configurazione selezionata.

Puoi calcolare che se il tuo schema di rete fat-tree ha 2 livelli e 8 porte per switch, puoi connettere 32 host alla rete. Se aumenti il numero di porte per switch, il numero di host supportati sale a 512. Come puoi vedere, il numero di host connessi dipende dal numero di porte su ciascuno switch. Se mantieni il fat tree a 2 livelli (la rete Clos a 3 stadi) e aumenti il numero di porte per switch, il numero di spine aumenta significativamente. Puoi risolvere questo problema aggiungendo un altro livello al fat tree. Per un fat tree a tre livelli, se il numero di porte per switch è 8, puoi connettere 128 host.

Se aumenti il numero di porte per switch a 32, puoi connettere 8192 host utilizzando questa topologia di rete. Questo numero per la rete Clos a 5 stadi è 16 volte superiore rispetto a quella a 3 stadi. Tieni presente i limiti del server rack quando pianifichi lo schema di installazione dei server e dell’attrezzatura di rete nel data center.

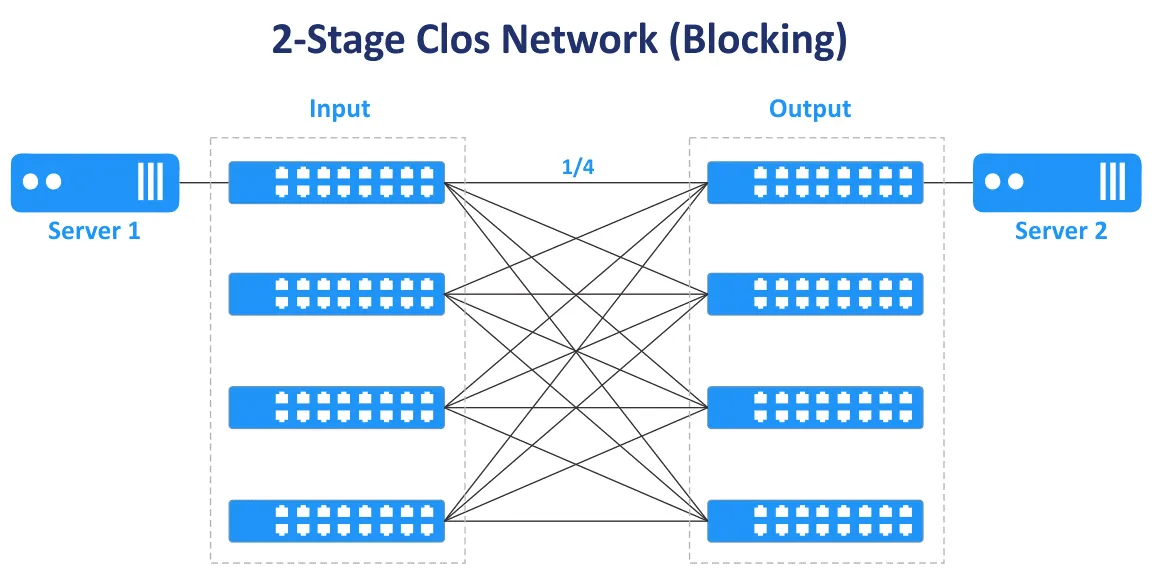

I numeri dispari di stadi vengono utilizzati per costruire reti Clos non bloccanti (3, 5, 7, ecc.). La rete Clos a 2 stadi non fornisce una connettività non bloccante e connessioni multiple tra gli switch.

Nel diagramma seguente, puoi vedere che nel caso della rete Clos a due stadi, c’è solo un percorso di trasmissione per collegare Server 1 e Server 2. Solo ¼ delle porte sono collegate, le altre porte non sono collegate e ti bloccano.

Il rapporto di sovrasottoscrizione è il rapporto tra la larghezza di banda in ingresso e quella in uscita nella direzione dai livelli inferiori a quelli superiori. Il rapporto di sovrasottoscrizione varia solitamente da 2 a 4.

Esempio: Uno switch ha 48 porte da 10-Gbit e 4 porte uplink da 40-Gbit. La larghezza di banda totale delle downlink verso i server è 48×10=480 Gbit/s. La velocità totale delle uplink è 4×40=160 Gbit/s. Il rapporto di sovraimpegno è 480/160=4.

Se la velocità totale della larghezza di banda è uguale per tutte le porte downlink e uplink dello switch, lo switch è non sovraimpegnato e in questo caso non ci sono collo di bottiglia. Un rapporto di sovraimpegno di 1:1 è il caso ideale. Valuta il traffico in diverse direzioni prima di acquistare switch con la velocità e il numero di porte appropriati.

Gli switch che hanno un rapporto di sovraimpegno superiore a 1 sono spesso utilizzati nello stadio leaf nelle reti con topologia a foglia-spin. Gli switch non sovraimpegnati dovrebbero essere utilizzati nello stadio spine. Gli switch nello stadio leaf nella topologia a foglia-spin sono di solito usati come switch ToR. Tuttavia, è possibile installare switch leaf come switch End of Row.

Differenze essenziali

Nella creazione di una rete, alcune decisioni influenzano la struttura della rete. Ecco alcune decisioni che influenzano il funzionamento della rete.

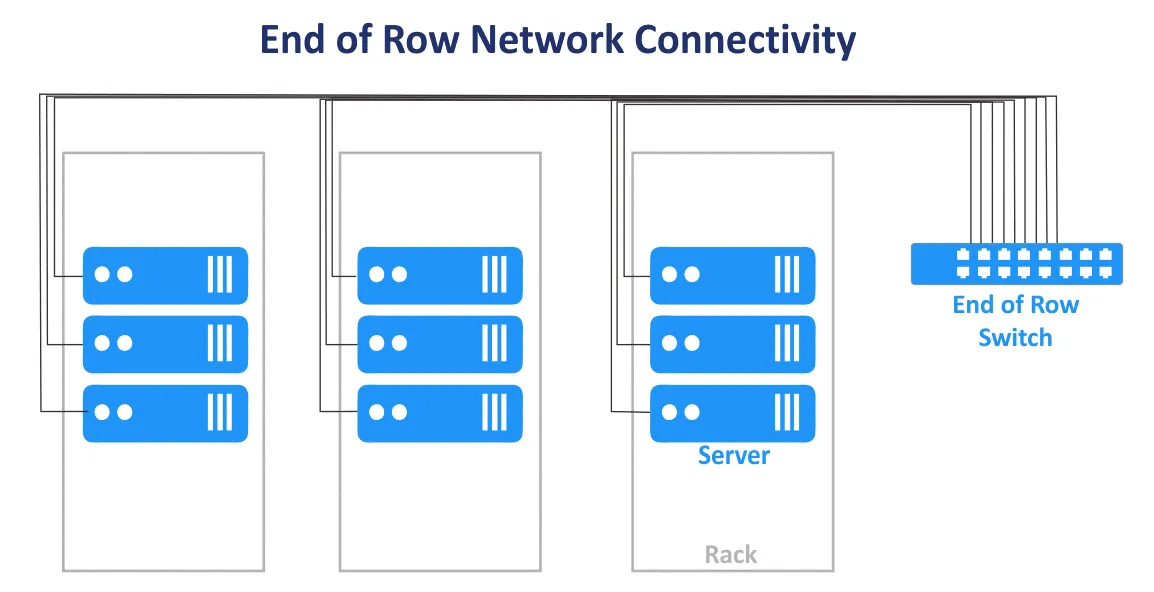

Top of Rack vs End of Row

Lo schema di connessione di rete Top of Rack (ToR) in un data center è dove uno o più switch sono installati in ogni rack. Vengono utilizzati cavi di patch corti per collegare lo switch in cima al rack con altri apparecchi di rete e server all’interno del rack. Gli switch ToR di solito hanno collegamenti ascendenti ad alta velocità con gli switch/router del livello superiore e possono essere collegati con cavi in fibra ottica. Il vantaggio è che utilizzando questo schema di connessione per una rete MSP, non è necessario installare un grosso fascio di cavi da ogni rack nel data center. L’uso dei cavi nel data center è più razionale quando si utilizza lo schema ToR. In questo caso, si spende meno per i cavi e si ha una migliore gestione dei cavi. È possibile gestire ogni rack come un singolo modulo senza influenzare altri rack all’interno di un data center perché i server solo in un rack sono influenzati. Nonostante il nome dello schema, è possibile montare uno switch nella parte centrale o nella parte inferiore di ogni rack.

Lo schema di connessione di rete End of Row (EoR) è quando un rack server alla fine della fila contiene apparecchiature di rete. Le apparecchiature includono uno switch di rete comune per collegare tutti i server e altri dispositivi di tutti i rack server nella fila. I cavi dalle apparecchiature di rete installate nel rack server EoR sono collegati ai dispositivi in tutti i rack della fila utilizzando pannelli di patch montati in ogni rack. Di conseguenza, vengono utilizzati cavi lunghi per collegare tutti i dispositivi di rete in una fila. Se vengono utilizzate connessioni di rete ridondanti, aumenta anche il numero di cavi. Grosse fasce di cavi possono bloccare l’accesso dell’aria alle apparecchiature.

I rack del server sono di solito posizionati in file affiancate in un data center. Una fila può contenere 10 o 12 rack, ad esempio. L’intera fila è considerata un’unica unità di gestione quando si utilizza lo schema di connessione EoR per la rete MSP in un data center. In questo caso viene utilizzato il modello di gestione per fila. Meno switch individuali sono necessari nel modello di connessione di rete EoR. La flessibilità è inferiore quando è necessario eseguire la manutenzione o l’aggiornamento degli switch perché più dispositivi sono interessati quando uno switch EoR viene disconnesso. Nonostante il suo nome, un rack con uno switch comune (switch) può essere posizionato al centro della fila.

Connessione Layer 2 vs Layer 3

Decidere sulle connessioni all’interno di una rete è un calcolo che coinvolge affidabilità, velocità e costo, oltre alla topologia che viene creata.

Ad esempio, ci sono segmenti di rete per le topologie di rete a tre livelli Access-Aggregazione-Core e Leaf-Spine. Lì, il traffico viene trasferito sul modello OSI L2 e L3. Nella rete gerarchica a tre livelli, il livello di accesso opera su L2, il livello di distribuzione/aggregazione aggrega i collegamenti L2 e fornisce il routing L3, il livello di rete core esegue il routing sul terzo livello del modello OSI. La rete della topologia Leaf-Spine a più livelli può essere configurata utilizzando L2 con VLAN e L3 con routing IP e subnet.

L’attrezzatura di rete L2 è più conveniente rispetto all’attrezzatura di rete L3, ma ci sono alcuni svantaggi nell’utilizzare la rete L2 per collegare i dispositivi di rete nella rete MSP di un data center. Di solito le VLAN vengono utilizzate per isolare logicamente le reti utilizzando lo stesso ambiente fisico. Il numero massimo di VLAN è 4095 (meno alcune VLAN riservate come 0, 4095, 1002-1005).

Un altro svantaggio, come già accennato, è l’incapacità di utilizzare collegamenti ridondanti quando STP è utilizzato su L2. Questo perché solo un collegamento può essere attivo allo stesso tempo, e tutta la larghezza di banda disponibile di tutti i collegamenti non è utilizzata. Quindi, il dominio L2 con STP diventa grande, aumenta la probabilità di problemi causati da cavi non corretti ed errori umani, e la risoluzione dei problemi diventa difficile.

Una configurazione di rete L3 consente agli ingegneri di migliorare la stabilità e la scalabilità della rete MSP e delle reti di data center in generale.

I seguenti protocolli di rete ti aiutano a gestire la rete L3 e il traffico di instradamento.

BGP (Border Gateway Protocol) è un protocollo di instradamento dinamico ampiamente utilizzato e considerato lo standard in molte organizzazioni con data center su larga scala. BGP è un protocollo altamente scalabile, estendibile ed efficiente.

ECMP (Equal Cost Multipath Routing) è una tecnologia di instradamento di rete utilizzata per distribuire il traffico utilizzando più percorsi migliori definiti da metriche sul terzo livello del modello OSI. ECMP con protocolli di instradamento viene utilizzato per il bilanciamento del carico in reti di grandi dimensioni. La maggior parte dei protocolli di instradamento, inclusi BGP, EIGRP, IS-IS, OSPF, supporta la tecnologia ECMP.

Cerca sempre di utilizzare i protocolli di rete più progressivi. Ma ricorda che meno protocolli vengono utilizzati nella rete, più conveniente è l’amministrazione della rete.

Topologia di rete per NV e SDN

Oltre alla virtualizzazione hardware e all’uso delle macchine virtuali, la virtualizzazione della rete con un approccio centrato sull’applicazione è diventata popolare. Le soluzioni di Virtualizzazione di Rete (NV) come VMware NSX, OpenStack networking e Cisco ASI utilizzano intensivamente il traffico est-ovest nella rete fisica, e una topologia di rete foglia-spinoso è adatta per le soluzioni di virtualizzazione di rete per questo motivo. Leggi il post del blog su VMware NSX per saperne di più sulla virtualizzazione della rete.

La rete definita dal software (SDN) viene utilizzata per virtualizzare le reti per un utilizzo efficace delle risorse, flessibilità e amministrazione centralizzata. Questa è una soluzione ottimale in un data center virtualizzato dove vengono utilizzate macchine virtuali collegate alla rete. Le macchine virtuali possono migrare tra server, creando così traffico est-ovest all’interno del data center. SDN è ampiamente utilizzato per le reti dei fornitori di servizi gestiti (MSP) che forniscono IaaS (infrastruttura come servizio).

Configurare reti definite dal software è efficace quando si utilizza la topologia di rete foglia-spinoso sottostante con routing dinamico, un numero fisso di hop, bassa latenza prevedibile e ottimizzazione del traffico est-ovest per la comunicazione da server a server in un data center.

VXLAN

VXLAN (Virtual eXtensible Local Area Network) è un protocollo di rete migliorato utilizzato al posto di VLAN nelle reti overlay. I tunnel L2 vengono creati utilizzando le reti sottostanti L3 (sottostante rete L3) per fornire connettività di rete L2 senza le limitazioni tradizionali di VLAN. Con VXLAN, è possibile configurare la rete L2 sulla rete L3. La topologia virtuale potrebbe essere diversa dalla topologia di rete fisica della rete sottostante.

I frame VXLAN vengono incapsulati in pacchetti IP utilizzando lo schema di incapsulamento MAC-in-UDP. VNI è l’equivalente dell’ID VLAN. Il numero massimo di VNI è 2^24, cioè circa 16 milioni. VXLAN viene utilizzato per creare reti L2 in ambienti geograficamente estesi, ad esempio, quando è necessario creare una rete attraverso due data center geograficamente distribuiti.

Utilizzando VXLAN e la virtualizzazione della rete si ottimizza la dimensione della tabella degli indirizzi MAC per gli switch ToR. Questo perché gli indirizzi MAC utilizzati dalle VM e il relativo traffico L2 vengono trasferiti tramite rete overlay L2 utilizzando VXLAN. Non sovraccaricano le tabelle MAC degli switch fisici. Le tabelle degli indirizzi MAC degli switch fisici non superano la capacità massima disponibile delle tabelle degli switch.

Conclusione

Tradizionalmente, le reti nei data center venivano costruite utilizzando la classica topologia a tre livelli accesso-aggregazione-nucleo. Date le moderne evoluzioni delle applicazioni client-server e distribuite, dei microservizi e di altri software che sono fonti di traffico est-ovest all’interno delle reti MSP, la topologia di rete foglia-spinain basata sul concetto di rete di Clos, è preferita nei data center moderni ed è una delle topologie di rete più comuni. La topologia di rete foglia-spinain è la migliore per i grandi data center perché questa topologia è altamente affidabile e scalabile. Prima di installare una rete in un data center, eseguire i calcoli e stimare il traffico generato e i carichi di lavoro. Tenere conto del traffico di servizio come il traffico di backup e di replica nella rete.

NAKIVO Backup & Replication è un potente software di backup per macchine virtuali che può proteggere i carichi di lavoro di VMware Cloud Director, le VM VMware, le VM Hyper-V, nonché le macchine fisiche Linux e Windows, i database Oracle. I fornitori di servizi gestiti che offrono infrastrutture come servizio (IaaS), backup come servizio (BaaS) e ripristino da disastro come servizio (DRaaS) possono utilizzare NAKIVO Backup & Replication installato in modalità multi-tenant. Scarica la versione di prova gratuita di NAKIVO Backup & Replication per gli MSP che supporta la modalità di installazione multi-tenancy.

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/