Para os provedores de serviços gerenciados (MSPs), construir uma rede de alto desempenho e escalável é um pilar do sucesso. Em um post anterior, abordamos os tipos básicos de topologia de rede, e neste post, examinaremos tipos de topologia de rede mais complexos para provedores de serviços, incluindo aqueles preferidos para redes MSP. Leia este post para descobrir qual é a melhor topologia de rede para um data center MSP e por quê.

Redes Hierárquicas Tradicionais em 3 Camadas

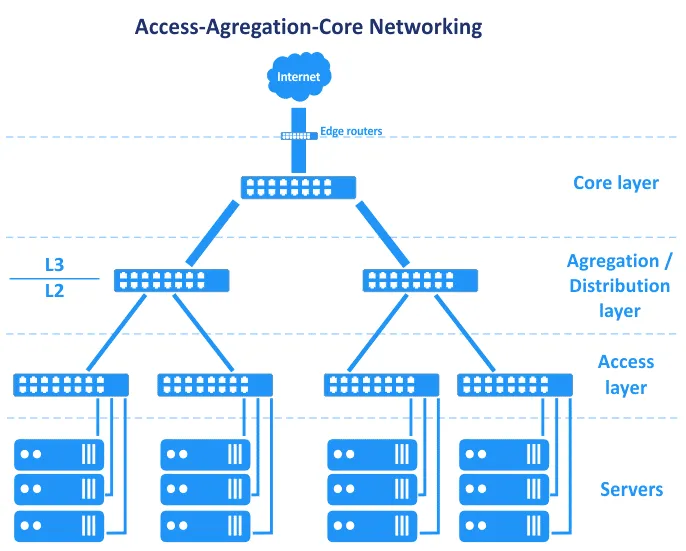

Antes de as Redes Definidas por Software se tornarem comuns, as redes em data centers eram baseadas na topologia de árvore hierárquica. Essa topologia se divide em três camadas principais: camada de núcleo, camada de agregação ou distribuição e camada de acesso. Nessa topologia, servidores são conectados a switches na camada de acesso. Roteadores de borda são conectados ao núcleo para fornecer acesso de/para a WAN (rede de área ampla) e a internet. Esses roteadores estão localizados entre o núcleo e a internet no esquema abaixo.

Em termos do modelo OSI (Interconexão de Sistemas Abertos), que divide a rede em uma camada de link de dados (L2) e camada de rede (L3), entre outras, a topologia de rede Acesso-Agregação-Núcleo abrange várias camadas, como visto na imagem.

Vamos analisar essas três camadas por vez.

Camada de Núcleo

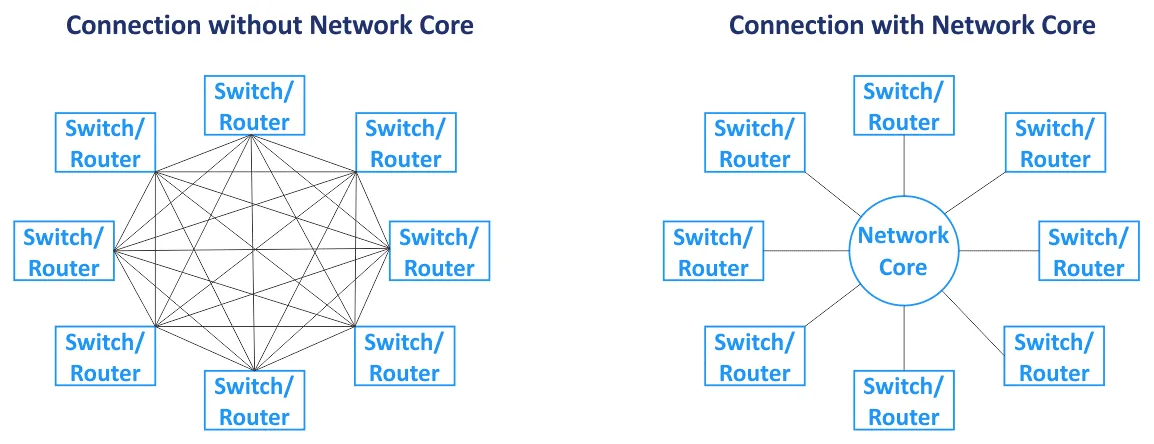

O núcleo da rede (também chamado de núcleo de rede) é o componente central da rede como um todo. Os nós primários estão conectados ao núcleo. A rede central geralmente é baseada na topologia de rede em malha, onde todos os nós estão conectados a todos os outros nós dentro do núcleo (para um tipo de topologia de rede em malha completa). Os switches e roteadores no núcleo da rede estão interconectados com links de alta velocidade (também chamados de conexões de backbone). Como roteadores são usados no núcleo da rede, a camada central opera com tráfego L3.

Camada de distribuição/agregação

Esta é uma camada intermediária usada para agregar uplinks da camada subjacente da topologia de rede de três camadas (a camada de acesso, que opera em L2) para a camada de núcleo de rede (que geralmente funciona em L3) usando links de maior largura de banda. A camada de distribuição combina um grande número de portas de baixa velocidade com um pequeno número de portas de tronco de alta velocidade. O roteamento começa na camada de distribuição/agregação desta topologia de rede quando os dados são transferidos da camada de acesso. O firewall, balanceamento de carga e outras configurações de segurança são definidos na camada de agregação. A camada de agregação/distribuição é usada para reduzir e simplificar o esquema de cabeamento no data center para uma gerência mais conveniente. Os switches instalados na camada de agregação devem suportar o armazenamento de mais endereços MAC na tabela de endereços MAC em sua memória. Enquanto a camada de acesso opera com tráfego L2, a camada de distribuição opera com tráfego L2 e L3.

Camada de acesso

Esta camada consiste em switches que funcionam na camada L2. Servidores e estações de trabalho estão conectados aos switches da camada de acesso. VLANs (redes locais virtuais) geralmente são usadas para separar domínios de broadcast L2 para reduzir o tráfego de broadcast e aumentar a segurança.

Para evitar gargalos, são usados links mais grossos mais próximos do núcleo da rede. Por exemplo, os servidores são conectados aos switches de acesso usando interfaces de rede de 10 Gbit/s, os switches de acesso são conectados aos switches de agregação usando interfaces de 10 Gbit/s, e os switches/roteadores da camada de agregação são conectados aos switches/roteadores do núcleo da rede via links de 100 Gbit/s. Nesse caso, a agregação de links pode ser usada para aumentar a largura de banda e a redundância. Todo o tráfego dos servidores é transferido para as uplinks. Existe um conjunto de equipamentos de rede inteligentes, apelidados de ‘caixas de deus’, localizados no topo da hierarquia dessa topologia de rede. As caixas de deus são responsáveis pelo roteamento e por todos os outros serviços. A topologia de rede hierárquica permite criar uma rede modular.

Na topologia de rede vista no diagrama anterior, a falha de um link leva à falha desse segmento da rede. Por esse motivo, canais reservados e redundância são usados para esse tipo de topologia de rede (veja o esquema a seguir) em cada camada de rede. A falha de um dispositivo ou link causa degradação de desempenho, mas a rede continua funcionando. Essa topologia de rede redundante geralmente requer STP (Protocolo de Árvore de Abrangência).

Manutenção. Se você desconectar algum dos equipamentos de rede no topo desse tipo de topologia de rede de 3 camadas para atualizar o software ou realizar outras tarefas de manutenção, o desempenho da rede se degrada. Alguns serviços podem ficar temporariamente indisponíveis.

Escalabilidade. O número de serviços em execução nos servidores está crescendo a cada ano e a quantidade de tráfego está aumentando em conformidade. Esta situação requer atualização e aumento da largura de banda da rede na rede MSP. Aumentar a largura de banda da rede em um data center clássico geralmente requer o seguinte:

- Aumento das conexões de agregação de links (LAG)

- Compra de placas de rede

- Se não houver slots disponíveis para instalação de placas de rede, comprar novos servidores ou equipamentos relacionados

Se você precisar adicionar um novo rack de servidor (gabinete de rack) como um novo módulo em seu data center, você pode aumentar a largura de banda da rede para este rack e os servidores instalados neste rack. Esse tipo de topologias de rede não pode garantir um alto nível de reserva de link e redundância como resultado das características do protocolo L2, como STP e MSTP (Protocolo de Árvore de Espanamento Múltiplo).

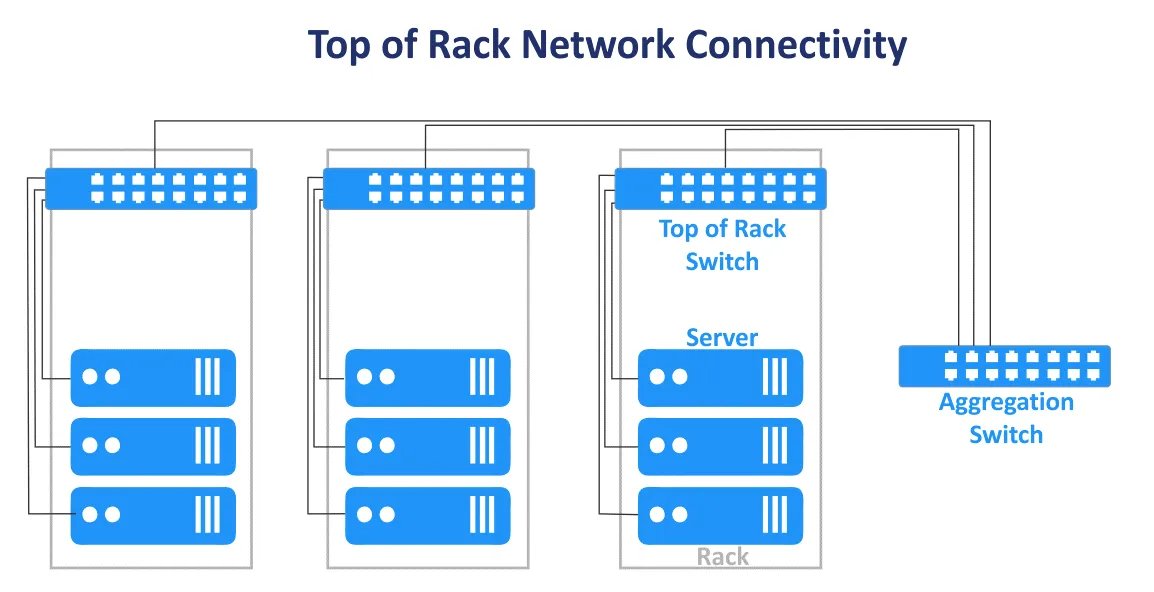

A clássica topologia de rede em três camadas em um data center pode ser combinada com os designs End of Row e Top of Rack. O esquema de conexão Top of Rack é agora mais popular. Esse nome é usado porque servidores e switches são conectados ao switch principal em cada rack. Os switches Top of Rack (ToR switches) são conectados a switches/roteadores dos níveis superiores na rede MSP. Os switches ToR são diferentes dos switches de borda do usuário e possuem várias portas de uplink de alta velocidade adicionais (como portas 10-Gbit/s) e um alto número de portas para conectar servidores. Os switches ToR são instalados em pares para redundância e para permitir manutenção no switch. As vantagens desse esquema de conexão ToR são o menor comprimento do cabo ao conectar dispositivos em um rack e entre racks. Switches de acesso da topologia de rede hierárquica de vários níveis geralmente são usados como switches ToR.

Direção do tráfego

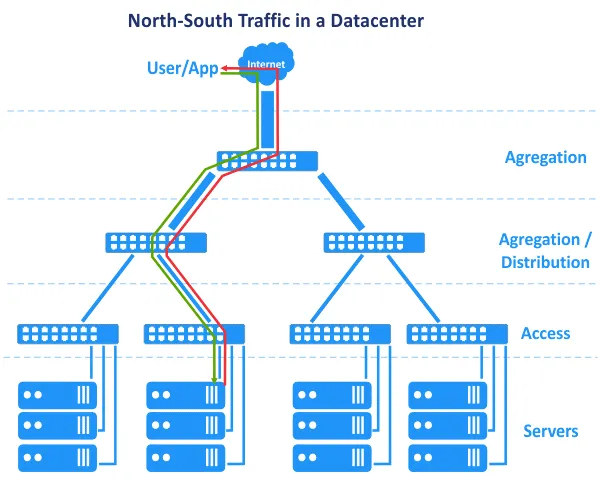

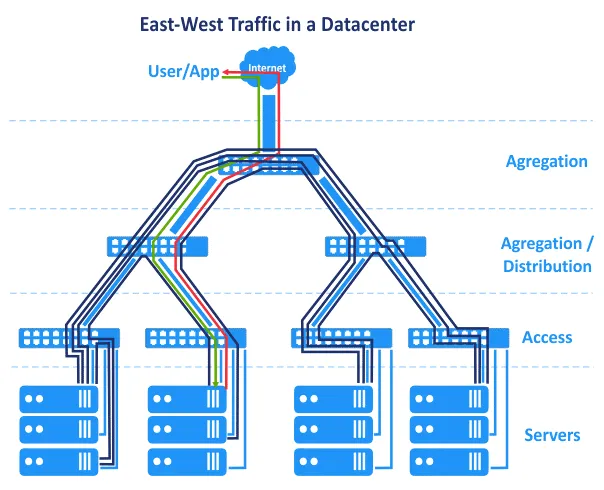

As desvantagens previamente explicadas não são muito críticas, e uma rede de centro de dados pode funcionar com sucesso com administração adequada. Mudar de L2 para L3 em uma parte da rede ajuda a resolver um conjunto de problemas. Há outra característica relacionada a como os centros de dados evoluíram e como as aplicações funcionam de maneira diferente hoje do que costumavam fazer. Na década de 2000, as aplicações foram criadas usando uma arquitetura centralizada, e as aplicações da arquitetura cliente-servidor eram principalmente monolíticas. Isso significa que os componentes de uma aplicação poderiam estar localizados em um único servidor. Como resultado, em nosso diagrama, a solicitação do usuário foi enviada do topo da rede, e a solicitação gerada pela aplicação foi enviada do nível do servidor inferior de volta para o topo da rede. A solicitação do usuário foi tratada em um único host. O tráfego horizontal (leste-oeste) entre hosts era mínimo, e o tráfego norte-sul era favorecido. A topologia de rede hierárquica de vários níveis tradicional usada para redes MSP em centros de dados atende a esses requisitos. No entanto, com o tempo, novas arquiteturas foram favorecidas no desenvolvimento de aplicações.

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

A arquitetura de microsserviços presume que os componentes de uma aplicação (serviços) são executados em contêineres logicamente isolados separados que estão conectados entre si por meio de uma rede. Contêineres podem ser executados em diferentes hosts em clusters. Esta arquitetura é altamente escalável e é amplamente utilizada em nuvens hoje em dia.

Além disso, os data centers agora operam com Big Data, bancos de dados grandes, análises, publicidade contextual, aplicativos baseados em inteligência artificial e outros softwares que requerem interconexão com vários servidores, conjuntos de armazenamento, máquinas virtuais ou contêineres. Os componentes do aplicativo são distribuídos em vários servidores ou VMs no data center.

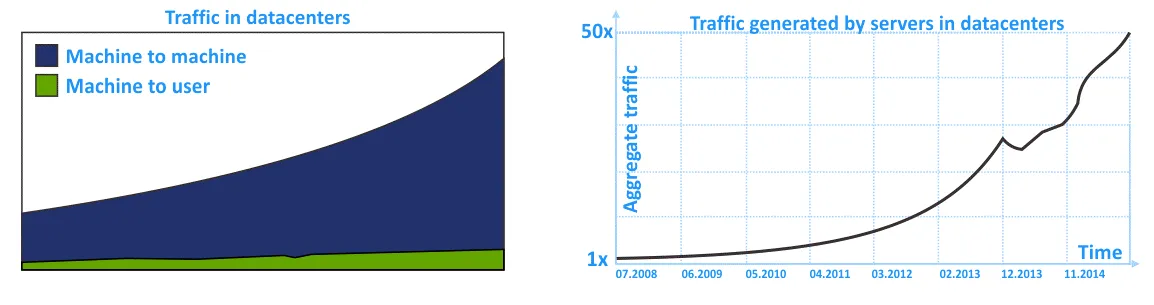

Como resultado, o tráfego leste-oeste é maior do que o tráfego norte-sul na rede MSP. O tráfego interno em uma rede de data center (tráfego intra-DC) é maior do que o tráfego de/para um usuário externo que envia uma solicitação ao data center. Não se esqueça do tráfego interno entre sistemas de armazenamento, replicação de banco de dados, backup de dados e outras atividades de serviço que usam a rede em um data center.

Nos diagramas a seguir, você pode ver a representação gráfica do crescente tráfego interno nas redes MSP dentro dos data centers nos últimos anos. A tendência mostra que o tráfego intra-DC está crescendo mais do que o tráfego de entrada/saída.

As redes tradicionais, construídas usando a topologia de rede hierárquica tradicional de três camadas, são confiáveis, mas não adaptadas para fluxos de tráfego lateral da maneira mais racional. Isso se deve à ênfase na rede L2 e no tráfego norte-sul.

Topologia de Rede Clos

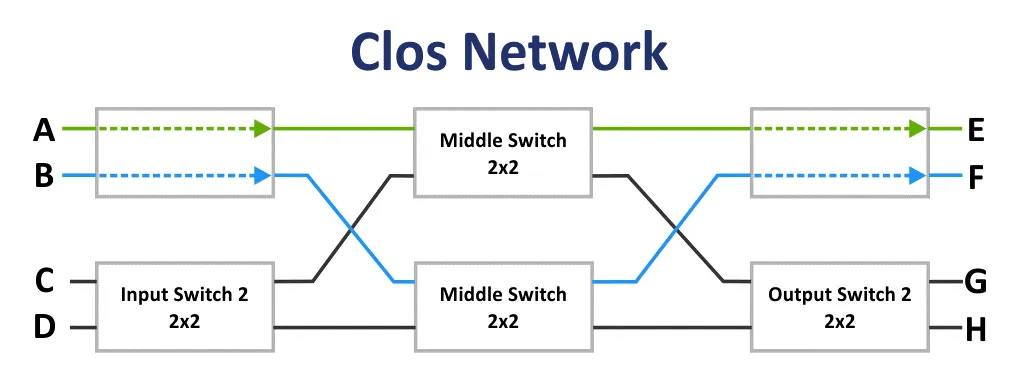

Inicialmente, a rede Clos foi inventada por Edson Erwin em 1938. Em 1953, Charles Clos decidiu usar redes de comutação não bloqueadoras em sistemas telefônicos para um uso mais racional das comunicações em comparação com o esquema de comunicação por matriz de cruzamento. Com matrizes com um baixo número de interconexões, entradas e saídas, o esquema de conexão parece ser difícil à primeira vista. No entanto, a rede Clos é menos complexa devido a um menor número de pontos de conexão de acordo com a fórmula: 6n^(3/2)-3n. Esse fato fica claro a partir de 36 pontos de conexão.

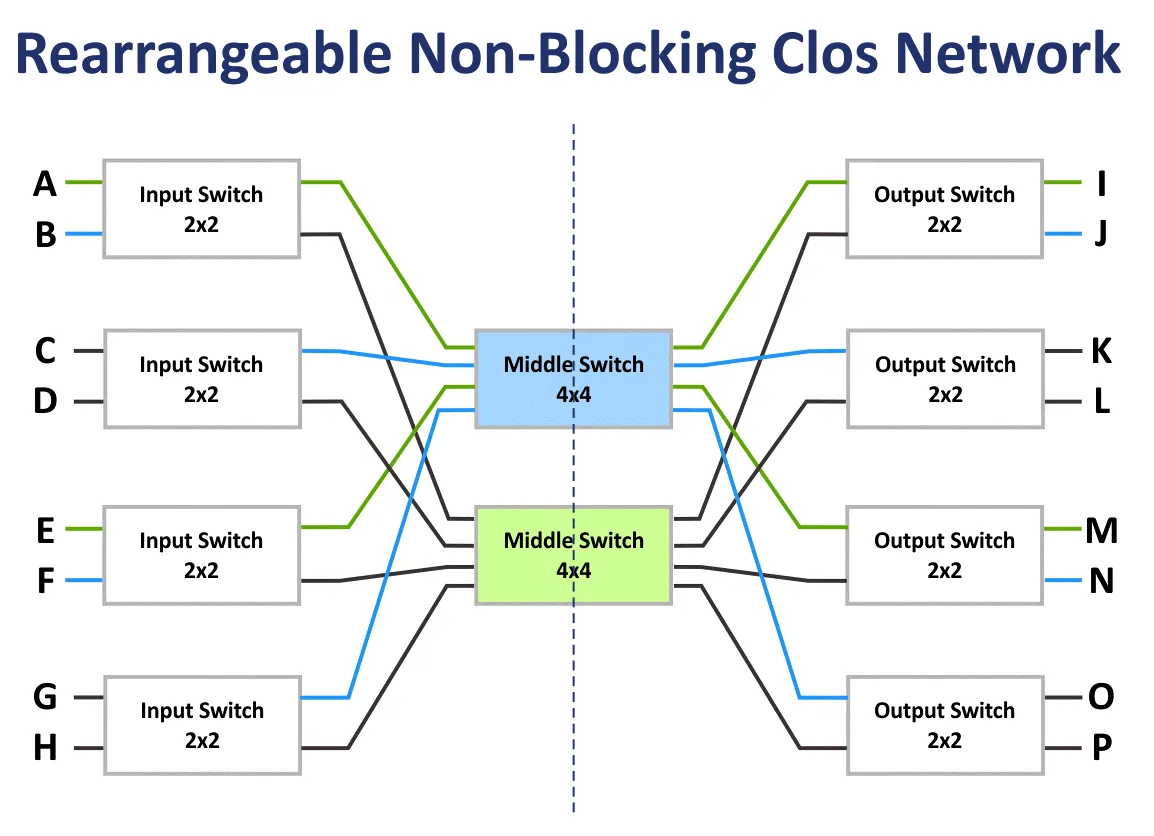

Se m é o número de switches de entrada e n é o número de switches de saída, então as características de bloqueio da rede Clos são calculadas usando a fórmula. De acordo com o teorema de Clos, uma rede Clos é estritamente não bloqueadora se o número de switches de segunda etapa m ≥ 2n−1.

A rede de bloqueio é uma rede na qual é impossível encontrar um caminho de comunicação de uma porta de entrada livre para uma porta de saída livre.

A rede não bloqueadora é a rede na qual um caminho para conectar qualquer porta de entrada e saída sempre existe. Redes não bloqueadoras são criadas adicionando uma etapa de comutação adicional.

A rede não bloqueadora rearranjável é a rede na qual todos os caminhos possíveis para conectar todas as portas de entrada e saída podem ser rearranjados.

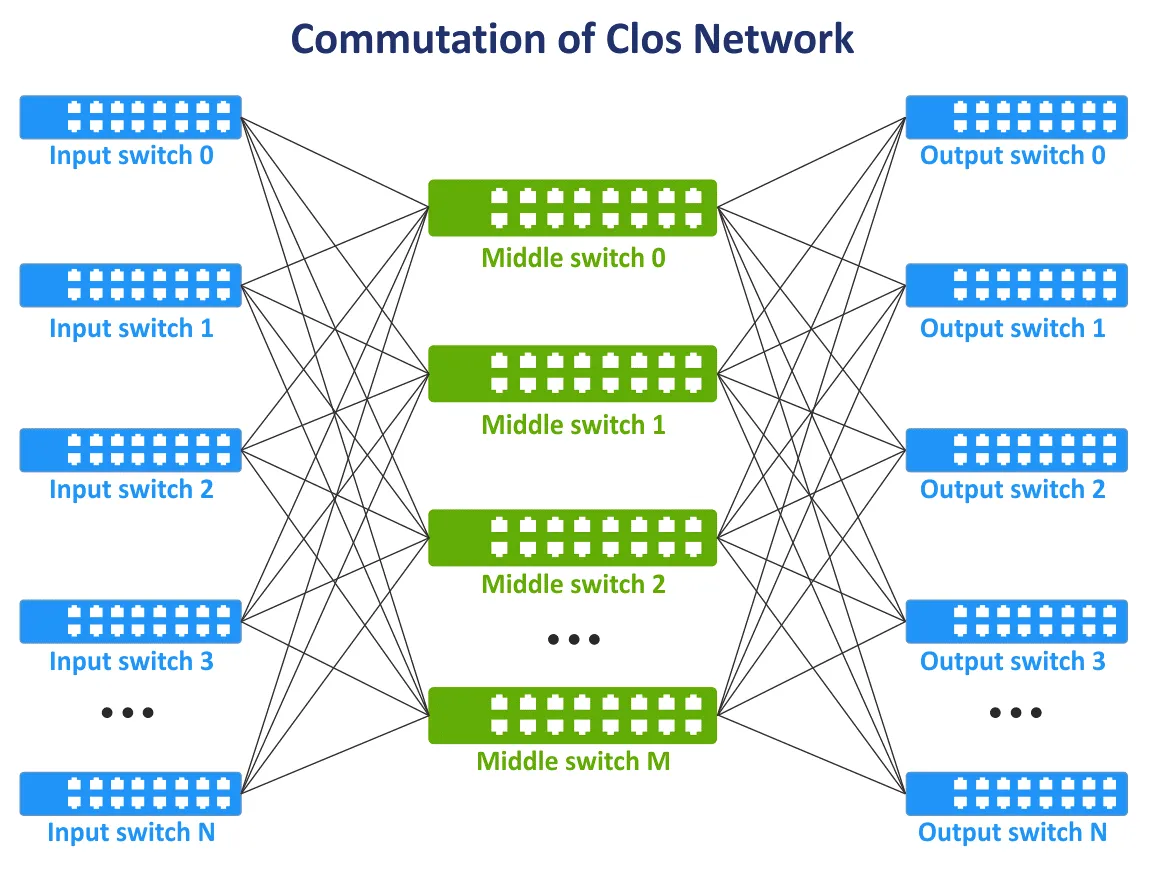

No final dos anos 1990, com a evolução das tecnologias de telecomunicações e redes de computadores, o conceito de redes Clos tornou-se relevante novamente. Há uma necessidade de todos os nós se comunicarem entre si na estrutura da rede e, se possível, não usar a topologia de malha completa quando todos os dispositivos estão interconectados. Uma nova camada de comunicação foi adicionada para interconectar dispositivos de rede. Como resultado, o conceito de rede Clos foi revivido em uma nova encarnação. Na seguinte imagem, você pode ver um esquema típico da rede Clos de três camadas.

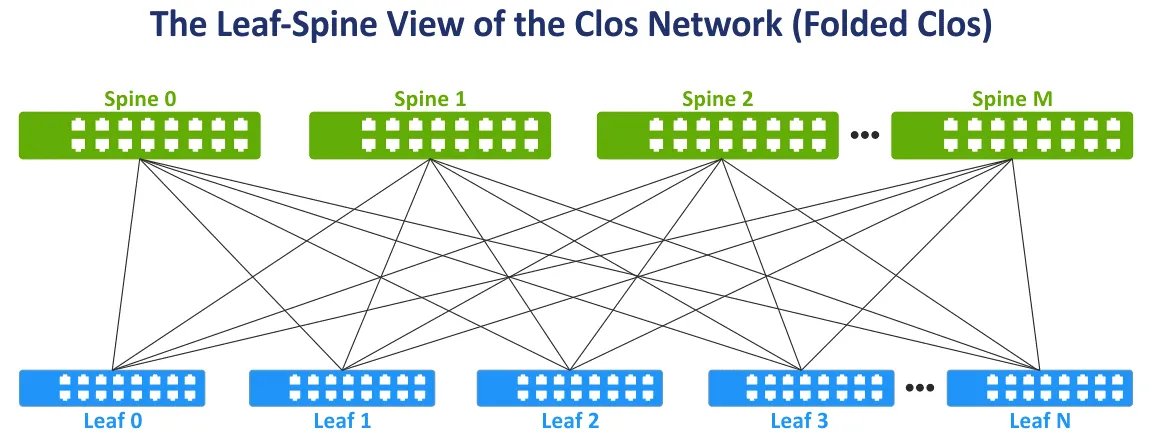

Vamos modificar a visualização da rede Clos para a amplamente utilizada visualização de Folha-Espinha para mais conveniência, dobrando os lados esquerdo e direito do esquema. Esta topologia de rede é conhecida como Folha-Espinha, Clos Dobrado e Rede Clos de 3 estágios (veja a seguinte imagem).

A camada de espinha. Os switches de espinha são usados para interconectar todos os switches de folha na topologia de rede de malha completa. A camada de espinha substitui, até certo ponto, a camada de agregação usada na tradicional topologia de rede hierárquica de três camadas. Mas a camada de espinha não é um equivalente direto da camada de agregação. A principal tarefa da camada de espinha é a transferência rápida de dados de uma folha para outra. Dispositivos de endpoint não estão conectados aos switches de espinha.

A camada de folha. Neste modelo, servidores ou outros dispositivos de endpoint no centro de dados estão conectados às folhas. Todas as folhas estão conectadas a todos os espinhos. Como resultado, há um grande número de conexões de rede com largura de banda igual entre todos os servidores. Existem conexões L3 entre espinhas e folhas (L3 no modelo OSI).

Quando o tráfego é transmitido de origem para destino na rede, o número de saltos é o mesmo (por exemplo, são necessários três saltos para transferir dados entre quaisquer servidores dentro da rede de folha-espinha de dois níveis no esquema a seguir). A latência é previsível e baixa. A capacidade da rede também é aumentada porque agora não é necessário usar STP. Quando o STP é usado para conexões redundantes entre switches, apenas um link pode estar ativo por vez.

Na topologia de rede de folha-espinha, o protocolo de roteamento de Multipath de Custos Iguais (ECMP) pode ser usado para balancear o tráfego e evitar loops na rede (para conexões de rede L3). Os protocolos BGP, OSPF, EIGRP, ISIS também podem ser usados.

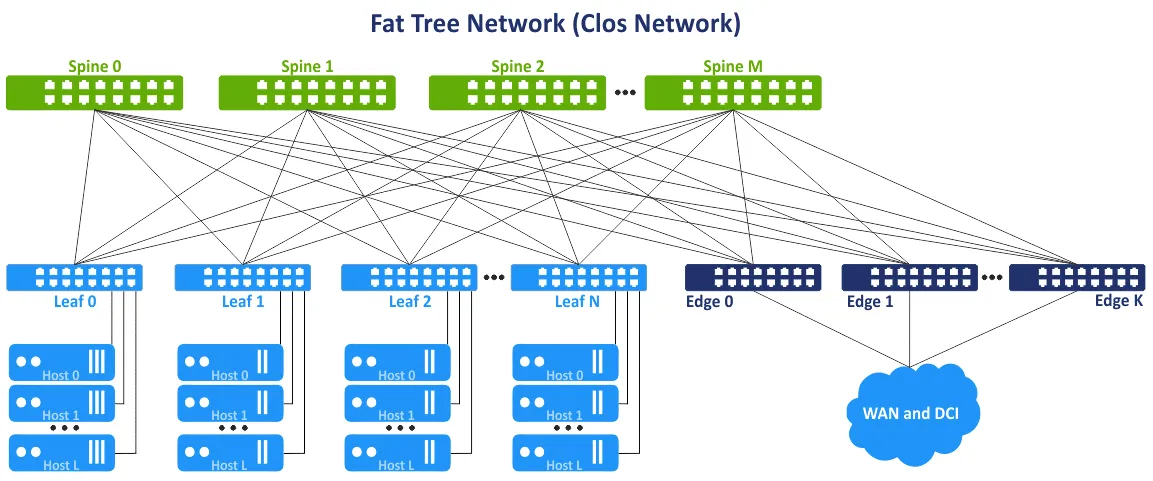

Este conceito de rede também é referido como topologia de rede de árvore gorda de várias camadas. A ideia é evitar gargalos nas camadas superiores da árvore (próximo à raiz da árvore) e adicionar links adicionais para aumentar a largura de banda nesses segmentos. Como resultado, há uma capacidade de link crescente em direção à raiz. A árvore gorda é um caso especial da rede Clos. A rede Clos de três camadas é transformada em uma rede de folha-espinha de dois níveis após a dobragem. Os switches de folha ou switches/balanceadores de borda de folha podem ser usados para acessar redes externas e outros data centers.

Vantagens da topologia de rede de folha-espinha

A topologia de rede de folha-espinha oferece um conjunto de vantagens sobre a topologia de rede de acesso-agregação-núcleo. Este conjunto de vantagens é a razão para usar o tipo de topologia de rede de folha-espinha em um centro de dados.

Conexões otimizadas. Links com largura de banda alta entre dispositivos de rede são ótimos para o tráfego leste-oeste. Não há links não utilizados (pois o L3 é usado em vez do L2). ECMP é recomendado para alta eficiência, e STP não é necessário.

Confiabilidade. A falha de um dispositivo ou desconexão de um link não causa resultados e desvantagens significativas. Se o switch ToR que atua como switch leaf falhar, o rack correspondente é afetado. Se um switch spine falhar, a largura de banda da rede degrada, mas não significativamente em comparação com a topologia tradicional de rede hierárquica de 3 camadas. A degradação da largura de banda para a topologia spine-leaf é 1/n, onde n é o número de espinhas. A degradação da largura de banda para a topologia hierárquica é 50% neste caso.

Alta escalabilidade. Você pode adicionar novas folhas até ter portas livres em espinhas. Adicionar novas espinhas permite aumentar os uplinks das folhas. Adicione switches/routers de borda para aumentar a largura de banda para redes externas. A abordagem tradicional para aumentar a largura de banda e conectar mais servidores para a topologia de rede hierárquica de camada de árvore é adicionar mais placas de rede com mais portas, equipamentos de rede com interfaces de rede mais rápidas e hardware mais poderoso em geral. Esta abordagem tradicional é chamada de escalabilidade vertical ou scale up.

Ao usar a topologia de rede leaf-spine em data centers e para redes MSP, você pode adicionar uma camada adicional de espinhas. Esta abordagem é chamada de escalabilidade horizontal ou scaled out. Adicionar um dispositivo de rede típico como um switch/router aumenta a escalabilidade de forma linear.

Manutenção. Você pode facilmente desconectar as espinhas da rede para manutenção ou substituição. As tarefas de manutenção nas espinhas não são arriscadas em comparação com as caixas centrais porque não há funcionalidade de inteligência nas espinhas, e a redução de largura de banda é mínima após a desconexão.

Rede Clos de Múltiplos Níveis

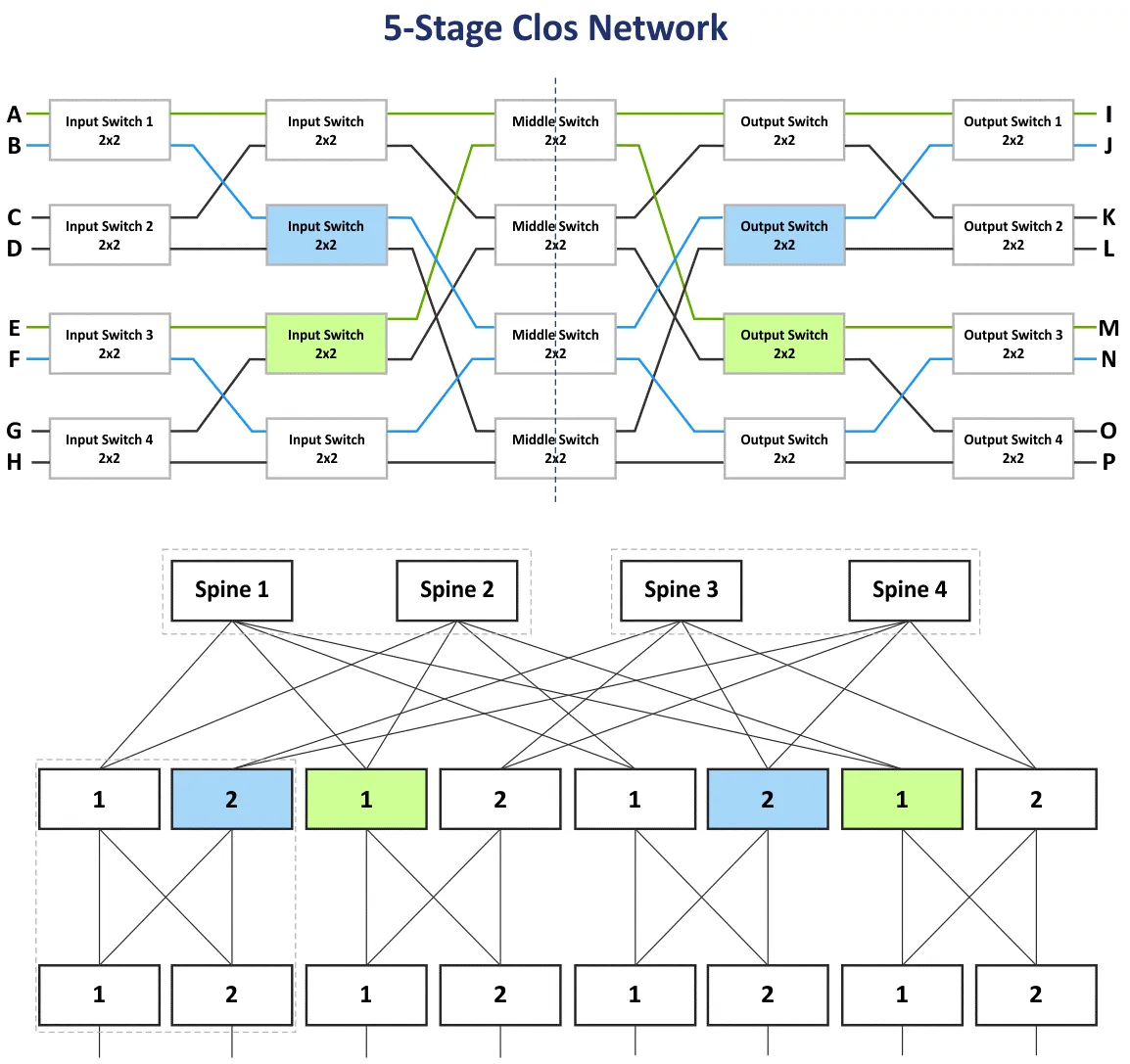

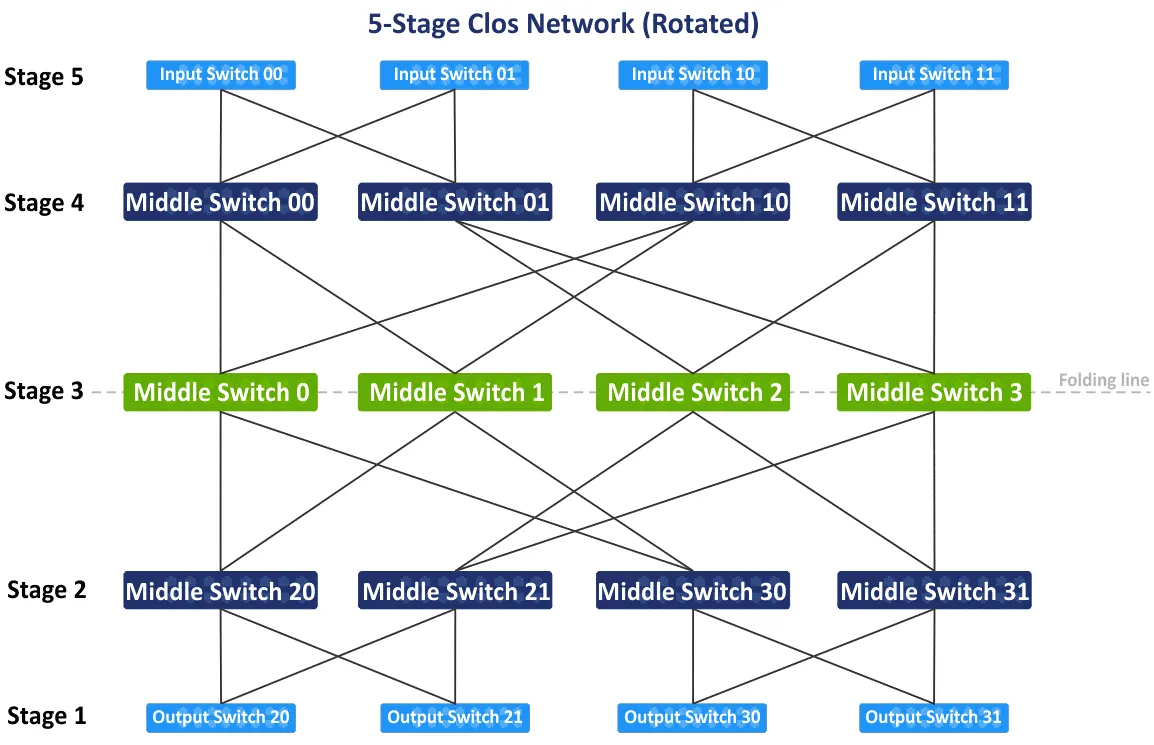

Na seção anterior, expliquei a rede Clos de três estágios com os estágios: Comutador de Entrada, Comutador do Meio e Comutador de Saída. Como os dispositivos nos estágios de entrada e saída são usados para receber/enviar dados, o esquema de rede pode ser dobrado usando uma linha intermediária composta por uma topologia de rede de folha-espinha de dois níveis. Você pode adicionar mais estágios e construir a rede Clos de múltiplos níveis para conectar mais dispositivos de rede a esta rede. Neste caso, você tem cinco estágios: Comutador de Entrada, Comutador do Meio 1, Comutador do Meio 2, Comutador do Meio 3, Comutador de Saída.

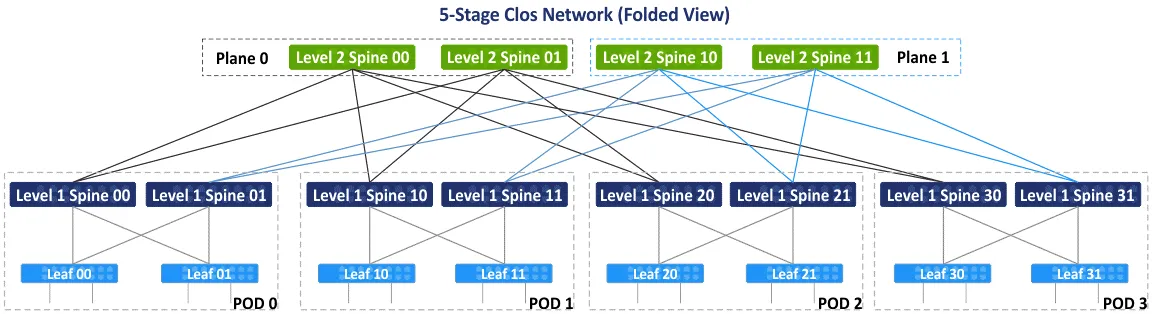

No diagrama a seguir, você pode ver o esquema inicial da rede Clos de cinco estágios não-bloqueadora após o rearranjo dos blocos azuis e verdes. Há também a visualização dobrada de folha-espinha ou a visualização de árvore gorda (4,3) (porque há 4 comutadores de espinha e 3 estágios no esquema de folha-espinha), mas vamos ver como conectar dispositivos na rede Clos de 5 estágios passo a passo. Um tipo de topologia de rede Clos com mais de 5 estágios não é comum e não é usado na prática porque o número de conexões é muito grande.

Depois de rodar o esquema inicial da rede Clos de cinco estágios 90 graus no sentido horário, você terá a visão tradicional com switches de entrada, switches de saída e três estágios de switches intermediários. Vamos desenhar a linha de dobragem através dos switches intermediários no centro do esquema para fazer a visualização dobrada da rede Clos de cinco estágios.

Após dobrar o esquema, você obtém a visualização dobrada ou a visualização de folha-espinha desse tipo de topologias de rede (veja o esquema a seguir). Existem 4 grupos individuais atuando como pontos de entrega (PODs). O POD é a unidade universal para a construção de data centers. Os PODs estão conectados às espinhas do primeiro nível. Se você precisar expandir seu data center ou adicionar mais servidores/equipamentos de rede, então adicione novos PODs e conecte-os à estrutura de rede. As espinhas de um POD estão conectadas às espinhas de outros PODs através de espinhas de segundo nível. Ao mesmo tempo, nem todas as espinhas L1 estão conectadas a todas as espinhas L2, e elas são divididas por planos.

Há dois planos – Plano 0 e Plano 1 no esquema a seguir. Este conceito é utilizado devido ao número limitado de portas em espinhas, e criar uma topologia de rede totalmente conectada não é possível neste caso. No esquema a seguir, cada espinha tem um limite de 4 portas. De acordo com a ideia principal, a rede Clos não bloqueante é baseada nos mesmos elementos (switches de 4 portas, como visto abaixo).

À primeira vista, você pode se confundir com termos como Clos, Clos dobrado, folha-espinha e árvore gorda. Deixe-me esclarecer esses termos.

Clos ou rede Clos é o termo que abrange a base teórica do tipo de topologia de rede Clos.

O Clos Dobrado é uma representação mais conveniente da rede Clos, onde as entradas e saídas têm o mesmo papel e estão localizadas no mesmo lugar.

Leaf-spine é uma topologia de rede baseada no esquema de rede Clos que é usada na prática em centros de dados para construir redes, incluindo redes MSP.

Fat tree é geralmente referido como uma variação da rede Clos. Este termo é o mais confuso porque alguns artigos mencionam a fat tree como a rede clássica de acesso-agregação-núcleo. Eu me refiro ao documento RFC 7938 que diz que a fat tree é baseada na topologia de rede Clos dobrada.

Cálculos

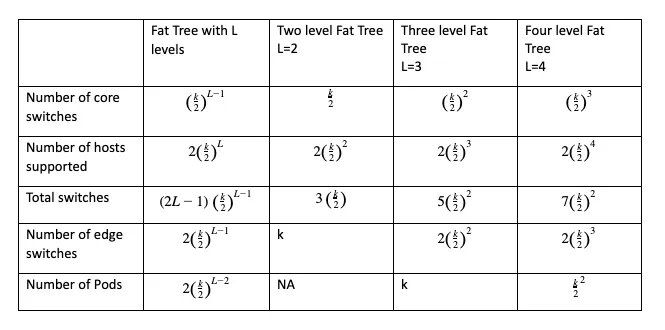

Você pode calcular o número de switches principais, switches de borda, switches totais necessários e o número total de hosts que podem ser conectados à rede da configuração selecionada usando fórmulas onde:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

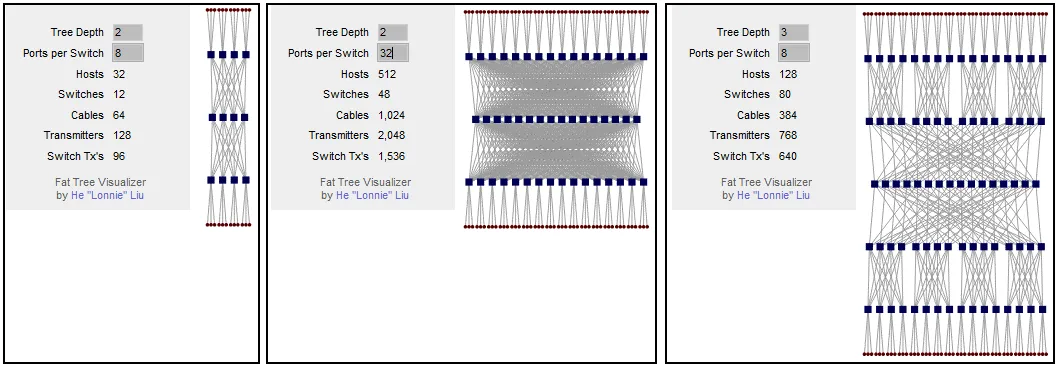

O parâmetro principal a ser calculado antes de construir sua rede é o número de hosts suportados. A configuração da fat-tree pode ser escrita como FT(k, L). Por exemplo, FT(32,3) é uma rede de fat-tree de três níveis com switches de 32 portas. Você pode usar este calculadora gratuita para redes Clos que também gera o esquema de visualização para a configuração selecionada.

Você pode calcular que se o seu esquema de rede de árvore gorda tiver 2 níveis e 8 portas por switch, então você pode conectar 32 hosts à rede. Se você aumentar o número de portas por switch, o número de hosts suportados aumenta para 512. Como você pode ver, o número de hosts conectados depende do número de portas em cada switch. Se você deixar a árvore gorda com 2 níveis (a rede Clos de 3 estágios) e aumentar o número de portas por switch, o número de espinhas aumenta significativamente. Você pode resolver esse problema adicionando mais um nível à árvore gorda. Para uma árvore gorda de três níveis, se o número de portas por switch for 8, você pode conectar 128 hosts.

Se você aumentar o número de portas por switch para 32, você pode conectar 8192 hosts usando esta topologia de rede. Este número para a rede Clos de 5 estágios é 16 vezes maior do que o da rede Clos de 3 estágios. Tenha em mente as limitações do rack do servidor ao planejar o esquema de instalação de servidores e equipamentos de rede no data center.

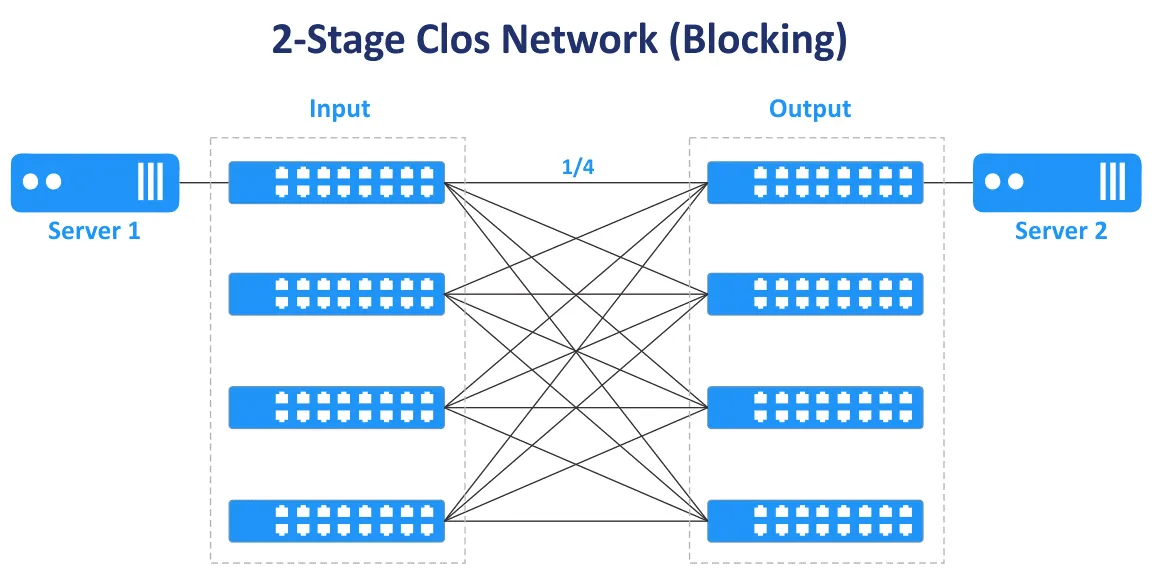

Números ímpares de estágios são usados para construir redes Clos sem bloqueio (3, 5, 7, etc.). A rede Clos de 2 estágios não fornece conectividade sem bloqueio e múltiplas conexões entre switches.

No diagrama a seguir, você pode ver que no caso da rede Clos de dois estágios, há apenas um caminho de transmissão para conectar o Servidor 1 e o Servidor 2. Apenas ¼ das portas estão conectadas, outras portas não estão conectadas e bloqueiam você.

A taxa de sobrescrição é a razão entre a largura de banda de entrada e a largura de banda de saída na direção das camadas inferiores para as camadas superiores. A taxa de sobrescrição geralmente varia de 2 a 4.

Um switch tem 48 portas de 10 Gbit e 4 portas de uplink de 40 Gbit. A largura de banda total das ligações descendentes para servidores é de 48×10=480 Gbit/s. A velocidade total dos uplinks é de 4×40=160 Gbit/s. A taxa de oversubscrição é de 480/160=4.

Se a velocidade total da largura de banda for igual para todas as portas de downlink e uplink do switch, o switch não está subscrito e não há gargalos neste caso. Uma taxa de oversubscrição de 1:1 é o caso ideal. Estime o tráfego em diferentes direções antes de comprar switches com a velocidade e o número de portas adequados.

Switches que têm uma taxa de oversubscrição superior a 1 são frequentemente usados no estágio de leaf em redes da topologia de rede leaf-spine. Switches não subscritos devem ser usados no estágio de spine. Switches no nível de folha na topologia de rede leaf-spine são geralmente usados como switches ToR. No entanto, é possível instalar switches de folha como switches End of Row.

Diferenças essenciais

Ao criar uma rede, algumas decisões afetam o layout da rede. Aqui estão algumas decisões que afetam o funcionamento da rede.

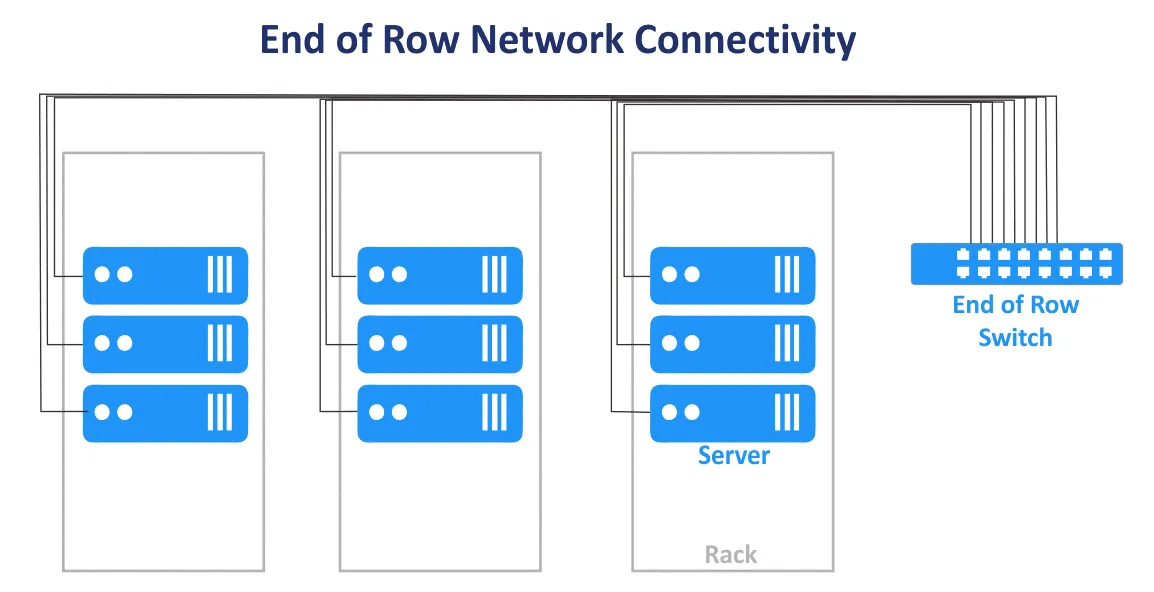

Top of Rack vs End of Row

O esquema de conexão de rede Top of Rack (ToR) em um centro de dados é onde um ou vários switches são instalados em cada rack. Cabos curtos são usados para conectar o switch no topo do rack com outro equipamento de rede e servidores dentro do rack. Os switches ToR geralmente têm uplinks de alta velocidade para os switches/roteadores de nível superior e podem ser conectados com cabos de fibra óptica. A vantagem é que ao usar este esquema de conexão para uma rede MSP, você não precisa instalar um grande volume de cabos de cada rack no centro de dados. O uso de cabos no centro de dados é mais racional ao usar o esquema ToR. Neste caso, você gasta menos com cabeamento e tem um melhor gerenciamento de cabos. Você pode gerenciar cada rack como um único módulo sem afetar outros racks dentro de um centro de dados porque apenas os servidores em um rack são afetados. Apesar do nome do esquema, você pode montar um switch no meio ou na parte inferior de cada rack.

O esquema de conexão de rede End of Row (EoR) é quando um rack de servidor no final da fila contém equipamento de rede. O equipamento inclui um switch de rede comum para conectar todos os servidores e outros dispositivos de todos os racks de servidor na fila. Cabos do equipamento de rede instalado no rack de servidor EoR são conectados aos dispositivos em todos os racks da fila usando painéis de conexão montados em cada rack. Como resultado, cabos longos são usados para conectar todos os dispositivos de rede em uma fila. Se forem usadas conexões de rede redundantes, o número de cabos também aumenta. Grandes volumes de cabos podem bloquear o acesso de ar ao equipamento.

Os racks do servidor geralmente estão localizados em filas lado a lado em um centro de dados. Uma fila pode conter 10 ou 12 racks, por exemplo. Toda a fila é considerada uma única unidade de gerenciamento ao utilizar o esquema de conexão EoR para a rede MSP em um centro de dados. O modelo de gerenciamento por fila é usado neste caso. Menos switches individuais são necessários no modelo de conexão de rede EoR. A flexibilidade é menor quando é necessário realizar manutenção ou atualização de switches porque mais dispositivos são afetados quando um switch EoR é desconectado. Apesar do nome, um rack com um switch comum (switches) pode ser colocado no meio da fila.

Conexão de Camada 2 vs Camada 3

A decisão sobre as conexões dentro de uma rede é um cálculo que envolve confiabilidade, velocidade e despesa, além da topologia sendo criada.

Por exemplo, existem segmentos de rede para a topologia de rede tridimensional de Acesso-Agregação-Núcleo e topologia Folha-Espinha. Lá, o tráfego é transferido nos modelos OSI L2 e L3. Na rede hierárquica de três camadas, a camada de acesso opera na L2, a camada de distribuição/agregação agrega links L2 e fornece roteamento L3, a camada de rede central realiza roteamento na terceira camada do modelo OSI. A rede da topologia multi-nível Folha-Espinha pode ser configurada usando L2 com VLANs e L3 com roteamento IP e sub-redes.

O equipamento de rede L2 é mais acessível do que o equipamento de rede L3, mas há algumas desvantagens ao usar a rede L2 para conectar dispositivos de rede na rede MSP de um centro de dados. VLAN é geralmente usada para isolar logicamente redes usando o mesmo ambiente físico. O número máximo de VLANs é 4095 (menos algumas VLANs reservadas como 0, 4095, 1002-1005).

Outra desvantagem, como mencionado anteriormente, é a incapacidade de usar links redundantes quando o STP é usado na L2. Isso ocorre porque apenas um link pode estar ativo ao mesmo tempo, e toda a largura de banda disponível de todos os links não é utilizada. Quando o domínio L2 com STP se torna grande, a probabilidade de problemas causados por cabos inadequados e erro humano aumenta, e a solução de problemas se torna difícil.

Uma configuração de rede L3 permite aos engenheiros melhorar a estabilidade e escalabilidade da rede MSP e das redes de data center em geral.

Os seguintes protocolos de rede ajudam a gerenciar a rede L3 e rotear o tráfego.

O BGP (Border Gateway Protocol) é um protocolo de roteamento dinâmico amplamente utilizado e considerado o padrão em muitas organizações com data centers em grande escala. O BGP é um protocolo altamente escalável, expansível e eficiente.

O ECMP (Equal Cost Multipath Routing) é uma tecnologia de roteamento de rede usada para distribuir o tráfego usando vários melhores caminhos definidos por métricas no terceiro nível do modelo OSI. O ECMP com protocolos de roteamento é usado para balanceamento de carga em redes grandes. A maioria dos protocolos de roteamento, incluindo BGP, EIGRP, IS-IS, OSPF, suporta a tecnologia ECMP.

Tente sempre usar os protocolos de rede mais progressistas. Mas lembre-se de que quanto menos protocolos forem usados na rede, mais conveniente será a administração da rede.

Topologia de Rede para NV e SDN

Além da virtualização de hardware e uso de máquinas virtuais, a virtualização de rede com uma abordagem centrada em aplicativos também se tornou popular. Soluções de Virtualização de Rede (NV) como VMware NSX, OpenStack networking e Cisco ASI utilizam intensamente o tráfego leste-oeste na rede física, e a topologia de rede leaf-spine é adequada para soluções de virtualização de rede por essa razão. Leia o post do blog sobre VMware NSX para saber mais sobre virtualização de rede.

A rede definida por software (SDN) é usada para virtualizar redes para uso eficaz de recursos, flexibilidade e administração centralizada. Esta é uma solução ideal em um data center virtualizado onde as máquinas virtuais conectadas à rede são usadas. As máquinas virtuais podem migrar entre servidores, criando assim tráfego leste-oeste dentro do data center. SDN é amplamente utilizado para redes de MSP por MSPs que fornecem IaaS (infraestrutura como serviço).

A configuração de redes definidas por software é eficaz ao usar a topologia de rede leaf-spine subjacente com roteamento dinâmico, um número fixo de saltos, baixa latência previsível e otimização de tráfego leste-oeste para comunicação de servidor para servidor em um data center.

VXLAN

VXLAN (Rede Local Virtual e Extensível) é um protocolo de rede aprimorado usado em vez de VLAN em redes de sobreposição. Túneis de L2 são criados usando as redes subjacentes de L3 (infraestrutura de rede L3) para fornecer conectividade de rede L2 sem as limitações tradicionais de VLAN. Com VXLAN, você pode configurar a rede L2 sobre a rede L3. A topologia virtual pode ser diferente da topologia de rede física da rede subjacente.

Os quadros VXLAN são encapsulados em pacotes IP usando o esquema de encapsulamento MAC-em-UDP. VNI é equivalente ao ID da VLAN. O número máximo de VNI é 2^24, ou seja, cerca de 16 milhões. VXLAN é usado para criar redes L2 em ambientes geograficamente estendidos, por exemplo, quando é necessário criar uma rede em dois data centers geograficamente distribuídos.

O uso de VXLAN e virtualização de rede ajuda a otimizar o tamanho da tabela de endereços MAC para switches ToR. Isso ocorre porque os endereços MAC usados pelas VMs e o tráfego de L2 relacionado são transferidos via rede de sobreposição de L2 usando VXLAN. Eles não sobrecarregam as tabelas MAC dos switches físicos. As tabelas de endereços MAC dos switches físicos não excedem a capacidade máxima disponível das tabelas dos switches.

Conclusão

Tradicionalmente, as redes em data centers eram construídas usando a clássica topologia de três camadas acesso-agregação-núcleo. Dada a evolução das aplicações modernas cliente-servidor e distribuídas, microsserviços e outros softwares que são fontes de tráfego leste-oeste dentro das redes de MSP, a topologia de rede folha-espinha, baseada no conceito de rede Clos, é preferida em data centers modernos e é uma das topologias de rede mais comuns. A topologia de rede folha-espinha é a melhor topologia de rede para grandes data centers porque esta topologia é altamente confiável e escalável. Antes de instalar uma rede em um data center, faça os cálculos e estime o tráfego gerado e as cargas de trabalho. Considere o tráfego de serviço, como tráfego de backup e replicação na rede.

O NAKIVO Backup & Replicação é um poderoso software de backup de máquinas virtuais que pode proteger cargas de trabalho do VMware Cloud Director, VMs do VMware, VMs do Hyper-V, bem como máquinas físicas Linux e Windows, bancos de dados Oracle. Provedores de serviços gerenciados que oferecem infraestrutura como serviço (IaaS), backup como serviço (BaaS) e recuperação de desastres como serviço (DRaaS) podem usar o NAKIVO Backup & Replicação instalado no modo multi-inquilino. Baixe o Teste Gratuito do NAKIVO Backup & Replicação para MSPs que suporta o modo de instalação multi-inquilino.

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/