Para proveedores de servicios gestionados (MSPs), construir una red de alto rendimiento y escalable es clave para el éxito. En un blog anterior post, cubrimos los tipos básicos de topología de red, y en este post, examinamos tipos de topología de red más complejos para proveedores de servicios, incluidos los favoritos para redes de MSP. Lee este post de blog para aprender qué topología es la mejor para un centro de datos de MSP y por qué.

Redes jerárquicas de 3 niveles tradicionales

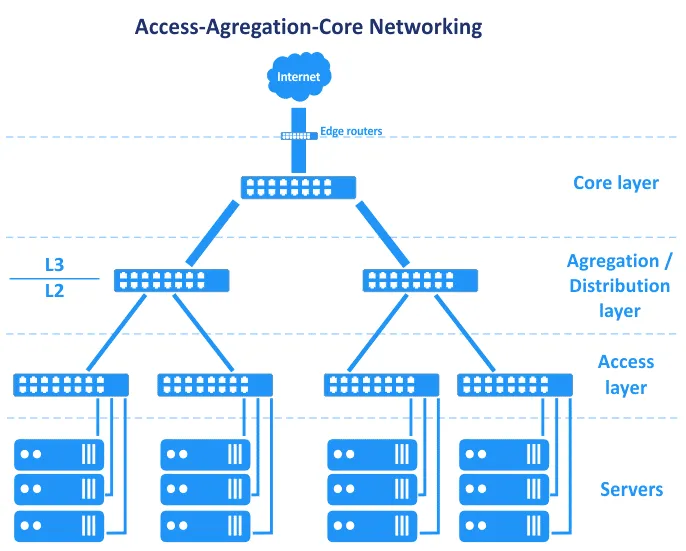

Antes de que las Redes Definidas por Software se hicieran comunes, las redes en los centros de datos se basaban en la topología de árbol jerárquico. Esta topología se divide en tres capas primarias: la capa de núcleo, la capa de agregación o distribución y la capa de acceso. En esta topología, los servidores están conectados a los switches en la capa de acceso. Los routers de borde están conectados al núcleo para proporcionar acceso desde/hacia WAN (red amplia) y internet. Estos routers se encuentran entre el núcleo y el internet en el esquema de abajo.

En términos del modelo OSI (Open Systems Interconnection), que divide la red en una capa de enlace de datos (L2) y capa de red (L3), entre otras, la topología de Acceso-Agregación-Núcleo se extiende entre capas, como se ve en el gráfico.

Veamos estas tres capas unas a las otras.

Capa de núcleo

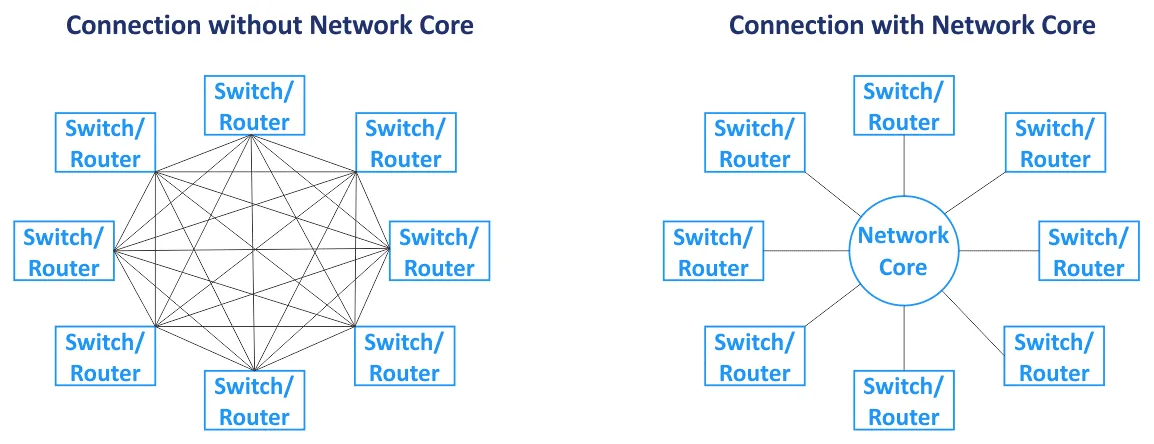

El núcleo de la red (también llamado red central) es el componente central de la red en su conjunto. Los nodos principales están conectados al núcleo. La red central suele basarse en la topología de red en malla, donde todos los nodos están conectados entre sí dentro del núcleo (para un tipo de topología de red de malla completa). Los conmutadores y enrutadores en el núcleo de la red están interconectados con enlaces de alta velocidad (que también se llaman conexiones de backbone). Dado que se utilizan enrutadores en el núcleo de la red, la capa central opera con tráfico L3.

Capa de distribución/agregación

Esta es una capa intermedia utilizada para agregar enlaces ascendentes desde la capa subyacente de la topología de red de tres niveles (la capa de acceso, que opera en L2) a la capa central de la red (que generalmente trabaja en L3) mediante el uso de enlaces de mayor ancho de banda. La capa de distribución combina un alto número de puertos de baja velocidad con un pequeño número de puertos de troncal de alta velocidad. El enrutamiento comienza en la capa de distribución/agregación de esta topología de red cuando los datos se transfieren desde la capa de acceso. El firewall, el equilibrio de carga y otras configuraciones de seguridad se establecen en la capa de agregación. La capa de agregación/distribución se utiliza para reducir y simplificar el esquema de cableado en el centro de datos para una gestión más conveniente. Los conmutadores instalados en la capa de agregación deben admitir el almacenamiento de más direcciones MAC en la tabla de direcciones MAC en su memoria. Mientras que la capa de acceso opera con tráfico L2, la capa de distribución opera con tráfico L2 y L3.

Capa de acceso

Esta capa consiste en interruptores que funcionan en L2. Los servidores y estaciones de trabajo están conectados a los interruptores de la capa de acceso. Usualmente se utilizan VLANs (red de área local virtual) para separar los dominios de difusión L2 y reducir el tráfico de difusión, aumentando así la seguridad.

Para evitar cuellos de botella, se utilizan enlaces más gruesos cerca del núcleo de la red. Por ejemplo, los servidores se conectan a los interruptores de acceso mediante interfaces de red de 10-Gbit/s, los interruptores de acceso se conectan a los interruptores de agregación mediante interfaces de 10-Gbit/s, y los interruptores/enrutadores de la capa de agregación se conectan a los interruptores/enrutadores del núcleo de la red mediante enlaces de 100-Gbit/s. En este caso, se puede utilizar la agregación de enlaces para aumentar el ancho de banda y la redundancia. Todo el tráfico de los servidores se transfiere a las salidas. Existe un conjunto de equipos de red inteligentes, apodados ‘cajas de Dios’, ubicados en la parte superior de la jerarquía de esta topología de red. Las cajas de Dios son responsables del enrutamiento y todos los demás servicios. La topología de red jerárquica le permite crear una red modular.

En la topología de red vista en el diagrama anterior, la falla de un enlace conduce a la falla de ese segmento de la red. Por esta razón, se utilizan canales reservados y redundancia para este tipo de topología de red (ver el siguiente esquema) en cada capa de red. La falla de un dispositivo o enlace causa degradación del rendimiento, pero la red continúa funcionando. Esta topología de red redundante generalmente requiere STP (Protocolo de Árbol de Expansión).

Mantenimiento. Si desconecta parte del equipo de red en la parte superior de este tipo de topología de red de 3 niveles para actualizar el software o realizar otras tareas de mantenimiento, el rendimiento de la red se degrada. Algunos servicios pueden estar temporalmente no disponibles.

Escalabilidad. El número de servicios en funcionamiento en los servidores está creciendo cada año y la cantidad de tráfico está aumentando en consecuencia. Esta situación requiere actualizar y aumentar el ancho de banda de red en la red de MSP. Aumentar el ancho de banda de red en un centro de datos clásico generalmente requería lo siguiente:

- Aumentar las conexiones de agregación de enlaces (LAG)

- Comprar tarjetas de red

- Si no hay ranuras disponibles para instalar tarjetas de red, comprar nuevos servidores o equipos relacionados

Si necesita agregar un nuevo rack de servidor (gabinete de rack) como un nuevo módulo en su centro de datos, puede aumentar el ancho de banda de red a este rack y los servidores instalados en este rack. Este tipo de topologías de red no pueden garantizar un alto nivel de reserva de enlace y redundancia como resultado de las características del protocolo L2 como STP y MSTP (Protocolo de árbol de expansión múltiple).

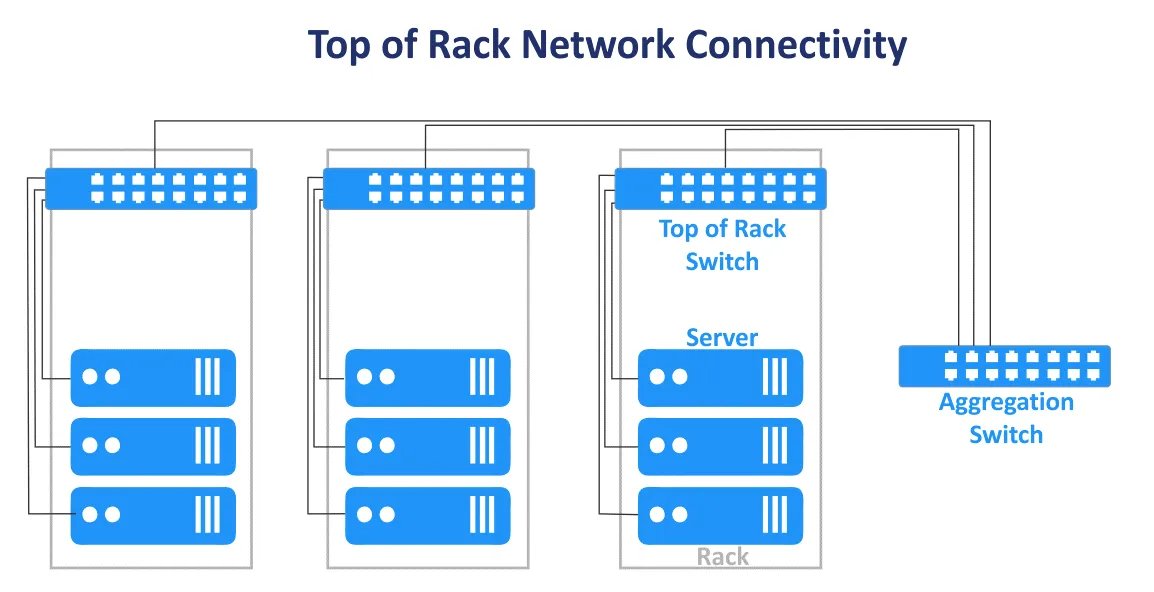

La topología de tres niveles clásica en un centro de datos se puede combinar con los diseños End of Row y Top of Rack. El esquema de conexión Top of Rack es el más popular en la actualidad. Este nombre se debe a que los servidores y conmutadores se conectan al conmutador principal en cada bastidor. Los conmutadores Top of Rack (ToR switches) se conectan a los conmutadores/enrutadores de niveles superiores en la red MSP. Los switches ToR son diferentes a los switches de borde de usuario y tienen varios puertos de enlace de alta velocidad adicionales (como puertos de 10-Gbit/s) y un gran número de puertos para conectar servidores. Los switches ToR se instalan en pares para redundancia y para habilitar el mantenimiento del conmutador. Las ventajas de este esquema de conexión ToR son la menor longitud del cable al cablear dispositivos en un rack y entre bastidores. Los conmutadores de acceso de la topología de red jerárquica de varios niveles generalmente se utilizan como switches ToR.

Dirección del tráfico

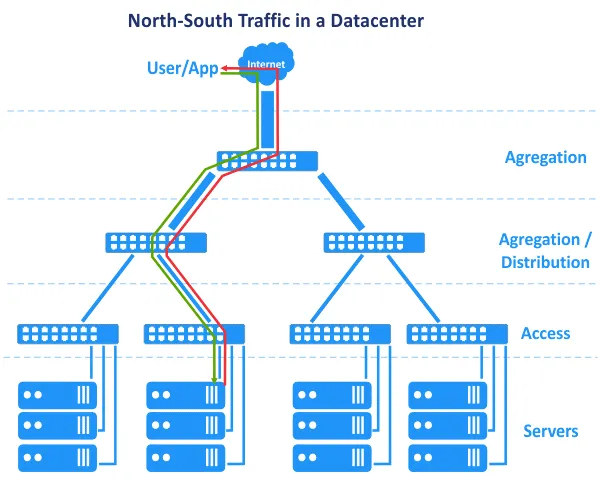

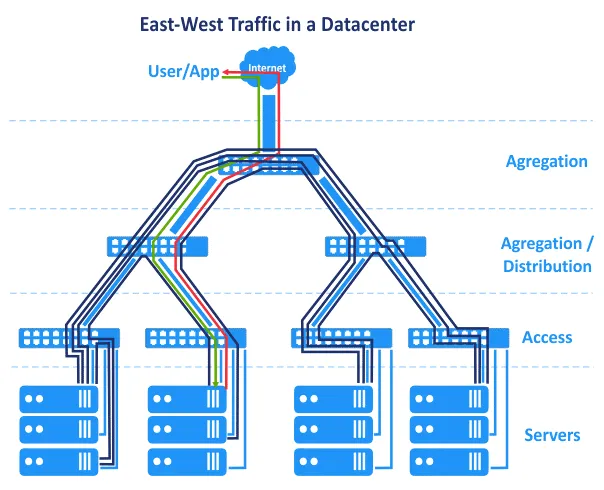

Las desventajas previamente explicadas no son demasiado críticas, y una red de centro de datos puede funcionar exitosamente con una administración adecuada. Cambiar de L2 a L3 en una parte de la red ayuda a resolver un conjunto de problemas. Hay otra característica relacionada con cómo han evolucionado los centros de datos y cómo funcionan las aplicaciones de manera diferente hoy en día que solían hacerlo. En los años 2000, las aplicaciones se creaban utilizando una arquitectura centralizada, y las aplicaciones de arquitectura cliente-servidor eran principalmente monolíticas. Esto significa que los componentes de una aplicación podían estar ubicados en un único servidor. Como resultado, en nuestro diagrama, la solicitud del usuario se enviaba desde la parte superior de la red, y la solicitud generada por la aplicación se enviaba desde el nivel del servidor inferior de vuelta a la parte superior de la red. La solicitud del usuario se manejaba en un único host. El tráfico horizontal (este-oeste) entre hosts era mínimo, y el tráfico norte-sur estaba a favor. La topología de red tradicional jerárquica de múltiples niveles utilizada para las redes de MSP en los centros de datos cumple con estos requisitos. Sin embargo, con el tiempo, se favorecieron nuevas arquitecturas al desarrollar aplicaciones.

N-tier layered architecture. Application components are distributed across multiple tiers, for example, the logic tier, the presentation tier, and the data tier. Web applications that have multiple components require these components to run on different servers, for example, a web server, application server, and database server. Application components running on multiple servers interact with each other over a network.

La arquitectura de microservicios presupone que los componentes de una aplicación (servicios) se ejecutan en contenedores lógicamente aislados separados que están conectados entre sí a través de una red. Los contenedores pueden ejecutarse en diferentes hosts en clústeres. Esta arquitectura es altamente escalable y se utiliza ampliamente en la nube en la actualidad.

Los centros de datos ahora operan con Big Data, grandes bases de datos, análisis, publicidad contextual, aplicaciones basadas en inteligencia artificial y otro software que requiere interconexión con múltiples servidores, matrices de almacenamiento, máquinas virtuales o contenedores. Los componentes de la aplicación están distribuidos en varios servidores o VMs en el centro de datos.

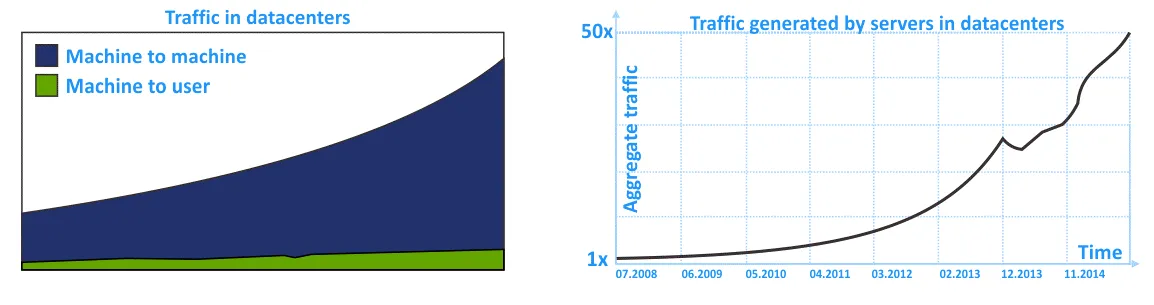

Como resultado, el tráfico este-oeste es mayor que el tráfico norte-sur en la red MSP. El tráfico interno en una red de centro de datos (tráfico intra-DC) es mayor que el tráfico desde/hacia un usuario externo que envía una solicitud al centro de datos. No olvide el tráfico interno entre sistemas de almacenamiento, replicación de bases de datos, copia de seguridad de datos y otras actividades de servicio que utilizan la red en un centro de datos.

En los siguientes diagramas, puede ver la representación gráfica del creciente tráfico interno en las redes MSP dentro de los centros de datos en los últimos años. La tendencia muestra que el tráfico intra-DC está creciendo más que el tráfico de entrada/salida.

Las redes tradicionales, construidas utilizando la topología de red jerárquica tradicional de tres niveles, son confiables pero no están adaptadas para los flujos de tráfico lateral de la manera más racional. Esto se debe al énfasis en la networking L2 y el tráfico norte-sur.

Topología de Red Clos

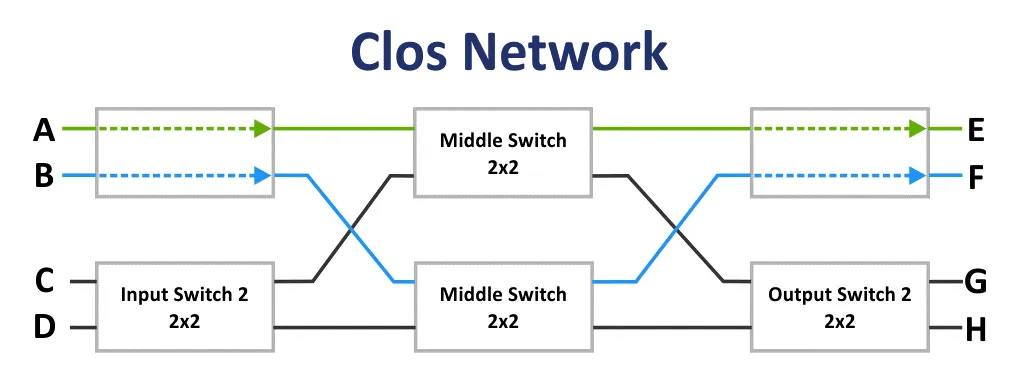

Inicialmente, la red de Clos fue inventada por Edson Erwin en 1938. En 1953, Charles Clos decidió utilizar redes de conmutación no bloqueantes en sistemas telefónicos para un uso más racional de las comunicaciones en comparación con el esquema de comunicación de cruzamiento. Con matrices con un bajo número de interconexiones, entradas y salidas, el esquema de conexión parece ser difícil a primera vista. Sin embargo, la red de Clos es menos compleja debido a un menor número de puntos de conexión según la fórmula: 6n^(3/2)-3n. Este hecho queda claro a partir de 36 puntos de conexión.

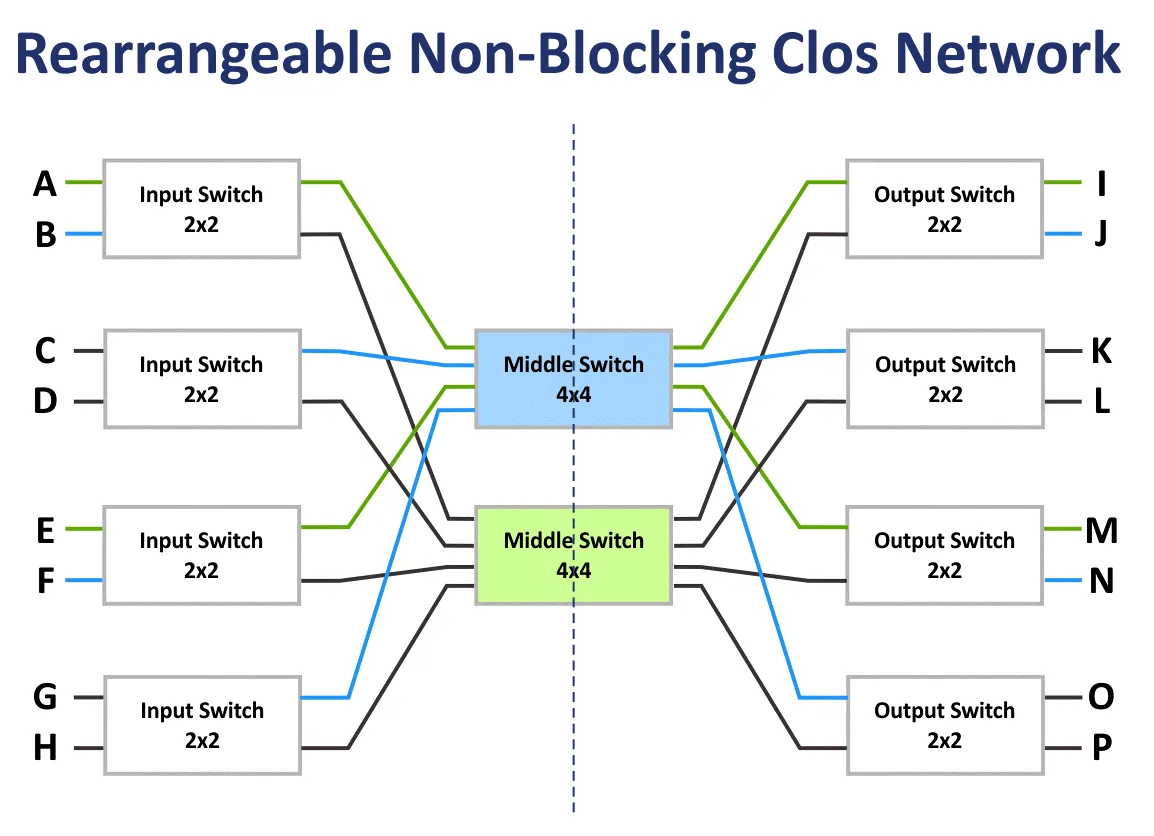

Si m es el número de conmutadores de entrada y n es el número de conmutadores de salida, entonces las características de bloqueo de la red de Clos se calculan utilizando la fórmula. Según el teorema de Clos, una red de Clos es estrictamente no bloqueante si el número de conmutadores de la segunda etapa m ≥ 2n−1.

La red de bloqueo es una red en la que es imposible encontrar un camino de comunicación desde un puerto de entrada libre hasta un puerto de salida libre.

La red no bloqueante es la red en la que siempre existe un camino para conectar cualquier puerto de entrada y salida. Las redes no bloqueantes se crean añadiendo una etapa de conmutación adicional.

La red no bloqueante rearrangeable es la red en la que se pueden reorganizar todos los posibles caminos para conectar todos los puertos de entrada y salida.

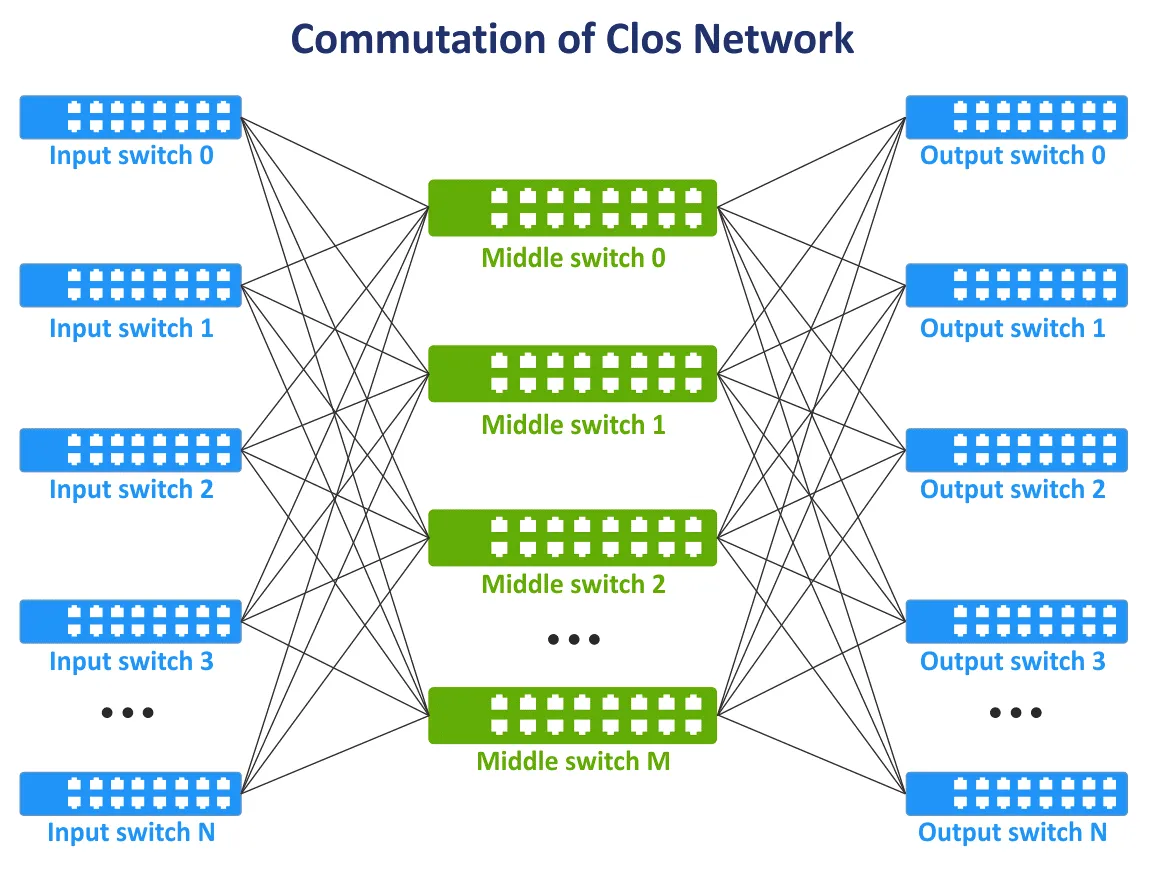

A finales de la década de 1990, con la evolución de las tecnologías de telecomunicaciones y las redes informáticas, el concepto de redes Clos volvió a ser relevante. Existe la necesidad de que todos los nodos se comuniquen entre sí en la estructura de red y, si es posible, no utilizar la topología de malla completa cuando todos los dispositivos están interconectados. Se agregó una nueva capa de comunicación para interconectar dispositivos de red. Como resultado, el concepto de red Clos fue revivido en una nueva encarnación. En la siguiente imagen, se puede ver un esquema típico de la red Clos de tres capas.

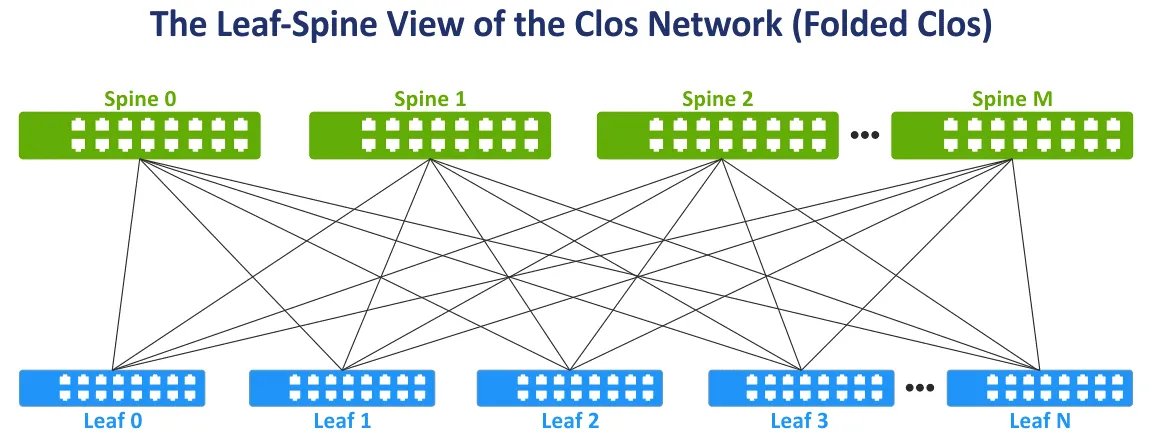

Modifiquemos la vista de la red Clos a la vista ampliamente utilizada de hoja-columna para mayor comodidad, plegando los lados izquierdo y derecho del esquema. Esta topología de red se conoce como vista de Hoja-Columna, Clos Plegado y red Clos de 3 etapas (ver la siguiente imagen).

La capa de columna vertebral. Los conmutadores de columna vertebral se utilizan para interconectar todos los conmutadores de hojas en la topología de red de malla completa. La capa de columna vertebral reemplaza, en cierto grado, la capa de agregación utilizada en la topología de red jerárquica tradicional de tres niveles. Pero la capa de columna vertebral no es un equivalente directo de la capa de agregación. La tarea principal de la capa de columna vertebral es la transferencia rápida de datos de una hoja a otra. Los dispositivos de punto final no están conectados a los conmutadores de columna vertebral.

La capa de hojas. En este modelo, los servidores u otros dispositivos de punto final en el centro de datos están conectados a las hojas. Todas las hojas están conectadas a todas las columnas vertebrales. Como resultado, hay un alto número de conexiones de red con ancho de banda igual entre todos los servidores. Hay conexiones L3 entre las columnas vertebrales y las hojas (L3 en el modelo OSI).

Cuando el tráfico se transmite desde la fuente hasta el destino en la red, el número de saltos es el mismo (por ejemplo, se necesitan tres saltos para transferir datos entre cualquier servidor dentro de la red de hoja-espina de dos niveles en el siguiente esquema). La latencia es predecible y baja. La capacidad de la red también se incrementa porque ahora no es necesario utilizar STP. Cuando se utiliza STP para conexiones redundantes entre switches, solo puede estar activo un enlace a la vez.

En la topología de red de hoja-espina, se puede utilizar el protocolo de enrutamiento de Multipath de costo igual (ECMP) para equilibrar la carga del tráfico y evitar bucles en la red (para conexiones de red L3). También se pueden utilizar los protocolos BGP, OSPF, EIGRP, ISIS.

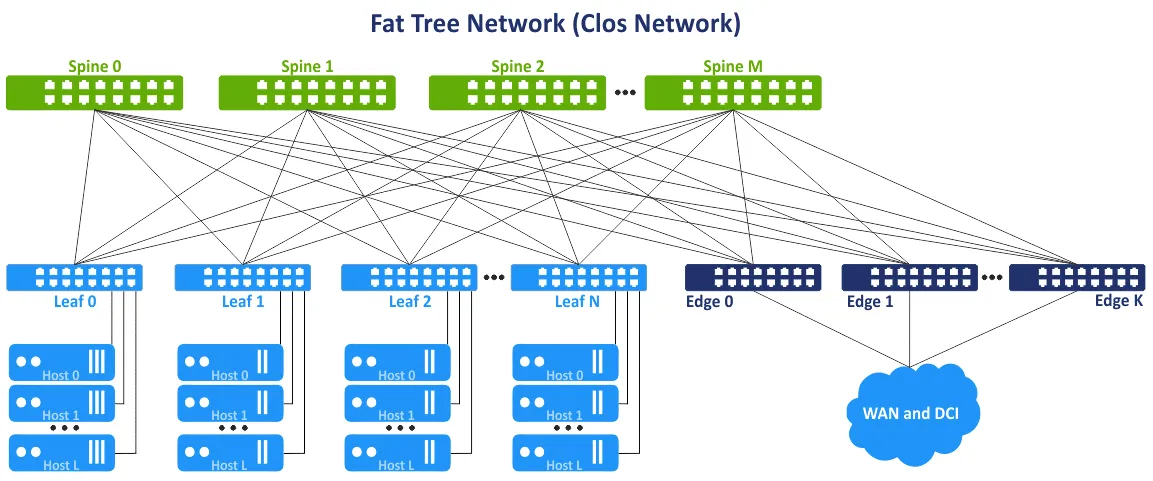

Este concepto de red también se conoce como la topología de red de árbol gordo de múltiples capas. La idea es evitar cuellos de botella en las capas superiores del árbol (cerca de la raíz del árbol) y agregar enlaces adicionales para aumentar el ancho de banda en estos segmentos. Como resultado, hay una capacidad de enlace en crecimiento hacia la raíz. El árbol gordo es un caso especial de la red Clos. La red Clos de tres niveles se transforma en una red de hoja-espina de dos niveles después de plegarse. Los switches de hoja o los switches/enrutadores de borde de hoja se pueden utilizar para acceder a redes externas y otros centros de datos.

Ventajas de la topología de red de hoja-espina

La topología de red de hoja-espina ofrece un conjunto de ventajas sobre la topología de red de acceso-agregación-núcleo. Este conjunto de ventajas es la razón para utilizar el tipo de topología de red de hoja-espina en un centro de datos.

Conexiones optimizadas. Los enlaces con alto ancho de banda entre dispositivos de red son óptimos para el tráfico este-oeste. No hay enlaces no utilizados (ya que se utiliza L3 en lugar de L2). Se recomienda ECMP para una alta eficiencia, y STP no es necesario.

Fiabilidad. La falla de un dispositivo o la desconexión de un enlace no causa resultados negativos significativos y desventajas. Si falla el interruptor ToR que actúa como interruptor de hoja, se ve afectado el bastidor correspondiente. Si falla un interruptor de columna vertebral, la capacidad de ancho de banda de la red se degrada, pero no significativamente en comparación con la topología de red jerárquica tradicional de 3 niveles. La degradación del ancho de banda para la topología de columna vertebral-hoja es 1/n, donde n es el número de columnas vertebrales. La degradación del ancho de banda para la topología jerárquica es del 50% en este caso.

Alta escalabilidad. Puede agregar nuevas hojas hasta que tenga puertos libres en las columnas vertebrales. Agregar nuevas columnas vertebrales le permite aumentar los enlaces ascendentes de las hojas. Agregue interruptores/enrutadores de borde para aumentar el ancho de banda a las redes externas. El enfoque tradicional para aumentar el ancho de banda y conectar más servidores para la topología de red jerárquica de tres capas es agregar más tarjetas de red con más puertos, equipos de red con interfaces de red más rápidas y hardware más potente en general. Este enfoque tradicional se llama escalar hacia arriba o escalabilidad vertical.

Cuando se utiliza la topología de red hoja-columna en centros de datos y para redes MSP, puede agregar una capa adicional de columnas vertebrales. Este enfoque se llama escalabilidad horizontal o escalado hacia afuera. Agregar un dispositivo de red típico como un interruptor/enrutador aumenta la escalabilidad de manera lineal.

Mantenimiento. Puede desconectar fácilmente las espinas de la red para mantenimiento o reemplazo. Las tareas de mantenimiento en la espina no son riesgosas en comparación con las cajas centrales porque no hay funcionalidad de inteligencia en las espinas, y la reducción de ancho de banda es mínima después de desconectar.

Red de Clos de Múltiples Niveles

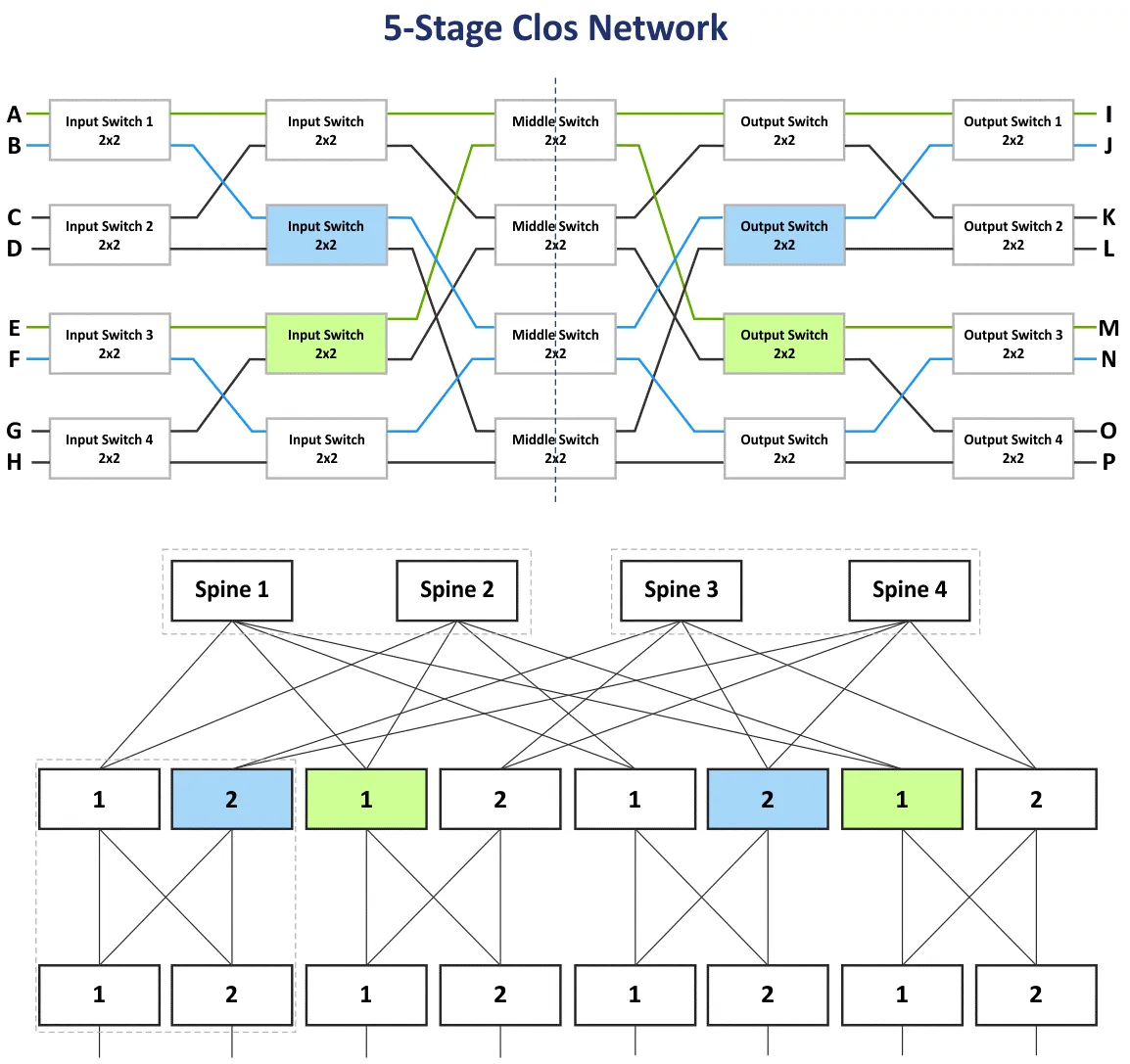

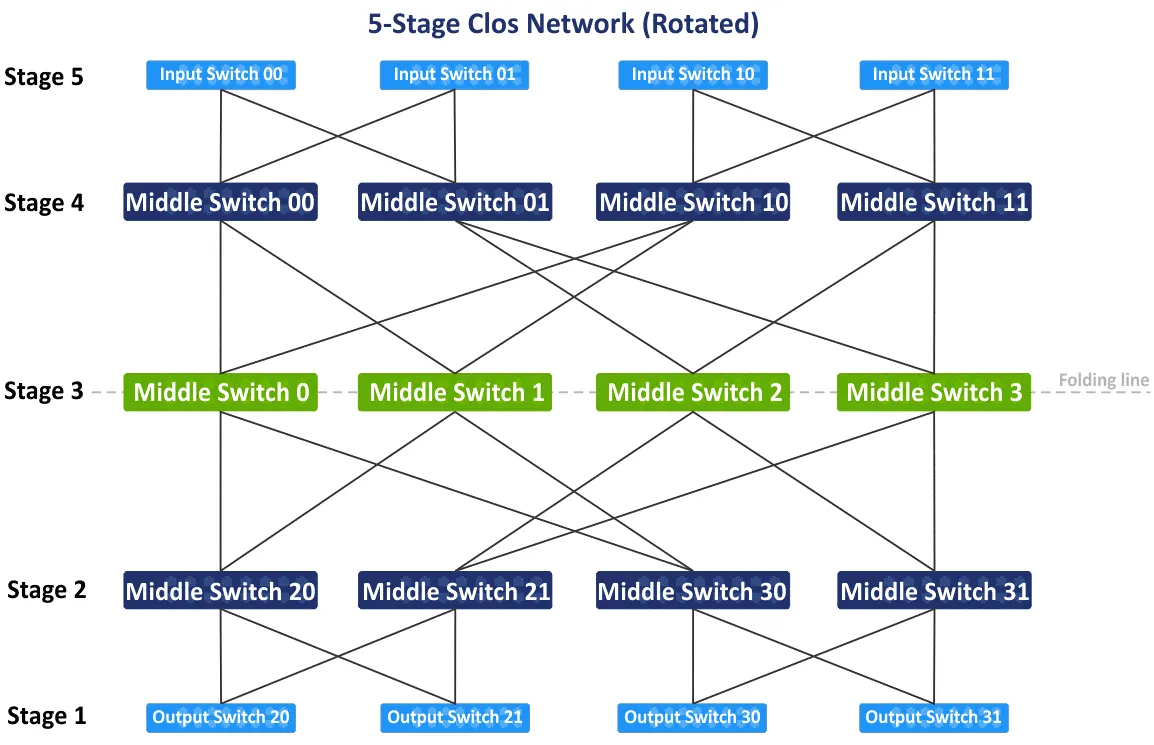

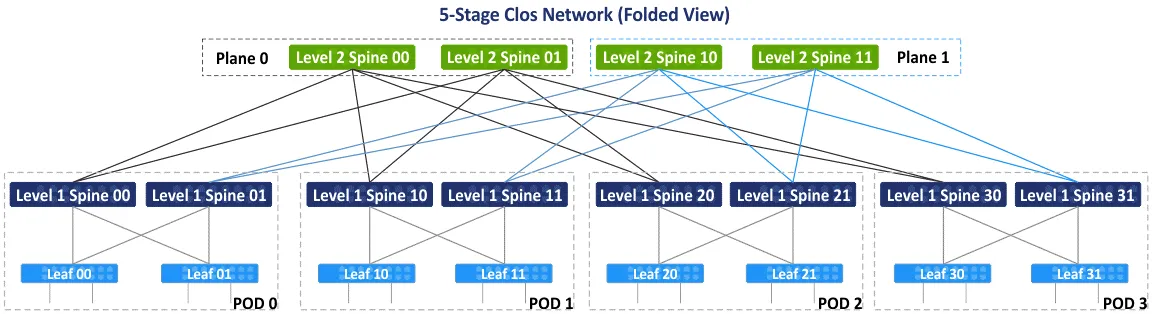

En la sección anterior, expliqué la red de Clos de tres etapas con las etapas: Interruptor de Entrada, Interruptor Medio y Interruptor de Salida. Como los dispositivos en las etapas de entrada y salida se utilizan para recibir/enviar datos, el esquema de la red se puede plegar utilizando una línea media que consiste en una topología de red de hoja-espinazo de dos niveles. Puede agregar más etapas y construir la red de Clos de múltiples niveles para conectar más dispositivos de red a esta red. En este caso, tiene cinco etapas: Interruptor de Entrada, Interruptor Medio 1, Interruptor Medio 2, Interruptor Medio 3, Interruptor de Salida.

En el siguiente diagrama, puede ver el esquema inicial de la red de Clos de cinco etapas no bloqueante después de la reorganización de los bloques azules y verdes. También está la vista plegada hoja-espinazo o la vista de árbol gordo (4,3) (porque hay 4 interruptores de espina y 3 etapas en el esquema de hoja-espinazo), pero veamos cómo conectar dispositivos en la red de Clos de 5 etapas paso a paso. Un tipo de topología de red de Clos con más de 5 etapas no es común y no se utiliza en la práctica porque el número de conexiones es demasiado grande.

Después de rotar el esquema inicial de la red de Clos de cinco etapas 90 grados en sentido horario, tendrás la vista tradicional con interruptores de entrada, interruptores de salida y tres etapas de los interruptores intermedios. Vamos a trazar la línea de plegado a través de los interruptores intermedios en el centro del esquema para hacer la vista plegada de la red de Clos de cinco etapas.

Después de plegar el esquema, obtienes la vista plegada o la vista hoja-tallo de este tipo de topologías de red (ver el siguiente esquema). Hay 4 grupos individuales que actúan como puntos de entrega (POD, por sus siglas en inglés). El POD es la unidad universal para construir centros de datos. Los POD están conectados a las espinas del primer nivel. Si necesitas ampliar tu centro de datos o agregar más servidores/equipos de red, entonces agrega nuevos POD y conéctalos a la estructura de red. Las espinas de un POD están conectadas a las espinas de otros POD a través de espinas de segundo nivel. Al mismo tiempo, no todas las espinas L1 están conectadas a todas las espinas L2, y están divididas por planos.

Hay dos planos: Plano 0 y Plano 1 en el siguiente esquema. Este concepto se utiliza debido al número limitado de puertos en las espinas, y crear una topología de red completamente conectada no es posible en este caso. En el siguiente esquema, cada espina tiene un límite de 4 puertos. Según la idea principal, la red de Clos no bloqueante se basa en los mismos elementos (interruptores de 4 puertos, como se ve a continuación).

A primera vista, puedes confundirte con términos como Clos, Clos plegado, hoja-tallo y árbol gordo. Permíteme aclarar estos términos.

Clos o Red de Clos es el término que cubre la base teórica del tipo de topología de red de Clos.

La Red Plegada Clos es una representación más conveniente de la red Clos, donde las entradas y salidas tienen el mismo rol y están ubicadas en el mismo lugar.

Leaf-spine es una topología de red basada en el esquema de red Clos que se utiliza en la práctica en centros de datos para construir redes, incluidas las redes MSP.

Árbol gordo suele ser referido como una variación de la red Clos. Este término es el más confuso porque algunos artículos mencionan al árbol gordo como la red clásica de acceso-agregación-núcleo. Me refiero al documento RFC 7938 que dice que el árbol gordo se basa en la topología de red plegada Clos.

Cálculos

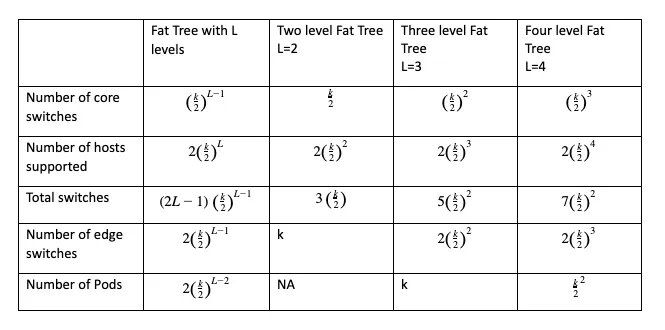

Puedes calcular el número de switches centrales, switches de borde, switches totales necesarios y el número total de hosts que pueden conectarse a la red de la configuración seleccionada mediante fórmulas donde:

k is the number of ports in the switch

L is the number of levels in the leaf-spine (fat tree) network topology

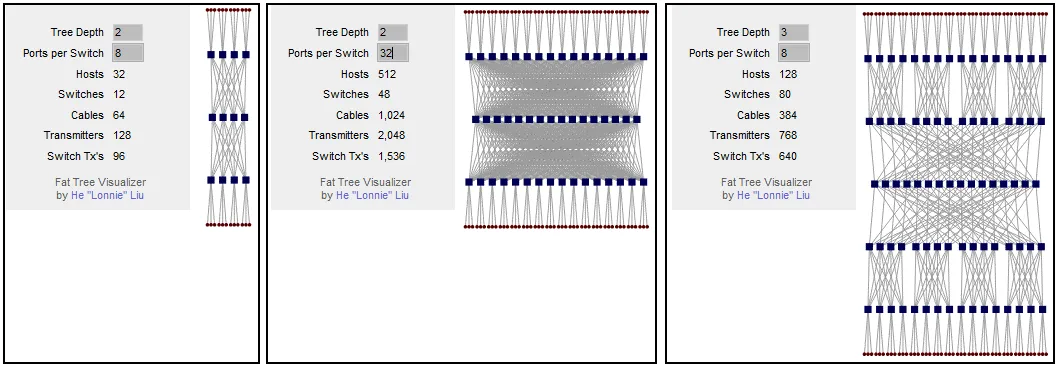

El parámetro principal a calcular antes de construir tu red es el número de hosts admitidos. La configuración de árbol gordo se puede escribir como FT(k, L). Por ejemplo, FT(32,3) es una red de árbol gordo de tres niveles con switches de 32 puertos. Puedes usar esta calculadora gratuita para redes Clos que también genera el esquema de visualización para la configuración seleccionada.

Puedes calcular que si tu esquema de red de árbol gordo tiene 2 niveles y 8 puertos por switch, entonces puedes conectar 32 hosts a la red. Si aumentas el número de puertos por switch, el número de hosts soportados se incrementa a 512. Como puedes ver, el número de hosts conectados depende del número de puertos en cada switch. Si dejas el árbol gordo en 2 niveles (la red Clos de 3 etapas) y aumentas el número de puertos por switch, el número de espinas aumenta significativamente. Puedes resolver este problema agregando un nivel más al árbol gordo. Para un árbol gordo de tres niveles, si el número de puertos por switch es 8, puedes conectar 128 hosts.

Si aumentas el número de puertos por switch a 32, puedes conectar 8192 hosts utilizando esta topología de red. Este número para la red Clos de 5 etapas es 16 veces más que para la red Clos de 3 etapas. Ten en cuenta las limitaciones del rack del servidor cuando planees el esquema de instalación de servidores y equipos de red en el centro de datos.

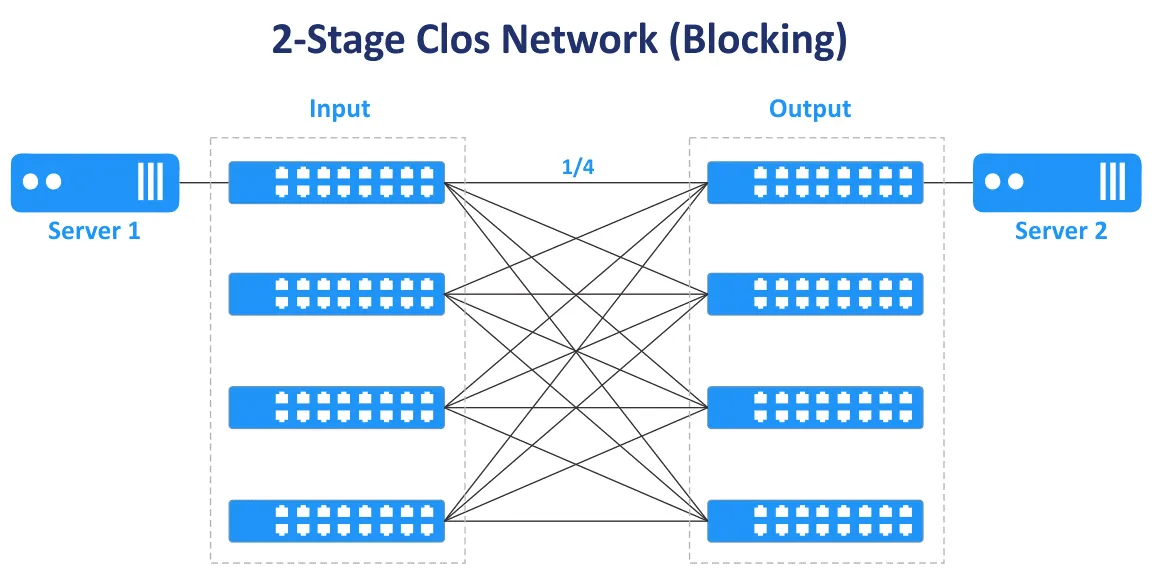

Los números impares de etapas se usan para construir redes Clos sin bloqueo (3, 5, 7, etc.). La red Clos de 2 etapas no proporciona conectividad sin bloqueo y múltiples conexiones entre switches.

En el siguiente diagrama, puedes ver que en el caso de la red Clos de dos etapas, solo hay un camino de transmisión para conectar el Servidor 1 y el Servidor 2. Solo ¼ de los puertos están conectados, otros puertos no están conectados y te bloquean.

La relación de sobresuscripción es la relación entre el ancho de banda de entrada y el ancho de banda de salida en la dirección de capas inferiores a capas superiores. La relación de sobresuscripción generalmente varía de 2 a 4.

Un switch tiene 48 puertos de 10-Gbit y 4 puertos de enlace ascendente de 40-Gbit. La velocidad total de los enlaces descendentes a los servidores es de 48×10=480 Gbit/s. La velocidad total de los enlaces ascendentes es de 4×40=160 Gbit/s. La relación de sobresuscripción es de 480/160=4.

Si la velocidad total de ancho de banda es igual para todos los puertos de enlace descendente y de enlace ascendente del switch, el switch no está sobresuscrito y no hay cuellos de botella en este caso. Una relación de sobresuscripción de 1:1 es el caso ideal. Estima el tráfico en diferentes direcciones antes de comprar switches con la velocidad y el número de puertos adecuados.

Los switches que tienen una relación de sobresuscripción superior a 1 se utilizan a menudo en la etapa de hoja en redes de topología de red hoja-tallo. Se deben utilizar switches no sobresuscritos en la etapa de tallo. Los switches en el nivel de hoja en el tipo de topología de red hoja-tallo suelen usarse como switches ToR. Sin embargo, es posible instalar switches de hoja como switches de fin de fila.

Diferencias esenciales

Cuando se crea una red, algunas decisiones afectan el diseño de la red. Aquí hay algunas decisiones de “o bien-o bien” que afectan el funcionamiento de la red.

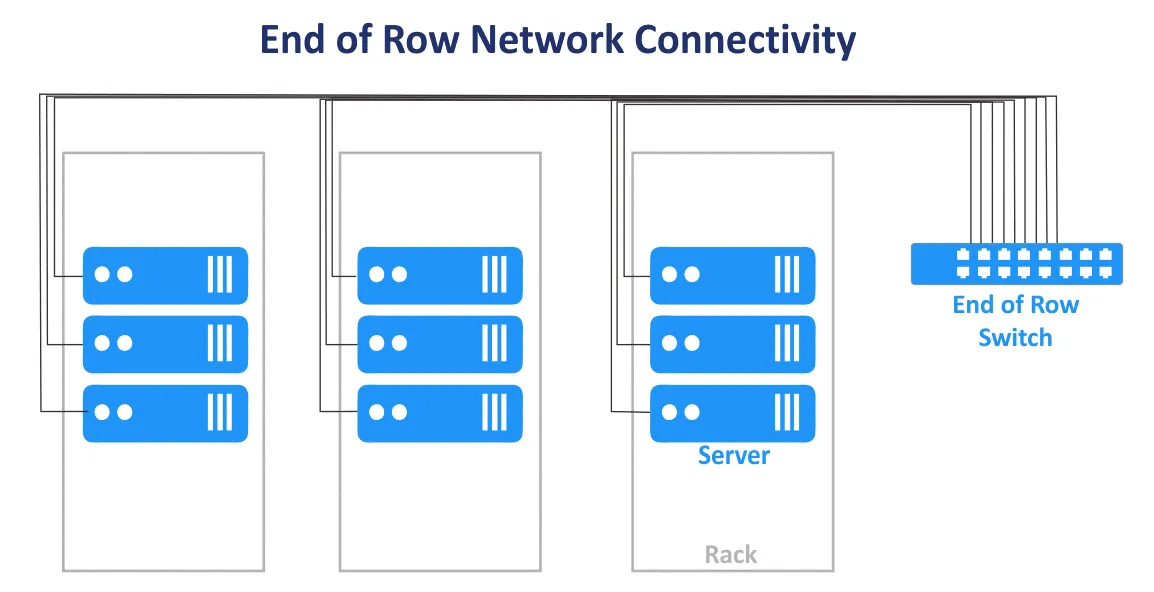

Top of Rack vs End of Row

El esquema de conexión de red Top of Rack (ToR) en un centro de datos es donde se instala uno o varios switches en cada rack. Se utilizan cables de parche cortos para conectar el switch en la parte superior del rack con otro equipo de red y servidores dentro del rack. Los switches ToR generalmente tienen enlaces de alta velocidad a los switches/enrutadores de niveles superiores y pueden conectarse con cables de fibra óptica. La ventaja es que al utilizar este esquema de conexión para una red de MSP, no es necesario instalar un grueso montón de cables desde cada rack en el centro de datos. El uso de cables en el centro de datos es más racional al usar el esquema ToR. En este caso, se gasta menos en cableado y se tiene un mejor manejo de cables. Se puede gestionar cada rack como un módulo único sin afectar a otros racks dentro de un centro de datos porque solo los servidores en un rack se ven afectados. A pesar del nombre del esquema, se puede montar un switch en el medio o en la parte inferior de cada rack.

El esquema de conexión de red End of Row (EoR) es cuando un rack de servidores al final de la fila contiene equipo de red. El equipo incluye un switch de red común para conectar todos los servidores y otros dispositivos de todos los racks de servidores en la fila. Los cables del equipo de red instalado en el rack de servidores EoR se conectan a dispositivos en todos los racks de la fila utilizando paneles de parcheo montados en cada rack. Como resultado, se utilizan cables largos para conectar todos los dispositivos de red en una fila. Si se utilizan conexiones de red redundantes, también aumenta el número de cables. Gruesos montones de cables pueden bloquear el acceso de aire al equipo.

Los bastidores del servidor suelen estar ubicados como filas uno al lado del otro en un centro de datos. Una fila puede contener 10 o 12 bastidores, por ejemplo. Toda la fila se considera una unidad de gestión única al usar el esquema de conexión EoR para la red MSP en un centro de datos. En este caso, se utiliza el modelo de gestión por fila. Se necesitan menos conmutadores individuales en el modelo de conexión de red EoR. La flexibilidad es menor cuando se necesita realizar mantenimiento o actualizar conmutadores porque más dispositivos se ven afectados cuando se desconecta un conmutador EoR. A pesar de su nombre, un bastidor con un conmutador común (conmutadores) puede colocarse en el medio de la fila.

Conexión de Capa 2 vs Capa 3

Decidir sobre las conexiones dentro de una red es un cálculo que implica confiabilidad, velocidad y gasto, así como la topología que se está creando.

Por ejemplo, hay segmentos de red para la topología de red de tres capas Acceso-Agregación-Núcleo y la topología de Hoja-Espina. Allí, el tráfico se transfiere en el modelo OSI L2 y L3. En la jerárquica red de tres capas, la capa de acceso opera en L2, la capa de distribución/agregación agrupa los enlaces L2 y proporciona enrutamiento L3, la capa de red central realiza enrutamiento en la tercera capa del modelo OSI. La red de la topología de Hoja-Espina de varios niveles se puede configurar utilizando L2 con VLAN y L3 con enrutamiento IP y subredes.

El equipo de red L2 es más asequible que el equipo de red L3, pero hay algunas desventajas al usar la red L2 para conectar dispositivos de red en la red MSP de un centro de datos. VLAN se usa generalmente para aislar lógicamente las redes que utilizan el mismo entorno físico. El número máximo de VLAN es 4095 (menos algunas VLAN reservadas como 0, 4095, 1002-1005).

Otra desventaja, como se mencionó anteriormente, es la incapacidad de utilizar enlaces redundantes cuando se utiliza STP en L2. Esto se debe a que solo un enlace puede estar activo al mismo tiempo y no se utiliza todo el ancho de banda disponible de todos los enlaces. Entonces, cuando el dominio L2 con STP es grande, aumenta la probabilidad de problemas causados por cableado incorrecto y errores humanos, y la resolución de problemas se vuelve difícil.

Una configuración de red L3 permite a los ingenieros mejorar la estabilidad y escalabilidad de la red MSP y las redes de centros de datos en general.

Los siguientes protocolos de red te ayudan a administrar la red L3 y dirigir el tráfico.

BGP (Protocolo de Puerta de Enlace de Borde) es un protocolo de enrutamiento dinámico ampliamente utilizado y considerado el estándar en muchas organizaciones con centros de datos a gran escala. BGP es un protocolo altamente escalable, extensible y eficiente.

ECMP (Enrutamiento de Múltiples Rutas con Costos Iguales) es una tecnología de enrutamiento de red utilizada para distribuir el tráfico utilizando múltiples mejores rutas definidas por métricas en la tercera capa del modelo OSI. ECMP con protocolos de enrutamiento se utiliza para el equilibrio de carga en redes grandes. La mayoría de los protocolos de enrutamiento, incluidos BGP, EIGRP, IS-IS, OSPF, admiten la tecnología ECMP.

Siempre intenta utilizar los protocolos de red más progresivos. Pero recuerda que cuanto menos protocolos se utilicen en la red, más conveniente será la administración de la red.

Topología de Red para NV y SDN

Además de la virtualización de hardware y el uso de máquinas virtuales, la virtualización de redes con un enfoque centrado en la aplicación también se ha vuelto popular. Las soluciones de Virtualización de Red (VR), como VMware NSX, la red OpenStack y Cisco ASI, utilizan intensivamente el tráfico este-oeste en la red física, y una topología de red hoja-espina es adecuada para soluciones de virtualización de redes por esta razón. Lea la publicación del blog sobre VMware NSX para obtener más información sobre la virtualización de redes.

La red definida por software (SDN) se utiliza para virtualizar redes para un uso eficaz de los recursos, flexibilidad y administración centralizada. Esta es una solución óptima en un centro de datos virtualizado donde se utilizan máquinas virtuales conectadas a la red. Las máquinas virtuales pueden migrar entre servidores, creando así tráfico este-oeste dentro del centro de datos. SDN se utiliza ampliamente para redes de MSP por los MSP que proporcionan IaaS (infraestructura como servicio).

Configurar redes definidas por software es efectivo cuando se utiliza la topología de red hoja-espina subyacente con enrutamiento dinámico, un número fijo de saltos, baja latencia predecible y optimización de tráfico este-oeste para la comunicación de servidor a servidor en un centro de datos.

VXLAN

VXLAN (Virtual eXtensible Local Area Network) es un protocolo de red mejorado utilizado en lugar de VLAN en redes superpuestas. Se crean túneles L2 utilizando las redes subyacentes L3 (infraestructura de red L3) para proporcionar conectividad de red L2 sin las limitaciones tradicionales de VLAN. Con VXLAN, puedes configurar la red L2 sobre la red L3. La topología virtual puede ser diferente de la topología de red física de la red subyacente.

Los marcos VXLAN se encapsulan en paquetes IP utilizando el esquema de encapsulación MAC-en-UDP. VNI es el equivalente al ID de VLAN. El número máximo de VNI es 2^24, es decir, alrededor de 16 millones. VXLAN se utiliza para crear redes L2 en entornos geográficamente ampliados, por ejemplo, cuando necesitas crear una red a través de dos centros de datos geográficamente distribuidos.

Utilizar VXLAN y virtualización de red ayuda a optimizar el tamaño de la tabla de direcciones MAC para los switches ToR. Esto se debe a que las direcciones MAC utilizadas por las MV y el tráfico L2 relacionado se transfieren a través de la red superpuesta L2 utilizando VXLAN. No sobrecargan las tablas MAC de los switches físicos. Las tablas de direcciones MAC de los switches físicos no superan la capacidad máxima de tabla disponible de los switches.

Conclusión

Tradicionalmente, las redes en los centros de datos se construían utilizando la clásica topología de tres capas de acceso-agregación-núcleo. Dada la evolución de las aplicaciones modernas cliente-servidor y distribuidas, microservicios y otros softwares que son fuentes de tráfico este-oeste dentro de las redes de proveedores de servicios gestionados (MSP), la topología de red hoja-columna, basada en el concepto de red Clos, es preferida en los centros de datos modernos y es una de las topologías de red más comunes. La topología de red hoja-columna es la mejor topología de red para grandes centros de datos porque esta topología es altamente confiable y escalable. Antes de instalar una red en un centro de datos, realice los cálculos y estime el tráfico generado y las cargas de trabajo. Tenga en cuenta el tráfico de servicios como el tráfico de copia de seguridad y replicación en la red.

NAKIVO Backup & Replication es un potente software de copia de seguridad de máquinas virtuales que puede proteger las cargas de trabajo de VMware Cloud Director, VM de VMware, VM de Hyper-V, así como máquinas físicas Linux y Windows, y bases de datos de Oracle. Los proveedores de servicios gestionados que ofrecen infraestructura como servicio (IaaS), copia de seguridad como servicio (BaaS) y recuperación ante desastres como servicio (DRaaS) pueden utilizar NAKIVO Backup & Replication instalado en modo multiinquilino. Descargue la Prueba Gratuita de NAKIVO Backup & Replication para MSP que soporta el modo de instalación multiinquilino.

Source:

https://www.nakivo.com/blog/msp-network-topology-for-beginners/