Als ich anfing, Docker zu verwenden, wurde mir schnell klar, wie leistungsstark es ist. Stellen Sie sich vor, Sie richten Ihre Entwicklungsumgebung in Minuten statt Stunden ein oder führen Anwendungen über verschiedene Maschinen aus, ohne das klassische Problem „es funktioniert auf meinem Rechner“.

Docker vereinfacht, wie wir Anwendungen erstellen, versenden und ausführen, indem sie in leichte, tragbare Container verpackt werden. Egal, ob Sie Entwickler, Datenwissenschaftler oder Systemadministrator sind, das Beherrschen von Docker kann Ihnen Kopfschmerzen ersparen und Ihre Workflows effizienter gestalten.

In diesem Tutorial werde ich Sie durch die Grundlagen führen – Installation von Docker, Verständnis der Schlüsselkonzepte und Ausführen Ihrer ersten containerisierten Anwendung. Am Ende werden Sie nicht nur wissen, wie Docker funktioniert, sondern auch praktische Erfahrung im Umgang damit haben und somit ein solides Fundament für fortgeschrittenere Themen legen. Lassen Sie uns eintauchen!

Was ist Docker?

Docker ist eine Open-Source-Containerisierungsplattform, die die Bereitstellung von Anwendungen vereinfacht, indem Software und deren Abhängigkeiten in eine standardisierte Einheit namens Container verpackt werden. Im Gegensatz zu herkömmlichen virtuellen Maschinen teilen Docker-Container den Host-Betriebssystem-Kernel, was sie effizienter und leichtgewichtiger macht.

Container stellen sicher, dass eine Anwendung in Entwicklung, Test- und Produktionsumgebungen auf dieselbe Weise ausgeführt wird. Dies reduziert Kompatibilitätsprobleme und verbessert die Portabilität über verschiedene Plattformen hinweg. Aufgrund seiner Flexibilität und Skalierbarkeit ist Docker zu einem entscheidenden Werkzeug in modernen DevOps- und Cloud-nativen Entwicklungs-Workflows geworden.

Docker offizielles Logo.

Installation von Docker

Docker kann auf verschiedenen Betriebssystemen installiert werden, einschließlich Windows, macOS und Linux. Während die Kernfunktionalität auf allen Plattformen gleich bleibt, unterscheidet sich der Installationsprozess je nach System leicht. Im Folgenden finden Sie schrittweise Anleitungen zur Installation von Docker auf Ihrem bevorzugten Betriebssystem.

Installation von Docker unter Windows

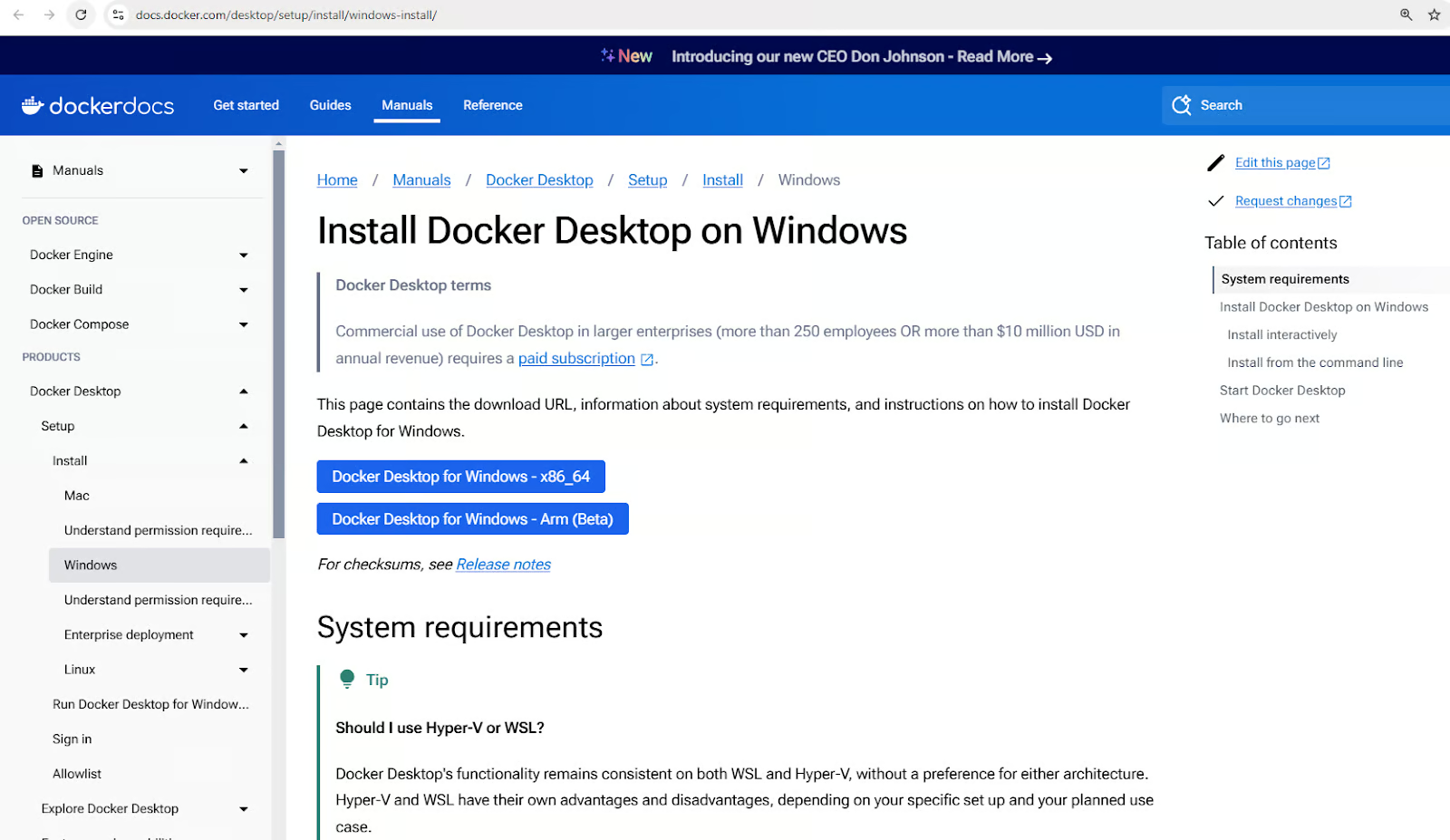

- Laden Sie Docker Desktop für Windows herunter.

Laden Sie den Docker Desktop Installer für Windows herunter

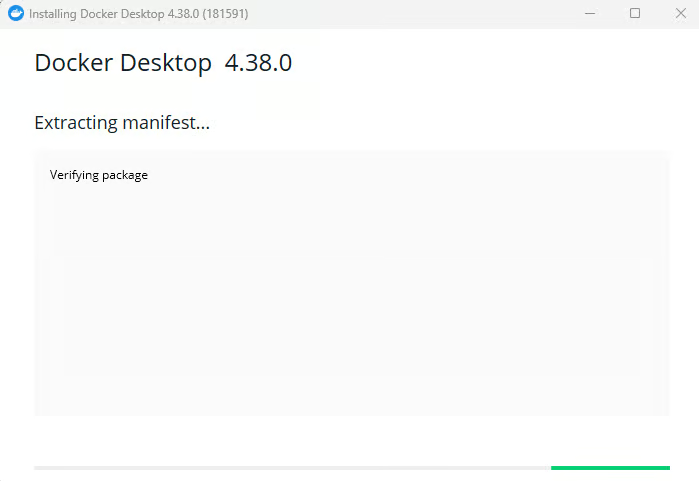

- Führen Sie den Installer aus und befolgen Sie die Einrichtungsanweisungen.

Installation von Docker Desktop für Windows

- Aktivieren Sie die WSL 2-Integration, wenn Sie dazu aufgefordert werden.

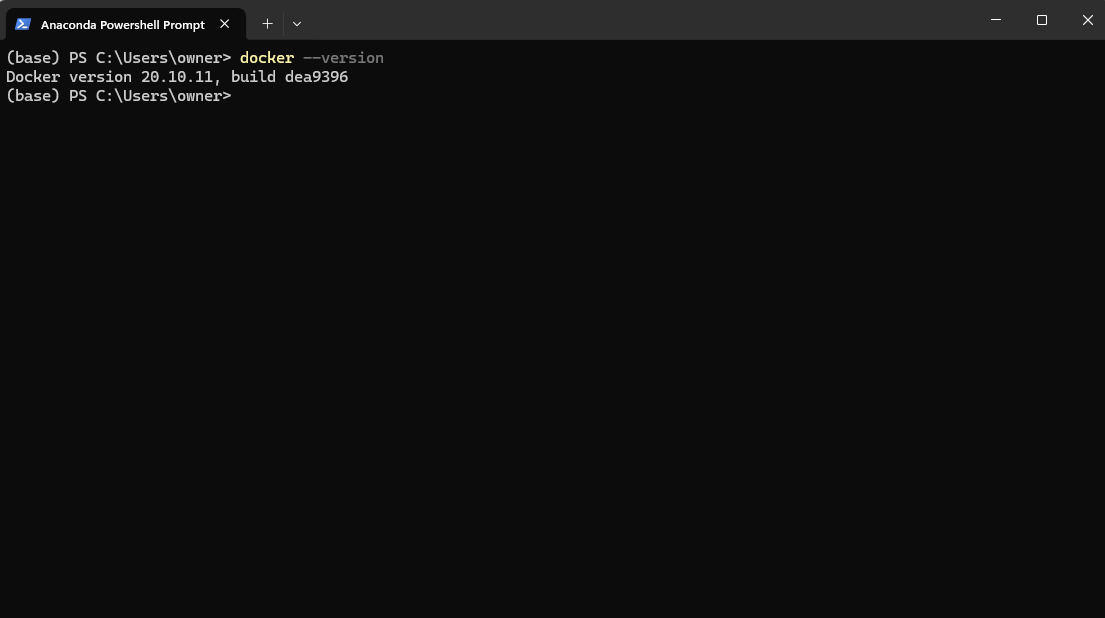

- Überprüfen Sie die Installation, indem Sie

docker –versionin PowerShell ausführen.

Überprüfung der Docker-Version nach der Installation über PowerShell

5. Starten Sie die Docker Desktop-App über das Ausführen-Menü.

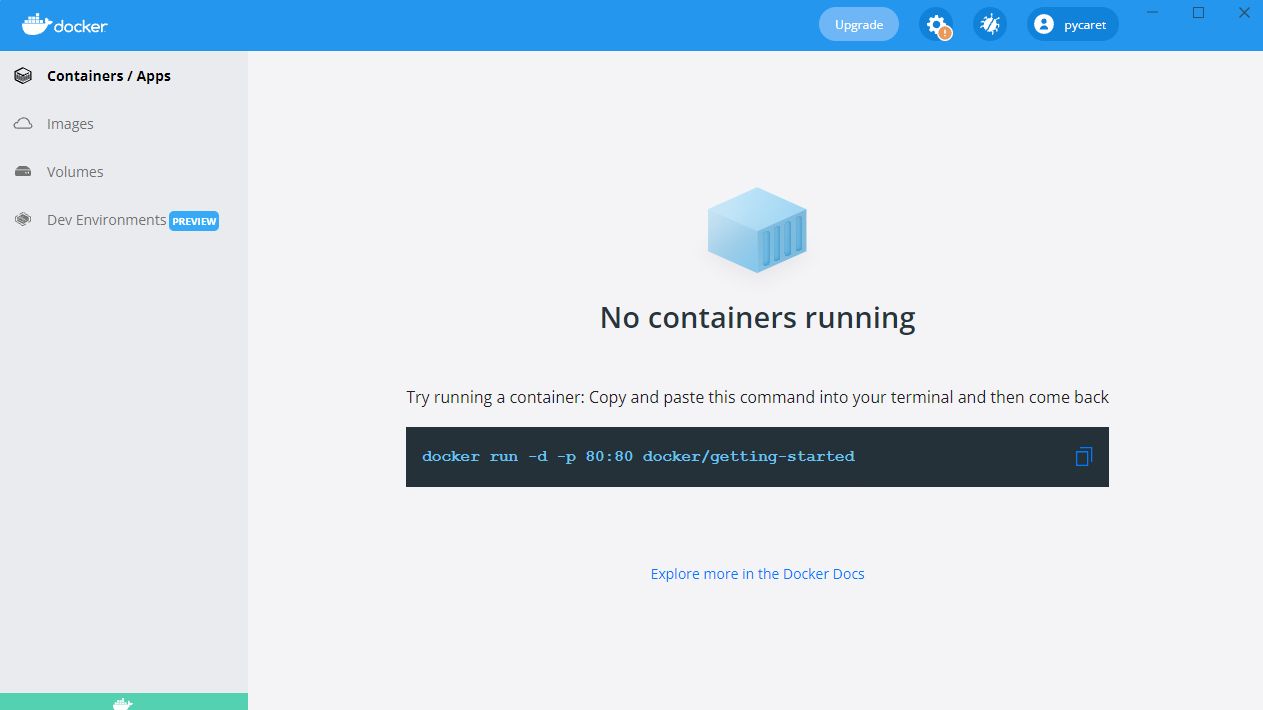

Starten der Docker Desktop-Anwendung unter Windows

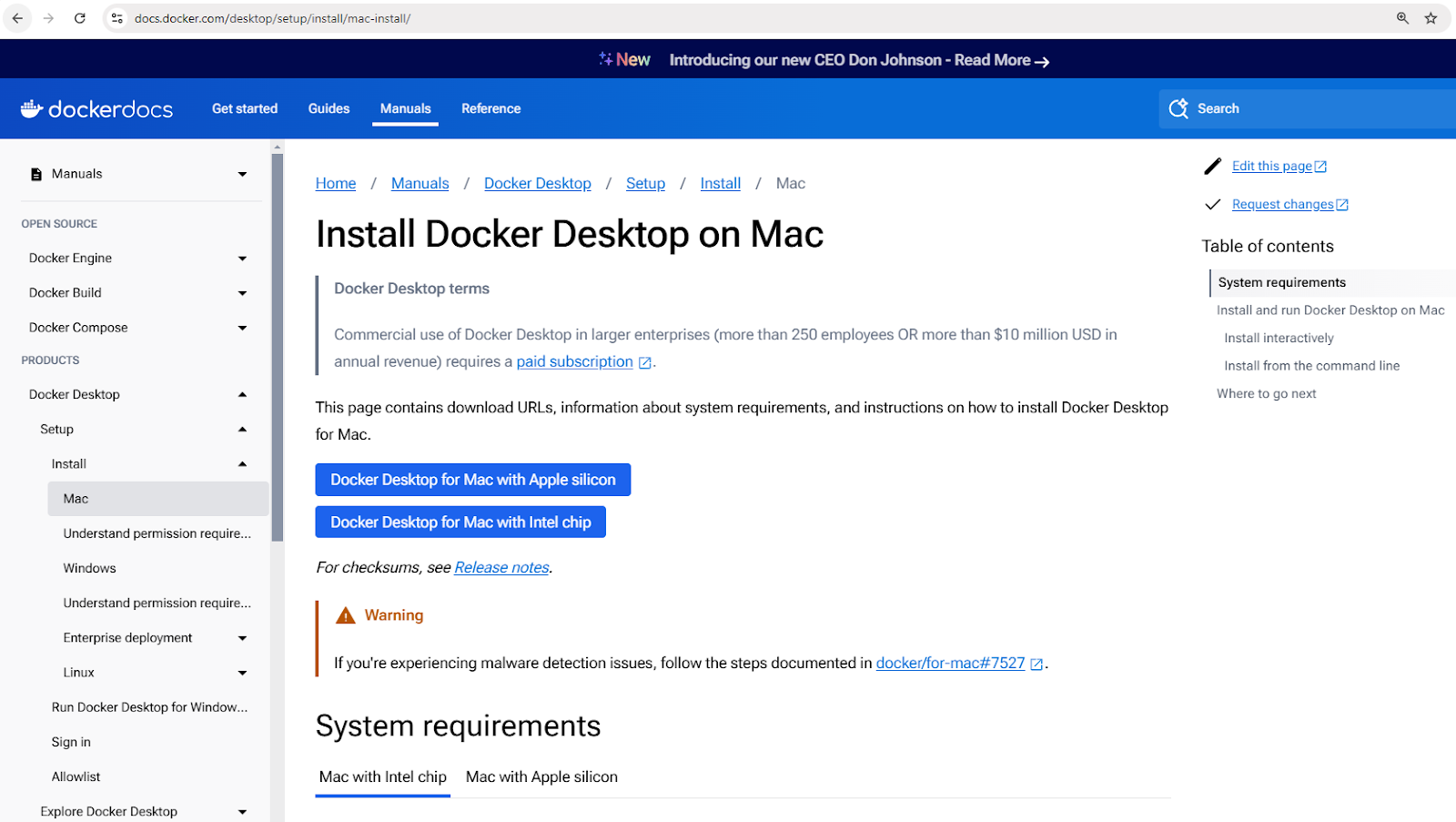

Installation von Docker auf macOS

- Laden Sie Docker Desktop für Mac herunter.

Laden Sie den Docker Desktop-Installer für Mac herunter

- Öffnen Sie die heruntergeladene

.dmgDatei und ziehen Sie Docker in den Programme-Ordner. - Starten Sie Docker und schließen Sie die Einrichtung ab.

- Überprüfen Sie die Installation mit

docker –versionim Terminal.

Installation von Docker unter Linux (Ubuntu)

- Aktualisieren Sie die Paketlisten:

sudo apt update - Installieren Sie Abhängigkeiten:

sudo apt install apt-transport-https ca-certificates curl software-properties-common - Fügen Sie den offiziellen GPG-Schlüssel von Docker hinzu:

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add - - Fügen Sie das Repository von Docker hinzu:

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" - Installieren Sie Docker:

sudo apt install docker-ce - Überprüfen Sie die Installation:

docker –version

Grundlegende Docker-Konzepte

Jetzt, da Docker installiert ist, möchten Sie vielleicht sofort loslegen und Container ausführen. Bevor wir das tun, ist es jedoch wichtig, einige Schlüsselkonzepte zu verstehen, die die Grundlage für die Arbeit von Docker bilden. Diese Konzepte helfen Ihnen, Docker effektiver zu nutzen und häufige Anfängerfehler zu vermeiden.

Im Herzen von Docker stehen Images, die als Blaupausen für Container dienen; Container, die die laufenden Instanzen dieser Images sind; und Docker Hub, ein zentrales Repository zum Teilen und Verwalten von Images.

Lasst uns jedes dieser Konzepte im Detail erkunden.

Docker-Images

Docker-Images sind die grundlegenden Bausteine von Containern. Sie sind unveränderlich, schreibgeschützte Vorlagen, die alles enthalten, was benötigt wird, um eine Anwendung auszuführen, einschließlich des Betriebssystems, des Anwendungscodes, der Laufzeit und der Abhängigkeiten.

Images werden mit einer Dockerfile erstellt, die die Anweisungen zum Erstellen eines Images Schicht für Schicht definiert.

Images können in Container-Registries wie Docker Hub gespeichert und abgerufen werden.

Hier sind einige Beispielbefehle für die Arbeit mit Images:

docker pull nginx: Laden Sie das neueste Nginx-Image von Docker Hub herunter.docker images: Listet alle verfügbaren Images auf der lokalen Maschine auf.docker rmi nginx: Entfernt ein Image von der lokalen Maschine.

Docker-Container

Ein Docker-Container ist eine laufende Instanz eines Docker-Images. Container bieten eine isolierte Laufzeitumgebung, in der Anwendungen ohne gegenseitige Beeinflussung oder Beeinträchtigung des Host-Systems ausgeführt werden können. Jeder Container hat sein eigenes Dateisystem, Netzwerk und Prozessraum, teilt sich jedoch den Host-Kernel.

Container folgen einem einfachen Lebenszyklus, der Erstellung, Starten, Stoppen und Löschung umfasst. Hier ist eine Aufschlüsselung gängiger Containerverwaltungsbefehle:

- Erstellen eines Containers:

docker createoderdocker run - Starten eines Containers:

docker start - Stoppen eines Containers:

docker stop - Neustarten eines Containers:

docker restart - Löschen eines Containers:

docker rm

Lassen Sie uns ein praktisches Beispiel sehen. Der folgende Befehl führt einen Nginx-Container im Hintergrund aus, wobei der Port 80 im Container auf Port 8080 auf dem Hostrechner abgebildet wird:

docker run -d -p 8080:80 nginx

Nach Ausführen dieses Befehls wird Docker das Nginx-Image abrufen (falls nicht bereits verfügbar), einen Container erstellen und starten.

Um alle laufenden und gestoppten Container zu überprüfen:

docker ps -a

Dies zeigt eine Liste aller Container und Details wie ihren Status und zugeordneten Ports.

Docker Hub

Docker Hub ist ein Cloud-basierter Registrierungsdienst zum Finden, Speichern und Verteilen von Container-Images. Benutzer können benutzerdefinierte Images in Docker Hub hochladen und sie öffentlich oder privat freigeben.

Hier sind einige Befehle zum Interagieren mit Docker Hub:

docker login: Authentifizieren Sie sich bei Docker Hub.docker push my-image: Laden Sie ein benutzerdefiniertes Image in Docker Hub hoch.docker search ubuntu: Suchen Sie nach offiziellen und Community-Images.docker pull ubuntu: Laden Sie ein Ubuntu-Image von Docker Hub herunter.

Neu in der Containerisierung? Erhalten Sie eine solide Grundlage mit dem Kurs Containerisierungs- und Virtualisierungskonzepte.

Ihren ersten Docker-Container ausführen

Jetzt, da wir die Kernkonzepte von Docker behandelt haben, ist es an der Zeit, sie in die Praxis umzusetzen! Lassen Sie uns damit beginnen, unseren ersten Container auszuführen, um sicherzustellen, dass Docker korrekt installiert ist und wie erwartet funktioniert.

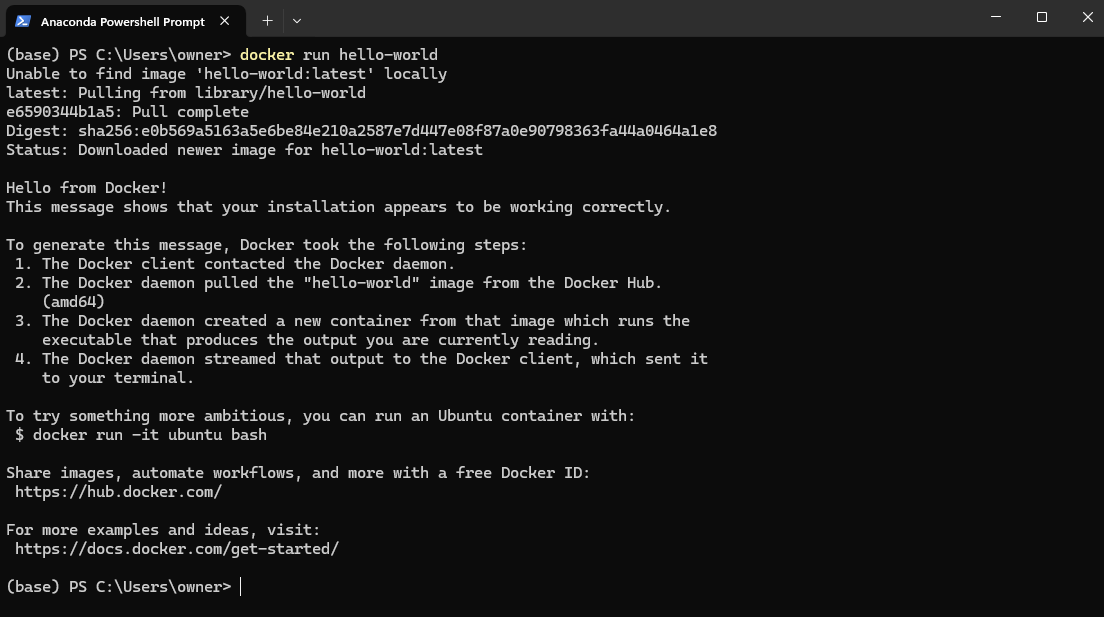

Um Ihre Docker-Installation zu testen, öffnen Sie PowerShell (Windows) oder Terminal (Mac und Linux) und führen Sie aus:

docker run hello-world

Dies lädt das hello-world Image von DockerHub herunter und führt es in einem Container aus.

Docker hello-world Bildbeispiel

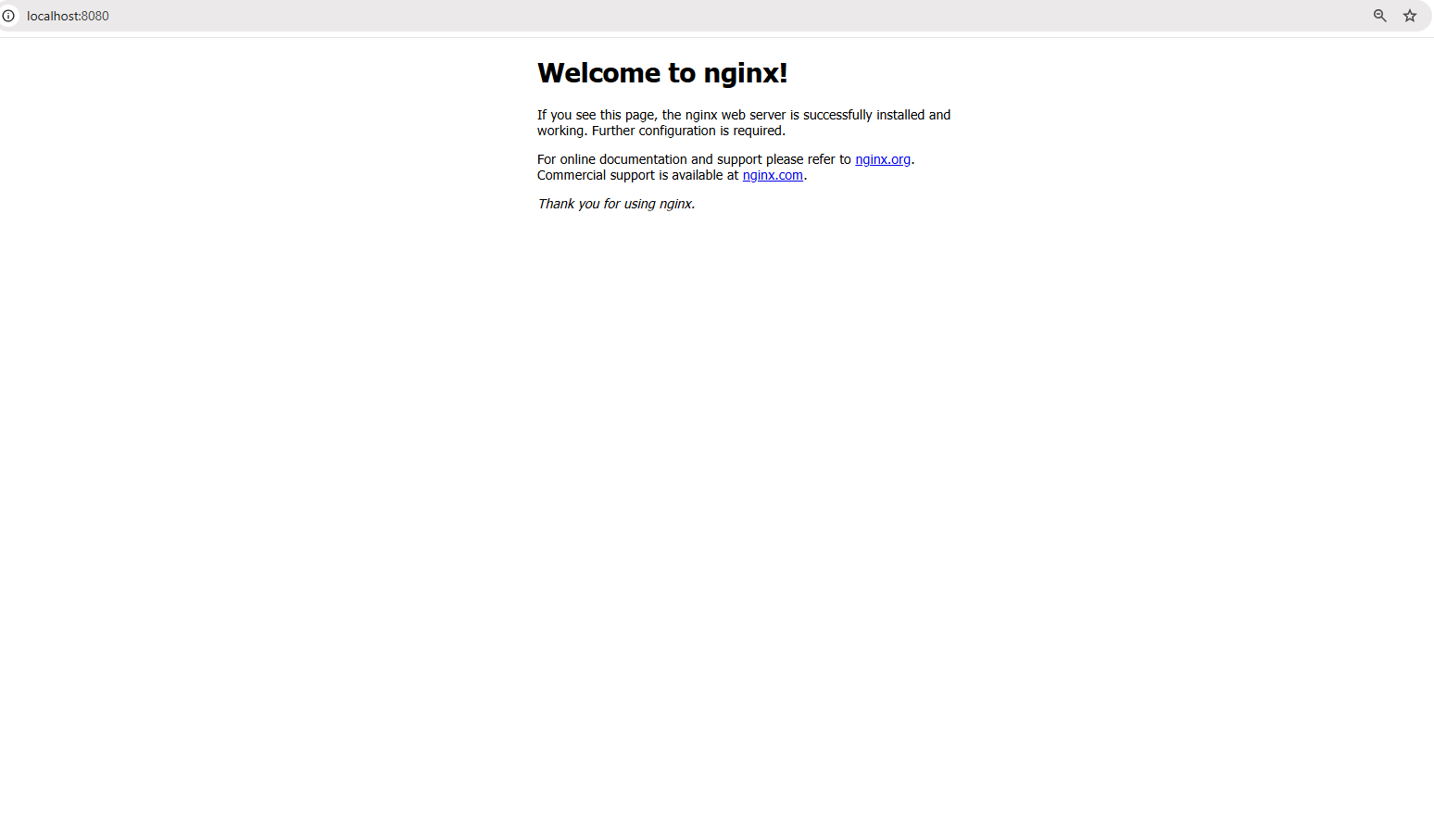

Jetzt gehen wir einen Schritt weiter und führen eine Anwendung in der realen Welt aus – einen Nginx-Webserver. Führen Sie den folgenden Befehl aus:

docker run -d -p 8080:80 nginx

Der obige Befehl führt folgendes aus:

- Die

-dFlagge führt den Container im Hintergrundmodus aus, was bedeutet, dass er im Hintergrund läuft. - Die

-p 8080:80Flagge bildet den Port 80 im Container auf Port 8080 auf Ihrem lokalen Rechner ab, sodass Sie auf den Webserver zugreifen können.

Nach erfolgreicher Ausführung des Befehls öffnen Sie einen Browser und besuchen Sie: http://localhost:8080

Zugriff auf Webserver unter localhost:8080

Sie sollten die Standard-Nginx-Begrüßungsseite sehen, was bestätigt, dass Ihr Webserver innerhalb eines Containers läuft!

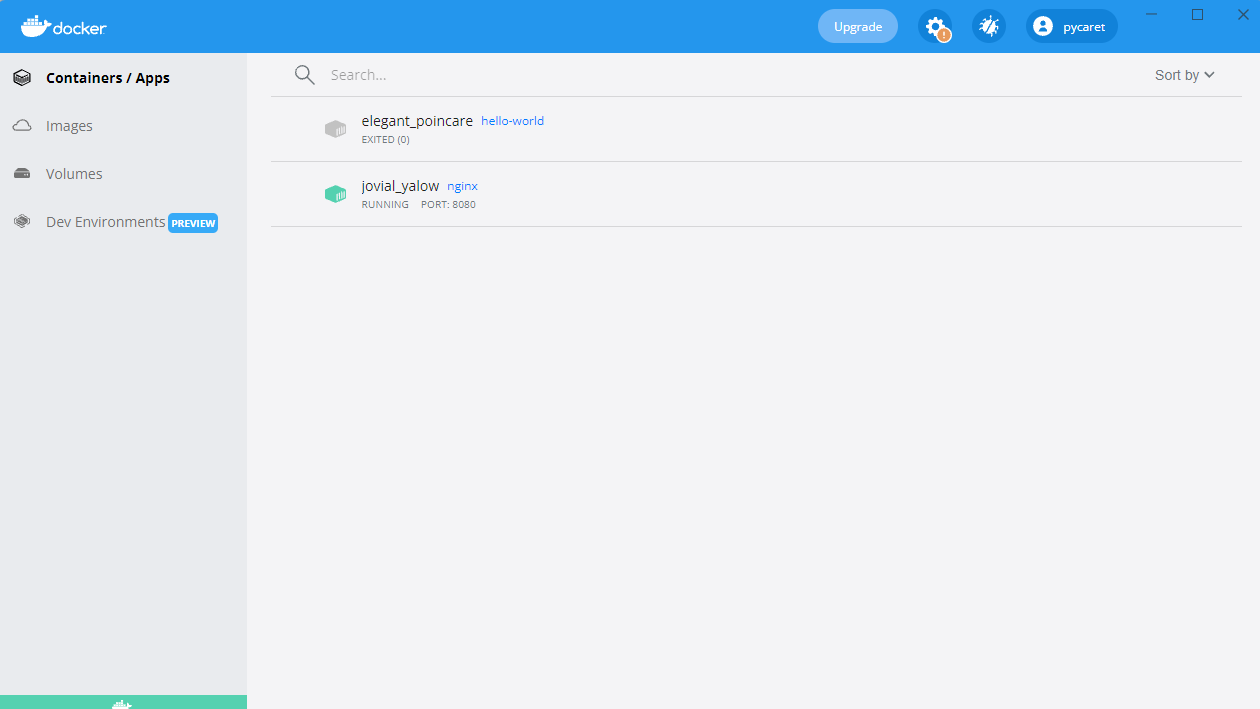

Sie sehen auch einen Container, der in Ihrem Docker Desktop läuft:

Nginx-Container läuft auf Port 8080

Erstellen Ihres ersten Docker-Images

Bisher haben wir vorgefertigte Images von Docker Hub verwendet. Aber was ist, wenn Sie eine benutzerdefinierte Umgebung benötigen, die auf Ihre Anwendung zugeschnitten ist? Hier kommt das Erstellen Ihres eigenen Docker-Images ins Spiel.

Das Erstellen eines Docker-Images umfasst das Schreiben einer Dockerfile, einem Skript, das den Image-Bau automatisiert. Dies gewährleistet Konsistenz und Portabilität über verschiedene Umgebungen hinweg. Sobald ein Image erstellt wurde, kann es als Container ausgeführt werden, um Anwendungen in einer isolierten Umgebung auszuführen.

In diesem Abschnitt lernen wir die Grundlagen des Schreibens eines Dockerfiles, des Bauens eines benutzerdefinierten Images und des Ausführens als Container.

Dockerfile-Grundlagen

Eine Dockerfile ist ein Skript, das eine Reihe von Anweisungen enthält, die definieren, wie ein Docker-Image gebaut wird. Es automatisiert den Prozess der Erstellung von Images und sorgt für Konsistenz in den Umgebungen. Jede Anweisung in einem Dockerfile erstellt eine neue Schicht im Image. Hier ist eine Übersicht eines Beispiel-Dockerfiles für eine einfache Python Flask-Anwendung:

# Basis-Image, das die Python-Laufzeit enthält FROM python:3.9 # Arbeitsverzeichnis innerhalb des Containers festlegen WORKDIR /app # Anwendungsdateien vom Host in den Container kopieren COPY . /app # Abhängigkeiten aus der requirements.txt installieren RUN pip install -r requirements.txt # Den Befehl definieren, um die Flask-Anwendung beim Start des Containers auszuführen CMD ["python", "app.py"]

In dem obigen Befehl:

-v my-volume:/app/databindet denmy-volumeSpeicher an das Verzeichnis/app/datainnerhalb des Containers.- Alle Daten, die in

/app/datagespeichert werden, bleiben erhalten, selbst wenn der Container stoppt oder entfernt wird.

Das obenstehende Dockerfile im Detail:

VON python:3.9: Legt das Basisbild mit vorinstalliertem Python 3.9 fest.WORKDIR /app: Legt/appals Arbeitsverzeichnis innerhalb des Containers fest.KOPIEREN . /app: Kopiert alle Dateien aus dem aktuellen Verzeichnis des Hosts in/appim Container.AUSFÜHREN pip install -r requirements.txt: Installiert alle erforderlichen Abhängigkeiten im Container.CMD ["python", "app.py"]: Definiert den Befehl, der beim Starten des Containers ausgeführt werden soll.

Erstellen und Ausführen des Images

Sobald das Dockerfile definiert ist, können Sie das Bild mit den folgenden Befehlen erstellen und ausführen:

Schritt 1: Erstellen des Bildes

docker build -t my-flask-app .

Der obige Befehl:

- Verwendet das aktuelle Verzeichnis (

.) als Build-Kontext. - Liess das

Dockerfilelesen und führt dessen Anweisungen aus. - Markiert (

-t) das resultierende Bild alsmy-flask-app.

Schritt 2: Führen Sie das Bild als Container aus

docker run -d -p 5000:5000 my-flask-app

Der obige Befehl:

- Führt den Container im Hintergrundmodus aus (

-d). - Mappt Port 5000 innerhalb des Containers auf Port 5000 des Hosts (

-p 5000:5000).

Nach dem Start können Sie auf die Flask-Anwendung zugreifen, indem Sie in einem Browser zu http://localhost:5000 navigieren.

Docker-Volumes und Persistenz

Standardmäßig sind Daten innerhalb eines Docker-Containers vorübergehend— sobald der Container stoppt oder entfernt wird, verschwinden die Daten. Um Daten über Container-Neustarts hinweg zu speichern und sie zwischen mehreren Containern zu teilen, bietet Docker Volumes, einen integrierten Mechanismus zur effizienten Verwaltung von persistentem Speicher.

Im Gegensatz zur Speicherung von Daten im Dateisystem des Containers werden Volumes separat von Docker verwaltet, was sie effizienter, flexibler und einfacher zu sichern macht.

Im nächsten Abschnitt werden wir erkunden, wie man Docker-Volumes erstellt und verwendet, um die Datenpersistenz in den Containern sicherzustellen.

Erstellen und Verwenden von Docker-Volumes

Schritt 1: Ein Volume erstellen

Bevor wir ein Volume verwenden können, müssen wir eins erstellen. Führen Sie den folgenden Befehl aus:

docker volume create my-volume

Dies erstellt ein benanntes Volume namens my-volume, das Docker separat von einem bestimmten Container verwalten wird.Schritt 2: Das Volume in einem Container verwenden

Jetzt starten wir einen Container und mounten das Volume darin:

docker run -d -v my-volume:/app/data my-app

In dem obigen Befehl:

-v my-volume:/app/databindet denmy-volumeSpeicher an das Verzeichnis/app/datainnerhalb des Containers.- Alle Daten, die in

/app/datagespeichert sind, bleiben erhalten, auch wenn der Container gestoppt oder entfernt wird.

Docker Compose für Multi-Container-Anwendungen

Bisher haben wir mit Einzel-Container-Anwendungen gearbeitet, aber viele Anwendungen in der realen Welt erfordern mehrere Container, die zusammenarbeiten. Zum Beispiel könnte eine Webanwendung einen Backend-Server, eine Datenbank und eine Caching-Schicht benötigen, die jeweils in ihrem eigenen Container laufen. Das manuelle Verwalten dieser Container mit separaten docker run Befehlen kann schnell mühsam werden.

Genau hier kommt Docker Compose ins Spiel.

Was ist Docker Compose?

Docker Compose ist ein Tool, das die Verwaltung von Multi-Container-Anwendungen vereinfacht. Anstatt mehrere docker run-Befehle auszuführen, können Sie mithilfe einer docker-compose.yml-Datei einen gesamten Anwendungsstack definieren und mit einem einzigen Befehl bereitstellen.

Das Schreiben einer Docker Compose-Datei

Jetzt erstellen wir ein Beispiel aus der realen Welt – eine einfache Node.js-Anwendung, die sich mit einer MongoDB-Datenbank verbindet. Anstatt die beiden Container separat zu verwalten, werden wir sie in einer docker-compose.yml-Datei definieren.

So definieren wir unser Multi-Container-Setup in Docker Compose:

version: '3' services: web: build: . ports: - "3000:3000" depends_on: - database database: image: mongo volumes: - db-data:/data/db volumes: db-data:

Aufschlüsselung der obigen Datei:

version: '3': Legt die Docker Compose-Version fest.services:: Definiert einzelne Dienste (Container).web:: Definiert die Node.js-Webanwendung.database:: Definiert den MongoDB-Datenbankcontainer.volumes:: Erstellt ein benanntes Volume (db-data) für die Datenpersistenz von MongoDB.

Ausführen von Multi-Container-Anwendungen

Sobald die docker-compose.yml-Datei bereit ist, können wir den gesamten Anwendungsstack mit einem einzigen Befehl starten:

docker-compose up -d

Der vorherige Befehl startet sowohl die Web- als auch die Datenbankcontainer im Hintergrundmodus (-d).

Um alle Dienste zu stoppen, verwenden Sie:

docker-compose down

Dies stoppt und entfernt alle Container, während Volumes und Netzwerkeinstellungen beibehalten werden.

Docker Netzwerkgrundlagen

Bis jetzt haben wir uns auf das Ausführen von Containern und das Verwalten von Speicher konzentriert, aber was passiert, wenn Container miteinander kommunizieren müssen? In den meisten realen Anwendungen arbeiten Container nicht isoliert – sie müssen Daten austauschen, sei es, dass ein Webserver mit einer Datenbank spricht oder Mikroservices miteinander interagieren.

Docker bietet eine Reihe von Netzwerkoptionen, um verschiedene Anwendungsfälle zu berücksichtigen, von isolierten internen Netzwerken bis hin zu extern zugänglichen Konfigurationen.

Bist du bereit, deine Docker-Fähigkeiten auf das nächste Level zu bringen? Melde dich für Intermediate Docker an, um Multi-Stage-Bauten, fortgeschrittene Netzwerktechniken und mehr zu erkunden!

Was ist Docker-Netzwerk?

Docker-Netzwerk ist eine integrierte Funktion, die es Containern ermöglicht, miteinander zu kommunizieren, egal ob auf demselben Host oder über mehrere Hosts in einer verteilten Umgebung. Es bietet Netzwerkisolierung, Segmentierung und Konnektivitätsoptionen, die für verschiedene Bereitstellungsszenarien geeignet sind.

Docker unterstützt mehrere Netzwerktypen, die jeweils für unterschiedliche Anwendungsfälle dienen:

- Bridge (Standard): Container auf demselben Host kommunizieren über ein internes virtuelles Netzwerk. Jeder Container erhält seine eigene private IP-Adresse im Bridge-Netzwerk, und sie können sich über die Containernamen erreichen.

- Beispiel:

docker network create my-bridge-network - Ideal für das Ausführen mehrerer Container auf einem einzelnen Host, die sicher kommunizieren müssen, ohne Dienste extern zugänglich zu machen.

- Host: Container teilen sich den Netzwerk-Stack des Hosts und verwenden direkt die IP-Adresse und Ports des Hosts.

- Beispiel:

docker run --network host nginx - Nützlich, wenn Sie hohe Leistung benötigen und keine Netzwerkisolierung erfordern, wie beim Ausführen von Überwachungsagenten oder latenzarmen Anwendungen.

- Überlagerung: Ermöglicht die Kommunikation zwischen Containern auf verschiedenen Hosts, indem ein verteiltes Netzwerk erstellt wird.

- Beispiel:

docker network create --driver overlay my-overlay-network - Entwickelt für orchestrierte Bereitstellungen wie Docker Swarm, bei denen Dienste über mehrere Knoten verteilt sind.

- Macvlan: Weist jedem Container eine eindeutige MAC-Adresse zu, sodass er im Netzwerk wie ein physisches Gerät erscheint.

- Beispiel:

docker network create -d macvlan --subnet=192.168.1.0/24 my-macvlan - Verwendet, wenn Container direkten Netzwerkzugang benötigen, beispielsweise bei der Integration von Altsystemen oder der Interaktion mit physischen Netzwerken.

Container in benutzerdefinierten Netzwerken ausführen

Gehen wir durch, wie man ein benutzerdefiniertes Bridge-Netzwerk für die Kommunikation zwischen Containern einrichtet und verwendet.

Schritt 1: Erstellen Sie ein benutzerdefiniertes Netzwerk

Bevor wir Container ausführen, müssen wir zunächst ein dediziertes Netzwerk erstellen:

docker network create my-custom-network

Dieser Befehl erstellt ein isoliertes Netzwerk, dem Container für die Kommunikation zwischen Containern beitreten können.

Schritt 2: Container im Netzwerk ausführen

Starten Sie nun zwei Container und verbinden Sie sie mit unserem neu erstellten Netzwerk:

docker run -d --network my-custom-network --name app1 my-app docker run -d --network my-custom-network --name app2 my-app

- Der

--network my-custom-networkFlag fügt den Container dem angegebenen Netzwerk hinzu. - Der

--nameFlag weist einen eindeutigen Container-Namen zu, um die Referenzierung zu erleichtern.

Sowohl app11 und app2 können nun mithilfe ihrer Container-Namen kommunizieren. Sie können die Konnektivität mithilfe des ping` Befehls innerhalb eines der Container testen:

docker exec -it app1 ping app2

Wenn alles korrekt eingerichtet ist, sehen Sie eine Antwort, die bestätigt, dass die Container kommunizieren können.

Überprüfen von Docker-Netzwerken

Um Netzwerkkonfigurationen und verbundene Container zu überprüfen, verwenden Sie:

docker network inspect my-custom-network

Dieser Befehl liefert Details zum Netzwerk, einschließlich IP-Bereichen, verbundenen Containern und Konfigurationen.

Ports freigeben und veröffentlichen

Wenn Sie Container ausführen, die extern zugänglich sein müssen, können Sie bestimmte Ports freigeben.

Um beispielsweise einen Nginx-Webserver auszuführen und ihn auf Port 8080 Ihres lokalen Rechners freizugeben, verwenden Sie:

docker run -d -p 8080:80 nginx

Dies mappt Port 80 innerhalb des Containers auf Port 8080 auf dem Host, wodurch der Dienst über http://localhost:8080.

Best Practices für Docker-Netzwerke

- Verwenden Sie benutzerdefinierte Netzwerke: Vermeiden Sie die Verwendung des Standard-Brücken-Netzwerks für Produktionsbereitstellungen, um unbeabsichtigten Zugriff zwischen Containern zu reduzieren.

- Nutzen Sie die DNS-basierte Entdeckung: Verwenden Sie anstelle von Festcodierung von IP-Adressen Container-Namen, um eine dynamische Diensteentdeckung zu ermöglichen.

- Beschränken Sie die externe Exposition: Verwenden Sie Firewalls oder Netzwerkrichtlinien, um den Zugriff auf Dienste zu kontrollieren.

- Überwachen Sie den Datenverkehr: Verwenden Sie Tools wie

docker network inspect, Wireshark oder Prometheus, um den Netzwerkverkehr zu analysieren und Anomalien zu erkennen. - Optimieren Sie Overlay-Netzwerke: Bei der Bereitstellung in einer verteilten Umgebung optimieren Sie Overlay-Netzwerke zur Reduzierung der Latenz, indem Sie hostlokale Routing-Optionen nutzen.

Docker Best Practices und nächste Schritte

Jetzt, da Sie die Grundlagen von Docker gelernt haben, ist es an der Zeit, Ihre Fähigkeiten zu verbessern und bewährte Verfahren zu übernehmen, die Ihnen helfen, sichere, effiziente und wartbare containerisierte Anwendungen zu erstellen.

Die folgenden bewährten Verfahren helfen Ihnen, Ihre Docker-Workflows zu optimieren und gängige Fallstricke zu vermeiden.

- Verwenden Sie offizielle Basisbilder: Bevorzugen Sie immer offizielle und gut gewartete Basisbilder, um Sicherheit und Stabilität zu gewährleisten. Offizielle Bilder sind optimiert, werden regelmäßig aktualisiert und haben eine geringere Wahrscheinlichkeit, Schwachstellen zu enthalten.

- Halten Sie Bilder klein: Reduzieren Sie die Bildgröße, indem Sie minimalistische Basisbilder wählen (z. B.

python:3.9-slimanstelle vonpython:3.9). Entfernen Sie unnötige Abhängigkeiten und Dateien, um Speicherplatz und Ladezeiten zu optimieren. - Verwenden Sie mehrstufige Builds: Optimieren Sie Dockerfiles, indem Sie Build- und Laufzeitabhängigkeiten trennen. Mehrstufige Builds stellen sicher, dass nur die notwendigen Artefakte im endgültigen Bild enthalten sind, was die Größe und die Angriffsfläche reduziert.

- Taggen Sie Bilder ordnungsgemäß: Verwenden Sie immer versionierte Tags (z.B.

my-app:v1.0.0) anstelle vonlatest, um unerwartete Updates beim Abrufen von Bildern zu vermeiden. - Scannen Sie Bilder auf Sicherheitsanfälligkeiten: Verwenden Sie Sicherheitsscanner wie

docker scan,TrivyoderClair, um Sicherheitsanfälligkeiten in Ihren Bildern vor der Bereitstellung zu identifizieren und zu beheben. - Verwalten Sie Umgebungsvariablen sicher: Vermeiden Sie es, sensible Anmeldeinformationen in Bildern zu speichern. Verwenden Sie Docker-Geheimnisse, Umgebungsvariablen oder externe Geheimnismanagement-Tools wie AWS Secrets Manager oder HashiCorp Vault.

- Verwenden Sie .dockerignore-Dateien: Schließen Sie unnötige Dateien aus (z. B.

.git, node_modules,venv), um die Größe des Build-Kontexts zu reduzieren und die versehentliche Aufnahme sensibler Dateien in Images zu verhindern. - Aktivieren Sie Logging und Monitoring: Verwenden Sie Tools wie Prometheus, Grafana und Fluentd für Container-Logs und Monitoring. Inspektieren Sie Logs mithilfe von

docker logsund aktivieren Sie strukturiertes Logging für bessere Beobachtbarkeit.

Nachdem Sie die Grundlagen von Docker gemeistert haben, gibt es viele fortgeschrittene Themen zu erkunden. Hier sind einige Bereiche, die sich als nächstes lohnen könnten:

- Docker Swarm & Kubernetes: Erforschen Sie Docker Swarm (integrierte Clusterbildung) und Kubernetes (unternehmenskontrollierte Orchestrierung mit automatischer Skalierung und Dienstentdeckung) für die Orchestrierung auf Produktionsniveau.

- Best Practices für die Sicherheit von Containern: Um containerisierte Anwendungen abzusichern, befolgen Sie die Richtlinien des CIS Docker Benchmark und implementieren Sie die rollenbasierte Zugriffskontrolle (RBAC).

- CI/CD-Pipelines mit Docker: Automatisieren Sie Image-Builds, Sicherheitsscans und Bereitstellungen mit GitHub Actions, GitLab CI oder Jenkins.

- Cloud-native Entwicklung: Nutzen Sie Docker mit Cloud-Plattformen wie AWS ECS, Azure Container Instances und Google Cloud Run für skalierbare und verwaltete Bereitstellungen.

- Datenspeicherungsstrategien: Um eine optimale Speicherverwaltung zu gewährleisten, verstehen Sie die Unterschiede zwischen Docker-Volumes, Bind-Mounts und tmpfs.

Conclusion

Docker hat revolutioniert, wie Entwickler Anwendungen erstellen, versenden und ausführen, was es zu einem unverzichtbaren Werkzeug für die moderne Softwareentwicklung macht.

In diesem Tutorial haben wir behandelt:

- Was Docker ist und warum es wichtig ist

- Wie man seinen ersten Container installiert und ausführt

- Wichtige Konzepte wie Bilder, Container und Netzwerke

- Permanenter Speicher mit Docker-Volumes

- Mehrcontaineranwendungen mit Docker Compose

- Best Practices für Sicherheit, Leistung und Skalierbarkeit

Aber das ist nur der Anfang! Wenn Sie Ihr Docker-Wissen vertiefen möchten, können Sie einen Anfängerkurs Einführung in Docker besuchen. Für vertiefte Kenntnisse können Sie einen Fortgeschrittenenkurs zu Docker belegen, der Multi-Stage-Bauten, Docker-Netzwerktools und Docker Compose behandelt. Schließlich können Sie auch eine Docker-Zertifizierung anstreben. Schauen Sie sich Den vollständigen Leitfaden zur Docker-Zertifizierung (DCA) für 2025 an, wenn Sie interessiert sind!